Принцип ортогональности

В статистике и обработке сигналов принцип ортогональности является необходимым и достаточным условием оптимальности байесовской оценки . Грубо говоря, принцип ортогональности гласит, что вектор ошибок оптимальной оценки (в смысле среднеквадратической ошибки ) ортогонален любой возможной оценке. Принцип ортогональности чаще всего формулируется для линейных оценок, но возможны и более общие формулировки. Поскольку этот принцип является необходимым и достаточным условием оптимальности, его можно использовать для нахождения минимальной оценки среднеквадратической ошибки .

Принцип ортогональности для линейных оценок

[ редактировать ]Принцип ортогональности чаще всего используется при линейной оценке. [1] В этом контексте пусть x будет неизвестным случайным вектором , который необходимо оценить на основе вектора наблюдения y . Требуется построить линейную оценку для некоторой матрицы H и вектора c . Тогда принцип ортогональности утверждает, что оценка достигает минимальной среднеквадратической ошибки тогда и только тогда, когда

- и

Если x и y имеют нулевое среднее, то достаточно потребовать выполнения первого условия.

Пример

[ редактировать ]Предположим, x — гауссова случайная величина со средним значением m и дисперсией Предположим также, что мы наблюдаем значение где w — гауссовский шум, который не зависит от x и имеет среднее значение 0 и дисперсию Мы хотим найти линейную оценку минимизация MSE. Подставив выражение на два требования принципа ортогональности, получаем

и

Решение этих двух линейных уравнений для h и c приводит к

так что линейная минимальная оценка среднеквадратической ошибки определяется выражением

Эту оценку можно интерпретировать как средневзвешенное значение между зашумленными измерениями y и предшествующим ожидаемым значением m . Если дисперсия шума мала по сравнению с дисперсией предыдущего (соответствует высокому SNR ), тогда большая часть веса отдается измерениям y , которые считаются более надежными, чем априорная информация. И наоборот, если дисперсия шума относительно выше, то оценка будет близка к m , поскольку измерения недостаточно надежны, чтобы перевесить априорную информацию.

Наконец, обратите внимание, что, поскольку переменные x и y совместно являются гауссовскими, минимальная оценка MSE является линейной. [2] Следовательно, в этом случае приведенная выше оценка минимизирует СКО среди всех оценок, а не только среди линейных оценок.

Общая формулировка

[ редактировать ]Позволять гильбертово пространство случайных величин со скалярным произведением , определяемым формулой . Предполагать является замкнутым подпространством , представляющий пространство всех возможных оценок. Человек хочет найти вектор который будет аппроксимировать вектор . Точнее, хотелось бы минимизировать среднеквадратичную ошибку (MSE). между и .

В частном случае линейных оценок, описанных выше, пространство представляет собой совокупность всех функций и , пока — набор линейных оценок, т. е. линейных функций от только. Другие настройки, которые можно сформулировать таким образом, включают подпространство причинных линейных фильтров и подпространство всех (возможно, нелинейных) оценок.

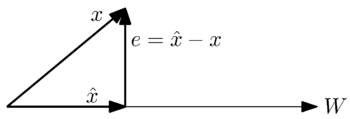

Геометрически мы можем увидеть эту проблему в следующем простом случае, когда представляет собой одномерное подпространство:

Мы хотим найти ближайшее приближение к вектору по вектору в космосе . Из геометрической интерпретации интуитивно понятно, что наилучшее приближение или наименьшая ошибка возникает, когда вектор ошибки , ортогонален векторам в пространстве .

Точнее, общий принцип ортогональности гласит следующее: учитывая замкнутое подпространство оценок в гильбертовом пространстве и элемент в , элемент достигает минимального MSE среди всех элементов в тогда и только тогда, когда для всех

Сформулированный таким образом, этот принцип представляет собой просто формулировку теоремы о проекции Гильберта . Тем не менее, широкое использование этого результата в обработке сигналов привело к появлению названия «принцип ортогональности».

Решение проблем минимизации ошибок

[ редактировать ]Ниже приведен один из способов найти минимальную оценку среднеквадратической ошибки , используя принцип ортогональности.

Мы хотим иметь возможность аппроксимировать вектор к

где

является приближением как линейная комбинация векторов в подпространстве охватываемый Следовательно, мы хотим иметь возможность решать коэффициенты, , так что мы можем записать наше приближение в известных терминах.

По теореме ортогональности квадрат нормы вектора ошибок , минимизируется, когда для всех j ,

Развивая это уравнение, получаем

Если существует конечное число векторов , это уравнение можно записать в матричной форме как

Предполагая , линейно независимы матрицу Грамиана можно инвертировать, чтобы получить

тем самым давая выражение для коэффициентов минимальной оценки среднеквадратической ошибки.

См. также

[ редактировать ]Примечания

[ редактировать ]- ^ Кей, стр.386

- ^ См. статью «Минимальная среднеквадратическая ошибка» .

Ссылки

[ редактировать ]- Кей, С.М. (1993). Основы статистической обработки сигналов: теория оценивания . Прентис Холл. ISBN 0-13-042268-1 .

- Мун, Тодд К. (2000). Математические методы и алгоритмы обработки сигналов . Прентис-Холл. ISBN 0-201-36186-8 .