Цеф (программное обеспечение)

| Оригинальный автор(ы) | Хранилище чернил ( Сейдж Вейл , Иегуда Саде Вайнрауб, Грегори Фарнум, Джош Дургин, Сэмюэл Джаст, Видо ден Холландер) |

|---|---|

| Разработчик(и) | Red Hat , Intel , CERN , Cisco , Fujitsu , SanDisk , Canonical и SUSE [ 1 ] |

| Стабильная версия | 18.2.0 [ 2 ] |

| Репозиторий | |

| Написано в | С++ , Питон [ 3 ] |

| Операционная система | Линукс , ФриБСД , [ 4 ] Окна [ 5 ] |

| Тип | Хранилище распределенных объектов |

| Лицензия | LGPLv2.1 [ 6 ] |

| Веб-сайт | цеф |

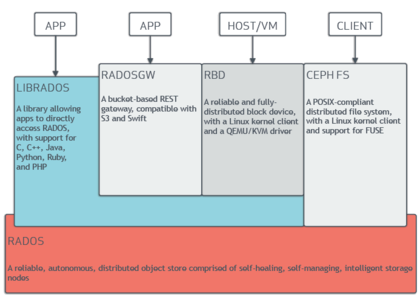

Ceph (произносится / ˈ s ɛ f / ) — это бесплатная с открытым исходным кодом программно-определяемая хранения данных платформа , которая обеспечивает объектное хранилище , [ 7 ] блочное хранилище и файловое хранилище, построенное на общей основе распределенного кластера. Ceph обеспечивает полностью распределенную работу без единой точки отказа и масштабируемость до эксабайтного уровня и доступен бесплатно. Начиная с версии 12 (Luminous), Ceph не полагается на какую-либо другую традиционную файловую систему и напрямую управляет жесткими дисками и твердотельными накопителями с помощью собственного хранилища данных BlueStore и может предоставлять POSIX файловую систему .

Ceph реплицирует данные с отказоустойчивостью , [ 8 ] с использованием стандартного оборудования и Ethernet IP и не требует специальной аппаратной поддержки. Ceph отличается высокой доступностью и обеспечивает надежную надежность данных посредством таких методов, как репликация, стирающее кодирование , снимки и клонирования. По своей конструкции система является одновременно самовосстанавливающейся и самоуправляемой , что сводит к минимуму время администрирования и другие затраты.

Крупномасштабные производственные развертывания Ceph включают CERN , [ 9 ] [ 10 ] ОВХ [ 11 ] [ 12 ] [ 13 ] [ 14 ] и Цифровой Океан . [ 15 ] [ 16 ]

Дизайн

[ редактировать ]

Ceph использует пять различных типов демонов : [ 17 ]

- Кластерные мониторы ( ceph-mon ), которые отслеживают активные и вышедшие из строя узлы кластера, конфигурацию кластера и информацию о размещении данных и глобальном состоянии кластера.

- OSD ( ceph-osd ), которые управляют устройствами хранения больших объемов данных напрямую через серверную часть BlueStore, [ 18 ] который с момента выпуска v12.x заменяет хранилище файлов [ 19 ] серверная часть, которая была реализована поверх традиционной файловой системы)

- Серверы метаданных ( ceph-mds ), которые поддерживают и обеспечивают доступ к индексным дескрипторам и каталогам внутри файловой системы CephFS.

- HTTP- шлюзы ( ceph-rgw ), которые предоставляют уровень хранения объектов как интерфейс, совместимый с Amazon S3 или OpenStack Swift. API-интерфейсами

- Менеджеры ( ceph-mgr ), которые выполняют задачи мониторинга, учета и обслуживания кластера, а также взаимодействуют с внешними системами мониторинга и управления (например, балансировщиком, информационной панелью, Prometheus , плагином Zabbix). [ 20 ]

Все они полностью распределены и могут быть развернуты на отдельных выделенных серверах или в конвергентной топологии . Клиенты с разными потребностями напрямую взаимодействуют с соответствующими компонентами кластера. [ 21 ]

Ceph распределяет данные по нескольким устройствам хранения и узлам для достижения более высокой пропускной способности аналогично RAID . адаптивная балансировка нагрузки , благодаря чему часто используемые службы могут реплицироваться на большее количество узлов. Поддерживается [ 22 ]

По состоянию на сентябрь 2017 г. [update], BlueStore — это серверная система хранения данных по умолчанию и рекомендуемая для производственных сред. [ 23 ] что обеспечивает лучшую задержку и возможность настройки, чем более старая серверная часть Filestore, а также позволяет избежать недостатков хранилища на основе файловой системы, включающего дополнительные уровни обработки и кэширования. Серверная часть Filestore будет прекращена с момента выпуска Reef в середине 2023 года. XFS была рекомендованной базовой файловой системой для OSD Filestore, а Btrfs можно было использовать на свой страх и риск. Файловые системы ext4 не рекомендовались из-за ограниченной емкости метаданных. [ 24 ] Серверная часть BlueStore по-прежнему использует XFS для небольшого раздела метаданных. [ 25 ]

Объектное хранилище S3

[ редактировать ]

Ceph реализует распределенное хранилище объектов через РАДОС Шлюз ( ceph-rgw ), который предоставляет базовый уровень хранения через интерфейс, совместимый с Amazon S3 или OpenStack Swift .

Развертывания Ceph RGW легко масштабируются и часто используют большие и плотные носители данных для массовых случаев использования, которые включают большие данные (хранилище данных), резервное копирование и архивирование , Интернет вещей , носители, видеозапись и образы развертывания для виртуальных машин и контейнеров . [ 26 ]

Библиотеки программного обеспечения Ceph предоставляют клиентским приложениям прямой доступ к надежной объектно-ориентированной системе хранения данных автономного распределенного хранилища объектов (RADOS). Чаще используются библиотеки для блочного устройства RADOS Ceph (RBD), шлюза RADOS и файловой системы Ceph служб . Таким образом, администраторы могут поддерживать свои устройства хранения данных в единой системе, что упрощает репликацию и защиту данных.

librados Программные библиотеки обеспечивают доступ к C , C++ , Java , PHP и Python . Шлюз RADOS также предоставляет хранилище объектов как интерфейс RESTful , который может представлять собой как собственные API-интерфейсы Amazon S3 , так и OpenStack Swift .

Блочное хранилище

[ редактировать ]Ceph может предоставлять клиентам с тонким предоставлением блочные устройства . Когда приложение записывает данные в Ceph с использованием блочного устройства, Ceph автоматически распределяет и реплицирует данные по кластеру. (RBD) Ceph Блочное устройство RADOS также интегрируется с виртуальными машинами на основе ядра (KVM).

Блочное хранилище Ceph может быть развернуто на традиционных жестких дисках и/или твердотельных накопителях , которые связаны с блочным хранилищем Ceph для сценариев использования, включая базы данных, виртуальные машины, анализ данных, искусственный интеллект и машинное обучение. Клиентам блочного хранилища часто требуется высокая пропускная способность и IOPS , поэтому при развертывании Ceph RBD все чаще используются твердотельные накопители с интерфейсами NVMe .

«RBD» построен на основе базовой системы хранения объектов RADOS Ceph, которая предоставляет интерфейс librados и файловую систему CephFS. Поскольку RBD построен на librados, RBD наследует возможности librados, включая клонирование и снимки . Распределяя тома по кластеру, Ceph повышает производительность для образов больших блочных устройств.

«Ceph-iSCSI» — это шлюз, который обеспечивает доступ к распределенному блочному хранилищу высокой доступности с серверов Microsoft Windows и VMware vSphere или клиентов, поддерживающих протокол iSCSI . При использовании ceph-iscsi на одном или нескольких хостах шлюза iSCSI образы Ceph RBD становятся доступными как логические единицы (LU), связанные с целями iSCSI, к которым можно получить доступ опционально с балансировкой нагрузки и высокой доступностью.

Поскольку конфигурация ceph-iscsi хранится в хранилище объектов Ceph RADOS, хосты шлюзов ceph-iscsi по своей сути не имеют постоянного состояния и, таким образом, могут быть заменены, расширены или сокращены по желанию. В результате Ceph Storage позволяет клиентам запускать по-настоящему распределенную, высокодоступную, отказоустойчивую и самовосстанавливающуюся корпоративную технологию хранения данных на стандартном оборудовании и платформе с полностью открытым исходным кодом.

Блочное устройство можно виртуализировать, предоставляя блочное хранилище виртуальным машинам на таких платформах виртуализации, как Openshift , OpenStack , Kubernetes , OpenNebula , Ganeti , Apache CloudStack и Proxmox Virtual Environment .

Хранение файлов

[ редактировать ]Файловая система Ceph (CephFS) работает поверх той же основы RADOS, что и службы хранения объектов и блочных устройств Ceph. Сервер метаданных CephFS (MDS) предоставляет службу, которая сопоставляет каталоги и имена файлов файловой системы с объектами, хранящимися в кластерах RADOS. Кластер серверов метаданных может расширяться или сжиматься, а также может динамически перебалансировать ранги метаданных файловой системы для равномерного распределения данных между узлами кластера. Это обеспечивает высокую производительность и предотвращает большие нагрузки на отдельные хосты внутри кластера.

Клиенты монтируют POSIX -совместимую файловую систему с помощью клиента ядра Linux . более старый клиент на базе FUSE Также доступен . Серверы работают как обычные демоны Unix .

Хранилище файлов Ceph часто связано со сбором журналов, обменом сообщениями и хранением файлов.

Панель управления

[ редактировать ]

С 2018 года также существует проект веб-интерфейса Dashboard, который помогает управлять кластером. Он разрабатывается сообществом Ceph на LGPL-3 и использует Ceph-mgr, Python , Angular framework и Grafana . [ 27 ] Целевая страница была обновлена в начале 2023 года. [ 28 ]

Предыдущие панели мониторинга были разработаны, но сейчас закрыты: Calamari (2013–2018), OpenAttic (2013–2019), VSM (2014–2016), Inkscope (2015–2016) и Ceph-Dash (2015–2017). [ 29 ]

малиновый

[ редактировать ]Начиная с 2019 года проект Crimson переопределяет путь к данным OSD. Цель Crimson — минимизировать задержку и нагрузку на процессор. Современные устройства хранения данных и интерфейсы, включая NVMe и 3D XPoint, стали намного быстрее, чем жесткие диски SAS/SATA и даже твердотельные накопители , но производительность процессора отстает. Более того crimson-osd задуман как обратно совместимая замена цеф-осд . Хотя Crimson может работать с серверной частью BlueStore (через AlienStore), для целей тестирования вместе с CyanStore также разрабатывается новая собственная реализация ObjectStore под названием SeaStore. Одной из причин создания SeaStore является то, что поддержка транзакций в серверной части BlueStore обеспечивается RocksDB , которую необходимо повторно реализовать для достижения лучшего параллелизма. [ 30 ] [ 31 ] [ 32 ]

История

[ редактировать ]Ceph был создан Сейджем Вейлом для его докторской диссертации . [ 33 ] который консультировался профессором Скоттом А. Брандтом из Инженерной школы Джека Баскина Калифорнийского университета в Санта-Крус (UCSC) и спонсировался Программой расширенного моделирования и вычислений (ASC), включая Национальную лабораторию Лос-Аламоса (LANL), Сандия. Национальные лаборатории (SNL) и Ливерморская национальная лаборатория Лоуренса (LLNL). [ 34 ] Первая строка кода, которая в конечном итоге стала частью Ceph, была написана Сейджем Вейлом в 2004 году во время летней стажировки в LLNL, где он работал над управлением метаданными масштабируемой файловой системы (известной сегодня как Ceph MDS). [ 35 ] В 2005 году в рамках летнего проекта, инициированного Скоттом А. Брандтом и возглавляемого Карлосом Мальцаном, Сейдж Вейл создал полнофункциональный прототип файловой системы, получивший название Ceph. Ceph дебютировал вместе с Sage Weil, проведя две презентации в ноябре 2006 г., одну на USENIX OSDI 2006. [ 36 ] и еще один на SC '06. [ 37 ]

После окончания учебы осенью 2007 года Вейл продолжал работать над Ceph на постоянной основе, а основная команда разработчиков расширилась, включив в себя Йехуду Саде Вайнрауба и Грегори Фарнума. 19 марта 2010 г. Линус Торвальдс объединил клиент Ceph с ядром Linux версии 2.6.34. [ 38 ] [ 39 ] который был выпущен 16 мая 2010 года. В 2012 году Вейл создал Inktank Storage для профессиональных услуг и поддержки Ceph. [ 40 ] [ 41 ]

В апреле 2014 года Red Hat приобрела Inktank, передав большую часть разработки Ceph собственными силами, чтобы сделать его производственной версией для предприятий с поддержкой (горячая линия) и постоянным обслуживанием (новые версии). [ 42 ]

В октябре 2015 года был сформирован Консультативный совет сообщества Ceph, чтобы помочь сообществу в продвижении направления технологии программно-определяемого хранилища с открытым исходным кодом. В состав уставного консультативного совета входят члены сообщества Ceph из глобальных ИТ-организаций, которые поддерживают проект Ceph, в том числе представители Red Hat , Intel , Canonical , CERN , Cisco , Fujitsu , SanDisk и SUSE . [ 43 ]

В ноябре 2018 года Linux Foundation запустил Ceph Foundation в качестве преемника Консультативного совета сообщества Ceph. В число основателей Ceph Foundation входили Amihan, Canonical , China Mobile , DigitalOcean , Intel , OVH , ProphetStor Data Services, Red Hat , SoftIron, SUSE , Western Digital , XSKY Data Technology и ZTE . [ 44 ]

В марте 2021 года SUSE прекратила выпуск продукта Enterprise Storage, включающего Ceph, в пользу Rancher . Longhorn от [ 45 ] а прежний веб-сайт Enterprise Storage был обновлен, в котором говорилось: «SUSE переориентировала усилия по хранению данных на обслуживание наших стратегических клиентов SUSE Enterprise Storage и больше не занимается активной продажей SUSE Enterprise Storage». [ 46 ]

История выпусков

[ редактировать ]| Имя | Выпускать | Первый выпуск | Конец жизнь |

Вехи |

|---|---|---|---|---|

| Аргонавт | 0.48. | 3 июля 2012 г. | Первый крупный «стабильный» выпуск | |

| Бобтейл | 0.56. | 1 января 2013 г. | ||

| Каракатица | 0.61. | 7 мая 2013 г. | ceph-deploy стабилен | |

| Пельмени | 0.67. | 14 августа 2013 г. | май 2015 г. | пространство имен, регион, мониторинг REST API |

| Император | 0.72. | 9 ноября 2013 г. | май 2014 г. | репликация в нескольких центрах обработки данных для RGW |

| Светлячок | 0.80. | 7 мая 2014 г. | апрель 2016 г. | стирающее кодирование, многоуровневое кэширование, первичное сходство, серверная часть OSD «ключ/значение» (экспериментальная), автономный RGW (экспериментальная) |

| Гигант | 0.87. | 29 октября 2014 г. | апрель 2015 г. | |

| Молоток | 0.94. | 7 апреля 2015 г. | август 2017 г. | |

| Адский | 9.2.0. | 6 ноября 2015 г. | апрель 2016 г. | |

| Драгоценность | 10.2.0. | 21 апреля 2016 г. | 2018-06-01 | Стабильная CephFS, экспериментальная серверная часть OSD под названием BlueStore, демоны больше не запускаются от имени пользователя root. |

| Кракен | 11.2.0. | 20 января 2017 г. | 2017-08-01 | BlueStore стабилен, EC для пулов RBD |

| Светящийся | 12.2.0. | 29 августа 2017 г. | 2020-03-01 | балансировщик pg-upmap |

| Подражать | 13.2.0. | 1 июня 2018 г. | 2020-07-22 | снимки стабильны, Beast стабилен, официальный графический интерфейс (панель управления) |

| Наутилус | 14.2.0. | 19 марта 2019 г. | 2021-06-01 | асинхронная репликация, автоповтор неудачной записи из-за перераспределения дефектов |

| Осьминог | 15.2.0. | 23 марта 2020 г. | 2022-06-01 | |

| Тихий океан | 16.2.0. | 31 марта 2021 г. [ 47 ] | 2023-06-01 | |

| Куинси | 17.2.0. | 19 апреля 2022 г. [ 48 ] | 2024-06-01 | автоматическая настройка min_alloc_size для новых носителей |

| Риф | 18.2.0. | 3 августа 2023 г. [ 49 ] | ||

| Кальмар | будет объявлено позднее | будет объявлено позже |

Доступные платформы

[ редактировать ]Хотя Ceph в основном создан для Linux, он также частично перенесен на платформу Windows. Он готов к работе для Windows Server 2016 (некоторые команды могут быть недоступны из-за отсутствия реализации сокетов UNIX ), Windows Server 2019 и Windows Server 2022 , но тестирование/разработку можно проводить и в Windows 10 и Windows 11 . В Windows можно использовать Ceph RBD и CephFS, но OSD на этой платформе не поддерживается. [ 50 ] [ 5 ] [ 51 ]

Существует также для FreeBSD . реализация Ceph [ 4 ]

Этимология

[ редактировать ]Название «Цеф» — это сокращенная форма от « головоногих моллюсков », класса моллюсков , в который входят кальмары, каракатицы, наутилоиды и осьминоги. Название (подчеркнутое логотипом) предполагает весьма параллельное поведение осьминога и было выбрано, чтобы связать файловую систему с «Сэмми», бананового слизняка талисманом UCSC . [ 17 ] И головоногие моллюски, и банановые слизни являются моллюсками.

См. также

[ редактировать ]- BeeGFS

- Распределенная файловая система

- Распределенные параллельные отказоустойчивые файловые системы

- Файловая система Gfarm

- ГлюстерФС

- Общая параллельная файловая система IBM (GPFS)

- Кубернетес

- ЯщерицаFS

- Блеск

- МапР ФС

- Файловая система Moose

- ОранжеваяФС

- Параллельная виртуальная файловая система

- Файловая система Quantcast

- РозоФС

- Программно-определяемое хранилище

- XtreemFS

- ZFS

- Сравнение распределенных файловых систем

Ссылки

[ редактировать ]- ^ «Консультационный совет сообщества Ceph» . 2015-10-28. Архивировано из оригинала 29 января 2019 г. Проверено 20 января 2016 г.

- ^ https://github.com/ceph/ceph/releases/tag/v18.2.0 . Проверено 26 августа 2023 г.

{{cite web}}: Отсутствует или пусто|title=( помощь ) - ^ «Репозиторий GitHub» . Гитхаб .

- ^ Jump up to: а б «Ежеквартальный отчет о состоянии FreeBSD» .

- ^ Jump up to: а б «Установка Ceph в Windows» . Цеф . Проверено 2 июля 2023 г.

- ^ «Файл лицензии LGPL2.1 в исходниках Ceph» . Гитхаб . 24 октября 2014 г. Проверено 24 октября 2014 г.

- ^ Николя, Филипп (15 июля 2016 г.). «The History Boys: Хранение предметов… с самого начала» . Регистр .

- ^ Джереми Эндрюс (15 ноября 2007 г.). «Распределенная сетевая файловая система Ceph» . Ядерная ловушка . Архивировано из оригинала 17 ноября 2007 г. Проверено 15 ноября 2007 г.

- ^ «Кластеры цефов» . ЦЕРН . Проверено 12 ноября 2022 г.

- ^ «Операции цефов в ЦЕРН: куда нам идти дальше? - Дэн ван дер Стер и Тео Муратидис, ЦЕРН» . Ютуб . 24 мая 2019 года . Проверено 12 ноября 2022 г.

- ^ Дорош, Филип (15 июня 2020 г.). «Путешествие к хранилищу Ceph следующего поколения в OVHcloud с LXD» . OVHcloud . Проверено 12 ноября 2022 г.

- ^ «Распределенная файловая система CephFS» . OVHcloud . Проверено 12 ноября 2022 г.

- ^ «Ceph — Распределенная система хранения в OVH [en] — Бартломей Свенцкий» . Ютуб . 7 апреля 2016 года . Проверено 12 ноября 2022 г.

- ^ «200 кластеров против 1 администратора — Бартош Рабиега, OVH» . Ютуб . 24 мая 2019 года . Проверено 15 ноября 2022 г.

- ^ Д'Атри, Энтони (31 мая 2018 г.). «Почему мы выбрали Ceph для создания блочного хранилища» . Цифровой Океан . Проверено 12 ноября 2022 г.

- ^ «Технический разговор о Ceph: Ceph в DigitalOcean» . Ютуб . 7 октября 2021 г. Проверено 12 ноября 2022 г.

- ^ Jump up to: а б с М. Тим Джонс (04 июня 2010 г.). «Ceph: распределенная файловая система Linux петабайтного масштаба» (PDF) . ИБМ . Проверено 3 декабря 2014 г.

- ^ «БлюСтор» . Цеф . Проверено 29 сентября 2017 г.

- ^ «Миграция BlueStore» . Архивировано из оригинала 4 декабря 2019 г. Проверено 12 апреля 2020 г.

- ^ «Демон-менеджер Ceph — Документация Ceph» . docs.ceph.com . Архивировано из оригинала 6 июня 2018 года . Проверено 31 января 2019 г. Архивная ссылка. Архивировано 19 июня 2020 г. в Wayback Machine.

- ^ Джейк Эдж (14 ноября 2007 г.). «Файловая система Ceph» . LWN.net .

- ^ Энтони Д'Атри, Вайбхав Бхембре (01 октября 2017 г.). «Изучение Ceph, второе издание» . Пакет .

- ^ Сейдж Вейл (29 августа 2017 г.). «Выпущена версия 12.2.0 Luminous» . Блог Ceph.

- ^ «Рекомендации по жесткому диску и файловой системе» . ceph.com. Архивировано из оригинала 14 июля 2017 г. Проверено 26 июня 2017 г.

- ^ «Справочник по конфигурации BlueStore» . Архивировано из оригинала 20 июля 2019 года . Проверено 12 апреля 2020 г.

- ^ «10-я Международная конференция «Распределенные вычисления и грид-технологии в науке и образовании» (ГРИД’2023)» . ОИЯИ (Индико) . 03.07.2023 . Проверено 9 августа 2023 г.

- ^ «Панель управления Ceph» . Документация Ceph . Проверено 11 апреля 2023 г.

- ^ Гомес, Педро Гонсалес (23 февраля 2023 г.). «Представляем новую целевую страницу информационной панели» . Проверено 11 апреля 2023 г.

- ^ «Работа с Ceph с панели управления Ceph: прошлое, настоящее и будущее» . Ютуб . 22 ноября 2022 г. Проверено 11 апреля 2023 г.

- ^ Просто, Сэм (18 января 2021 г.). «Crimson: развитие Ceph для высокопроизводительного NVMe» . Новые технологии Red Hat . Проверено 12 ноября 2022 г.

- ^ Просто, Сэмюэл (10 ноября 2022 г.). «Что нового в Crimson и Seastore?» . Ютуб . Проверено 12 ноября 2022 г.

- ^ «Crimson: OSD Ceph следующего поколения для многоядерной масштабируемости» . Блог Ceph . Цеф. 7 февраля 2023 г. Проверено 11 апреля 2023 г.

- ^ Сейдж Вейл (01 декабря 2007 г.). «Ceph: надежное, масштабируемое и высокопроизводительное распределенное хранилище» (PDF) . Калифорнийский университет, Санта-Круз . Архивировано из оригинала (PDF) 6 июля 2017 г. Проверено 11 марта 2017 г.

- ^ Гэри Грайдер (1 мая 2004 г.). «История и стратегия масштабируемого ввода-вывода ASCI/DOD» (PDF) . Университет Миннесоты . Проверено 17 июля 2019 г.

- ^ Динамическое управление метаданными для файловых систем петабайтного масштаба, С.А. Вейл, К.Т. Поллак, С.А. Брандт, Э.Л. Миллер, Proc. SC'04, Питтсбург, Пенсильвания, ноябрь 2004 г.

- ^ «Ceph: масштабируемая, высокопроизводительная распределенная файловая система», SA Weil, SA Brandt, EL Miller, DDE Long, C Maltzahn, Proc. OSDI, Сиэтл, Вашингтон, ноябрь 2006 г.

- ^ «CRUSH: контролируемое, масштабируемое, децентрализованное размещение реплицируемых данных», С.А. Вейл, С.А. Брандт, Э.Л. Миллер, DDE Long, C Maltzahn, SC'06, Тампа, Флорида, ноябрь 2006 г.

- ^ Сейдж Вейл (19 февраля 2010 г.). «Клиент объединен для 2.6.34» . ceph.newdream.net. Архивировано из оригинала 23 марта 2010 г. Проверено 21 марта 2010 г.

- ^ Тим Стивенс (20 мая 2010 г.). «Новая версия ОС Linux включает файловую систему Ceph, разработанную в UCSC» . news.ucsc.edu.

- ^ Брайан Богенсбергер (3 мая 2012 г.). «И все это вместе» . Блог чернильницы. Архивировано из оригинала 19 июля 2012 г. Проверено 10 июля 2012 г.

- ^ Джозеф Ф. Ковар (10 июля 2012 г.). «10 самых крутых стартапов в сфере хранения данных 2012 года (на данный момент)» . КРН . Проверено 19 июля 2013 г.

- ^ Red Hat Inc (30 апреля 2014 г.). «Red Hat приобретает Inktank, поставщика Ceph» . Красная шляпа . Проверено 19 августа 2014 г.

- ^ «Консультационный совет сообщества Ceph» . 2015-10-28. Архивировано из оригинала 29 января 2019 г. Проверено 20 января 2016 г.

- ^ «Фонд Linux запускает Фонд Ceph для развития систем хранения данных с открытым исходным кодом» . 2018-11-12. [ постоянная мертвая ссылка ]

- ^ «SUSE говорит «tschüss» корпоративному продукту хранения данных на базе Ceph – с этого момента это Rancher's Longhorn» .

- ^ «Программно-определяемая система хранения данных SUSE Enterprise» .

- ^ Ceph.io — выпущена версия 16.2.0 Pacific.

- ^ Ceph.io — выпущена версия Quincy v17.2.0

- ^ Флорес, Лаура (6 августа 2023 г.). «Выпущена версия v18.2.0 Reef» . Блог Ceph . Проверено 26 августа 2023 г.

- ^ «Цеф для Windows» . Облачные решения . Проверено 2 июля 2023 г.

- ^ Пилот Алессандро. «Ceph в Windows» . Ютуб . Проверено 2 июля 2023 г.

Дальнейшее чтение

[ редактировать ]- М. Тим Джонс (4 мая 2010 г.). «Ceph: распределенная файловая система Linux петабайтного масштаба» . DeveloperWorks > Linux > Техническая библиотека . Проверено 6 мая 2010 г.

- Джеффри Б. Лейтон (20 апреля 2010 г.). «Ceph: существо распределенной файловой системы из лагуны объектов» . Журнал Линукс . Архивировано из оригинала 23 апреля 2010 года . Проверено 24 апреля 2010 г.

{{cite journal}}: CS1 maint: неподходящий URL ( ссылка ) - Карлос Мальцан; Эстебан Молина-Эстолано; Амандип Хурана; Алекс Дж. Нельсон; Скотт А. Брандт; Сейдж Вейл (август 2010 г.). «Ceph как масштабируемая альтернатива распределенной файловой системе Hadoop» . ;авторизоваться: . 35 (4) . Проверено 9 марта 2012 г.

- Мартин Лошвиц (24 апреля 2012 г.). «Хранилище объектов RADOS и файловая система Ceph» . Журнал HPC ADMIN . Проверено 25 апреля 2012 г.

Внешние ссылки

[ редактировать ]- Распределенные файловые системы, поддерживаемые ядром Linux.

- Сетевые файловые системы

- Программное обеспечение Red Hat

- Файловые системы пользовательского пространства

- Программное обеспечение виртуализации для Linux

- Бесплатное программное обеспечение, написанное на C++.

- Бесплатное программное обеспечение, написанное на Python.

- Программное обеспечение, использующее лицензию LGPL