Теория адаптивного резонанса

Теория адаптивного резонанса ( АРТ ) – это теория, разработанная Стивеном Гроссбергом и Гейл Карпентер и касающаяся аспектов того, как мозг обрабатывает информацию . В нем описывается ряд моделей искусственных нейронных сетей , которые используют контролируемые и неконтролируемые методы обучения и решают такие проблемы, как распознавание и прогнозирование образов .

Основная интуиция, лежащая в основе модели ART, заключается в том, что идентификация и распознавание объектов обычно происходят в результате взаимодействия ожиданий наблюдателя «сверху вниз» с сенсорной информацией «снизу вверх» . Модель постулирует, что ожидания «сверху вниз» принимают форму шаблона или прототипа памяти , который затем сравнивается с фактическими характеристиками объекта, обнаруженными органами чувств. Это сравнение порождает меру категориальной принадлежности. Пока эта разница между ощущением и ожиданием не превышает установленного порога, называемого «параметром бдительности», воспринимаемый объект будет считаться членом ожидаемого класса. Таким образом, система предлагает решение проблемы «пластичности/стабильности», то есть проблемы приобретения новых знаний без разрушения существующих знаний, что также называется инкрементальным обучением .

Модель обучения

[ редактировать ]

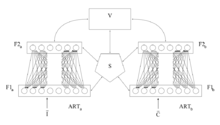

Базовая система ART представляет собой модель обучения без присмотра . Обычно оно состоит из поля сравнения и поля распознавания, состоящего из нейронов , параметра бдительности (порога распознавания) и модуля сброса .

- Поле сравнения принимает входной вектор (одномерный массив значений) и передает его наилучшему совпадению в поле распознавания.

- Его лучшим соответствием является одиночный нейрон, набор весов которого (весовой вектор) наиболее точно соответствует входному вектору.

- Каждый нейрон поля распознавания выводит отрицательный сигнал (пропорциональный качеству соответствия этого нейрона входному вектору) каждому из других нейронов поля распознавания и, таким образом, подавляет их выходной сигнал.

- Таким образом, поле распознавания демонстрирует латеральное торможение , позволяя каждому нейрону в нем представлять категорию, к которой классифицируются входные векторы.

- После того как входной вектор классифицирован, модуль сброса сравнивает силу совпадения распознавания с параметром бдительности.

- Если параметр бдительности превышен (т. е. входной вектор находится в пределах нормального диапазона, наблюдаемого для предыдущих входных векторов), то начинается обучение:

- Веса победившего нейрона распознавания корректируются с учетом особенностей входного вектора.

- В противном случае, если уровень совпадения ниже параметра бдительности (т.е. совпадение входного вектора находится за пределами нормального ожидаемого диапазона для этого нейрона), выигравший нейрон распознавания блокируется и выполняется процедура поиска.

- В этой процедуре поиска нейроны распознавания отключаются один за другим с помощью функции сброса до тех пор, пока параметр бдительности не будет преодолен при совпадении распознавания.

- В частности, на каждом цикле процедуры поиска выбирается и затем отключается наиболее активный нейрон распознавания, если его активация ниже параметра бдительности.

- (обратите внимание, что таким образом он освобождает оставшиеся нейроны распознавания от своего торможения).

- В этой процедуре поиска нейроны распознавания отключаются один за другим с помощью функции сброса до тех пор, пока параметр бдительности не будет преодолен при совпадении распознавания.

- Если ни один из зафиксированных нейронов распознавания не превышает параметр бдительности, то незафиксированный нейрон фиксируется, и его веса корректируются для соответствия входному вектору.

- Если параметр бдительности превышен (т. е. входной вектор находится в пределах нормального диапазона, наблюдаемого для предыдущих входных векторов), то начинается обучение:

- Параметр бдительности оказывает значительное влияние на систему: более высокая бдительность приводит к очень детальным воспоминаниям (многим более мелким категориям), тогда как более низкая бдительность приводит к более общим воспоминаниям (меньшее количество более общих категорий).

Обучение

[ редактировать ]Существует два основных метода обучения нейронных сетей на основе ART: медленный и быстрый. В методе медленного обучения степень обучения весов распознающего нейрона входному вектору рассчитывается до непрерывных значений с помощью дифференциальных уравнений и, таким образом, зависит от продолжительности времени представления входного вектора. При быстром обучении алгебраические уравнения для расчета степени корректировки веса используются и используются двоичные значения. Хотя быстрое обучение является эффективным и действенным для множества задач, метод медленного обучения более биологически правдоподобен и может использоваться с сетями с непрерывным временем (т. е. когда входной вектор может непрерывно меняться).

Типы

[ редактировать ]АРТ 1 [1] [2] — это простейшая разновидность сетей ART, принимающая только двоичные входы. АРТ 2 [3] расширяет возможности сети для поддержки непрерывного ввода. АРТ 2-А [4] представляет собой упрощенную версию ART-2 с значительно ускоренным временем выполнения и качественными результатами, лишь изредка уступающими полной реализации ART-2. АРТ 3 [5] основывается на ART-2 путем моделирования рудиментарной нейромедиаторной регуляции синаптической активности путем включения моделируемых концентраций ионов натрия (Na+) и кальция (Ca2+) в уравнения системы, что приводит к более физиологически реалистичным средствам частичного подавления категорий, которые запускают сброс несоответствий.

АРТМАП [6] также известный как Predictive ART , объединяет два слегка модифицированных блока ART-1 или ART-2 в контролируемую структуру обучения, где первый блок принимает входные данные, а второй блок принимает правильные выходные данные, которые затем используются для минимально возможной корректировки параметр бдительности в первом блоке, чтобы сделать правильную классификацию.

Нечеткое ИСКУССТВО [7] реализует нечеткую логику в распознавании образов ART, тем самым повышая возможность обобщения. Дополнительной (и очень полезной) функцией нечеткого ART является дополнительное кодирование, средство включения отсутствия признаков в классификации шаблонов, что имеет большое значение для предотвращения неэффективного и ненужного увеличения категорий. Применяемые меры сходства основаны на норме L1 . Известно, что Fuzzy ART очень чувствителен к шуму.

Нечеткое АРТМАП [8] представляет собой просто ARTMAP с использованием нечетких единиц ART, что приводит к соответствующему увеличению эффективности.

Упрощенное нечеткое ARTMAP (SFAM) [9] представляет собой сильно упрощенный вариант нечеткого ARTMAP, предназначенный для классификации задач .

Гауссово АРТ [10] и гауссовская ARTMAP [10] использовать гауссовы функции активации и вычисления, основанные на теории вероятностей. Поэтому они имеют некоторое сходство с моделями гауссовой смеси . По сравнению с нечетким ART и нечетким ARTMAP они менее чувствительны к шуму. Но стабильность изученных представлений снижается, что может привести к увеличению количества категорий в открытых учебных задачах.

Fusion ART и связанные с ним сети [11] [12] [13] расширить ART и ARTMAP на несколько каналов шаблонов. Они поддерживают несколько парадигм обучения, включая обучение без учителя, обучение с учителем и обучение с подкреплением.

ТопоАРТ [14] сочетает в себе нечеткое ART с сетями обучения топологии, такими как растущий нейронный газ . Кроме того, он добавляет механизм шумоподавления. Существует несколько производных нейронных сетей, которые расширяют TopoART для дальнейших парадигм обучения.

Гиперсферное АРТ [15] и гиперсфера ARTMAP [15] тесно связаны с нечетким ART и нечетким ARTMAP соответственно. Но поскольку они используют другой тип представления категорий (а именно гиперсферы), они не требуют нормализации входных данных к интервалу [0, 1]. Они применяют меры сходства, основанные на норме L2 .

ЧАСТЬ [16] Нейронные сети теории латерального адаптивного резонанса (LAPART) объединяют два алгоритма Fuzzy ART для создания механизма прогнозирования на основе изученных ассоциаций. Соединение двух Fuzzy ART обладает уникальной стабильностью, которая позволяет системе быстро сходиться к четкому решению. Кроме того, он может выполнять логический вывод и контролируемое обучение, аналогично нечеткому ARTMAP.

Критика

[ редактировать ]Этот раздел нуждается в расширении . Вы можете помочь, добавив к нему . ( сентябрь 2015 г. ) |

Было отмечено, что результаты Fuzzy ART и ART 1 (т.е. изученные категории) критически зависят от порядка, в котором обрабатываются обучающие данные. Эффект можно в некоторой степени уменьшить, используя более медленную скорость обучения, но он присутствует независимо от размера набора входных данных. Следовательно, нечеткие оценки ART и ART 1 не обладают статистическим свойством согласованности . [17] Эту проблему можно рассматривать как побочный эффект соответствующих механизмов, обеспечивающих стабильное обучение в обеих сетях.

Более продвинутые сети ART, такие как TopoART и Hypersphere TopoART, которые суммируют категории в кластеры, могут решить эту проблему, поскольку формы кластеров не зависят от порядка создания связанных категорий. (ср. рис. 3(ж, з) и рис. 4 [18] )

Ссылки

[ редактировать ]- ^ Карпентер, Г.А. и Гроссберг, С. (2003), Теория адаптивного резонанса, заархивировано 19 мая 2006 г. в Wayback Machine , В книге Майкла А. Арбиба (ред.), Справочник по теории мозга и нейронных сетей, второе издание (стр. . 87-90). Кембридж, Массачусетс: MIT Press

- ^ Гроссберг, С. (1987), Конкурентное обучение: от интерактивной активации к адаптивному резонансу. Архивировано 7 сентября 2006 г. в Wayback Machine , Cognitive Science (журнал) , 11, 23-63.

- ^ Карпентер, Г.А. и Гроссберг, С. (1987), ИСКУССТВО 2: Самоорганизация стабильных кодов распознавания категорий для шаблонов аналогового ввода. Архивировано 4 сентября 2006 г. в Wayback Machine , Applied Optics , 26 (23), 4919-4930.

- ^ Карпентер Г.А., Гроссберг С. и Розен Д.Б. (1991a), ART 2-A: Алгоритм адаптивного резонанса для быстрого обучения и распознавания категорий. Архивировано 19 мая 2006 г. в Wayback Machine , Neural Networks , 4, 493. -504

- ^ Карпентер, Г.А. и Гроссберг, С. (1990), ИСКУССТВО 3: Иерархический поиск с использованием химических передатчиков в самоорганизующихся архитектурах распознавания образов. Архивировано 6 сентября 2006 г. в Wayback Machine , Neural Networks , 3, 129-152.

- ^ Карпентер, Г.А., Гроссберг, С., и Рейнольдс, Дж.Х. (1991), ARTMAP: контролируемое обучение в реальном времени и классификация нестационарных данных с помощью самоорганизующейся нейронной сети. Архивировано 19 мая 2006 г. в Wayback Machine , нейронные сети. , 4, 565-588

- ^ Карпентер Г.А., Гроссберг С. и Розен Д.Б. (1991b), Fuzzy ART: Быстрое стабильное обучение и категоризация аналоговых паттернов с помощью адаптивной резонансной системы. Архивировано 19 мая 2006 г. в Wayback Machine , Neural Networks , 4, 759-771

- ^ Карпентер Г.А., Гроссберг С., Маркузон Н., Рейнольдс Дж. Х. и Розен Д.Б. (1992), Fuzzy ARTMAP: архитектура нейронной сети для постепенного контролируемого обучения аналоговых многомерных карт. Архивировано 19 мая 2006 г. в Wayback Machine , Транзакции IEEE в нейронных сетях , 3, 698-713

- ^ Мохаммад-Таги Вакил-Багмише и Никола Павешич. (2003) Быстрая упрощенная нечеткая сеть ARTMAP, Письма о нейронной обработке, 17 (3): 273–316.

- ^ Jump up to: а б Джеймс Р. Уильямсон. (1996), Gaussian ARTMAP: нейронная сеть для быстрого постепенного обучения зашумленных многомерных карт , Neural Networks, 9(5):881-897

- ^ Ю. Р. Асфур, Г. А. Карпентер, С. Гроссберг и Г. В. Лешер. (1993) Fusion ARTMAP: адаптивная нечеткая сеть для многоканальной классификации . В: Материалы Третьей Международной конференции по промышленному нечеткому управлению и интеллектуальным системам (IFIS).

- ^ Тан, А.-Х.; Карпентер, Джорджия; Гроссберг, С. (2007). «Интеллект через взаимодействие: на пути к единой теории обучения» . Ин Лю, Д.; Фей, С.; Хоу, З.-Г.; Чжан, Х.; Сан, К. (ред.). Достижения в области нейронных сетей – ISNN 2007 . Конспекты лекций по информатике. Том. 4491. Берлин, Гейдельберг: Springer. стр. 1094–1103. дои : 10.1007/978-3-540-72383-7_128 . ISBN 978-3-540-72383-7 .

- ^ Тан, А.-Х.; Субагджа, Б.; Ван, Д.; Мэн, Л. (2019). «Самоорганизующиеся нейронные сети для универсального обучения и мультимодального кодирования памяти» . Нейронные сети . 120 : 58–73. дои : 10.1016/j.neunet.2019.08.020 . ПМИД 31537437 . S2CID 202703163 .

- ^ Марко Черепанов. (2010) TopoART: Иерархическая сеть ART с изучением топологии , В: Материалы Международной конференции по искусственным нейронным сетям (ICANN), Часть III, LNCS 6354, 157-167.

- ^ Jump up to: а б Георгиос К. Анагностопулос и Майкл Георгиопулос. (2000), Hypersphere ART и ARTMAP для неконтролируемого и контролируемого постепенного обучения , В: Proceedings of the International Joint Conference on Neural Networks (IJCNN), vol. 6, 59-64

- ^ Национальные лаборатории Сандии (2017) Документация по Lapart-python

- ^ Сарл, Уоррен С. (1995), Почему статистикам не следует FART. Архивировано 20 июля 2011 г., в Wayback Machine.

- ^ Марко Черепанов. (2012) Инкрементальная онлайн-кластеризация с иерархической нейронной сетью ART с обучением топологии с использованием гиперсферических категорий , В: Плакат и отраслевые материалы Промышленной конференции по интеллектуальному анализу данных (ICDM), 22–34

Вассерман, Филип Д. (1989), Нейронные вычисления: теория и практика, Нью-Йорк: Ван Ностранд Рейнхольд, ISBN 0-442-20743-3

Внешние ссылки

[ редактировать ]- Стивена Гроссберга сайт

- Внедрение ART для обучения без присмотра (ART 1, ART 2A, ART 2A-C и ART дистанционно)

- Краткое описание алгоритма ART

- LibTopoART — реализации TopoART для контролируемого и неконтролируемого обучения (TopoART, TopoART-AM, TopoART-C, TopoART-R, эпизодический TopoART, Hypersphere TopoART и Hypersphere TopoART-C)