Метод информационного узкого места

Метод информационного узкого места — это метод теории информации, предложенный Нафтали Тишби , Фернандо К. Перейрой и Уильямом Биалеком . [1] Он предназначен для поиска наилучшего компромисса между точностью и сложностью ( сжатием ) при суммировании (например, кластеризации ) случайной величины X с учетом совместного распределения вероятностей p(X,Y) между X и наблюдаемой соответствующей переменной Y - и самоописываемого как предоставление «удивительно богатой основы для обсуждения множества проблем обработки и обучения сигналов» . [1]

Приложения включают распределенную кластеризацию и уменьшение размерностей , а в последнее время это было предложено в качестве теоретической основы для глубокого обучения . Он обобщил классическое понятие минимальной достаточной статистики с параметрической статистики на произвольные распределения, не обязательно экспоненциальной формы. Это достигается за счет ослабления условия достаточности для захвата некоторой доли взаимной информации с помощью соответствующей переменной Y .

Информационное узкое место также можно рассматривать как проблему искажения скорости с функцией искажения, которая измеряет, насколько хорошо Y прогнозируется на основе сжатого представления T по сравнению с его прямым прогнозированием на основе X . Эта интерпретация обеспечивает общий итерационный алгоритм для решения проблемы информационного узкого места и расчета информационной кривой на основе распределения p(X,Y) .

Пусть сжатое представление задается случайной величиной . Алгоритм минимизирует следующий функционал относительно условного распределения :

где и являются взаимной информацией и и из и соответственно и является множителем Лагранжа .

Теория обучения для глубокого обучения

[ редактировать ]Математически доказано, что контроль узких мест в информации является одним из способов контроля ошибок обобщения в глубоком обучении. [2] А именно, доказано, что ошибка обобщения масштабируется как где количество обучающих выборок, является входными данными для глубокой нейронной сети, а это результат скрытого слоя. Это обобщение связано со степенью узкого места в информации, в отличие от других границ обобщения, которые масштабируются с количеством параметров, размерностью VC , сложностью Радемахера , стабильностью или надежностью.

Фазовые переходы

[ редактировать ]Этот раздел пуст. Вы можете помочь, добавив к нему . ( декабрь 2018 г. ) |

Информационная теория глубокого обучения

[ редактировать ]Теория информационных узких мест недавно использовалась для изучения глубоких нейронных сетей (DNN). [3] Учитывать и соответственно как входной и выходной слои DNN, и пусть быть любым скрытым слоем сети. Шварц-Зив и Тишби предложили информационное узкое место, которое отражает компромисс между мерами взаимного информирования. и . В этом случае, и соответственно количественно оценить объем информации, которую содержит скрытый слой о входных и выходных данных.Они предположили, что процесс обучения DNN состоит из двух отдельных этапов; 1) начальная фаза подгонки, на которой увеличивается, и 2) последующая фаза сжатия, в которой уменьшается. Сакс и др. в [4] опроверг иск Шварц-Зива и Тишби, [3] заявив, что это явление сжатия в DNN не является всеобъемлющим и зависит от конкретной функции активации. В частности, они утверждали, что при использовании функций активации ReLu сжатие не происходит. Шварц-Зив и Тишби оспорили эти утверждения, утверждая, что Сакс и др. не наблюдал сжатия из-за слабых оценок взаимной информации. Недавно Ношад и др. использовал оптимальную по скорости оценку взаимной информации, чтобы исследовать это противоречие, отметив, что оптимальная оценка на основе хэша выявляет явление сжатия в более широком диапазоне сетей с активациями ReLu и maxpooling. [5] С другой стороны, недавно Goldfeld et al. утверждали, что наблюдаемое сжатие является результатом геометрических, а не теоретико-информационных явлений. [6] точка зрения, которая была распространена также в. [7]

Вариационное узкое место

[ редактировать ]Этот раздел пуст. Вы можете помочь, добавив к нему . ( декабрь 2018 г. ) |

Гауссово узкое место

[ редактировать ]Гауссово узкое место, [8] а именно, применение подхода к информационным узким местам к гауссовским переменным приводит к решениям, связанным с каноническим корреляционным анализом. Предполагать являются совместно многомерными нормальными векторами с нулевым средним значением с ковариациями и представляет собой сжатую версию которые должны поддерживать заданную ценность взаимной информации с . Можно показать, что оптимум — нормальный вектор, состоящий из линейных комбинаций элементов где матрица имеет ортогональные строки.

Матрица проекции на самом деле содержит строки, выбранные из взвешенных левых собственных векторов сингулярного разложения матрицы (обычно асимметричных)

Определите разложение по сингулярным значениям

и критические значения

тогда число активных собственных векторов в проекции или порядке приближения определяется выражением

И мы наконец получаем

В котором веса задаются выражением

где

Применение узкого места гауссовой информации к временным рядам (процессам) дает решения, связанные с оптимальным прогнозирующим кодированием. Эта процедура формально эквивалентна линейному анализу медленных функций. [9]

Оптимальные временные структуры в линейных динамических системах могут быть обнаружены с помощью так называемого информационного узкого места прошлого будущего - применения метода узкого места к негауссовым выборочным данным. [10] Эта концепция, как ее трактовали Крейциг, Тишби и др., не лишена сложностей, поскольку в этом упражнении есть два независимых этапа: во-первых, оценка неизвестных родительских плотностей вероятностей, из которых извлекаются выборки данных, и, во-вторых, использование этих плотностей в рамках теоретическая информационная основа узкого места.

Оценка плотности

[ редактировать ]Поскольку метод «узких мест» сформулирован в вероятностных, а не статистических терминах, основная плотность вероятности в точках выборки необходимо оценить. Это хорошо известная проблема с множеством решений, описанная Сильверманом . [11] В настоящем методе вероятности совместной выборки находятся с использованием метода матрицы переходов Маркова , и это имеет некоторую математическую синергию с самим методом узкого места.

Произвольно возрастающая метрика расстояния между всеми парами выборок и расстояний матрицей . Тогда вероятности перехода между парами выборок для некоторых необходимо вычислить. Обработка выборок как состояний и нормализованной версии как матрица вероятности перехода марковского состояния, вектор вероятностей «состояний» после шаги, обусловленные исходным состоянием , является . Вектор равновесной вероятности задается обычным образом доминирующим собственным вектором матрицы который не зависит от инициализирующего вектора . Этот метод перехода Маркова устанавливает вероятность в точках выборки, которая, как утверждается, пропорциональна плотности вероятностей там.

Другие интерпретации использования собственных значений матрицы расстояний обсуждаются в книге Сильвермана «Оценка плотности для статистики и анализа данных» . [11]

Кластеры

[ редактировать ]В следующем примере мягкой кластеризации опорный вектор содержит выборочные категории и совместную вероятность предполагается известным. Мягкий кластер определяется распределением вероятностей по выборкам данных . Тишби и др. представлен [1] следующий итерационный набор уравнений для определения кластеров, которые в конечном итоге являются обобщением алгоритма Блахута-Аримото , разработанного в теории искажений скорости . Применение этого типа алгоритма в нейронных сетях, по-видимому, связано с аргументами в пользу энтропии, возникающими при применении распределений Гиббса в детерминистическом отжиге. [12] [13]

Функция каждой строки итерации расширяется как

Строка 1: Это матричный набор условных вероятностей.

Расхождение Кульбака – Лейблера между векторы, созданные на основе выборочных данных и те, которые генерируются его сокращенным информационным прокси применяется для оценки точности сжатого вектора по отношению к эталонным (или категориальным) данным. в соответствии с фундаментальным уравнением узкого места. – это расхождение Кульбака – Лейблера между распределениями

и является скалярной нормализацией. Взвешивание по отрицательному показателю расстояния означает, что вероятности предшествующих кластеров уменьшаются в строке 1, когда расхождение Кульбака – Лейблера велико, таким образом, вероятность успешных кластеров увеличивается, а неудачных - распада.

Строка 2: Второй матричный набор условных вероятностей. По определению

где тождества Байеса используются.

Строка 3: эта линия находит предельное распределение кластеров.

Это стандартный результат.

Дополнительными входными данными для алгоритма являются предельное распределение выборки. который уже определен доминирующим собственным вектором и матричная функция дивергенции Кульбака–Лейблера

полученные на основе интервалов между образцами и вероятностей перехода.

Матрица может быть инициализирован случайным образом или с разумным предположением, в то время как матрица не требует никаких предварительных значений. Хотя алгоритм сходится, может существовать несколько минимумов, которые необходимо будет разрешить. [14]

Определение контуров решений

[ редактировать ]Чтобы классифицировать новый образец внешний по отношению к обучающему набору , предыдущая метрика расстояния находит вероятности перехода между и все образцы в , с нормализация. Во-вторых, примените последние две строки трехстрочного алгоритма, чтобы получить вероятности кластера и условной категории.

Окончательно

Параметр должна находиться под пристальным наблюдением, поскольку по мере ее увеличения от нуля все большее число признаков в вероятностном пространстве категорий фокусируется на определенных критических порогах.

Пример

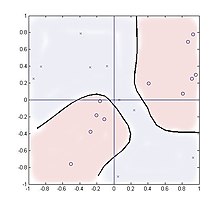

[ редактировать ]В следующем случае рассматривается кластеризация в четырехквадрантном множителе со случайными входными данными. и две категории продукции, , созданный . Эта функция имеет два пространственно разделенных кластера для каждой категории и, таким образом, демонстрирует, что метод может обрабатывать такие распределения.

Отбирают 20 проб, равномерно распределенных по площади. . Количество используемых кластеров помимо количества категорий (в данном случае двух) мало влияет на производительность, и результаты отображаются для двух кластеров с использованием параметров. .

Функция расстояния где в то время как условное распределение представляет собой матрицу 2 × 20

и ноль в другом месте.

Суммирование в строке 2 включает только два значения, представляющие обучающие значения +1 или -1, но, тем не менее, работает хорошо. На рисунке показано расположение двадцати образцов, где «0» представляет Y = 1, а «x» представляет Y = -1. Показан контур на уровне отношения правдоподобия единицы:

как новый образец сканируется по площади. Теоретически контур должен совпадать с и координаты, но для такого малого количества выборок вместо этого они следовали ложным кластерам точек выборки.

Аналогии с нейронными сетями и нечеткой логикой

[ редактировать ]Этот алгоритм чем-то похож на нейронную сеть с одним скрытым слоем. Внутренние узлы представлены кластерами а первый и второй слои весов сети — это условные вероятности и соответственно. Однако, в отличие от стандартной нейронной сети, алгоритм полностью полагается на вероятности в качестве входных данных, а не на сами выборочные значения, в то время как все внутренние и выходные значения представляют собой условные распределения плотности вероятности. Нелинейные функции инкапсулированы в метрике расстояния. (или функции влияния/радиальные базисные функции ) и вероятности перехода вместо сигмовидных функций .

Трехстрочный алгоритм Блахута-Аримото сходится быстро, часто за десятки итераций, и при варьировании , и и мощности кластеров, можно достичь различных уровней внимания к функциям.

Определение статистической мягкой кластеризации имеет некоторое совпадение с концепцией вербального нечеткого членства нечеткой логики .

Расширения

[ редактировать ]Интересным расширением является случай информационного узкого места с дополнительной информацией. [15] Здесь информация максимизируется об одной целевой переменной и минимизируется о другой, создавая представление, которое информативно об выбранных аспектах данных. Формально

Библиография

[ редактировать ]- Вайс, Ю. (1999), «Сегментация с использованием собственных векторов: объединяющий взгляд», Труды Международной конференции IEEE по компьютерному зрению (PDF) , стр. 975–982.

- П. Харремос и Н. Тишби «Возвращение к узкому месту в информации или как выбрать хороший показатель искажения». В материалах Международного симпозиума по теории информации (ISIT) 2007 г.

Ссылки

[ редактировать ]- ^ Jump up to: а б с Тишби, Нафтали ; Перейра, Фернандо К.; Бялек, Уильям (сентябрь 1999 г.). Метод информационных узких мест (PDF) . 37-я ежегодная Аллертонская конференция по связи, управлению и вычислениям. стр. 368–377.

- ^ Кенджи Кавагути, Чжунь Дэн, Сюй Цзи, Цзяоян Хуан. «Как узкое место в информации помогает глубокому обучению?» Материалы 40-й Международной конференции по машинному обучению, PMLR 202: 16049-16096, 2023.

- ^ Jump up to: а б Шварц-Зив, Равид; Тишби, Нафтали (2017). «Открытие черного ящика глубоких нейронных сетей с помощью информации». arXiv : 1703.00810 [ cs.LG ].

- ^ Эндрю М, Саксен; и др. (2018). «О теории информационных узких мест глубокого обучения» . Слепая подача заявок на конференцию ICLR 2018 . 2019 (12): 124020. Бибкод : 2019JSMTE..12.4020S . дои : 10.1088/1742-5468/ab3985 . S2CID 49584497 .

- ^ Ношад, Мортеза; и др. (2018). «Масштабируемая взаимная оценка информации с использованием графиков зависимостей». arXiv : 1801.09125 [ cs.IT ].

- ^ Гольдфельд, Зив; и др. (2019). «Оценка информационного потока в глубоких нейронных сетях» . Icml 2019 : 2299–2308. arXiv : 1810.05728 .

- ^ Гейгер, Бернхард К. (2022). «Анализ классификаторов нейронных сетей в информационной плоскости — обзор». Транзакции IEEE в нейронных сетях и системах обучения . 33 (12): 7039–7051. arXiv : 2003.09671 . дои : 10.1109/TNNLS.2021.3089037 . ПМИД 34191733 . S2CID 214611728 .

- ^ Чечик, Гал; Глоберсон, Амир; Тишби, Нафтали; Вайс, Яир (1 января 2005 г.). Даян, Питер (ред.). «Информационное узкое место для гауссовских переменных» (PDF) . Журнал исследований машинного обучения (6) (опубликовано 1 мая 2005 г.): 165–188.

- ^ Крейциг, Феликс ; Шпрекелер, Хеннинг (17 декабря 2007 г.). «Прогнозирующее кодирование и принцип медлительности: теоретико-информационный подход». Нейронные вычисления . 20 (4): 1026–1041. CiteSeerX 10.1.1.169.6917 . дои : 10.1162/neco.2008.01-07-455 . ISSN 0899-7667 . ПМИД 18085988 . S2CID 2138951 .

- ^ Крейциг, Феликс; Глоберсон, Амир; Тишби, Нафтали (27 апреля 2009 г.). «Узкое место информации о прошлом будущем в динамических системах». Физический обзор E . 79 (4): 041925. Бибкод : 2009PhRvE..79d1925C . дои : 10.1103/PhysRevE.79.041925 . ПМИД 19518274 .

- ^ Jump up to: а б Сильверман, Берни (1986). Оценка плотности для статистики и анализа данных . Чепмен и Холл. Бибкод : 1986desd.book.....S . ISBN 978-0412246203 .

{{cite book}}:|journal=игнорируется ( помогите ) - ^ Слоним, Ноам; Тишби, Нафтали (01.01.2000). «Кластеризация документов с использованием кластеров слов с помощью метода информационного узкого места». Материалы 23-й ежегодной международной конференции ACM SIGIR по исследованиям и разработкам в области информационного поиска . СИГИР '00. Нью-Йорк, штат Нью-Йорк, США: ACM. стр. 208–215. CiteSeerX 10.1.1.21.3062 . дои : 10.1145/345508.345578 . ISBN 978-1-58113-226-7 . S2CID 1373541 .

- ^ DJ Миллер, А. В. Рао, К. Роуз, А. Гершо: «Теоретико-информационный алгоритм обучения для классификации нейронных сетей». НИПС 1995: стр. 591–597.

- ^ Тишби, Нафтали ; Слоним, Н. Кластеризация данных методом марковской релаксации и метода информационных узких мест (PDF) . Нейронные системы обработки информации (NIPS) 2000. стр. 640–646.

- ^ Чечик, Гал; Тишби, Нафтали (2002). «Извлечение соответствующих структур с дополнительной информацией» (PDF) . Достижения в области нейронных систем обработки информации : 857–864.

![{\displaystyle A=[w_{1}U_{1},\dots ,w_{M}U_{M}]^{T}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2452fbcc21043b263e6427f67922d2f3794ed0da)

![{\displaystyle {\begin{cases}p(c|x)=Kp(c)\exp {\Big (}-\beta \,D^{KL}{\Big [}p(y|x)\, ||\,p(y|c){\Big ]}{\Big )}\\p(y|c)=\textstyle \sum _{x}p(y|x)p(c|x)p (x){\big /}p(c)\\p(c)=\textstyle \sum _{x}p(c|x)p(x)\\\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f9b29faec038fbb2da40e4ba191be82a2fd73760)

![{\displaystyle A_{i,j}=p(c_{i}|x_{j})=Kp(c_{i})\exp {\Big (}-\beta \,D^{KL}{\Big [}p(y|x_{j})\,||\,p(y|c_{i}){\Big ]}{\Big )}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6f287e6823ebfa39f521fe993a875691ff778fdc)

![{\displaystyle D_{i,j}^{KL}=D^{KL}{\Big [}p(y|x_{j})\,||\,p(y|c_{i}){\ Большой ]}{\Большой )}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3589cf4b3fe5eeb605388c57058dfb558db84576)

![{\displaystyle [-1,1]^{2}\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a4376d6f93ed4561418bc9e39a4992b97da77bc0)