Гипотеза многообразия

Гипотеза многообразия утверждает, что многие многомерные наборы данных, которые встречаются в реальном мире, на самом деле лежат вдоль скрытых многообразий низкой размерности внутри этого многомерного пространства. [1] [2] [3] [4] Как следствие гипотезы многообразия, многие наборы данных, которые изначально требуют для описания множества переменных, на самом деле могут быть описаны сравнительно небольшим количеством переменных, сравнимых с локальной системой координат основного многообразия. Предполагается, что этот принцип лежит в основе эффективности алгоритмов машинного обучения при описании наборов данных большой размерности за счет рассмотрения нескольких общих особенностей.

Гипотеза многообразия связана с эффективностью методов нелинейного уменьшения размерности в машинном обучении. Многие методы уменьшения размерностей предполагают, что данные лежат вдоль подмногообразия низкой размерности, такие как моделирование многообразия , выравнивание многообразия и регуляризация многообразия .

Основное значение этой гипотезы состоит в том, что

- Модели машинного обучения должны соответствовать только относительно простым, маломерным, высокоструктурированным подпространствам в их потенциальном входном пространстве (скрытые многообразия).

- Внутри одного из этих многообразий всегда можно интерполировать между двумя входными данными, то есть преобразовать одно в другое по непрерывному пути, по которому все точки попадают на многообразие.

Возможность интерполяции между выборками является ключом к обобщению в глубоком обучении . [5]

геометрия статистических многообразий Информационная

Эмпирически мотивированный подход к гипотезе многообразия фокусируется на ее соответствии с эффективной теорией многообразного обучения при предположении, что надежное машинное обучение требует кодирования интересующего набора данных с использованием методов сжатия данных. Эта перспектива постепенно возникла с использованием инструментов информационной геометрии благодаря скоординированным усилиям ученых, работающих над гипотезой эффективного кодирования , прогнозирующим кодированием и вариационными байесовскими методами .

Аргумент в пользу рассуждений об информационной геометрии в скрытом пространстве распределений основан на существовании и единственности информационной метрики Фишера . [6] В этой общей ситуации мы пытаемся найти стохастическое вложение статистического многообразия. С точки зрения динамических систем, в режиме больших данных это многообразие обычно демонстрирует определенные свойства, такие как гомеостаз:

- Мы можем выбирать большие объемы данных из основного генеративного процесса.

- Эксперименты по машинному обучению воспроизводимы, поэтому статистика процесса генерации демонстрирует стационарность.

В смысле, уточненном нейробиологами-теоретиками, работающими над принципом свободной энергии , рассматриваемое статистическое многообразие обладает марковским одеялом . [7]

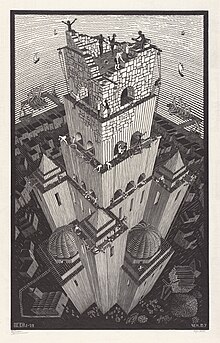

Парадокс Вавилонской башни [ править ]

Как глобальные коды возникают из локальных кодов, если глобальное кодирование необходимо для возникновения синхронизации в больших нейронных сетях?

Фундаментальной проблемой, с которой сталкивается любой биологически правдоподобный алгоритм многообразного обучения, является парадокс Вавилонской башни Ромена Бретта. [8] для гипотезы эффективного кодирования :

Гипотеза эффективного кодирования предполагает, что нейроны кодируют сигналы в последовательности импульсов эффективным способом, то есть используют такой код, при котором вся избыточность удаляется из исходного сообщения, сохраняя при этом информацию, в том смысле, что закодированное сообщение может быть отображено обратно в исходное сообщение (Барлоу, 1961; Симончелли, 2003). Это означает, что при идеально эффективном коде закодированные сообщения неотличимы от случайных. Поскольку код определяется на основе статистики входов и передаются только закодированные сообщения, код эффективен в той степени, в которой он непонятен получателю. В этом парадокс эффективного кода.

В метафоре нейронного кодирования код является личным и специфичным для каждого нейрона. Если следовать этой метафоре, это означает, что все нейроны говорят на разном языке, языке, который позволяет очень кратко выражать понятия, но который никто другой не может понять. Таким образом, согласно метафоре кодирования, мозг — это Вавилонская башня.

Тезисы прогнозирующего и эффективного кодирования предсказывают, что каждый нейрон имеет свой собственный эффективный код, полученный посредством вывода максимальной энтропии. Мы можем думать об этих местных кодах как об отдельных языках. Затем Бретт предполагает, что, поскольку каждый нейрон имеет язык, неотличимый от случайного по отношению к его соседям, глобальное кодирование должно быть невозможным.

Ссылки [ править ]

- ^ Горбань, АН; Тюкин, И.Ю. (2018). «Благословение размерности: математические основы статистической физики данных» . Фил. Пер. Р. Сок. А. 15 (3): 20170237. Бибкод : 2018RSPTA.37670237G . дои : 10.1098/rsta.2017.0237 . ПМК 5869543 . ПМИД 29555807 .

- ^ Кейтон, Л. (2005). Алгоритмы многообразного обучения (PDF) (Технический отчет). Калифорнийский университет в Сан-Диего. п. 1. 12 (1–17).

- ^ Фефферман, Чарльз; Миттер, Санджой; Нараянан, Харихаран (9 февраля 2016 г.). «Проверка гипотезы многообразия» . Журнал Американского математического общества . 29 (4): 983–1049. arXiv : 1310.0425 . дои : 10.1090/jams/852 . S2CID 50258911 .

- ^ Ола, Кристофер (2014). «Блог: нейронные сети, многообразия и топология» .

- ^ Шолле, Франсуа (2021). Глубокое обучение с помощью Python (2-е изд.). Мэннинг . стр. 128–129. ISBN 9781617296864 .

- ^ Катича, Ариэль (2015). Геометрия из информационной геометрии . MaxEnt 2015, 35-й международный семинар по байесовскому выводу и методам максимальной энтропии в науке и технике. arXiv : 1512.09076 .

- ^ Кирхгоф, Майкл; Парр, Томас; Паласиос, Энсор; Фристон, Карл; Киверштейн, Джулиан (2018). «Марковские одеяла жизни: автономия, активный вывод и принцип свободной энергии» . JR Soc. Интерфейс . 15 (138): 20170792. doi : 10.1098/rsif.2017.0792 . ПМК 5805980 . ПМИД 29343629 .

- ↑ Бретт, Р., 7 декабря 2017 г. Парадокс эффективного кода и нейронная вавилонская башня [сообщение в блоге]. Получено с http://romainbrette.fr/what-is-computational-neuroscience-xxvii-the-paradox-of-the-efficient-code-and-the-neural-tower-of-babel/.

Дальнейшее чтение [ править ]

- Браун, Брэдли, Калифорния; Катерини, Энтони Л.; Росс, Брендан Ли; Крессвелл, Джесси С.; Лоаиза-Ганем, Габриэль (2023). Гипотеза объединения многообразий и ее последствия для глубокого генеративного моделирования . Одиннадцатая международная конференция по обучению представлений. arXiv : 2207.02862 .

- Ли, Ёнхён (2023). Геометрический взгляд на автоэнкодеры . arXiv : 2309.08247 .