Машинное обучение

| Часть серии о |

| Машинное обучение и интеллектуальный анализ данных |

|---|

| Part of a series on |

| Artificial intelligence |

|---|

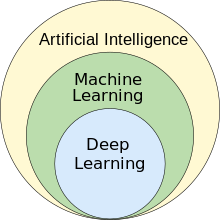

Машинное обучение ( МО ) — это область исследования искусственного интеллекта , связанная с разработкой и изучением статистических алгоритмов , которые могут учиться на данных и обобщать их на невидимые данные и, таким образом, выполнять задачи без явных инструкций . [1] В последнее время искусственные нейронные сети смогли превзойти по производительности многие предыдущие подходы. [2] [3]

Машинное обучение находит применение во многих областях, включая обработку естественного языка , компьютерное зрение , распознавание речи , фильтрацию электронной почты , сельское хозяйство и медицину. [4] [5] Применительно к бизнес-задачам она известна под названием прогнозной аналитики . Хотя не все машинное обучение основано на статистике , вычислительная статистика является важным источником методов в этой области.

Математические основы ML обеспечивают методы математической оптимизации (математического программирования). Интеллектуальный анализ данных — это смежная (параллельная) область исследований, в которой основное внимание уделяется исследовательскому анализу данных (EDA) посредством обучения без учителя . [7] [8]

С теоретической точки зрения, вероятно, приблизительно правильное (PAC) обучение обеспечивает основу для описания машинного обучения.

История [ править ]

The term machine learning was coined in 1959 by Arthur Samuel, an IBM employee and pioneer in the field of computer gaming and artificial intelligence.[9][10] The synonym self-teaching computers was also used in this time period.[11][12]

Although the earliest machine learning model was introduced in the 1950s when Arthur Samuel invented a program that calculated the winning chance in checkers for each side, the history of machine learning roots back to decades of human desire and effort to study human cognitive processes.[13] In 1949, Canadian psychologist Donald Hebb published the book The Organization of Behavior, in which he introduced a theoretical neural structure formed by certain interactions among nerve cells.[14] Hebb's model of neurons interacting with one another set a groundwork for how AIs and machine learning algorithms work under nodes, or artificial neurons used by computers to communicate data.[13] Other researchers who have studied human cognitive systems contributed to the modern machine learning technologies as well, including logician Walter Pitts and Warren McCulloch, who proposed the early mathematical models of neural networks to come up with algorithms that mirror human thought processes.[13]

By the early 1960s an experimental "learning machine" with punched tape memory, called Cybertron, had been developed by Raytheon Company to analyze sonar signals, electrocardiograms, and speech patterns using rudimentary reinforcement learning. It was repetitively "trained" by a human operator/teacher to recognize patterns and equipped with a "goof" button to cause it to re-evaluate incorrect decisions.[15] A representative book on research into machine learning during the 1960s was Nilsson's book on Learning Machines, dealing mostly with machine learning for pattern classification.[16] Interest related to pattern recognition continued into the 1970s, as described by Duda and Hart in 1973.[17] In 1981 a report was given on using teaching strategies so that an artificial neural network learns to recognize 40 characters (26 letters, 10 digits, and 4 special symbols) from a computer terminal.[18]

Tom M. Mitchell provided a widely quoted, more formal definition of the algorithms studied in the machine learning field: "A computer program is said to learn from experience E with respect to some class of tasks T and performance measure P if its performance at tasks in T, as measured by P, improves with experience E."[19] This definition of the tasks in which machine learning is concerned offers a fundamentally operational definition rather than defining the field in cognitive terms. This follows Alan Turing's proposal in his paper "Computing Machinery and Intelligence", in which the question "Can machines think?" is replaced with the question "Can machines do what we (as thinking entities) can do?".[20]

Modern-day machine learning has two objectives. One is to classify data based on models which have been developed; the other purpose is to make predictions for future outcomes based on these models. A hypothetical algorithm specific to classifying data may use computer vision of moles coupled with supervised learning in order to train it to classify the cancerous moles. A machine learning algorithm for stock trading may inform the trader of future potential predictions.[21]

Relationships to other fields[edit]

Artificial intelligence[edit]

As a scientific endeavor, machine learning grew out of the quest for artificial intelligence (AI). In the early days of AI as an academic discipline, some researchers were interested in having machines learn from data. They attempted to approach the problem with various symbolic methods, as well as what were then termed "neural networks"; these were mostly perceptrons and other models that were later found to be reinventions of the generalized linear models of statistics.[23] Probabilistic reasoning was also employed, especially in automated medical diagnosis.[24]: 488

However, an increasing emphasis on the logical, knowledge-based approach caused a rift between AI and machine learning. Probabilistic systems were plagued by theoretical and practical problems of data acquisition and representation.[24]: 488 By 1980, expert systems had come to dominate AI, and statistics was out of favor.[25] Work on symbolic/knowledge-based learning did continue within AI, leading to inductive logic programming(ILP), but the more statistical line of research was now outside the field of AI proper, in pattern recognition and information retrieval.[24]: 708–710, 755 Neural networks research had been abandoned by AI and computer science around the same time. This line, too, was continued outside the AI/CS field, as "connectionism", by researchers from other disciplines including Hopfield, Rumelhart, and Hinton. Their main success came in the mid-1980s with the reinvention of backpropagation.[24]: 25

Machine learning (ML), reorganized and recognized as its own field, started to flourish in the 1990s. The field changed its goal from achieving artificial intelligence to tackling solvable problems of a practical nature. It shifted focus away from the symbolic approaches it had inherited from AI, and toward methods and models borrowed from statistics, fuzzy logic, and probability theory.[25]

Data compression[edit]

There is a close connection between machine learning and compression. A system that predicts the posterior probabilities of a sequence given its entire history can be used for optimal data compression (by using arithmetic coding on the output distribution). Conversely, an optimal compressor can be used for prediction (by finding the symbol that compresses best, given the previous history). This equivalence has been used as a justification for using data compression as a benchmark for "general intelligence".[26][27][28]

An alternative view can show compression algorithms implicitly map strings into implicit feature space vectors, and compression-based similarity measures compute similarity within these feature spaces. For each compressor C(.) we define an associated vector space ℵ, such that C(.) maps an input string x, corresponding to the vector norm ||~x||. An exhaustive examination of the feature spaces underlying all compression algorithms is precluded by space; instead, feature vectors chooses to examine three representative lossless compression methods, LZW, LZ77, and PPM.[29]

According to AIXI theory, a connection more directly explained in Hutter Prize, the best possible compression of x is the smallest possible software that generates x. For example, in that model, a zip file's compressed size includes both the zip file and the unzipping software, since you can not unzip it without both, but there may be an even smaller combined form.

Examples of AI-powered audio/video compression software include VP9, NVIDIA Maxine, AIVC, AccMPEG.[30] Examples of software that can perform AI-powered image compression include OpenCV, TensorFlow, MATLAB's Image Processing Toolbox (IPT) and High-Fidelity Generative Image Compression.[31]

In unsupervised machine learning, k-means clustering can be utilized to compress data by grouping similar data points into clusters. This technique simplifies handling extensive datasets that lack predefined labels and finds widespread use in fields such as image compression.[32]

Data compression aims to reduce the size of data files, enhancing storage efficiency and speeding up data transmission. K-means clustering, an unsupervised machine learning algorithm, is employed to partition a dataset into a specified number of clusters, k, each represented by the centroid of its points. This process condenses extensive datasets into a more compact set of representative points. Particularly beneficial in image and signal processing, k-means clustering aids in data reduction by replacing groups of data points with their centroids, thereby preserving the core information of the original data while significantly decreasing the required storage space.[33]

Large language models (LLMs) are also capable of lossless data compression, as demonstrated by DeepMind's research with the Chinchilla 70B model. Developed by DeepMind, Chinchilla 70B effectively compressed data, outperforming conventional methods such as Portable Network Graphics (PNG) for images and Free Lossless Audio Codec (FLAC) for audio. It achieved compression of image and audio data to 43.4% and 16.4% of their original sizes, respectively.[34]Data mining[edit]

Machine learning and data mining often employ the same methods and overlap significantly, but while machine learning focuses on prediction, based on known properties learned from the training data, data mining focuses on the discovery of (previously) unknown properties in the data (this is the analysis step of knowledge discovery in databases). Data mining uses many machine learning methods, but with different goals; on the other hand, machine learning also employs data mining methods as "unsupervised learning" or as a preprocessing step to improve learner accuracy. Much of the confusion between these two research communities (which do often have separate conferences and separate journals, ECML PKDD being a major exception) comes from the basic assumptions they work with: in machine learning, performance is usually evaluated with respect to the ability to reproduce known knowledge, while in knowledge discovery and data mining (KDD) the key task is the discovery of previously unknown knowledge. Evaluated with respect to known knowledge, an uninformed (unsupervised) method will easily be outperformed by other supervised methods, while in a typical KDD task, supervised methods cannot be used due to the unavailability of training data.

Machine learning also has intimate ties to optimization: many learning problems are formulated as minimization of some loss function on a training set of examples. Loss functions express the discrepancy between the predictions of the model being trained and the actual problem instances (for example, in classification, one wants to assign a label to instances, and models are trained to correctly predict the pre-assigned labels of a set of examples).[35]

Generalization[edit]

The difference between optimization and machine learning arises from the goal of generalization: while optimization algorithms can minimize the loss on a training set, machine learning is concerned with minimizing the loss on unseen samples. Characterizing the generalization of various learning algorithms is an active topic of current research, especially for deep learning algorithms.

Statistics[edit]

Machine learning and statistics are closely related fields in terms of methods, but distinct in their principal goal: statistics draws population inferences from a sample, while machine learning finds generalizable predictive patterns.[36] According to Michael I. Jordan, the ideas of machine learning, from methodological principles to theoretical tools, have had a long pre-history in statistics.[37] He also suggested the term data science as a placeholder to call the overall field.[37]

Conventional statistical analyses require the a priori selection of a model most suitable for the study data set. In addition, only significant or theoretically relevant variables based on previous experience are included for analysis. In contrast, machine learning is not built on a pre-structured model; rather, the data shape the model by detecting underlying patterns. The more variables (input) used to train the model, the more accurate the ultimate model will be.[38]

Leo Breiman distinguished two statistical modeling paradigms: data model and algorithmic model,[39] wherein "algorithmic model" means more or less the machine learning algorithms like Random Forest.

Some statisticians have adopted methods from machine learning, leading to a combined field that they call statistical learning.[40]

Statistical physics[edit]

Analytical and computational techniques derived from deep-rooted physics of disordered systems can be extended to large-scale problems, including machine learning, e.g., to analyze the weight space of deep neural networks.[41] Statistical physics is thus finding applications in the area of medical diagnostics.[42]

Theory[edit]

A core objective of a learner is to generalize from its experience.[6][43] Generalization in this context is the ability of a learning machine to perform accurately on new, unseen examples/tasks after having experienced a learning data set. The training examples come from some generally unknown probability distribution (considered representative of the space of occurrences) and the learner has to build a general model about this space that enables it to produce sufficiently accurate predictions in new cases.

The computational analysis of machine learning algorithms and their performance is a branch of theoretical computer science known as computational learning theory via the Probably Approximately Correct Learning (PAC) model. Because training sets are finite and the future is uncertain, learning theory usually does not yield guarantees of the performance of algorithms. Instead, probabilistic bounds on the performance are quite common. The bias–variance decomposition is one way to quantify generalization error.

For the best performance in the context of generalization, the complexity of the hypothesis should match the complexity of the function underlying the data. If the hypothesis is less complex than the function, then the model has under fitted the data. If the complexity of the model is increased in response, then the training error decreases. But if the hypothesis is too complex, then the model is subject to overfitting and generalization will be poorer.[44]

In addition to performance bounds, learning theorists study the time complexity and feasibility of learning. In computational learning theory, a computation is considered feasible if it can be done in polynomial time. There are two kinds of time complexity results: Positive results show that a certain class of functions can be learned in polynomial time. Negative results show that certain classes cannot be learned in polynomial time.

Approaches[edit]

Machine learning approaches are traditionally divided into three broad categories, which correspond to learning paradigms, depending on the nature of the "signal" or "feedback" available to the learning system:

- Supervised learning: The computer is presented with example inputs and their desired outputs, given by a "teacher", and the goal is to learn a general rule that maps inputs to outputs.

- Unsupervised learning: No labels are given to the learning algorithm, leaving it on its own to find structure in its input. Unsupervised learning can be a goal in itself (discovering hidden patterns in data) or a means towards an end (feature learning).

- Reinforcement learning: A computer program interacts with a dynamic environment in which it must perform a certain goal (such as driving a vehicle or playing a game against an opponent). As it navigates its problem space, the program is provided feedback that's analogous to rewards, which it tries to maximize.[6]

Although each algorithm has advantages and limitations, no single algorithm works for all problems.[45][46][47]

Supervised learning[edit]

Supervised learning algorithms build a mathematical model of a set of data that contains both the inputs and the desired outputs.[48] The data is known as training data, and consists of a set of training examples. Each training example has one or more inputs and the desired output, also known as a supervisory signal. In the mathematical model, each training example is represented by an array or vector, sometimes called a feature vector, and the training data is represented by a matrix. Through iterative optimization of an objective function, supervised learning algorithms learn a function that can be used to predict the output associated with new inputs.[49] An optimal function allows the algorithm to correctly determine the output for inputs that were not a part of the training data. An algorithm that improves the accuracy of its outputs or predictions over time is said to have learned to perform that task.[19]

Types of supervised-learning algorithms include active learning, classification and regression.[50] Classification algorithms are used when the outputs are restricted to a limited set of values, and regression algorithms are used when the outputs may have any numerical value within a range. As an example, for a classification algorithm that filters emails, the input would be an incoming email, and the output would be the name of the folder in which to file the email.

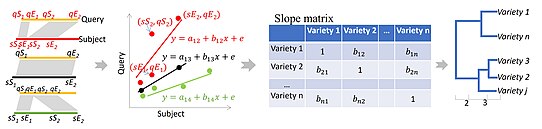

Similarity learning is an area of supervised machine learning closely related to regression and classification, but the goal is to learn from examples using a similarity function that measures how similar or related two objects are. It has applications in ranking, recommendation systems, visual identity tracking, face verification, and speaker verification.

Unsupervised learning[edit]

Unsupervised learning algorithms find structures in data that has not been labeled, classified or categorized. Instead of responding to feedback, unsupervised learning algorithms identify commonalities in the data and react based on the presence or absence of such commonalities in each new piece of data. Central applications of unsupervised machine learning include clustering, dimensionality reduction,[8] and density estimation.[51] Unsupervised learning algorithms also streamlined the process of identifying large indel based haplotypes of a gene of interest from pan-genome.[52]

Cluster analysis is the assignment of a set of observations into subsets (called clusters) so that observations within the same cluster are similar according to one or more predesignated criteria, while observations drawn from different clusters are dissimilar. Different clustering techniques make different assumptions on the structure of the data, often defined by some similarity metric and evaluated, for example, by internal compactness, or the similarity between members of the same cluster, and separation, the difference between clusters. Other methods are based on estimated density and graph connectivity.

Semi-supervised learning[edit]

Semi-supervised learning falls between unsupervised learning (without any labeled training data) and supervised learning (with completely labeled training data). Some of the training examples are missing training labels, yet many machine-learning researchers have found that unlabeled data, when used in conjunction with a small amount of labeled data, can produce a considerable improvement in learning accuracy.

In weakly supervised learning, the training labels are noisy, limited, or imprecise; however, these labels are often cheaper to obtain, resulting in larger effective training sets.[54]

Reinforcement learning[edit]

Reinforcement learning is an area of machine learning concerned with how software agents ought to take actions in an environment so as to maximize some notion of cumulative reward. Due to its generality, the field is studied in many other disciplines, such as game theory, control theory, operations research, information theory, simulation-based optimization, multi-agent systems, swarm intelligence, statistics and genetic algorithms. In reinforcement learning, the environment is typically represented as a Markov decision process (MDP). Many reinforcements learning algorithms use dynamic programming techniques.[55] Reinforcement learning algorithms do not assume knowledge of an exact mathematical model of the MDP and are used when exact models are infeasible. Reinforcement learning algorithms are used in autonomous vehicles or in learning to play a game against a human opponent.

Dimensionality reduction[edit]

Dimensionality reduction is a process of reducing the number of random variables under consideration by obtaining a set of principal variables.[56] In other words, it is a process of reducing the dimension of the feature set, also called the "number of features". Most of the dimensionality reduction techniques can be considered as either feature elimination or extraction. One of the popular methods of dimensionality reduction is principal component analysis (PCA). PCA involves changing higher-dimensional data (e.g., 3D) to a smaller space (e.g., 2D). This results in a smaller dimension of data (2D instead of 3D), while keeping all original variables in the model without changing the data.[57]The manifold hypothesis proposes that high-dimensional data sets lie along low-dimensional manifolds, and many dimensionality reduction techniques make this assumption, leading to the area of manifold learning and manifold regularization.

Other types[edit]

Other approaches have been developed which do not fit neatly into this three-fold categorization, and sometimes more than one is used by the same machine learning system. For example, topic modeling, meta-learning.[58]

Self-learning[edit]

Self-learning, as a machine learning paradigm was introduced in 1982 along with a neural network capable of self-learning, named crossbar adaptive array (CAA).[59] It is learning with no external rewards and no external teacher advice. The CAA self-learning algorithm computes, in a crossbar fashion, both decisions about actions and emotions (feelings) about consequence situations. The system is driven by the interaction between cognition and emotion.[60]The self-learning algorithm updates a memory matrix W =||w(a,s)|| such that in each iteration executes the following machine learning routine:

- in situation s perform action a

- receive a consequence situation s'

- compute emotion of being in the consequence situation v(s')

- update crossbar memory w'(a,s) = w(a,s) + v(s')

It is a system with only one input, situation, and only one output, action (or behavior) a. There is neither a separate reinforcement input nor an advice input from the environment. The backpropagated value (secondary reinforcement) is the emotion toward the consequence situation. The CAA exists in two environments, one is the behavioral environment where it behaves, and the other is the genetic environment, wherefrom it initially and only once receives initial emotions about situations to be encountered in the behavioral environment. After receiving the genome (species) vector from the genetic environment, the CAA learns a goal-seeking behavior, in an environment that contains both desirable and undesirable situations.[61]

Feature learning[edit]

Several learning algorithms aim at discovering better representations of the inputs provided during training.[62] Classic examples include principal component analysis and cluster analysis. Feature learning algorithms, also called representation learning algorithms, often attempt to preserve the information in their input but also transform it in a way that makes it useful, often as a pre-processing step before performing classification or predictions. This technique allows reconstruction of the inputs coming from the unknown data-generating distribution, while not being necessarily faithful to configurations that are implausible under that distribution. This replaces manual feature engineering, and allows a machine to both learn the features and use them to perform a specific task.

Feature learning can be either supervised or unsupervised. In supervised feature learning, features are learned using labeled input data. Examples include artificial neural networks, multilayer perceptrons, and supervised dictionary learning. In unsupervised feature learning, features are learned with unlabeled input data. Examples include dictionary learning, independent component analysis, autoencoders, matrix factorization[63] and various forms of clustering.[64][65][66]

Manifold learning algorithms attempt to do so under the constraint that the learned representation is low-dimensional. Sparse coding algorithms attempt to do so under the constraint that the learned representation is sparse, meaning that the mathematical model has many zeros. Multilinear subspace learning algorithms aim to learn low-dimensional representations directly from tensor representations for multidimensional data, without reshaping them into higher-dimensional vectors.[67] Deep learning algorithms discover multiple levels of representation, or a hierarchy of features, with higher-level, more abstract features defined in terms of (or generating) lower-level features. It has been argued that an intelligent machine is one that learns a representation that disentangles the underlying factors of variation that explain the observed data.[68]

Feature learning is motivated by the fact that machine learning tasks such as classification often require input that is mathematically and computationally convenient to process. However, real-world data such as images, video, and sensory data has not yielded attempts to algorithmically define specific features. An alternative is to discover such features or representations through examination, without relying on explicit algorithms.

Sparse dictionary learning[edit]

Sparse dictionary learning is a feature learning method where a training example is represented as a linear combination of basis functions, and is assumed to be a sparse matrix. The method is strongly NP-hard and difficult to solve approximately.[69] A popular heuristic method for sparse dictionary learning is the k-SVD algorithm. Sparse dictionary learning has been applied in several contexts. In classification, the problem is to determine the class to which a previously unseen training example belongs. For a dictionary where each class has already been built, a new training example is associated with the class that is best sparsely represented by the corresponding dictionary. Sparse dictionary learning has also been applied in image de-noising. The key idea is that a clean image patch can be sparsely represented by an image dictionary, but the noise cannot.[70]

Anomaly detection[edit]

In data mining, anomaly detection, also known as outlier detection, is the identification of rare items, events or observations which raise suspicions by differing significantly from the majority of the data.[71] Typically, the anomalous items represent an issue such as bank fraud, a structural defect, medical problems or errors in a text. Anomalies are referred to as outliers, novelties, noise, deviations and exceptions.[72]

In particular, in the context of abuse and network intrusion detection, the interesting objects are often not rare objects, but unexpected bursts of inactivity. This pattern does not adhere to the common statistical definition of an outlier as a rare object. Many outlier detection methods (in particular, unsupervised algorithms) will fail on such data unless aggregated appropriately. Instead, a cluster analysis algorithm may be able to detect the micro-clusters formed by these patterns.[73]

Three broad categories of anomaly detection techniques exist.[74] Unsupervised anomaly detection techniques detect anomalies in an unlabeled test data set under the assumption that the majority of the instances in the data set are normal, by looking for instances that seem to fit the least to the remainder of the data set. Supervised anomaly detection techniques require a data set that has been labeled as "normal" and "abnormal" and involves training a classifier (the key difference to many other statistical classification problems is the inherently unbalanced nature of outlier detection). Semi-supervised anomaly detection techniques construct a model representing normal behavior from a given normal training data set and then test the likelihood of a test instance to be generated by the model.

Robot learning[edit]

Robot learning is inspired by a multitude of machine learning methods, starting from supervised learning, reinforcement learning,[75][76] and finally meta-learning (e.g. MAML).

Association rules[edit]

Association rule learning is a rule-based machine learning method for discovering relationships between variables in large databases. It is intended to identify strong rules discovered in databases using some measure of "interestingness".[77]

Машинное обучение на основе правил — это общий термин для любого метода машинного обучения, который идентифицирует, изучает или развивает «правила» для хранения, манипулирования или применения знаний. Определяющей характеристикой алгоритма машинного обучения, основанного на правилах, является идентификация и использование набора реляционных правил, которые в совокупности представляют знания, полученные системой. В этом отличие от других алгоритмов машинного обучения, которые обычно определяют единую модель, которую можно универсально применить к любому случаю для получения прогноза. [78] Rule-based machine learning approaches include learning classifier systems, association rule learning, and artificial immune systems.

Основываясь на концепции строгих правил, Ракеш Агравал , Томаш Имиелински и Арун Свами представили ассоциативные правила для обнаружения закономерностей между продуктами в крупномасштабных данных о транзакциях, записываемых системами точек продаж (POS) в супермаркетах. [79] Например, правило обнаруженный в данных о продажах супермаркета, указывает на то, что если покупатель покупает лук и картофель вместе, он, скорее всего, также купит мясо для гамбургера. Такая информация может использоваться в качестве основы для принятия решений о маркетинговой деятельности, такой как рекламное ценообразование или размещение продукта . Помимо анализа потребительской корзины , правила ассоциации сегодня используются в таких прикладных областях, как анализ использования Интернета , обнаружение вторжений , непрерывное производство и биоинформатика . В отличие от интеллектуального анализа последовательностей , изучение правил ассоциации обычно не учитывает порядок элементов ни внутри транзакции, ни между транзакциями.

Системы классификаторов обучения (LCS) — это семейство алгоритмов машинного обучения на основе правил, которые сочетают в себе компонент обнаружения, обычно генетический алгоритм , с компонентом обучения, выполняя обучение с учителем , обучение с подкреплением или обучение без учителя . Они стремятся определить набор контекстно-зависимых правил, которые коллективно хранят и фрагментарно применяют знания для того, чтобы делать прогнозы. [80]

Индуктивное логическое программирование (ILP) — это подход к изучению правил с использованием логического программирования в качестве единообразного представления входных примеров, базовых знаний и гипотез. Учитывая кодирование известных фоновых знаний и набора примеров, представленных в виде логической базы данных фактов, система ПДОДИ выводит гипотетическую логическую программу, которая влечет за собой все положительные и не содержит отрицательных примеров. Индуктивное программирование — смежная область, которая рассматривает любой язык программирования для представления гипотез (и не только логическое программирование), например функциональные программы .

Индуктивное логическое программирование особенно полезно в биоинформатике и обработке естественного языка . Гордон Плоткин и Эхуд Шапиро заложили первоначальную теоретическую основу индуктивного машинного обучения в логической постановке. [81] [82] [83] Шапиро создал свою первую реализацию (систему вывода моделей) в 1981 году: программу на Прологе, которая индуктивно выводила логические программы на основе положительных и отрицательных примеров. [84] Термин «индукция» здесь относится к философской индукции, предлагающей теорию для объяснения наблюдаемых фактов, а не к математической индукции , доказывающей свойство для всех членов хорошо упорядоченного множества.

Модели [ править ]

А Модель машинного обучения — это тип математической модели , которая после «обучения» на заданном наборе данных может использоваться для прогнозирования или классификации новых данных. Во время обучения алгоритм обучения итеративно корректирует внутренние параметры модели, чтобы минимизировать ошибки в ее прогнозах. [85] В более широком смысле термин «модель» может относиться к нескольким уровням детализации: от общего класса моделей и связанных с ними алгоритмов обучения до полностью обученной модели со всеми настроенными внутренними параметрами. [86]

Для систем машинного обучения использовались и исследовались различные типы моделей, выбор лучшей модели для задачи называется выбором модели .

Искусственные нейронные сети [ править ]

Искусственные нейронные сети (ИНС), или коннекционистские системы, представляют собой вычислительные системы, отчасти основанные на биологических нейронных сетях животных , составляющих мозг . Такие системы «учатся» выполнять задачи, рассматривая примеры, как правило, без программирования каких-либо правил для конкретных задач.

ИНС — это модель, основанная на наборе связанных единиц или узлов, называемых « искусственными нейронами », которые в общих чертах моделируют нейроны биологического мозга . Каждое соединение, подобно синапсам в биологическом мозге , может передавать информацию, «сигнал», от одного искусственного нейрона к другому. Искусственный нейрон, получивший сигнал, может его обработать и затем передать сигнал подключенным к нему дополнительным искусственным нейронам. В обычных реализациях ИНС сигнал при соединении между искусственными нейронами представляет собой действительное число , а выход каждого искусственного нейрона вычисляется с помощью некоторой нелинейной функции суммы его входов. Связи между искусственными нейронами называются «ребрами». Искусственные нейроны и ребра обычно имеют вес , который корректируется по мере обучения. Вес увеличивает или уменьшает силу сигнала при соединении. Искусственные нейроны могут иметь такой порог, что сигнал отправляется только в том случае, если совокупный сигнал пересекает этот порог. Обычно искусственные нейроны объединяются в слои. Разные слои могут выполнять разные виды преобразований на своих входах. Сигналы передаются от первого слоя (входной слой) к последнему слою (выходной слой), возможно, после многократного прохождения слоев.

Первоначальная цель подхода ИНС заключалась в том, чтобы решать проблемы так же, как это делает человеческий мозг . Однако со временем внимание переместилось на выполнение конкретных задач, что привело к отклонениям от биологии . Искусственные нейронные сети использовались для решения множества задач, включая компьютерное зрение , распознавание речи , машинный перевод , социальных сетей фильтрацию , настольные и видеоигры , а также медицинскую диагностику .

Глубокое обучение состоит из нескольких скрытых слоев в искусственной нейронной сети. Этот подход пытается смоделировать то, как человеческий мозг преобразует свет и звук в зрение и слух. Некоторые успешные применения глубокого обучения — это компьютерное зрение и распознавание речи . [87]

Деревья решений [ править ]

решений используется При обучении по дереву решений дерево в качестве прогностической модели для перехода от наблюдений за элементом (представленных в ветвях) к выводам о целевом значении элемента (представленном в листьях). Это один из подходов прогнозного моделирования, используемых в статистике, интеллектуальном анализе данных и машинном обучении. Древовидные модели, в которых целевая переменная может принимать дискретный набор значений, называются деревьями классификации; в этих древовидных структурах листья представляют метки классов, а ветви представляют собой соединения объектов, которые приводят к этим меткам классов. Деревья решений, в которых целевая переменная может принимать непрерывные значения (обычно действительные числа ), называются деревьями регрессии. При анализе решений дерево решений можно использовать для визуального и явного представления решений и процесса их принятия . При интеллектуальном анализе данных дерево решений описывает данные, но полученное дерево классификации может быть входными данными для принятия решений.

векторов опорных Машины

Машины опорных векторов (SVM), также известные как сети опорных векторов, представляют собой набор связанных методов обучения с учителем, используемых для классификации и регрессии. Учитывая набор обучающих примеров, каждый из которых помечен как принадлежащий к одной из двух категорий, алгоритм обучения SVM строит модель, которая предсказывает, попадает ли новый пример в одну категорию. [88] Алгоритм обучения SVM представляет собой невероятностный бинарный линейный классификатор для , хотя существуют такие методы, как масштабирование Платта, использования SVM в условиях вероятностной классификации. Помимо выполнения линейной классификации, SVM могут эффективно выполнять нелинейную классификацию, используя так называемый трюк ядра , неявно отображая свои входные данные в многомерные пространства признаков.

Регрессионный анализ [ править ]

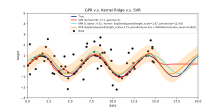

Регрессионный анализ включает в себя большое количество статистических методов для оценки взаимосвязи между входными переменными и связанными с ними функциями. Его наиболее распространенной формой является линейная регрессия , когда одна линия рисуется так, чтобы наилучшим образом соответствовать заданным данным в соответствии с математическим критерием, таким как обычный метод наименьших квадратов . Последнее часто расширяется с помощью методов регуляризации , чтобы уменьшить переобучение и систематическую ошибку, как в случае с гребневой регрессией . При решении нелинейных задач модели перехода включают полиномиальную регрессию (например, используемую для аппроксимации линии тренда в Microsoft Excel). [89] ), логистическая регрессия (часто используемая в статистической классификации ) или даже ядерная регрессия , которая вводит нелинейность за счет использования трюка ядра для неявного сопоставления входных переменных с многомерным пространством.

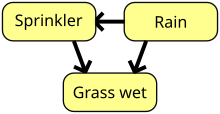

Байесовские сети [ править ]

Байесовская сеть, сеть убеждений или направленная ациклическая графическая модель — это вероятностная графическая модель , которая представляет набор случайных величин и их условную независимость с помощью ориентированного ациклического графа (DAG). Например, байесовская сеть может представлять вероятностные связи между заболеваниями и симптомами. Учитывая симптомы, сеть можно использовать для расчета вероятности наличия различных заболеваний. Существуют эффективные алгоритмы, которые выполняют логический вывод и обучение. Байесовские сети, которые моделируют последовательности переменных, таких как речевые сигналы или последовательности белков , называются динамическими байесовскими сетями . Обобщения байесовских сетей, которые могут представлять и решать проблемы принятия решений в условиях неопределенности, называются диаграммами влияния .

Гауссовы процессы [ править ]

Гауссов процесс — это стохастический процесс , в котором каждый конечный набор случайных величин в процессе имеет многомерное нормальное распределение и опирается на заранее определенную ковариационную функцию или ядро, которое моделирует, как пары точек связаны друг с другом в зависимости на своих местах.

Учитывая набор наблюдаемых точек или примеров ввода-вывода, распределение (ненаблюдаемых) выходных данных новой точки в зависимости от ее входных данных может быть непосредственно вычислено путем просмотра наблюдаемых точек и ковариаций между этими точками и новыми , ненаблюдаемая точка.

Гауссовские процессы являются популярными суррогатными моделями в байесовской оптимизации, используемыми для оптимизации гиперпараметров .

Генетические алгоритмы [ править ]

Генетический алгоритм (ГА) — это алгоритм поиска и эвристический метод, который имитирует процесс естественного отбора , используя такие методы, как мутация и скрещивание, для создания новых генотипов в надежде найти хорошие решения данной проблемы. В машинном обучении генетические алгоритмы использовались в 1980-х и 1990-х годах. [91] [92] И наоборот, методы машинного обучения использовались для повышения производительности генетических и эволюционных алгоритмов . [93]

Функции убеждений [ править ]

Теория функций убеждения, также называемая теорией доказательств или теорией Демпстера-Шейфера, представляет собой общую основу для рассуждений с неопределенностью, с понятными связями с другими теориями, такими как теории вероятности , возможности и неточные теории вероятностей . Эти теоретические рамки можно рассматривать как своего рода обучающие системы, и они имеют некоторые аналогичные свойства того, как объединяются доказательства (например, правило комбинации Демпстера), точно так же, как в PMF. байесовском подходе, основанном на [ нужны разъяснения ] объединил бы вероятности. Однако есть много предостережений относительно этих функций убеждений по сравнению с байесовскими подходами, чтобы включить количественную оценку незнания и неопределенности . Эти подходы с функцией доверия, которые реализованы в области машинного обучения, обычно используют подход объединения различных ансамблевых методов учащимся , чтобы лучше справляться с границей принятия решения , небольшими выборками и неоднозначными проблемами класса, которые стандартный подход машинного обучения, как правило, с трудом решает. [3] [5] [10] Однако вычислительная сложность этих алгоритмов зависит от количества предложений (классов) и может привести к гораздо большему времени вычислений по сравнению с другими подходами машинного обучения.

Модели обучения [ править ]

Обычно модели машинного обучения требуют большого количества надежных данных, чтобы модели могли выполнять точные прогнозы. При обучении модели машинного обучения инженерам машинного обучения необходимо собрать большую и репрезентативную выборку данных. Данные из обучающего набора могут быть такими же разнообразными, как корпус текста , набор изображений, данные датчиков и данные, собранные от отдельных пользователей службы. Переоснащение — это то, на что следует обратить внимание при обучении модели машинного обучения. Обученные модели, полученные на основе предвзятых или неоцененных данных, могут привести к искаженным или нежелательным прогнозам. Модели предвзятости могут привести к пагубным результатам, тем самым усиливая негативное воздействие на общество или цели. Алгоритмическая ошибка — это потенциальный результат того, что данные не полностью подготовлены к обучению. Этика машинного обучения становится областью исследований и, в частности, интегрируется в команды разработчиков машинного обучения.

Федеративное обучение [ править ]

Федеративное обучение — это адаптированная форма распределенного искусственного интеллекта для обучения моделей машинного обучения, которая децентрализует процесс обучения, позволяя сохранять конфиденциальность пользователей без необходимости отправлять их данные на централизованный сервер. Это также повышает эффективность за счет децентрализации процесса обучения на множество устройств. Например, Gboard использует интегрированное машинное обучение для обучения моделей прогнозирования поисковых запросов на мобильных телефонах пользователей без необходимости отправлять отдельные поисковые запросы обратно в Google . [94]

Приложения [ править ]

Существует множество приложений для машинного обучения, в том числе:

- Сельское хозяйство

- Анатомия

- Адаптивный сайт

- Аффективные вычисления

- Астрономия

- Автоматизированное принятие решений

- Банковское дело

- Бихевиоризм

- Биоинформатика

- Интерфейсы мозг-машина

- Хеминформатика

- Гражданская наука

- Климатология

- Компьютерные сети

- Компьютерное зрение

- мошенничества с кредитными картами Обнаружение

- Качество данных

- последовательностей ДНК Классификация

- Экономика

- финансового рынка Анализ [95]

- Общая игра

- Распознавание рукописного ввода

- Здравоохранение

- Поиск информации

- Страхование

- мошенничества в Интернете Обнаружение

- Встраивание графа знаний

- Лингвистика

- Управление машинным обучением

- Машинное восприятие

- Машинный перевод

- Маркетинг

- Медицинский диагноз

- Обработка естественного языка

- Понимание естественного языка

- Интернет-реклама

- Оптимизация

- Рекомендательные системы

- Передвижение робота

- Поисковые системы

- Анализ настроений

- Последовательный майнинг

- Программная инженерия

- Распознавание речи

- Структурный мониторинг здоровья

- Распознавание синтаксических образов

- Телекоммуникации

- Доказательство теоремы

- Прогнозирование временных рядов

- Томографическая реконструкция [96]

- Аналитика поведения пользователей

В 2006 году поставщик медиа-услуг Netflix провел первый конкурс « Netflix Prize », чтобы найти программу, которая лучше прогнозирует предпочтения пользователей и повышает точность существующего алгоритма рекомендации фильмов Cinematch как минимум на 10%. Совместная команда, состоящая из исследователей из AT&T Labs -Research в сотрудничестве с командами Big Chaos и Pragmatic Theory, создала ансамблевую модель , которая выиграла главный приз в 2009 году за 1 миллион долларов. [97] Вскоре после присуждения премии в Netflix поняли, что рейтинги зрителей не являются лучшим индикатором их моделей просмотра («все является рекомендацией»), и соответствующим образом изменили свою систему рекомендаций. [98] В 2010 году The Wall Street Journal написала о фирме Rebellion Research и использовании ими машинного обучения для прогнозирования финансового кризиса. [99] В 2012 году соучредитель Sun Microsystems Винод Хосла предсказал, что 80% рабочих мест врачей будут потеряны в ближайшие два десятилетия из-за автоматизированного медицинского диагностического программного обеспечения с машинным обучением. [100] В 2014 году сообщалось, что алгоритм машинного обучения был применен в области истории искусства для изучения картин изобразительного искусства и что он, возможно, выявил ранее непризнанные влияния среди художников. [101] В 2019 году Springer Nature опубликовала первую исследовательскую книгу, созданную с использованием машинного обучения. [102] В 2020 году технология машинного обучения была использована для постановки диагноза и помощи исследователям в разработке лекарства от COVID-19. [103] Машинное обучение недавно было применено для прогнозирования экологически чистого поведения путешественников. [104] Недавно технология машинного обучения также была применена для оптимизации производительности и температурного режима смартфона в зависимости от взаимодействия пользователя с телефоном. [105] [106] [107] При правильном применении алгоритмы машинного обучения (MLA) могут использовать широкий спектр характеристик компании для прогнозирования доходности акций без переобучения . Используя эффективную разработку признаков и комбинируя прогнозы, MLA могут генерировать результаты, которые намного превосходят результаты, полученные с помощью базовых линейных методов, таких как OLS . [108]

Последние достижения в области машинного обучения распространились и на область квантовой химии, где новые алгоритмы теперь позволяют прогнозировать влияние растворителей на химические реакции, тем самым предлагая химикам новые инструменты для адаптации экспериментальных условий для получения оптимальных результатов. [109]

Машинное обучение становится полезным инструментом для расследования и прогнозирования принятия решений об эвакуации в случае крупномасштабных и небольших стихийных бедствий. Были протестированы различные решения, чтобы предсказать, решат ли домовладельцы эвакуироваться во время лесных пожаров и ураганов и если да, то когда. [110] [111] [112] Другие приложения были сосредоточены на принятии решений по предварительной эвакуации при пожарах в зданиях. [113] [114]

Ограничения [ править ]

Хотя машинное обучение произвело трансформацию в некоторых областях, программы машинного обучения часто не дают ожидаемых результатов. [115] [116] [117] Причин для этого множество: отсутствие (подходящих) данных, отсутствие доступа к данным, предвзятость данных, проблемы конфиденциальности, неправильно выбранные задачи и алгоритмы, неправильные инструменты и люди, нехватка ресурсов и проблемы с оценкой. [118]

« Теория черного ящика » представляет собой еще одну, но важную проблему. Черный ящик относится к ситуации, когда алгоритм или процесс получения выходных данных полностью непрозрачен, а это означает, что даже программисты алгоритма не могут проверить шаблон, который машина извлекла из данных. [119] Специальный комитет Палаты лордов заявил, что такая «разведывательная система», которая могла бы оказать «существенное влияние на жизнь человека», не будет считаться приемлемой, если она не предоставит «полное и удовлетворительное объяснение принимаемым ею решениям». [119]

В 2018 году беспилотный автомобиль Uber не смог обнаружить пешехода, погибшего в результате столкновения. [120] Попытки использовать машинное обучение в здравоохранении с помощью системы IBM Watson не увенчались успехом даже после многих лет времени и инвестиций в миллиарды долларов. [121] [122] Microsoft Bing Chat вызывает враждебную и оскорбительную реакцию в отношении своих пользователей. Сообщается, что чат-бот [123]

Машинное обучение использовалось в качестве стратегии для обновления данных, связанных с систематическим обзором, и увеличения нагрузки на рецензентов, связанной с ростом биомедицинской литературы. Несмотря на то, что благодаря обучающим наборам он улучшился, он еще не развился в достаточной степени, чтобы снизить рабочую нагрузку без ограничения необходимой чувствительности для самих результатов исследования. [124]

Предвзятость [ править ]

Различные подходы к машинному обучению могут страдать от различных искажений данных. Система машинного обучения, специально обученная на текущих клиентах, может быть не в состоянии предсказать потребности новых групп клиентов, которые не представлены в данных обучения. При обучении на данных, созданных человеком, машинное обучение, скорее всего, уловит конституционные и бессознательные предубеждения, уже присутствующие в обществе. [125]

Было показано, что языковые модели, полученные на основе данных, содержат предвзятости, подобные человеческим. [126] [127] В эксперименте, проведенном ProPublica , организацией , занимающейся журналистскими расследованиями , анализ алгоритма машинного обучения уровня рецидивизма среди заключенных ошибочно отметил, что «черные обвиняемые подвергаются высокому риску в два раза чаще, чем белые обвиняемые». [128] В 2015 году Google Фото часто отмечал чернокожих людей как горилл. [128] и в 2018 году эта проблема все еще не была решена должным образом, но, как сообщается, Google все еще использовал обходной путь для удаления всех горилл из обучающих данных и, таким образом, вообще не мог распознавать настоящих горилл. [129] Подобные проблемы с признанием небелых людей были обнаружены во многих других системах. [130] В 2016 году Microsoft протестировала Tay , чат-бота , который учился на Twitter, и быстро усвоил расистские и сексистские высказывания. [131]

Из-за таких проблем эффективное использование машинного обучения может занять больше времени, прежде чем оно будет внедрено в других областях. [132] Обеспокоенность по поводу справедливости в машинном обучении, то есть уменьшения предвзятости в машинном обучении и стимулирования его использования на благо человечества, все чаще выражается учеными в области искусственного интеллекта, в том числе Фей-Фей Ли , который напоминает инженерам, что «в ИИ нет ничего искусственного. . Он вдохновлен людьми, создан людьми и, что наиболее важно, влияет на людей. Это мощный инструмент, который мы только начинаем понимать, и это огромная ответственность». [133]

Объясняемость [ править ]

Объяснимый ИИ (XAI), или Интерпретируемый ИИ, или Объясняемое машинное обучение (XML), — это искусственный интеллект (ИИ), с помощью которого люди могут понимать решения или прогнозы, сделанные ИИ. [134] Это контрастирует с концепцией «черного ящика» в машинном обучении, где даже разработчики не могут объяснить, почему ИИ принял конкретное решение. [135] Совершенствуя ментальные модели пользователей систем на базе искусственного интеллекта и разрушая их заблуждения, XAI обещает помочь пользователям работать более эффективно. XAI может быть реализацией социального права на объяснение.

Переоснащение [ править ]

Выбор плохой, слишком сложной теории, подстроенной так, чтобы соответствовать всем прошлым обучающим данным, известен как переобучение. Многие системы пытаются уменьшить переоснащение, вознаграждая теорию в зависимости от того, насколько хорошо она соответствует данным, и наказывая теорию в соответствии с ее сложностью. [136]

Другие ограничения и уязвимости [ править ]

Учащиеся также могут разочароваться, «усвоив неправильный урок». Игрушечный пример: классификатор изображений, обученный только на изображениях коричневых лошадей и черных кошек, может прийти к выводу, что все коричневые пятна, скорее всего, являются лошадьми. [137] Реальным примером является то, что, в отличие от людей, современные классификаторы изображений часто не делают суждения в первую очередь на основе пространственных отношений между компонентами изображения, а изучают отношения между пикселями, о которых люди не обращают внимания, но которые все же коррелируют с изображениями определенных изображений. типы реальных объектов. Изменение этих шаблонов на законном изображении может привести к появлению «конкурентных» изображений, которые система неправильно классифицирует. [138] [139]

Состязательные уязвимости также могут привести к нелинейным системам или к нешаблоновым возмущениям. В некоторых системах можно изменить выходные данные, изменив только один выбранный состязательно пиксель. [140] Модели машинного обучения часто уязвимы для манипуляций и/или обхода с помощью состязательного машинного обучения . [141]

Исследователи продемонстрировали, как бэкдоры могут быть незаметно помещены в классифицирующие (например, по категориям «спам» и хорошо видимые «не спам» сообщений) модели машинного обучения, которые часто разрабатываются и/или обучаются третьими лицами. тип прозрачности данных/программного обеспечения Стороны могут изменить классификацию любых входных данных, в том числе в случаях, когда предусмотрен , возможно, включая доступ к «белому ящику» . [142] [143] [144]

оценки Модельные

Классификация моделей машинного обучения может быть проверена с помощью методов оценки точности, таких как метод удержания , который разделяет данные на обучающий и тестовый наборы (обычно 2/3 обучающего набора и 1/3 обозначения тестового набора) и оценивает производительность обучающей модели. на тестовом наборе. Для сравнения, метод K-кратной перекрестной проверки случайным образом разделяет данные на K подмножества, а затем проводится K экспериментов, каждый из которых соответственно рассматривает 1 подмножество для оценки и оставшиеся K-1 подмножества для обучения модели. В дополнение к методам удержания и перекрестной проверки для оценки точности модели можно использовать bootstrap , который выбирает n экземпляров с заменой из набора данных. [145]

Помимо общей точности, исследователи часто сообщают о чувствительности и специфичности , что означает долю истинно положительных результатов (TPR) и частоту истинного отрицательных результатов (TNR) соответственно. Точно так же исследователи иногда сообщают о частоте ложноположительных результатов (FPR), а также о частоте ложноотрицательных результатов (FNR). Однако эти ставки представляют собой отношения, в которых не раскрываются их числители и знаменатели. Общая рабочая характеристика (ТОС) является эффективным методом выражения диагностических возможностей модели. TOC показывает числители и знаменатели ранее упомянутых скоростей, таким образом TOC предоставляет больше информации, чем обычно используемая рабочая характеристика приемника (ROC) и связанная с ROC площадь под кривой (AUC). [146]

Этика [ править ]

Машинное обучение ставит множество этических вопросов . Системы, обученные на наборах данных, собранных с предвзятостью, могут проявлять эти предвзятости при использовании ( алгоритмическая предвзятость ), тем самым оцифровывая культурные предрассудки. [147] Великобритании Например, в 1988 году Комиссия по расовому равенству обнаружила, что Медицинская школа Св. Георгия использовала компьютерную программу, созданную на основе данных предыдущих сотрудников приемной комиссии, и эта программа отклонила почти 60 кандидатов, которые были признаны либо женщинами, либо не имели -Европейско звучащие имена. [125] Использование данных о найме на работу от фирмы с расистской политикой найма может привести к тому, что система машинного обучения будет дублировать предвзятость, оценивая кандидатов на работу по сходству с предыдущими успешными кандидатами. [148] [149] Другой пример — алгоритм прогнозирования полицейской компании Geolitica , который привел к «непропорционально высокому уровню чрезмерной полицейской деятельности в общинах с низкими доходами и меньшинствами» после обучения на исторических данных о преступлениях. [128]

Хотя ответственный сбор данных и документирование алгоритмических правил, используемых системой, считаются важной частью машинного обучения, некоторые исследователи обвиняют отсутствие участия и представительства меньшинств в области ИИ в уязвимости машинного обучения к предвзятости. [150] Фактически, согласно исследованию, проведенному Ассоциацией компьютерных исследований (CRA) в 2021 году, «женщины-преподаватели составляют лишь 16,1%» от всех преподавателей, специализирующихся на искусственном интеллекте, в нескольких университетах по всему миру. [151] Кроме того, среди группы «новых выпускников аспирантов в области ИИ, постоянно проживающих в США», 45% идентифицированы как белые, 22,4% как азиаты, 3,2% как латиноамериканцы и 2,4% как афроамериканцы, что еще раз демонстрирует отсутствие разнообразия в области ИИ. . [151]

ИИ может быть хорошо оснащен для принятия решений в технических областях, которые в значительной степени полагаются на данные и историческую информацию. Эти решения основаны на объективности и логическом обосновании. [152] Поскольку человеческие языки содержат предубеждения, машины, обученные на языковых корпусах , обязательно также усвоят эти предубеждения. [153] [154]

Другие формы этических проблем, не связанные с личными предубеждениями, наблюдаются в здравоохранении. Среди специалистов здравоохранения существуют опасения, что эти системы могут быть разработаны не в интересах общества, а как машины, приносящие доход. [155] Это особенно верно в Соединенных Штатах, где существует давняя этическая дилемма улучшения здравоохранения, но также и увеличения прибылей. Например, алгоритмы могут быть разработаны так, чтобы предоставлять пациентам ненужные тесты или лекарства, в которых заинтересованы владельцы алгоритма. Машинное обучение в здравоохранении потенциально может предоставить специалистам дополнительный инструмент для диагностики, лечения и планирования путей выздоровления пациентов, но для этого необходимо смягчить эти предубеждения. [156]

Аппаратное обеспечение [ править ]

С 2010-х годов достижения как в алгоритмах машинного обучения, так и в компьютерном оборудовании привели к появлению более эффективных методов обучения глубоких нейронных сетей (особой узкой подобласти машинного обучения), которые содержат множество слоев нелинейных скрытых модулей. [157] К 2019 году графические процессоры ( GPU ), часто с усовершенствованиями, специально предназначенными для искусственного интеллекта, вытеснили центральные процессоры в качестве доминирующего метода обучения крупномасштабного коммерческого облачного искусственного интеллекта. [158] OpenAI оценила аппаратные вычисления, используемые в крупнейших проектах глубокого обучения, от AlexNet (2012 г.) до AlphaZero (2017 г.), и обнаружила 300 000-кратное увеличение объема необходимых вычислений с линией тренда удвоения, равной 3,4 месяца. [159] [160]

сети Нейроморфные / физические нейронные

Физическая нейронная сеть или нейроморфный компьютер — это тип искусственной нейронной сети , в которой электрически регулируемый материал используется для имитации функции нейронного синапса . «Физическая» нейронная сеть используется, чтобы подчеркнуть зависимость от физического оборудования, используемого для эмуляции нейронов, в отличие от программных подходов. В более общем смысле этот термин применим к другим искусственным нейронным сетям, в которых мемристор или другой материал с электрически регулируемым сопротивлением. для эмуляции нейронного синапса используется [161] [162]

машинное Встроенное обучение

Встроенное машинное обучение — это подобласть машинного обучения, в которой модель машинного обучения запускается во встроенных системах с ограниченными вычислительными ресурсами, таких как носимые компьютеры , периферийные устройства и микроконтроллеры . [163] [164] [165] Запуск модели машинного обучения во встроенных устройствах устраняет необходимость передачи и хранения данных на облачных серверах для дальнейшей обработки, что в дальнейшем снижает утечки данных и конфиденциальности, происходящие из-за передачи данных, а также сводит к минимуму кражу интеллектуальной собственности, личных данных и коммерческой тайны. Встроенное машинное обучение может применяться с помощью нескольких методов, включая аппаратное ускорение , [166] [167] используя приближенные вычисления , [168] оптимизация моделей машинного обучения и многое другое. [169] [170] Отсечение , квантование , дистилляция знаний , факторизация низкого ранга, поиск сетевой архитектуры (NAS) и совместное использование параметров — вот лишь некоторые из методов, используемых для оптимизации моделей машинного обучения.

Программное обеспечение [ править ]

Пакеты программного обеспечения, содержащие различные алгоритмы машинного обучения, включают следующее:

Бесплатное программное обеспечение с открытым исходным кодом [ править ]

- Кафе

- Глубокое обучение4j

- ДипСпид

- ELKI

- Гугл Джакс

- Infer.NET

- Жесткий

- Кубефлоу

- ЛайтГБМ

- Махаут

- Маллет

- Когнитивный инструментарий Microsoft

- ML.NET

- млпак

- MXNet

- ОпенНН

- Апельсин

- панды (программное обеспечение)

- КОРЕНЬ (TMVA с ROOT)

- scikit-learn

- Сёгун

- Искра MLlib

- СистемаML

- Тензорфлоу

- Факел / PyTorch

- Набор / МОА

- XGBoost

- Йорик

программное обеспечение с бесплатными версиями и версиями с открытым исходным кодом Проприетарное

Собственное программное обеспечение [ править ]

- Машинное обучение Amazon

- Ангосс ЗнанияСТУДИЯ

- Машинное обучение Azure

- IBM Ватсон Студия

- Google Cloud Vertex AI

- API прогнозов Google

- IBM SPSS Modeler

- Разработчик моделей KXEN

- решатель LION

- Математика

- МАТЛАБ

- Нейронный дизайнер

- Нейрорешения

- Oracle Data Mining

- Облачный сервис Oracle AI Platform

- ПолиАналитик

- RCASE

- SAS Enterprise Майнер

- ПоследовательностьL

- Спланк

- СТАТИСТИКА Data Miner

Журналы [ править ]

- Журнал исследований машинного обучения

- Машинное обучение

- Природа Машинный интеллект

- Нейронные вычисления

- Транзакции IEEE по анализу шаблонов и машинному интеллекту

Конференции [ править ]

- Конференция AAAI по искусственному интеллекту

- Ассоциация компьютерной лингвистики ( ACL )

- Европейская конференция по машинному обучению, принципам и практике обнаружения знаний в базах данных ( ECML PKDD )

- Международная конференция по методам вычислительного интеллекта для биоинформатики и биостатистики ( CIBB )

- Международная конференция по машинному обучению ( ICML )

- Международная конференция по обучению представлений ( ICLR )

- Международная конференция по интеллектуальным роботам и системам ( IROS )

- Конференция по обнаружению знаний и интеллектуальному анализу данных ( KDD )

- Конференция по нейронным системам обработки информации ( NeurIPS )

См. также [ править ]

- Автоматизированное машинное обучение - процесс автоматизации применения машинного обучения.

- Большие данные . Чрезвычайно большие или сложные наборы данных.

- Дифференцируемое программирование – парадигма программирования

- Силовое управление

- Список важных публикаций по машинному обучению

- Список наборов данных для исследований в области машинного обучения

Ссылки [ править ]

- ^ Определение «без явного программирования» часто приписывают Артуру Сэмюэлю , который придумал термин «машинное обучение» в 1959 году, но в этой публикации эта фраза не встречается дословно и может быть перефразом, появившимся позже. Конференция «Перефразируя Артура Сэмюэля (1959), вопрос таков: как компьютеры могут научиться решать проблемы без явного программирования?» в Коза, Джон Р.; Беннетт, Форрест Х.; Андре, Дэвид; Кин, Мартин А. (1996). «Автоматическое проектирование топологии и размеров аналоговых электрических цепей с использованием генетического программирования». Искусственный интеллект в дизайне '96 . Искусственный интеллект в дизайне '96. Спрингер, Дордрехт. стр. 151–170. дои : 10.1007/978-94-009-0279-4_9 . ISBN 978-94-010-6610-5 .

- ^ «Что такое машинное обучение?» . ИБМ . Архивировано из оригинала 27 декабря 2023 г. Проверено 27 июня 2023 г.

- ^ Перейти обратно: а б Чжоу, Виктор (20 декабря 2019 г.). «Машинное обучение для начинающих: введение в нейронные сети» . Середина . Архивировано из оригинала 9 марта 2022 г. Проверено 15 августа 2021 г.

- ^ Ху, Джуньянь; Ню, Ханлин; Карраско, Хоакин; Леннокс, Барри; Арвин, Фаршад (2020). «Автономные исследования с несколькими роботами на основе Вороного в неизвестных средах посредством глубокого обучения с подкреплением» . Транзакции IEEE по автомобильным технологиям . 69 (12): 14413–14423. дои : 10.1109/tvt.2020.3034800 . ISSN 0018-9545 . S2CID 228989788 .

- ^ Перейти обратно: а б Юсефзаде-Наджафабади, Мохсен; Хью, Эрл; Тюльпан, Дэн; Сулик, Джон; Эскандари, Милад (2021). «Применение алгоритмов машинного обучения в селекции растений: прогнозирование урожайности на основе гиперспектрального отражения сои?» . Передний. Наука о растениях . 11 : 624273. doi : 10.3389/fpls.2020.624273 . ПМЦ 7835636 . ПМИД 33510761 .

- ^ Перейти обратно: а б с Бишоп, CM (2006), Распознавание образов и машинное обучение , Springer, ISBN 978-0-387-31073-2

- ^ Машинное обучение и распознавание образов «можно рассматривать как два аспекта одной области». [6] : vii

- ^ Перейти обратно: а б Фридман, Джером Х. (1998). «Интеллектуальный анализ данных и статистика: какая связь?». Информатика и статистика . 29 (1): 3–9.

- ^ Сэмюэл, Артур (1959). «Некоторые исследования в области машинного обучения с использованием игры в шашки». Журнал исследований и разработок IBM . 3 (3): 210–229. CiteSeerX 10.1.1.368.2254 . дои : 10.1147/рд.33.0210 . S2CID 2126705 .

- ^ Перейти обратно: а б Р. Кохави и Ф. Провост, «Словарь терминов», Machine Learning, vol. 30, нет. 2–3, стр. 271–274, 1998.

- ^ Герович, Слава (9 апреля 2015 г.). «Как компьютер отомстил Советскому Союзу» . Наутилус . Архивировано из оригинала 22 сентября 2021 года . Проверено 19 сентября 2021 г.

- ^ Линдси, Ричард П. (1 сентября 1964 г.). «Влияние автоматизации на государственное управление» . Западный политический ежеквартальный журнал . 17 (3): 78–81. дои : 10.1177/106591296401700364 . ISSN 0043-4078 . S2CID 154021253 . Архивировано из оригинала 6 октября 2021 года . Проверено 6 октября 2021 г.

- ^ Перейти обратно: а б с «История и эволюция машинного обучения: хронология» . Что такое . Архивировано из оригинала 8 декабря 2023 г. Проверено 8 декабря 2023 г.

- ^ Милнер, Питер М. (1993). «Разум и Дональд О. Хебб» . Научный американец . 268 (1): 124–129. Бибкод : 1993SciAm.268a.124M . doi : 10.1038/scientificamerican0193-124 . ISSN 0036-8733 . JSTOR 24941344 . ПМИД 8418480 . Архивировано из оригинала 20 декабря 2023 г. Проверено 9 декабря 2023 г.

- ^ «Наука: Кнопка дурака», Time (журнал) , 18 августа 1961 г.

- ^ Нильссон Н. Обучающиеся машины, МакГроу Хилл, 1965.

- ^ Дуда Р., Харт П. Распознавание образов и анализ сцены, Wiley Interscience, 1973

- ^ С. Бозиновски «Обучающее пространство: концепция представления для классификации адаптивных шаблонов», Технический отчет COINS № 81-28, Факультет компьютерных и информационных наук, Массачусетский университет в Амхерсте, Массачусетс, 1981. https://web.cs.umass .edu/publication/docs/1981/UM-CS-1981-028.pdf. Архивировано 25 февраля 2021 г. в Wayback Machine.

- ^ Перейти обратно: а б Митчелл, Т. (1997). Машинное обучение . МакГроу Хилл. п. 2. ISBN 978-0-07-042807-2 .

- ^ Харнад, Стеван (2008), «Аннотационная игра: О Тьюринге (1950) о вычислительной технике, технике и интеллекте» , в Эпштейне, Роберт; Питерс, Грейс (ред.), Справочник по тесту Тьюринга: философские и методологические проблемы в поисках мыслящего компьютера , Kluwer, стр. 23–66, ISBN 9781402067082 , заархивировано из оригинала 9 марта 2012 г. , получено 11 декабря 2012 г.

- ^ «Введение в ИИ. Часть 1» . Эдцион . 08.12.2020. Архивировано из оригинала 18 февраля 2021 г. Проверено 9 декабря 2020 г.

- ^ Синдху В., Ниведха С., Пракаш М. (февраль 2020 г.). «Эмпирическое научное исследование биоинформатики в машинном обучении» . Журнал механики сплошных сред и математических наук (7). doi : 10.26782/jmcms.spl.7/2020.02.00006 .

- ^ Сарл, Уоррен С. (1994). «Нейронные сети и статистические модели». SUGI 19: материалы девятнадцатой ежегодной международной конференции группы пользователей SAS . Институт САС. стр. 1538–50. ISBN 9781555446116 . ОСЛК 35546178 .

- ^ Перейти обратно: а б с д Рассел, Стюарт ; Норвиг, Питер (2003) [1995]. Искусственный интеллект: современный подход (2-е изд.). Прентис Холл. ISBN 978-0137903955 .

- ^ Перейти обратно: а б Лэнгли, Пэт (2011). «Изменяющаяся наука о машинном обучении» . Машинное обучение . 82 (3): 275–9. дои : 10.1007/s10994-011-5242-y .

- ^ Махони, Мэтт. «Обоснование теста сжатия большого текста» . Флоридский технологический институт . Проверено 5 марта 2013 г.

- ^ Шмилович А.; Кахири Ю.; Бен-Гал И.; Хаузер С. (2009). «Измерение эффективности внутридневного рынка Форекс с помощью универсального алгоритма сжатия данных» (PDF) . Вычислительная экономика . 33 (2): 131–154. CiteSeerX 10.1.1.627.3751 . дои : 10.1007/s10614-008-9153-3 . S2CID 17234503 . Архивировано (PDF) из оригинала 9 июля 2009 г.

- ^ И. Бен-Гал (2008). «Об использовании мер сжатия данных для анализа робастных проектов» (PDF) . Транзакции IEEE о надежности . 54 (3): 381–388. дои : 10.1109/TR.2005.853280 . S2CID 9376086 .

- ^ Д. Скалли; Карла Э. Бродли (2006). «Сжатие и машинное обучение: новый взгляд на векторы пространства признаков». Конференция по сжатию данных (DCC'06) . п. 332. дои : 10.1109/DCC.2006.13 . ISBN 0-7695-2545-8 . S2CID 12311412 .

- ^ Гэри Адкок (5 января 2023 г.). «Что такое сжатие видео AI?» . массивный.io . Проверено 6 апреля 2023 г.

- ^ Гилад Давид Мааян (24 ноября 2021 г.). «Сжатие изображений на основе искусственного интеллекта: современное состояние» . На пути к науке о данных . Проверено 6 апреля 2023 г.

- ^ «Что такое обучение без учителя? | IBM» . www.ibm.com . 23 сентября 2021 г. Проверено 5 февраля 2024 г.

- ^ «Дифференциально частная кластеризация для крупномасштабных наборов данных» . блог.research.google . 25 мая 2023 г. Проверено 16 марта 2024 г.

- ^ Эдвардс, Бендж (28 сентября 2023 г.). «Языковые модели искусственного интеллекта могут превосходить PNG и FLAC по сжатию без потерь, говорится в исследовании» . Арс Техника . Проверено 7 марта 2024 г.

- ^ Ле Ру, Николя; Бенджио, Йошуа; Фитцгиббон, Эндрю (2012). «Улучшение методов первого и второго порядка путем моделирования неопределенности» . Ин Сра, Суврит; Новозин, Себастьян; Райт, Стивен Дж. (ред.). Оптимизация для машинного обучения . МТИ Пресс. п. 404. ИСБН 9780262016469 . Архивировано из оригинала 17 января 2023 г. Проверено 12 ноября 2020 г.

- ^ Бздок, Данило; Альтман, Наоми ; Кшивинский, Мартин (2018). «Статистика против машинного обучения» . Природные методы . 15 (4): 233–234. дои : 10.1038/nmeth.4642 . ПМК 6082636 . ПМИД 30100822 .

- ^ Перейти обратно: а б Майкл И. Джордан (10 сентября 2014 г.). «статистика и машинное обучение» . реддит. Архивировано из оригинала 18 октября 2017 г. Проверено 1 октября 2014 г.

- ^ Хунг и др. Алгоритмы измерения эффективности хирурга и прогнозирования клинических результатов в роботизированной хирургии. ЖАМА Сург. 2018 год

- ^ Библиотека Корнельского университета (август 2001 г.). «Брейман: Статистическое моделирование: две культуры (с комментариями и ответом автора)» . Статистическая наука . 16 (3). дои : 10.1214/сс/1009213726 . S2CID 62729017 . Архивировано из оригинала 26 июня 2017 года . Проверено 8 августа 2015 г.

- ^ Гарет Джеймс; Даниэла Виттен; Тревор Хэсти; Роберт Тибширани (2013). Введение в статистическое обучение . Спрингер. п. VII. Архивировано из оригинала 23 июня 2019 г. Проверено 25 октября 2014 г.

- ^ Рамезанпур, А.; Бим, Алабама; Чен, Дж. Х.; Машаги, А. (17 ноября 2020 г.). «Статистическая физика для медицинской диагностики: алгоритмы обучения, вывода и оптимизации» . Диагностика . 10 (11): 972. doi : 10.3390/diagnostics10110972 . ПМЦ 7699346 . ПМИД 33228143 .

- ^ Машаги, А.; Рамезанпур, А. (16 марта 2018 г.). «Статистическая физика медицинской диагностики: Исследование вероятностной модели». Физический обзор E . 97 (3–1): 032118. arXiv : 1803.10019 . Бибкод : 2018PhRvE..97c2118M . дои : 10.1103/PhysRevE.97.032118 . ПМИД 29776109 . S2CID 4955393 .

- ^ Мори, Мехриар ; Ростамизаде, Афшин; Талвалкар, Амит (2012). Основы машинного обучения . США, Массачусетс: MIT Press. ISBN 9780262018258 .

- ^ Алпайдин, Этем (2010). Введение в машинное обучение . Лондон: MIT Press. ISBN 978-0-262-01243-0 . Проверено 4 февраля 2017 г.

- ^ Джордан, Мичиган; Митчелл, ТМ (17 июля 2015 г.). «Машинное обучение: тенденции, перспективы и перспективы». Наука . 349 (6245): 255–260. Бибкод : 2015Sci...349..255J . дои : 10.1126/science.aaa8415 . ПМИД 26185243 . S2CID 677218 .

- ^ Эль-Нака, Иссам; Мерфи, Мартин Дж. (2015). «Что такое машинное обучение?». Машинное обучение в радиационной онкологии . стр. 3–11. дои : 10.1007/978-3-319-18305-3_1 . ISBN 978-3-319-18304-6 . S2CID 178586107 .

- ^ Околи, Джуд А.; Сэвидж, Шона; Огбага, Чуквума К.; Гюнеш, Бурджу (июнь 2022 г.). «Оценка потенциала методов машинного обучения для изучения удаления фармацевтических препаратов из сточных вод с помощью биоугля или активированного угля» . Темы всеобщих исследований окружающей среды . 1–2 : 100001. doi : 10.1016/j.totert.2022.100001 . S2CID 249022386 .

- ^ Рассел, Стюарт Дж.; Норвиг, Питер (2010). Искусственный интеллект: современный подход (Третье изд.). Прентис Холл. ISBN 9780136042594 .

- ^ Мори, Мехриар; Ростамизаде, Афшин; Талвалкар, Амит (2012). Основы машинного обучения . Массачусетский технологический институт Пресс. ISBN 9780262018258 .

- ^ Алпайдин, Этем (2010). Введение в машинное обучение . МТИ Пресс. п. 9. ISBN 978-0-262-01243-0 . Архивировано из оригинала 17 января 2023 г. Проверено 25 ноября 2018 г.

- ^ Джордан, Майкл И.; Бишоп, Кристофер М. (2004). «Нейронные сети». У Аллена Б. Такера (ред.). Справочник по информатике, второе издание (раздел VII: Интеллектуальные системы) . Бока-Ратон, Флорида: Chapman & Hall/CRC Press LLC. ISBN 978-1-58488-360-9 .

- ^ Чжан, Бозен; Хуан, Хайян; Тиббс-Кортес, Лаура Э.; Ванус, Адам; Чжан, Живу; Сангине, Карен; Гарланд-Кэмпбелл, Кимберли А.; Ю, Цзяньмин; Ли, Сяньрань (2023). «Упростить машинное обучение без присмотра для исследования и построения графиков гаплотипов на основе indel из пангеномов» . Молекулярный завод . 16 (6): 975–978. дои : 10.1016/j.molp.2023.05.005 . ПМИД 37202927 .

- ^ Чжан, Бозен; Хуан, Хайян; Тиббс-Кортес, Лаура Э.; Ванус, Адам; Чжан, Живу; Сангине, Карен; Гарланд-Кэмпбелл, Кимберли А.; Ю, Цзяньмин; Ли, Сяньрань (13 февраля 2023 г.). Оптимизация машинного обучения без присмотра для исследования и построения графиков гаплотипов на основе indel из пангеномов (отчет). дои : 10.1101/2023.02.11.527743 .

- ^ Алекс Ратнер; Стивен Бах; Парома Варма; Крис. «Слабый надзор: новая парадигма программирования для машинного обучения» . hazyresearch.github.io . ссылаясь на работы многих других членов Hazy Research. Архивировано из оригинала 6 июня 2019 г. Проверено 6 июня 2019 г.

- ^ ван Оттерло, М.; Виринг, М. (2012). «Обучение с подкреплением и марковские процессы принятия решений». Обучение с подкреплением . Адаптация, обучение и оптимизация. Том. 12. стр. 3–42. дои : 10.1007/978-3-642-27645-3_1 . ISBN 978-3-642-27644-6 .

- ^ Роуэйс, Сэм Т.; Сол, Лоуренс К. (22 декабря 2000 г.). «Нелинейное уменьшение размерности путем локально линейного встраивания» . Наука . 290 (5500): 2323–2326. Бибкод : 2000Sci...290.2323R . дои : 10.1126/science.290.5500.2323 . ПМИД 11125150 . S2CID 5987139 . Архивировано из оригинала 15 августа 2021 года . Проверено 17 июля 2023 г.