Встраивание графа знаний

В представлению обучении используется внедрение графа знаний ( KGE ), также называемое обучением представлению знаний ( KRL ) или обучением с несколькими отношениями . [1] — это задача машинного обучения , заключающаяся в изучении низкоразмерного представления графа знаний сущностей и отношений с сохранением их семантического значения. [1] [2] [3] Используя встроенное представление, графы знаний (KG) могут использоваться для различных приложений, таких как прогнозирование связей , тройная классификация , распознавание сущностей , кластеризация и извлечение отношений . [1] [4]

Определение [ править ]

Граф знаний представляет собой совокупность сущностей , отношения и факты . [5] Факт – это тройка это обозначает ссылку между головой и хвост из тройки. Другое обозначение, которое часто используется в литературе для обозначения тройки (или факта), — это . Эта нотация называется структурой описания ресурсов (RDF). [1] [5] Граф знаний представляет знания, относящиеся к определенной области; используя это структурированное представление, можно вывести из него часть новых знаний после некоторых шагов уточнения. [6] Однако в настоящее время людям приходится сталкиваться с нехваткой данных и неэффективностью вычислений, чтобы использовать их в реальных приложениях. [3] [7]

Встраивание графа знаний преобразует каждую сущность и отношение графа знаний. в вектор заданной размерности , называемое измерением внедрения. [7] В общем случае мы можем иметь разные размеры внедрения для сущностей. и отношения . [7] Коллекция векторов внедрения для всех сущностей и отношений в графе знаний может затем использоваться для последующих задач.

Встраивание графа знаний характеризуется четырьмя различными аспектами: [1]

- Пространство представления: низкомерное пространство, в котором представлены сущности и отношения. [1]

- Функция оценки: мера качества тройного встроенного представления. [1]

- Модели кодирования: модальность, в которой встроенное представление сущностей и отношений взаимодействует друг с другом. [1]

- Дополнительная информация: любая дополнительная информация, поступающая из графа знаний, которая может обогатить встроенное представление. [1] Обычно специальная функция оценки интегрируется в общую функцию оценки для каждой дополнительной информации. [5] [1] [8]

Процедура встраивания [ править ]

Все различные модели внедрения графа знаний следуют примерно одной и той же процедуре для изучения семантического значения фактов. [7] Прежде всего, чтобы изучить встроенное представление графа знаний, векторы внедрения сущностей и отношений инициализируются случайными значениями. [7] Затем, начиная с обучающего набора и до достижения условия остановки, алгоритм непрерывно оптимизирует вложения. [7] Обычно условие остановки задается переобучением обучающего набора. [7] Для каждой итерации отбирается партия размером из обучающего набора, и для каждой тройки пакета выбирается случайный искаженный факт, т. е. тройка, которая не представляет истинный факт в графе знаний. [7] Искажение тройки предполагает замену головы или хвоста (или того и другого) тройки другой сущностью, что делает факт ложным. [7] Исходная тройка и поврежденная тройка добавляются в обучающий пакет, а затем встраивания обновляются, оптимизируя функцию оценки. [5] [7] В конце алгоритма изученные вложения должны были извлечь семантическое значение из троек и правильно предсказать невидимые истинные факты в графе знаний. [5]

Псевдокод [ править ]

Ниже приведен псевдокод общей процедуры внедрения. [9] [7]

algorithm Compute entity and relation embeddings is

input: The training set ,

entity set ,

relation set ,

embedding dimension

output: Entity and relation embeddings

initialization: the entities and relations embeddings (vectors) are randomly initialized

while stop condition do

// From the training set randomly sample a batch of size b

for each in do

// sample a corrupted fact of triple

end for

Update embeddings by minimizing the loss function

end while

эффективности Показатели

Эти индексы часто используются для измерения качества внедрения модели. Простота индексов делает их очень подходящими для оценки производительности алгоритма внедрения даже в больших масштабах. [10] Данный В качестве набора всех ранжированных прогнозов модели можно определить три различных индекса производительности: Hits@K, MR и MRR. [10]

Хитс@К [ править ]

Hits@K или, короче, H@K — это индекс производительности, который измеряет вероятность найти правильный прогноз в первых K лучших прогнозах модели. [10] Обычно его используют . [10] Hits@K отражает точность модели внедрения, позволяющую правильно предсказать связь между двумя заданными тройками. [10]

Хиты@К

Большие значения означают лучшие прогнозные характеристики. [10]

Средний рейтинг (MR) [ править ]

Средний рейтинг — это среднее ранговое положение элементов, предсказанных моделью, среди всех возможных элементов. [10]

Чем меньше значение, тем лучше модель. [10]

Средний обратный ранг ( ) MRR

Средний обратный ранг измеряет количество правильно предсказанных троек. [10] Если первая предсказанная тройка верна, то добавляется 1, если верна вторая суммируется и так далее. [10]

Средний обратный ранг обычно используется для количественной оценки эффекта алгоритмов поиска. [10]

Чем больше индекс, тем лучше модель. [10]

Приложения [ править ]

Задачи машинного обучения [ править ]

Завершение графа знаний (KGC) — это набор методов вывода знаний из встроенного представления графа знаний. [11] В частности, этот метод завершает тройной вывод недостающей сущности или отношения. [11] Соответствующие подзадачи называются прогнозированием связи или объекта (т. е. угадывание объекта по вложению с учетом другого объекта тройки и отношения) и прогнозированием отношения (т. е. прогнозирование наиболее правдоподобного отношения, соединяющего два объекта). [11]

Тройная классификация — это проблема бинарной классификации. [1] Учитывая тройку, обученная модель оценивает правдоподобность тройки, используя встраивание, чтобы определить, является ли тройка истинной или ложной. [11] Решение принимается с использованием функции оценки модели и заданного порога. [11] Кластеризация — это еще одно приложение, которое использует встроенное представление разреженного графа знаний для уплотнения представления схожих семантических объектов, близких к 2D-пространству. [4]

Реальные приложения [ править ]

Использование внедрения графа знаний становится все более распространенным во многих приложениях. В случае рекомендательных систем использование внедрения графа знаний может преодолеть ограничения обычного обучения с подкреплением . [12] [13] Обучение такой рекомендательной системы требует от пользователей огромного количества информации; однако методы графа знаний могут решить эту проблему, используя граф, уже построенный на основе предшествующих знаний о корреляции элементов, и используя встраивание, чтобы вывести из него рекомендацию. [12] Перепрофилирование лекарств – это использование уже одобренного лекарственного средства, но для терапевтической цели, отличной от той, для которой оно было первоначально разработано. [14] Можно использовать задачу прогнозирования связей, чтобы сделать вывод о новой связи между уже существующим лекарством и заболеванием, используя граф биомедицинских знаний, построенный с использованием огромного количества литературы и биомедицинских баз данных. [14] Встраивание графа знаний также можно использовать в области социальной политики. [4]

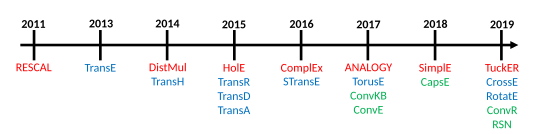

Модели [ править ]

Учитывая набор троек (или фактов) Модель внедрения графа знаний создает для каждой сущности и отношения, присутствующих в графе знаний, непрерывное векторное представление. [7] — соответствующее вложение тройки с и , где - это размерность внедрения для сущностей, и для отношений. [7] Оценочная функция данной модели обозначается и измеряет расстояние от внедрения головы до внедрения хвоста с учетом внедрения отношения, или, другими словами, он количественно определяет правдоподобие встроенного представления данного факта. [5]

Росси и др. предложить таксономию моделей внедрения и выделить три основных семейства моделей: модели тензорной декомпозиции, геометрические модели и модели глубокого обучения. [5]

Модель тензорной декомпозиции

Тензорная декомпозиция — это семейство моделей внедрения графа знаний, в которых для представления графа знаний используется многомерная матрица. [1] [5] [17] это частично познаваемо из-за пробелов в графе знаний, подробно описывающем конкретную область. [5] В частности, в этих моделях используется трехмерный (3D) тензор , который затем разлагается на низкоразмерные векторы, которые представляют собой вложения сущностей и отношений. [5] [17] Тензор третьего порядка является подходящей методологией для представления графа знаний, поскольку он фиксирует только наличие или отсутствие связи между сущностями. [17] и по этой причине просто, и нет необходимости априори знать структуру сети, [15] делая этот класс моделей внедрения легким и простым в обучении, даже если они страдают от многомерности и разреженности данных. [5] [17]

Билинейные модели [ править ]

В этом семействе моделей используется линейное уравнение для внедрения связи между объектами через отношение. [1] В частности, встроенное представление отношений представляет собой двумерную матрицу. [5] Эти модели во время процедуры внедрения используют только отдельные факты для вычисления встроенного представления и игнорируют другие ассоциации с той же сущностью или отношением. [18]

- ДистМульт [19] : Поскольку матрица вложения отношения является диагональной матрицей, [5] функция оценки не может различать асимметричные факты. [5] [18]

- Сложный [20] : поскольку DistMult использует диагональную матрицу для представления встраивания отношений, но добавляет представление в комплексном векторном пространстве и эрмитово произведение , он может различать симметричные и асимметричные факты. [5] [17] Этот подход масштабируется до большого графа знаний с точки зрения затрат времени и пространства. [20]

- АНАЛОГИЯ [21] : Эта модель кодирует встраивание аналогичной структуры графа знаний для имитации индуктивного рассуждения. [21] [5] [1] Используя дифференцируемую целевую функцию, АНАЛОГИЯ имеет хорошую теоретическую общность и вычислительную масштабируемость. [21] Доказано, что встраивание, произведенное ANALOGY, полностью восстанавливает встраивание DistMult, ComplEx и HolE. [21]

- Простой [22] : Эта модель является усовершенствованием канонической полиадической декомпозиции (CP), в которой изучаются вектор внедрения для отношения и два независимых вектора внедрения для каждого объекта, в зависимости от того, является ли он головой или хвостом в факте графа знаний. [22] SimplE решает проблему независимого обучения двух вложений сущностей, используя обратную зависимость и усредняя оценку CP и . [7] [17] Таким образом, SimplE собирает отношения между сущностями, пока они выступают в роли субъекта или объекта внутри факта, и может встраивать асимметричные отношения. [5]

Небилинейные модели [ править ]

- Дыра: [23] HolE использует круговую корреляцию для создания встроенного представления графа знаний. [23] который можно рассматривать как сжатие матричного произведения, но он более эффективен в вычислительном отношении и масштабируем, сохраняя при этом возможность выражать асимметричное отношение, поскольку круговая корреляция не является коммутативной. [18] HolE связывает голографические и комплексные вложения, поскольку при использовании вместе с Fourier его можно рассматривать как частный случай ComplEx. [1]

- ТакЕР: [24] TuckER рассматривает граф знаний как тензор, который можно разложить с помощью разложения Такера в набор векторов (то есть вложений сущностей и отношений) с общим ядром. [24] [5] Веса основного тензора изучаются вместе с вложениями и представляют уровень взаимодействия записей. [25] Каждая сущность и отношение имеют свое собственное измерение внедрения, а размер основного тензора определяется формой взаимодействующих сущностей и отношений. [5] Внедрение субъекта и объекта факта суммируется одинаковым образом, что делает TuckER полностью выразительным, а другие модели внедрения, такие как RESCAL, DistMult, ComplEx и SimplE, могут быть выражены как специальная формулировка TuckER. [24]

- МОЖЕТ: [26] MEI представляет метод многораздельного взаимодействия с тензорным форматом блочных терминов, который является обобщением CP-разложения и разложения Такера. Он делит вектор внедрения на несколько разделов и изучает локальные шаблоны взаимодействия на основе данных вместо использования фиксированных специальных шаблонов, как в моделях ComplEx или SimplE. Это позволяет MEI достичь оптимальной эффективности — компромисса между выразительностью, а не просто полной выразительностью. [26] Предыдущие модели, такие как TuckER, RESCAL, DistMult, ComplEx и SimplE, представляют собой неоптимальные ограниченные частные случаи MEI.

- мим: [27] MEIM выходит за рамки формата тензора блочных терминов и представляет независимый базовый тензор для эффектов усиления ансамбля и мягкую ортогональность для реляционного отображения максимального ранга, в дополнение к многораздельному взаимодействию встраивания. MEIM обобщает несколько предыдущих моделей, таких как MEI и входящие в нее модели RotaE и QuatE. [27] MEIM повышает выразительность, сохраняя при этом высокую эффективность на практике, помогая добиться хороших результатов при использовании моделей довольно небольших размеров.

Геометрические модели [ править ]

Геометрическое пространство, определяемое этим семейством моделей, кодирует отношение как геометрическое преобразование между началом и хвостом факта. [5] По этой причине для вычисления вложения хвоста необходимо применить преобразование к вложению головы и функции расстояния используется для измерения качества вложения или оценки надежности факта. [5]

Геометрические модели похожи на модель тензорного разложения, но основное различие между ними состоит в том, что они должны сохранять применимость преобразования в геометрическом пространстве, в котором он определен. [5]

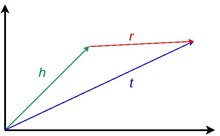

трансляционные Чисто модели

Этот класс моделей основан на идее трансляционной инвариантности, представленной в word2vec . [7] Чистая трансляционная модель опирается на тот факт, что вектора внедрения сущностей близки друг к другу после применения надлежащего реляционного перевода в геометрическом пространстве, в котором они определены. [18] Другими словами, если к внедрению отношения добавляется вложение головы, ожидаемым результатом должно быть встраивание хвоста. [5] Близость встраивания сущностей определяется некоторой мерой расстояния и количественно определяет надежность факта. [17]

- Транс [9] : Эта модель использует функцию оценки, которая заставляет вложения удовлетворять простому уравнению векторной суммы в каждом факте, в котором они появляются: . [7] Встраивание будет точным, если каждая сущность и отношение встречаются только в одном факте и по этой причине на практике плохо представляют отношения «один-ко-многим» , «многие-к-одному » и асимметричные отношения. [5] [7]

- TransH [28] : Это эволюция TransE, в которой гиперплоскость рассматривается как геометрическое пространство для решения проблемы правильного представления типов отношений. [28] В TransH каждое отношение имеет свое встроенное представление в другой гиперплоскости, в зависимости от того, с какими сущностями оно взаимодействует. [7] Следовательно, чтобы вычислить, например, оценочную функцию факта, встроенное представление головы и хвоста необходимо спроецировать с помощью реляционной матрицы проекции на правильную гиперплоскость отношения. [1] [7]

- ТрансР [29] : TransR является развитием TransH, поскольку он использует два разных пространства для представления встроенного представления сущностей и отношений. [1] [18] и полностью отделить семантическое пространство сущностей и отношений. [7] Также TransR использует матрицу реляционной проекции для перевода встраивания сущностей в пространство отношений. [7]

- Транс : [30] Учитывая факт, в TransR голова и хвост факта могут принадлежать двум разным типам сущностей, например, в факте Обама — две сущности, но одна — человек , и США а другая — страна. [30] [7] Умножение матриц также является дорогостоящей процедурой в TransR для вычисления проекции. [7] [30] В этом контексте TransD использует два вектора для каждой пары сущность-связь для вычисления динамического отображения, которое заменяет матрицу проекции, одновременно уменьшая размерную сложность. [1] [7] [30] Первый вектор используется для представления семантического значения сущностей и отношений, второй — для вычисления матрицы отображения. [30]

- TransA: [31] Все трансляционные модели определяют функцию оценки в своем пространстве представления, но они слишком упрощают эту потерю метрики. [31] Поскольку векторное представление сущностей и отношений не идеально, чистый перевод может быть далеко от , а сферическое эквипотенциальное евклидово расстояние затрудняет определение ближайшего объекта. [31] Вместо этого TransA вводит адаптивное расстояние Махаланобиса для взвешивания встраиваемых размеров вместе с эллиптическими поверхностями для устранения неоднозначности. [1] [7] [31]

Трансляционные модели с дополнительными вложениями [ править ]

С каждым элементом графа знаний и общими фактами их представления можно связать дополнительную информацию. [1] Каждая сущность и отношение могут быть дополнены текстовыми описаниями, весами, ограничениями и т. д., чтобы улучшить общее описание предметной области с помощью графа знаний. [1] Во время внедрения графа знаний эта информация может быть использована для изучения специализированных вложений по этим характеристикам вместе с обычным встроенным представлением сущностей и отношений, при этом затраты на обучение более значительного числа векторов. [5]

- СТрансЭ: [32] Эта модель является результатом комбинации TransE и встраивания структуры. [32] таким образом он может лучше представлять отношения «один-ко-многим», «многие-к-одному» и «многие-ко-многим» . [5] Для этого в модели задействованы две дополнительные независимые матрицы и для каждого встроенного отношения в КГ. [32] Каждая дополнительная матрица используется на основе того факта, что конкретное отношение взаимодействует с началом или хвостом факта. [32] Другими словами, учитывая факт , перед применением векторного перевода голова умножается на и хвост умножается на . [7]

- КроссЭ : [33] Перекрестные взаимодействия могут использоваться для выбора связанной информации и могут быть очень полезны для процедуры внедрения. [33] Перекрестные взаимодействия вносят два различных вклада в отбор информации: взаимодействия от отношений к сущностям и взаимодействия от сущностей к отношениям. [33] Это означает, что отношение, например «президент_оф», автоматически выбирает типы сущностей, которые связывают субъект с объектом факта. [33] Подобным образом сущность факта косвенно определяет, какой путь вывода необходимо выбрать, чтобы предсказать объект связанной тройки. [33] Для этого CrossE изучает дополнительную матрицу взаимодействия. , использует поэлементное произведение для вычисления взаимодействия между и . [5] [33] Даже если CrossE не опирается на архитектуру нейронной сети, показано, что эту методологию можно закодировать в такой архитектуре. [1]

Рото-трансляционные модели [ править ]

В этом семействе моделей в дополнение к переводу или вместо него используется преобразование, подобное повороту. [5]

- ТорЭ: [34] Термин регуляризации TransE заставляет объект встраиваться в сферическое пространство и, следовательно, теряет свойства перевода геометрического пространства. [34] Чтобы решить эту проблему, TorusE использует компактную группу Ли , которая в данном конкретном случае представляет собой n-мерное пространство тора , и избегает использования регуляризации. [1] [34] TorusE определяет функции расстояния для замены норм L1 и L2 TransE. [5]

- ПовернутьE: [35] RotatE вдохновлен тождеством Эйлера и предполагает использование произведения Адамара для представления отношения. как вращение от головы в хвост в сложном пространстве. [35] Для каждого элемента тройки комплексная часть вложения описывает вращение против часовой стрелки относительно оси, которое можно описать тождеством Эйлера, тогда как модуль вектора отношения равен 1. [35] Показано, что модель способна встраивать симметричные, асимметричные, инверсионные и композиционные отношения из графа знаний. [35]

глубокого обучения Модели

Эта группа моделей внедрения использует глубокую нейронную сеть для изучения закономерностей из графа знаний, которые являются входными данными. [5] Эти модели обладают общностью, позволяющей различать тип сущности и отношения, временную информацию, информацию о пути, подлежащую структурированную информацию, [18] и устранить ограничения моделей, основанных на расстоянии и семантическом сопоставлении, при представлении всех особенностей графа знаний. [1] Использование глубокого обучения для внедрения графа знаний показало хорошую прогностическую эффективность, даже если оно обходится дороже на этапе обучения, требует нехватки данных и часто требует предварительно обученного представления графа знаний, полученного из другой модели внедрения. [1] [5]

Сверточные нейронные сети [ править ]

В этом семействе моделей вместо использования полностью связанных слоев используются один или несколько сверточных слоев , которые свертывают входные данные с применением низкоразмерного фильтра, способного внедрять сложные структуры с небольшим количеством параметров путем изучения нелинейных функций. [1] [5] [18]

- Соглашение: [36] ConvE — это модель внедрения, которая представляет собой хороший компромисс между выразительностью моделей глубокого обучения и затратами вычислений. [17] фактически показано, что он использовал в 8 раз меньше параметров по сравнению с DistMult. [36] ConvE использует одномерный -размерное вложение для представления сущностей и отношений графа знаний. [5] [36] Чтобы вычислить оценочную функцию тройки, ConvE применяет простую процедуру: сначала объединяет и объединяет вложения головы тройки и отношения в одни данные. , то эта матрица используется в качестве входных данных для 2D-сверточного слоя. [5] [17] Затем результат передается через плотный слой, который применяет линейное преобразование, параметризованное матрицей и в конце с внутренним произведением соединяется хвостовая тройка. [5] [18] ConvE также особенно эффективен в процедуре оценки: при использовании оценки 1-N модель сопоставляет, учитывая заголовок и отношение, все хвосты одновременно, что экономит много времени оценки по сравнению с оценкой 1-1. программа других моделей. [18]

- КонвР: [37] ConvR — это адаптивная сверточная сеть, предназначенная для глубокого представления всех возможных взаимодействий между сущностями и отношениями. [37] Для этой задачи ConvR вычисляет сверточный фильтр для каждого отношения и, при необходимости, применяет эти фильтры к интересующему объекту для извлечения запутанных функций. [37] Процедура расчета тройного балла такая же, как и для ConvE. [5]

- КонвКБ: [38] ConvKB, для вычисления оценочной функции данной тройки , он производит ввод размера без изменения формы и передает его в серию сверточных фильтров размером . [38] Этот результат передает плотный слой только с одним нейроном, который выдает окончательную оценку. [38] Единственный конечный нейрон превращает эту архитектуру в бинарный классификатор, в котором факт может быть истинным или ложным. [5] Отличие от ConvE заключается в том, что размерность объектов не изменяется. [17]

Капсульные нейронные сети [ править ]

В этом семействе моделей используются капсульные нейронные сети для создания более стабильного представления, способного распознавать входные функции без потери пространственной информации. [5] Сеть состоит из сверточных слоев, но они организованы в капсулы, и общий результат капсулы отправляется в капсулу более высокого уровня, определяемую динамической процедурой процесса. [5]

- Шапки: [39] CapsE реализует капсульную сеть для моделирования факта . [39] Как и в ConvKB, каждый тройной элемент объединяется для построения матрицы. и используется для подачи на сверточный слой для извлечения сверточных признаков. [5] [39] Эти функции затем перенаправляются в капсулу для создания непрерывного вектора: чем длиннее вектор, тем более верен факт. [39]

Рекуррентные нейронные сети [ править ]

Этот класс моделей использует использование рекуррентной нейронной сети . [5] Преимущество этой архитектуры заключается в запоминании последовательности фактов, а не просто в разработке отдельных событий. [40]

- РСН: [40] В ходе процедуры внедрения обычно предполагается, что подобные сущности имеют схожие отношения. [40] На практике этот тип информации не используется, поскольку встраивание рассчитывается только на основе факта, а не истории фактов. [40] Сети с рекуррентным пропуском (RSN) используют рекуррентную нейронную сеть для изучения реляционного пути с использованием выборки случайного блуждания. [5] [40]

Производительность модели [ править ]

Задачей машинного обучения для внедрения графа знаний, которая чаще всего используется для оценки точности внедрения моделей, является прогнозирование связей. [1] [3] [5] [6] [7] [18] Росси и др. [5] провели обширное тестирование моделей, но и другие исследования дали аналогичные результаты. [3] [7] [18] [25] В тесте участвуют пять наборов данных FB15k, [9] ВН18, [9] ФБ15к-237, [41] ВН18РР, [36] и ЯГО3-10. [42] Совсем недавно обсуждалось, что эти наборы данных далеки от реальных приложений, и другие наборы данных должны быть интегрированы в качестве стандартного эталона. [43]

| Имя набора данных | Количество различных объектов | Количество различных отношений | Количество троек |

|---|---|---|---|

| ФБ15к [9] | 14951 | 1345 | 584,113 |

| ВН18 [9] | 40943 | 18 | 151,442 |

| ФБ15к-237 [41] | 14541 | 237 | 310,116 |

| ВН18RR [36] | 40943 | 11 | 93,003 |

| ВОЗРАСТ 3-10 лет [42] | 123182 | 37 | 1,089,040 |

| Название модели | Сложность памяти | FB15K (обращений @ 10) | ФБ15К (МР) | ФБ15К (МРР) | FB15K - 237 (Хит @ 10) | ФБ15К-237 (МР) | ФБ15К-237 (МРР) | WN18 (Хит@10) | WN18 (MR) | WN18 (МРР) | WN18RR (Хит@10) | WN18RR (MR) | WN18RR (МРР) | ЯГО3-10 (Хит@10) | ЯГО3-10 (МР) | ЯГО3-10 (МРР) |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| ДистМул [19] | 0.863 | 173 | 0.784 | 0.490 | 199 | 0.313 | 0.946 | 675 | 0.824 | 0.502 | 5913 | 0.433 | 0.661 | 1107 | 0.501 | |

| Сложный [20] | 0.905 | 34 | 0.848 | 0.529 | 202 | 0.349 | 0.955 | 3623 | 0.949 | 0.521 | 4907 | 0.458 | 0.703 | 1112 | 0.576 | |

| Дыра [23] | 0.867 | 211 | 0.800 | 0.476 | 186 | 0.303 | 0.949 | 650 | 0.938 | 0.487 | 8401 | 0.432 | 0.651 | 6489 | 0.502 | |

| АНАЛОГИЯ [21] | 0.837 | 126 | 0.726 | 0.353 | 476 | 0.202 | 0.944 | 808 | 0.934 | 0.380 | 9266 | 0.366 | 0.456 | 2423 | 0.283 | |

| Простой [22] | 0.836 | 138 | 0.726 | 0.343 | 651 | 0.179 | 0.945 | 759 | 0.938 | 0.426 | 8764 | 0.398 | 0.631 | 2849 | 0.453 | |

| ТакЕР [24] | 0.888 | 39 | 0.788 | 0.536 | 162 | 0.352 | 0.958 | 510 | 0.951 | 0.514 | 6239 | 0.459 | 0.680 | 2417 | 0.544 | |

| МОЖЕТ [26] | 0.552 | 145 | 0.365 | 0.551 | 3268 | 0.481 | 0.709 | 756 | 0.578 | |||||||

| мим [27] | 0.557 | 137 | 0.369 | 0.577 | 2434 | 0.499 | 0.716 | 747 | 0.585 | |||||||

| Транс [9] | 0.847 | 45 | 0.628 | 0.497 | 209 | 0.310 | 0.948 | 279 | 0.646 | 0.495 | 3936 | 0.206 | 0.673 | 1187 | 0.501 | |

| ЗАКРЫВАТЬ [32] | 0.796 | 69 | 0.543 | 0.495 | 357 | 0.315 | 0.934 | 208 | 0.656 | 0.422 | 5172 | 0.226 | 0.073 | 5797 | 0.049 | |

| КроссE [33] | 0.862 | 136 | 0.702 | 0.470 | 227 | 0.298 | 0.950 | 441 | 0.834 | 0.449 | 5212 | 0.405 | 0.654 | 3839 | 0.446 | |

| ТорусЭ [34] | 0.839 | 143 | 0.746 | 0.447 | 211 | 0.281 | 0.954 | 525 | 0.947 | 0.535 | 4873 | 0.463 | 0.474 | 19455 | 0.342 | |

| ПоворотE [35] | 0.881 | 42 | 0.791 | 0.522 | 178 | 0.336 | 0.960 | 274 | 0.949 | 0.573 | 3318 | 0.475 | 0.570 | 1827 | 0.498 | |

| КонвЭ [36] | 0.849 | 51 | 0.688 | 0.521 | 281 | 0.305 | 0.956 | 413 | 0.945 | 0.507 | 4944 | 0.427 | 0.657 | 2429 | 0.488 | |

| КонвКБ [38] | 0.408 | 324 | 0.211 | 0.517 | 309 | 0.230 | 0.948 | 202 | 0.709 | 0.525 | 3429 | 0.249 | 0.604 | 1683 | 0.420 | |

| конвр [37] | 0.885 | 70 | 0.773 | 0.526 | 251 | 0.346 | 0.958 | 471 | 0.950 | 0.526 | 5646 | 0.467 | 0.673 | 2582 | 0.527 | |

| СКОБЫ [39] | 0.217 | 610 | 0.087 | 0.356 | 405 | 0.160 | 0.950 | 233 | 0.890 | 0.559 | 720 | 0.415 | 0 | 60676 | 0.000 | |

| РСН [40] | 0.870 | 51 | 0.777 | 0.444 | 248 | 0.280 | 0.951 | 346 | 0.928 | 0.483 | 4210 | 0.395 | 0.664 | 1339 | 0.511 |

Библиотеки [ править ]

- КГЭ на GitHub

- МЭИ-КГЭ на GitHub

- Pykg2vec на GitHub

- DGL-KE на GitHub

- PyKEEN на GitHub

- TorchKGE on GitHub

- AmpliGraph на GitHub

- OpenKE на GitHub

- scikit-kge на GitHub

- Fast-TransX на GitHub

- МЭИМ-КГЭ на GitHub

- DICEE на GitHub

См. также [ править ]

- График знаний

- Встраивание

- Машинное обучение

- База знаний

- Извлечение знаний

- Статистическое реляционное обучение

- Обучение представлению

- Встраивание графа

Ссылки [ править ]

- ^ Jump up to: Перейти обратно: а б с д и ж г час я дж к л м н тот п д р с т в v В х и С аа Цзи, Шаосюн; Пан, Шируи; Камбрия, Эрик; Мартинен, Пекка; Ю, Филип С. (2021). «Опрос по графам знаний: представление, приобретение и применение» . Транзакции IEEE в нейронных сетях и системах обучения . ПП (2): 494–514. arXiv : 2002.00388 . дои : 10.1109/TNNLS.2021.3070843 . hdl : 10072/416709 . ISSN 2162-237X . ПМИД 33900922 . S2CID 211010433 .

- ^ Мохамед, Самех К; Новачек, Вит; Нуну, Аая (01 августа 2019 г.). Коуэн, Ленор (ред.). «Обнаружение мишеней белковых лекарств с использованием встраивания графа знаний» . Биоинформатика . 36 (2): 603–610. doi : 10.1093/биоинформатика/btz600 . hdl : 10379/15375 . ISSN 1367-4803 . PMID 31368482 .

- ^ Jump up to: Перейти обратно: а б с д ; Янкай Линь Хань , , Сюй ,

- ^ Jump up to: Перейти обратно: а б с Абу-Салих, Билал; Аль-Тавиль, Марван; Альджара, Ибрагим; Фарис, Хосам; Вонгтонгтам, Порнпит; Чан, Кит Ян; Бехешти, Амин (12 мая 2021 г.). «Анализ социальной политики с использованием реляционного обучения с использованием внедрения графа знаний» . Интеллектуальный анализ данных и обнаружение знаний . 35 (4): 1497–1536. arXiv : 2006.01626 . дои : 10.1007/s10618-021-00760-w . ISSN 1573-756X . S2CID 219179556 .

- ^ Jump up to: Перейти обратно: а б с д и ж г час я дж к л м н тот п д р с т в v В х и С аа аб и объявление но из в ах есть также и аль являюсь а к ап ак с как Росси, Андреа; Барбоза, Денилсон; Фирмани, Донателла; Матината, Антонио; Мериальдо, Паоло (2020). «Внедрение графов знаний для прогнозирования ссылок: сравнительный анализ» . Транзакции ACM по извлечению знаний из данных . 15 (2): 1–49. arXiv : 2002.00819 . дои : 10.1145/3424672 . hdl : 11573/1638610 . ISSN 1556-4681 . S2CID 211011226 .

- ^ Jump up to: Перейти обратно: а б Паульхейм, Хайко (06 декабря 2016 г.). Чимиано, Филипп (ред.). «Уточнение графа знаний: обзор подходов и методов оценки» . Семантическая сеть . 8 (3): 489–508. дои : 10.3233/SW-160218 . S2CID 13151033 .

- ^ Jump up to: Перейти обратно: а б с д и ж г час я дж к л м н тот п д р с т в v В х и С аа аб Дай, Юаньфэй; Ван, Шиппинг; Сюн, Нил Н.; Го, Вэньчжун (май 2020 г.). «Опрос по внедрению графов знаний: подходы, приложения и ориентиры» . Электроника . 9 (5): 750. doi : 10.3390/electronics9050750 .

- ^ Го, Шу; Ван, Цюань; Ван, Бин; Ван, Лихун; Го, Ли (2015). «Семантически гладкое встраивание графа знаний» . Материалы 53-го ежегодного собрания Ассоциации компьютерной лингвистики и 7-й Международной совместной конференции по обработке естественного языка (Том 1: Длинные статьи) . Ассоциация компьютерной лингвистики. стр. 84–94. дои : 10.3115/v1/P15-1009 . S2CID 205692 .

- ^ Jump up to: Перейти обратно: а б с д и ж г Борд, Антуан; Усунье, Николя; Гарсиа-Дюран, Альберто; Уэстон, Джейсон; Яхненко, Оксана (май 2013 г.). «Перевод вложений для моделирования многореляционных данных» . NIPS'13: Материалы 26-й Международной конференции по нейронным системам обработки информации . Curran Associates Inc., стр. 2787–2795.

- ^ Jump up to: Перейти обратно: а б с д и ж г час я дж к л Чэнь, Юэхан; Чжао, ( . 2020 Дуань Цзунтао Цзин ; , ) .8s2435C .дои : 10.1109 . ISSN 2169-3536 ACCESS.2020.3030076 /

- ^ Jump up to: Перейти обратно: а б с д и Цай, Хонгюн; Чжэн, Винсент В.; Чанг, Кевин Чен-Чуан (2 февраля 2018 г.). «Комплексный обзор встраивания графов: проблемы, методы и приложения». arXiv : 1709.07604 [ cs.AI ].

- ^ Jump up to: Перейти обратно: а б Чжоу, Синьи; Чен, Вэйнань; Тан, Жуймин; Сюцян, Юн (18 июня 2020 г.). " .arXiv : 2006.10389 [ cs.IR ].

- ^ Лю, Чан; Ли, Лунь; Яо, Сяолу; Тан, Линь (август 2019 г.). «Обзор рекомендательных алгоритмов, основанных на внедрении графа знаний» . Международная конференция IEEE по компьютерным наукам и информатизации образования (CSEI) 2019 . стр. 168–171. дои : 10.1109/CSEI47661.2019.8938875 . ISBN 978-1-7281-2308-0 . S2CID 209459928 .

- ^ Jump up to: Перейти обратно: а б Соса, Дэниел Н.; Дерри, Александр; Го, Маргарет; Вэй, Эрик; Бринтон, Коннор; Альтман, Расс Б. (2020). «Метод внедрения графа знаний на основе литературы для выявления возможностей повторного использования лекарств при редких заболеваниях» . Тихоокеанский симпозиум по биокомпьютингу. Тихоокеанский симпозиум по биокомпьютингу . 25 : 463–474. ISSN 2335-6936 . ПМК 6937428 . ПМИД 31797619 .

- ^ Jump up to: Перейти обратно: а б Никель, Максимилиан; Тресп, Волкер; Кригель, Ханс-Петер (28 июня 2011 г.). «Трехсторонняя модель коллективного обучения на многореляционных данных» . ICML'11: Материалы 28-й Международной конференции по машинному обучению . Омнипресс. стр. 809–816. ISBN 978-1-4503-0619-5 .

- ^ Никель, Максимилиан; Тресп, Волкер; Кригель, Ханс-Петер (16 апреля 2012 г.). «Факторизация ЯГО». Материалы 21-й международной конференции по Всемирной паутине . Ассоциация вычислительной техники. стр. 271–280. дои : 10.1145/2187836.2187874 . ISBN 978-1-4503-1229-5 . S2CID 6348464 .

- ^ Jump up to: Перейти обратно: а б с д и ж г час я дж Альшахрани, Мона; Тафар, Маха А.; Эссак, Магбуба (18 февраля 2021 г.). «Применение и оценка встраивания графов знаний в биомедицинские данные» . PeerJ Информатика . 7 : е341. doi : 10.7717/peerj-cs.341 . ISSN 2376-5992 . ПМЦ 7959619 . ПМИД 33816992 .

- ^ Jump up to: Перейти обратно: а б с д и ж г час я дж к Ван, Мэйхун; Цю, Линьлин; Ван, Сяоли (16 марта 2021 г.). «Опрос по внедрению графов знаний для прогнозирования ссылок» . Симметрия . 13 (3): 485. Бибкод : 2021Symm...13..485W . дои : 10.3390/sym13030485 . ISSN 2073-8994 .

- ^ Jump up to: Перейти обратно: а б Ян, Бишань; Йи, Вен-тау; Он, Сяодун; Гао, Цзяньфэн; Дэн, Ли (29 августа 2015 г.). «Внедрение сущностей и отношений для обучения и вывода в базы знаний». arXiv : 1412.6575 [ cs.CL ].

- ^ Jump up to: Перейти обратно: а б с Труйон, Тео; Вельбл, Йоханнес; Ридель, Себастьян; Гаусье, Эрик; Бушар, Гийом (20 июня 2016 г.). «Сложные внедрения для простого прогнозирования ссылок». arXiv : 1606.06357 [ cs.AI ].

- ^ Jump up to: Перейти обратно: а б с д и Лю, Ханьсяо; Ву, Юэсинь; Ян, Имин (6 июля 2017 г.). «Аналогический вывод для многореляционных вложений». arXiv : 1705.02426 [ cs.LG ].

- ^ Jump up to: Перейти обратно: а б с Каземи, Сейед Мехран; Пул, Дэвид (25 октября 2018 г.). «Внедрение SimplE для прогнозирования ссылок в диаграммах знаний». arXiv : 1802.04868 [ stat.ML ].

- ^ Jump up to: Перейти обратно: а б с Никель, Максимилиан; Росаско, Лоренцо; Поджо, Томазо (07 декабря 2015 г.). «Голографические вложения графов знаний». arXiv : 1510.04935 [ cs.AI ].

- ^ Jump up to: Перейти обратно: а б с д Балажевич, Ивана; Аллен, Карл; Хоспедалес, Тимоти М. (2019). «TuckER: Тензорная факторизация для завершения графа знаний». Материалы конференции 2019 года по эмпирическим методам обработки естественного языка и 9-й Международной совместной конференции по обработке естественного языка (EMNLP-IJCNLP) . стр. 5184–5193. arXiv : 1901.09590 . дои : 10.18653/v1/D19-1522 . S2CID 59316623 .

- ^ Jump up to: Перейти обратно: а б Али, Мехди; Беррендорф, Макс; Хойт, Чарльз Тэпли; Вермю, Лоран; Галкин Михаил; Шарифзаде, Саханд; Фишер, Ася; Тресп, Волкер; Леманн, Йенс (2021). «Просвещая тьму: крупномасштабная оценка моделей внедрения графов знаний в единой структуре». Транзакции IEEE по анализу шаблонов и машинному интеллекту . ПП (12): 8825–8845. arXiv : 2006.13365 . дои : 10.1109/TPAMI.2021.3124805 . ПМИД 34735335 . S2CID 220041612 .

- ^ Jump up to: Перейти обратно: а б с Тран, Хунг Нгип; Такасу, Ацухиро (2020). «Взаимодействие многораздельного внедрения с форматом блочного термина для завершения диаграммы знаний» . Материалы Европейской конференции по искусственному интеллекту (ECAI 2020) . Границы искусственного интеллекта и приложений. Том. 325. ИОС Пресс. стр. 833–840. дои : 10.3233/FAIA200173 . S2CID 220265751 .

- ^ Jump up to: Перейти обратно: а б с Тран, Хунг-Нгип; Такасу, Ацухиро (16 июля 2022 г.). «MEIM: многораздельное встраивание взаимодействия за пределами формата блочного термина для эффективного и выразительного прогнозирования ссылок». Материалы тридцать первой международной совместной конференции по искусственному интеллекту . Том. 3. С. 2262–2269. дои : 10.24963/ijcai.2022/314 . ISBN 978-1-956792-00-3 . S2CID 250635995 .

- ^ Jump up to: Перейти обратно: а б Ван, Чжэнь (2014). «Встраивание графов знаний путем перевода на гиперплоскости» . Материалы конференции AAAI по искусственному интеллекту . Том. 28. дои : 10.1609/aaai.v28i1.8870 . S2CID 15027084 .

- ^ Лин, Янкай; Лю, Чжиюань; Сунь, Маосун; Лю, Ян; Чжу, Сюань (25 января 2015 г.). Встраивание обучающих сущностей и отношений для завершения графа знаний . АААИ Пресс. стр. 2181–2187. ISBN 978-0-262-51129-2 .

- ^ Jump up to: Перейти обратно: а б с д и Цзи, Голян; Он, Шижу; Сюй, Лихэн; Лю, Канг; Чжао, Цзюнь (июль 2015 г.). «Внедрение графа знаний с помощью матрицы динамического отображения» . Материалы 53-го ежегодного собрания Ассоциации компьютерной лингвистики и 7-й Международной совместной конференции по обработке естественного языка (Том 1: Длинные статьи) . Ассоциация компьютерной лингвистики. стр. 687–696. дои : 10.3115/v1/P15-1067 . S2CID 11202498 .

- ^ Jump up to: Перейти обратно: а б с д Сяо, Хан; Хуан, Минли; Хао, Ю; Чжу, Сяоянь (27 сентября 2015 г.). «TransA: адаптивный подход к внедрению графа знаний». arXiv : 1509.05490 [ cs.CL ].

- ^ Jump up to: Перейти обратно: а б с д и Нгуен, Дат Куок; Сиртс, Кайрит; Цюй, Личжэнь; Джонсон, Марк (июнь 2016 г.). «STransE: новая модель внедрения сущностей и отношений в базы знаний» . Материалы конференции Североамериканского отделения Ассоциации компьютерной лингвистики 2016 года: технологии человеческого языка . Ассоциация компьютерной лингвистики. стр. 460–466. arXiv : 1606.08140 . дои : 10.18653/v1/N16-1054 . S2CID 9884935 .

- ^ Jump up to: Перейти обратно: а б с д и ж г Чжан, Вэнь; Паудель, Бибек; Чжан, Вэй; Бернштейн, Авраам; Чен, Хуацзюнь (30 января 2019 г.). «Внедрение взаимодействия для прогнозирования и объяснения в графах знаний». Материалы двенадцатой Международной конференции ACM по веб-поиску и интеллектуальному анализу данных . стр. 96–104. arXiv : 1903.04750 . дои : 10.1145/3289600.3291014 . ISBN 9781450359405 . S2CID 59516071 .

- ^ Jump up to: Перейти обратно: а б с д Эбису, Такума; Ичисе, Рютаро (15 ноября 2017 г.). «TorusE: встраивание графа знаний в группу лжи». arXiv : 1711.05435 [ cs.AI ].

- ^ Jump up to: Перейти обратно: а б с д и Сунь, Чжицин; Дэн, Чжи-Хун; Не, Цзянь-Юнь; Тан, Цзянь (26 февраля 2019 г.). «Rotate: встраивание графа знаний путем реляционного вращения в сложное пространство». arXiv : 1902.10197 [ cs.LG ].

- ^ Jump up to: Перейти обратно: а б с д и ж Деттмерс, Тим; Минервини, Паскуале; Стенеторп, Понт; Ридель, Себастьян (04 июля 2018 г.). «Вложения сверточных 2D-графов знаний». arXiv : 1707.01476 [ cs.LG ].

- ^ Jump up to: Перейти обратно: а б с д Цзян, Сяотянь; Ван, Цюань; Ван, Бинь (июнь 2019 г.). «Адаптивная свертка для многореляционного обучения» . Материалы конференции Севера 2019 года . Ассоциация компьютерной лингвистики. стр. 978–987. дои : 10.18653/v1/N19-1103 . S2CID 174800352 .

- ^ Jump up to: Перейти обратно: а б с д Нгуен, Дай Куок; Нгуен, Ту Динь; Нгуен, Дат Куок; Пхунг, Динь (2018). «Новая модель внедрения для пополнения базы знаний на основе сверточной нейронной сети». Материалы конференции Североамериканского отделения Ассоциации компьютерной лингвистики 2018 года: технологии человеческого языка, том 2 (короткие статьи) . стр. 327–333. arXiv : 1712.02121 . дои : 10.18653/v1/N18-2053 . S2CID 3882054 .

- ^ Jump up to: Перейти обратно: а б с д и Нгуен, Дай Куок; Ву, Тхань; Нгуен, Ту Динь; Нгуен, Дат Куок; Пунг, Динь (06 марта 2019 г.). «Модель внедрения на основе капсульной сети для заполнения диаграмм знаний и персонализации поиска». arXiv : 1808.04122 [ cs.CL ].

- ^ Jump up to: Перейти обратно: а б с д и ж Го, Линбин; Сунь, Зекун; Ху, Вэй (13 мая 2019 г.). «Научимся использовать долгосрочные реляционные зависимости в графах знаний». arXiv : 1905.04914 [ cs.AI ].

- ^ Jump up to: Перейти обратно: а б Тутанова, Кристина; Чен, Данци (июль 2015 г.). «Наблюдаемые и скрытые функции для базы знаний и вывода текста» . Материалы 3-го семинара по моделям непрерывного векторного пространства и их композиционности . Ассоциация компьютерной лингвистики. стр. 57–66. дои : 10.18653/v1/W15-4007 . S2CID 5378837 .

- ^ Jump up to: Перейти обратно: а б Махдисолтани, Ф.; Биега, Дж.; Суханек, Фабиан М. (2015). «ЯГО3: База знаний из многоязычной Википедии» ЦИДР . S2CID 6611164 .

- ^ Ху, Вэйхуа; Фей, Матиас; Зитник, Маринка; Донг, Юйсяо; Рен, Хунъюй; Лю, Боуэн; Катаста, Микеле; Лесковец, Юре (24 февраля 2021 г.). «Бенчмарк Open Graph: наборы данных для машинного обучения на графиках». arXiv : 2005.00687 [ cs.LG ].

![{\displaystyle ={\frac {|\{q\in Q:q<k\}|}{|Q|}}\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cd0b504a6a4026009b8f5a0c39ad0ce4c88e5977)

![{\displaystyle MRR={\frac {1}{|Q|}}\sum _{q\in Q}{\frac {1}{q}}\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/adf9b1771d7ac872c4d3082c26b15e8eb9f3e512)

![{\displaystyle {\ce {[h;{\mathcal {r}}]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4754a8e29d7b4ccd4cf13de3052aef0922840171)

![{\displaystyle {\ce {[h;{\mathcal {r}};t]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fb32c4cfc9fa12eb799777f7234990ce33b3d544)