Глубокое обучение

| Часть серии о |

| Искусственный интеллект |

|---|

Глубокое обучение — это подмножество методов машинного обучения , основанных на нейронных сетях с обучением представлений . Прилагательное «глубокий» относится к использованию в сети нескольких уровней. Используемые методы могут быть контролируемыми , полуконтролируемыми или неконтролируемыми . [2]

Архитектуры глубокого обучения, такие как глубокие нейронные сети , сети глубоких убеждений , рекуррентные нейронные сети , сверточные нейронные сети и преобразователи, применяются в таких областях, как компьютерное зрение , распознавание речи , обработка естественного языка , машинный перевод , биоинформатика , дизайн лекарств , анализ медицинских изображений. , климатологии , инспекции материалов и программ настольных игр , где они дали результаты, сравнимые, а в некоторых случаях превосходящие результаты человеческих экспертов. [3] [4] [5]

Ранние формы нейронных сетей были вдохновлены обработкой информации и распределенными узлами связи в биологических системах , в частности в человеческом мозге . Однако современные нейронные сети не предназначены для моделирования функций мозга организмов и обычно рассматриваются для этой цели как модели низкого качества. [6]

Обзор [ править ]

Большинство современных моделей глубокого обучения основаны на многослойных нейронных сетях , таких как сверточные нейронные сети и преобразователи , хотя они также могут включать в себя пропозициональные формулы или скрытые переменные, организованные послойно в глубоких генеративных моделях, таких как узлы в глубоких сетях доверия и глубоких моделях Больцмана. машины . [7]

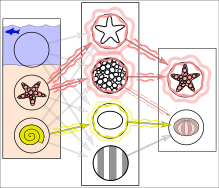

По сути, глубокое обучение относится к классу машинного обучения алгоритмов , в которых иерархия слоев используется для преобразования входных данных в несколько более абстрактное и составное представление. Например, в модели распознавания изображений необработанными входными данными может быть изображение (представленное в виде пикселей ) тензора . Первый репрезентативный уровень может пытаться идентифицировать основные формы, такие как линии и круги, второй уровень может составлять и кодировать расположение краев, третий уровень может кодировать нос и глаза, а четвертый уровень может распознавать, что изображение содержит лицо.

Важно отметить, что процесс глубокого обучения может самостоятельно определить, какие функции и на каком уровне оптимально разместить . До глубокого обучения методы машинного обучения часто включали в себя ручную разработку признаков для преобразования данных в более подходящее представление для работы алгоритма классификации. В подходе глубокого обучения функции не создаются вручную, и модель автоматически обнаруживает полезные представления функций из данных. Это не исключает необходимости ручной настройки; например, разное количество слоев и их размеры могут обеспечить разную степень абстракции. [8] [2]

Слово «глубокий» в «глубоком обучении» относится к количеству слоев, посредством которых преобразуются данные. Точнее, системы глубокого обучения имеют значительную глубину пути присвоения кредитов (CAP). CAP — это цепочка преобразований от входа к выходу. CAP описывают потенциально причинно-следственные связи между входом и выходом. Для нейронной сети прямого распространения глубина CAP равна глубине сети и равна количеству скрытых слоев плюс один (поскольку выходной слой также параметризуется). Для рекуррентных нейронных сетей , в которых сигнал может распространяться через слой более одного раза, глубина CAP потенциально не ограничена. [9] Не существует общепринятого порога глубины, который разделяет поверхностное обучение и глубокое обучение, но большинство исследователей согласны с тем, что глубокое обучение предполагает глубину CAP выше 2. Было показано, что CAP глубины 2 является универсальным аппроксиматором в том смысле, что он может имитировать любую функцию. . [10] Помимо этого, большее количество слоев не увеличивает возможности аппроксимации функций сети. Глубокие модели (CAP > 2) способны извлекать лучшие функции, чем поверхностные модели, и, следовательно, дополнительные слои помогают эффективно изучать функции.

Архитектуры глубокого обучения могут быть построены жадным послойным методом. [11] Глубокое обучение помогает распутать эти абстракции и выбрать, какие функции улучшают производительность. [8]

Алгоритмы глубокого обучения могут применяться к задачам обучения без присмотра. Это важное преимущество, поскольку неразмеченных данных больше, чем размеченных. Примерами глубоких структур, которые можно обучать без присмотра, являются сети глубоких убеждений . [8] [12]

Интерпретации [ править ]

Глубокие нейронные сети обычно интерпретируются с точки зрения универсальной аппроксимационной теоремы. [13] [14] [15] [16] [17] или вероятностный вывод . [18] [19] [8] [9] [20]

Классическая универсальная теорема аппроксимации касается способности нейронных сетей прямого распространения с одним скрытым слоем конечного размера аппроксимировать непрерывные функции . [13] [14] [15] [16] было опубликовано первое доказательство В 1989 году Джорджем Цибенко функций сигмовидной кишки . активации [13] и был обобщен для многоуровневых архитектур с прямой связью в 1991 году Куртом Хорником. [14] Недавняя работа также показала, что универсальное приближение справедливо и для неограниченных функций активации, таких как Кунихико Фукусимы выпрямленная линейная единица . [21] [22]

Универсальная аппроксимационная теорема для глубоких нейронных сетей касается пропускной способности сетей с ограниченной шириной, но глубине разрешено расти. Лу и др. [17] доказал, что если ширина глубокой нейронной сети с активацией ReLU строго больше входной размерности, то сеть может аппроксимировать любую интегрируемую по Лебегу функцию ; если ширина меньше или равна входному измерению, то глубокая нейронная сеть не является универсальным аппроксиматором.

Вероятностная интерпретация [20] происходит из области машинного обучения . Он включает в себя умозаключение, [19] [7] [8] [9] [12] [20] а также оптимизации концепции обучения и тестирования , связанные с подгонкой и обобщением соответственно. Более конкретно, вероятностная интерпретация рассматривает нелинейность активации как кумулятивную функцию распределения . [20] Вероятностная интерпретация привела к использованию отсева в качестве регуляризатора в нейронных сетях. Вероятностная интерпретация была предложена такими исследователями, как Хопфилд , Уидроу и Нарендра , и популяризирована в исследованиях, таких как исследование Бишопа . [23]

История [ править ]

Существовало два типа искусственных нейронных сетей (ИНС): нейронные сети прямого распространения (FNN) и рекуррентные нейронные сети (RNN). У RNN есть циклы в структуре связности, у FNN их нет. В 1920-х годах Вильгельм Ленц и Эрнст Изинг создали и проанализировали модель Изинга. [24] по сути, это необучающаяся архитектура RNN, состоящая из нейроноподобных пороговых элементов. В 1972 году Шуничи Амари сделал эту архитектуру адаптивной. [25] [26] Его изучение RNN было популяризировано Джоном Хопфилдом в 1982 году. [27]

Чарльз Тапперт пишет, что Фрэнк Розенблатт разработал и исследовал все основные компоненты современных систем глубокого обучения. [28] ссылка на книгу Розенблатта 1962 года [29] который представил многослойный персептрон (MLP) с тремя слоями: входным слоем, скрытым слоем со случайными весами, которые не обучались, и выходным слоем. Он также представил варианты, в том числе версию с четырехслойными перцептронами, где последние два слоя обучаются весам (и, таким образом, это настоящий многослойный перцептрон). [29] : раздел 16 Кроме того, термин глубокое обучение был предложен в 1986 году Риной Дектер. [30] хотя история его появления, видимо, более сложна. [31]

Первый общий рабочий алгоритм обучения для контролируемых, глубоких, многослойных перцептронов с прямой связью был опубликован Алексеем Ивахненко и Лапа в 1967 году. [32] В статье 1971 года описывалась глубокая сеть с восемью уровнями, обученная групповым методом обработки данных . [33]

Первый многослойный перцептрон глубокого обучения , обученный методом стохастического градиентного спуска [34] был опубликован в 1967 году Шуничи Амари . [35] [26] В компьютерных экспериментах, проведенных учеником Амари Сайто, пятислойная MLP с двумя изменяемыми слоями изучила внутренние представления для классификации классов нелинейно разделимых шаблонов. [26] В 1987 году Мэтью Брэнд сообщил, что широкие 12-слойные нелинейные перцептроны могут быть полностью обучены для воспроизведения логических функций нетривиальной глубины схемы посредством градиентного спуска на небольших партиях случайных входных/выходных выборок, но пришел к выводу, что время обучения на современном оборудовании (компьютеры с субмегафлопсной производительностью) сделали эту технику непрактичной и предложили использовать фиксированные случайные ранние слои в качестве входного хеша для одного изменяемого слоя. [36] Вместо этого последующие разработки в области аппаратного обеспечения и настройки гиперпараметров сделали сквозной стохастический градиентный спуск доминирующим в настоящее время методом обучения.

В 1970 году Сеппо Линнаинмаа опубликовал обратный режим автоматического дифференцирования дискретных связных сетей вложенных дифференцируемых функций. [37] [38] [39] Это стало известно как обратное распространение ошибки . [9] Это эффективное применение цепного правила, выведенного Готфридом Вильгельмом Лейбницем в 1673 году. [40] к сетям дифференцируемых узлов. [26] Терминология «ошибки обратного распространения ошибки» была введена в 1962 году Розенблаттом. [29] [26] но он не знал, как это реализовать, хотя у Генри Дж. Келли был постоянный предшественник обратного распространения ошибки [41] уже в 1960 году в контексте теории управления . [26] В 1982 году Пол Вербос применил обратное распространение ошибки к MLP способом, который стал стандартным. [42] [43] [26] В 1985 году Дэвид Э. Румельхарт и др. опубликовал экспериментальный анализ метода. [44]

Архитектуры глубокого обучения для сверточных нейронных сетей (CNN) со сверточными слоями и слоями понижающей дискретизации начались с Неокогнитрона , представленного Кунихико Фукусимой в 1980 году. [45] В 1969 году он также представил ReLU (выпрямленная линейная единица) функцию активации . [21] [26] Выпрямитель стал самой популярной функцией активации для CNN и глубокого обучения в целом. [46] CNN стали важным инструментом компьютерного зрения .

Термин « глубокое обучение» был представлен сообществу машинного обучения Риной Дектер в 1986 году. [30] и искусственным нейронным сетям Игоря Айзенберга и его коллег в 2000 году в контексте логических пороговых нейронов. [47] [48]

В 1988 году Вэй Чжан и др. применил алгоритм обратного распространения ошибки к сверточной нейронной сети (упрощенному неокогнитрону со сверточными связями между слоями признаков изображения и последним полносвязным слоем) для распознавания алфавита. Они также предложили реализацию CNN с оптической вычислительной системой. [49] [50] В 1989 году Ян ЛеКун и др. применил обратное распространение ошибки к CNN с целью распознавания рукописных почтовых индексов в почте. Пока алгоритм работал, обучение заняло 3 дня. [51] Впоследствии Вэй Чжан и др. модифицировали свою модель, удалив последний полностью связанный слой, и применили ее для сегментации объектов медицинских изображений в 1991 году. [52] и обнаружение рака молочной железы с помощью маммографии в 1994 году. [53] LeNet-5 (1998), 7-уровневая CNN, созданная Яном ЛеКуном и др., [54] который классифицирует цифры, был применен несколькими банками для распознавания рукописных чисел на чеках, оцифрованных в изображениях размером 32x32 пикселя.

В 1980-х годах обратное распространение ошибки не подходило для глубокого обучения с длинными путями присвоения кредитов. Чтобы преодолеть эту проблему, Юрген Шмидхубер (1992) предложил иерархию RNN, предварительно обучаемых по одному уровню за раз посредством самостоятельного обучения . [55] Он использует прогнозирующее кодирование для изучения внутренних представлений в нескольких самоорганизующихся временных масштабах. Это может существенно облегчить последующее глубокое обучение. Иерархию RNN можно свернуть в единую RNN путем разделения более высокого уровня сети блоков в сеть автоматизатора более низкого уровня . [55] [26] В 1993 году чанкёр решил задачу глубокого обучения, глубина которой превысила 1000. [56]

В 1992 году Юрген Шмидхубер также опубликовал альтернативу RNN. [57] который теперь называется линейным Трансформатором или Трансформатором с линеаризованным самовниманием [58] [59] [26] (за исключением оператора нормализации). Он усваивает внутренние направления внимания : [60] медленная нейронная сеть прямого распространения учится путем градиентного спуска управлять быстрыми весами другой нейронной сети через внешние продукты самогенерируемых шаблонов активации ОТ и ДО (которые теперь называются ключом и значением для самообслуживания ). [58] Это быстрое отображение внимания к весам применяется к шаблону запроса.

Современный Трансформер был представлен Ашишем Васвани и др. в своей статье 2017 года «Внимание — это все, что вам нужно». [61] Он сочетает в себе это с оператором softmax и матрицей проекции. [26] Трансформаторы все чаще становятся предпочтительной моделью обработки естественного языка . [62] многие современные модели больших языков, такие как ChatGPT , GPT-4 и BERT Его используют . Трансформаторы также все чаще используются в компьютерном зрении . [ нужна ссылка ]

В 1991 году Юрген Шмидхубер также опубликовал состязательные нейронные сети, которые соревнуются друг с другом в форме игры с нулевой суммой , где выигрыш одной сети является проигрышем другой сети. [63] [64] [65] Первая сеть представляет собой генеративную модель , которая моделирует распределение вероятностей по шаблонам выходных данных. Вторая сеть учится с помощью градиентного спуска предсказывать реакцию окружающей среды на эти закономерности. Это называлось «искусственное любопытство». В 2014 году этот принцип был использован в генеративно-состязательной сети (GAN) Яном Гудфеллоу и др. [66] Здесь реакция окружающей среды равна 1 или 0 в зависимости от того, входит ли выход первой сети в данный набор. Это можно использовать для создания реалистичных дипфейков . [67] Превосходное качество изображения достигается с помощью Nvidia от StyleGAN (2018). [68] на основе Progressive GAN Теро Карраса и др. [69] Здесь генератор GAN растет от малого к большому по пирамидальной схеме.

Зеппа Хохрайтера (1991). Дипломная работа [70] был назван «одним из самых важных документов в истории машинного обучения» его руководителем Шмидхубером . [26] Он не только протестировал компрессор нейронной истории, [55] но также выявил и проанализировал проблему исчезающего градиента . [70] [71] Хохрейтер предложил рекуррентные остаточные связи для решения этой проблемы. Это привело к появлению метода глубокого обучения под названием «длинная кратковременная память» (LSTM), опубликованного в 1997 году. [72] Рекуррентные нейронные сети LSTM могут изучать задачи «очень глубокого обучения» [9] с длинными путями присвоения кредитов, требующими воспоминаний о событиях, произошедших за тысячи дискретных шагов времени до этого. «Ванильный LSTM» с затвором забывания был представлен в 1999 году Феликсом Герсом , Шмидхубером и Фредом Камминсом. [73] LSTM стала самой цитируемой нейронной сетью 20 века. [26] В 2015 году Рупеш Кумар Шривастава, Клаус Грефф и Шмидхубер использовали LSTM принципы для создания сети Highway — нейронной сети прямого распространения с сотнями слоев, гораздо более глубокой, чем предыдущие сети. [74] [75] 7 месяцев спустя Каймин Хэ, Сянъюй Чжан; с открытыми воротами или без ворот сети шоссе Шаоцин Рен и Цзянь Сунь выиграли конкурс ImageNet 2015, предложив вариант под названием Остаточная нейронная сеть . [76] Это самая цитируемая нейронная сеть 21 века. [26]

В 1994 году Андре де Карвальо вместе с Майком Фэйрхерстом и Дэвидом Биссетом опубликовали экспериментальные результаты многослойной логической нейронной сети, также известной как невесомая нейронная сеть, состоящей из трехслойного самоорганизующегося модуля нейронной сети для извлечения признаков ( SOFT), за которым следовал модуль нейронной сети многоуровневой классификации (GSN), которые прошли независимое обучение. Каждый уровень модуля извлечения признаков извлекал признаки с возрастающей сложностью по сравнению с предыдущим слоем. [77]

В 1995 году Брендан Фрей продемонстрировал, что можно обучать (в течение двух дней) сеть, содержащую шесть полностью связанных слоев и несколько сотен скрытых блоков, с помощью алгоритма пробуждения-сна , разработанного совместно с Питером Даяном и Хинтоном . [78]

С 1997 года Свен Бенке расширил иерархический сверточный подход с прямой связью в пирамиде нейронной абстракции. [79] посредством боковых и обратных связей, чтобы гибко включать контекст в решения и итеративно разрешать локальные двусмысленности.

Более простые модели, в которых используются функции, созданные вручную для конкретных задач, такие как фильтры Габора и машины опорных векторов (SVM), были популярным выбором в 1990-х и 2000-х годах из-за вычислительной стоимости искусственных нейронных сетей и отсутствия понимания того, как мозг связывает свои биологические процессы. сети.

Как поверхностное, так и глубокое обучение (например, рекуррентные сети) ИНС для распознавания речи исследуются уже много лет. [80] [81] [82] Эти методы никогда не превосходили неоднородную модель гауссовской смеси с внутренним ручным созданием / технологию скрытой модели Маркова (GMM-HMM), основанную на генеративных моделях речи, обученных дискриминативно. [83] Были проанализированы основные трудности, в том числе уменьшение градиента. [70] и слабая структура временной корреляции в нейронных прогнозирующих моделях. [84] [85] Дополнительными трудностями были отсутствие обучающих данных и ограниченная вычислительная мощность. Большинство исследователей распознавания речи отошли от нейронных сетей и занялись генеративным моделированием. Исключением была компания SRI International в конце 1990-х годов. США SRI, финансируемый АНБ и DARPA , изучал глубокие нейронные сети (DNN) в распознавании речи и говорящего . Группа распознавания говорящих под руководством Ларри Хека сообщила о значительных успехах в использовании глубоких нейронных сетей в обработке речи в ходе оценки распознавания говорящих Национального института стандартов и технологий 1998 года . [86] Затем глубокая нейронная сеть SRI была развернута в Nuance Verifier, представляя собой первое крупное промышленное применение глубокого обучения. [87] Принцип превосходства «необработанных» функций над оптимизацией, созданной вручную, был впервые успешно исследован в архитектуре глубокого автокодирования на «необработанных» спектрограммах или функциях набора линейных фильтров в конце 1990-х годов. [87] показывая его превосходство над функциями Mel-Cepstral , которые содержат этапы фиксированной трансформации из спектрограмм. Необработанные характеристики речи, формы сигналов , позже дали превосходные результаты в более крупном масштабе. [88]

Распознавание речи взял на себя LSTM . В 2003 году LSTM начал конкурировать с традиционными распознавателями речи в определенных задачах. [89] В 2006 году Алекс Грейвс , Сантьяго Фернандес, Фаустино Гомес и Шмидхубер объединили ее с коннекционистской временной классификацией (CTC). [90] в стеках LSTM RNN. [91] Сообщается, что в 2015 году производительность распознавания речи Google резко выросла на 49% благодаря LSTM, обученному CTC, который они сделали доступным через Google Voice Search . [92]

По словам Яна Лекуна, влияние глубокого обучения на промышленность началось в начале 2000-х годов, когда CNN уже обрабатывали от 10% до 20% всех чеков, выписанных в США. [93] Промышленное применение глубокого обучения для крупномасштабного распознавания речи началось примерно в 2010 году.

В 2006 году вышли публикации Джеффа Хинтона , Руслана Салахутдинова , Осиндеро и Тех. [94] [95] [96] показал, как многослойную нейронную сеть прямого распространения можно эффективно предварительно обучать по одному слою за раз, обрабатывая каждый слой по очереди как неконтролируемую ограниченную машину Больцмана , а затем настраивая ее с помощью контролируемого обратного распространения ошибки. [97] В документах говорилось об обучении глубоким сетям убеждений.

Семинар NIPS 2009 года по глубокому обучению для распознавания речи был мотивирован ограничениями глубоких генеративных моделей речи и возможностью того, что при наличии более мощного оборудования и крупномасштабных наборов данных глубокие нейронные сети могут стать практичными. Считалось, что предварительное обучение DNN с использованием генеративных моделей сетей глубокого доверия (DBN) позволит преодолеть основные трудности нейронных сетей. Однако было обнаружено, что замена предварительного обучения большими объемами обучающих данных для прямого обратного распространения ошибки при использовании DNN с большими, контекстно-зависимыми выходными слоями приводит к значительно более низкому уровню ошибок, чем современная на тот момент модель смеси Гаусса (GMM). )/Скрытая марковская модель (HMM), а также более продвинутые системы на основе генеративных моделей. [98] Природа ошибок распознавания, производимых двумя типами систем, характерно различалась. [99] предлагая техническую информацию о том, как интегрировать глубокое обучение в существующую высокоэффективную систему декодирования речи во время выполнения, используемую всеми основными системами распознавания речи. [19] [100] [101] Анализ 2009–2010 годов, сравнивающий GMM (и другие модели генеративной речи) с моделями DNN, стимулировал ранние промышленные инвестиции в глубокое обучение для распознавания речи. [99] Этот анализ был проведен с сопоставимой производительностью (менее 1,5% по частоте ошибок) между дискриминативными DNN и генеративными моделями. [98] [99] [102] В 2010 году исследователи расширили глубокое обучение от TIMIT до распознавания речи с большим словарным запасом, приняв большие выходные слои DNN на основе контекстно-зависимых состояний HMM, построенных с помощью деревьев решений . [103] [104] [105] [100]

Глубокое обучение является частью современных систем в различных дисциплинах, в частности в компьютерном зрении и автоматическом распознавании речи (ASR). Результаты часто используемых оценочных наборов, таких как TIMIT (ASR) и MNIST ( классификация изображений ), а также ряда задач по распознаванию речи с большим словарным запасом постоянно улучшаются. [98] [106] Сверточные нейронные сети были заменены ASR на CTC. [90] для ЛСТМ . [72] [92] [107] [108] [109] но более успешны в компьютерном зрении.

Достижения в области аппаратного обеспечения возобновили интерес к глубокому обучению. В 2009 году Nvidia участвовала в так называемом «большом взрыве» глубокого обучения, «поскольку нейронные сети глубокого обучения обучались с помощью графических процессоров (GPU) Nvidia». [110] В том же году Эндрю Нг определил, что графические процессоры могут увеличить скорость систем глубокого обучения примерно в 100 раз. [111] В частности, графические процессоры хорошо подходят для матричных/векторных вычислений, используемых в машинном обучении. [112] [113] [114] Графические процессоры ускоряют алгоритмы обучения на порядки, сокращая время работы с недель до дней. [115] [116] Кроме того, для эффективной обработки моделей глубокого обучения можно использовать специализированное оборудование и оптимизацию алгоритмов. [117]

глубокого обучения Революция

В конце 2000-х годов глубокое обучение начало превосходить другие методы в соревнованиях по машинному обучению.В 2009 году длинная кратковременная память тренировалась с помощью коннекционистской временной классификации ( Алекс Грейвс , Сантьяго Фернандес, Фаустино Гомес и Юрген Шмидхубер , 2006). [90] была первой RNN, выигравшей конкурсы по распознаванию образов , выиграв три конкурса по распознаванию связанного рукописного ввода . [118] [9] Позже Google использовал LSTM, обученный CTC, для распознавания речи на смартфоне . [119] [92]

Значительное влияние на распознавание изображений или объектов ощущалось в период с 2011 по 2012 год. Хотя CNN, обученные методом обратного распространения ошибки, существовали уже несколько десятилетий, [49] [51] и реализации NN на GPU в течение многих лет, [112] включая CNN, [114] [9] Для прогресса в области компьютерного зрения требовалось более быстрое внедрение CNN на графических процессорах. В 2011 году DanNet [120] [3] Дэн Чиресан, Ули Мейер, Джонатан Маски, Лука Мария Гамбарделла и Юрген Шмидхубер впервые достигли сверхчеловеческих результатов в конкурсе по визуальному распознаванию образов, превзойдя традиционные методы в 3 раза. [9] Также в 2011 году DanNet выиграла конкурс китайского почерка ICDAR, а в мае 2012 года — конкурс сегментации изображений ISBI. [121] До 2011 года CNN не играли важной роли на конференциях по компьютерному зрению, но в июне 2012 года появилась статья Чиресана и др. на ведущей конференции CVPR [3] показал, как максимальное объединение CNN на графическом процессоре может значительно улучшить многие показатели тестов машинного зрения. В сентябре 2012 года DanNet также выиграла конкурс ICPR по анализу больших медицинских изображений для выявления рака, а в следующем году — MICCAI Grand Challenge по той же теме. [122] В октябре 2012 года аналогичный AlexNet , Алекса Крижевского Ильи Суцкевера и Джеффри Хинтона [4] выиграл крупномасштабное соревнование ImageNet со значительным отрывом от поверхностных методов машинного обучения. Сеть VGG-16 Карена Симоняна и Андрея Зиссермана [123] еще больше снизило частоту ошибок ивыиграл конкурс ImageNet 2014, следуя аналогичной тенденции в области крупномасштабного распознавания речи.

Затем классификация изображений была расширена до более сложной задачи создания описаний (подписей) для изображений, часто в виде комбинации CNN и LSTM. [124] [125] [126]

В 2012 году команда под руководством Джорджа Э. Даля выиграла конкурс Merck Molecular Activity Challenge, используя многозадачные глубокие нейронные сети для прогнозирования биомолекулярной мишени одного лекарства. [127] [128] В 2014 году группа Зеппа Хохрейтера использовала глубокое обучение для обнаружения нецелевого и токсического воздействия химических веществ из окружающей среды в питательных веществах, предметах домашнего обихода и лекарствах и выиграла конкурс «Tox21 Data Challenge» от NIH , FDA и NCATS . [129] [130] [131]

В 2016 году Роджер Парлофф упомянул «революцию глубокого обучения», которая изменила индустрию искусственного интеллекта. [132]

В марте 2019 года Йошуа Бенджио , Джеффри Хинтон и Ян ЛеКун были награждены Премией Тьюринга за концептуальные и инженерные прорывы, которые сделали глубокие нейронные сети важнейшим компонентом вычислений.

Нейронные сети [ править ]

В действительности текстуры и контуры будут представлены не отдельными узлами, а скорее соответствующими весовыми шаблонами нескольких узлов.

Искусственные нейронные сети ( ИНС ) или коннекционистские системы — это вычислительные системы, вдохновленные биологическими нейронными сетями , которые составляют мозг животных. Такие системы учатся (постепенно совершенствуют свои способности) выполнять задачи, рассматривая примеры, как правило, без программирования для конкретных задач. Например, при распознавании изображений они могут научиться распознавать изображения, на которых есть кошки, анализируя примеры изображений, которые были вручную помечены как «кошка» или «нет кошки», и используя результаты анализа для идентификации кошек на других изображениях. Они нашли наибольшее применение в приложениях, которые трудно выразить с помощью традиционного компьютерного алгоритма с использованием программирования на основе правил .

ИНС основана на наборе связанных единиц, называемых искусственными нейронами (аналог биологических нейронов в биологическом мозге ). Каждое соединение ( синапс ) между нейронами может передавать сигнал другому нейрону. Принимающий (постсинаптический) нейрон может обрабатывать сигнал(ы), а затем сигнализировать нижестоящим нейронам, подключенным к нему. Нейроны могут иметь состояние, обычно представленное действительными числами , обычно от 0 до 1. Нейроны и синапсы также могут иметь вес, который меняется по мере обучения, что может увеличивать или уменьшать силу сигнала, который они посылают вниз по течению.

Обычно нейроны организованы слоями. Разные слои могут выполнять разные виды преобразований на своих входах. Сигналы перемещаются от первого (входного) к последнему (выходному) слою, возможно, после многократного прохождения слоев.

Первоначальная цель нейросетевого подхода заключалась в том, чтобы решать проблемы так же, как это делает человеческий мозг. Со временем внимание сосредоточилось на сопоставлении конкретных умственных способностей, что привело к отклонениям от биологии, таким как обратное распространение ошибки или передача информации в обратном направлении и настройка сети для отражения этой информации.

Нейронные сети использовались для решения различных задач, включая компьютерное зрение, распознавание речи , машинный перевод , социальных сетей фильтрацию , настольные и видеоигры , а также медицинскую диагностику.

По состоянию на 2017 год нейронные сети обычно насчитывают от нескольких тысяч до нескольких миллионов единиц и миллионов соединений. Несмотря на то, что это число на несколько порядков меньше количества нейронов в человеческом мозге, эти сети могут выполнять многие задачи на уровне, превосходящем человеческий (например, распознавание лиц или игра в «Го»). [134] ).

Глубокие нейронные сети [ править ]

Глубокая нейронная сеть (DNN) — это искусственная нейронная сеть с несколькими слоями между входным и выходным слоями. [7] [9] Существуют разные типы нейронных сетей, но они всегда состоят из одних и тех же компонентов: нейронов, синапсов, весов, смещений и функций. [135] Эти компоненты в целом функционируют таким образом, что имитируют функции человеческого мозга, и их можно обучать, как и любой другой алгоритм ML. [ нужна ссылка ]

Например, DNN, обученная распознавать породы собак, просматривает данное изображение и рассчитывает вероятность того, что собака на изображении принадлежит к определенной породе. Пользователь может просмотреть результаты и выбрать, какие вероятности должна отображать сеть (выше определенного порога и т. д.), а также вернуть предложенную метку. Каждая математическая манипуляция как таковая рассматривается как слой, [ нужна ссылка ] и сложные DNN имеют много слоев, отсюда и название «глубокие» сети.

DNN могут моделировать сложные нелинейные отношения. Архитектуры DNN генерируют композиционные модели, в которых объект выражается как многоуровневая композиция примитивов . [136] Дополнительные уровни позволяют комбинировать объекты из нижних слоев, потенциально моделируя сложные данные с меньшим количеством единиц, чем в мелкой сети с аналогичной производительностью. [7] Например, было доказано, что разреженные многомерные полиномы экспоненциально легче аппроксимировать с помощью DNN, чем с помощью мелких сетей. [137]

Глубокие архитектуры включают множество вариантов нескольких базовых подходов. Каждая архитектура нашла успех в определенных областях. Не всегда возможно сравнить производительность нескольких архитектур, если только они не оценивались на одних и тех же наборах данных.

DNN обычно представляют собой сети прямой связи, в которых данные передаются от входного уровня к выходному без обратного цикла. Сначала DNN создает карту виртуальных нейронов и присваивает случайные числовые значения или «веса» связям между ними. Веса и входные данные умножаются и возвращают выходные данные в диапазоне от 0 до 1. Если сеть не распознала точно определенный шаблон, алгоритм скорректирует веса. [138] Таким образом, алгоритм может сделать определенные параметры более влиятельными, пока не определит правильные математические манипуляции для полной обработки данных.

Рекуррентные нейронные сети , в которых данные могут передаваться в любом направлении, используются для таких приложений, как языковое моделирование . [139] [140] [141] [142] [143] Длительная кратковременная память особенно эффективна для этого использования. [72] [144]

Сверточные нейронные сети (CNN) используются в компьютерном зрении. [145] CNN также применялись для акустического моделирования для автоматического распознавания речи (ASR). [146]

Проблемы [ править ]

Как и в случае с ИНС, с наивно обученными DNN может возникнуть множество проблем. Двумя распространенными проблемами являются переобучение и время вычислений.

DNN склонны к переоснащению из-за дополнительных уровней абстракции, которые позволяют им моделировать редкие зависимости в обучающих данных. Методы регуляризации, такие как сокращение единиц Ивахненко. [33] или снижение веса ( -регуляризация) или разреженность ( -регуляризация) может применяться во время тренировок для борьбы с переобучением. [147] Альтернативно, регуляризация отсева случайным образом исключает единицы из скрытых слоев во время обучения. Это помогает исключить редкие зависимости. [148] Наконец, данные можно дополнять с помощью таких методов, как обрезка и вращение, чтобы можно было увеличить размер меньших обучающих наборов, чтобы уменьшить вероятность переобучения. [149]

DNN должны учитывать множество параметров обучения, таких как размер (количество слоев и количество единиц на слой), скорость обучения и начальные веса. Просмотр пространства параметров для поиска оптимальных параметров может оказаться невозможным из-за затрат времени и вычислительных ресурсов. Различные трюки, такие как пакетная обработка (вычисление градиента сразу на нескольких обучающих примерах, а не на отдельных примерах). [150] ускорить вычисления. Большие вычислительные возможности многоядерных архитектур (таких как графические процессоры или Intel Xeon Phi) позволили значительно ускорить обучение благодаря пригодности таких архитектур обработки для матричных и векторных вычислений. [151] [152]

В качестве альтернативы инженеры могут искать другие типы нейронных сетей с более простыми и конвергентными алгоритмами обучения. CMAC ( контроллер артикуляции модели мозжечка ) — один из таких типов нейронной сети. Он не требует скорости обучения или рандомизированных начальных весов. Можно гарантировать, что процесс обучения сходится за один шаг с новой порцией данных, а вычислительная сложность алгоритма обучения линейна в зависимости от количества задействованных нейронов. [153] [154]

Аппаратное обеспечение [ править ]

С 2010-х годов достижения как в алгоритмах машинного обучения, так и в компьютерном оборудовании привели к появлению более эффективных методов обучения глубоких нейронных сетей, которые содержат множество слоев нелинейных скрытых модулей и очень большой выходной слой. [155] К 2019 году графические процессоры ( GPU ), часто с усовершенствованиями, специально предназначенными для искусственного интеллекта, вытеснили центральные процессоры в качестве доминирующего метода обучения крупномасштабного коммерческого облачного искусственного интеллекта. [156] OpenAI оценила аппаратные вычисления, используемые в крупнейших проектах глубокого обучения, от AlexNet (2012) до AlphaZero (2017), и обнаружила 300 000-кратное увеличение объема необходимых вычислений с линией тренда удвоения, равной 3,4 месяца. [157] [158]

Специальные электронные схемы , называемые процессорами глубокого обучения, были разработаны для ускорения алгоритмов глубокого обучения. Процессоры глубокого обучения включают в себя нейронные процессоры (NPU) в Huawei . мобильных телефонах [159] и серверы облачных вычислений , такие как тензорные процессоры (TPU) в Google Cloud Platform . [160] Компания Cerebras Systems также создала специальную систему для работы с большими моделями глубокого обучения — CS-2 — на базе крупнейшего процессора в отрасли — Wafer Scale Engine второго поколения (WSE-2). [161] [162]

Атомно тонкие полупроводники считаются перспективными для создания энергоэффективного оборудования глубокого обучения, где одна и та же базовая структура устройства используется как для логических операций, так и для хранения данных.В 2020 году Марега и др. опубликовали эксперименты с материалом активного канала большой площади для разработки устройств и схем логики в памяти на основе с плавающим затвором полевых транзисторов (FGFET). [163]

В 2021 г. Дж. Фельдманн и др. предложил интегрированный фотонный аппаратный ускоритель для параллельной сверточной обработки. [164] Авторы выделяют два ключевых преимущества интегрированной фотоники перед ее электронными аналогами: (1) массово параллельная передача данных посредством по длине волны с разделением мультиплексирования в сочетании с частотными гребенками и (2) чрезвычайно высокая скорость модуляции данных. [164] Их система может выполнять триллионы операций умножения-накопления в секунду, что указывает на потенциал интегрированной фотоники в приложениях искусственного интеллекта с большим объемом данных. [164]

Приложения [ править ]

Автоматическое распознавание речи [ править ]

Масштабное автоматическое распознавание речи — первый и наиболее убедительный успешный случай глубокого обучения. LSTM RNN могут изучать задачи «очень глубокого обучения» [9] которые включают в себя многосекундные интервалы, содержащие речевые события, разделенные тысячами дискретных временных шагов, где один временной шаг соответствует примерно 10 мс. LSTM с воротами забывания [144] конкурирует с традиционными распознавателями речи в определенных задачах. [89]

Первоначальный успех в распознавании речи был основан на небольших задачах распознавания на основе TIMIT. Набор данных содержит 630 носителей восьми основных диалектов американского английского , где каждый говорящий читает 10 предложений. [165] Его небольшой размер позволяет опробовать множество конфигураций. Что еще более важно, задача TIMIT касается распознавания телефонных последовательностей, которое, в отличие от распознавания последовательностей слов, позволяет создавать слабые телефонных биграмм языковые модели . Это позволяет легче анализировать сильные стороны акустического моделирования распознавания речи. Перечисленные ниже коэффициенты ошибок, включая эти ранние результаты и измеряемые в процентах коэффициента ошибок телефона (PER), суммируются с 1991 года.

| Метод | Процент телефона коэффициент ошибок (PER) (%) |

|---|---|

| Случайно инициализированный RNN [166] | 26.1 |

| Байесовский трифон GMM-HMM | 25.6 |

| Модель скрытой траектории (генеративная) | 24.8 |

| Монофонический случайно инициализированный DNN | 23.4 |

| Монофон ДБН-ДНН | 22.4 |

| Triphone GMM-HMM с обучением BMMI | 21.7 |

| Монофон ДБН-ДНН на фбанке | 20.7 |

| Сверточная DNN [167] | 20.0 |

| Сверточная DNN w. Гетерогенное объединение | 18.7 |

| Ансамбль ДНН/CNN/РНН [168] | 18.3 |

| Двунаправленный LSTM | 17.8 |

| Иерархическая сверточная сеть Deep Maxout [169] | 16.5 |

Дебют DNN для распознавания говорящих в конце 1990-х годов, распознавания речи примерно в 2009–2011 годах и LSTM примерно в 2003–2007 годах ускорил прогресс в восьми основных областях: [19] [102] [100]

- Масштабирование и ускорение обучения и декодирования DNN

- Последовательное дискриминационное обучение

- Обработка признаков с помощью глубоких моделей с глубоким пониманием основных механизмов

- Адаптация DNN и связанных с ними глубоких моделей

- Многозадачное и трансферное обучение с помощью DNN и связанных с ними глубоких моделей

- CNN и как их спроектировать, чтобы наилучшим образом использовать знания предметной области речи

- RNN и его богатые варианты LSTM

- Другие типы глубоких моделей, включая тензорные модели и интегрированные глубокие генеративные/дискриминационные модели.

Все основные коммерческие системы распознавания речи (например, Microsoft Cortana , Xbox , Skype Translator , Amazon Alexa , Google Now , Apple Siri , Baidu и голосовой поиск iFlyTek , а также ряд речевых продуктов Nuance и т. д.) основаны на глубоком обучении. [19] [170] [171]

Распознавание изображений [ править ]

Обычным набором оценок для классификации изображений является набор данных базы данных MNIST . MNIST состоит из рукописных цифр и включает 60 000 обучающих примеров и 10 000 тестовых примеров. Как и в случае с TIMIT, его небольшой размер позволяет пользователям тестировать несколько конфигураций. Доступен полный список результатов по этому набору. [172]

Распознавание изображений на основе глубокого обучения стало «сверхчеловеческим», давая более точные результаты, чем участники-люди. Впервые это произошло в 2011 году при распознавании дорожных знаков, а в 2014 году — при распознавании человеческих лиц. [173] [174]

Транспортные средства, обученные глубокому обучению, теперь интерпретируют изображения с камер на 360°. [175] Другим примером является новый анализ лицевой дисморфологии (FDNA), используемый для анализа случаев пороков развития человека, связанных с большой базой данных генетических синдромов.

Обработка визуального искусства [ править ]

С прогрессом, достигнутым в распознавании изображений, тесно связано все более широкое применение методов глубокого обучения для различных задач визуального искусства. DNN доказали свою способность, например,

- определение стилевого периода данной картины [176] [177]

- Нейронная передача стиля – фиксация стиля данного произведения искусства и применение его визуально приятным образом к произвольной фотографии или видео. [176] [177]

- создание ярких изображений на основе случайных полей визуального ввода. [176] [177]

Обработка естественного языка [ править ]

Нейронные сети используются для реализации языковых моделей с начала 2000-х годов. [139] LSTM помог улучшить машинный перевод и языковое моделирование. [140] [141] [142]

Другими ключевыми методами в этой области являются отрицательные выборки. [178] и встраивание слов . Встраивание слов, такое как word2vec , можно рассматривать как репрезентативный уровень в архитектуре глубокого обучения, который преобразует атомарное слово в позиционное представление слова относительно других слов в наборе данных; положение представлено как точка в векторном пространстве . Использование встраивания слов в качестве входного слоя RNN позволяет сети анализировать предложения и фразы, используя эффективную композиционную векторную грамматику. Композиционную векторную грамматику можно рассматривать как вероятностную контекстно-свободную грамматику (PCFG), реализуемую RNN. [179] Рекурсивные автокодировщики, построенные на основе встраивания слов, могут оценивать сходство предложений и обнаруживать перефразирование. [179] Глубокие нейронные архитектуры обеспечивают наилучшие результаты при анализе избирательного округа. [180] анализ настроений , [181] поиск информации, [182] [183] понимание разговорной речи, [184] машинный перевод, [140] [185] контекстное связывание сущностей, [185] распознавание стиля письма, [186] распознавание именованных объектов (классификация токенов), [187] классификация текста и другие. [188]

Недавние разработки обобщают встраивание слов в встраивание предложений .

Google Translate (GT) использует большую сквозную сеть с длинной краткосрочной памятью (LSTM). [189] [190] [191] [192] Нейронный машинный перевод Google (GNMT) использует метод машинного перевода на основе примеров , при котором система «обучается на миллионах примеров». [190] Он переводит «целые предложения за раз, а не по частям». Google Translate поддерживает более ста языков. [190] Сеть кодирует «семантику предложения, а не просто запоминает построчный перевод». [190] [193] GT использует английский как промежуточный вариант между большинством языковых пар. [193]

лекарств токсикология и Открытие

Большой процент потенциальных лекарств не получает одобрения регулирующих органов. Эти неудачи вызваны недостаточной эффективностью (нецелевой эффект), нежелательными взаимодействиями (нецелевые эффекты) или непредвиденными токсическими эффектами . [194] [195] Исследования изучали возможность использования глубокого обучения для прогнозирования биомолекулярных целей . [127] [128] нецелевые результаты и токсическое воздействие химических веществ, содержащихся в питательных веществах, предметах домашнего обихода и лекарствах. [129] [130] [131]

AtomNet — это система глубокого обучения для рационального проектирования лекарств на основе структуры . [196] AtomNet использовался для прогнозирования новых биомолекул-кандидатов для борьбы с такими болезнями, как вирус Эбола. [197] и рассеянный склероз . [198] [197]

В 2017 году графовые нейронные сети были впервые использованы для прогнозирования различных свойств молекул в большом наборе токсикологических данных. [199] В 2019 году генеративные нейронные сети были использованы для производства молекул, которые были экспериментально проверены на мышах. [200] [201]

Управление взаимоотношениями с клиентами [ править ]

Глубокое обучение с подкреплением использовалось для приблизительного определения ценности возможных действий прямого маркетинга , определенной с точки зрения RFM переменных . Было показано, что функция оценочной стоимости имеет естественную интерпретацию как пожизненная ценность клиента . [202]

Рекомендательные системы [ править ]

Системы рекомендаций использовали глубокое обучение для извлечения значимых функций для модели скрытых факторов для рекомендаций по музыке и журналам на основе контента. [203] [204] Глубокое обучение с несколькими представлениями применялось для изучения предпочтений пользователей из нескольких доменов. [205] Модель использует гибридный подход, основанный на совместной работе и контенте, и расширяет рекомендации для решения нескольких задач.

Биоинформатика [ править ]

Автоэнкодер аннотаций ИНС использовался в биоинформатике для прогнозирования онтологии генов и отношений ген-функция. [206]

В медицинской информатике глубокое обучение использовалось для прогнозирования качества сна на основе данных носимых устройств. [207] и прогнозирование осложнений со здоровьем на основе данных электронных медицинских карт . [208]

Глубокие нейронные сети продемонстрировали беспрецедентную эффективность в предсказании структуры белка в соответствии с последовательностью аминокислот, из которых он состоит. В 2020 году AlphaFold , система, основанная на глубоком обучении, достигла уровня точности, значительно превышающего все предыдущие вычислительные методы. [209] [210]

сетей Оценка нейронных глубоких

Глубокие нейронные сети могут использоваться для оценки энтропии случайного процесса и называются оценщиком энтропии нейронных соединений (NJEE). [211] Такая оценка дает представление о влиянии входных случайных величин на независимую случайную величину . На практике DNN обучается как классификатор , который сопоставляет входной вектор или матрицу X с выходным распределением вероятностей по возможным классам случайной величины Y при заданных входных данных X. Например, в задачах классификации изображений NJEE отображает вектор пикселей ' значения цвета для вероятностей возможных классов изображений. На практике распределение вероятностей Y получается с помощью слоя Softmax с количеством узлов, равным размеру алфавита Y. NJEE использует непрерывно дифференцируемые функции активации , так что выполняются условия универсальной теоремы аппроксимации . Показано, что этот метод обеспечивает строго согласованную оценку и превосходит другие методы в случае больших размеров алфавита. [211]

Анализ медицинских изображений

Было показано, что глубокое обучение дает конкурентоспособные результаты в медицинских приложениях, таких как классификация раковых клеток, обнаружение поражений, сегментация органов и улучшение изображений. [212] [213] Современные инструменты глубокого обучения демонстрируют высокую точность выявления различных заболеваний и полезность их использования специалистами для повышения эффективности диагностики. [214] [215]

Мобильная реклама [ править ]

Найти подходящую мобильную аудиторию для мобильной рекламы всегда непросто, поскольку необходимо учитывать и анализировать множество точек данных, прежде чем целевой сегмент можно будет создать и использовать при показе рекламы любым рекламным сервером. [216] Глубокое обучение использовалось для интерпретации больших и многомерных наборов рекламных данных. Многие данные собираются во время цикла интернет-рекламы «запрос/обслуживание/нажатие». Эта информация может лечь в основу машинного обучения для улучшения выбора рекламы.

Восстановление изображения [ править ]

Глубокое обучение успешно применяется для решения обратных задач, таких как шумоподавление , суперразрешение , рисование и раскрашивание пленки . [217] Эти приложения включают в себя такие методы обучения, как «Поля усадки для эффективного восстановления изображений». [218] который обучается на наборе данных изображения, и Deep Image Prior , который обучается на изображении, требующем восстановления.

финансового Обнаружение мошенничества

Глубокое обучение успешно применяется для обнаружения финансового мошенничества , уклонения от уплаты налогов, [219] и борьба с отмыванием денег. [220]

Материаловедение [ править ]

В ноябре 2023 года исследователи из Google DeepMind и Национальной лаборатории Лоуренса Беркли объявили, что разработали систему искусственного интеллекта, известную как GNoME. Эта система внесла вклад в материаловедение , открыв более 2 миллионов новых материалов за относительно короткий период времени. GNoME использует методы глубокого обучения для эффективного исследования потенциальных структур материалов, достигая значительного улучшения идентификации стабильных неорганических кристаллических структур . Предсказания системы были подтверждены в ходе автономных роботизированных экспериментов, продемонстрировавших примечательный уровень успеха — 71%. Данные о вновь обнаруженных материалах общедоступны через базу данных Materials Project , что дает исследователям возможность идентифицировать материалы с желаемыми свойствами для различных применений. Это развитие имеет последствия для будущего научных открытий и интеграции ИИ в исследования в области материаловедения, потенциально ускоряя инновации в материалах и снижая затраты на разработку продуктов. Использование искусственного интеллекта и глубокого обучения предполагает возможность свести к минимуму или исключить ручные лабораторные эксперименты и позволить ученым больше сосредоточиться на разработке и анализе уникальных соединений. [221] [222] [223]

Военный [ править ]

Министерство обороны США применило глубокое обучение для обучения роботов новым задачам посредством наблюдения. [224]

Уравнения в частных производных [ править ]

Нейронные сети, основанные на физике, использовались для решения уравнений в частных производных как в прямых, так и в обратных задачах на основе данных. [225] Одним из примеров является реконструкция потока жидкости, определяемая уравнениями Навье-Стокса . Использование нейронных сетей, основанных на физике, не требует часто дорогостоящего создания сетки, CFD . на котором полагаются традиционные методы [226] [227]

Реконструкция изображения [ править ]

Реконструкция изображения — это реконструкция основных изображений на основе измерений, связанных с изображением. Несколько работ показали лучшую и превосходящую производительность методов глубокого обучения по сравнению с аналитическими методами для различных приложений, например, спектральной визуализации. [228] и ультразвуковое исследование. [229]

Прогноз погоды [ править ]

Традиционные системы прогнозирования погоды решают очень сложную систему дифференциальных уравнений Патриала. GraphCast — это модель, основанная на глубоком обучении, обученная на длительной истории погодных данных и позволяющая прогнозировать, как погодные условия изменяются с течением времени. Он способен прогнозировать погодные условия на срок до 10 дней по всему миру, на очень детальном уровне и менее чем за минуту, с точностью, аналогичной современным системам. [230] [231]

Эпигенетические часы [ править ]

Эпигенетические часы — это биохимический тест , который можно использовать для измерения возраста. Галкин и др. использовали глубокие нейронные сети для обучения эпигенетических часов старения с беспрецедентной точностью, используя более 6000 образцов крови. [232] Часы используют информацию из 1000 CpG-сайтов и прогнозируют людей с определенными заболеваниями старше, чем здоровый контроль: воспалительное заболевание кишечника , лобно-височная деменция , рак яичников , ожирение . Часы старения планировалось выпустить для публичного использования в 2021 году дочерней компанией Insilico Medicine Deep Longevity.

способностями и развитием мозга человека Связь с когнитивными

Глубокое обучение тесно связано с классом теорий развития мозга (в частности, развития неокортекса), предложенных когнитивными нейробиологами в начале 1990-х годов. [233] [234] [235] [236] Эти теории развития были воплощены в вычислительных моделях, что сделало их предшественниками систем глубокого обучения. Эти модели развития обладают тем общим свойством, что различные предполагаемые динамики обучения в мозге (например, волна фактора роста нервов ) поддерживают самоорганизацию, в некоторой степени аналогичную нейронным сетям, используемым в моделях глубокого обучения. Как и неокортекс , нейронные сети используют иерархию многоуровневых фильтров, в которой каждый уровень рассматривает информацию из предыдущего уровня (или операционной среды), а затем передает ее выходные данные (и, возможно, исходные входные данные) на другие уровни. В результате этого процесса получается самоорганизующийся набор датчиков , хорошо настроенный к рабочей среде. В описании 1995 года говорилось: «...мозг младенца, по-видимому, самоорганизуется под влиянием волн так называемых трофических факторов... различные области мозга соединяются последовательно, при этом один слой ткани созревает раньше другого и так до тех пор, пока весь мозг не созреет». [237]

Для исследования правдоподобности моделей глубокого обучения с нейробиологической точки зрения использовались различные подходы. С одной стороны, обратного распространения ошибки с целью повышения реалистичности его обработки. было предложено несколько вариантов алгоритма [238] [239] Другие исследователи утверждают, что неконтролируемые формы глубокого обучения, например, основанные на иерархических генеративных моделях и сетях глубоких убеждений , могут быть ближе к биологической реальности. [240] [241] В этом отношении модели генеративных нейронных сетей связаны с нейробиологическими данными об обработке данных в коре головного мозга на основе выборки. [242]

Хотя систематическое сравнение между организацией человеческого мозга и кодированием нейронов в глубоких сетях еще не проведено, сообщалось о нескольких аналогиях. Например, вычисления, выполняемые модулями глубокого обучения, могут быть аналогичны вычислениям реальных нейронов. [243] и нейронные популяции. [244] Точно так же представления, разработанные моделями глубокого обучения, аналогичны тем, которые измеряются в зрительной системе приматов. [245] оба в одном блоке [246] и у населения [247] уровни.

Коммерческая деятельность [ править ]

Facebook Лаборатория искусственного интеллекта выполняет такие задачи, как автоматическая пометка загруженных изображений именами людей на них. [248]

компании Google Компания DeepMind Technologies разработала систему, способную научиться играть Atari, в видеоигры используя в качестве входных данных только пиксели. В 2015 году они продемонстрировали свою систему AlphaGo , которая достаточно хорошо изучила игру в го, чтобы победить профессионального игрока в го. [249] [250] [251] Google Translate использует нейронную сеть для перевода более чем на 100 языков.

В 2017 году был запущен Covariant.ai, целью которого является интеграция глубокого обучения в фабрики. [252]

По состоянию на 2008 год [253] Исследователи из Техасского университета в Остине (Юта) разработали систему машинного обучения под названием «Обучение агента вручную с помощью оценочного подкрепления» или TAMER, которая предложила новые методы, позволяющие роботам или компьютерным программам научиться выполнять задачи, взаимодействуя с человеком-инструктором. [224] Новый алгоритм под названием Deep TAMER, впервые разработанный как TAMER, был позже представлен в 2018 году в ходе сотрудничества между Исследовательской лабораторией армии США (ARL) и исследователями UT. Deep TAMER использовал глубокое обучение, чтобы предоставить роботу возможность изучать новые задачи посредством наблюдения. [224] Используя Deep TAMER, робот обучался выполнению задачи вместе с тренером-человеком, просматривая видеопотоки или наблюдая, как человек выполняет задачу лично. Позже робот попрактиковался в выполнении задания под руководством тренера, который давал такие отзывы, как «хорошая работа» и «плохая работа». [254]

Критика и комментарии [ править ]

Глубокое обучение вызвало как критику, так и комментарии, в некоторых случаях за пределами области информатики.

Теория [ править ]

Основная критика касается отсутствия теории вокруг некоторых методов. [255] Обучение в наиболее распространенных глубоких архитектурах реализуется с помощью хорошо понятного градиентного спуска. Однако теория других алгоритмов, таких как контрастивная дивергенция, менее ясна. [ нужна ссылка ] (например, сходится ли оно? Если да, то как быстро? Что оно аппроксимирует?) Методы глубокого обучения часто рассматриваются как черный ящик , причем большинство подтверждений делается эмпирически, а не теоретически. [256]

Другие отмечают, что глубокое обучение следует рассматривать как шаг к созданию сильного ИИ , а не как всеобъемлющее решение. Несмотря на мощь методов глубокого обучения, им все еще не хватает функциональности, необходимой для полной реализации этой цели. Психолог-исследователь Гэри Маркус отметил:

На самом деле глубокое обучение — это лишь часть более масштабной задачи создания интеллектуальных машин. В таких методах отсутствуют способы представления причинно-следственных связей (...), нет очевидных способов выполнения логических выводов , а также они еще далеки от интеграции абстрактных знаний, таких как информация о том, что представляют собой объекты, для чего они предназначены и как они обычно используются. Самые мощные системы искусственного интеллекта, такие как Watson (...), используют такие методы, как глубокое обучение, как лишь один элемент в очень сложном ансамбле методов, начиная от статистического метода байесовского вывода и заканчивая дедуктивным рассуждением . [257]

В качестве дальнейшей ссылки на идею о том, что художественная чувствительность может быть присуща относительно низким уровням когнитивной иерархии, опубликована серия графических изображений внутренних состояний глубоких (20-30 слоев) нейронных сетей, пытающихся различить среди по существу случайных данных изображения. на котором они обучались [258] продемонстрировать визуальную привлекательность: оригинальное уведомление об исследовании получило более 1000 комментариев и стало темой статьи, которая какое-то время была наиболее часто доступной статьей в The Guardian . [259] веб-сайт.

Ошибки [ править ]

Некоторые архитектуры глубокого обучения демонстрируют проблемное поведение. [260] например, уверенное отнесение неузнаваемых изображений к знакомой категории обычных изображений (2014) [261] и неправильная классификация мельчайших искажений правильно классифицированных изображений (2013). [262] Герцель предположил, что такое поведение обусловлено ограничениями их внутренних представлений и что эти ограничения будут препятствовать интеграции в гетерогенные многокомпонентные общего искусственного интеллекта (AGI). архитектуры [260] Эти проблемы, возможно, могут быть решены с помощью архитектур глубокого обучения, которые внутри формируют состояния, гомологичные грамматике изображения. [263] декомпозиции наблюдаемых сущностей и событий. [260] Изучение грамматики (визуальной или лингвистической) на основе обучающих данных было бы эквивалентно ограничению системы рассуждениями здравого смысла , которые оперируют понятиями с точки зрения грамматических правил производства и являются основной целью как овладения человеческим языком, так и [264] и искусственный интеллект (ИИ). [265]

Киберугроза [ править ]

По мере того как глубокое обучение выходит из лабораторий в мир, исследования и опыт показывают, что искусственные нейронные сети уязвимы для хакерских атак и обмана. [266] Выявив закономерности, которые эти системы используют для функционирования, злоумышленники могут изменить входные данные ИНС таким образом, что ИНС найдет совпадение, которое люди-наблюдатели не смогут распознать. Например, злоумышленник может внести незначительные изменения в изображение, так что ИНС найдет совпадение, даже если для человека изображение выглядит совсем не так, как цель поиска. Такая манипуляция называется «состязательной атакой». [267]

В 2016 году исследователи использовали одну ИНС для обработки изображений методом проб и ошибок, определения фокусных точек другого и, таким образом, создания изображений, которые обманывали его. Модифицированные изображения ничем не отличались от человеческих глаз. Другая группа показала, что распечатки сфальсифицированных изображений, которые затем были сфотографированы, успешно обманули систему классификации изображений. [268] Одним из способов защиты является обратный поиск изображений, при котором возможное поддельное изображение отправляется на такой сайт, как TinEye , который затем может найти другие его экземпляры. Уточнение состоит в том, чтобы искать, используя только части изображения, чтобы идентифицировать изображения, из которых эта часть могла быть взята . [269]

Другая группа показала, что некоторые психоделические зрелища могут обмануть систему распознавания лиц , заставив ее думать, что обычные люди — знаменитости, потенциально позволяя одному человеку выдавать себя за другого. В 2017 году исследователи добавили наклейки на знаки остановки , из-за чего ANN неправильно их классифицировала. [268]

Однако ИНС можно дополнительно обучить обнаружению попыток обмана , что потенциально может привести злоумышленников и защитников к гонке вооружений, подобной той, которая уже определяет индустрию защиты от вредоносного ПО . ИНС обучены побеждать антивирусное программное обеспечение на основе ИНС, неоднократно атакуя защиту с помощью вредоносного ПО, которое постоянно изменялось генетическим алгоритмом, пока оно не обмануло антивирусное ПО, сохраняя при этом свою способность наносить ущерб цели. [268]

В 2016 году другая группа продемонстрировала, что определенные звуки могут заставить систему голосовых команд Google Now открыть определенный веб-адрес, и предположила, что это может «послужить трамплином для дальнейших атак (например, открытие веб-страницы, на которой размещено вредоносное ПО). ". [268]

При « отравлении данных » ложные данные постоянно вводятся в обучающий набор системы машинного обучения, чтобы помешать ей достичь мастерства. [268]

сбора Этика данных

Этот раздел нуждается в дополнительных цитатах для проверки . ( апрель 2021 г. ) |

Большинство систем глубокого обучения полагаются на данные обучения и проверки, которые генерируются и/или аннотируются людьми. [270] утверждается В философии СМИ , что для этой цели регулярно используется не только низкооплачиваемая работа с кликами (например, на Amazon Mechanical Turk ), но и неявные формы человеческой микроработы , которые часто не признаются как таковые. [271] Философ Райнер Мюльхофф выделяет пять типов «машинного захвата» микроработы человека для генерации обучающих данных: (1) геймификация (встраивание аннотаций или вычислительных задач в ход игры), (2) «перехват и отслеживание» (например, CAPTCHA для распознавания изображений или отслеживания кликов на страницах результатов поиска Google ), (3) использование социальных мотивов (например, пометка лиц на Facebook для получения маркированных изображений лиц), (4) интеллектуальный анализ информации (например, путем использования устройств количественной самооценки , таких как трекеры активности ) и (5) кликворк . [271]

Мюльхофф утверждает, что в большинстве коммерческих приложений глубокого обучения для конечных пользователей, таких как система распознавания лиц Facebook , потребность в обучающих данных не прекращается после обучения ИНС. Скорее, существует постоянный спрос на данные проверки, созданные человеком, для постоянной калибровки и обновления ИНС. С этой целью Facebook представил функцию: как только пользователь автоматически распознается на изображении, он получает уведомление. Они могут выбрать, хотят ли они, чтобы их публично отмечали на изображении, или сказать Facebook, что на изображении не они. [272] Этот пользовательский интерфейс представляет собой механизм генерации «постоянного потока проверочных данных». [271] для дальнейшего обучения сети в режиме реального времени. Как утверждает Мюльхофф, участие пользователей-людей для создания данных обучения и проверки настолько типично для большинства коммерческих приложений глубокого обучения для конечных пользователей, что такие системы можно назвать «искусственным интеллектом, управляемым человеком». [271]

См. также [ править ]

- Приложения искусственного интеллекта

- Сравнение программного обеспечения глубокого обучения

- Сжатое зондирование

- Дифференцируемое программирование

- Государственная сеть Эхо

- Список проектов искусственного интеллекта

- Машина жидкого состояния

- Список наборов данных для исследований в области машинного обучения

- Резервуарные вычисления

- Масштабирование пространства и глубокое обучение

- Разреженное кодирование

- Стохастический попугай

- Топологическое глубокое обучение

Ссылки [ править ]

- ^ Шульц, Ханнес; Бенке, Свен (1 ноября 2012 г.). «Глубокое обучение» . ИИ – искусственный интеллект . 26 (4): 357–363. дои : 10.1007/s13218-012-0198-z . ISSN 1610-1987 . S2CID 220523562 .

- ↑ Перейти обратно: Перейти обратно: а б ЛеКун, Янн; Бенджио, Йошуа; Хинтон, Джеффри (2015). «Глубокое обучение» (PDF) . Природа . 521 (7553): 436–444. Бибкод : 2015Natur.521..436L . дои : 10.1038/nature14539 . ПМИД 26017442 . S2CID 3074096 .

- ↑ Перейти обратно: Перейти обратно: а б с Чиресан, Д.; Мейер, У.; Шмидхубер, Дж. (2012). «Многостолбцовые глубокие нейронные сети для классификации изображений». Конференция IEEE 2012 по компьютерному зрению и распознаванию образов . стр. 3642–3649. arXiv : 1202.2745 . дои : 10.1109/cvpr.2012.6248110 . ISBN 978-1-4673-1228-8 . S2CID 2161592 .

- ↑ Перейти обратно: Перейти обратно: а б Крижевский, Алекс; Суцкевер, Илья; Хинтон, Джеффри (2012). «Классификация ImageNet с глубокими сверточными нейронными сетями» (PDF) . NIPS 2012: Нейронные системы обработки информации, озеро Тахо, Невада . Архивировано (PDF) из оригинала 10 января 2017 г. Проверено 24 мая 2017 г.

- ^ «ИИ AlphaGo от Google выиграл серию из трех матчей у лучшего в мире игрока в го» . ТехКранч . 25 мая 2017 года. Архивировано из оригинала 17 июня 2018 года . Проверено 17 июня 2018 г.

- ^ «Исследование призывает к осторожности при сравнении нейронных сетей с мозгом» . Новости Массачусетского технологического института | Массачусетский технологический институт . 02.11.2022 . Проверено 6 декабря 2023 г.

- ↑ Перейти обратно: Перейти обратно: а б с д Бенджио, Йошуа (2009). «Изучение глубокой архитектуры для искусственного интеллекта» (PDF) . Основы и тенденции в машинном обучении . 2 (1): 1–127. CiteSeerX 10.1.1.701.9550 . дои : 10.1561/2200000006 . S2CID 207178999 . Архивировано из оригинала (PDF) 4 марта 2016 года . Проверено 3 сентября 2015 г.

- ↑ Перейти обратно: Перейти обратно: а б с д и Бенджио, Ю.; Курвиль, А.; Винсент, П. (2013). «Обучение репрезентации: обзор и новые перспективы». Транзакции IEEE по анализу шаблонов и машинному интеллекту . 35 (8): 1798–1828. arXiv : 1206.5538 . дои : 10.1109/tpami.2013.50 . ПМИД 23787338 . S2CID 393948 .

- ↑ Перейти обратно: Перейти обратно: а б с д и ж г час я дж Шмидхубер, Дж. (2015). «Глубокое обучение в нейронных сетях: обзор». Нейронные сети . 61 : 85–117. arXiv : 1404.7828 . дои : 10.1016/j.neunet.2014.09.003 . ПМИД 25462637 . S2CID 11715509 .

- ^ Сигэки, Сугияма (12 апреля 2019 г.). Человеческое поведение и другие виды сознания: новые исследования и возможности: новые исследования и возможности . IGI Global. ISBN 978-1-5225-8218-2 .

- ^ Бенджио, Йошуа; Ламблин, Паскаль; Поповичи, Дэн; Ларошель, Хьюго (2007). Жадное послойное обучение глубоких сетей (PDF) . Достижения в области нейронных систем обработки информации. стр. 153–160. Архивировано (PDF) из оригинала 20 октября 2019 г. Проверено 6 октября 2019 г.

- ↑ Перейти обратно: Перейти обратно: а б Хинтон, GE (2009). «Сети глубоких убеждений» . Схоларпедия . 4 (5): 5947. Бибкод : 2009SchpJ...4.5947H . doi : 10.4249/scholarpedia.5947 .

- ↑ Перейти обратно: Перейти обратно: а б с Цыбенко (1989). «Приближения суперпозициями сигмоидальных функций» (PDF) . Математика управления, сигналов и систем . 2 (4): 303–314. дои : 10.1007/bf02551274 . S2CID 3958369 . Архивировано из оригинала (PDF) 10 октября 2015 года.

- ↑ Перейти обратно: Перейти обратно: а б с Хорник, Курт (1991). «Аппроксимационные возможности многослойных сетей прямого распространения». Нейронные сети . 4 (2): 251–257. дои : 10.1016/0893-6080(91)90009-т . S2CID 7343126 .

- ↑ Перейти обратно: Перейти обратно: а б Хайкин, Саймон С. (1999). Нейронные сети: комплексная основа . Прентис Холл. ISBN 978-0-13-273350-2 .

- ↑ Перейти обратно: Перейти обратно: а б Хассун, Мохамад Х. (1995). Основы искусственных нейронных сетей . МТИ Пресс. п. 48. ИСБН 978-0-262-08239-6 .

- ↑ Перейти обратно: Перейти обратно: а б Лу З., Пу Х., Ван Ф., Ху З. и Ван Л. (2017). Выразительная сила нейронных сетей: взгляд со стороны. Архивировано 13 февраля 2019 г. на Wayback Machine . Нейронные системы обработки информации, 6231-6239.

- ^ Орхан, А.Е.; Ма, WJ (2017). «Эффективный вероятностный вывод в универсальных нейронных сетях, обученных с использованием невероятностной обратной связи» . Природные коммуникации . 8 (1): 138. Бибкод : 2017NatCo...8..138O . дои : 10.1038/s41467-017-00181-8 . ПМК 5527101 . ПМИД 28743932 .

- ↑ Перейти обратно: Перейти обратно: а б с д и Дэн, Л.; Ю, Д. (2014). «Глубокое обучение: методы и приложения» (PDF) . Основы и тенденции в области обработки сигналов . 7 (3–4): 1–199. дои : 10.1561/2000000039 . Архивировано (PDF) из оригинала 14 марта 2016 г. Проверено 18 октября 2014 г.

- ↑ Перейти обратно: Перейти обратно: а б с д Мерфи, Кевин П. (24 августа 2012 г.). Машинное обучение: вероятностный взгляд . МТИ Пресс. ISBN 978-0-262-01802-9 .

- ↑ Перейти обратно: Перейти обратно: а б Фукусима, К. (1969). «Визуальное извлечение признаков с помощью многослойной сети аналоговых пороговых элементов». Транзакции IEEE по системным наукам и кибернетике . 5 (4): 322–333. дои : 10.1109/TSSC.1969.300225 .

- ^ Сонода, Шо; Мурата, Нобору (2017). «Нейронная сеть с неограниченными функциями активации является универсальным аппроксиматором». Прикладной и вычислительный гармонический анализ . 43 (2): 233–268. arXiv : 1505.03654 . дои : 10.1016/j.acha.2015.12.005 . S2CID 12149203 .

- ^ Бишоп, Кристофер М. (2006). Распознавание образов и машинное обучение (PDF) . Спрингер. ISBN 978-0-387-31073-2 . Архивировано (PDF) из оригинала 11 января 2017 г. Проверено 6 августа 2017 г.

- ^ Браш, Стивен Г. (1967). «История модели Ленца-Изинга». Обзоры современной физики . 39 (4): 883–893. Бибкод : 1967РвМП...39..883Б . дои : 10.1103/RevModPhys.39.883 .

- ^ Амари, Сюн-Ичи (1972). «Обучение шаблонам и последовательностям шаблонов с помощью самоорганизующихся сетей пороговых элементов». IEEE-транзакции . С (21): 1197–1206.

- ↑ Перейти обратно: Перейти обратно: а б с д и ж г час я дж к л м н Шмидхубер, Юрген (2022). «Аннотированная история современного искусственного интеллекта и глубокого обучения». arXiv : 2212.11279 [ cs.NE ].

- ^ Хопфилд, Джей-Джей (1982). «Нейронные сети и физические системы с возникающими коллективными вычислительными способностями» . Труды Национальной академии наук . 79 (8): 2554–2558. Бибкод : 1982PNAS...79.2554H . дои : 10.1073/pnas.79.8.2554 . ПМЦ 346238 . ПМИД 6953413 .

- ^ Тапперт, Чарльз К. (2019). «Кто отец глубокого обучения?» . Международная конференция по вычислительной науке и вычислительному интеллекту (CSCI) 2019 . IEEE. стр. 343–348. дои : 10.1109/CSCI49370.2019.00067 . ISBN 978-1-7281-5584-5 . S2CID 216043128 . Проверено 31 мая 2021 г.

- ↑ Перейти обратно: Перейти обратно: а б с Розенблатт, Франк (1962). Принципы нейродинамики . Спартан, Нью-Йорк.

- ↑ Перейти обратно: Перейти обратно: а б Рина Дектер (1986). Обучение во время поиска в задачах ограничения-удовлетворения. Калифорнийский университет, факультет компьютерных наук, лаборатория когнитивных систем. Интернет- архив, заархивированный 19 апреля 2016 г., на Wayback Machine.

- ^ Фрадков, Александр Львович (01.01.2020). «Ранняя история машинного обучения» . IFAC-PapersOnLine . 21-й Всемирный конгресс МФБ. 53 (2): 1385–1390. doi : 10.1016/j.ifacol.2020.12.1888 . ISSN 2405-8963 . S2CID 235081987 .

- ^ Ивахненко А.Г.; Лапа, В.Г. (1967). Кибернетика и методы прогнозирования . американской издательской компании Elsevier ISBN 978-0-444-00020-0 .

- ↑ Перейти обратно: Перейти обратно: а б Ивахненко, Алексей (1971). «Полиномиальная теория сложных систем» (PDF) . Транзакции IEEE по системам, человеку и кибернетике . СМК-1 (4): 364–378. дои : 10.1109/TSMC.1971.4308320 . Архивировано (PDF) из оригинала 29 августа 2017 г. Проверено 5 ноября 2019 г.

- ^ Роббинс, Х .; Монро, С. (1951). «Метод стохастической аппроксимации» . Анналы математической статистики . 22 (3): 400. дои : 10.1214/aoms/1177729586 .

- ^ Амари, Шуничи (1967). «Теория адаптивного классификатора шаблонов». IEEE-транзакции . ЕС (16): 279–307.

- ^ Мэтью Брэнд (1988) Машинное обучение и обучение мозга. Бакалаврская диссертация по методическим исследованиям Чикагского университета, 1988 г. Сообщено в Летнем лингвистическом институте Стэнфордского университета, 1987 г.

- ^ Линнаинмаа, Сеппо (1970). Представление совокупной ошибки округления алгоритма в виде разложения Тейлора локальных ошибок округления (Мастерс) (на финском языке). Университет Хельсинки. стр. 6–7.

- ^ Линнаинмаа, Сеппо (1976). «Разложение Тейлора накопленной ошибки округления». БИТ Численная математика . 16 (2): 146–160. дои : 10.1007/bf01931367 . S2CID 122357351 .

- ^ Гриванк, Андреас (2012). «Кто изобрел обратный способ дифференциации?» (PDF) . Документа Математика . Серия Documenta Mathematica (дополнительный том ISMP): 389–400. дои : 10.4171/dms/6/38 . ISBN 978-3-936609-58-5 . Архивировано из оригинала (PDF) 21 июля 2017 года . Проверено 11 июня 2017 г.

- ^ Лейбниц, Готфрид Вильгельм Фрайгер фон (1920). Ранние математические рукописи Лейбница: перевод с латинских текстов, опубликованных Карлом Иммануэлем Герхардтом с критическими и историческими примечаниями (Лейбниц опубликовал цепное правило в мемуарах 1676 года) . Издательство «Открытый суд». ISBN 9780598818461 .

- ^ Келли, Генри Дж. (1960). «Градиентная теория оптимальных траекторий полета». Журнал АРС . 30 (10): 947–954. дои : 10.2514/8.5282 .

- ^ Вербос, Пол (1982). «Применение достижений нелинейного анализа чувствительности». Системное моделирование и оптимизация . Спрингер. стр. 762–770.

- ^ Вербос, П. (1974). «За пределами регрессии: новые инструменты прогнозирования и анализа в поведенческих науках» . Гарвардский университет . Проверено 12 июня 2017 г.

- ^ Румельхарт, Дэвид Э., Джеффри Э. Хинтон и Р. Дж. Уильямс. « Изучение внутренних представлений путем распространения ошибок. Архивировано 13 октября 2022 г. в Wayback Machine ». Дэвид Э. Румельхарт, Джеймс Л. Макклелланд и исследовательская группа НДП. (редакторы), Параллельная распределенная обработка: Исследования микроструктуры познания, Том 1: Фонд. Массачусетский технологический институт Пресс, 1986.

- ^ Фукусима, К. (1980). «Неокогнитрон: самоорганизующаяся модель нейронной сети для механизма распознавания образов, на который не влияет сдвиг положения». Биол. Киберн . 36 (4): 193–202. дои : 10.1007/bf00344251 . ПМИД 7370364 . S2CID 206775608 .

- ^ Рамачандран, Праджит; Баррет, Зоф; Куок, В. Ле (16 октября 2017 г.). «Поиск функций активации». arXiv : 1710.05941 [ cs.NE ].

- ^ Айзенберг, Индиана; Айзенберг, Н.Н.; Вандевалле, Дж. (2000). Многозначные и универсальные бинарные нейроны . Научные и деловые СМИ. дои : 10.1007/978-1-4757-3115-6 . ISBN 978-0-7923-7824-2 . Проверено 27 декабря 2023 г.

- ^ Коэволюционирующие рекуррентные нейроны изучают POMDP глубокой памяти. Учеб. GECCO, Вашингтон, округ Колумбия, стр. 1795–1802, ACM Press, Нью-Йорк, Нью-Йорк, США, 2005 г.

- ↑ Перейти обратно: Перейти обратно: а б Чжан, Вэй (1988). «Сдвиг-инвариантная нейронная сеть распознавания образов и ее оптическая архитектура» . Материалы ежегодной конференции Японского общества прикладной физики .

- ^ Чжан, Вэй (1990). «Модель параллельной распределенной обработки с локальными пространственно-инвариантными соединениями и ее оптическая архитектура» . Прикладная оптика . 29 (32): 4790–7. Бибкод : 1990ApOpt..29.4790Z . дои : 10.1364/AO.29.004790 . ПМИД 20577468 .

- ↑ Перейти обратно: Перейти обратно: а б ЛеКун и др. , «Обратное распространение ошибки, примененное к распознаванию рукописного почтового индекса», Neural Computation , 1, стр. 541–551, 1989.

- ^ Чжан, Вэй (1991). «Обработка изображений эндотелия роговицы человека на основе обучающей сети» . Прикладная оптика . 30 (29): 4211–7. Бибкод : 1991ApOpt..30.4211Z . дои : 10.1364/AO.30.004211 . ПМИД 20706526 .

- ^ Чжан, Вэй (1994). «Компьютерное обнаружение кластерных микрокальцинатов на цифровых маммограммах с использованием инвариантной к сдвигу искусственной нейронной сети» . Медицинская физика . 21 (4): 517–24. Бибкод : 1994MedPh..21..517Z . дои : 10.1118/1.597177 . ПМИД 8058017 .

- ^ ЛеКун, Янн; Леон Ботту; Йошуа Бенджио; Патрик Хаффнер (1998). «Градиентное обучение, применяемое для распознавания документов» (PDF) . Труды IEEE . 86 (11): 2278–2324. CiteSeerX 10.1.1.32.9552 . дои : 10.1109/5.726791 . S2CID 14542261 . Проверено 7 октября 2016 г.

- ↑ Перейти обратно: Перейти обратно: а б с Шмидхубер, Юрген (1992). «Обучение сложных, расширенных последовательностей с использованием принципа сжатия истории (на основе ТР ФКИ-148, 1991 г.)» (PDF) . Нейронные вычисления . 4 (2): 234–242. дои : 10.1162/neco.1992.4.2.234 . S2CID 18271205 . [ постоянная мертвая ссылка ]

- ^ Шмидхубер, Юрген (1993). Кандидатская диссертация (PDF) (на немецком языке). Архивировано из оригинала (PDF) 26 июня 2021 года.

- ^ Шмидхубер, Юрген (1 ноября 1992 г.). «Научимся контролировать быстрые воспоминания: альтернатива повторяющимся сетям». Нейронные вычисления . 4 (1): 131–139. дои : 10.1162/neco.1992.4.1.131 . S2CID 16683347 .