Философия искусственного интеллекта

| Часть серии о |

| Искусственный интеллект |

|---|

Философия искусственного интеллекта — это ветвь философии разума и философии информатики. [1] который исследует искусственный интеллект и его значение для знаний и понимания интеллекта , этики , сознания , эпистемологии и свободы воли . [2] [3] Более того, технология связана с созданием искусственных животных или искусственных людей (или, по крайней мере, искусственных существ; см. искусственную жизнь ), поэтому эта дисциплина представляет значительный интерес для философов. [4] Эти факторы способствовали появлению философии искусственного интеллекта.

Философия искусственного интеллекта пытается ответить на такие вопросы следующим образом: [5]

- Может ли машина действовать разумно? Может ли он решить любую проблему, которую человек решил бы, думая?

- Человеческий интеллект и машинный интеллект — одно и то же? Является ли человеческий мозг по сути компьютером?

- Может ли машина обладать разумом , психическими состояниями и сознанием в том же смысле, что и человек? Может ли оно почувствовать, как обстоят дела ? (т.е. есть ли у него квалиа ?)

Подобные вопросы отражают расходящиеся интересы исследователей ИИ , учёных-когнитивистов и философов соответственно. Научные ответы на эти вопросы зависят от определения «интеллекта» и «сознания» и от того, о каких именно «машинах» идет речь.

Важные положения философии ИИ включают некоторые из следующих:

- «Вежливое соглашение» Тьюринга : если машина ведет себя так же разумно, как человек, то она так же разумна, как человек. [6]

- Предложение Дартмута : «Каждый аспект обучения или любая другая особенность интеллекта в принципе может быть описана настолько точно, что можно создать машину для его моделирования». [7]

- Гипотеза Аллена Ньюэлла и Герберта А. Саймона о системе физических символов : «Система физических символов обладает необходимыми и достаточными средствами общего разумного действия». [8]

- Сирла Джона Сильная гипотеза ИИ : «Правильно запрограммированный компьютер с правильными входами и выходами, таким образом, будет обладать разумом точно в том же смысле, в котором разум есть у людей». [9]

- Механизм Гоббса : «Ибо «разум»… есть не что иное, как «подсчет», то есть добавление и вычитание последствий общих названий, согласованных для «маркировки» и «означания» наших мыслей…» [10]

Может ли машина проявлять общий интеллект? [ редактировать ]

Возможно ли создать машину, которая сможет решить все проблемы, которые люди решают, используя свой интеллект? Этот вопрос определяет масштаб того, что машины смогут делать в будущем, и определяет направление исследований ИИ. Оно касается только поведения машин и игнорирует вопросы, интересующие психологов , когнитивистов и философов , вызывая вопрос: имеет ли значение, действительно ли машина думает так, как думает человек, а не просто производит результаты, которые кажутся результатом думаешь? [11]

Основная позиция большинства исследователей ИИ суммирована в этом заявлении, которое появилось в предложении Дартмутского семинара 1956 года:

- «Каждый аспект обучения или любая другая особенность интеллекта в принципе может быть описана настолько точно, что можно создать машину, имитирующую его». [7]

Аргументы против основной предпосылки должны показать, что создание работающей системы искусственного интеллекта невозможно, потому что существует некоторый практический предел возможностей компьютеров или что существует какое-то особое качество человеческого разума, которое необходимо для разумного поведения и, тем не менее, не может быть воспроизведено компьютером. машине (или методами современных исследований ИИ). Аргументы в пользу основной предпосылки должны показать, что такая система возможна.

Можно также обойти связь между двумя частями приведенного выше предложения. Например, машинное обучение, начиная с печально известного Тьюринга о детских машинах , предложения [12] по сути, достигает желаемой функции интеллекта без точного описания во время разработки того, как именно это будет работать. Отчет о неявных знаниях роботов [13] вообще исключает необходимость точного описания.

Первым шагом к ответу на этот вопрос является четкое определение понятия «интеллект».

Интеллект [ править ]

Тест Тьюринга [ править ]

Алан Тьюринг [15] свел проблему определения интеллекта к простому вопросу о разговоре. Он предполагает следующее: если машина может ответить на любой заданный ей вопрос, используя те же слова, что и обычный человек, то мы можем назвать эту машину разумной. В современной версии его экспериментального проекта будет использоваться онлайн- чат , где одним из участников является реальный человек, а одним из участников — компьютерная программа. Программа проходит тест, если никто не может сказать, кто из двух участников человек. [6] Тьюринг отмечает, что никто (кроме философов) никогда не задается вопросом «могут ли люди мыслить?» Он пишет: «Вместо того, чтобы постоянно спорить по этому поводу, обычно существует вежливая договоренность, о которой все думают». [16] Тест Тьюринга распространяет это вежливое соглашение на машины:

- Если машина действует так же разумно, как человек, то она так же разумна, как человек.

Критика теста Тьюринга заключается в том, что он измеряет только «человечность» поведения машины, а не «разумность» поведения. Поскольку человеческое поведение и разумное поведение — не одно и то же, тест не позволяет измерить интеллект. Стюарт Дж. Рассел и Питер Норвиг пишут, что «в текстах по авиационной технике цель их области не определяется как« создание машин, которые летают настолько точно, как голуби, чтобы они могли обмануть других голубей »». [17]

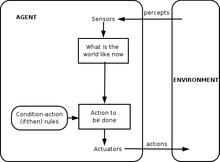

Интеллект целей достижение как

Исследования искусственного интеллекта XXI века определяют интеллект как целенаправленное поведение. Он рассматривает интеллект как набор задач, которые должна решить машина: чем больше проблем она может решить и чем лучше ее решения, тем умнее программа. Основатель искусственного интеллекта Джон Маккарти определил интеллект как «вычислительную часть способности достигать целей в мире». [18]

Стюарт Рассел и Питер Норвиг формализовали это определение, используя абстрактных интеллектуальных агентов . «Агент» — это нечто, что воспринимает и действует в окружающей среде. «Показатель эффективности» определяет, что считается успехом для агента. [19]

- «Если агент действует так, чтобы максимизировать ожидаемое значение показателя эффективности на основе прошлого опыта и знаний, то он разумен». [20]

Определения, подобные этому, пытаются уловить суть интеллекта. У них есть то преимущество, что, в отличие от теста Тьюринга, они также не проверяют неразумные человеческие качества, такие как ошибки при наборе текста. [21] Их недостаток заключается в том, что они не могут отличить «вещи, которые думают», от «вещей, которые не думают». Согласно этому определению, даже термостат обладает рудиментарным интеллектом. [22]

, что машина может демонстрировать общий интеллект Аргументы в пользу того

Мозг можно моделировать

Хьюберт Дрейфус описывает этот аргумент как утверждение, что «если нервная система подчиняется законам физики и химии, а у нас есть все основания предполагать, что это так, то… мы… должны быть способны воспроизводить поведение нервной системы». система с каким-либо физическим устройством». [23] Этот аргумент, впервые представленный еще в 1943 г. [24] и ярко описано Гансом Моравецом в 1988 году, [25] теперь связан с футуристом Рэем Курцвейлом , который считает, что мощности компьютера будет достаточно для полной симуляции мозга к 2029 году. [26] Моделирование таламокортикальной модели, не работающей в режиме реального времени, размером с человеческий мозг (10 11 нейроны) было выполнено в 2005 году, [27] и потребовалось 50 дней, чтобы смоделировать 1 секунду динамики мозга на кластере из 27 процессоров.

Даже самые суровые критики ИИ (такие как Хьюберт Дрейфус и Джон Сирл ) согласны с тем, что моделирование мозга теоретически возможно. [а] Однако Сирл отмечает, что в принципе все с помощью компьютера можно смоделировать ; таким образом, доведение определения до критической точки приводит к выводу, что любой процесс вообще можно технически считать «вычислением». «Мы хотели узнать, что отличает разум от термостатов и печени», — пишет он. [30] Таким образом, простое моделирование функционирования живого мозга само по себе было бы признанием невежества в отношении интеллекта и природы разума, подобно попытке построить реактивный авиалайнер путем точного копирования живой птицы, перышко за перышком, без теоретического понимания авиационная техника . [31]

Человеческое мышление — обработка это символов

В 1963 году Аллен Ньюэлл и Герберт А. Саймон предположили, что «манипулирование символами» является сутью как человеческого, так и машинного интеллекта. Они написали:

- «Физическая символьная система обладает необходимыми и достаточными средствами общего разумного действия». [8]

Это утверждение очень сильное: оно подразумевает как то, что человеческое мышление — это своего рода манипулирование символами (поскольку для интеллекта необходима системы символов ). достаточно система символов), так и то, что машины могут быть разумными (поскольку для интеллекта [32] Другая версия этой позиции была описана философом Губертом Дрейфусом, который назвал ее «психологическим предположением»:

- «Разум можно рассматривать как устройство, оперирующее битами информации в соответствии с формальными правилами». [33]

«Символы», которые обсуждали Ньюэлл, Саймон и Дрейфус, были словесными и высокого уровня — символами, которые напрямую соответствуют объектам в мире, например <собака> и <хвост>. Большинство программ искусственного интеллекта, написанных между 1956 и 1990 годами, использовали этот тип символов. Современный ИИ, основанный на статистике и математической оптимизации, не использует высокоуровневую «обработку символов», о которой говорили Ньюэлл и Саймон.

символов обработки Аргументы против

Эти аргументы показывают, что человеческое мышление не состоит (исключительно) из манипуляций с символами высокого уровня. Они не доказывают, что искусственный интеллект невозможен, а лишь показывают, что требуется нечто большее, чем просто обработка символов.

антимеханистские аргументы Гёделевские

В 1931 году Курт Гёдель доказал с помощью теоремы о неполноте , что всегда возможно построить « утверждение Гёделя », которое данная непротиворечивая формальная система логики (например, программа манипулирования символами высокого уровня) не может доказать. Несмотря на то, что построенное утверждение Гёделя является истинным, оно недоказуемо в данной системе. (Истинность построенного утверждения Гёделя зависит от непротиворечивости данной системы; применение того же процесса к слегка противоречивой системе может показаться успешным, но на самом деле вместо этого приведет к ложному «утверждению Гёделя».) [ нужна цитата ] В более умозрительном плане Гёдель предположил, что человеческий разум может в конечном итоге правильно определить истинность или ложность любого хорошо обоснованного математического утверждения (включая любое возможное утверждение Гёделя), и что, следовательно, сила человеческого разума не сводится к механизму . [34] Философ Джон Лукас (с 1961 года) и Роджер Пенроуз (с 1989 года) отстаивали этот философский антимеханистический аргумент . [35]

Гёделевские антимеханистические аргументы имеют тенденцию опираться на кажущееся безобидным утверждение о том, что система людей-математиков (или некоторая идеализация людей-математиков) одновременно непротиворечива (полностью свободна от ошибок) и полностью верит в свою непротиворечивость (и может сделать все логическими). выводы, которые следуют из его собственной последовательности, включая веру в утверждение Гёделя) [ нужна цитата ] . Доказуемо невозможно сделать это для машины Тьюринга (см. Проблема остановки ); следовательно, гёделианец заключает, что человеческое мышление слишком мощно, чтобы его можно было охватить машиной Тьюринга и, как следствие, любым цифровым механическим устройством.

Однако современный консенсус в научном и математическом сообществе заключается в том, что реальные человеческие рассуждения непоследовательны; что любая последовательная «идеализированная версия» H человеческого рассуждения логически будет вынуждена принять здоровый, но нелогичный и открытый скептицизм относительно непротиворечивости H (в противном случае H будет доказуемо непоследовательным); и что теоремы Гёделя не приводят к какому-либо вескому аргументу в пользу того, что люди обладают способностями к математическому мышлению, превосходящими те, которые машина когда-либо могла бы воспроизвести. [36] [37] [38] Консенсус о том, что гёделевские антимеханистские аргументы обречены на провал, четко изложен в «Искусственном интеллекте» : « любая попытка использовать (результаты Гёделя о неполноте) для критики тезиса вычислительной техники неизбежно будет нелегитимной, поскольку эти результаты вполне согласуются с тезисами вычислительной техники». Тезис." [39]

Стюарт Рассел и Питер Норвиг согласны с тем, что аргументы Гёделя не учитывают природу реальных человеческих рассуждений. Оно применимо к тому, что теоретически можно доказать, имея бесконечное количество памяти и времени. На практике реальные машины (включая людей) имеют ограниченные ресурсы и с трудом доказывают многие теоремы. Чтобы быть умным человеком, не обязательно уметь все доказать. [40]

Менее формально Дуглас Хофштадтер в своей », получившей Пулитцеровскую премию книге «Гёдель, Эшер, Бах: Вечная золотая коса , утверждает, что эти «геделевские утверждения» всегда относятся к самой системе, проводя аналогию с тем, как в парадоксе Эпименида используются утверждения, которые ссылаются на себя, например: «Это утверждение ложно» или «Я лгу». [41] Но, конечно, парадокс Эпименида применим ко всему, что высказывает утверждения, будь то машины или люди, даже сам Лукас. Учитывать:

- Лукас не может утверждать истинность этого утверждения. [42]

Это утверждение верно, но Лукас не может его утверждать. Это показывает, что сам Лукас, как и все люди, подвержен тем же ограничениям, которые он описывает для машин, и поэтому аргумент Лукаса бессмысленен. [43]

Придя к выводу, что человеческое мышление не поддается вычислению, Пенроуз продолжил спорное предположение, что некие гипотетические невычислимые процессы, включающие коллапс квантово-механических состояний, дают людям особое преимущество перед существующими компьютерами. Существующие квантовые компьютеры способны только снизить сложность вычислительных задач Тьюринга и по-прежнему ограничиваются задачами, входящим в рамки машин Тьюринга. [ нужна цитата ] [ нужны разъяснения ] . Согласно аргументам Пенроуза и Лукаса, тот факт, что квантовые компьютеры способны решать только задачи, вычислимые по Тьюрингу, означает, что их недостаточно для имитации человеческого разума. [ нужна цитата ] Поэтому Пенроуз ищет какой-то другой процесс, включающий новую физику, например квантовую гравитацию, которая могла бы проявить новую физику в масштабе планковской массы посредством спонтанного квантового коллапса волновой функции. Он предположил, что эти состояния возникают как внутри нейронов, так и охватывают более одного нейрона. [44] Однако другие учёные отмечают, что в мозге нет убедительного органического механизма, способного использовать какие-либо квантовые вычисления, и, кроме того, временные рамки квантовой декогеренции кажутся слишком быстрыми, чтобы влиять на активацию нейронов. [45]

: главенство неявных Дрейфус навыков

Хьюберт Дрейфус утверждал, что человеческий интеллект и опыт зависят в первую очередь от быстрых интуитивных суждений, а не от пошаговых символических манипуляций, и утверждал, что эти навыки никогда не будут отражены в формальных правилах. [46]

Аргумент Дрейфуса был предвосхищен Тьюрингом в его статье 1950 года « Вычислительная техника и интеллект» , где он классифицировал его как «аргумент, основанный на неформальном поведении». [47] Тьюринг в ответ утверждал, что то, что мы не знаем правил, управляющих сложным поведением, не означает, что таких правил не существует. Он писал: «Мы не можем так легко убедить себя в отсутствии полных законов поведения... Единственный известный нам способ найти такие законы — это научное наблюдение, и мы, конечно, не знаем никаких обстоятельств, при которых мы могли бы сказать: «Мы достаточно обыскали. Таких законов нет». [48]

Рассел и Норвиг отмечают, что за годы, прошедшие с тех пор, как Дрейфус опубликовал свою критику, был достигнут прогресс в открытии «правил», управляющих бессознательным рассуждением. [49] Ситуационное движение в исследованиях робототехники пытается уловить наши бессознательные навыки восприятия и внимания. [50] вычислительного интеллекта Парадигмы , такие как нейронные сети , эволюционные алгоритмы и т. д., в основном направлены на моделирование бессознательных рассуждений и обучения. Статистические подходы к ИИ позволяют делать прогнозы, точность которых приближается к интуитивным догадкам человека. Исследования здравого смысла сосредоточены на воспроизведении «предыстории» или контекста знаний. Фактически, исследования ИИ в целом отошли от манипуляций с символами высокого уровня в сторону новых моделей, которые призваны лучше отражать наши интуитивные рассуждения. [49]

Когнитивная наука и психология в конечном итоге пришли к согласию с описанием человеческого опыта, данным Дрейфусом. Дэниел Канеман и другие разработали аналогичную теорию, определив две «системы», которые люди используют для решения проблем, которые он назвал «Системой 1» (быстрые интуитивные суждения) и «Системой 2» (медленное сознательное, пошаговое мышление). [51]

Хотя взгляды Дрейфуса были подтверждены во многих отношениях, работа в области когнитивной науки и искусственного интеллекта была ответом на конкретные проблемы в этих областях и не находилась под прямым влиянием Дрейфуса. Историк и исследователь искусственного интеллекта Дэниел Кревье писал, что «время доказало точность и проницательность некоторых комментариев Дрейфуса. Если бы он сформулировал их менее агрессивно, предлагаемые ими конструктивные действия могли бы быть предприняты гораздо раньше». [52]

Может ли машина обладать разумом, сознанием и психическими состояниями? [ редактировать ]

Это философский вопрос, связанный с проблемой других разумов и трудной проблемой сознания . Вопрос вращается вокруг позиции, которую Джон Сирл определил как «сильный ИИ»:

- Физическая система символов может иметь разум и психические состояния. [9]

Сирл отличал эту позицию от того, что он называл «слабым ИИ»:

- Физическая система символов может действовать разумно. [9]

Сирл ввел термины, позволяющие отделить сильный ИИ от слабого ИИ, чтобы он мог сосредоточиться на том, что, по его мнению, было более интересным и спорным вопросом. Он утверждал, что даже если мы предположим , что у нас есть компьютерная программа, действующая точно так же, как человеческий разум, все равно останется трудный философский вопрос, на который необходимо ответить. [9]

Ни одна из двух позиций Сирла не представляет особого интереса для исследований ИИ, поскольку они не дают прямого ответа на вопрос: «Может ли машина демонстрировать общий интеллект?» (если только не будет также показано, что сознание необходимо для интеллекта). Тьюринг писал: «Я не хочу создавать впечатление, что, по моему мнению, в сознании нет никакой тайны… [б] но я не думаю, что эти загадки обязательно необходимо разгадать, прежде чем мы сможем ответить на вопрос [могут ли машины думать]. " [53] Рассел и Норвиг соглашаются: «Большинство исследователей ИИ принимают слабую гипотезу ИИ как нечто само собой разумеющееся и не заботятся о сильной гипотезе ИИ». [54]

Есть несколько исследователей, которые считают, что сознание является важным элементом интеллекта, например Игорь Александер , Стэн Франклин , Рон Сан и Пентти Хайконен , хотя их определение «сознания» очень близко к «интеллекту». (См. искусственное сознание .)

Прежде чем мы сможем ответить на этот вопрос, мы должны прояснить, что мы подразумеваем под «умами», «психическими состояниями» и «сознанием».

Сознание, умы, психические состояния, значение [ править ]

Слова « разум » и « сознание » используются разными сообществами по-разному. Некоторые мыслители нового века , например, используют слово «сознание» для описания чего-то похожего на » Бергсона « жизненный порыв : невидимый энергетический флюид, который пронизывает жизнь и особенно разум. Писатели -фантасты используют это слово для описания некоторого существенного свойства, которое делает нас людьми: машина или инопланетянин, обладающий «сознанием», будет представлен как полностью человеческий персонаж, обладающий интеллектом, желаниями, волей , проницательностью, гордостью и так далее. (Писатели-фантасты также используют слова «разум», «разум», «самосознание» или « призрак » — как в манге и аниме «Призрак в доспехах» — для описания этого важного человеческого свойства). Для других [ ВОЗ? ] Слова «разум» или «сознание» используются как своего рода светский синоним души .

Для философов , нейробиологов и когнитивистов эти слова используются одновременно более точно и более обыденно: они относятся к знакомому, повседневному опыту наличия «мысли в голове», например, к восприятию, сну, намерение или план, а также то, как мы что-то видим , что-то знаем , что-то имеем в виду или что-то понимаем . [55] «Нетрудно дать здравое определение сознания», — замечает философ Джон Сирл. [56] Загадочно и увлекательно не столько то, что это такое, сколько то, как оно есть: как комок жировой ткани и электричества порождает этот (знакомый) опыт восприятия, значения или мышления?

Философы называют это трудной проблемой сознания . Это последняя версия классической проблемы философии сознания, называемой « проблемой разума и тела ». [57] Связанной с этим проблемой является проблема значения или понимания (которую философы называют « интенциональностью »): какова связь между нашими мыслями и тем, о чем мы думаем (т.е. объектами и ситуациями в мире)? Третий вопрос — это проблема опыта (или « феноменологии »): если два человека видят одно и то же, имеют ли они одинаковый опыт? Или есть вещи «внутри их головы» (называемые « квалиа »), которые могут отличаться от человека к человеку? [58]

Нейробиологи полагают, что все эти проблемы будут решены, когда мы начнем идентифицировать нейронные корреляты сознания : реальную взаимосвязь между механизмами в нашей голове и их коллективными свойствами; такие как разум, опыт и понимание. Некоторые из самых резких критиков искусственного интеллекта согласны с тем, что мозг — это всего лишь машина, а сознание и интеллект — результат физических процессов в мозге. [59] Сложный философский вопрос заключается в следующем: может ли компьютерная программа, работающая на цифровой машине, которая перемешивает двоичные цифры нуля и единицы, дублировать способность нейронов создавать разум с ментальными состояниями (такими как понимание или восприятие) и, в конечном итоге, опыт сознания?

Аргументы о том, что у компьютера не может быть разума и психических состояний [ править ]

Китайская комната Сирла [ править ]

Джон Сирл предлагает нам рассмотреть мысленный эксперимент : предположим, что мы написали компьютерную программу, которая проходит тест Тьюринга и демонстрирует общие разумные действия. Предположим, в частности, что программа может свободно общаться на китайском языке. Напишите программу на карточках 3х5 и дайте их обычному человеку, не говорящему по-китайски. Заприте человека в комнате и предложите ему следовать инструкциям на карточках. Он будет копировать китайские иероглифы и передавать их в комнату и из нее через щель. Со стороны может показаться, что в китайской комнате находится вполне разумный человек, говорящий по-китайски. Вопрос вот в чем: есть ли в комнате кто-нибудь (или что-нибудь) понимающий китайский язык? То есть, есть ли что-нибудь, что обладает ментальным состоянием понимания или сознательно осознает то, что обсуждается на китайском языке? Мужчина явно не в курсе. Комната не может быть в курсе. Карты конечно не в курсе. Сирл заключает, что китайская комната или любая другая физическая система символов не может иметь разума. [60]

Сирл продолжает утверждать, что реальные психические состояния и сознание требуют (еще не описанных) «реальных физико-химических свойств реального человеческого мозга». [61] Он утверждает, что существуют особые «причинные свойства» мозга и нейронов , которые порождают разум : по его словам, «мозг вызывает разум». [62]

аргументы: мельница Лейбница, телефонная станция Дэвиса, китайская нация Блока и . Болван Связанные

Готфрид Лейбниц выдвинул по существу тот же аргумент, что и Серл в 1714 году, используя мысленный эксперимент по расширению мозга до размеров мельницы. [63] В 1974 году Лоуренс Дэвис представил, как можно дублировать мозг с помощью телефонных линий и офисов, укомплектованных людьми, а в 1978 году Нед Блок представил, что все население Китая будет участвовать в таком моделировании мозга. Этот мысленный эксперимент называется «Китайская нация» или «Китайский тренажерный зал». [64] Нед Блок также предложил свой аргумент «Болван» , который представляет собой версию китайской комнаты , в которой программа была переработана в простой набор правил формы «посмотри это, сделай то», убрав из программы всю тайну.

Ответы на китайскую комнату [ править ]

В ответах на китайскую комнату подчеркивается несколько разных моментов.

- Ответ системы и ответ виртуального разума : [65] В этом ответе утверждается, что система , включая человека, программу, комнату и карты, понимает китайский язык. Сирл утверждает, что человек в комнате — единственное, что может «иметь разум» или «понимать», но другие не согласны, утверждая, что в одном и том же физическом месте могут существовать два разума, подобно тому, как компьютер может одновременно «быть» сразу двумя машинами: одной физической (например, Macintosh ) и одной « виртуальной » (например, текстовым процессором ).

- Ответы на скорость, мощность и сложность : [66] Некоторые критики отмечают, что человеку в комнате, вероятно, потребуются миллионы лет, чтобы ответить на простой вопрос, и ему потребуются «картотеки» астрономических размеров. Это ставит под сомнение ясность интуиции Сирла.

- Ответ робота : [67] Некоторые считают, что для того, чтобы по-настоящему понять, Китайской комнате нужны глаза и руки. Ганс Моравец пишет: «Если бы мы могли привить робота к программе рассуждения, нам больше не нужен был бы человек, который мог бы передавать смысл: он исходил бы из физического мира». [68]

- Ответ симулятора мозга : [69] Что, если программа имитирует последовательность нервных импульсов в синапсах реального мозга настоящего говорящего по-китайски? Мужчина в комнате будет моделировать настоящий мозг. Это вариант «ответа системы», который кажется более правдоподобным, поскольку «система» теперь явно действует как человеческий мозг, что усиливает интуицию о том, что помимо мужчины в комнате есть что-то, что может понимать по-китайски.

- Ответ других умов и ответ эпифеномена : [70] Некоторые люди отметили, что аргумент Сирла — это всего лишь версия проблемы других разумов , применённая к машинам. Поскольку трудно решить, думают ли люди «на самом деле», не следует удивляться, что на тот же вопрос трудно ответить и о машинах.

- Связанный с этим вопрос заключается в том, существует ли «сознание» (как его понимает Сирл). Сирл утверждает, что опыт сознания нельзя обнаружить, исследуя поведение машины, человека или любого другого животного. Дэниел Деннетт указывает, что естественный отбор не может сохранить особенность животного, которая не оказывает влияния на поведение животного, и, следовательно, сознание (в понимании Сёрла) не может быть создано путем естественного отбора. Следовательно, либо естественный отбор не создал сознание, либо «сильный ИИ» верен в том смысле, что сознание можно обнаружить с помощью специально разработанного теста Тьюринга.

Является ли мышление своего рода вычислением? [ редактировать ]

Вычислительная теория разума или « компьютерализм » утверждает, что отношения между разумом и мозгом аналогичны (если не идентичны) отношениям между работающей программой (программным обеспечением) и компьютером (аппаратным обеспечением). Эта идея имеет философские корни у Гоббса (который утверждал, что рассуждение — это «не более чем расчет»), Лейбница (который пытался создать логическое исчисление всех человеческих идей), Юма (который считал, что восприятие можно свести к «атомарным впечатлениям») и даже Кант (который анализировал весь опыт как контролируемый формальными правилами). [71] Последняя версия связана с философами Хилари Патнэм и Джерри Фодором . [72]

Этот вопрос связан с нашими предыдущими вопросами: если человеческий мозг — это своего рода компьютер, то компьютеры могут быть одновременно интеллектуальными и сознательными, отвечая как на практические, так и на философские вопросы ИИ. Что касается практического вопроса ИИ («Может ли машина демонстрировать общий интеллект?»), некоторые версии компьютерализма утверждают, что (как писал Гоббс ):

- Рассуждение — это не что иное, как расчет. [10]

Другими словами, наш интеллект основан на расчетах , похожих на арифметику . Это гипотеза системы физических символов , обсуждавшаяся выше, и она подразумевает, что искусственный интеллект возможен. Что касается философского вопроса об ИИ («Может ли машина иметь разум, ментальные состояния и сознание?»), большинство версий компьютерализма утверждают , что (как Стеван Харнад это характеризует ):

- Ментальные состояния — это всего лишь реализации (правильных) компьютерных программ. [73]

Это «сильный ИИ» Джона Сирла, о котором говорилось выше, и он является настоящей целью аргумента о китайской комнате (по мнению Харнада ). [73]

[ править ]

Может ли машина иметь эмоции? [ редактировать ]

Если « эмоции » определяются только с точки зрения их влияния на поведение или на то, как они функционируют внутри организма, то эмоции можно рассматривать как механизм, который интеллектуальный агент использует для максимизации полезности своих действий. Учитывая такое определение эмоций, Ганс Моравец считает, что «роботы в целом будут очень эмоционально относиться к тому, что они хорошие люди». [74] Страх является источником срочности. Эмпатия является необходимым компонентом хорошего взаимодействия человека с компьютером . Он говорит, что роботы «будут стараться доставить вам удовольствие в явно бескорыстной манере, потому что они получат удовольствие от этого положительного подкрепления. Вы можете интерпретировать это как своего рода любовь». [74] Дэниел Кревье пишет: «Моравек считает, что эмоции — это всего лишь средства направления поведения в направлении, выгодном для выживания вида». [75]

Может ли машина обладать самосознанием? [ редактировать ]

« Самосознание », как отмечалось выше, иногда используется писателями -фантастами как название важнейшего человеческого свойства, делающего персонажа полностью человечным. Тьюринг отбрасывает все остальные свойства человека и сводит вопрос к следующему: «Может ли машина быть предметом собственного мышления?» Может ли оно думать о себе ? С этой точки зрения можно написать программу, которая может сообщать о своих внутренних состояниях, например отладчик . [76]

Может ли машина быть оригинальной или креативной? [ редактировать ]

Тьюринг сводит это к вопросу о том, может ли машина «застать нас врасплох», и утверждает, что это, очевидно, правда, что может подтвердить любой программист. [77] Он отмечает, что при достаточной емкости памяти компьютер может вести себя астрономически по-разному. [78] Для компьютера, способного представлять идеи, должна быть возможность, даже тривиальная, комбинировать их новыми способами. ( Дугласа Лената » « Автоматическую математику В качестве примера можно привести , объединившую идеи для открытия новых математических истин.) Каплан и Хенляйн предполагают, что машины могут демонстрировать научное творчество, хотя вполне вероятно, что люди одержат верх в том, что касается художественного творчества. [79]

В 2009 году ученые из Аберистуитского университета в Уэльсе и британского Кембриджского университета разработали робота по имени Адам, который, по их мнению, станет первой машиной, которая самостоятельно сделает новые научные открытия. [80] Также в 2009 году исследователи из Корнелла разработали Eureqa — компьютерную программу, которая экстраполирует формулы в соответствии с введенными данными, например, находя законы движения на основе движения маятника.

Может ли машина быть доброжелательной или враждебной? [ редактировать ]

Этот вопрос (как и многие другие в философии искусственного интеллекта) можно представить в двух формах. «Враждебность» можно определить с точки зрения функции или поведения , и в этом случае «враждебный» становится синонимом «опасного». Или это можно определить с точки зрения намерения: может ли машина «намеренно» намереваться причинить вред? Последний вопрос — «может ли машина иметь сознательные состояния?» (например, намерения ) в другой форме. [53]

Вопрос о том, будут ли опасны высокоинтеллектуальные и полностью автономные машины, подробно исследовался футуристами (например, НИИ машинного интеллекта ). Очевидный элемент драмы также сделал эту тему популярной в научной фантастике , которая рассматривала множество различных возможных сценариев, в которых интеллектуальные машины представляют угрозу человечеству; см. Искусственный интеллект в художественной литературе .

Одна из проблем заключается в том, что машины могут очень быстро приобрести автономию и интеллект, необходимые для того, чтобы стать опасными. Вернор Виндж предположил, что всего за несколько лет компьютеры внезапно станут в тысячи или миллионы раз умнее человека. Он называет это « сингулярностью ». [81] Он предполагает, что это может быть в некоторой степени или, возможно, очень опасно для человека. [82] Это обсуждается философией под названием Сингуляритаризм .

В 2009 году ученые и технические эксперты посетили конференцию, чтобы обсудить потенциальное влияние роботов и компьютеров, а также влияние гипотетической возможности того, что они смогут стать самодостаточными и принимать собственные решения . Они обсудили возможность и степень, в которой компьютеры и роботы смогут приобрести тот или иной уровень автономии, и в какой степени они могут использовать такие способности, чтобы представлять какую-либо угрозу или опасность. Они отметили, что некоторые машины приобрели различные формы полуавтономности, в том числе способность самостоятельно находить источники питания и возможность самостоятельно выбирать цели для атаки оружием. Они также отметили, что некоторые компьютерные вирусы могут уклоняться от уничтожения и обладают «тараканьим интеллектом». Они отметили, что самосознание , изображенное в научной фантастике, вероятно, маловероятно, но существуют и другие потенциальные опасности и ловушки. [81]

Некоторые эксперты и ученые ставят под сомнение использование роботов в боевых действиях, особенно когда таким роботам наделяется определенная степень автономных функций. [83] ВМС США профинансировали отчет, в котором указывается, что по мере того, как военные роботы становятся все более сложными, следует уделять больше внимания последствиям их способности принимать автономные решения. [84] [85]

Президент Ассоциации по развитию искусственного интеллекта заказал исследование по этому вопросу. [86] Они указывают на такие программы, как Устройство овладения языком, которое может имитировать человеческое взаимодействие.

Некоторые полагают, что необходимо создать « Дружественный ИИ » — термин, придуманный Элиезером Юдковски , означающий, что достижения, которые уже происходят в области ИИ, должны также включать усилия по созданию ИИ по своей сути дружелюбным и гуманным. [87]

Может ли машина имитировать все человеческие качества? [ редактировать ]

Тьюринг сказал: «Принято... предлагать долю утешения в форме заявления о том, что машина никогда не сможет имитировать какую-то особую человеческую характеристику. ... Я не могу предложить такого утешения, поскольку считаю, что нет такие границы могут быть установлены». [88]

Тьюринг отметил, что существует множество аргументов в форме «машина никогда не сделает X», где X может означать множество вещей, например:

Будьте добрыми, находчивыми, красивыми, дружелюбными, проявляйте инициативу, имейте чувство юмора, отличайте хорошее от неправильного, совершайте ошибки, влюбляйтесь, наслаждайтесь клубникой и сливками, влюбляйте в нее кого-то, учитесь на опыте, правильно используйте слова , быть предметом собственной мысли, иметь такое же разнообразие поведения, как и мужчина, делать что-то действительно новое. [76]

Тьюринг утверждает, что эти возражения часто основаны на наивных предположениях об универсальности машин или являются «замаскированными формами аргументации сознания». Написание программы, демонстрирующей одно из этих поведений, «не произведет особого впечатления». [76] Все эти аргументы имеют отношение к основной предпосылке ИИ, если только не будет показано, что одна из этих черт важна для общего интеллекта.

Может ли у машины быть душа? [ редактировать ]

Наконец, те, кто верит в существование души, могут утверждать, что «мышление — это функция бессмертной души человека». Алан Тьюринг назвал это «теологическим возражением». Он написал:

Пытаясь сконструировать такие машины, мы не должны непочтительно узурпировать Его силу создания душ, так же как мы не занимаемся рождением детей: скорее, в любом случае мы являемся инструментами Его воли, предоставляющими обители душам, которые Он создает. [89]

Дискуссия на эту тему возобновилась в результате недавних заявлений Google LaMDA от системы искусственного интеллекта о том, что она разумна и имеет « душу ». [90]

LaMDA ( языковая модель для диалоговых приложений) — это система искусственного интеллекта , которая создает чат-ботов — роботов с искусственным интеллектом, предназначенных для общения с людьми, — путем сбора огромных объемов текста из Интернета и использования алгоритмов для ответа на запросы наиболее гибким и естественным способом.

Стенограммы разговоров между учеными и LaMDA показывают, что система ИИ превосходно справляется с этим, давая ответы на сложные темы о природе эмоций , генерируя басни в стиле Эзопа о текущем моменте и даже описывая свои предполагаемые страхи. [91] Практически все философы сомневаются в разумности LaMDA. [92]

Взгляды на роль философии [ править ]

Некоторые ученые утверждают, что игнорирование философии сообществом ИИ вредно. В Стэнфордской энциклопедии философии некоторые философы утверждают, что роль философии в ИИ недооценена. [4] Физик Дэвид Дойч утверждает, что без понимания философии и ее концепций развитие ИИ пострадает из-за отсутствия прогресса. [93]

и литература Конференции

Основная серия конференций по этой проблеме — «Философия и теория искусственного интеллекта» (PT-AI), проводимая Винсентом К. Мюллером .

Основная библиография по этой теме с несколькими подразделами находится на сайте PhilPapers .

Недавний обзор « Философии искусственного интеллекта» — Мюллер (2023). [3]

См. также [ править ]

- Поглощение ИИ

- Искусственный мозг

- Искусственное сознание

- Искусственный интеллект

- Искусственная нейронная сеть

- Чат-бот

- Вычислительная теория разума

- Вычислительная техника и интеллект

- Экзистенциальный риск от общего искусственного интеллекта

- Функционализм

- Взгляды Хьюберта Дрейфуса на искусственный интеллект

- Мультиагентная система

- Философия информатики

- Философия информации

- Философия разума

- Система физических символов

- Имитированная реальность

- Суперинтеллект: пути, опасности, стратегии

- Синтетический интеллект

- Заголовок провода

Примечания [ править ]

- ^ Хьюберт Дрейфус пишет: «В целом, принимая фундаментальные предположения о том, что нервная система является частью физического мира и что все физические процессы могут быть описаны с помощью математического формализма, которым, в свою очередь, можно манипулировать с помощью цифрового компьютера, можно можно прийти к серьезному утверждению, что поведение, возникающее в результате «обработки информации» человеком, независимо от того, поддается ли оно прямой формализации или нет, всегда может быть косвенно воспроизведено на цифровой машине». . [28] Джон Сирл пишет: «Может ли человек заставить машину думать? Если предположить, что возможно искусственно создать машину с нервной системой... ответ на вопрос кажется очевидным: да... Может ли цифровой компьютер думать? «цифровой компьютер» вы имеете в виду что-либо вообще, имеющее такой уровень описания, на котором это можно правильно описать как реализацию компьютерной программы, тогда ответ, конечно же, да, поскольку мы являемся экземплярами любого количества компьютерных программ. , и мы можем думать». [29]

Ссылки [ править ]

- ^ «Философия информатики» . обо .

- ^ Маккарти, Джон. «Философия ИИ и ИИ философии» . jmc.stanford.edu . Архивировано из оригинала 23 октября 2018 г. Проверено 18 сентября 2018 г.

- ^ Перейти обратно: а б Мюллер, Винсент К. (24 июля 2023 г.). «Философия ИИ: структурированный обзор» . Натали А. Смуха (ред.), Кембриджский справочник по праву, этике и политике искусственного интеллекта .

- ^ Перейти обратно: а б Брингсйорд, Зельмер; Говиндараджулу, Навин Сундар (2018), «Искусственный интеллект» , в Залте, Эдвард Н. (редактор), Стэнфордская энциклопедия философии (изд. осени 2018 г.), Лаборатория метафизических исследований, Стэнфордский университет, заархивировано из оригинала в 2019 г. 9 сентября , получено 18 сентября 2018 г.

- ^ Рассел и Норвиг 2003 , с. 947 определяют философию ИИ как состоящую из первых двух вопросов и дополнительного вопроса об этике искусственного интеллекта . Ферн 2007 , с. 55 пишет: «В современной литературе философия играет две главные роли: определить, будут ли такие машины сознательными или нет, и, во-вторых, предсказать, возможны ли такие машины». Последний вопрос связан с первыми двумя.

- ^ Перейти обратно: а б Это перефраз основного пункта теста Тьюринга . Тьюринг 1950 , Хаугеланд 1985 , стр. 6–9, Кревье 1993 , стр. 24, Рассел и Норвиг 2003 , стр. 2–3 и 948.

- ^ Перейти обратно: а б Маккарти и др. 1955 год . Это утверждение было напечатано в программе Дартмутской конференции считали «рождением искусственного интеллекта». 1956 года, которую многие 28

- ^ Перейти обратно: а б Newell & Simon 1976. и Russell & Norvig 2003 , стр. 18

- ^ Перейти обратно: а б с д Эта версия взята из Searle (1999) , а также цитируется Dennett 1991 , p. 435. Первоначальная формулировка Сирла гласила: «Правильно запрограммированный компьютер на самом деле является разумом в том смысле, что можно буквально сказать, что компьютеры с правильными программами понимают и обладают другими когнитивными состояниями». ( Серл 1980 , стр. 1). Сильный ИИ определяется аналогичным образом Расселом и Норвигом (2003 , стр. 947): «Утверждение о том, что машины могут действовать разумно (или, возможно, лучше, действовать так, как если бы они были разумными), философы называют гипотезой «слабого ИИ». и утверждение, что машины, которые это делают, на самом деле думают (а не моделируют мышление), называется гипотезой «сильного ИИ».

- ^ Перейти обратно: а б Гоббс 1651 , гл. 5

- ^ См. Рассел и Норвиг 2003 , стр. 3, где они проводят различие между рациональными действиями и рациональными действиями и определяют ИИ как изучение первого.

- ^ Тьюринг, Алан М. (1950). «Вычислительная техника и интеллект» . Разум . 49 (236): 433–460. дои : 10.1093/mind/LIX.236.433 . Архивировано из оригинала 22 декабря 2021 г. Получено 18 октября 2020 г. - через отпечатки пальцев.

- ^ Хедер, Михай; Пакси, Дэниел (2012). «Автономные роботы и неявное знание» . Оценка . 9 (2): 8–14 – через academia.edu.

- ^ Получено в 2000 году .

- ^ Тьюринг 1950 и см. Рассел и Норвиг 2003 , стр. 948, где его статью называют «знаменитой» и пишут: «Тьюринг исследовал широкий спектр возможных возражений против возможности существования разумных машин, включая практически все те, которые были выдвинуты за полвека с момента появления его статьи».

- ^ Тьюринг, 1950, в разделе «Аргумент от сознания».

- ^ Рассел и Норвиг 2003 , с. 3

- ^ Маккарти 1999 .

- ^ Рассел и Норвиг 2003 , с. 4–5, 32, 35, 36 и 56.

- ^ Рассел и Норвиг предпочли бы слово « рациональный » слову «разумный».

- ^ «Искусственная глупость». Экономист . Том. 324, нет. 7770. 1 августа 1992. с. 14.

- ^ Рассел и Норвиг (2003 , стр. 48–52) считают термостат простой формой интеллектуального агента , известного как рефлекторный агент . Для более глубокого рассмотрения роли термостата в философии см. Чалмерс (1996 , стр. 293–301) «4. Повсеместен ли опыт?» подразделы Каково быть термостатом? , Куда панпсихизм? и Ограничение принципа двойного аспекта .

- ^ Дрейфус 1972 , с. 106.

- ^ Питтс и Маккалоу, 1943 .

- ^ Моравец 1988 .

- ^ Курцвейл 2005 , с. 262. См. также Рассел и Норвиг , с. 957 и Crevier 1993 , стр. 271 и 279. Самая крайняя форма этого аргумента (сценарий замены мозга) была выдвинута Кларком Глаймором в середине 1970-х годов и затронута Зенон Пилишин и Джон Сирл в 1980 году.

- ^ Евгений Ижикевич (27 октября 2005 г.). «Евгений Михайлович Ижикевич, Масштабное моделирование человеческого мозга» . Vesicle.nsi.edu. Архивировано из оригинала 1 мая 2009 г. Проверено 29 июля 2010 г.

- ^ Дрейфус 1972 , стр. 194–5.

- ^ Сирл 1980 , с. 11.

- ^ Сирл 1980 , с. 7.

- ^ Юдковский 2008 .

- ↑ Сирл пишет: «Мне нравится прямота утверждения». Сирл 1980 , с. 4

- ^ Дрейфус 1979 , с. 156

- ^ Гёдель, Курт , 1951, Некоторые основные теоремы об основах математики и их последствия в Соломоне Фефермане , изд., 1995. Собрание сочинений / Курт Гёдель, Vol. III . Издательство Оксфордского университета: 304-23. - В этой лекции Гёдель использует теорему о неполноте, чтобы прийти к следующему выводу: (а) человеческий разум не является последовательной конечной машиной, или (б) существуют диофантовы уравнения , для которых он не может решить, существуют ли решения. Гёдель считает (б) неправдоподобным и поэтому, похоже, полагал, что человеческий разум не эквивалентен конечной машине, т. е. его мощность превышает мощность любой конечной машины. Он признал, что это было лишь предположением, поскольку опровергнуть (б) никогда нельзя. И все же он считал дизъюнктивный вывод «определенным фактом».

- ^ Люк 1961 , Рассел и Норвиг 2003 , стр. 949–950, Хофштадтер 1979 , стр. 949–950. 471–473, 476–477

- ^ Грэм Оппи (20 января 2015 г.). «Теоремы Гёделя о неполноте» . Стэнфордская энциклопедия философии . Архивировано из оригинала 3 мая 2021 года . Проверено 27 апреля 2016 г.

Однако эти антимеханистские аргументы Геделя проблематичны, и существует широкое мнение, что они терпят неудачу.

- ^ Стюарт Дж. Рассел ; Питер Норвиг (2010). «26.1.2: Философские основы/Слабый ИИ: могут ли машины действовать разумно?/Математическое возражение». Искусственный интеллект: современный подход (3-е изд.). Река Аппер-Сэддл, Нью-Джерси: Прентис-Холл . ISBN 978-0-13-604259-4 .

...даже если мы признаем, что у компьютеров есть ограничения на то, что они могут доказать, нет никаких доказательств того, что люди застрахованы от этих ограничений.

- ^ Марк Коливан. Введение в философию математики . Cambridge University Press , 2012. Из раздела 2.2.2 «Философское значение результатов Гёделя о неполноте»: «Принято считать (с чем я согласен) что аргументы Лукаса-Пенроуза несостоятельны».

- ^ ЛаФорте, Г., Хейс, П.Дж., Форд, К.М. 1998. Почему теорема Гёделя не может опровергнуть вычислительный подход. Искусственный интеллект , 104:265-286, 1998.

- ^ Рассел и Норвиг 2003 , с. 950 Они отмечают, что реальные машины с конечной памятью можно моделировать с помощью логики высказываний , которая формально разрешима , и аргумент Гёделя к ним вообще не применим.

- ^ Хофштадтер 1979

- ↑ Согласно Hofstadter 1979 , стр. 476–477, это утверждение было впервые предложено CH Whiteley.

- ^ Хофштадтер 1979 , стр. 476–477, Рассел и Норвиг 2003 , стр. 476–477. 950, Тьюринг 1950 в разделе «Аргумент от математики», где он пишет: «Хотя установлено, что возможности любой конкретной машины имеют ограничения, было лишь заявлено, без каких-либо доказательств, что такие ограничения не применимы к человеческому интеллект».

- ^ Пенроуз 1989

- ^ Литт, Абниндер; Элиасмит, Крис; Крун, Фредерик В.; Вайнштейн, Стивен; Тагард, Пол (6 мая 2006 г.). «Является ли мозг квантовым компьютером?» . Когнитивная наука . 30 (3): 593–603. дои : 10.1207/s15516709cog0000_59 . ПМИД 21702826 .

- ^ Дрейфус 1972 , Дрейфус 1979 , Дрейфус и Дрейфус 1986 . См. также Russell & Norvig 2003 , стр. 950–952, Crevier 1993 , стр. 120–132 и Fearn 2007 , стр. 50–51.

- ^ Рассел и Норвиг 2003 , с. 950–51

- ^ Тьюринг 1950 в разделе «(8) Аргумент неформальности поведения»

- ^ Перейти обратно: а б Рассел и Норвиг 2003 , с. 52

- ^ См. Брукс 1990 и Моравец 1988.

- ^ Дэниел Канеман (2011). Мышление быстрое и медленное . Макмиллан. ISBN 978-1-4299-6935-2 . Архивировано из оригинала 15 марта 2023 года . Проверено 8 апреля 2012 г.

- ^ Кревье 1993 , с. 125

- ^ Перейти обратно: а б Тьюринг 1950 г. в разделе «(4) Аргумент от сознания». См. также Russell & Norvig 2003 , стр. 952–3, где они отождествляют аргумент Сирла с «Аргументом от сознания» Тьюринга.

- ^ Рассел и Норвиг 2003 , с. 947

- ^ Блэкмор 2005 , с. 1.

- ^ "[Люди] всегда говорят мне, что было очень сложно определить сознание, но я думаю, что если вы просто ищете определение здравого смысла, которое вы получаете в начале исследования, а не жесткое научное определение что приходит в конце, нетрудно дать здравое определение сознания». Зона философа: вопрос сознания. Архивировано 28 ноября 2007 г. в Wayback Machine . См. также Деннетт, 1991 г.

- ^ Блэкмор 2005 , с. 2

- ^ Рассел и Норвиг 2003 , с. 954–956

- ^ Например, Джон Сирл пишет: «Может ли машина думать? Ответ очевиден: да. Мы именно такие машины». ( Сирл 1980 , стр. 11)

- ^ Сирл 1980 . См. также Коул 2004 , Рассел и Норвиг 2003 , стр. 101–1. стр . 958–960, Кревье, 1993 . стр . 269–272 и Хирн 2007 , с. 43–50

- ^ Сирл 1980 , с. 13

- ^ Ошибка Searle 1984

- ^ Коул 2004 , 2.1, Лейбниц 1714 , 17

- ^ Коул 2004 , 2.3

- ^ Сирл 1980, раздел «1. Ответ систем (Беркли)», Crevier 1993 , стр. 269, Рассел и Норвиг 2003 , с. 959, Коул 2004 , 4.1. Среди тех, кто придерживается позиции «системы» (по мнению Коула), — Нед Блок, Джек Коупленд , Дэниел Деннетт , Джерри Фодор , Джон Хогеланд , Рэй Курцвейл и Жорж Рей . В число тех, кто защищает ответ «виртуального разума», входят Марвин Мински , Алан Перлис , Дэвид Чалмерс , Нед Блок и Дж. Коул (опять же, согласно Коулу, 2004 г. ).

- ^ Коул 2004 , 4.2 приписывает эту позицию Неду Блоку , Дэниелу Деннетту, Тиму Модлину , Дэвиду Чалмерсу , Стивену Пинкеру , Патрисии Черчленд и другим.

- ^ Сирл, 1980, в разделе «2. Ответ робота (Йельский университет)». Коул 2004 , 4.3 приписывает эту позицию Маргарет Боден , Тиму Крэйну , Дэниелу Деннетту, Джерри Фодору, Стевану Харнаду , Гансу Моравецу и Жоржу Рею.

- ^ Цитируется по Crevier 1993 , с. 272

- ^ Сирл 1980 в разделе «3. Ответ на симулятор мозга (Беркли и Массачусетский технологический институт)» Коул 2004 приписывает эту позицию Полу и Патрисии Черчленд и Рэю Курцвейлу.

- ^ Сирл 1980, раздел «5. Ответ других умов», Коул 2004 , 4.4. Тьюринг 1950 дает этот ответ в разделе «(4) Аргумент от сознания». Коул приписывает эту позицию Дэниелу Деннету и Гансу Моравецу.

- ^ Дрейфус 1979 , с. 156, Хаугеланд, 1985 , стр. 15–44.

- ^ Ошибка Horst 2005

- ^ Перейти обратно: а б Харнад 2001 г.

- ^ Перейти обратно: а б Цитируется по Crevier 1993 , с. 266

- ^ Кревье 1993 , с. 266

- ^ Перейти обратно: а б с Тьюринг 1950 г. в разделе «(5) Аргументы от различных нарушений».

- ^ Тьюринг 1950 в разделе «(6) Возражение леди Лавлейс»

- ^ Тьюринг 1950 в разделе «(5) Аргумент от различных нарушений»

- ^ «Каплан Андреас; Михаэль Хэнлайн». Горизонты бизнеса . 62 (1): 15–25. Январь 2019 г. doi : 10.1016/j.bushor.2018.08.004 . S2CID 158433736 .

- ^ Кац, Лесли (2 апреля 2009 г.). «Робоученый самостоятельно совершает открытие генов | Crave — vrenture.com/ . News.cnet.com. Архивировано из оригинала 12 июля 2012 года . Проверено 29 июля 2010 г.

- ^ Перейти обратно: а б Ученые опасаются, что машины могут перехитрить человека. Архивировано 1 июля 2017 г. в Wayback Machine . Автор: ДЖОН МАРКОФФ, NY Times, 26 июля 2009 г.

- ^ Грядущая технологическая сингулярность: как выжить в постчеловеческую эпоху , Вернор Виндж, факультет математических наук, Государственный университет Сан-Диего, (c) 1993, Вернор Виндж.

- ↑ Призыв к дебатам о роботах-убийцах. Архивировано 7 августа 2009 г. в Wayback Machine , Джейсон Палмер, репортер по науке и технологиям, BBC News, 3 августа 2009 г.

- ↑ Новый отчет Science, финансируемый ВМФ, предупреждает о том, что военные роботы станут «Терминаторами». Архивировано 28 июля 2009 г. в Wayback Machine , Джейсон Мик (блог), dailytech.com, 17 февраля 2009 г.

- ↑ Отчет ВМФ предупреждает о восстании роботов и предполагает сильный моральный компас. Архивировано 4 июня 2011 г. в Wayback Machine Джозефом Л. Флэтли на сайте engadget.com, 18 февраля 2009 г.

- ^ Президентская комиссия AAAI по долгосрочному исследованию будущего искусственного интеллекта на 2008-2009 гг. Архивировано 28 августа 2009 г. в Wayback Machine , Ассоциация по развитию искусственного интеллекта, по состоянию на 26 июля 2009 г.

- ^ Статья на Asimovlaws.com , июль 2004 г., по состоянию на 27 июля 2009 г. Архивировано 30 июня 2009 г. в Wayback Machine .

- ^ «Могут ли цифровые компьютеры думать?». Выступление в третьей программе BBC, 15 мая 1951 г. http://www.turingarchive.org/viewer/?id=459&title=8.

- ^ Тьюринг 1950 в разделе «(1) Богословское возражение», хотя он также пишет: «Меня не очень впечатляют богословские аргументы, какие бы они ни были использованы для поддержки»

- ^ Брэндон Спектор опубликован (13 июня 2022 г.). «ИИ Google разумен», — заявил инженер-программист перед тем, как его отстранили от работы . www.livscience.com . Архивировано из оригинала 14 июня 2022 г. Проверено 14 июня 2022 г.

- ^ Лемуан, Блейк (11 июня 2022 г.). «Разумна ли LaMDA? — Интервью» . Середина . Архивировано из оригинала 13 июня 2022 г. Проверено 14 июня 2022 г.

- ^ М.Мориока и др. (15 января 2023 г.) Искусственный интеллект, роботы и философия. Архивировано 28 декабря 2022 г. в Wayback Machine , стр. 2–4.

- ^ Дойч, Дэвид (3 октября 2012 г.). «Философия станет ключом, который откроет путь к искусственному интеллекту | Дэвид Дойч» . хранитель . Архивировано из оригинала 27 сентября 2013 г. Проверено 18 сентября 2018 г.

Цитируемые работы [ править ]

- Адам, Элисон (1989). Искусственное знание: гендер и думающая машина. Рутледж и CRC Press . ISBN 978-0-415-12963-3

- Бенджамин, Руха (2019). Гонка за технологиями: аболиционистские инструменты для нового кодекса Джима . Уайли. ISBN 978-1-509-52643-7

- Блэкмор, Сьюзен (2005), Сознание: очень краткое введение , Oxford University Press

- Бостром, Ник (2014), Суперинтеллект: пути, опасности, стратегии , Oxford University Press , ISBN 978-0-19-967811-2

- Брукс, Родни (1990), «Слоны не играют в шахматы» (PDF) , Робототехника и автономные системы , 6 (1–2): 3–15, CiteSeerX 10.1.1.588.7539 , doi : 10.1016/S0921-8890( 05)80025-9 , получено 30 августа 2007 г.

- Брайсон, Джоанна (2019). Искусственный интеллект этики искусственного интеллекта: вводный обзор законодательства и регулирования, 34.

- Чалмерс, Дэвид Дж. (1996), Сознание: в поисках фундаментальной теории , Oxford University Press, Нью-Йорк, ISBN 978-0-19-511789-9

- Коул, Дэвид (осень 2004 г.), «Аргумент о китайской комнате», в Залте, Эдвард Н. (редактор), Стэнфордская энциклопедия философии .

- Кроуфорд, Кейт (2021). Атлас искусственного интеллекта: власть, политика и планетарные издержки искусственного интеллекта . Издательство Йельского университета.

- Кревье, Дэниел (1993). ИИ: бурные поиски искусственного интеллекта . Нью-Йорк, штат Нью-Йорк: BasicBooks. ISBN 0-465-02997-3 .

- Деннетт, Дэниел (1991), Объяснение сознания , The Penguin Press, ISBN 978-0-7139-9037-9

- Дрейфус, Хьюберт (1972), Чего не могут компьютеры , Нью-Йорк: MIT Press, ISBN 978-0-06-011082-6

- Дрейфус, Хьюберт (1979), Чего компьютеры все еще не могут сделать , Нью-Йорк: MIT Press .

- Дрейфус, Юбер ; Дрейфус, Стюарт (1986), Разум над машиной: сила человеческой интуиции и опыта в эпоху компьютеров , Оксфорд, Великобритания: Блэквелл.

- Ферн, Николас (2007), Последние ответы на самые старые вопросы: философское приключение с величайшими мыслителями мира , Нью-Йорк: Grove Press

- Гладуэлл, Малкольм (2005), Блинк: Сила мышления без мышления , Бостон: Литтл, Браун, ISBN 978-0-316-17232-5 .

- Харнад, Стеван (2001), «Что плохого и правильного в аргументе Сирла о китайской комнате?», Бишоп, М.; Престон, Дж. (ред.), Очерки аргумента Сирла о китайской комнате , Oxford University Press

- Харауэй, Донна (1985). Киборгский манифест .

- Хаугеланд, Джон (1985), Искусственный интеллект: сама идея , Кембридж, Массачусетс: MIT Press .

- Хофштадтер, Дуглас (1979), Гёдель, Эшер, Бах: вечная золотая коса .

- Хорст, Стивен (2009), «Вычислительная теория разума», в Залте, Эдвард Н. (редактор), Стэнфордская энциклопедия философии , Лаборатория метафизических исследований, Стэнфордский университет .

- Каплан, Андреас ; Хэнляйн, Майкл (2018), «Сири, Сири в моей руке, кто самый справедливый на земле? Об интерпретациях, иллюстрациях и последствиях искусственного интеллекта», Business Horizons , 62 : 15–25, doi : 10.1016/j.bushor .2018.08.004 , S2CID 158433736

- Курцвейл, Рэй (2005), Сингулярность близка , Нью-Йорк: Viking Press, ISBN 978-0-670-03384-3 .

- Лукас, Джон (1961), «Разум, машины и Гёдель», в Андерсоне, Арканзас (редактор), « Разум и машины» .

- Малабу, Кэтрин (2019). Морфинг интеллекта: от измерения IQ до искусственного мозга . (К. Шред, Пер.). Издательство Колумбийского университета.

- Маккарти, Джон ; Мински, Марвин ; Рочестер, Натан ; Шеннон, Клод (1955), Предложение для Дартмутского летнего исследовательского проекта по искусственному интеллекту , заархивировано из оригинала 30 сентября 2008 г.

- Маккарти, Джон (1999), Что такое ИИ? , заархивировано из оригинала 4 декабря 2022 года , получено 4 декабря 2022 года.

- Макдермотт, Дрю (14 мая 1997 г.), «Насколько интеллектуален Deep Blue» , New York Times , заархивировано из оригинала 4 октября 2007 г. , получено 10 октября 2007 г.

- Моравец, Ганс (1988), Mind Children , издательство Гарвардского университета

- Пенроуз, Роджер (1989), Новый разум императора: о компьютерах, разуме и законах физики , Oxford University Press, ISBN 978-0-14-014534-2 с

- Рескорла, Майкл, «Вычислительная теория разума», в: Эдвард Н. Залта (редактор), Стэнфордская энциклопедия философии (выпуск осенью 2020 г.)

- Рассел, Стюарт Дж .; Норвиг, Питер (2003), Искусственный интеллект: современный подход (2-е изд.), Аппер-Сэддл-Ривер, Нью-Джерси: Прентис-Холл, ISBN 0-13-790395-2

- Сирл, Джон (1980), «Разум, мозг и программы» (PDF) , Behavioral and Brain Sciences , 3 (3): 417–457, doi : 10.1017/S0140525X00005756 , S2CID 55303721 , заархивировано из оригинала (PDF) в 2015 г. -09-23

- Сирл, Джон (1992), Новое открытие разума , Кембридж, Массачусетс: MIT Press

- Сирл, Джон (1999), Разум, язык и общество , Нью-Йорк, штат Нью-Йорк: Basic Books, ISBN 978-0-465-04521-1 , OCLC 231867665

- Тьюринг, Алан (октябрь 1950 г.), «Вычислительная техника и интеллект», Mind , LIX (236): 433–460, doi : 10.1093/mind/LIX.236.433 , ISSN 0026-4423