Генеративно-состязательная сеть

| Часть серии о |

| Машинное обучение и интеллектуальный анализ данных |

|---|

( Генеративно-состязательная сеть GAN ) — это класс фреймворков машинного обучения и известная основа для подхода к генеративному искусственному интеллекту . [1] [2] Концепция была первоначально разработана Яном Гудфеллоу и его коллегами в июне 2014 года. [3] В GAN две нейронные сети соревнуются друг с другом в форме игры с нулевой суммой , где выигрыш одного агента является проигрышем другого агента.

Учитывая обучающий набор, этот метод учится генерировать новые данные с той же статистикой, что и обучающий набор. Например, GAN, обученный на фотографиях, может создавать новые фотографии, которые выглядят, по крайней мере, на первый взгляд, аутентичными для людей-наблюдателей и имеют множество реалистичных характеристик. Хотя изначально GAN были предложены как форма генеративной модели для обучения без учителя , они также оказались полезными для обучения с полуконтролем . [4] полным обучение под контролем , [5] и обучение с подкреплением . [6]

Основная идея GAN основана на «косвенном» обучении через дискриминатор, еще одну нейронную сеть, которая может определить, насколько «реалистичным» кажется входной сигнал, который сам по себе также динамически обновляется. [7] Это означает, что генератор не обучен минимизировать расстояние до конкретного изображения, а скорее обманывает дискриминатор. Это позволяет модели обучаться без присмотра.

GAN похожи на мимикрию в эволюционной биологии с эволюционной гонкой вооружений между обеими сетями.

Определение [ править ]

Математический [ править ]

Оригинальный GAN определяется как следующая игра : [3]

Каждое вероятностное пространство определяет игру GAN.

Есть 2 игрока: генератор и дискриминатор.

генератора стратегий Набор , множество всех вероятностных мер на .

Набор стратегий дискриминатора представляет собой набор марковских ядер. , где представляет собой набор вероятностных мер на .

Игра GAN — это игра с нулевой суммой и целевой функцией.

Генератор стремится минимизировать цель, а дискриминатор стремится максимизировать цель.

Задача генератора – приблизиться , то есть максимально точно согласовать собственное выходное распределение с эталонным распределением. Задача дискриминатора — вывести значение, близкое к 1, когда входные данные кажутся полученными из эталонного распределения, и вывести значение, близкое к 0, когда входные данные выглядят так, как будто они получены из генераторного распределения.

На практике [ править ]

Генеративная дискриминативная сеть генерирует кандидатов, а сеть их оценивает. [3] Конкурс работает с точки зрения распределения данных. Обычно генеративная сеть учится отображать скрытое пространство на интересующее распределение данных, в то время как дискриминативная сеть отличает кандидатов, созданных генератором, от истинного распределения данных. Целью обучения генеративной сети является увеличение частоты ошибок дискриминационной сети (т. е. «обмануть» дискриминаторную сеть, создав новых кандидатов, которые, по мнению дискриминатора, не синтезируются (являются частью истинного распределения данных)). [3] [8]

Известный набор данных служит исходными данными для обучения дискриминатора. Обучение предполагает предоставление ему выборок из набора обучающих данных до тех пор, пока он не достигнет приемлемой точности. Генератор обучается на основе того, удалось ли ему обмануть дискриминатор. Обычно генератор заполняется рандомизированными входными данными, которые выбираются из заранее определенного скрытого пространства (например, многомерного нормального распределения ). После этого кандидаты, синтезированные генератором, оцениваются дискриминатором. независимые процедуры обратного распространения ошибки , так что генератор производит более качественные выборки, а дискриминатор становится более опытным в маркировке синтетических выборок. К обеим сетям применяются [9] При использовании для генерации изображений генератор обычно представляет собой деконволюционную нейронную сеть , а дискриминатор — сверточную нейронную сеть .

машинного обучения с другими статистическими Связь методами

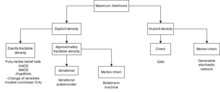

GAN — это неявные генеративные модели , [10] это означает, что они не моделируют явно функцию правдоподобия и не предоставляют средств для поиска скрытой переменной, соответствующей данной выборке, в отличие от таких альтернатив, как генеративная модель на основе потоков .

По сравнению с полностью видимыми сетями убеждений, такими как WaveNet и PixelRNN, и авторегрессионными моделями в целом, GAN могут генерировать одну полную выборку за один проход, а не за несколько проходов через сеть.

По сравнению с машинами Больцмана и линейным ICA здесь нет ограничений на тип функций, используемых сетью.

Поскольку нейронные сети являются универсальными аппроксиматорами , GAN асимптотически непротиворечивы . Вариационные автоэнкодеры могут быть универсальными аппроксиматорами, но по состоянию на 2017 год это не доказано. [11]

Математические свойства [ править ]

теории Соображения меры

В этом разделе представлены некоторые математические теории, лежащие в основе этих методов.

В современной теории вероятностей, основанной на теории меры , вероятностное пространство также должно быть оснащено σ-алгеброй . В результате более строгое определение игры GAN внесло бы следующие изменения:

Каждое вероятностное пространство определяет игру GAN.

Набор стратегий генератора , множество всех вероятностных мер на пространстве меры .

Набор стратегий дискриминатора представляет собой набор марковских ядер. , где является борелевской σ-алгеброй на .

Поскольку вопросы измеримости на практике никогда не возникают, они нас больше не будут касаться.

Выбор набора стратегий [ править ]

В наиболее общей версии игры GAN, описанной выше, набор стратегий для дискриминатора содержит все марковские ядра. , а набор стратегий генератора содержит произвольные распределения вероятностей на .

Однако, как показано ниже, оптимальная стратегия дискриминатора против любого является детерминированным, поэтому нет потери общности при ограничении стратегий дискриминатора детерминированными функциями. . В большинстве приложений — это функция глубокой нейронной сети .

Что касается генератора, то теоретически это может быть любое вычислимое распределение вероятностей, на практике оно обычно реализуется как упреждающее : . То есть начнем со случайной величины , где — это распределение вероятностей, которое легко вычислить (например, равномерное распределение или распределение Гаусса ), а затем определить функцию . Тогда распределение это распределение .

Следовательно, стратегия генератора обычно определяется как , уход скрытый. В этом формализме цель игры GAN такова:

Генеративная репараметризация [ править ]

Архитектура GAN состоит из двух основных компонентов. Один из них — это внедрение оптимизации в игру в форме , отличающийся от обычного вида оптимизации, вида . Другое дело – разложение в , что можно понимать как трюк с перепараметризацией.

Чтобы понять его значение, необходимо сравнить GAN с предыдущими методами обучения генеративных моделей, которые страдали от «неразрешимых вероятностных вычислений, возникающих при оценке максимального правдоподобия и связанных с ними стратегиях». [3]

В то же время Кингма и Веллинг [12] и Резенде и др. [13] разработал ту же идею репараметризации в общий метод стохастического обратного распространения ошибки. Среди его первых применений был вариационный автоэнкодер .

перемещения и стратегическое равновесие Порядок

В исходной статье, как и в большинстве последующих статей, обычно предполагается, что генератор движется первым , а дискриминатор движется вторым , что дает следующую минимаксную игру:

Если множества стратегий генератора и дискриминатора охватываются конечным числом стратегий, то по теореме о минимаксе

Однако, поскольку оба множества стратегий не являются конечно ограниченными, теорема о минимаксе неприменима, и идея «равновесия» становится деликатной. А именно, существуют следующие различные концепции равновесия:

- Равновесие, когда генератор движется первым, а дискриминатор движется вторым:

- Равновесие, когда дискриминатор движется первым, а генератор движется вторым:

- Равновесие Нэша , который стабилен при одновременном порядке перемещения:

В обычных играх эти равновесия не обязательно должны совпадать или даже существовать. В оригинальной игре GAN все эти равновесия существуют и все равны. Однако для более общих игр GAN они не обязательно существуют или согласуются друг с другом. [14]

игры GAN теоремы Основные

В оригинальной статье GAN были доказаны следующие две теоремы: [3]

Теорема (оптимальный дискриминатор вычисляет расхождение Дженсена – Шеннона) — Для любой стратегии фиксированного генератора , пусть оптимальным ответом будет , затем

где производная – производная Радона–Никодима , а – расхождение Дженсена–Шеннона .

По неравенству Йенсена

Чтобы определить подходящие функции плотности, мы определяем базовую меру , что позволяет взять производные Радона–Никодима

Тогда у нас есть

Подынтегральная функция — это просто отрицательная перекрестная энтропия между двумя случайными величинами Бернулли с параметрами и . Мы можем написать это как , где — это функция двоичной энтропии , поэтому

Это означает, что оптимальная стратегия дискриминатора равна , с

после рутинного расчета.

Интерпретация : Для любой стратегии фиксированного генератора. , оптимальный дискриминатор отслеживает отношение правдоподобия между эталонным распределением и распределением генератора:

Теорема (единственная точка равновесия). Для любой игры GAN существует пара это одновременно и последовательное равновесие, и равновесие Нэша:

То есть генератор идеально имитирует эталон, а дискриминатор выдает детерминированно на всех входах.

Из предыдущего предложения,

Для любой стратегии фиксированного дискриминатора , любой сосредоточился на съемочной площадке

Согласно неравенству Йенсена, дискриминатор может улучшиться, только приняв детерминированную стратегию постоянной игры. . Поэтому,

По неравенству Йенсена

с равенством, если , так

Наконец, чтобы проверить, что это равновесие по Нэшу, заметим, что когда , у нас есть

Когда , любая стратегия оптимальна для генератора.

и GAN оценка Обучение

Обучение [ править ]

конвергенция Нестабильная

Хотя игра GAN имеет уникальную глобальную точку равновесия, когда и генератор, и дискриминатор имеют доступ ко всем своим наборам стратегий, равновесие больше не гарантируется, когда у них есть ограниченный набор стратегий. [14]

На практике генератор имеет доступ только к мерам формы , где это функция, вычисляемая нейронной сетью с параметрами , и представляет собой легко выбираемое распределение, такое как равномерное или нормальное распределение. Аналогично, дискриминатор имеет доступ только к функциям вида , функция, вычисляемая нейронной сетью с параметрами . Эти ограниченные наборы стратегий занимают исчезающе малую долю от общего набора стратегий. [15]

Более того, даже если равновесие все еще существует, его можно найти только путем поиска в многомерном пространстве всех возможных функций нейронной сети. Стандартная стратегия использования градиентного спуска для поиска равновесия часто не работает для GAN, и зачастую игра «схлопывается» в один из нескольких режимов сбоя. Чтобы улучшить стабильность сходимости, некоторые стратегии обучения начинаются с более простой задачи, например создания изображений с низким разрешением. [16] или простые изображения (один объект с однородным фоном), [17] и постепенно увеличивайте сложность задания в ходе тренировки. По сути, это означает применение схемы обучения по учебной программе. [18]

Свернуть режим [ править ]

GAN часто страдают от коллапса режимов , когда они не могут должным образом обобщить, пропуская целые режимы из входных данных. Например, GAN, обученный на наборе данных MNIST , содержащем множество образцов каждой цифры, может генерировать только изображения цифры 0. Это было названо «сценарием Helvetica». [3]

Одна из причин, по которой это может произойти, — если генератор учится слишком быстро по сравнению с дискриминатором. Если дискриминатор остается постоянным, то оптимальный генератор будет выводить только элементы . [19] Так, например, если во время обучения GAN для генерации набора данных MNIST в течение нескольких эпох дискриминатор почему-то предпочитает цифру 0 немного больше, чем другие цифры, генератор может воспользоваться возможностью сгенерировать только цифру 0, а затем не сможет избежать локального минимум после улучшения дискриминатора.

Некоторые исследователи считают, что корень проблемы заключается в слабой дискриминационной сети, которая не замечает закономерностей упущений, в то время как другие возлагают вину на неправильный выбор целевой функции . Было предложено множество решений, но это все еще открытая проблема. [20] [21]

Даже самая современная архитектура BigGAN (2019) не смогла избежать коллапса режимов. Авторы прибегли к «допущению коллапса на более поздних этапах обучения, когда модель уже достаточно обучена для достижения хороших результатов». [22]

Правило обновления двух временных рамок [ править ]

Правило обновления двух временных масштабов (TTUR) предлагается для того, чтобы сделать сходимость GAN более стабильной, делая скорость обучения генератора ниже, чем скорость обучения дискриминатора. Авторы утверждали, что генератор должен двигаться медленнее, чем дискриминатор, чтобы он «не постоянно направлял дискриминатор в новые области, не перехватывая собранную им информацию».

Они доказали, что общий класс игр, включающий игру GAN, при обучении под TTUR «сходится при мягких предположениях к стационарному локальному равновесию Нэша». [23]

Они также предложили использовать стохастическую оптимизацию Адама. [24] во избежание коллапса режима, а также начальное расстояние Фреше для оценки характеристик GAN.

Исчезающий градиент [ править ]

И наоборот, если дискриминатор обучается слишком быстро по сравнению с генератором, то дискриминатор может почти идеально различать . В таком случае генератор может понести очень большие потери независимо от того, в каком направлении он меняет свое направление. , что означает, что градиент было бы близко к нулю. В таком случае генератор не может обучаться, что является случаем исчезающего градиента проблемы . [15]

Интуитивно говоря, дискриминатор слишком хорош, и поскольку генератор не может сделать ни одного маленького шага (при градиентном спуске учитываются только маленькие шаги) для улучшения своего выигрыша, он даже не пытается.

Одним из важных методов решения этой проблемы является GAN Вассерштейна .

Оценка [ править ]

GAN обычно оцениваются по начальному показателю (IS), который измеряет, насколько различаются выходные данные генератора (по классификации классификатора изображений, обычно Inception-v3 ), или по начальному расстоянию Фреше (FID), которое измеряет, насколько выходные данные генератора похожи на эталонный набор (классифицированный специалистом по изучению изображений, например Inception-v3, без его последнего слоя). Многие статьи, предлагающие новые архитектуры GAN для генерации изображений, сообщают, как их архитектуры ломают современное состояние FID или IS.

Другой метод оценки - это подобие изученных перцептивных изображений (LPIPS), который начинается с средства определения характеристик изученных изображений. и настраивает его путем контролируемого обучения на наборе , где это изображение, это его искаженная версия, и насколько они различаются, по сообщениям людей. Модель настроена таким образом, что она может приближаться к . Эта точно настроенная модель затем используется для определения . [25]

Другие методы оценки рассматриваются в . [26]

Варианты [ править ]

Существует настоящий зоопарк вариантов GAN. [27] Некоторые из наиболее известных из них следующие:

Условный GAN [ править ]

Условные GAN аналогичны стандартным GAN, за исключением того, что они позволяют модели условно генерировать выборки на основе дополнительной информации. Например, если мы хотим сгенерировать морду кошки по изображению собаки, мы можем использовать условный GAN.

Генератор в игре GAN генерирует , распределение вероятностей в вероятностном пространстве . Это приводит к идее условной GAN, в которой вместо генерации одного распределения вероятностей на , генератор генерирует другое распределение вероятностей на , для каждой метки класса .

Например, для создания изображений, которые выглядят как ImageNet , генератор должен иметь возможность генерировать изображение кошки, если ему присвоена метка класса «cat».

В оригинальной статье [3] авторы отметили, что GAN можно тривиально расширить до условного GAN, предоставив метки как генератору, так и дискриминатору.

Конкретно, условная игра GAN — это просто игра GAN с предоставленными метками классов:

В 2017 году условный GAN научился генерировать 1000 классов изображений ImageNet . [28]

с альтернативной архитектурой GAN

Игра GAN представляет собой общую структуру и может быть запущена с любой разумной параметризацией генератора. и дискриминатор . В оригинальной статье авторы продемонстрировали это с помощью многослойных перцептронных сетей и сверточных нейронных сетей . Было опробовано множество альтернативных архитектур.

Глубокий сверточный GAN (DCGAN): [29] И для генератора, и для дискриминатора используются только глубокие сети, полностью состоящие из слоев свертки-деконволюции, то есть полностью сверточные сети. [30]

Самовнимание ГАН (САГАН): [31] Начинается с DCGAN, затем добавляются стандартные модули самообслуживания к генератору и дискриминатору с остаточным соединением.

Вариационный автоэнкодер GAN (VAEGAN): [32] используется вариационный автоэнкодер Для генератора (VAE).

Трансформатор ГАН (ТрансГАН): [33] Использует чистую архитектуру трансформатора как для генератора, так и для дискриминатора, полностью лишенную слоев свертки-деконволюции.

Поток-ГАН: [34] Использует генеративную модель на основе потока для генератора, что позволяет эффективно вычислять функцию правдоподобия.

с альтернативными целями ГАНы

Многие варианты GAN получаются просто путем изменения функций потерь для генератора и дискриминатора.

Оригинальный ГАН:

Переделаем исходную цель GAN в более удобную для сравнения форму:

Исходный GAN, ненасыщающие потери:

Эта цель для генератора была рекомендована в исходной статье для более быстрой сходимости. [3]

Исходный ГАН, максимальная вероятность:

потеря шарнира ТОЛЬКО : [38]

Вассерштейн BY (WGAN) [ править ]

GAN Вассерштейна модифицирует игру GAN в двух моментах:

- Множество стратегий дискриминатора представляет собой множество измеримых функций типа с ограниченной липшицевой нормой : , где — фиксированная положительная константа.

- Целью является

Одна из его целей — решить проблему коллапса мод (см. выше). [15] Авторы заявляют: «Ни в одном эксперименте мы не увидели свидетельств коллапса режима алгоритма WGAN».

GAN с более чем двумя игроками [ править ]

Состязательный автоэнкодер [ править ]

Состязательный автокодировщик (AAE) [40] является более автоэнкодером, чем GAN. Идея состоит в том, чтобы начать с простого автоэнкодера , но обучить дискриминатор отличать скрытые векторы от эталонного распределения (часто нормального распределения).

ИнфоГАН [ править ]

В условном GAN генератор получает как вектор шума, так и вектор шума. и этикетка и создает изображение . Дискриминатор получает пары изображение-метка. и вычисляет .

Когда набор обучающих данных не помечен, условный GAN не работает напрямую.

Идея InfoGAN состоит в том, чтобы объявить, что каждый скрытый вектор в скрытом пространстве можно разложить на : несжимаемая шумовая часть и информативная часть этикетки , и призвать производителя соблюдать постановление, поощряя его максимизировать , взаимная информация между и , не предъявляя при этом требований к взаимной информации между .

К сожалению, в целом трудноразрешима. Ключевая идея InfoGAN — это вариационная взаимная максимизация информации: [41] косвенно максимизировать его, максимизируя нижнюю границу

Игра InfoGAN определяется следующим образом: [42]

Три вероятностных пространства определяют игру InfoGAN:

- , пространство эталонных изображений.

- , фиксированный генератор случайного шума.

- , фиксированный генератор случайной информации.

В двух командах участвуют 3 игрока: генератор, Q и дискриминатор. Генератор и Q находятся в одной команде, а дискриминатор — в другой.

Целевая функция

где это исходная цель игры GAN, иКоманда Generator-Q стремится минимизировать цель, а дискриминатор — максимизировать ее:

Двунаправленная ГАН (BiGAN) [ править ]

Стандартный генератор GAN представляет собой функцию типа , то есть это отображение из скрытого пространства в пространство изображения . Это можно понимать как процесс «декодирования», при котором каждый скрытый вектор это код изображения , и генератор выполняет декодирование. Это естественным образом приводит к идее обучения другой сети, выполняющей «кодирование», создания автоэнкодера из пары кодер-генератор.

Уже в оригинальной статье [3] авторы отметили, что «обученный приблизительный вывод может быть выполнен путем обучения вспомогательной сети для прогнозирования данный «. Двунаправленная архитектура GAN выполняет именно это. [43]

BiGAN определяется следующим образом:

Два вероятностных пространства определяют игру BiGAN:

- , пространство эталонных изображений.

- , скрытое пространство.

В двух командах участвуют 3 игрока: генератор, кодировщик и дискриминатор. Генератор и кодер находятся в одной команде, а дискриминатор — в другой.

Стратегии генератора — это функции , а стратегии кодировщика — это функции . Стратегии дискриминатора — это функции .

Целевая функция

Команда генератор-кодировщик стремится минимизировать цель, а дискриминатор — максимизировать ее:

В статье они дали более абстрактное определение цели:

Приложения двунаправленных моделей включают полуконтролируемое обучение , [44] интерпретируемое машинное обучение , [45] и нейронный машинный перевод . [46]

ЦиклГАН [ править ]

CycleGAN — это архитектура для выполнения преобразований между двумя доменами, например, между фотографиями лошадей и фотографиями зебр или фотографиями ночных городов и фотографиями дневных городов.

Игра CycleGAN определяется следующим образом: [47]

Есть два вероятностных пространства , соответствующий двум доменам, необходимым для прямого и обратного перевода.

В 2 командах по 4 игрока: генераторы. и дискриминаторы .

Целевая функция

где – положительный регулируемый параметр, цель игры GAN, и цикла потеря согласованности :

Генераторы стремятся минимизировать цель, а дискриминаторы — максимизировать ее:

В отличие от предыдущих работ, таких как pix2pix, [48] для которого требуются парные обучающие данные, для CyclGAN парные данные не требуются. Например, чтобы обучить модель pix2pix превращать фотографию летнего пейзажа в фотографию зимнего пейзажа и обратно, набор данных должен содержать пары одних и тех же мест летом и зимой, снятых под одним и тем же углом; CycleGAN понадобится только набор фотографий летних пейзажей и несвязанный набор фотографий зимних пейзажей.

больших или масштабов ГАН особенно малых

БигГАН [ править ]

BigGAN, по сути, представляет собой GAN с самообслуживанием, обученную в больших масштабах (до 80 миллионов параметров) для создания больших изображений ImageNet (разрешение до 512 x 512) с многочисленными инженерными уловками для их сходимости. [22] [49]

данных Обратимое увеличение

Когда данных для обучения недостаточно, эталонное распределение не может быть хорошо аппроксимирован эмпирическим распределением, заданным набором обучающих данных. В таких случаях увеличение данных можно применить , чтобы обеспечить обучение GAN на меньших наборах данных. Однако наивное увеличение данных приносит свои проблемы.

Рассмотрим оригинальную игру GAN, слегка переформулированную следующим образом:

Результатом такого обучения будет генератор, имитирующий . Например, он будет генерировать изображения, которые выглядят так, как будто они случайно обрезаны, если при дополнении данных используется случайное кадрирование.

Решение состоит в том, чтобы применить увеличение данных как к сгенерированным, так и к реальным изображениям:

В документе StyleGAN-2-ADA указывается еще на один момент увеличения данных: оно должно быть обратимым . [51] Продолжим пример создания изображений ImageNet. Если увеличение данных заключается в «произвольном повороте изображения на 0, 90, 180, 270 градусов с равной вероятностью», то генератор не сможет узнать, какая ориентация является истинной: рассмотрим два генератора. , такой, что для любого скрытого , сгенерированное изображение представляет собой поворот на 90 градусов . У них будут совершенно одинаковые ожидаемые потери, и поэтому ни один из них не является предпочтительным перед другим.

Решение состоит в том, чтобы использовать только обратимое увеличение данных: вместо «произвольно повернуть изображение на 0, 90, 180, 270 градусов с равной вероятностью» использовать «случайно повернуть изображение на 90, 180, 270 градусов с вероятностью 0,1 и оставить картина такая, какая она есть с вероятностью 0,7". Таким образом, генератор по-прежнему получает вознаграждение за то, что изображения ориентированы так же, как и нерасширенные изображения ImageNet.

Абстрактно, эффект преобразований случайной выборки из распределения заключается в определении ядра Маркова . Затем игра GAN, дополненная данными, заставляет генератор найти некоторые , такой, что

Есть два прототипных примера обратимых ядер Маркова:

Дискретный случай : Обратимые стохастические матрицы , когда конечно.

Например, если представляет собой набор из четырех изображений стрелки, указывающей в 4 направлениях, а увеличение данных происходит «случайным поворотом изображения на 90, 180, 270 градусов с вероятностью , и оставьте картинку такой, какая она есть с вероятностью ", то марковское ядро можно представить в виде стохастической матрицы:

Непрерывный случай : ядро Гаусса, когда для некоторых .

Например, если — это пространство изображений размером 256x256, а метод увеличения данных — «генерировать гауссов шум , затем добавьте к изображению", затем это просто свертка с помощью функции плотности . Это обратимо, поскольку свертка по гауссу — это всего лишь свертка по тепловому ядру , поэтому при любом свернутое распределение можно получить путем нагревания точно согласно , тогда подожди время . Благодаря этому мы можем восстановить прогоняя уравнение теплопроводности назад во времени для .

Дополнительные примеры обратимого увеличения данных можно найти в статье. [51]

сломанный [ править ]

SinGAN доводит увеличение данных до предела, используя только одно изображение в качестве обучающих данных и выполняя на нем увеличение данных. Архитектура GAN адаптирована к этому методу обучения с помощью многомасштабного конвейера.

Генератор раскладывается на пирамиду образующих , причем самый низкий генерирует изображение с наименьшим разрешением, затем сгенерированное изображение масштабируется до и передается на следующий уровень для создания изображения в более высоком разрешении и так далее. Дискриминатор также разбивается на пирамиду. [52]

Серия StyleGAN [ править ]

Семейство StyleGAN — это серия архитектур, опубликованная Nvidia исследовательским подразделением .

Прогрессивный ГАН [ править ]

Прогрессивный ГАН [16] - это метод обучения GAN для стабильной генерации крупномасштабных изображений путем увеличения генератора GAN от малого до большого масштаба по пирамидальной схеме. Как и SinGAN, он разлагает генератор на , а дискриминатор как .

Во время обучения сначала только используются в игре GAN для создания изображений 4х4. Затем добавляются для достижения второго этапа игры GAN, для генерации изображений 8x8 и так далее, пока мы не достигнем игры GAN для генерации изображений 1024x1024.

Чтобы избежать шока между этапами игры GAN, каждый новый слой «смешивается» (рис. 2 статьи). [16] ). Например, вот как начинается игра GAN второго этапа:

- Непосредственно перед этим игра GAN состоит из пары создание и распознавание изображений 4х4.

- Сразу после этого игра GAN состоит из пары создание и распознавание изображений размером 8х8. Здесь функции — это функции повышения и понижения разрешения изображения, и — это коэффициент смешивания (во многом похожий на альфу при составлении изображений), который плавно меняется от 0 до 1.

StyleGAN-1 [ править ]

StyleGAN-1 спроектирован как комбинация Progressive GAN с нейронной передачей стилей . [53]

Ключевым архитектурным выбором StyleGAN-1 является механизм прогрессивного роста, аналогичный Progressive GAN. Каждое сгенерированное изображение начинается как константа массив и неоднократно проходил через блоки стилей. Каждый блок стиля применяет «скрытый вектор стиля» посредством аффинного преобразования («адаптивная нормализация экземпляра»), аналогично тому, как нейронная передача стиля использует матрицу Грамиана . Затем он добавляет шум и нормализует (вычитает среднее значение, затем делит на дисперсию).

Во время обучения обычно для каждого сгенерированного изображения используется только один скрытый вектор стиля, но иногда и два («регуляризация смешивания»), чтобы стимулировать каждый блок стиля независимо выполнять свою стилизацию, не ожидая помощи от других блоков стиля (поскольку они могут получить скрытый вектор совершенно другого стиля).

После обучения в каждый блок стиля можно ввести несколько скрытых векторов стиля. Те, которые подаются на нижние уровни, управляют крупномасштабными стилями, а те, которые подаются на более высокие уровни, управляют стилями с мелкими деталями.

Смешение стилей между двумя изображениями также можно выполнить. Сначала запустите градиентный спуск, чтобы найти такой, что . Это называется «проецированием изображения обратно в скрытое пространство стиля». Затем, может быть передан в блоки нижнего стиля, и к блокам более высокого стиля, чтобы создать составное изображение, имеющее крупномасштабный стиль и стиль, детализированный . Таким же образом можно составить несколько изображений.

СтильГАН-2 [ править ]

StyleGAN-2 является усовершенствованием StyleGAN-1, используя вместо этого скрытый вектор стиля для преобразования весов слоя свертки, тем самым решая проблему «капли». [54]

Он был обновлен StyleGAN-2-ADA («ADA» означает «адаптивный»), [51] который использует обратимое увеличение данных, как описано выше. Он также настраивает объем применяемого увеличения данных, начиная с нуля и постепенно увеличивая его до тех пор, пока «эвристика переоснащения» не достигнет целевого уровня, отсюда и название «адаптивный».

СтильГАН-3 [ править ]

СтильГАН-3 [55] Улучшение StyleGAN-2 за счет решения проблемы «прилипания текстур», которую можно увидеть в официальных видеороликах. [56] Они проанализировали проблему с помощью теоремы выборки Найквиста-Шеннона и заявили, что слои генератора научились использовать высокочастотный сигнал в пикселях, с которыми они работают.

Чтобы решить эту проблему, они предложили установить строгие фильтры нижних частот между слоями каждого генератора, чтобы генератор был вынужден работать с пикселями точно так же, как непрерывные сигналы, которые они представляют, а не работать с ними как с просто дискретными сигналами. Они дополнительно обеспечили вращательную и трансляционную инвариантность, используя больше фильтров сигналов . Получившийся StyleGAN-3 способен решить проблему прилипания текстур, а также генерировать изображения, которые плавно вращаются и перемещаются.

Приложения [ править ]

Приложения GAN быстро развиваются. [57]

Мода, искусство и реклама [ править ]

GAN можно использовать для создания произведений искусства; В марте 2019 года издание The Verge написало: «Изображения, созданные с помощью GAN, стали определяющим обликом современного искусства искусственного интеллекта». [58] GAN также можно использовать для раскрашивания фотографий. [59] или создавайте фотографии воображаемых манекенщиц, без необходимости нанимать модель, фотографа или визажиста или платить за студию и транспорт. [60] GAN также использовались для генерации виртуальных теней. [61]

Интерактивные медиа [ править ]

В 2020 году Artbreeder использовался для создания главного антагониста в продолжении психологического веб-хоррора « Бен утонул» . Позже автор хвалил приложения GAN за их способность создавать ресурсы для независимых артистов, испытывающих недостаток бюджета и рабочей силы. [62] [63]

Наука [ править ]

GAN могут улучшить астрономические изображения [64] и моделировать гравитационное линзирование для исследования темной материи. [65] [66] [67] Они использовались в 2019 году для успешного моделирования распределения темной материи в определенном направлении в космосе и для прогнозирования гравитационного линзирования, которое произойдет. [68] [69]

GAN были предложены как быстрый и точный способ моделирования формирования струи высокой энергии. [70] и моделирование ливней с помощью калориметров экспериментов по физике высоких энергий . [71] [72] [73] [74] GAN также обучены точно аппроксимировать узкие места в дорогостоящем с точки зрения вычислений моделировании экспериментов по физике элементарных частиц. Применение в контексте нынешних и предлагаемых экспериментов ЦЕРН продемонстрировало потенциал этих методов для ускорения моделирования и/или повышения точности моделирования. [75] [76]

Видеоигры [ править ]

В 2018 году GAN достигли сообщества моддеров видеоигр как метод масштабирования 2D-текстур низкого разрешения в старых видеоиграх путем воссоздания их в разрешении 4K или выше посредством обучения изображений, а затем понижения их дискретизации, чтобы они соответствовали исходному коду игры. разрешение (с результатами, напоминающими ) метод сглаживания суперсэмплинга . [77] При правильном обучении GAN обеспечивают более четкое и резкое изображение 2D-текстуры, качество которого выше, чем у оригинала, при этом полностью сохраняя исходный уровень детализации, цветов и т. д. Известные примеры широкого использования GAN включают Final Fantasy VIII , Final Fantasy IX , Resident. Evil REmake HD Remaster и Max Payne . [ нужна ссылка ]

Синтез звука [ править ]

Генеративное аудио относится к созданию аудиофайлов из баз данных аудиоклипов . [ нужна ссылка ] Эта технология отличается от синтезированных голосов , таких как Siri от Amazon от Apple или Alexa , которые используют набор фрагментов, которые сшиваются вместе по требованию.

Опасения по поводу вредоносных приложений [ править ]

Высказывались опасения по поводу потенциального использования синтеза изображений человека на основе GAN в зловещих целях, например, для создания поддельных, возможно, компрометирующих фотографий и видео. [79] GAN можно использовать для создания уникальных, реалистичных фотографий профилей несуществующих людей, чтобы автоматизировать создание фейковых профилей в социальных сетях. [80]

В 2019 году штат Калифорния считал [81] и принятый 3 октября 2019 года законопроект AB-602 , который запрещает использование технологий синтеза изображений человека для изготовления фейковой порнографии без согласия изображенных людей, и законопроект AB-730 , который запрещает распространение манипулируемых видеороликов политического характера. кандидата в течение 60 дней после выборов. Оба законопроекта были написаны членом Ассамблеи Марком Берманом и подписаны губернатором Гэвином Ньюсомом . Законы вступили в силу в 2020 году. [82]

Программа DARPA Media Forensics изучает способы противодействия фейковым СМИ, в том числе фейковым СМИ, созданным с использованием GAN. [83]

Трансферное обучение [ править ]

Современные исследования в области трансферного обучения используют GAN для обеспечения выравнивания пространства скрытых функций, например, при глубоком обучении с подкреплением. [84] Это работает путем передачи вложений исходной и целевой задачи дискриминатору, который пытается угадать контекст. Результирующие потери затем (обратно) распространяются через кодер.

Разные приложения [ править ]

GAN можно использовать для обнаружения изображений глаукомы, что помогает в ранней диагностике, что важно для предотвращения частичной или полной потери изображения.видения. [85]

GAN, создающие фотореалистичные изображения, можно использовать для визуализации дизайна интерьера , промышленного дизайна , обуви, [86] сумки и предметы одежды или предметы для компьютерных игр . сцен [ нужна ссылка ] Сообщается, что такие сети используются Facebook . [87]

GAN использовались для создания судебно-медицинских реконструкций лиц умерших исторических деятелей. [88]

GAN могут реконструировать 3D-модели объектов по изображениям . [89] генерировать новые объекты в виде 3D-облаков точек, [90] и моделировать модели движения в видео. [91]

GAN можно использовать для определения возраста фотографий лица, чтобы показать, как внешний вид человека может измениться с возрастом. [92]

GAN также можно использовать для добавления недостающих объектов на карты, переноса стилей карт в картографию. [93] или дополните изображения просмотра улиц. [94]

Соответствующая обратная связь по GAN может использоваться для создания изображений и замены систем поиска изображений. [95]

Разновидность GAN используется при обучении сети для генерации оптимальных управляющих входных данных для нелинейных динамических систем . Дискриминационная сеть известна как критик, проверяющий оптимальность решения, а генеративная сеть известна как адаптивная сеть, которая генерирует оптимальное управление. Критик и адаптивная сеть обучают друг друга аппроксимации нелинейного оптимального управления. [96]

GAN использовались для визуализации влияния изменения климата на конкретные дома. [97]

Модель GAN под названием Speech2Face может реконструировать изображение лица человека после прослушивания его голоса. [98]

В 2016 году GAN были использованы для создания новых молекул для различных белков-мишеней, участвующих в развитии рака, воспаления и фиброза. В 2019 году молекулы, созданные с помощью GAN, были экспериментально проверены на мышах. [99] [100]

Хотя большинство приложений GAN предназначены для обработки изображений, работа также ведется с данными временных рядов. Например, повторяющиеся GAN (R-GAN) использовались для генерации данных об энергии для машинного обучения. [101]

История [ править ]

В 1991 году Юрген Шмидхубер опубликовал генеративные и состязательные нейронные сети , которые соревнуются друг с другом в форме игры с нулевой суммой , где выигрыш одной сети является проигрышем другой сети. [102] [103] [104] Первая сеть представляет собой генеративную модель со стохастичностью , которая моделирует распределение вероятностей по шаблонам выходных данных. Вторая сеть учится с помощью градиентного спуска предсказывать реакцию окружающей среды на эти закономерности. Это называлось «искусственным любопытством». Для современных ГАН (2014 г.) [3] реакция окружающей среды равна 1 или 0 в зависимости от того, входит ли выход первой сети в данный набор. [104]

У других людей были схожие идеи, но они не развивались аналогичным образом. Идея использования состязательных сетей была опубликована в блоге Олли Ниемитало в 2010 году. [105] Эта идея так и не была реализована, не включала стохастичность в генераторе и, следовательно, не была генеративной моделью. Теперь он известен как условный GAN или cGAN. [106] Идея, похожая на GAN, была использована для моделирования поведения животных Ли, Гаучи и Гроссом в 2013 году. [107]

Еще одним источником вдохновения для GAN стала оценка контрастности шума. [108] который использует ту же функцию потерь, что и GAN, и который Гудфеллоу изучал во время своей докторской диссертации в 2010–2014 годах.

Состязательное машинное обучение имеет и другие применения, помимо генеративного моделирования, и может применяться к моделям, отличным от нейронных сетей. В теории управления состязательное обучение на основе нейронных сетей использовалось в 2006 году для обучения надежных контроллеров в теоретико-игровом смысле путем чередования итераций между политикой минимизации (контроллер) и политикой максимизации (возмущение). [109] [110]

В 2017 году GAN использовался для улучшения изображения с упором на реалистичные текстуры, а не на точность пикселей, обеспечивая более высокое качество изображения при большом увеличении. [111] В 2017 году появились первые лица. [112] Они были выставлены в феврале 2018 года в Гран-Пале. [113] [114] Лица, созданные StyleGAN [115] в 2019 году провели сравнения с Deepfakes . [116] [117] [118]

Начиная с 2017 года технология GAN начала заявлять о своем присутствии на арене изобразительного искусства с появлением недавно разработанной реализации, которая, как утверждается, преодолела порог возможности создания уникальных и привлекательных абстрактных картин и, таким образом, получила название «CAN». ", для "творческой состязательной сети". [119] Система GAN использовалась для создания картины «Эдмон де Белами» 2018 года , которая была продана за 432 500 долларов США. [120] В статье, опубликованной в начале 2019 года членами первоначальной команды CAN, обсуждался дальнейший прогресс в этой системе, а также рассматривались общие перспективы искусства с поддержкой ИИ. [121]

В мае 2019 года исследователи из Samsung продемонстрировали систему на базе GAN, которая создает видео говорящего человека, имея только одну фотографию этого человека. [122]

В августе 2019 года был создан большой набор данных, состоящий из 12 197 MIDI-песен, каждая из которых имеет парные тексты и выравнивание мелодий, для нейронной генерации мелодий из текстов с использованием условного GAN-LSTM (см. источники на GitHub AI Melody Generation from Lyrics ). [123]

В мае 2020 года исследователи Nvidia научили систему искусственного интеллекта (названную «GameGAN») воссоздавать игру Pac-Man, просто наблюдая за ее игрой. [124] [125]

Ссылки [ править ]

- ^ «Генераторный ИИ и будущее» . 15 ноября 2022 г.

- ^ «CSDL | Компьютерное общество IEEE» .

- ↑ Перейти обратно: Перейти обратно: а б с д и ж г час я дж к Гудфеллоу, Ян; Пуже-Абади, Жан; Мирза, Мехди; Сюй, Бин; Вард-Фарли, Дэвид; Озаир, Шерджил; Курвиль, Аарон; Бенджио, Йошуа (2014). Генеративно-состязательные сети (PDF) . Материалы Международной конференции по нейронным системам обработки информации (NIPS 2014). стр. 2672–2680.

- ^ Салиманс, Тим; Гудфеллоу, Ян; Заремба, Войцех; Чунг, Вики; Рэдфорд, Алек; Чен, Си (2016). «Улучшенные методы обучения GAN». arXiv : 1606.03498 [ cs.LG ].

- ^ Изола, Филипп; Чжу, Цзюнь-Янь; Чжоу, Тинхуэй; Эфрос, Алексей (2017). «Перевод изображений в изображения с помощью условно-состязательных сетей» . Компьютерное зрение и распознавание образов .

- ^ Эй, Джонатон; Эрмон, Стефано (2016). «Генераторно-состязательное имитационное обучение» . Достижения в области нейронных систем обработки информации . 29 : 4565–4573. arXiv : 1606.03476 .

- ^ «Ванильный GAN (GAN в компьютерном зрении: Введение в генеративное обучение)» . theaisummer.com . ИИ Лето. 10 апреля 2020 года. Архивировано из оригинала 3 июня 2020 года . Проверено 20 сентября 2020 г.

- ^ Люк, Полина; Купри, Камилла; Чинтала, Сумит; Вербек, Якоб (25 ноября 2016 г.). «Семантическая сегментация с использованием состязательных сетей». Семинар NIPS по состязательным тренировкам, декабрь, Барселона, Испания . 2016 . arXiv : 1611.08408 .

- ^ Андрей Карпаты ; Питер Аббель ; Грег Брокман; Питер Чен; Вики Чунг; Рокки Дуан; Ян Гудфеллоу; Дурк Кингма; Джонатан Хо; Рейн Хаутхофт; Тим Салиманс; Джон Шульман; Илья Суцкевер; Войцех Заремба, Генеративные модели , OpenAI , получено 7 апреля 2016 г.

- ^ Мохамед, Шакир; Лакшминараянан, Баладжи (2016). «Обучение в неявных генеративных моделях». arXiv : 1610.03483 [ stat.ML ].

- ↑ Перейти обратно: Перейти обратно: а б Гудфеллоу, Ян (3 апреля 2017 г.). «Учебное пособие NIPS 2016: Генеративно-состязательные сети». arXiv : 1701.00160 [ cs.LG ].

- ^ Кингма, Дидерик П.; Веллинг, Макс (1 мая 2014 г.). «Автокодирование вариационного Байеса». arXiv : 1312.6114 [ stat.ML ].

- ^ Резенде, Данило Хименес; Мохамед, Шакир; Виерстра, Даан (18 июня 2014 г.). «Стохастическое обратное распространение ошибки и приближенный вывод в глубоких генеративных моделях» . Международная конференция по машинному обучению . ПМЛР: 1278–1286. arXiv : 1401.4082 .

- ↑ Перейти обратно: Перейти обратно: а б Фарния, Фарзан; Оздаглар, Асуман (21 ноября 2020 г.). «Всегда ли ГАН имеют равновесие Нэша?» . Международная конференция по машинному обучению . ПМЛР: 3029–3039.

- ↑ Перейти обратно: Перейти обратно: а б с Венг, Лилиан (18 апреля 2019 г.). «От ГАН до ВГАН». arXiv : 1904.08994 [ cs.LG ].

- ↑ Перейти обратно: Перейти обратно: а б с Каррас, Теро; Айла, Тимо; Лайне, Самули; Лехтинен, Яакко (1 октября 2017 г.). «Прогрессивное развитие GAN для повышения качества, стабильности и разнообразия». arXiv : 1710.10196 [ cs.NE ].

- ^ Совяный, Петр; Перцы, Клавдий; Ионеску, Раду Тудор; Леордеану, Мариус (22 октября 2019 г.). «Учебная программа по сложности изображений для генеративно-состязательных сетей (CuGAN)». arXiv : 1910.08967 [ cs.LG ].

- ^ Хакоэн, Гай; Вайншалл, Дафна (24 мая 2019 г.). «О силе обучения по учебной программе в обучении глубоких сетей» . Международная конференция по машинному обучению . ПМЛР: 2535–2544. arXiv : 1904.03626 .

- ^ «r/MachineLearning — Комментарий пользователя u/ian_goodfellow к «[R] [1701.07875] Wasserstein GAN» . Reddit . 30 января 2017 г. Проверено 15 июля 2022 г.

- ^ Лин, Зинан; и др. (декабрь 2018 г.). PacGAN: сила двух выборок в генеративно-состязательных сетях . 32-я Международная конференция по нейронным системам обработки информации. стр. 1505–1514. arXiv : 1712.04086 .

- ^ Мешедер, Ларс; Гейгер, Андреас; Новозин, Себастьян (31 июля 2018 г.). «Какие методы обучения GAN действительно сходятся?». arXiv : 1801.04406 [ cs.LG ].

- ↑ Перейти обратно: Перейти обратно: а б Брок, Эндрю; Донахью, Джефф; Симонян, Карен (1 сентября 2018 г.). Крупномасштабное обучение GAN для синтеза высококачественных естественных изображений . Международная конференция по обучению представлений 2019. arXiv : 1809.11096 .

- ^ Хойзель, Мартин; Рамзауэр, Хуберт; Унтертинер, Томас; Несслер, Бернхард; Хохрейтер, Зепп (2017). «GAN, обученные по правилу обновления в двух временных масштабах, сходятся к локальному равновесию Нэша» . Достижения в области нейронных систем обработки информации . 30 . Curran Associates, Inc. arXiv : 1706.08500 .

- ^ Кингма, Дидерик П.; Ба, Джимми (29 января 2017 г.). «Адам: метод стохастической оптимизации». arXiv : 1412.6980 [ cs.LG ].

- ^ Чжан, Ричард; Изола, Филипп; Эфрос, Алексей А.; Шехтман, Эли; Ван, Оливер (2018). «Необоснованная эффективность глубоких функций как показателя восприятия». стр. 586–595. arXiv : 1801.03924 [ cs.CV ].

- ^ Борджи, Али (1 февраля 2019 г.). «Плюсы и минусы мер оценки GAN» . Компьютерное зрение и понимание изображений . 179 : 41–65. arXiv : 1802.03446 . дои : 10.1016/j.cviu.2018.10.009 . ISSN 1077-3142 . S2CID 3627712 .

- ^ Хиндупур, Авинаш (15 июля 2022 г.), Зоопарк GAN , данные получены 15 июля 2022 г.

- ^ Одена, Август; Ола, Кристофер; Шленс, Джонатон (17 июля 2017 г.). «Синтез условного изображения с помощью вспомогательных классификаторов GAN» . Международная конференция по машинному обучению . ПМЛР: 2642–2651. arXiv : 1610.09585 .

- ^ Рэдфорд, Алек; Мец, Люк; Чинтала, Сумит (2016). «Обучение представлению без учителя с помощью глубоких сверточных генеративно-состязательных сетей». ИКЛР . S2CID 11758569 .

- ^ Лонг, Джонатан; Шелхамер, Эван; Даррелл, Тревор (2015). «Полностью сверточные сети для семантической сегментации» . КВФ : 3431–3440.

- ^ Чжан, Хан; Гудфеллоу, Ян; Метаксас, Димитрис; Одена, Август (24 мая 2019 г.). «Генераторно-состязательные сети самовнимания» . Международная конференция по машинному обучению . ПМЛР: 7354–7363.

- ^ Ларсен, Андерс Боесен Линдбо; Сёндербю, Сорен Кааэ; Ларошель, Хьюго; Винтер, Оле (11 июня 2016 г.). «Автокодирование за пределами пикселей с использованием изученной метрики сходства» . Международная конференция по машинному обучению . ПМЛР: 1558–1566. arXiv : 1512.09300 .

- ^ Цзян, Ифань; Чанг, Шию; Ван, Чжанъян (8 декабря 2021 г.). «TransGAN: два чистых трансформатора могут создать один мощный GAN, и его можно масштабировать». arXiv : 2102.07074 [ cs.CV ].

- ^ Гровер, Адитья; Дхар, Маник; Эрмон, Стефано (1 мая 2017 г.). «Flow-GAN: сочетание максимального правдоподобия и состязательного обучения в генеративных моделях». arXiv : 1705.08868 [ cs.LG ].

- ^ Арджовский, Мартин; Ботту, Леон (1 января 2017 г.). «К принципиальным методам обучения генеративно-состязательных сетей». arXiv : 1701.04862 [ stat.ML ].

- ^ Гудфеллоу, Ян Дж. (1 декабря 2014 г.). «О критериях различимости оценки генеративных моделей». arXiv : 1412.6515 [ stat.ML ].

- ^ Гудфеллоу, Ян (31 августа 2016 г.). «Генераторно-состязательные сети (GAN), презентация в Лаборатории искусственного интеллекта Беркли» (PDF) . Архивировано (PDF) из оригинала 8 мая 2022 г.

- ^ Лим, Джэ Хён; Йе, Чон Чхоль (8 мая 2017 г.). «Геометрический ГАН». arXiv : 1705.02894 [ stat.ML ].

- ^ Мао, Сюйдун; Ли, Цин; Се, Хаоран; Лау, Раймонд Ю.К.; Ван, Чжэнь; Пол Смолли, Стивен (2017). «Генераторно-состязательные сети метода наименьших квадратов» : 2794–2802.

{{cite journal}}: Для цитирования журнала требуется|journal=( помощь ) - ^ Махзани, Алиреза; Шленс, Джонатон; Джейтли, Навдип; Гудфеллоу, Ян ; Фрей, Брендан (2016). «Состязательные автоэнкодеры». arXiv : 1511.05644 [ cs.LG ].

- ^ Барбер, Дэвид; Агаков, Феликс (9 декабря 2003 г.). «Алгоритм IM: вариационный подход к максимизации информации» . Материалы 16-й Международной конференции по нейронным системам обработки информации . НИПС'03. Кембридж, Массачусетс, США: MIT Press: 201–208.

- ^ Чен, Си; Дуань, Ян; Хаутхофт, Рейн; Шульман, Джон; Суцкевер, Илья; Аббель, Питер (2016). «InfoGAN: обучение интерпретируемому представлению с помощью генеративно-состязательных сетей, максимизирующих информацию» . Достижения в области нейронных систем обработки информации . 29 . Curran Associates, Inc. arXiv : 1606.03657 .

- ^ Донахью, Джефф; Креэнбюль, Филипп; Даррелл, Тревор (2016). «Состязательное обучение функциям». arXiv : 1605.09782 [ cs.LG ].

- ^ Дюмулен, Винсент; Белгази, Измаил; Пул, Бен; Мастропьетро, Оливье; Арджовский, Алекс; Курвиль, Аарон (2016). «Состязательно полученный вывод». arXiv : 1606.00704 [ stat.ML ].

- ^ Си Чен; Ян Дуань; Рейн Хаутхофт; Джон Шульман; Илья Суцкевер ; Питер Абиль (2016). «InfoGAN: обучение интерпретируемому представлению с помощью генеративно-состязательных сетей, максимизирующих информацию». arXiv : 1606.03657 [ cs.LG ].

- ^ Жируй Чжан; Шуцзе Лю; Му Ли; Мин Чжоу; Энхун Чен (октябрь 2018 г.). «Двунаправленные генеративно-состязательные сети для нейронного машинного перевода» (PDF) . стр. 190–199.

- ^ Чжу, Цзюнь-Янь; Пак, Тэсон; Изола, Филипп; Эфрос, Алексей А. (2017). «Непарный перевод изображений в изображения с использованием циклически-согласованных состязательных сетей». стр. 2223–2232. arXiv : 1703.10593 [ cs.CV ].

- ^ Изола, Филипп; Чжу, Цзюнь-Янь; Чжоу, Тинхуэй; Эфрос, Алексей А. (2017). «Перевод изображений в изображения с использованием условно-состязательных сетей». стр. 1125–1134. arXiv : 1611.07004 [ cs.CV ].

- ^ Браунли, Джейсон (22 августа 2019 г.). «Нежное введение в BigGAN, большую генеративно-состязательную сеть» . Мастерство машинного обучения . Проверено 15 июля 2022 г.

- ^ Шэнъюй, Чжао; Чжицзянь, Лю; Цзи, Линь; Цзюнь-Янь, Чжу; Сон, Хан (2020). «Дифференцируемое увеличение для эффективного обучения GAN» . Достижения в области нейронных систем обработки информации . 33 . arXiv : 2006.10738 .

- ↑ Перейти обратно: Перейти обратно: а б с Теро, Каррас; Миика, Айттала; Янне, Хеллстен; Самули, Лайне; Яакко, Лехтинен; Тимо, Айла (2020). «Обучение генеративно-состязательных сетей с ограниченными данными» . Достижения в области нейронных систем обработки информации . 33 .

- ^ Шахам, Тамар Ротт; Декель, Тали; Михаэли, Томер (октябрь 2019 г.). «SinGAN: изучение генеративной модели на основе одного естественного изображения» . Международная конференция IEEE/CVF по компьютерному зрению (ICCV) 2019 . IEEE. стр. 4569–4579. arXiv : 1905.01164 . дои : 10.1109/iccv.2019.00467 . ISBN 978-1-7281-4803-8 . S2CID 145052179 .

- ^ Каррас, Теро; Лайне, Самули; Айла, Тимо (июнь 2019 г.). «Архитектура генератора на основе стилей для генеративно-состязательных сетей» . Конференция IEEE/CVF 2019 по компьютерному зрению и распознаванию образов (CVPR) . IEEE. стр. 4396–4405. arXiv : 1812.04948 . дои : 10.1109/cvpr.2019.00453 . ISBN 978-1-7281-3293-8 . S2CID 54482423 .

- ^ Каррас, Теро; Лайне, Самули; Айттала, Миика; Хеллстен, Янне; Лехтинен, Яакко; Айла, Тимо (июнь 2020 г.). «Анализ и улучшение качества изображения StyleGAN» . Конференция IEEE/CVF 2020 года по компьютерному зрению и распознаванию образов (CVPR) . IEEE. п.п. 8107–8116. arXiv : 1912.04958 . дои : 10.1109/cvpr42600.2020.00813 . ISBN 978-1-7281-7168-5 . S2CID 209202273 .

- ^ Тимо, Каррас, Теро Айттала, Миика Лайне, Самули Харконен, Эрик Хеллстен, Янне Лехтинен, Яакко Айла (23 июня 2021 г.). Генеративно-состязательные сети без псевдонимов . OCLC 1269560084 .

{{cite book}}: CS1 maint: несколько имен: список авторов ( ссылка ) - ^ Каррас, Теро; Айттала, Миика; Лайне, Самули; Харконен, Эрик; Хеллстен, Янне; Лехтинен, Яакко; Айла, Тимо. «Генераторно-состязательные сети без псевдонимов (StyleGAN3)» . nvlabs.github.io . Проверено 16 июля 2022 г.

- ^ Цезарь, Хольгер (1 марта 2019 г.), Список статей о генеративно-состязательных (нейронных) сетях: nightrome/really-awesome-gan , получено 2 марта 2019 г.

- ^ Винсент, Джеймс (5 марта 2019 г.). «Бесконечный поток произведений искусства искусственного интеллекта выставлен на аукцион» . Грань . Проверено 13 июня 2020 г.

- ^ Ю, Цзяхуэй и др. « Генеративное рисование изображений с контекстуальным вниманием ». Материалы конференции IEEE по компьютерному зрению и распознаванию образов. 2018.

- ^ Вонг, Сиси. «Восстание супермоделей с искусственным интеллектом» . Тенденции CDO .

- ^ Таиф, К.; Угайл, Х.; Мехмуд, И. (2020). «Генерация отбрасываемых теней с использованием генеративно-состязательных сетей». Вычислительная наука – ICCS 2020 . Конспекты лекций по информатике. Том. 12141. стр. 481–495. дои : 10.1007/978-3-030-50426-7_36 . ISBN 978-3-030-50425-0 . ПМК 7302543 .

- ^ Аллен, Эрик Ван (8 июля 2020 г.). «Печально известная сага о крипипасте Zelda использует искусственный интеллект для создания финала» . СШАгеймер . Архивировано из оригинала 7 ноября 2022 года . Проверено 7 ноября 2022 г.

- ^ аркадаатака (28 сентября 2020 г.). «Подкаст Arcade Attack – сентябрь (4 из 4) 2020 г. – Алекс Холл (Бен утонул) – Интервью» . Аркадная атака . Проверено 7 ноября 2022 г.

- ^ Шавински, Кевин; Чжан, Се; Чжан, Ханьтянь; Фаулер, Лукас; Сантанам, Гокула Кришнан (1 февраля 2017 г.). «Генеративно-состязательные сети восстанавливают особенности астрофизических изображений галактик за пределами предела деконволюции». Ежемесячные уведомления Королевского астрономического общества: письма . 467 (1): Л110–Л114. arXiv : 1702.00403 . Бибкод : 2017MNRAS.467L.110S . дои : 10.1093/mnrasl/slx008 . S2CID 7213940 .

- ^ Кинкейд, Кэти. «Исследователи обучают нейронную сеть изучению темной материи» . Журнал НИОКР.

- ^ Кинкейд, Кэти (16 мая 2019 г.). «CosmoGAN: Обучение нейронной сети для изучения темной материи» . Физика.орг .

- ^ «Обучение нейронной сети изучению темной материи» . Наука Дейли . 16 мая 2019 г.

- ^ в 06:13, Катянна Куах, 20 мая 2019 г. «Космобоффины используют нейронные сети для простого построения карт темной материи» . www.theregister.co.uk . Проверено 20 мая 2019 г.

{{cite web}}: CS1 maint: числовые имена: список авторов ( ссылка ) - ^ Мустафа, Мустафа; Бард, Дебора; Бхимджи, Вахид; Лукич, Зария; Аль-Рфу, Рами; Краточвил, Ян М. (6 мая 2019 г.). «CosmoGAN: создание высокоточных карт конвергенции слабого линзирования с использованием генеративно-состязательных сетей» . Вычислительная астрофизика и космология . 6 (1): 1. arXiv : 1706.02390 . Бибкод : 2019ComAC...6....1M . дои : 10.1186/s40668-019-0029-9 . ISSN 2197-7909 . S2CID 126034204 .

- ^ Паганини, Микела; де Оливейра, Люк; Нахман, Бенджамин (2017). «Изучение физики элементарных частиц на примере: генеративно-состязательные сети с учетом местоположения для физического синтеза». Вычисления и программное обеспечение для большой науки . 1 : 4. arXiv : 1701.05927 . Бибкод : 2017arXiv170105927D . дои : 10.1007/s41781-017-0004-6 . S2CID 88514467 .

- ^ Паганини, Микела; де Оливейра, Люк; Нахман, Бенджамин (2018). «Ускорение науки с помощью генеративно-состязательных сетей: приложение к трехмерным потокам частиц в многослойных калориметрах». Письма о физических отзывах . 120 (4): 042003. arXiv : 1705.02355 . Бибкод : 2018PhRvL.120d2003P . doi : 10.1103/PhysRevLett.120.042003 . ПМИД 29437460 . S2CID 3330974 .

- ^ Паганини, Микела; де Оливейра, Люк; Нахман, Бенджамин (2018). «CaloGAN: трехмерное моделирование ливней частиц высокой энергии в многослойных электромагнитных калориметрах с генеративно-состязательными сетями». Физ. Преподобный Д. 97 (1): 014021. arXiv : 1712.10321 . Бибкод : 2018PhRvD..97a4021P . дои : 10.1103/PhysRevD.97.014021 . S2CID 41265836 .

- ^ Эрдманн, Мартин; Гломбица, Йонас; Кваст, Торбен (2019). «Точное моделирование ливней электромагнитного калориметра с использованием генеративно-состязательной сети Вассерштейна». Вычисления и программное обеспечение для большой науки . 3 : 4. arXiv : 1807.01954 . дои : 10.1007/s41781-018-0019-7 . S2CID 54216502 .

- ^ Муселла, Паскуале; Пандольфи, Франческо (2018). «Быстрое и точное моделирование детекторов частиц с использованием генеративно-состязательных сетей». Вычисления и программное обеспечение для большой науки . 2 : 8. arXiv : 1805.00850 . Бибкод : 2018arXiv180500850M . дои : 10.1007/s41781-018-0015-y . S2CID 119474793 .

- ^ «Глубокие генеративные модели для моделирования быстрого ливня в ATLAS» . 2018.

- ^ ШиП, Сотрудничество (2019). «Быстрое моделирование мюонов, полученных в эксперименте SHiP, с использованием генеративно-состязательных сетей». Журнал приборостроения . 14 (11): P11028. arXiv : 1909.04451 . Бибкод : 2019JInst..14P1028A . дои : 10.1088/1748-0221/14/11/P11028 . S2CID 202542604 .

- ^ Тан, Сяоу, Ю; Лой, Чэнь, Чао; Гу, Цзиньцзинь; Ван, Синьтао (1 сентября 2018 г.). Генеративно-состязательные сети». arXiv : 1809.00219 . Bibcode : 2018arXiv180900219W .

- ^ «Фейковые новости: вы еще ничего не видели» . Экономист . июль 2017 года . Проверено 1 июля 2017 г.

- ^ мсмаш (14 февраля 2019). « Сайт «Этот человек не существует» использует искусственный интеллект для создания реалистичных, но устрашающих лиц» . Слэшдот . Проверено 16 февраля 2019 г.

- ^ Дойл, Майкл (16 мая 2019 г.). «Джон Бизли живет на Сэддлхорс-Драйв в Эвансвилле. Или так?» . Курьер и пресса.

- ^ Таргетт, Эд (16 мая 2019 г.). «Калифорния приближается к тому, чтобы объявить дипфейковую порнографию незаконной». Обзор компьютерного бизнеса.

- ^ Михальчик, Кэрри (4 октября 2019 г.). «Законы Калифорнии направлены на борьбу с дипфейками в политике и порнографии» . cnet.com . CNET . Проверено 13 октября 2019 г.

- ^ Найт, Уилл (7 августа 2018 г.). «Министерство обороны выпустило первые инструменты для ловли дипфейков» . Обзор технологий Массачусетского технологического института .

- ^ Ли, Бонни; Франсуа-Лаве, Винсент; Доан, Танг; Пино, Жоэль (14 февраля 2021 г.). «Обучение с состязательным подкреплением в предметной области». arXiv : 2102.07097 [ cs.LG ].

- ^ Правнук Томаз Рибейро Виана; де Карвальо Фильо, Антонио Осеас; Магальяйнс, Дебора Мария Виейра (февраль 2020 г.). «Генератно-состязательная сеть и текстурные особенности, применяемые для автоматического обнаружения глаукомы». Прикладные мягкие вычисления . 90 : 106165. doi : 10.1016/j.asoc.2020.106165 . S2CID 214571484 .

- ^ Вэй, Джерри (3 июля 2019 г.). «Создание дизайна обуви с помощью машинного обучения» . Середина . Проверено 6 ноября 2019 г.

- ^ Гринемайер, Ларри (20 июня 2016 г.). «Когда у компьютеров появится здравый смысл? Спросите Facebook» . Научный американец . Проверено 31 июля 2016 г.

- ^ Реконструкция римских императоров: интервью с Дэниелом Фошартом , получено 3 июня 2022 г.

- ^ «3D-генеративная состязательная сеть» . 3dgan.csail.mit.edu .

- ^ Ахлиоптас, Панос; Диаманти, Ольга; Митлягкас, Иоаннис; Гибас, Леонидас (2018). «Изучение представлений и генеративных моделей для трехмерных облаков точек». arXiv : 1707.02392 [ cs.CV ].

- ^ Вондрик, Карл; Пирсиаваш, Хамед; Торральба, Антонио (2016). «Создание видео с динамикой сцены» . carlvondrick.com . arXiv : 1609.02612 . Бибкод : 2016arXiv160902612V .

- ^ Антипов, Григорий; Баккуш, Моэз; Дюгелей, Жан-Люк (2017). «Старение лица с помощью условных генеративно-состязательных сетей». arXiv : 1702.01983 [ cs.CV ].

- ^ Кан, Юхао; Гао, Сун; Рот, Роб (2019). «Перенос стилей многомасштабных карт с использованием генеративно-состязательных сетей» . Международный журнал картографии . 5 (2–3): 115–141. arXiv : 1905.02200 . Бибкод : 2019arXiv190502200K . дои : 10.1080/23729333.2019.1615729 . S2CID 146808465 .

- ^ Вейнандс, Джаспер; Приятно, Керри; Томпсон, Джейсон; Чжао, Хайфэн; Стивенсон, Марк (2019). «Улучшение уличного ландшафта с использованием генеративно-состязательных сетей: идеи, связанные со здоровьем и благополучием». Устойчивые города и общество . 49 : 101602. arXiv : 1905.06464 . Бибкод : 2019arXiv190506464W . дои : 10.1016/j.scs.2019.101602 . S2CID 155100183 .

- ^ Укконен, Антти; Джуна, Пири; Руотсало, Туукка (2020). «Создание изображений вместо их получения» . Материалы 43-й Международной конференции ACM SIGIR по исследованиям и разработкам в области информационного поиска . стр. 1329–1338. дои : 10.1145/3397271.3401129 . hdl : 10138/328471 . ISBN 9781450380164 . S2CID 220730163 .

- ^ Падхи, Радхакант; Унникришнан, Нишант (2006). «Единая архитектура адаптивного критика сети (SNAC) для синтеза оптимального управления для класса нелинейных систем». Нейронные сети . 19 (10): 1648–1660. дои : 10.1016/j.neunet.2006.08.010 . ПМИД 17045458 .

- ^ «ИИ может показать нам разрушительные последствия изменения климата» . Обзор технологий Массачусетского технологического института . 16 мая 2019 г.

- ^ Кристиан, Джон (28 мая 2019 г.). «ПОТРЯСАЮЩИЙ ИИ УГАДАЕТ, КАК ВЫ ВЫГЛЯДИТЕ, ПО ВАШЕМУ ГОЛОСУ» . Футуризм.

- ^ Жаворонков, Алексей (2019). «Глубокое обучение позволяет быстро идентифицировать мощные ингибиторы киназы DDR1». Природная биотехнология . 37 (9): 1038–1040. дои : 10.1038/s41587-019-0224-x . ПМИД 31477924 . S2CID 201716327 .

- ^ Барбер, Грегори. «Молекула, созданная искусственным интеллектом, обладает свойствами, подобными лекарству» . Проводной .

- ^ Мохаммад Навид Фекри; Ананда Мохон Гош; Катарина Гролингер (2020). «Генерация энергетических данных для машинного обучения с помощью рекуррентных генеративно-состязательных сетей» . Энергии . 13 (1): 130. дои : 10.3390/en13010130 .

- ^ Шмидхубер, Юрген (1991). «Возможность реализовать любопытство и скуку в нейронных контроллерах для построения моделей». Учеб. САБ'1991 . MIT Press/Брэдфорд Букс. стр. 222–227.

- ^ Шмидхубер, Юрген (2010). «Формальная теория творчества, веселья и внутренней мотивации (1990–2010)». Транзакции IEEE по автономному умственному развитию . 2 (3): 230–247. дои : 10.1109/TAMD.2010.2056368 . S2CID 234198 .

- ↑ Перейти обратно: Перейти обратно: а б Шмидхубер, Юрген (2020). «Генераторно-состязательные сети являются особыми случаями искусственного любопытства (1990), а также тесно связаны с минимизацией предсказуемости (1991)». Нейронные сети . 127 : 58–66. arXiv : 1906.04493 . doi : 10.1016/j.neunet.2020.04.008 . ПМИД 32334341 . S2CID 216056336 .

- ^ Ниемитало, Олли (24 февраля 2010 г.). «Метод обучения искусственных нейронных сетей генерированию недостающих данных в переменном контексте» . Интернет-архив (Wayback Machine) . Архивировано из оригинала 12 марта 2012 года . Проверено 22 февраля 2019 г.

- ^ «ГАНы были изобретены в 2010 году?» . Reddit r/MachineLearning . 2019 . Проверено 28 мая 2019 г.

- ^ Ли, Вэй; Гаучи, Мелвин; Гросс, Родерих (6 июля 2013 г.). «Труды пятнадцатой ежегодной конференции по генетическим и эволюционным вычислениям - GECCO '13». Материалы 15-й ежегодной конференции по генетическим и эволюционным вычислениям (GECCO 2013) . Амстердам, Нидерланды: ACM. стр. 223–230. дои : 10.1145/2463372.2465801 . ISBN 9781450319638 .

- ^ Гутманн, Майкл; Хюваринен, Аапо. «Оценка контрастности шума» (PDF) . Международная конференция по искусственному интеллекту и статистике .

- ^ Абу-Халаф, Мурад; Льюис, Фрэнк Л.; Хуан, Цзе (1 июля 2008 г.). «Нейродинамическое программирование и игры с нулевой суммой для систем управления с ограничениями». Транзакции IEEE в нейронных сетях . 19 (7): 1243–1252. дои : 10.1109/ТНН.2008.2000204 . S2CID 15680448 .

- ^ Абу-Халаф, Мурад; Льюис, Фрэнк Л.; Хуан, Цзе (1 декабря 2006 г.). «Итерации политики по уравнению Гамильтона – Якоби – Айзекса для управления с обратной связью по состоянию H ∞ с входным насыщением». Транзакции IEEE при автоматическом управлении . дои : 10.1109/TAC.2006.884959 . S2CID 1338976 .

- ^ Саджади, Мехди С.М.; Шёлкопф, Бернхард; Хирш, Майкл (23 декабря 2016 г.). «EnhanceNet: сверхвысокое разрешение одного изображения посредством автоматического синтеза текстур». arXiv : 1612.07919 [ cs.CV ].

- ^ «Этого человека не существует: и с ИИ ничего не будет» . 20 марта 2019 г.

- ^ «ИСКУССТВЕННЫЙ интеллект входит в историю искусства» . 28 декабря 2018 г.

- ^ Том Феврие (17 февраля 2019 г.). «Скандал об искусственном интеллекте» .

- ^ «StyleGAN: официальная реализация TensorFlow» . 2 марта 2019 г. – через GitHub.

- ^ Паес, Дэнни (13 февраля 2019 г.). «Этот человек не существует — лучший одноразовый веб-сайт 2019 года» . Проверено 16 февраля 2019 г.

- ^ Бешицца, Роб (15 февраля 2019 г.). «Этого человека не существует» . Боинг-Боинг . Проверено 16 февраля 2019 г.

- ^ Хорев, Рани (26 декабря 2018 г.). «GAN на основе стилей – создание и настройка реалистичных искусственных лиц» . Лирн.AI. Архивировано из оригинала 5 ноября 2020 года . Проверено 16 февраля 2019 г.

- ^ Эльгаммаль, Ахмед; Лю, Бинчен; Эльхосейни, Мохамед; Маццоне, Мариан (2017). «МОЖЕТ: творческие состязательные сети, генерирующие «искусство» путем изучения стилей и отклонения от стилевых норм». arXiv : 1706.07068 [ cs.AI ].

- ^ Кон, Гейб (25 октября 2018 г.). «Искусство искусственного интеллекта на Christie's продано за 432 500 долларов» . Нью-Йорк Таймс .

- ^ Маццоне, Мэриан; Ахмед Эльгаммаль (21 февраля 2019 г.). «Искусство, творчество и потенциал искусственного интеллекта» . Искусство . 8:26 . doi : 10.3390/arts8010026 .

- ^ Кулп, Патрик (23 мая 2019 г.). «Лаборатория искусственного интеллекта Samsung может создать фейковое видео из одного кадра в голову» . Рекламная неделя .

- ^ Ю, Йи; Каналес, Саймон (2021). «Условный LSTM-GAN для генерации мелодий из текстов». Транзакции ACM по мультимедийным вычислениям, коммуникациям и приложениям . 17 :1–20. arXiv : 1908.05551 . дои : 10.1145/3424116 . ISSN 1551-6857 . S2CID 199668828 .

- ^ «ИИ NVIDIA воссоздает Pac-Man с нуля, просто наблюдая за тем, как в него играют» . Грань . 22 мая 2020 г.

- ^ Сын Ук Ким; Чжоу, Юхао; Филион, Иона; Торральба, Антонио; Фидлер, Саня (2020). «Учимся моделировать динамические среды с помощью GameGAN». arXiv : 2005.12126 [ cs.CV ].

Внешние ссылки [ править ]

- Найт, Уилл. «5 больших прогнозов для искусственного интеллекта в 2017 году» . Обзор технологий Массачусетского технологического института . Проверено 5 января 2017 г.

- Каррас, Теро; Лайне, Самули; Айла, Тимо (2018). «Архитектура генератора на основе стилей для генеративно-состязательных сетей». arXiv : 1812.04948 [ cs.NE ].

- Этот человек не существует — фотореалистичные изображения несуществующих людей, созданные StyleGAN.

- Этого кота не существует. Архивировано 5 марта 2019 года в Wayback Machine — фотореалистичные изображения несуществующих кошек, созданные StyleGAN.

- Ван, Чжэнвэй; Она, Ци; Уорд, Томас Э. (2019). «Генеративно-состязательные сети в компьютерном зрении: обзор и таксономия». arXiv : 1906.01529 [ cs.LG ].

![{\displaystyle \mu _{D}:\Omega \to {\mathcal {P}}[0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dce97271df1c30e57ae96f72c566661f1bae9dad)

![{\displaystyle {\mathcal {P}}[0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/23bc6194efec9e3aaf67b5270e6b8cbc3834d99e)

![{\displaystyle [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/738f7d23bb2d9642bab520020873cccbef49768d)

![{\displaystyle L(\mu _{G},\mu _{D}):=\mathbb {E} _{x\sim \mu _ {\text{ref}},y\sim \mu _{D }(x)}[\ln y]+\mathbb {E} _{x\sim \mu _{G},y\sim \mu _{D}(x)}[\ln(1-y)] .}](https://wikimedia.org/api/rest_v1/media/math/render/svg/10e10d3b6d174d6ff6720514d31ee8394826288f)

![{\displaystyle \mu _{D}:(\Omega ,{\mathcal {B}})\to {\mathcal {P}}([0,1],{\mathcal {B}}([0,1]))}](https://wikimedia.org/api/rest_v1/media/math/render/svg/54c054944874a3a2751d0c67770b8af5d0425425)

![{\displaystyle {\mathcal {B}}([0,1])}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2a2035d78993071419aef7ec2b3f1b7df235173f)

![{\displaystyle D:\Omega \to [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/298d9bf50461bcde11bd77e61e9048b0eaabbc12)

![{\displaystyle L(G,D):=\mathbb {E} _{x\sim \mu _ {\text{ref}}}[\ln D(x)]+\mathbb {E} _{z\ sim \mu _{Z}}[\ln(1-D(G(z)))].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c5b9300eaf96d398d8579afd470b8233188a4a47)

![{\displaystyle \min _{\mu _{G}} \max _{\mu _{D}}L (\mu _{G},\mu _{D}):=\mathbb {E} _{ x\sim \mu _{\text{ref}},y\sim \mu _{D}(x)}[\ln y]+\mathbb {E} _{x\sim \mu _{G}, y\sim \mu _{D}(x)}[\ln(1-y)].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/99dc9157ae3568c0ea78f9c78b625278583b39ca)

![{\displaystyle \mathbb {E} _ {x\sim \mu _ {\text{ref}},y\sim \mu _{D}(x)}[\ln y]\leq \mathbb {E} _ {x\sim \mu _{\text{ref}}}[\ln \mathbb {E} _{y\sim \mu _{D}(x)}[y]]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/17982ba0672532bcc3acfcf9d191965f654f9aad)

![{\displaystyle L(\mu _{G},\mu _{D}):=\mathbb {E} _{x\sim \mu _ {\text{ref}}}[\ln D(x)] +\mathbb {E} _{x\sim \mu _{G}}[\ln(1-D(x))].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/37af02109e28d94c8624158bc2facc33995e9256)

![{\displaystyle L(\mu _{G},\mu _{D}):=\int \mu (dx)\left[\rho _{\text{ref}}(x)\ln(D(x ))+\rho _{G}(x)\ln(1-D(x))\right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3d89762c883725af3a4781671c0e33a4a9c5050d)

![{\displaystyle \{x|\mathbb {E} _{y\sim \mu _{D}(x)}[\ln(1-y)]=\inf _{x}\mathbb {E} _{ y\sim \mu _{D}(x)}[\ln(1-y)]\}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d9d620c0a45064347c4f08943a9a0bf648a363f8)

![{\displaystyle \arg \max _{\mu _{D}} \min _{\mu _{G}}L (\mu _{G},\mu _{D}) = \arg \max _{ \mu _{D}}\mathbb {E} _{x\sim \mu _{\text{ref}},y\sim \mu _{D}(x)}[\ln y]+\inf _ {x}\mathbb {E} _{y\sim \mu _{D}(x)}[\ln(1-y)].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/79e791bf8ad2fbfe072f41a67d23d6bda1fda67e)

![{\displaystyle D(x)=\mathbb {E} _{y\sim \mu _{D}(x)}[y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/62b34fdf229109bdb32719d1987b3c18e9f88623)

![{\displaystyle \arg \max _{\mu _{D}} \min _{\mu _{G}}L (\mu _{G},\mu _{D}) = \arg \max _{ D}\mathbb {E} _{x\sim \mu _{\text{ref}}}[\ln D(x)]+\inf _{x}\ln(1-D(x))}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c69298bc8ce96160d962e540d2666ea2dd66639c)

![{\displaystyle \ln \mathbb {E} _{x\sim \mu _ {\text{ref}}}[D(x)]+\inf _{x}\ln(1-D(x))= \ln \mathbb {E} _{x\sim \mu _{\text{ref}}}[D(x)]+\ln(1-\sup _{x}D(x))=\ln[ \mathbb {E} _{x\sim \mu _ {\text{ref}}}[D(x)](1-\sup _{x}D(x))]\leq \ln[\sup _ {x}D(x))(1-\sup _{x}D(x))]\leq \ln {\frac {1}{4}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/399ec4ca87cf3f188cef719ff84c9f3840728c9e)

![{\displaystyle L(\mu _{G},\mu _{D}):=\mathbb {E} _{x\sim \mu _ {\text{ref}},y\sim \mu _{D }(x)}[\ln(y(1-y))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dc53775d7e30369c325b15393d25c529fcf23058)

![{\displaystyle L(\mu _{G},D):=\mathbb {E} _{c\sim \mu _{C},x\sim \mu _{\text{ref}}(c)} [\ln D(x,c)]+\mathbb {E} _{c\sim \mu _{C},x\sim \mu _{G}(c)}[\ln(1-D(x ,в))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cff5120c597335b415be3b163b99f2efc5fe3e1f)

![{\displaystyle {\begin{cases}\min _{D}L_{D}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{G}}[\ ln D(x)]-\mathbb {E} _{x\sim \mu _{\text{ref}}}[\ln(1-D(x))]\\\min _{G}L_{ G}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{G}}[\ln(1-D(x))]\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fef0dbae6e77883b1137eed6e6619f9ab04cc389)

![{\displaystyle L_{G}=\mathbb {E} _{x\sim \mu _{G}}[\ln D(x)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0fa507c647c2e473c5ae1e9ff8324d3e5678a3a5)

![{\displaystyle L_{G}=\mathbb {E} _{x\sim \mu _{G}}[(\exp \circ \sigma ^{-1}\circ D)(x)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5802ca7fcd3acb4138f4af911f531a866faf7940)

![{\displaystyle L_{D}=-\mathbb {E} _{x\sim {p}_{\text{ref}}}\left[\min \left(0,-1+D\left(x\) right)\right)\right]-\mathbb {E} _{x\sim \mu _{G}}\left[\min \left(0,-1-D\left(x\right)\right) \верно]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e319c91b33888f97995e5f5d50cea22413687fd7)

![{\displaystyle L_{G}=-\mathbb {E} _{x\sim \mu _{G}}[D\left(x\right)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cdd4d471bcff109ba9a253528b4af9973808163b)

![{\displaystyle L_{D}=\mathbb {E} _{x\sim \mu _ {\text{ref}}}[(D(x)-b)^{2}]+\mathbb {E} _ {x\sim \mu _{G}}[(D(x)-a)^{2}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/514a6b4044cae5524f1854d4348a21684b16f5a9)

![{\displaystyle L_{G}=\mathbb {E} _{x\sim \mu _{G}}[(D(x)-c)^{2}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b17a43360234d70453ba840b08962a96eece249a)

![{\displaystyle L_{WGAN}(\mu _{G},D):=\mathbb {E} _{x\sim \mu _{G}}[D(x)]-\mathbb {E} _{ x\sim \mu _{\text{ref}}}[D(x)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/88861f8fb6318fc8f32caab6467e7aaca721107b)

![{\displaystyle {\hat {I}}(G,Q)=\mathbb {E} _{z\sim \mu _{Z},c\sim \mu _{C}}[\ln Q(c| G(z,c))];\quad I(c,G(z,c))\geq \sup _{Q}{\hat {I}}(G,Q)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2f9d0a6292d5fe0efd763c7789986eda14d3386d)

![{\displaystyle L_{GAN}(G,D)=\mathbb {E} _{x\sim \mu _ {\text{ref}},}[\ln D(x)]+\mathbb {E} _ {z\sim \mu _{Z}}[\ln(1-D(G(z,c)))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/17f14990690b58dafea5101d98709c971334567c)

![{\displaystyle {\hat {I}}(G,Q)=\mathbb {E} _{z\sim \mu _{Z},c\sim \mu _{C}}[\ln Q(c| G(z,c))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/331080a17784eb6d80cbd5485576237aae26f6de)

![{\displaystyle D:\Omega _{X}\to [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/22a37008c49fac57a80a9a59f49c34c0273168f6)

![{\displaystyle L(G,E,D)=\mathbb {E} _{x\sim \mu _{X}} [\ln D(x,E(x))]+\mathbb {E} _{ z\sim \mu _{Z}}[\ln(1-D(G(z),z))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/354bd3dd8cbb2f8292e671dd6b42263d323ef532)

![{\displaystyle L(G,E,D)=\mathbb {E} _{(x,z)\sim \mu _{E,X}}[\ln D(x,z)]+\mathbb {E } _{(x,z)\sim \mu _{G,Z}}[\ln(1-D(x,z))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5b66ef02b76d9476dc6ec665cb2d84c71fbb4879)

![{\displaystyle D_{X}:\Omega _{X}\to [0,1],D_{Y}:\Omega _{Y}\to [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8c4c214517f2a68640295a7c1a6d00850fc084e6)

![{\displaystyle {\begin{cases}\min _{D}L_{D}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{\text{ref} }}[\ln D(x)]-\mathbb {E} _{x\sim \mu _{G}}[\ln(1-D(x))]\\\min _{G}L_{ G}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{G}}[\ln(1-D(x))]\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b03868f1bcb6c801320523df04b083675e0e73d0)

![{\displaystyle {\begin{cases}\min _{D}L_{D}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{\text{ref} },T\sim \mu _{trans}}[\ln D(T(x))]-\mathbb {E} _{x\sim \mu _{G}}[\ln(1-D(x ))]\\\min _{G}L_{G}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{G}}[\ln(1- D(x))]\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d665caac49bf83c9f632bc25fa0617ee134682f1)

![{\displaystyle {\begin{cases}\min _{D}L_{D}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{\text{ref} },T\sim \mu _{trans}}[\ln D(T(x))]-\mathbb {E} _{x\sim \mu _{G},T\sim \mu _{trans} }[\ln(1-D(T(x)))]\\\min _{G}L_{G}(D,\mu _{G})=-\mathbb {E} _{x\sim \mu _{G},T\sim \mu _{trans}}[\ln(1-D(T(x)))]\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bae5172c65d37d142fb3ce8b25964f2e0c1bacdf)

![{\displaystyle [K_{trans}]={\begin{bmatrix}(1-3p)&p&p&p\\p&(1-3p)&p&p\\p&p&(1-3p)&p\\p&p&p&(1-3p)\end {bmatrix}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ca9754f61e7f936d873ecfa5a7a7237aa2b02c6a)

![{\displaystyle [K_{trans}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e51428b20010e3dbcf0a439c2d948cf775fd1d47)