Логистическая регрессия

В статистике логистическая модель (или логит-модель ) — это статистическая модель , которая моделирует логарифмические шансы события как линейную комбинацию одной или нескольких независимых переменных . В анализе регрессионном логистическая регрессия [1] (или логит-регрессия ) оценивает параметры логистической модели (коэффициенты в линейной комбинации). Формально в бинарной логистической регрессии существует одна двоичная зависимая переменная , кодируемая индикаторной переменной , где два значения помечены «0» и «1», в то время как каждая из независимых переменных может быть двоичной переменной (два класса, кодируемые индикаторная переменная) или непрерывная переменная (любое действительное значение). Соответствующая вероятность значения, помеченного «1», может варьироваться от 0 (определенно значения «0») до 1 (определенно значения «1»), отсюда и маркировка; [2] Функция, которая преобразует логарифм шансов в вероятность, — это логистическая функция , отсюда и название. Единица измерения шкалы логарифмических шансов называется логит , от логистическая единица слова , отсюда и альтернативные названия. См. § «История» и § «Определение» для формальной математики, а также § «Пример» для рабочего примера.

Бинарные переменные широко используются в статистике для моделирования вероятности возникновения определенного класса или события, например, вероятности победы команды, здоровья пациента и т. д. (см. § Приложения ), а логистическая модель была наиболее часто используемая модель бинарной регрессии примерно с 1970 года. [3] Бинарные переменные могут быть обобщены до категориальных переменных , когда существует более двух возможных значений (например, изображение кошки, собаки, льва и т. д.), а бинарная логистическая регрессия может быть обобщена до полиномиальной логистической регрессии . Если несколько категорий упорядочены , можно использовать порядковую логистическую регрессию (например, порядковую логистическую модель с пропорциональными шансами). [4] ). см. в § Расширения Дополнительные расширения . Сама модель логистической регрессии просто моделирует вероятность выхода с точки зрения входных данных и не выполняет статистическую классификацию (это не классификатор), хотя ее можно использовать для создания классификатора, например, выбрав пороговое значение и классифицируя входные данные с вероятностью. больше порогового значения для одного класса и ниже порогового значения для другого; это распространенный способ создания двоичного классификатора .

Также могут использоваться аналогичные линейные модели для двоичных переменных с другой сигмовидной функцией вместо логистической функции (для преобразования линейной комбинации в вероятность), в первую очередь пробит-модель ; см. § Альтернативы . Определяющей характеристикой логистической модели является то, что увеличение одной из независимых переменных мультипликативно масштабирует шансы данного результата с постоянной скоростью, при этом каждая независимая переменная имеет свой собственный параметр; для двоичной зависимой переменной это обобщает отношение шансов . Говоря более абстрактно, логистическая функция является естественным параметром распределения Бернулли и в этом смысле является «простейшим» способом преобразования действительного числа в вероятность. В частности, он максимизирует энтропию (минимизирует добавленную информацию) и в этом смысле делает наименьшее количество предположений относительно моделируемых данных; см. § Максимальная энтропия .

Параметры логистической регрессии чаще всего оцениваются с помощью оценки максимального правдоподобия (MLE). , здесь нет выражения в замкнутой форме В отличие от линейного метода наименьших квадратов ; см. § Примерка модели . Логистическая регрессия с помощью MLE играет такую же базовую роль для бинарных или категориальных ответов, как линейная регрессия с помощью обычных наименьших квадратов (OLS) играет для скалярных ответов: это простая, хорошо проанализированная базовая модель; см. § Сравнение с линейной регрессией для обсуждения. Логистическая регрессия как общая статистическая модель была первоначально разработана и популяризирована в первую очередь Джозефом Берксоном . [5] начиная с Берксона (1944) , где он придумал «логит»; см . § История .

| Часть серии о |

| Регрессионный анализ |

|---|

| Модели |

| Оценка |

| Фон |

Приложения [ править ]

Общие [ править ]

Логистическая регрессия используется в различных областях, включая машинное обучение, большинство областей медицины и социальные науки. Например, шкала тяжести травм и травм ( TRISS ), которая широко используется для прогнозирования смертности пациентов с травмами, первоначально была разработана Boyd et al. с использованием логистической регрессии. [6] Многие другие медицинские шкалы, используемые для оценки тяжести состояния пациента, были разработаны с использованием логистической регрессии. [7] [8] [9] [10] Логистическая регрессия может использоваться для прогнозирования риска развития того или иного заболевания (например, диабета , ишемической болезни сердца ) на основе наблюдаемых характеристик пациента (возраст, пол, индекс массы тела , результаты различных анализов крови и т. д.). [11] [12] Другим примером может быть прогнозирование того, проголосует ли непальский избиратель за Конгресс Непала, Коммунистическую партию Непала или любую другую партию, на основе возраста, дохода, пола, расы, штата проживания, голосов на предыдущих выборах и т. д. [13] Этот метод также можно использовать в технике , особенно для прогнозирования вероятности отказа данного процесса, системы или продукта. [14] [15] Он также используется в маркетинговых приложениях, таких как прогнозирование склонности клиента к покупке продукта или прекращению подписки и т. д. [16] В экономике его можно использовать для прогнозирования вероятности того, что человек окажется на рынке труда, а в бизнес-приложении можно было бы предсказать вероятность того, что домовладелец не сможет выплатить ипотечный кредит . Условные случайные поля , расширение логистической регрессии на последовательные данные, используются при обработке естественного языка . Специалисты по планированию стихийных бедствий и инженеры полагаются на эти модели для прогнозирования решений, принимаемых домовладельцами или жильцами зданий при мелкомасштабной и крупномасштабной эвакуации, например, пожарах в зданиях, лесных пожарах, ураганах и других. [17] [18] [19] Эти модели помогают в разработке надежных планов борьбы со стихийными бедствиями и более безопасного проектирования застроенной среды .

машинное Контролируемое обучение

Логистическая регрессия — это контролируемый алгоритм машинного обучения , широко используемый для задач двоичной классификации , таких как определение того, является ли электронное письмо спамом или нет, а также диагностика заболеваний путем оценки наличия или отсутствия конкретных состояний на основе результатов тестирования пациентов. Этот подход использует логистическую (или сигмовидную) функцию для преобразования линейной комбинации входных функций в значение вероятности в диапазоне от 0 до 1. Эта вероятность указывает на вероятность того, что данный вход соответствует одной из двух предопределенных категорий. Основной механизм логистической регрессии основан на способности логистической функции точно моделировать вероятность бинарных результатов. Благодаря своей характерной S-образной кривой логистическая функция эффективно сопоставляет любое действительное число со значением в интервале от 0 до 1. Эта функция делает его особенно подходящим для задач двоичной классификации, таких как сортировка электронных писем на «спам» или «не спам». Вычисляя вероятность того, что зависимая переменная будет отнесена к определенной группе, логистическая регрессия обеспечивает вероятностную основу, которая поддерживает принятие обоснованных решений. [20]

Пример [ править ]

Проблема [ править ]

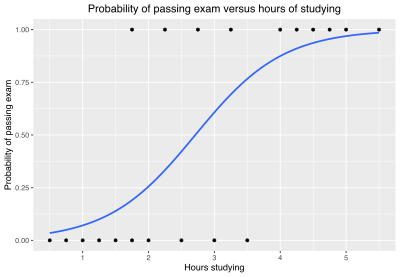

В качестве простого примера мы можем использовать логистическую регрессию с одной независимой переменной и двумя категориями, чтобы ответить на следующий вопрос:

Группа из 20 студентов тратит от 0 до 6 часов на подготовку к экзамену. Как количество часов, потраченных на обучение, влияет на вероятность сдачи студентом экзамена?

Причина использования логистической регрессии для этой задачи заключается в том, что значения зависимой переменной «пройдено» и «не пройдено», хотя и представлены «1» и «0», не являются кардинальными числами . Если бы проблема была изменена таким образом, что «прошел/не прошел» оценку от 0 до 100 (количественное число), то простой регрессионный анализ можно было бы использовать .

В таблице показано количество часов, потраченных на обучение каждым студентом, а также сведения о том, сдали ли они экзамен (1) или не сдали экзамен (0).

| Часы ( х k ) | 0.50 | 0.75 | 1.00 | 1.25 | 1.50 | 1.75 | 1.75 | 2.00 | 2.25 | 2.50 | 2.75 | 3.00 | 3.25 | 3.50 | 4.00 | 4.25 | 4.50 | 4.75 | 5.00 | 5.50 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Пас ( y k ) | 0 | 0 | 0 | 0 | 0 | 0 | 1 | 0 | 1 | 0 | 1 | 0 | 1 | 0 | 1 | 1 | 1 | 1 | 1 | 1 |

Мы хотим подогнать логистическую функцию к данным, состоящим из изученных часов ( x k ) и результатов теста ( y k =1 для прохождения, 0 для провала). Точки данных индексируются индексом k , который начинается с к . Переменная x называется « объясняющей переменной », а переменная y называется « категорической переменной », состоящей из двух категорий: «пройден» или «не пройден», соответствующих категориальным значениям 1 и 0 соответственно.

Модель [ править ]

Логистическая функция имеет вид:

где μ — параметр местоположения (середина кривой, где ) и s — параметр масштаба . Это выражение можно переписать так:

где и известен как точка пересечения (это вертикальная точка пересечения или точка пересечения по оси y линии ), и (параметр обратного масштаба или параметр скорости ): это точка пересечения по оси y и наклон логарифмических шансов как функция x . Наоборот, и .

Подходит [ править ]

Обычная мера согласия для логистической регрессии использует логистические потери (или логарифмические потери ), отрицательное логарифмическое правдоподобие . заданных xk и yk напишите Для . – это вероятности того, что соответствующие будет равняться единице и — это вероятности того, что они будут равны нулю (см. Распределение Бернулли ). Мы хотим найти значения и которые дают «наилучшее соответствие» данным. В случае линейной регрессии сумма квадратов отклонений аппроксимации от точек данных ( yk функция ), квадратичная потеря ошибки , принимается в качестве меры качества аппроксимации, и наилучшее аппроксимация получается, когда эта сведен к минимуму .

Логарифмические потери для k -й точки является:

Потеря журнала может быть интерпретирована как « неожиданность » фактического результата. относительно предсказания и является мерой содержания информации . Логарифмические потери всегда больше или равны 0, равны 0 только в случае идеального прогноза (т. е. когда и , или и ) и приближается к бесконечности по мере ухудшения прогноза (т. е. когда и или и ), что означает, что фактический результат «более неожиданный». Поскольку значение логистической функции всегда находится строго между нулем и единицей, логарифмические потери всегда больше нуля и меньше бесконечности. В отличие от линейной регрессии, где модель может иметь нулевые потери в какой-либо точке при прохождении через точку данных (и нулевые потери в целом, если все точки находятся на линии), в логистической регрессии невозможно иметь нулевые потери в любой точке. баллы, поскольку либо 0, либо 1, но .

Их можно объединить в одно выражение:

Это выражение более формально известно как перекрестная энтропия предсказанного распределения. от фактического распределения , как распределения вероятностей в двухэлементном пространстве (пройдено, не пройдено).

Их сумма, общие потери, представляет собой общую отрицательную логарифмическую вероятность. , и наилучшее соответствие получается для этих вариантов выбора и для чего сведен к минимуму .

Альтернативно, вместо минимизации потерь можно максимизировать обратную величину (положительную) логарифмическую вероятность:

или, что эквивалентно, максимизировать саму функцию правдоподобия , которая представляет собой вероятность того, что данный набор данных создается определенной логистической функцией:

Этот метод известен как оценка максимального правдоподобия .

Оценка параметров [ править ]

Поскольку ℓ нелинейно по и , определение их оптимальных значений потребует численных методов. Один из методов максимизации ℓ состоит в том, чтобы потребовать производные ℓ по отношению к и быть нулевым:

и процедура максимизации может быть выполнена путем решения двух приведенных выше уравнений для и , что опять же, как правило, потребует использования численных методов.

Значения и которые максимизируют ℓ и L с использованием приведенных выше данных:

что дает значение для µ и s :

Прогнозы [ править ]

The и Коэффициенты могут быть введены в уравнение логистической регрессии, чтобы оценить вероятность сдачи экзамена.

Например, для студента, который учится 2 часа, введя значение в уравнение дает расчетную вероятность сдачи экзамена 0,25:

Аналогично, для студента, который учится 4 часа, предполагаемая вероятность сдачи экзамена равна 0,87:

В этой таблице показана предполагаемая вероятность сдачи экзамена при нескольких значениях часов обучения.

| Часы учебы (х) | Сдача экзамена | ||

|---|---|---|---|

| Логарифм шансов (t) | Шансы (e т ) | Вероятность (р) | |

| 1 | −2.57 | 0.076 ≈ 1:13.1 | 0.07 |

| 2 | −1.07 | 0.34 ≈ 1:2.91 | 0.26 |

| 0 | 1 | = 0.50 | |

| 3 | 0.44 | 1.55 | 0.61 |

| 4 | 1.94 | 6.96 | 0.87 |

| 5 | 3.45 | 31.4 | 0.97 |

Оценка модели [ править ]

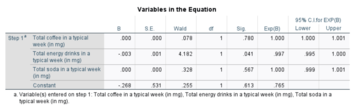

Логистический регрессионный анализ дает следующий результат.

| Коэффициент | Стандарт. Ошибка | z -значение | p -значение (Вальда) | |

|---|---|---|---|---|

| Перехват ( β 0 ) | −4.1 | 1.8 | −2.3 | 0.021 |

| Часы ( β 1 ) | 1.5 | 0.6 | 2.4 | 0.017 |

По тесту Вальда выходные данные показывают, что часы обучения значимо связаны с вероятностью сдачи экзамена ( ). Вместо метода Вальда рекомендуется использовать метод [21] Для расчета значения p для логистической регрессии используется тест отношения правдоподобия (LRT), который для этих данных дает (см. § Тесты на отклонение и отношение правдоподобия ниже).

Обобщения [ править ]

Эта простая модель является примером бинарной логистической регрессии и имеет одну объясняющую переменную и двоичную категориальную переменную, которая может принимать одно из двух категориальных значений. Полиномиальная логистическая регрессия — это обобщение бинарной логистической регрессии, включающее любое количество независимых переменных и любое количество категорий.

Предыстория [ править ]

Определение логистической функции [ править ]

Объяснение логистической регрессии можно начать с объяснения стандартной логистической функции . Логистическая функция — это сигмовидная функция , которая принимает любые реальные входные данные. и выводит значение от нуля до единицы. [2] Для логита это интерпретируется как входные логарифмические шансы и выходная вероятность . Стандартная функция логистическая определяется следующим образом:

График логистической функции на t -интервале (−6,6) показан на рисунке 1.

Предположим, что является линейной функцией одной объясняющей переменной (случай, когда представляет собой линейную комбинацию нескольких независимых переменных, рассматривается аналогично). Затем мы можем выразить следующее:

И общая логистическая функция теперь можно записать как:

В логистической модели интерпретируется как вероятность зависимой переменной что соответствует успеху/случайу, а не неудаче/неслучаю. Очевидно, что переменные ответа распределены неодинаково: отличается от одной точки данных другому, хотя они независимы, учитывая матрицу проектирования и общие параметры . [11]

Определение обратной логистической функции [ править ]

Теперь мы можем определить функцию logit (логарифм шансов) как обратную стандартной логистической функции. Легко видеть, что оно удовлетворяет:

и, что эквивалентно, после возведения в степень обеих сторон мы имеем шансы:

Интерпретация этих терминов [ править ]

В приведенных выше уравнениях члены следующие:

- это логит-функция. Уравнение для иллюстрирует, что логит (т. е. логарифм шансов или натуральный логарифм шансов) эквивалентен выражению линейной регрессии.

- обозначает натуральный логарифм .

- — это вероятность того, что зависимая переменная соответствует случаю при некоторой линейной комбинации предикторов. Формула для иллюстрирует, что вероятность того, что зависимая переменная равна случаю, равна значению логистической функции выражения линейной регрессии. Это важно тем, что показывает, что значение выражения линейной регрессии может варьироваться от отрицательной до положительной бесконечности, и тем не менее, после преобразования результирующее выражение для вероятности находится в диапазоне от 0 до 1.

- — это результат уравнения линейной регрессии (значение критерия, когда предиктор равен нулю).

- — коэффициент регрессии, умноженный на некоторое значение предиктора.

- база обозначает показательную функцию.

Определение шансов [ править ]

Вероятность того, что зависимая переменная соответствует случаю (при некоторой линейной комбинации предикторов) эквивалентна экспоненциальной функции выражения линейной регрессии. Это иллюстрирует, как логит служит функцией связи между вероятностью и выражением линейной регрессии. Учитывая, что логит находится в диапазоне от отрицательной до положительной бесконечности, он обеспечивает адекватный критерий для проведения линейной регрессии, и логит легко преобразуется обратно в шансы. [2]

Таким образом, мы определяем шансы зависимой переменной, равной случаю (при некоторой линейной комбинации предикторов) следующим образом:

Отношение шансов [ править ]

Для непрерывной независимой переменной отношение шансов можно определить как:

Изображение представляет собой схему того, как соотношение шансов выглядит в письменной форме, с помощью шаблона в дополнение к примеру результатов теста в разделе «Пример» содержания. Проще говоря, если мы гипотетически получим отношение шансов 2 к 1, мы можем сказать... «Для каждого увеличения количества изучаемых часов на одну единицу шансы сдать (группа 1) или провалить (группа 0) (ожидаемо) ) 2 к 1 (Денис, 2019).

Эта экспоненциальная зависимость дает интерпретацию : Шансы умножаются на за каждое увеличение x на 1 единицу. [22]

Для двоичной независимой переменной отношение шансов определяется как где a , b , c и d — ячейки в таблице сопряженности 2×2 . [23]

Несколько независимых переменных [ править ]

Если имеется несколько независимых переменных, приведенное выше выражение может быть пересмотрено на . Затем, когда это используется в уравнении, связывающем логарифм шансов успеха со значениями предикторов, линейная регрессия будет множественной регрессией с m объяснителями; параметры для всех все оценены.

Опять же, более традиционные уравнения:

и

где обычно .

Определение [ править ]

Набор данных содержит N точек. Каждая точка i состоит из набора m входных переменных x 1, i ... x m,i (также называемых независимыми переменными , объясняющими переменными, переменными-предикторами, признаками или атрибутами) и двоичной выходной переменной Y i (также известной как как зависимая переменная , переменная ответа, выходная переменная или класс), т. е. она может принимать только два возможных значения: 0 (часто означает «нет» или «неудача») или 1 (часто означает «да» или «успех»). Цель логистической регрессии — использовать набор данных для создания прогнозной модели результирующей переменной.

переменные результата Y i Как и в линейной регрессии, предполагается, что зависят от объясняющих переменных x 1, i ... x m,i .

- Независимые переменные

Независимые переменные могут быть любого типа : действительные , двоичные , категориальные и т. д. Основное различие заключается в непрерывных переменных и дискретных переменных .

(Дискретные переменные, относящиеся к более чем двум возможным вариантам выбора, обычно кодируются с использованием фиктивных переменных (или индикаторных переменных ), то есть для каждого возможного значения дискретной переменной создаются отдельные объясняющие переменные, принимающие значение 0 или 1, причем 1 означает « переменная имеет заданное значение», а 0 означает «переменная не имеет этого значения».)

- Итоговые переменные

Формально результаты Y i описываются как данные , распределенные по Бернулли , где каждый результат определяется ненаблюдаемой вероятностью p i , которая специфична для рассматриваемого результата, но связана с объясняющими переменными. Это может быть выражено в любой из следующих эквивалентных форм:

Значения этих четырех строк таковы:

- Первая строка выражает распределение вероятностей каждого Y i : при условии объясняющих переменных оно соответствует распределению Бернулли с параметрами pi , вероятностью результата 1 для испытания i . Как отмечалось выше, каждое отдельное испытание имеет свою вероятность успеха, так же как каждое испытание имеет свои собственные объясняющие переменные. Вероятность успеха p i не наблюдается, а только результат отдельного испытания Бернулли с использованием этой вероятности.

- Вторая строка выражает тот факт, что ожидаемое значение каждого Y i равно вероятности успеха p i , что является общим свойством распределения Бернулли. Другими словами, если мы проведем большое количество испытаний Бернулли, используя одну и ту же вероятность успеха i , а затем возьмем среднее значение всех исходов 1 и 0, то результат будет близок к pi . p Это связано с тем, что при таком усреднении просто вычисляется доля видимых успехов, которая, как мы ожидаем, будет сходиться с основной вероятностью успеха.

- Третья строка записывает функцию массы вероятности распределения Бернулли, определяющую вероятность увидеть каждый из двух возможных результатов.

- Четвертая строка — это еще один способ записи функции массы вероятности, который позволяет избежать написания отдельных случаев и более удобен для определенных типов вычислений. Это основано на том, что Y i может принимать только значение 0 или 1. В каждом случае один из показателей степени будет равен 1, «выбирая» значение под ним, а другой равен 0, «отменяя» значение под ним. это. Следовательно, результатом будет либо p i, либо 1 − p i , как в предыдущей строке.

- Функция линейного прогнозирования

Основная идея логистической регрессии заключается в использовании механизма, уже разработанного для линейной регрессии , путем моделирования вероятности p i с использованием линейной предикторной функции , то есть линейной комбинации объясняющих переменных и набора коэффициентов регрессии , специфичных для рассматриваемой модели. но то же самое для всех испытаний. Функция линейного предиктора для конкретной точки данных i записывается как:

где представляют собой коэффициенты регрессии , указывающие относительное влияние конкретной объясняющей переменной на результат.

Модель обычно придают более компактную форму следующим образом:

- Коэффициенты регрессии β 0 , β 1 , ..., β m группируются в один вектор β размера m + 1.

- Для каждой точки данных i добавляется дополнительная поясняющая псевдопеременная x 0, i с фиксированным значением 1, соответствующим пересечения коэффициенту β 0 .

- Полученные объясняющие переменные x 0, i , x 1, i , ..., x m,i затем группируются в один вектор X i размера m + 1.

Это позволяет записать функцию линейного предиктора следующим образом:

используя обозначение скалярного произведения между двумя векторами.

, две категории Множество независимых переменных

Приведенный выше пример бинарной логистической регрессии с одной независимой переменной можно обобщить до бинарной логистической регрессии с любым количеством объясняющих переменных x 1 , x 2 ,... и любым количеством категориальных значений. .

Для начала мы можем рассмотреть логистическую модель с M объясняющими переменными x 1 , x 2 ... x M и, как в приведенном выше примере, двумя категориальными значениями ( y = 0 и 1). Для простой модели бинарной логистической регрессии мы предположили линейную связь между переменной-предиктором и логарифмом шансов (также называемым logit ) события, которое . Эту линейную зависимость можно распространить на случай M объясняющих переменных:

где t - логарифм шансов и являются параметрами модели. Введено дополнительное обобщение, в котором база модели ( b ) не ограничивается числом Эйлера e . В большинстве приложений база логарифма обычно принимается равным e . Однако в некоторых случаях может быть проще сообщить результаты, работая по основанию 2 или 10.

Для более компактных обозначений мы зададим объясняющие переменные и коэффициенты β как -мерные векторы:

с добавленной объясняющей переменной x 0 =1. Логит теперь может быть записан как:

Решая вероятность p, что дает:

- ,

где это сигмовидная функция с основанием . Приведенная выше формула показывает, что как только фиксированы, мы можем легко вычислить либо логарифмические шансы, которые для данного наблюдения или вероятность того, что для данного наблюдения. Основной вариант использования логистической модели — это наблюдение. , и оценим вероятность что . Оптимальные бета-коэффициенты снова могут быть найдены путем максимизации логарифмического правдоподобия. Для измерений K , определяющих как объясняющий вектор k -го измерения, и В качестве категориального результата этого измерения логарифм правдоподобия может быть записан в форме, очень похожей на простую случай выше:

Как и в простом примере выше, для поиска оптимальных параметров β потребуются численные методы. Одним из полезных методов является приравнивание производных логарифмического правдоподобия по каждому из параметров β нулю, что дает набор уравнений, которые будут выполняться при максимуме логарифмического правдоподобия:

где x mk — значение объясняющей переменной x m по k-му измерению.

Рассмотрим пример с объясняющие переменные, , и коэффициенты , , и которые были определены вышеуказанным методом. Если быть более конкретным, то модель такова:

- ,

где p — вероятность того, что событие . Это можно интерпретировать следующим образом:

- это y -перехват . Это лог-шанс события, которое , когда предсказатели . Возведя в степень, мы можем увидеть, что когда вероятность того, что событие имеют значения от 1 до 1000, или . Аналогично, вероятность события, которое когда может быть вычислено как

- означает, что увеличение на 1 увеличивает логарифмические шансы на . Итак, если увеличивается на 1, вероятность того, что увеличиться в раз . Вероятность также увеличилось, но не настолько, насколько увеличились шансы.

- означает, что увеличение на 1 увеличивает логарифмические шансы на . Итак, если увеличивается на 1, вероятность того, что увеличиться в раз Обратите внимание, как эффект на логарифмические шансы в два раза больше, чем эффект , но влияние на шансы в 10 раз больше. влияние на вероятность Но не в 10 раз больше, просто влияние на шансы в 10 раз больше.

логистическая регрессия: множество независимых переменных и категорий множество Полиномиальная

В приведенных выше случаях двух категорий (биномиальная логистическая регрессия) категории были проиндексированы «0» и «1», и у нас было две вероятности: вероятность того, что результат находился в категории 1, определялась выражением а вероятность того, что результат относился к категории 0, определялась выражением . Сумма этих вероятностей равна 1, что должно быть правдой, поскольку «0» и «1» — единственные возможные категории в этой настройке.

В общем, если у нас есть объясняющие переменные (включая x 0 ) и категории, нам понадобится отдельные вероятности, по одной для каждой категории, индексированные n , которые описывают вероятность того, что категориальный результат y будет в категории y=n , зависящей от вектора ковариат x . Сумма этих вероятностей по всем категориям должна равняться 1. Используя математически удобную базу e , эти вероятности равны:

- для

Каждая из вероятностей, кроме будет иметь свой собственный набор коэффициентов регрессии . Видно, что, как и требовалось, сумма по всем категориям n равно 1. Выбор определяться в терминах других вероятностей искусственно. Любая из вероятностей могла быть выбрана для такого определения. Это особое значение n называется «индексом поворота», а логарифмические шансы ( t n ) выражаются через вероятность поворота и снова выражаются как линейная комбинация объясняющих переменных:

Отметим также, что для простого случая , восстанавливается случай двух категорий, при этом и .

Теперь можно вычислить логарифмическую вероятность того, что конкретный набор K измерений или точек данных будет сгенерирован вышеуказанными вероятностями. Индексируя каждое измерение индексом k , обозначим k -й набор измеряемых независимых переменных через и их категориальные результаты обозначаются через которое может быть равно любому целому числу из [0,N]. Логарифмическая вероятность тогда равна:

где – индикаторная функция , равная 1, если y k = n , и нулю в противном случае. В случае двух объясняющих переменных эта индикаторная функция определялась как y k при n = 1 и 1-y k при n = 0. Это было удобно, но не обязательно. [24] Опять же, оптимальные бета-коэффициенты могут быть найдены путем максимизации логарифмической функции правдоподобия, обычно с использованием численных методов. Возможный метод решения состоит в том, чтобы установить производные логарифмического правдоподобия по каждому бета-коэффициенту равными нулю и найти бета-коэффициенты:

где - m -й коэффициент вектор и – m -я объясняющая переменная k -го измерения. Как только бета-коэффициенты будут оценены на основе данных, мы сможем оценить вероятность того, что любой последующий набор объясняющих переменных приведет к любой из возможных категорий результатов.

Интерпретации [ править ]

Существуют различные эквивалентные спецификации и интерпретации логистической регрессии, которые вписываются в разные типы более общих моделей и допускают различные обобщения.

Как обобщенная линейная модель [ править ]

Конкретная модель, используемая логистической регрессией, которая отличает ее от стандартной линейной регрессии и от других типов регрессионного анализа, используемых для двоичных результатов, представляет собой способ, которым вероятность конкретного результата связана с функцией линейного предиктора:

Написанное с использованием более компактной записи, описанной выше, это:

Эта формулировка выражает логистическую регрессию как тип обобщенной линейной модели , которая предсказывает переменные с различными типами распределений вероятностей путем подгонки линейной предикторной функции вышеуказанной формы к некоторому произвольному преобразованию ожидаемого значения переменной.

Интуитивный подход к преобразованию с использованием функции логит (натуральный логарифм шансов) был объяснен выше. [ нужны разъяснения ] . Это также имеет практический эффект преобразования вероятности (которая ограничена диапазоном от 0 до 1) в переменную, которая находится в диапазоне более — тем самым сопоставляя потенциальный диапазон функции линейного прогнозирования в правой части уравнения.

И вероятности pi , и коэффициенты регрессии не наблюдаются, и средства их определения не являются частью самой модели. Обычно они определяются с помощью какой-либо процедуры оптимизации, например, оценки максимального правдоподобия , которая находит значения, которые лучше всего соответствуют наблюдаемым данным (т. е. которые дают наиболее точные прогнозы для уже наблюдаемых данных), обычно с учетом условий регуляризации , которые стремятся исключить маловероятные данные. значения, например чрезвычайно большие значения для любого из коэффициентов регрессии. Использование условия регуляризации эквивалентно выполнению максимальной апостериорной оценки (MAP), что является расширением метода максимального правдоподобия. (Регуляризация чаще всего выполняется с использованием квадратичной функции регуляризации , которая эквивалентна размещению Гаусса априорного распределения с нулевым средним на коэффициентах, но возможны и другие регуляризаторы.) Независимо от того, используется ли регуляризация, обычно невозможно найти решение закрытой формы; вместо этого необходимо использовать итерационный численный метод, например итеративно перевзвешенный метод наименьших квадратов (IRLS) или, что чаще встречается в наши дни, квазиньютоновский метод , такой как метод L-BFGS . [25]

Интерпретация оценок параметра β j заключается в аддитивном влиянии на логарифм шансов единичного изменения j объясняющей переменной . В случае дихотомической объясняющей переменной, например, пола — это оценка шансов на достижение результата, скажем, для мужчин по сравнению с женщинами.

Эквивалентная формула использует обратную функцию логит, которая является логистической функцией , т.е.:

Формулу также можно записать в виде распределения вероятностей (в частности, с использованием функции массы вероятности ):

Как модель переменными скрытыми со

Логистическая модель имеет эквивалентную формулировку как модель со скрытыми переменными . Эта формулировка распространена в теории моделей дискретного выбора и позволяет легко расширить ее до некоторых более сложных моделей с множественным коррелированным выбором, а также сравнить логистическую регрессию с тесно связанной пробит-моделью .

Представьте, что для каждого испытания i существует непрерывная латентная переменная Y i * (т.е. ненаблюдаемая случайная величина ), которая распределяется следующим образом:

где

т.е. скрытая переменная может быть записана непосредственно через функцию линейного прогнозирования и аддитивную переменную случайной ошибки , которая распределяется в соответствии со стандартным логистическим распределением .

Тогда Y i можно рассматривать как индикатор того, является ли эта скрытая переменная положительной:

Выбор моделирования переменной ошибки именно со стандартным логистическим распределением, а не с общим логистическим распределением с произвольными значениями местоположения и масштаба, кажется ограничительным, но на самом деле это не так. Следует иметь в виду, что мы можем сами выбирать коэффициенты регрессии и очень часто можем использовать их для компенсации изменений параметров распределения переменной ошибки. Например, распределение логистической переменной ошибки с ненулевым параметром местоположения ц (который устанавливает среднее значение) эквивалентно распределению с нулевым параметром местоположения, где ц был добавлен к коэффициенту пересечения. Обе ситуации дают одно и то же значение Y i * независимо от настроек объясняющих переменных. Аналогично, произвольный параметр масштабирования s эквивалентен установке параметра масштаба на 1, а затем делению всех коэффициентов регрессии на s . В последнем случае результирующее значение Y i * раз меньше, будет в s чем в первом случае, для всех наборов объясняющих переменных, но, что особенно важно, он всегда будет оставаться по ту же сторону от 0 и, следовательно, приведет к одному и тому же Y i выбору .

(Это предсказывает, что нерелевантность параметра масштаба может не распространяться на более сложные модели, в которых доступно более двух вариантов.)

Оказывается, эта формулировка в точности эквивалентна предыдущей, сформулированной в терминах обобщенной линейной модели и без каких-либо скрытых переменных . Это можно показать следующим образом, используя тот факт, что кумулятивная функция распределения (CDF) стандартного логистического распределения представляет собой логистическую функцию , которая является обратной логит-функцией , т.е.

Затем:

Эта формулировка, которая является стандартной в моделях дискретного выбора , проясняет связь между логистической регрессией («логит-моделью») и пробит-моделью , которая использует переменную ошибки, распределенную в соответствии со стандартным нормальным распределением вместо стандартного логистического распределения. И логистическое, и нормальное распределения симметричны и имеют базовую унимодальную форму «колокола». Единственное отличие состоит в том, что логистическое распределение имеет несколько более тяжелые хвосты , что означает, что оно менее чувствительно к посторонним данным (и, следовательно, несколько более устойчиво к моделированию неправильных спецификаций или ошибочных данных).

Двусторонняя модель переменными скрытыми со

Еще одна формулировка использует две отдельные скрытые переменные:

где

где EV 1 (0,1) — стандартное распределение экстремальных значений типа 1 : т.е.

Затем

Эта модель имеет отдельную скрытую переменную и отдельный набор коэффициентов регрессии для каждого возможного результата зависимой переменной. Причина такого разделения в том, что оно позволяет легко распространить логистическую регрессию на категориальные переменные с несколькими исходами, как в полиномиальной логит- модели. В такой модели естественно моделировать каждый возможный результат, используя другой набор коэффициентов регрессии. Также возможно мотивировать каждую из отдельных скрытых переменных как теоретическую полезность, связанную с совершением соответствующего выбора, и, таким образом, мотивировать логистическую регрессию с точки зрения теории полезности . (С точки зрения теории полезности, рациональный субъект всегда выбирает выбор с наибольшей связанной с ним полезностью.) Это подход, используемый экономистами при формулировании моделей дискретного выбора , поскольку он одновременно обеспечивает теоретически прочную основу и облегчает интуитивное представление о модели, которая в свою очередь, позволяет легко рассматривать различные виды расширений. (См. пример ниже.)

Выбор распределения экстремальных значений типа 1 кажется довольно произвольным, но он заставляет математически работать, и его использование может быть возможно оправдать с помощью теории рационального выбора .

Оказывается, эта модель эквивалентна предыдущей модели, хотя это кажется неочевидным, поскольку теперь существует два набора коэффициентов регрессии и переменных ошибок, а переменные ошибок имеют другое распределение. Фактически эта модель сводится непосредственно к предыдущей со следующими заменами:

Интуитивное понимание этого исходит из того факта, что, поскольку мы выбираем, основываясь максимум на двух значениях, имеет значение только их разница, а не точные значения — и это эффективно удаляет одну степень свободы . Другим важным фактом является то, что разница двух переменных с распределением экстремальных значений типа 1 представляет собой логистическое распределение, т.е. Мы можем продемонстрировать эквивалент следующим образом:

Пример [ править ]

Этот пример , возможно, содержит оригинальное исследование . ( Май 2022 г. )

Этот пример , возможно, содержит оригинальное исследование . ( Май 2022 г. )

В качестве примера рассмотрим выборы на уровне провинции, на которых стоит выбор между правоцентристской партией, левоцентристской партией и сепаратистской партией (например, Квебекская партия , которая хочет Квебека отделения от Канады ). Затем мы использовали бы три скрытых переменных, по одной для каждого выбора. Затем, в соответствии с теорией полезности , мы можем интерпретировать скрытые переменные как выражение полезности , возникающей в результате каждого из выборов. Мы также можем интерпретировать коэффициенты регрессии как указывающие на силу, которую связанный фактор (т. е. объясняющая переменная) оказывает на полезность — или, точнее, на величину, на которую изменение единицы объясняющей переменной меняет полезность данного выбора. Избиратель мог бы ожидать, что правоцентристская партия снизит налоги, особенно для богатых людей. Это не дало бы людям с низкими доходами никакой выгоды, т.е. никакого изменения в полезности (поскольку они обычно не платят налоги); принесет умеренную выгоду (т.е. несколько больше денег или умеренное увеличение полезности) для людей со средним доходом; принесет значительные выгоды людям с высокими доходами. С другой стороны, можно было бы ожидать, что левоцентристская партия повысит налоги и компенсирует это повышением благосостояния и другой помощью для низших и средних классов. Это принесет значительную положительную выгоду людям с низкими доходами, возможно, слабую выгоду людям со средним доходом и значительную отрицательную выгоду людям с высокими доходами. Наконец, сепаратистская партия не будет предпринимать прямых действий в отношении экономики, а просто отделится. Избиратель с низким или средним доходом может не ожидать от этого явного выигрыша или убытка от полезности, но избиратель с высоким доходом может ожидать отрицательной полезности, поскольку он/она, скорее всего, будет владеть компаниями, которым будет труднее вести бизнес в стране. такая среда и, вероятно, потеряете деньги.

Эти интуиции можно выразить следующим образом:

| Правоцентристский | левоцентристский | сепаратист | |

|---|---|---|---|

| Высокий доход | сильный + | сильный — | сильный — |

| Средний доход | умеренный + | слабый + | никто |

| Низкий доход | никто | сильный + | никто |

Это ясно показывает, что

- Для каждого выбора должны существовать отдельные наборы коэффициентов регрессии. Если говорить с точки зрения полезности, это можно увидеть очень легко. Разные варианты выбора по-разному влияют на чистую полезность; более того, эффекты варьируются сложным образом и зависят от характеристик каждого человека, поэтому для каждой характеристики должны быть отдельные наборы коэффициентов, а не просто одна дополнительная характеристика для каждого выбора.

- Хотя доход является непрерывной переменной, его влияние на полезность слишком сложно, чтобы его можно было рассматривать как одну переменную. Либо его необходимо напрямую разделить на диапазоны, либо необходимо добавить более высокие степени дохода, чтобы полиномиальную регрессию по доходу. эффективно выполнить

Как «логарифмически-линейная» модель [ править ]

Еще одна формулировка объединяет приведенную выше формулировку двусторонней скрытой переменной с исходной формулировкой выше без скрытых переменных и в процессе обеспечивает ссылку на одну из стандартных формулировок полиномиального логита .

Здесь вместо того, чтобы записывать логит вероятностей pi : как линейный предиктор, мы разделяем линейный предиктор на два, по одному для каждого из двух результатов

Были введены два отдельных набора коэффициентов регрессии, как и в модели двусторонней скрытой переменной, и два уравнения имеют форму, которая записывает логарифм связанной вероятности как линейный предиктор с дополнительным членом. в конце. Этот член, как выясняется, служит нормирующим фактором, гарантирующим, что результат является распределением. Это можно увидеть, возведя в степень обе стороны:

В этой форме ясно, что цель Z состоит в том, чтобы гарантировать, что результирующее распределение по Y i на самом деле является распределением вероятностей , т. е. его сумма равна 1. Это означает, что Z является просто суммой всех ненормализованных вероятностей, и разделив каждую вероятность на Z , вероятности становятся « нормализованными ». То есть:

и полученные уравнения имеют вид

Или вообще:

Это ясно показывает, как обобщить эту формулировку на более чем два результата, как в случае с полиномиальным логитом .Эта общая формулировка представляет собой в точности функцию softmax, как в

Чтобы доказать, что это эквивалентно предыдущей модели, приведенная выше модель слишком конкретизирована, поскольку и не может быть указано независимо: скорее поэтому знание одного автоматически определяет другое. В результате модель становится неидентифицируемой , поскольку множественные комбинации β 0 и β 1 будут давать одинаковые вероятности для всех возможных объясняющих переменных. Фактически, можно видеть, что добавление любого постоянного вектора к ним обоим даст одинаковые вероятности:

В результате мы можем упростить ситуацию и восстановить идентифицируемость, выбрав произвольное значение для одного из двух векторов. Мы решили установить Затем,

и так

что показывает, что эта формулировка действительно эквивалентна предыдущей формулировке. (Как и в формулировке двусторонней латентной переменной, любые настройки, в которых даст эквивалентные результаты.)

Большинство трактовок полиномиальной логит- модели начинаются либо с расширения представленной здесь «логарифмически-линейной» формулировки, либо с формулировки двусторонней латентной переменной, представленной выше, поскольку обе ясно показывают, как модель может быть расширена до многосторонних результатов. В целом представление со скрытыми переменными более распространено в эконометрике и политологии , где дискретного выбора господствуют модели и теория полезности , тогда как «логарифмически-линейная» формулировка здесь более распространена в информатике , например, в машинном обучении и обработке естественного языка .

Как однослойный перцептрон [ править ]

Модель имеет эквивалентную формулировку

Эту функциональную форму обычно называют однослойным перцептроном или однослойной искусственной нейронной сетью . Однослойная нейронная сеть вычисляет непрерывный результат вместо ступенчатой функции . Производная p i по X = ( x 1 , ..., x k ) вычисляется по общей форме:

где f ( X ) — функция от X. аналитическая При таком выборе однослойная нейронная сеть идентична модели логистической регрессии. Эта функция имеет непрерывную производную, что позволяет использовать ее в обратном распространении ошибки . Эта функция предпочтительна еще и потому, что ее производная легко вычисляется:

С точки биномиальных зрения данных

Тесно связанная модель предполагает, что каждое i связано не с одним испытанием Бернулли, а с n i независимыми одинаково распределенными испытаниями, где наблюдение Y i представляет собой количество наблюдаемых успехов (сумма отдельных случайных величин с распределением Бернулли), и отсюда следует биномиальное распределение :

Примером такого распределения является доля семян ( pi ) , которые прорастают после n i посадки .

С точки зрения ожидаемых значений эта модель выражается следующим образом:

так что

Или эквивалентно:

Эта модель может быть адаптирована с использованием тех же методов, что и приведенная выше более базовая модель.

Примерка модели [ править ]

Оценка максимального правдоподобия (MLE) [ править ]

Коэффициенты регрессии обычно оцениваются с использованием оценки максимального правдоподобия . [26] [27] В отличие от линейной регрессии с нормально распределенными остатками, невозможно найти выражение в замкнутой форме для значений коэффициентов, которые максимизируют функцию правдоподобия, поэтому вместо этого необходимо использовать итерационный процесс; например метод Ньютона . Этот процесс начинается с предварительного решения, его слегка пересматривают, чтобы увидеть, можно ли его улучшить, и повторяют этот пересмотр до тех пор, пока улучшения не перестанут вноситься, после чего говорят, что процесс сошелся. [26]

В некоторых случаях модель может не достичь сходимости. Несходимость модели указывает на то, что коэффициенты не имеют смысла, поскольку итерационный процесс не смог найти подходящие решения. Неспособность сходиться может произойти по ряду причин: большое соотношение предикторов к случаям, мультиколлинеарность , разреженность или полное разделение .

- Большое соотношение переменных к случаям приводит к чрезмерно консервативной статистике Вальда (обсуждается ниже) и может привести к несходимости. Регуляризованная логистическая регрессия специально предназначена для использования в этой ситуации.

- Мультиколлинеарность относится к неприемлемо высоким корреляциям между предикторами. По мере увеличения мультиколлинеарности коэффициенты остаются несмещенными, но стандартные ошибки увеличиваются, а вероятность сходимости модели снижается. [26] Чтобы обнаружить мультиколлинеарность среди предикторов, можно провести линейный регрессионный анализ с интересующими предикторами с единственной целью - изучить статистику толерантности. [26] используется для оценки того, является ли мультиколлинеарность неприемлемо высокой.

- Разреженность данных означает наличие большой доли пустых ячеек (ячейок с нулевым количеством). Нулевое количество ячеек особенно проблематично для категориальных предикторов. При использовании непрерывных предикторов модель может выводить значения для нулевого количества ячеек, но это не относится к категориальным предикторам. Модель не будет сходиться с нулевым количеством ячеек для категориальных предикторов, поскольку натуральный логарифм нуля является неопределенным значением, поэтому окончательное решение модели не может быть достигнуто. Чтобы решить эту проблему, исследователи могут сжимать категории теоретически осмысленным способом или добавлять константы во все ячейки. [26]

- Другая численная проблема, которая может привести к отсутствию сходимости, — это полное разделение, которое относится к случаю, когда предикторы идеально предсказывают критерий — все случаи точно классифицируются, а вероятность максимизируется с помощью бесконечных коэффициентов. В таких случаях следует перепроверить данные, так как может быть какая-то ошибка. [2] [ нужны дальнейшие объяснения ]

- Можно также использовать полупараметрические или непараметрические подходы, например, с помощью методов локального правдоподобия или непараметрических методов квазиправдоподобия, которые избегают предположений о параметрической форме индексной функции и устойчивы к выбору функции связи (например, пробит или логит). [28]

метод наименьших квадратов (IRLS Итеративно перевзвешенный )

Бинарная логистическая регрессия ( или ) можно, например, рассчитать с помощью итеративно перевзвешенного метода наименьших квадратов (IRLS), что эквивалентно максимизации логарифмического правдоподобия распределенного процесса Бернулли с использованием метода Ньютона . Если задача записана в виде векторной матрицы, с параметрами , объясняющие переменные и ожидаемое значение распределения Бернулли , параметры можно найти с помощью следующего итерационного алгоритма:

где - диагональная весовая матрица, вектор ожидаемых значений,

Матрица регрессора и вектор переменных ответа. Более подробную информацию можно найти в литературе. [29]

Байесовский [ править ]

В байесовской статистики контексте априорные распределения обычно помещаются в коэффициенты регрессии, например, в форме распределений Гаусса . В логистической регрессии не существует сопряженной априорной функции правдоподобия . Когда байесовский вывод выполнялся аналитически, это затрудняло апостериорного распределения вычисление , за исключением очень малых размерностей. Однако теперь автоматическое программное обеспечение, такое как OpenBUGS , JAGS , PyMC , Stan или Turing.jl, позволяет вычислять эти апостериорные данные с помощью моделирования, поэтому отсутствие сопряжения не является проблемой. Однако, когда размер выборки или количество параметров велики, полное байесовское моделирование может быть медленным, и люди часто используют приближенные методы, такие как вариационные байесовские методы и распространение ожиданий .

«Правило десяти» [ править ]

Широко используемое правило « одного из десяти » гласит, что модели логистической регрессии дают стабильные значения для объясняющих переменных, если они основаны как минимум на примерно 10 событиях на каждую объясняющую переменную (EPV); где событие обозначает случаи, относящиеся к менее частой категории зависимой переменной. Таким образом, исследование, предназначенное для использования объясняющие переменные для события (например, инфаркта миокарда ), которое, как ожидается, произойдет в определенной пропорции участников исследования потребуется в общей сложности участники. Однако ведутся серьезные споры о надежности этого правила, которое основано на исследованиях моделирования и не имеет надежного теоретического обоснования. [30] По мнению некоторых авторов [31] в некоторых обстоятельствах это правило является чрезмерно консервативным: авторы заявляют: «Если мы (несколько субъективно) считаем, что охват доверительного интервала менее 93 процентов, ошибка типа I более 7 процентов или относительное смещение более 15 процентов как проблематичные, наши результаты указывают на то, что проблемы возникают довольно часто при 2–4 EPV, редко при 5–9 EPV и все еще наблюдаются при 10–16 EPV. Худшие случаи каждой проблемы не были серьезными при 5–9 EPV и обычно сравнимы с таковыми при 10–. 16 ЭПВ». [32]

Другие нашли результаты, которые не соответствуют вышеизложенному, используя другие критерии. Полезным критерием является то, можно ли ожидать, что подобранная модель обеспечит такую же прогностическую дискриминацию в новой выборке, какую она, по-видимому, достигла в выборке для разработки модели. Для этого критерия может потребоваться 20 событий на каждую переменную-кандидата. [33] Кроме того, можно утверждать, что 96 наблюдений необходимы только для того, чтобы оценить точку пересечения модели достаточно точно, чтобы погрешность прогнозируемых вероятностей составляла ± 0,1 с уровнем достоверности 0,95. [13]

Ошибка и значение соответствия [ править ]

Тест на отклонение и отношение правдоподобия ─ простой случай [ править ]

В любой процедуре подбора добавление в модель другого параметра подбора (например, бета-параметров в модели логистической регрессии) почти всегда улучшает способность модели прогнозировать измеренные результаты. Это будет верно, даже если дополнительный член не имеет прогностической ценности, поскольку модель просто будет « подстраиваться » под шум в данных. Возникает вопрос о том, является ли улучшение, полученное за счет добавления другого подходящего параметра, достаточно значительным, чтобы рекомендовать включение дополнительного термина, или же улучшение является просто тем, которого можно ожидать от переобучения.

Короче говоря, для логистической регрессии определяется статистика, известная как отклонение , которая является мерой ошибки между подгонкой логистической модели и данными результатов. В пределе большого количества точек данных отклонение распределяется по хи-квадрату , что позволяет реализовать тест хи-квадрат для определения значимости объясняющих переменных.

Линейная регрессия и логистическая регрессия имеют много общего. Например, в простой линейной регрессии набор K точек данных ( x k , y k ) соответствует предложенной модельной функции формы . Подбор достигается путем выбора параметров b , которые минимизируют сумму квадратов остатков (квадрат ошибки) для каждой точки данных:

Минимальное значение, составляющее соответствие, будет обозначаться

Можно ввести идею нулевой модели , в которой предполагается, что переменная x бесполезна для прогнозирования результатов y k : точки данных подгоняются к нулевой функции модели формы y = b 0 с квадратом термин ошибки:

Процесс аппроксимации состоит в выборе значения b 0, которое минимизирует соответствия нулевой модели, обозначаемой где нижний индекс обозначает нулевую модель. Видно, что нулевая модель оптимизирована путем где — среднее значение y k , а оптимизированное является:

который пропорционален квадрату (нескорректированного) выборочного стандартного отклонения точек данных y k .

Мы можем представить себе случай, когда точки данных y k случайным образом присваиваются различным x k , а затем подбираются с использованием предложенной модели. рассмотреть соответствие предлагаемой модели каждой перестановке результатов yk В частности, мы можем . Можно показать, что оптимизированная ошибка любой из этих подгонок никогда не будет меньше оптимальной ошибки нулевой модели, и что разница между этими минимальными ошибками будет подчиняться распределению хи-квадрат со степенями свободы, равными степеням свободы модели. предлагаемой модели минус значения нулевой модели, которые в данном случае будут . Используя критерий хи-квадрат , мы можем затем оценить, сколько из этих перестановочных наборов y k дадут минимальную ошибку, меньшую или равную минимальной ошибке, используя исходный y k , и таким образом мы можем оценить, насколько существенное улучшение дается. путем включения переменной x в предлагаемую модель.

Для логистической регрессии мерой согласия является функция правдоподобия L или ее логарифм, логарифмическое правдоподобие ℓ . Функция правдоподобия L аналогична в случае линейной регрессии, за исключением того, что вероятность максимизируется, а не минимизируется. Обозначим максимальное логарифмическое правдоподобие предлагаемой модели через .

В случае простой бинарной логистической регрессии набор K точек данных в вероятностном смысле подгоняется к функции вида:

где это вероятность того, что . Логарифмические шансы определяются следующим образом:

и логарифмическая вероятность равна:

Для нулевой модели вероятность того, что дается:

Логарифмические шансы для нулевой модели определяются следующим образом:

и логарифмическая вероятность равна:

Поскольку у нас есть при максимуме L максимальное логарифмическое правдоподобие для нулевой модели равно

Оптимум является:

где снова является средним значением y k . Опять же, мы можем концептуально рассмотреть соответствие предлагаемой модели каждой перестановке y k и можно показать, что максимальная логарифмическая вероятность этих подгонок перестановок никогда не будет меньше, чем у нулевой модели:

Кроме того, как аналог ошибки в случае линейной регрессии, мы можем определить отклонение подгонки логистической регрессии как:

который всегда будет положительным или нулевым. Причина такого выбора заключается в том, что отклонение не только является хорошей мерой степени соответствия, но также имеет приблизительное распределение хи-квадрат, причем аппроксимация улучшается по мере увеличения числа точек данных ( K ), становясь в точности хи-квадратом. распределены в пределах бесконечного числа точек данных. Как и в случае линейной регрессии, мы можем использовать этот факт для оценки вероятности того, что случайный набор точек данных даст лучшее соответствие, чем соответствие, полученное с помощью предложенной модели, и, таким образом, оценить, насколько значительно модель улучшится за счет включая точки данных x k в предлагаемой модели.

Для простой модели результатов тестов учащихся, описанной выше, максимальное значение логарифмического правдоподобия нулевой модели равно Максимальное значение логарифмического правдоподобия для простой модели равно так что отклонение

Используя критерий значимости хи-квадрат , интеграл распределения хи-квадрат с одной степенью свободы от 11,6661... до бесконечности равен 0,00063649...

что около 6 из 10 000 подгонок случайного y k Фактически это означает, что можно ожидать, будут иметь лучшее соответствие (меньшее отклонение), чем заданный y k , и поэтому мы можем заключить, что включение переменной x и данных в предлагаемую модель это очень значительное улучшение по сравнению с нулевой моделью. Другими словами, мы отвергаем нулевую гипотезу с уверенность.

Краткое описание соответствия [ править ]

Степень соответствия в моделях линейной регрессии обычно измеряется с помощью R 2 . Поскольку это не имеет прямого аналога в логистической регрессии, различные методы [34] : гл.21 вместо этого можно использовать следующее.

отклонение и правдоподобия Тесты на отношение

В анализе линейной регрессии речь идет о разделении дисперсии посредством вычислений суммы квадратов - дисперсия критерия по существу делится на дисперсию, учитываемую предикторами, и остаточную дисперсию. В логистическом регрессионном анализе отклонение используется вместо вычислений суммы квадратов. [35] Отклонение аналогично расчетам суммы квадратов в линейной регрессии. [2] и является мерой несоответствия данных в модели логистической регрессии. [35] Когда доступна «насыщенная» модель (модель с теоретически идеальным соответствием), отклонение рассчитывается путем сравнения данной модели с насыщенной моделью. [2] Это вычисление дает тест отношения правдоподобия : [2]

В приведенном выше уравнении D представляет отклонение, а ln представляет натуральный логарифм. Логарифм этого отношения правдоподобия (отношение подобранной модели к насыщенной модели) даст отрицательное значение, следовательно, необходим отрицательный знак. D Можно показать, что соответствует приблизительному распределению хи-квадрат . [2] Меньшие значения указывают на лучшее соответствие, поскольку подобранная модель меньше отклоняется от насыщенной модели. При оценке по распределению хи-квадрат незначительные значения хи-квадрат указывают на очень небольшую необъяснимую дисперсию и, следовательно, на хорошее соответствие модели. И наоборот, значительное значение хи-квадрат указывает на то, что значительная часть дисперсии необъяснима.

Когда насыщенная модель недоступна (обычный случай), отклонение рассчитывается просто как -2 · (логарифм правдоподобия подобранной модели), и ссылку на логарифм правдоподобия насыщенной модели можно без вреда удалить из всего, что следует дальше.

В логистической регрессии особенно важны две меры отклонения: нулевое отклонение и отклонение модели. Нулевое отклонение представляет собой разницу между моделью только с точкой пересечения (что означает «без предикторов») и насыщенной моделью. Отклонение модели представляет собой разницу между моделью хотя бы с одним предиктором и насыщенной моделью. [35] В этом отношении нулевая модель обеспечивает основу для сравнения моделей предикторов. Учитывая, что отклонение является мерой различия между данной моделью и насыщенной моделью, меньшие значения указывают на лучшее соответствие. Таким образом, чтобы оценить вклад предиктора или набора предикторов, можно вычесть отклонение модели из нулевого отклонения и оценить разницу по распределение хи-квадрат со степенями свободы [2] равна разнице числа оцениваемых параметров.

Позволять

Тогда разница обоих:

Если отклонение модели значительно меньше, чем нулевое отклонение, можно сделать вывод, что предиктор или набор предикторов значительно улучшают соответствие модели. Это аналогично F -тесту, используемому в анализе линейной регрессии для оценки значимости прогноза. [35]

Псевдо-R-квадрат [ править ]

В линейной регрессии квадрат множественной корреляции R 2 используется для оценки степени соответствия, поскольку представляет собой долю дисперсии критерия, объясняемую предикторами. [35] В логистическом регрессионном анализе не существует согласованной аналогичной меры, но существует несколько конкурирующих мер, каждая из которых имеет ограничения. [35] [36]

На этой странице рассмотрены четыре наиболее часто используемых индекса и один менее распространенный:

- Отношение правдоподобия R 2 л

- Кокс и Снелл Р. 2 CS

- Нагелькерке Р 2 Н

- Макфадден Р. 2 МакФ

- Бык Р 2 Т

Тест Хосмера-Лемешоу [ править ]

Тест Хосмера – Лемешоу использует тестовую статистику, которая асимптотически следует распределение , чтобы оценить, соответствуют ли наблюдаемые частоты событий ожидаемым частотам событий в подгруппах модельной совокупности. Некоторые статистики считают этот тест устаревшим из-за его зависимости от произвольного группирования прогнозируемых вероятностей и относительно низкой мощности. [37]

Значимость коэффициента

После подбора модели исследователи, вероятно, захотят изучить вклад отдельных предикторов. Для этого они захотят изучить коэффициенты регрессии. В линейной регрессии коэффициенты регрессии представляют собой изменение критерия для каждого изменения единицы предиктора. [35] Однако в логистической регрессии коэффициенты регрессии представляют собой изменение логита для каждого изменения единицы предиктора. Учитывая, что логит не является интуитивно понятным, исследователи, скорее всего, сосредоточат внимание на влиянии предиктора на экспоненциальную функцию коэффициента регрессии – отношение шансов (см. определение ). В линейной регрессии значимость коэффициента регрессии оценивается путем вычисления t- критерия. В логистической регрессии существует несколько различных тестов, предназначенных для оценки значимости отдельного предиктора, в первую очередь тест отношения правдоподобия и статистика Вальда.

Тест правдоподобия отношения

Обсужденный выше тест отношения правдоподобия для оценки соответствия модели также является рекомендуемой процедурой для оценки вклада отдельных «предсказателей» в данную модель. [2] [26] [35] В случае одной модели предиктора просто сравнивают отклонение модели предиктора с отклонением нулевой модели на распределении хи-квадрат с одной степенью свободы. Если модель предиктора имеет значительно меньшее отклонение (ср. хи-квадрат, использующий разницу в степенях свободы двух моделей), то можно заключить, что существует значительная связь между «предсказателем» и результатом. Хотя некоторые распространенные статистические пакеты (например, SPSS) предоставляют статистику теста отношения правдоподобия, без этого трудоемкого теста было бы сложнее оценить вклад отдельных предикторов в случае множественной логистической регрессии. [ нужна ссылка ] Чтобы оценить вклад отдельных предикторов, можно ввести предикторы иерархически, сравнивая каждую новую модель с предыдущей, чтобы определить вклад каждого предиктора. [35] Среди статистиков ведутся споры о целесообразности так называемых «пошаговых» процедур. [ ласковые слова ] Есть опасение, что они могут не сохранить номинальные статистические свойства и могут ввести в заблуждение. [38]

Статистика Вальда [ править ]

Альтернативно, при оценке вклада отдельных предикторов в данной модели можно проверить значимость статистики Вальда . Статистика Вальда, аналогичная t -критерию в линейной регрессии, используется для оценки значимости коэффициентов. Статистика Вальда представляет собой отношение квадрата коэффициента регрессии к квадрату стандартной ошибки коэффициента и асимптотически распределяется как распределение хи-квадрат. [26]

Хотя некоторые статистические пакеты (например, SPSS, SAS) предоставляют статистику Вальда для оценки вклада отдельных предикторов, статистика Вальда имеет ограничения. Когда коэффициент регрессии велик, стандартная ошибка коэффициента регрессии также имеет тенденцию быть больше, увеличивая вероятность ошибки второго рода . Статистика Уолда также имеет тенденцию быть необъективной, когда данных мало. [35]

Выборка случай-контроль [ править ]

Предположим, случаи редки. Тогда мы могли бы захотеть проверять их чаще, чем их распространенность среди населения. Например, предположим, что есть заболевание, которым страдает 1 человек из 10 000, и для сбора данных нам необходимо пройти полный медицинский осмотр. Проводить тысячи медосмотров здоровых людей, чтобы получить данные лишь о нескольких больных, может быть слишком дорого. Таким образом, мы можем оценить больше больных людей, возможно, все редкие исходы. Это также ретроспективная выборка или, что то же самое, называется несбалансированными данными. Как правило, контрольная выборка в количестве, в пять раз превышающем количество случаев, дает достаточные контрольные данные. [39]

Логистическая регрессия уникальна тем, что ее можно оценить на основе несбалансированных данных, а не данных, выбранных случайным образом, и при этом она дает правильные оценки коэффициентов влияния каждой независимой переменной на результат. То есть, если мы сформируем логистическую модель на основе таких данных, если модель верна для генеральной совокупности, все параметры верны, кроме . Мы можем исправить если мы знаем истинную распространенность следующим образом: [39]

где истинная распространенность и — распространенность в выборке.

Обсуждение [ править ]

Как и другие формы регрессионного анализа , логистическая регрессия использует одну или несколько переменных-предикторов, которые могут быть непрерывными или категориальными. Однако, в отличие от обычной линейной регрессии, логистическая регрессия используется для прогнозирования зависимых переменных, которые относятся к одной из ограниченного числа категорий (в биномиальном случае зависимая переменная рассматривается как результат испытания Бернулли ), а не для непрерывного результата. Учитывая эту разницу, предположения линейной регрессии нарушаются. В частности, остатки не могут быть нормально распределены. Кроме того, линейная регрессия может давать бессмысленные прогнозы для бинарной зависимой переменной. Необходим способ преобразования двоичной переменной в непрерывную, которая может принимать любое действительное значение (отрицательное или положительное). Для этого биномиальная логистическая регрессия сначала вычисляет вероятность того, что событие произойдет для разных уровней каждой независимой переменной, а затем логарифмирует ее, чтобы создать непрерывный критерий как преобразованную версию зависимой переменной. Логарифм шансов – это логит вероятности, логит определяется следующим образом:

Хотя зависимой переменной в логистической регрессии является Бернулли, логит имеет неограниченный масштаб. [2] Логит-функция — это функция связи в такой обобщенной линейной модели, т.е.

Y — переменная отклика, распределенная по Бернулли, а x — предикторная переменная; значения β являются линейными параметрами.

вероятности Затем логит успеха подгоняется под предикторы. Прогнозируемое значение логита преобразуется обратно в прогнозируемые шансы посредством обратной функции натурального логарифма – экспоненциальной функции . Таким образом, хотя наблюдаемая зависимая переменная в бинарной логистической регрессии представляет собой переменную 0 или 1, логистическая регрессия как непрерывная переменная оценивает вероятность того, что зависимая переменная является «успехом». В некоторых приложениях достаточно только шансов. В других случаях необходим конкретный прогноз «да» или «нет» для определения того, является ли зависимая переменная «успехом» или нет; этот категориальный прогноз может быть основан на вычисленных шансах на успех, при этом прогнозируемые шансы выше некоторого выбранного порогового значения преобразуются в прогноз успеха.

Максимальная энтропия [ править ]

Из всех функциональных форм, используемых для оценки вероятностей конкретного категориального результата, которые оптимизируют соответствие путем максимизации функции правдоподобия (например, пробит-регрессия , регрессия Пуассона и т. д.), решение логистической регрессии является уникальным, поскольку оно является с максимальной энтропией. решением . [40] Это случай общего свойства: экспоненциальное семейство распределений максимизирует энтропию при заданном ожидаемом значении. В случае логистической модели логистическая функция является естественным параметром распределения Бернулли (она находится в « канонической форме », а логистическая функция — это каноническая функция связи), тогда как другие сигмовидные функции являются неканоническими функциями связи; это лежит в основе его математической элегантности и простоты оптимизации. см. в разделе Экспоненциальное семейство § Вывод максимальной энтропии Подробности .

Доказательство [ править ]

Чтобы это показать, воспользуемся методом множителей Лагранжа . Лагранжиан равен энтропии плюс сумме произведений множителей Лагранжа на различные выражения ограничений. Будет рассмотрен общий полиномиальный случай, поскольку рассмотрение более простых случаев не сильно упрощает доказательство. Приравнивание производной лагранжиана по различным вероятностям нулю дает функциональную форму для этих вероятностей, которая соответствует формам, используемым в логистической регрессии. [40]

Как и в приведенном выше разделе о полиномиальной логистической регрессии , мы рассмотрим поясняющие переменные, обозначенные и которые включают в себя . Всего будет K точек данных, проиндексированных , а точки данных имеют вид и . x как mk также будет представлен -мерный вектор . Будет возможные значения категориальной переменной y в диапазоне от 0 до N.

Пусть p n ( x ) будет вероятностью, учитывая вектор объясняющей переменной x , что результат будет . Определять которая представляет собой вероятность того, что для k -го измерения категориальный результат равен n .

Лагранжиан будет выражаться как функция вероятностей pnk и минимизироваться путем приравнивания производных лагранжиана по этим вероятностям нулю. Важным моментом является то, что вероятности рассматриваются одинаково, и тот факт, что их сумма равна 1, является частью лагранжевой формулировки, а не предполагается с самого начала.

Первым вкладом в лагранжиан является энтропия :

Логарифмическая вероятность равна:

Предполагая полиномиальную логистическую функцию, производная логарифмического правдоподобия по бета-коэффициентам оказалась равной:

Очень важным моментом здесь является то, что это выражение (что примечательно) не является явной функцией бета-коэффициентов. всего лишь функция вероятностей pnk Это и данных. Вместо того, чтобы быть специфичным для предполагаемого полиномиального логистического случая, оно считается общим утверждением условия, при котором логарифмическое правдоподобие максимизируется, и не делает ссылки на функциональную pnk форму . Тогда существуют ( M +1)( N +1) ограничения аппроксимации, и член ограничения аппроксимации в лагранжиане тогда равен:

где λ нм — соответствующие множители Лагранжа. Существует K ограничений нормализации, которые можно записать:

так что нормировочный член в лагранжиане равен:

где α k — соответствующие множители Лагранжа. Тогда лагранжиан представляет собой сумму трех вышеуказанных членов:

Приравнивание производной лагранжиана по одной из вероятностей к нулю дает:

Используя более сжатую векторную запись:

и отбрасываем простые числа от индексов n и k , а затем решаем дает:

где:

Наложив ограничение нормализации, мы можем найти Z k и записать вероятности как:

The не все независимы. Мы можем добавить любую константу -мерный вектор для каждого из без изменения стоимости вероятностей, так что существует только N, а не независимый . В разделе полиномиальной логистической регрессии выше было вычтено из каждого который устанавливает экспоненциальный член, включающий до 1, а бета-коэффициенты определялись как .

Другие подходы [ править ]

В приложениях машинного обучения, где для двоичной классификации используется логистическая регрессия, MLE минимизирует функцию перекрестных энтропийных потерь.

Логистическая регрессия — важный алгоритм машинного обучения . Цель состоит в том, чтобы смоделировать вероятность случайной величины. равен 0 или 1 согласно экспериментальным данным. [41]

Рассмотрим обобщенную линейную модельную функцию, параметризованную ,

Поэтому,

и поскольку , мы видим это дается Теперь мы рассчитаем функцию правдоподобия , предполагая, что все наблюдения в выборке независимо распределены Бернулли:

Обычно вероятность журнала максимальна,

который максимизируется с помощью методов оптимизации, таких как градиентный спуск .

Предполагая пары извлекаются равномерно из основного распределения, то в пределе больших N ,

где – условная энтропия и – расходимость Кульбака–Лейблера . Это приводит к интуитивному пониманию того, что, максимизируя логарифмическое правдоподобие модели, вы минимизируете отклонение KL вашей модели от максимального распределения энтропии. Интуитивный поиск модели, которая делает наименьшее количество допущений в своих параметрах.

с линейной Сравнение регрессией

Логистическую регрессию можно рассматривать как частный случай обобщенной линейной модели и, таким образом, аналог линейной регрессии . Однако модель логистической регрессии основана на совершенно иных предположениях (о взаимосвязи между зависимыми и независимыми переменными), чем в линейной регрессии. В частности, ключевые различия между этими двумя моделями можно увидеть в следующих двух особенностях логистической регрессии. Во-первых, условное распределение является распределением Бернулли , а не распределением Гаусса , поскольку зависимая переменная является двоичной. Во-вторых, прогнозируемые значения являются вероятностями и поэтому ограничены значением (0,1) посредством функции логистического распределения , поскольку логистическая регрессия предсказывает вероятность конкретных результатов, а не сами результаты.

Альтернативы [ править ]

Распространенной альтернативой логистической модели (логит-модели) является пробит-модель , как следует из родственных названий. С точки зрения обобщенных линейных моделей они различаются выбором функции связи : логистическая модель использует логит-функцию (обратную логистическую функцию), а пробит-модель использует пробит-функцию (обратную функцию ошибок ). Аналогично, в интерпретации скрытых переменных этих двух методов первый предполагает стандартное логистическое распределение ошибок, а второй - стандартное нормальное распределение ошибок. [42] другие сигмовидные функции Вместо этого можно использовать или распределения ошибок.

Логистическая регрессия является альтернативой методу Фишера 1936 года — линейному дискриминантному анализу . [43] Если предположения линейного дискриминантного анализа верны, условие можно изменить на противоположное, чтобы получить логистическую регрессию. Однако обратное неверно, поскольку логистическая регрессия не требует многомерного нормального предположения дискриминантного анализа. [44]

Предположение о линейных эффектах прогнозирования можно легко ослабить, используя такие методы, как сплайн-функции . [13]

История [ править ]

Подробная история логистической регрессии представлена в Cramer (2002) . Логистическая функция была разработана как модель роста населения и названа «логистикой» Пьером Франсуа Ферхюстом в 1830-х и 1840-х годах под руководством Адольфа Кетле ; см. в разделе Логистическая функция § История . подробности [45] В своей самой ранней статье (1838 г.) Ферхюльст не уточнил, как он согласовал кривые с данными. [46] [47] В своей более подробной статье (1845 г.) Ферхюльст определил три параметра модели, заставив кривую проходить через три наблюдаемые точки, что дало плохие прогнозы. [48] [49]

Логистическая функция была независимо разработана в химии как модель автокатализа ( Вильгельм Оствальд , 1883). [50] Автокаталитическая реакция — это реакция, в которой один из продуктов сам является катализатором той же реакции, а запас одного из реагентов фиксирован. Это естественным образом приводит к логистическому уравнению по той же причине, что и рост населения: реакция самоусиливающаяся, но ограниченная.