Выбор модели

В этой статье есть несколько проблем. Пожалуйста, помогите улучшить его или обсудите эти проблемы на странице обсуждения . ( Узнайте, как и когда удалять эти шаблонные сообщения )

|

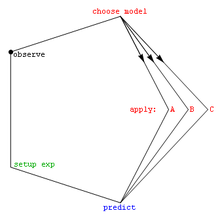

Выбор модели — это задача выбора модели из числа различных кандидатов на основе критерия производительности, чтобы выбрать лучшую. [1] В контексте машинного обучения и, в более общем смысле, статистического анализа , это может быть выбор статистической модели из набора моделей-кандидатов на основе данных. В простейших случаях рассматривается уже существующий набор данных. Однако задача может также включать в себя разработку экспериментов таким образом, чтобы собранные данные хорошо подходили для решения проблемы выбора модели. Учитывая возможные модели со схожей предсказательной или объяснительной силой, простейшая модель, скорее всего, будет лучшим выбором (« бритва Оккама» ).

Кониси и Китагава (2008 , стр. 75) утверждают: «Большинство проблем статистического вывода можно считать проблемами, связанными со статистическим моделированием». В связи с этим Кокс (2006 , стр. 197) сказал: «Как осуществляется перевод предметной задачи в статистическую модель, часто является наиболее важной частью анализа».

Выбор модели может также относиться к проблеме выбора нескольких репрезентативных моделей из большого набора вычислительных моделей с целью принятия решений или оптимизации в условиях неопределенности. [2]

В машинном обучении алгоритмические подходы к выбору модели включают выбор признаков , оптимизацию гиперпараметров и теорию статистического обучения .

Введение [ править ]

В своих самых основных формах выбор модели является одной из фундаментальных задач научного исследования . Определение принципа, объясняющего серию наблюдений, часто напрямую связано с математической моделью, предсказывающей эти наблюдения. Например, когда Галилей проводил эксперименты на наклонной плоскости , он продемонстрировал, что движение шаров соответствует параболе, предсказанной его моделью. [ нужна ссылка ] .

Как можно вообще выбрать лучшую модель из бесчисленного множества возможных механизмов и процессов, которые могли бы произвести данные? Обычно используемый математический подход делает выбор между набором возможных моделей; этот набор должен быть выбран исследователем. простые модели, такие как полиномы , по крайней мере, на начальном этапе. Часто используются [ нужна ссылка ] . Бернем и Андерсон (2002) на протяжении всей своей книги подчеркивают важность выбора моделей, основанных на здравых научных принципах, таких как понимание феноменологических процессов или механизмов (например, химических реакций), лежащих в основе данных.

После того, как набор моделей-кандидатов выбран, статистический анализ позволяет нам выбрать лучшую из этих моделей. Что подразумевается под лучшим, является спорным. Хорошая техника выбора модели позволит сбалансировать ее соответствие с простотой. Более сложные модели смогут лучше адаптировать свою форму к данным (например, полином пятого порядка может точно соответствовать шести точкам), но дополнительные параметры могут не представлять ничего полезного. (Возможно, эти шесть точек на самом деле просто случайно распределены вокруг прямой линии.) Степень соответствия обычно определяется с использованием подхода отношения правдоподобия или его приближения, что приводит к тесту хи-квадрат . Сложность обычно измеряется путем подсчета количества параметров в модели.

Методы выбора модели можно рассматривать как оценку некоторой физической величины, например вероятности того, что модель предоставит данные данные. Смещение являются важными и дисперсия показателями качества этой оценки; эффективность также часто учитывается.

Стандартным примером выбора модели является подбор кривой , где, учитывая набор точек и другие базовые знания (например, точки являются результатом выборок iid ), мы должны выбрать кривую, описывающую функцию, сгенерировавшую точки.

Два направления выбора модели [ править ]

Есть две основные цели в умозаключении и обучении на данных. Один из них предназначен для научных открытий, также называемых статистическим выводом, понимания основного механизма генерации данных и интерпретации природы данных. Другая цель обучения на основе данных — прогнозирование будущих или невидимых наблюдений, также называемое статистическим прогнозированием. Во второй цели специалист по данным не обязательно заботится о точном вероятностном описании данных. Конечно, можно заинтересоваться и в том, и в другом направлении.

В соответствии с двумя разными целями выбор модели также может иметь два направления: выбор модели для вывода и выбор модели для прогнозирования. [3] Первое направление – определить лучшую модель данных, которая предпочтительно обеспечит надежную характеристику источников неопределенности для научной интерпретации. Для этой цели очень важно, чтобы выбранная модель не была слишком чувствительна к размеру выборки. Соответственно, подходящим понятием для оценки выбора модели является согласованность выбора, означающая, что наиболее надежный кандидат будет последовательно выбран при наличии достаточного количества выборок данных.

Второе направление — выбрать модель в качестве механизма, обеспечивающую превосходные прогнозные характеристики. Однако в последнем случае выбранная модель может просто стать счастливым победителем среди нескольких близких конкурентов, однако прогнозные характеристики все равно могут быть максимально возможными. Если да, то выбор модели подходит для достижения второй цели (прогноза), но использование выбранной модели для понимания и интерпретации может быть крайне ненадежным и вводящим в заблуждение. [3] Более того, для очень сложных моделей, выбранных таким образом, даже прогнозы могут оказаться необоснованными для данных, лишь незначительно отличающихся от тех, на которых был сделан выбор. [4]

помогающие выбрать набор моделей- кандидатов , Методы

- Преобразование данных (статистика)

- Исследовательский анализ данных

- Спецификация модели

- Научный метод

Критерии [ править ]

Ниже приведен список критериев выбора модели. Наиболее часто используемыми информационными критериями являются (i) информационный критерий Акаике и (ii) фактор Байеса и/или байесовский информационный критерий (который в некоторой степени приближается к фактору Байеса), см. Стойка и Селен (2004) для обзора.

- Информационный критерий Акаике (AIC), мера соответствия оцененной статистической модели.

- Байесовский фактор

- Байесовский информационный критерий (BIC), также известный как информационный критерий Шварца, статистический критерий выбора модели.

- Мостовой критерий (BC), статистический критерий, который может обеспечить лучшую производительность AIC и BIC, несмотря на соответствие спецификации модели. [5]

- Перекрестная проверка

- Критерий информации об отклонениях (DIC), еще один критерий выбора байесовской модели.

- Уровень ложного обнаружения

- Критерий фокусированной информации (FIC), критерий отбора, сортирующий статистические модели по их эффективности для заданного параметра фокуса.

- Информационный критерий Ханнана-Куинна , альтернатива критериям Акаике и Байеса.

- Информационный критерий Кашьяпа (KIC) является мощной альтернативой AIC и BIC, поскольку KIC использует информационную матрицу Фишера.

- Тест отношения правдоподобия

- Мальвы C p

- Минимальная длина описания

- Минимальная длина сообщения (MML)

- Статистика PRESS , также известная как критерий PRESS.

- Структурная минимизация рисков

- Пошаговая регрессия

- Информационный критерий Ватанабэ-Акаике (WAIC), также называемый широко применимым информационным критерием.

- Расширенный байесовский информационный критерий (EBIC) — это расширение обычного байесовского информационного критерия (BIC) для моделей с пространствами с высокими параметрами.

- Расширенный информационный критерий Фишера (EFIC) — это критерий выбора модели для моделей линейной регрессии.

- Критерий ограниченного минимума (CMC) — это часто встречающийся критерий для выбора моделей регрессии с геометрической основой. [6]

Среди этих критериев перекрестная проверка обычно является наиболее точной и самой дорогой в вычислительном отношении для задач контролируемого обучения. [ нужна ссылка ]

Бернем и Андерсон (2002 , §6.3) говорят следующее:

Существует множество методов выбора модели. Однако с точки зрения статистической эффективности метода и предполагаемого контекста его использования существует только два различных класса методов: они были названы эффективными и последовательными . (...) В соответствии с частотной парадигмой выбора модели обычно существует три основных подхода: (I) оптимизация некоторых критериев выбора, (II) проверка гипотез и (III) специальные методы.

См. также [ править ]

- Все модели неправильные

- Анализ конкурирующих гипотез

- Автоматизированное машинное обучение (AutoML)

- Дилемма смещения-дисперсии

- Выбор функции

- Парадокс Фридмана

- Поиск по сетке

- Анализ идентифицируемости

- Логлинейный анализ

- Идентификация модели

- Бритва Оккама

- Оптимальный дизайн

- Проблема идентификации параметров

- Научное моделирование

- Статистическая проверка модели

- Парадокс Штейна

Примечания [ править ]

- ^ Хасти, Тибширани, Фридман (2009). Элементы статистического обучения . Спрингер. п. 195.

{{cite book}}: CS1 maint: несколько имен: список авторов ( ссылка ) - ^ Ширанги, Мехрдад Г.; Дурлофски, Луи Дж. (2016). «Общий метод выбора репрезентативных моделей для принятия решений и оптимизации в условиях неопределенности». Компьютеры и геонауки . 96 : 109–123. Бибкод : 2016CG.....96..109S . дои : 10.1016/j.cageo.2016.08.002 .

- ^ Jump up to: Перейти обратно: а б Дин, Цзе; Тарох, Вахид; Ян, Юхонг (2018). «Методы выбора модели: обзор» . Журнал обработки сигналов IEEE . 35 (6): 16–34. arXiv : 1810.09583 . Бибкод : 2018ISPM...35f..16D . дои : 10.1109/MSP.2018.2867638 . ISSN 1053-5888 . S2CID 53035396 .

- ^ Су, Дж.; Варгас, Д.В.; Сакурай, К. (2019). «Однопиксельная атака для обмана глубоких нейронных сетей». Транзакции IEEE в эволюционных вычислениях . 23 (5): 828–841. arXiv : 1710.08864 . дои : 10.1109/TEVC.2019.2890858 . S2CID 2698863 .

- ^ Дин, Дж.; Тарох, В.; Ян, Ю. (июнь 2018 г.). «Соединение AIC и BIC: новый критерий авторегрессии» . Транзакции IEEE по теории информации . 64 (6): 4024–4043. arXiv : 1508.02473 . дои : 10.1109/TIT.2017.2717599 . ISSN 1557-9654 . S2CID 5189440 .

- ^ Цао, Мин (2023). «Выбор модели регрессии с помощью логарифмического отношения правдоподобия и критерия ограниченного минимума». Канадский статистический журнал . arXiv : 2107.08529 . дои : 10.1002/cjs.11756 . S2CID 236087375 .

Ссылки [ править ]

- Ахо, К.; Дерриберри, Д.; Петерсон, Т. (2014), «Выбор модели для экологов: мировоззрение AIC и BIC», Ecology , 95 (3): 631–636, doi : 10.1890/13-1452.1 , PMID 24804445

- Акаике, Х. (1994), «Последствия информационной точки зрения на развитие статистической науки», в Боздогане, Х. (ред.), Материалы первой конференции США и Японии по границам статистического моделирования: информационное Подход – Том 3 , Kluwer Academic Publishers , стр. 27–38.

- Андерсон, Д.Р. (2008), Вывод на основе моделей в науках о жизни , Springer, ISBN 9780387740751

- Андо, Т. (2010), Выбор байесовской модели и статистическое моделирование , CRC Press , ISBN 9781439836156

- Брейман, Л. (2001), «Статистическое моделирование: две культуры», Statistical Science , 16 : 199–231, doi : 10.1214/ss/1009213726

- Бернхэм, КП; Андерсон, Д.Р. (2002), Выбор модели и многомодельный вывод: практический информационно-теоретический подход (2-е изд.), Springer-Verlag, ISBN 0-387-95364-7 [это более 38000 цитирований в Google Scholar ]

- Чемберлин, Т.К. (1890), «Метод множественных рабочих гипотез», Science , 15 (366): 92–6, Бибкод : 1890Sci....15R..92. , doi : 10.1126/science.ns-15.366.92 , PMID 17782687 (перепечатано в 1965 г., Science 148: 754–759 [1] дои : 10.1126/science.148.3671.754 )

- Класкенс, Г. (2016), «Выбор статистической модели» (PDF) , Ежегодный обзор статистики и ее применения , 3 (1): 233–256, Бибкод : 2016AnRSA...3..233C , doi : 10.1146/annurev -статистика-041715-033413 [ постоянная мертвая ссылка ]

- Класкенс, Г.; Хьорт, Нидерланды (2008), Выбор модели и усреднение модели , издательство Кембриджского университета, ISBN 9781139471800

- Кокс, Д.Р. (2006), Принципы статистического вывода , издательство Кембриджского университета.

- Дин, Дж.; Тарох, В.; Ян, Ю. (2018), «Методы выбора модели — обзор» , журнал IEEE Signal Processing Magazine , 35 (6): 16–34, arXiv : 1810.09583 , Bibcode : 2018ISPM...35f..16D , doi : 10.1109/ MSP.2018.2867638 , S2CID 53035396

- Кашьяп, Р.Л. (1982), «Оптимальный выбор частей AR и MA в моделях авторегрессионного скользящего среднего», IEEE Transactions on Pattern Analysis and Machine Intelligence , PAMI-4 (2), IEEE: 99–104, doi : 10.1109/TPAMI. 1982.4767213 , PMID 21869012 , S2CID 18484243

- Кониши, С.; Китагава, Г. (2008), Информационные критерии и статистическое моделирование , Springer, Bibcode : 2007icsm.book.....K , ISBN 9780387718866

- Лахири, П. (2001), Выбор модели , Институт математической статистики.

- Лееб, Х.; Пётшер, Б.М. (2009), «Выбор модели», Андерсон, Т.Г. (редактор), Справочник финансовых временных рядов , Springer, стр. 889–925, doi : 10.1007/978-3-540-71297-8_39 , ISBN 978-3-540-71296-1

- Лукач, премьер-министр; Томпсон, Вашингтон; Кендалл, WL; Гулд, WR; Доэрти, П.Ф. младший; Бернхэм, КП; Андерсон, Д.Р. (2007), «Обеспокоенность по поводу призыва к плюрализму теории информации и проверке гипотез», Journal of Applied Ecology , 44 (2): 456–460, doi : 10.1111/j.1365-2664.2006.01267.x , S2CID 83816981

- МакКуорри, Аллан Д.Р.; Цай, Чи-Линг (1998), Выбор модели регрессии и временных рядов , Сингапур: World Scientific, ISBN 981-02-3242-Х

- Массарт, П. (2007), Неравенства концентрации и выбор модели , Springer

- Массарт, П. (2014), «Неасимптотическое блуждание по вероятности и статистике» , в книге Лин, Сихонг (редактор), « Прошлое, настоящее и будущее статистической науки» , Chapman & Hall , стр. 309–321, ISBN. 9781482204988

- Наварро, ди-джей (2019), «Между дьяволом и глубоким синим морем: противоречия между научными суждениями и выбором статистической модели», Computational Brain & Behavior , 2 : 28–34, doi : 10.1007/s42113-018-0019-z

- Ресенде, Пауло Анджело Алвес; Дореа, Чанг Чунг Ю (2016), «Идентификация модели с использованием эффективного критерия детерминации», Журнал многомерного анализа , 150 : 229–244, arXiv : 1409.7441 , doi : 10.1016/j.jmva.2016.06.002 , S2CID 5469654

- Шмуэли, Г. (2010), «Объяснить или предсказать?» , Статистическая наука , 25 (3): 289–310, arXiv : 1101.0891 , doi : 10.1214/10-STS330 , MR 2791669 , S2CID 15900983

- Стойка, П.; Селен, Ю. (2004), «Выбор порядка модели: обзор правил информационных критериев» (PDF) , журнал IEEE Signal Processing Magazine , 21 (4): 36–47, doi : 10.1109/MSP.2004.1311138 , S2CID 17338979

- Уайт, Э.; ван ден Хеувел, Э.; Ромейн, Ж.-В. (2012), « Все модели неверны...»: введение в неопределенность моделей» (PDF) , Statistica Neerlandica , 66 (3): 217–236, doi : 10.1111/j.1467-9574.2012.00530.x , S2CID 7793470

- Вит, Э.; МакКаллах, П. (2001), Виана, MAG; Ричардс, Д. Ст. П. (ред.), «Расширяемость статистических моделей», Алгебраические методы в статистике и вероятности , стр. 327–340.

- Войтович, Анна; Бигай, Томаш (2016), «Обоснование, подтверждение и проблема взаимоисключающих гипотез», у Кузняра, Адриана; Одровонж-Сипневска, Иоанна (ред.), «Раскрывая факты и ценности» , Brill Publishers , стр. 122–143, doi : 10.1163/9789004312654_009 , ISBN 9789004312654

- Оранг, Араш; Янссон, Магнус (2018), «Критерий выбора модели для многомерной линейной регрессии» , IEEE Transactions on Signal Processing , 66 (13): 3436–3446, Bibcode : 2018ITSP...66.3436O , doi : 10.1109/TSP. 2018.2821628 , ISSN 1941-0476 , S2CID 46931136

- Б. Гохайн, Пракаш; Янссон, Магнус (2022), «Масштабно-инвариантный и последовательный байесовский информационный критерий для выбора порядка в моделях линейной регрессии», Signal Processing , 196 : 108499, doi : 10.1016/j.sigpro.2022.108499 , ISSN 0165-1684 , S2CID 246759677