Максимальная апостериорная оценка

Эта статья нуждается в дополнительных цитатах для проверки . ( сентябрь 2011 г. ) |

| Часть серии о |

| Байесовская статистика |

|---|

| Апостериорный = Вероятность × Априорный ÷ Доказательства |

| Фон |

| Модельное здание |

| Апостериорное приближение |

| Оценщики |

| Приближение доказательств |

| Оценка модели |

В байесовской статистике максимальная апостериорной вероятности ( MAP ) оценка — это оценка неизвестной величины, которая равна моде апостериорного распределения . MAP можно использовать для получения точечной оценки ненаблюдаемой величины на основе эмпирических данных. Он тесно связан с методом оценки максимального правдоподобия (ML), но использует расширенную цель оптимизации , которая включает в себя априорное распределение (которое количественно определяет дополнительную информацию, доступную благодаря предшествующим знаниям о связанном событии) по величине, которую необходимо оценить. Таким образом, оценку MAP можно рассматривать как регуляризацию оценки максимального правдоподобия.

Описание [ править ]

Предположим, что мы хотим оценить ненаблюдаемый параметр популяции. на основе наблюдений . Позволять быть выборочным распределением , так что это вероятность когда базовый параметр совокупности равен . Тогда функция:

известна как функция правдоподобия и оценка:

это оценка максимального правдоподобия .

Теперь предположим, что априорное распределение над существует. Это позволяет нам лечить как случайная величина, как в байесовской статистике . Мы можем вычислить апостериорное распределение используя теорему Байеса :

где — функция плотности , является областью .

Затем метод максимальной апостериорной оценки оценивает как мода апостериорного распределения этой случайной величины:

Знаменатель апостериорного распределения (так называемое предельное правдоподобие ) всегда положителен и не зависит от и поэтому не играет никакой роли в оптимизации. Обратите внимание, что оценка MAP совпадает с оценкой ML, когда априорная является однородным (т.е. является постоянной функцией ).

Когда функция потерь имеет вид

как стремится к 0, оценка Байеса приближается к оценке MAP при условии, что распределение он квазивогнутый. [1] Но обычно оценка MAP не является оценкой Байеса, если только является дискретным .

Вычисление [ править ]

Оценки MAP можно рассчитать несколькими способами:

- Аналитически, когда мода(ы) апостериорного распределения может быть задана в замкнутой форме . Это тот случай, когда сопряженные априорные значения . используются

- С помощью численной оптимизации, такой как метод сопряженных градиентов или метод Ньютона . Обычно для этого требуются первые или вторые производные , которые необходимо оценить аналитически или численно.

- Через модификацию алгоритма максимизации ожидания . Для этого не требуются производные от апостериорной плотности.

- Методом Монте-Карло с имитацией отжига.

Ограничения [ править ]

Хотя для оценки MAP требуются только мягкие условия, чтобы она была предельным случаем оценки Байеса (при функции потерь 0–1), [1] в целом он не очень репрезентативен для байесовских методов. Это связано с тем, что оценки MAP являются точечными оценками, тогда как байесовские методы характеризуются использованием распределений для суммирования данных и вывода выводов: таким образом, байесовские методы имеют тенденцию вместо этого сообщать апостериорное среднее или медиану вместе с достоверными интервалами . Это связано как с тем, что эти оценки оптимальны при потерях с квадратичной и линейной ошибкой соответственно (которые более репрезентативны для типичных функций потерь ), так и с тем, что для непрерывного апостериорного распределения не существует функции потерь, которая предполагает, что MAP является оптимальной точечной оценкой. Кроме того, апостериорное распределение часто может не иметь простой аналитической формы: в этом случае распределение можно смоделировать с использованием методов Монте-Карло для цепей Маркова , а оптимизация для нахождения его режима (мод) может быть затруднена или невозможна. [ нужна ссылка ]

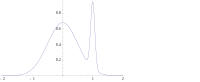

Во многих типах моделей, таких как смешанные модели , задняя часть может быть мультимодальной . В таком случае обычно рекомендуется выбирать самый высокий режим: это не всегда осуществимо ( глобальная оптимизация является сложной проблемой), а в некоторых случаях даже невозможно (например, когда возникают проблемы с идентификацией ). Более того, высшая мода может быть нехарактерна для большинства задних.

Наконец, в отличие от оценок ML, оценка MAP не является инвариантной при перепараметризации. Переход от одной параметризации к другой предполагает введение якобиана , влияющего на расположение максимума. [2]

В качестве примера разницы между упомянутыми выше оценками Байеса (оценками среднего и медианы) и использованием оценки MAP рассмотрим случай, когда необходимо классифицировать входные данные. как положительные или отрицательные (например, кредиты как рискованные или безопасные). Предположим, что существует всего три возможных гипотезы о правильном методе классификации. , и с задними 0,4, 0,3 и 0,3 соответственно. Предположим, что дан новый экземпляр, , классифицирует его как положительный, тогда как два других классифицируют его как отрицательный. Использование оценки MAP для правильного классификатора , классифицируется как положительный, тогда как оценки Байеса усредняют все гипотезы и классифицируют как отрицательный.

Пример [ править ]

Предположим, что нам дана последовательность МИР случайные величины и априорное распределение дается . Мы хотим найти оценку MAP . Обратите внимание, что нормальное распределение является своим собственным сопряженным априором , поэтому мы сможем найти решение в замкнутой форме аналитически.

Тогда функция, которую необходимо максимизировать, определяется выражением

что эквивалентно минимизации следующей функции :

Таким образом, мы видим, что оценка MAP для µ имеет вид

которое оказывается линейной интерполяцией между априорным средним значением и выборочным средним, взвешенным по их соответствующим ковариациям.

Случай называется неинформативным априором и приводит к неправильному распределению вероятностей ; в этом случае

Ссылки [ править ]

- ^ Jump up to: Перейти обратно: а б Бассетт, Роберт; Дериде, Хулио (30 января 2018 г.). «Максимальные апостериорные оценки как предел оценок Байеса». Математическое программирование : 1–16. arXiv : 1611.05917 . дои : 10.1007/s10107-018-1241-0 . ISSN 0025-5610 .

- ^ Мерфи, Кевин П. (2012). Машинное обучение: вероятностная перспектива . Кембридж, Массачусетс: MIT Press. стр. 151–152. ISBN 978-0-262-01802-9 .

- ДеГрут, М. (1970). Оптимальные статистические решения . МакГроу-Хилл. ISBN 0-07-016242-5 .

- Соренсон, Гарольд В. (1980). Оценка параметров: принципы и проблемы . Марсель Деккер. ISBN 0-8247-6987-2 .

- Хальд, Андерс (2007). «Вывод Гаусса нормального распределения и метод наименьших квадратов, 1809 г.». История параметрического статистического вывода от Бернулли до Фишера, 1713–1935 гг . Нью-Йорк: Спрингер. стр. 55–61. ISBN 978-0-387-46409-1 .