Функции потерь для классификации

| Часть серии о |

| Машинное обучение и интеллектуальный анализ данных |

|---|

Эту статью может потребовать очистки Википедии , чтобы она соответствовала стандартам качества . Конкретная проблема: Обсудить разницу по сравнению с правилами подсчета очков. ( январь 2024 г. ) |

Было предложено объединить эту статью с правилом подсчета очков . ( Обсудить ) Предлагается с апреля 2024 г. |

В машинном обучении и математической оптимизации функции потерь для классификации — это вычислительно осуществимые функции потерь, представляющие цену, уплаченную за неточность прогнозов в задачах классификации (проблемы определения того, к какой категории принадлежит конкретное наблюдение). [1] Данный как пространство всех возможных входов (обычно ), и как набор меток (возможных выходов), типичная цель алгоритмов классификации — найти функцию что лучше всего предсказывает ярлык для данного входа . [2] Однако из-за неполной информации, шума в измерениях или вероятностных составляющих основного процесса возможно то же самое. генерировать разные . [3] В результате целью задачи обучения является минимизация ожидаемых потерь (также известных как риск), определяемых как

где - заданная функция потерь, и - это функция плотности вероятности процесса, который сгенерировал данные, что эквивалентно можно записать как

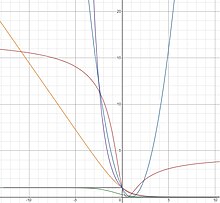

В рамках классификации некоторые часто используемые функции потерь записываются исключительно в терминах произведения истинной метки. и предсказанная метка . Поэтому их можно определить как функции только одной переменной. , так что с подходящим образом выбранной функцией . Они называются функциями потерь на основе маржи . Выбор функции потерь на основе маржи означает выбор . Выбор функции потерь в рамках этой структуры влияет на оптимальную который минимизирует ожидаемый риск, см. минимизацию эмпирического риска .

В случае бинарной классификации можно упростить расчет ожидаемого риска по указанному выше интегралу. Конкретно,

Второе равенство следует из описанных выше свойств. Третье равенство следует из того, что 1 и −1 являются единственно возможными значениями для , а четвертый потому что . Термин в скобках называется условным риском.

Можно найти минимизатор взяв функциональную производную последнего равенства по и установив производную равной 0. Это приведет к следующему уравнению

- [ нужна ссылка ] [ нужны разъяснения ]

где , что также эквивалентно присвоению производной условного риска равной нулю.

Учитывая бинарный характер классификации, естественным отбором функции потерь (при условии равной стоимости ложноположительных и ложноотрицательных результатов ) будет функция потерь 0–1 ( индикаторная функция 0–1 ), которая принимает значение 0, если предсказанное классификация равна истинному классу или 1, если прогнозируемая классификация не соответствует истинному классу. Этот выбор моделируется

где указывает на ступенчатую функцию Хевисайда .Однако эта функция потерь невыпуклая и негладкая, и поиск оптимального решения представляет собой NP-трудную задачу комбинаторной оптимизации. [4] В результате лучше заменить суррогаты функции потерь , которые подходят для широко используемых алгоритмов обучения, поскольку они обладают удобными свойствами, такими как выпуклость и гладкость. В дополнение к их вычислительной технологичности можно показать, что решения проблемы обучения с использованием этих суррогатов потерь позволяют восстановить фактическое решение исходной задачи классификации. [5] Некоторые из этих суррогатов описаны ниже.

На практике распределение вероятностей неизвестно. Следовательно, используя обучающий набор независимо и одинаково распределенные точки отбора проб

данных взятые из выборочного пространства , каждый стремится минимизировать эмпирический риск

в качестве показателя ожидаемого риска. [3] ( см. в статистической теории обучения Более подробное описание .)

Байесовская консистенция

[ редактировать ]Используя теорему Байеса , можно показать, что оптимальное , т.е. тот, который минимизирует ожидаемый риск, связанный с потерей ноль-единица, реализует правило оптимального решения Байеса для задачи бинарной классификации и имеет форму

- .

Функция потерь называется классификационно-калиброванной или байесовской, если она оптимальна. таков, что и, таким образом, является оптимальным в соответствии с правилом принятия решений Байеса. Функция потерь, согласованная по Байесу, позволяет нам найти оптимальную функцию решения Байеса. путем прямой минимизации ожидаемого риска и без необходимости явного моделирования функций плотности вероятности.

Для выпуклой потери запаса , можно показать, что является байесовским тогда и только тогда, когда оно дифференцируемо в точках 0 и . [6] [1] Однако этот результат не исключает существования невыпуклых функций потерь, согласованных по Байесу. Более общий результат гласит, что байесовские функции потерь могут быть созданы с использованием следующей формулировки: [7]

- ,

где — любая обратимая функция такая, что и — любая дифференцируемая строго вогнутая функция такая, что . В Таблице I показаны сгенерированные функции потерь, согласованные по Байесу, для некоторых примеров выбора и . Обратите внимание, что потери Сэвиджа и Касательной не являются выпуклыми. Было показано, что такие невыпуклые функции потерь полезны при работе с выбросами при классификации. [7] [8] Для всех функций потерь, генерируемых из (2), апостериорная вероятность можно найти с помощью функции обратимой ссылки как . Такие функции потерь, апостериорную вероятность которых можно восстановить с помощью обратимой связи, называются собственными функциями потерь .

| Имя потери | ||||

|---|---|---|---|---|

| Экспоненциальный | ||||

| Логистика | ||||

| Квадрат | ||||

| Дикий | ||||

| Касательная |

Единственный минимизатор ожидаемого риска, , связанный с сгенерированными выше функциями потерь, может быть непосредственно найден из уравнения (1) и показан как равный соответствующему . Это справедливо даже для невыпуклых функций потерь, а это означает, что алгоритмы на основе градиентного спуска, такие как повышение градиента для построения минимизатора можно использовать .

Правильные функции потерь, маржа потерь и регуляризация

[ редактировать ]

Для правильных функций потерь предел потерь можно определить как и показано, что они напрямую связаны со свойствами регуляризации классификатора. [9] В частности, функция потерь с большим запасом увеличивает регуляризацию и дает лучшие оценки апостериорной вероятности. Например, маржу убытков можно увеличить за счет логистических потерь, введя параметр и записываем логистические потери как где меньше увеличивает размер убытка. Показано, что это прямо эквивалентно снижению скорости обучения при градиентном бустинге. где уменьшение улучшает регуляризацию усиленного классификатора. Теория ясно показывает, что когда скорость обучения используется, правильная формула для получения апостериорной вероятности теперь имеет вид .

В заключение, выбрав функцию потерь с большим запасом (меньший ) мы увеличиваем регуляризацию и улучшаем наши оценки апостериорной вероятности, что, в свою очередь, улучшает кривую ROC окончательного классификатора.

Квадратная потеря

[ редактировать ]Хотя функция квадратичных потерь чаще используется в регрессии, ее можно переписать как функцию и используется для классификации. Его можно сгенерировать с использованием (2) и таблицы I следующим образом.

Функция квадратичных потерь одновременно выпуклая и гладкая. Однако функция квадратичных потерь имеет тенденцию чрезмерно наказывать выбросы, что приводит к более медленным темпам сходимости (в отношении сложности выборки), чем для функций логистических потерь или шарнирных потерь. [1] Кроме того, функции, которые дают высокие значения для некоторых будет плохо работать с функцией квадратичных потерь, поскольку высокие значения будут строго наказаны, независимо от наличия признаков и соответствовать.

Преимущество функции квадратичных потерь заключается в том, что ее структура позволяет легко проводить перекрестную проверку параметров регуляризации. В частности, для регуляризации Тихонова с исключением одного, можно найти параметр регуляризации, используя перекрестную проверку за то же время, которое потребовалось бы для решения одной задачи. [10]

Минимизатор для квадратичной функции потерь можно найти непосредственно из уравнения (1) как

Логистические потери

[ редактировать ]Функция логистических потерь может быть сгенерирована с использованием (2) и таблицы I следующим образом:

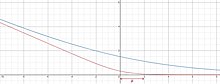

Логистические потери выпуклы и растут линейно для отрицательных значений, что делает их менее чувствительными к выбросам. Логистические потери используются в алгоритме LogitBoost .

Минимизатор для функции логистических потерь можно найти непосредственно из уравнения (1) как

Эта функция не определена, когда или (склоняясь к ∞ и −∞ соответственно), но предсказывает плавную кривую, которая растет, когда увеличивается и становится равным 0, когда . [3]

Легко проверить, что логистические потери и двоичные кросс-энтропийные потери (Log loss) на самом деле одинаковы (с точностью до мультипликативной константы). ). Перекрестная потеря энтропии тесно связана с расхождением Кульбака-Лейблера между эмпирическим распределением и предсказанным распределением. Перекрестная потеря энтропии повсеместно распространена в современных глубоких нейронных сетях .

Экспоненциальная потеря

[ редактировать ]Экспоненциальная функция потерь может быть сгенерирована с использованием (2) и таблицы I следующим образом:

Экспоненциальные потери выпуклы и экспоненциально растут для отрицательных значений, что делает их более чувствительными к выбросам. Экспоненциально взвешенные потери 0–1 используются в алгоритме AdaBoost, что неявно приводит к экспоненциальным потерям.

Минимизатор для экспоненциальной функции потерь можно непосредственно найти из уравнения (1) как

Дикая потеря

[ редактировать ]Дикая потеря [7] может быть сгенерировано с использованием (2) и таблицы-I следующим образом

Потери Сэвиджа квазивыпуклы и ограничены большими отрицательными значениями, что делает их менее чувствительными к выбросам. Потери Savage использовались в повышении градиента и алгоритме SavageBoost.

Минимизатор для функции потерь Сэвиджа можно найти непосредственно из уравнения (1) как

Касательная потеря

[ редактировать ]Касательная потеря [11] может быть сгенерировано с использованием (2) и таблицы-I следующим образом

Касательная потеря является квазивыпуклой и ограничена большими отрицательными значениями, что делает ее менее чувствительной к выбросам. Интересно, что потеря касательной также накладывает ограниченный штраф на точки данных, которые были классифицированы «слишком правильно». Это может помочь предотвратить чрезмерное обучение набора данных. Потери касательной использовались в повышении градиента , алгоритме TangentBoost и альтернативных лесах решений. [12]

Минимизатор для функции тангенциальных потерь можно найти непосредственно из уравнения (1) как

Потеря шарнира

[ редактировать ]Функция шарнирных потерь определяется формулой , где – положительная часть функции.

Потеря шарнира обеспечивает относительно жесткую, выпуклую верхнюю границу индикаторной функции 0–1 . В частности, шарнирные потери равны индикаторной функции 0–1 , когда и . Кроме того, эмпирическая минимизация риска этих потерь эквивалентна классической формулировке для машин опорных векторов (SVM). Правильно классифицированные точки, лежащие за пределами границ опорных векторов, не штрафуются, тогда как точки внутри границ поля или на неправильной стороне гиперплоскости наказываются линейно по сравнению с их расстоянием от правильной границы. [4]

Хотя функция шарнирных потерь одновременно выпуклая и непрерывная, она не является гладкой (не дифференцируемой) при . Следовательно, функцию шарнирных потерь нельзя использовать с методами градиентного спуска или методами стохастического градиентного спуска , которые основаны на дифференцируемости во всей области. Тем не менее, шарнирные потери имеют субградиент при , что позволяет использовать методы субградиентного спуска . [4] SVM, использующие функцию шарнирных потерь, также могут быть решены с помощью квадратичного программирования .

Минимизатор для функции шарнирных потерь

когда , что соответствует индикаторной функции 0–1. Этот вывод делает шарнирную потерю весьма привлекательной, поскольку можно установить границы разницы между ожидаемым риском и знаком функции шарнирной потери. [1] Потери на шарнирах не могут быть выведены из (2), поскольку не является обратимым.

Генерализованная плавная потеря шарнира

[ редактировать ]Обобщенная гладкая функция шарнирных потерь с параметром определяется как

где

Оно монотонно возрастает и достигает 0, когда .

См. также

[ редактировать ]Ссылки

[ редактировать ]- ^ Jump up to: а б с д Росаско, Л.; Де Вито, Эд; Капоннетто, А.; Пиана, М.; Верри, А. (2004). «Все ли функции потерь одинаковы?» (PDF) . Нейронные вычисления . 16 (5): 1063–1076. CiteSeerX 10.1.1.109.6786 . дои : 10.1162/089976604773135104 . ПМИД 15070510 . S2CID 11845688 .

- ^ Шен, Йи (2005), Функции потерь для двоичной классификации и оценки вероятности класса (PDF) , Университет Пенсильвании , получено 6 декабря 2014 г.

- ^ Jump up to: а б с Росаско, Лоренцо; Поджио, Томазо (2014), Регуляризация машинного обучения , MIT-9.520 Конспект лекций, том. Рукопись

- ^ Jump up to: а б с Пиюш, Рай (13 сентября 2011 г.), Машины опорных векторов (продолжение), Функции потерь классификации и регуляризаторы (PDF) , Юта CS5350/6350: Машинное обучение , получено 4 мая 2021 г.

- ^ Раманан, Дева (27 февраля 2008 г.), Лекция 14 (PDF) , UCI ICS273A: Машинное обучение , получено 6 декабря 2014 г.

- ^ Бартлетт, Питер Л.; Джордан, Майкл И.; Маколифф, Джон Д. (2006). «Выпуклость, классификация и границы риска». Журнал Американской статистической ассоциации . 101 (473): 138–156. дои : 10.1198/016214505000000907 . ISSN 0162-1459 . JSTOR 30047445 . S2CID 2833811 .

- ^ Jump up to: а б с Маснади-Ширази, Хамед; Васконселос, Нуно (2008). «О разработке функций потерь для классификации: теория, устойчивость к выбросам и SavageBoost» (PDF) . Материалы 21-й Международной конференции по нейронным системам обработки информации . НИПС'08. США: Curran Associates Inc.: 1049–1056. ISBN 9781605609492 .

- ^ Лейстнер, К.; Саффари, А.; Рот, премьер-министр; Бишоф, Х. (сентябрь 2009 г.). «О надежности онлайн-прокачки - конкурентное исследование». 2009 г. 12-я Международная конференция IEEE по компьютерному зрению, семинары ICCV . стр. 1362–1369. дои : 10.1109/ICCVW.2009.5457451 . ISBN 978-1-4244-4442-7 . S2CID 6032045 .

- ^ Васконселос, Нуно; Маснади-Ширази, Хамед (2015). «Взгляд на потери маржи как на регуляторы оценок вероятности» . Журнал исследований машинного обучения . 16 (85): 2751–2795. ISSN 1533-7928 .

- ^ Рифкин, Райан М.; Липперт, Росс А. (1 мая 2007 г.), Заметки о регуляризованных методах наименьших квадратов (PDF) , Лаборатория компьютерных наук и искусственного интеллекта Массачусетского технологического института.

- ^ Маснади-Ширази, Х.; Махадеван, В.; Васконселос, Н. (июнь 2010 г.). «О разработке робастных классификаторов для компьютерного зрения». Конференция IEEE Computer Society 2010 по компьютерному зрению и распознаванию образов . стр. 779–786. CiteSeerX 10.1.1.172.6416 . дои : 10.1109/CVPR.2010.5540136 . ISBN 978-1-4244-6984-0 . S2CID 632758 .

- ^ Шультер, С.; Уолхарт, П.; Лейстнер, К.; Саффари, А.; Рот, премьер-министр; Бишоф, Х. (июнь 2013 г.). «Альтернативные леса решений». Конференция IEEE 2013 по компьютерному зрению и распознаванию образов . стр. 508–515. CiteSeerX 10.1.1.301.1305 . дои : 10.1109/CVPR.2013.72 . ISBN 978-0-7695-4989-7 . S2CID 6557162 .

![{\displaystyle I[f]=\displaystyle \int _ {{\mathcal {X}}\times {\mathcal {Y}}}V(f({\vec {x}}),y)\,p( {\vec {x}},y)\,d{\vec {x}}\,dy}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b2f4cdc396ff9108f1164104f1307a61148e02a8)

![{\displaystyle {\begin{aligned}I[f]&=\int _ {{\mathcal {X}}\times {\mathcal {Y}}}V(f({\vec {x}}),y )\,p({\vec {x}},y)\,d{\vec {x}}\,dy\\[6pt]&=\int _{\mathcal {X}}\int _{\ mathcal {Y}}\phi (yf({\vec {x}}))\,p(y\mid {\vec {x}})\,p({\vec {x}})\,dy\ ,d{\vec {x}}\\[6pt]&=\int _{\mathcal {X}}[\phi (f({\vec {x}}))\,p(1\mid {\ vec {x}})+\phi (-f({\vec {x}}))\,p(-1\mid {\vec {x}})]\,p({\vec {x}} )\,d{\vec {x}}\\[6pt]&=\int _{\mathcal {X}}[\phi (f({\vec {x}}))\,p(1\mid {\vec {x}})+\phi (-f({\vec {x}}))\,(1-p(1\mid {\vec {x}}))]\,p({\ vec {x}})\,d{\vec {x}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f149639a6ffc0370e42f861a14842a1f21112848)

![{\displaystyle [\phi (f({\vec {x}}))p(1\mid {\vec {x}})+\phi (-f({\vec {x}}))(1- p(1\mid {\vec {x}}))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/976cb6e601d74f6154999611a9c8113ee189b6c4)

![{\displaystyle I[f]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8213b3ec4b7c34969992d3f12dd96b830c9082ef)

![{\displaystyle I_{S}[f]={\frac {1}{n}}\sum _{i=1}^{n}V(f({\vec {x}}_{i}),y_{i})}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f11407df44b1dc610c3fe193ce436cc33520ffe5)

![{\displaystyle \phi (v)=C[f^{-1}(v)]+(1-f^{-1}(v))C'[f^{-1}(v)]\; \;\;\;\;(2)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7ba1d9d0d51b1c65272af55aa780a285afa90d9d)

![{\displaystyle {\frac {1}{\log(2)}}[-\and \log(\and)-(1-\and)\log(1-\and)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7e609e1c16646f7a8a99eb51b64fb94416a6a425)

![{\displaystyle \phi (v)=C[f^{-1}(v)]+(1-f^{-1}(v))C'[f^{-1}(v)]=4 ({\frac {1}{2}}(v+1))(1- {\frac {1}{2}}(v+1))+(1- {\frac {1}{2}} (v+1))(4-8({\frac {1}{2}}(v+1)))=(1-v)^{2}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7cdde8f62987c985c1028a98d8c24682dfe0c2d7)

![{\displaystyle {\begin{aligned}\phi (v)&=C[f^{-1}(v)]+\left(1-f^{-1}(v)\right)\,C' \left[f^{-1}(v)\right]\\&={\frac {1}{\log(2)}}\left[{\frac {-e^{v}}{1+ e^{v}}}\log {\frac {e^{v}}{1+e^{v}}}-\left(1-{\frac {e^{v}}{1+e^ {v}}}\right)\log \left(1-{\frac {e^{v}}{1+e^{v}}}\right)\right]+\left(1-{\frac {e^{v}}{1+e^{v}}}\right)\left[{\frac {-1}{\log(2)}}\log \left({\frac {\frac { e^{v}}{1+e^{v}}}{1-{\frac {e^{v}}{1+e^{v}}}}}\right)\right]\\& = {\frac {1}{\log(2)}}\log(1+e^{-v}).\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4fd7a4c1188c935bcf5f76e4063f97034fb54e39)

![{\displaystyle \phi (v)=C[f^{-1}(v)]+(1-f^{-1}(v))C'[f^{-1}(v)]=2 {\sqrt {\left({\frac {e^{2v}}{1+e^{2v}}}\right)\left(1- {\frac {e^{2v}}{1+e^ {2v}}}\right)}}+\left(1- {\frac {e^{2v}}{1+e^{2v}}}\right)\left({\frac {1-{\ frac {2e^{2v}}{1+e^{2v}}}}{\sqrt {{\frac {e^{2v}}{1+e^{2v}}}(1-{\frac { e^{2v}}{1+e^{2v}}})}}}\right)=e^{-v}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5216a5728f6d95ccb1204e5c0a47c130c6dc874f)

![{\displaystyle \phi (v)=C[f^{-1}(v)]+(1-f^{-1}(v))C'[f^{-1}(v)]=\ left({\frac {e^{v}}{1+e^{v}}}\right)\left(1- {\frac {e^{v}}{1+e^{v}}} \right)+\left(1-{\frac {e^{v}}{1+e^{v}}}\right)\left(1-{\frac {2e^{v}}{1+ e^{v}}}\right)={\frac {1}{(1+e^{v})^{2}}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/617b6718aa33179b14a860c22759a345f7f6a52a)

![{\displaystyle {\begin{aligned}\phi (v)&=C[f^{-1}(v)]+(1-f^{-1}(v))C'[f^{-1 }(v)]=4(\arctan(v)+{\frac {1}{2}})(1-(\arctan(v)+{\frac {1}{2}}))+(1 -(\arctan(v)+{\frac {1}{2}}))(4-8(\arctan(v)+{\frac {1}{2}}))\\&=(2\ arctan(v)-1)^{2}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/48fc53108e779ecf1e26b0725b3873944fcd9644)

![{\displaystyle \phi (\upsilon)=\max(0,1-\upsilon)=[1-\upsilon ]_{+}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/068b33990cb9f189f89c1c4b775424ff8bd5fade)

![{\displaystyle [a]_{+}=\max(0,a)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/eb205e8d8fd29396410d5c3764b95f1323335f6e)

![{\displaystyle V(f({\vec {x}}),y)=\max(0,1-yf({\vec {x}}))=[1-yf({\vec {x}}) )]_{+}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bec5bd9d55a0fa201d877181b995db28b17f9827)