Информационное измерение

В теории информации информационная размерность является информационной мерой для случайных векторов в евклидовом пространстве , основанной на нормализованной энтропии точно квантованных версий случайных векторов . Эта концепция была впервые введена Альфредом Реньи в 1959 году. [1]

Проще говоря, это мера фрактальной размерности распределения вероятностей . Он характеризует скорость роста энтропии Шеннона , задаваемую последовательно более тонкой дискретизацией пространства.

В 2010 году Ву и Верду дали оперативную характеристику информационного измерения Реньи как фундаментального предела сжатия данных практически без потерь для аналоговых источников при различных ограничениях регулярности кодера/декодера.

Определение и свойства

[ редактировать ]Энтропия дискретной случайной величины является

где является вероятностной мерой когда и обозначает набор .

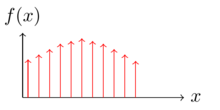

Позволять быть произвольной действительной случайной величиной. Учитывая положительное целое число , мы создаем новую дискретную случайную величину

где это оператор пола, который преобразует действительное число в наибольшее целое число, меньшее его. Затем

и

называются нижним и верхним информационными измерениями соответственно. Когда мы называем это ценностно-информационным измерением ,

Некоторые важные свойства информационного измерения :

- Если состояние легкой степени выполнено, мы имеем .

- Для -мерный случайный вектор , первое свойство можно обобщить до .

- Достаточно вычислить верхнюю и нижнюю информационную размерность при ограничении экспоненциальной подпоследовательности . .

- и сохраняются неизменными, если при квантовании используются функции округления или ограничения.

d -мерная энтропия

[ редактировать ]Если информационное измерение существует, можно определить -мерная энтропия этого распределения по

при условии, что предел существует. Если нульмерная энтропия равна стандартной энтропии Шеннона . Для целочисленного измерения , -мерная энтропия – это -кратный интеграл, определяющий соответствующую дифференциальную энтропию .

Эквивалентное определение информационного измерения

[ редактировать ]В 1994 году Кавабата и Дембо в работе Kawabata & Dembo 1994 предложили новый способ измерения информации, основанный на значении скорости искажения случайной величины. Мера определяется как

где — это функция искажения скорости, которая определяется как

или, что то же самое, минимальная информация, которая может привести к -близкое приближение .

Далее они доказали, что такое определение эквивалентно определению информационного измерения. Формально,

Смещение размерной скорости

[ редактировать ]Используя приведенное выше определение информационного измерения Реньи, мера, аналогичная d -мерной энтропии, определена в Charusaie, Amini & Rini 2022 . Это значение то, что называется смещением размерной скорости, определяется таким образом, чтобы уловить конечный член функции скорости-искажения. Формально,

Смещение размерной скорости равно d -мерной скорости для непрерывного , дискретного и дискретно-непрерывного смешанного распределения. Более того, она вычислима для набора сингулярных случайных величин , тогда как d -мерная энтропия там не обязательно существует.

Наконец, смещение размерности обобщает энтропию Шеннона и дифференциальную энтропию , поскольку можно найти взаимную информацию. используя следующую формулу:

Дискретно-непрерывные распределения смеси

[ редактировать ]По теореме Лебега о разложении [2] распределение вероятностей может быть однозначно представлено смесью

где и ; — чисто атомарная вероятностная мера (дискретная часть), – абсолютно непрерывная вероятностная мера, а — вероятностная мера, сингулярная относительно меры Лебега, но не содержащая атомов (сингулярная часть).Позволять быть случайной величиной такой, что . Предположим, что распределение может быть представлено как

где является дискретной мерой и – абсолютно непрерывная вероятностная мера с . Затем

Более того, учитывая и дифференциальная энтропия , -Размерная энтропия просто определяется выражением

где - энтропия Шеннона дискретной случайной величины с и и предоставлено

Пример

[ редактировать ]

Рассмотрим сигнал, который имеет распределение вероятностей по Гауссу .

Мы пропускаем сигнал через полуволновой выпрямитель , который преобразует все отрицательные значения в 0 и сохраняет все остальные значения. Полупериодный выпрямитель можно охарактеризовать функцией

Тогда на выходе выпрямителя сигнал имеет выпрямленное распределение Гаусса . Он характеризуется атомной массой 0,5 и имеет гауссову PDF для всех .

При таком распределении смеси мы применяем приведенную выше формулу и получаем информационную размерность распределения и вычислить -мерная энтропия.

Нормализованная правая часть гауссовского распределения с нулевым средним имеет энтропию , следовательно

Связь с дифференциальной энтропией

[ редактировать ]Это показано [3] что информационное измерение и дифференциальная энтропия тесно связаны.

Позволять быть случайной величиной с непрерывной плотностью .

Предположим, мы разделили диапазон в контейнеры длины . По теореме о среднем значении существует значение внутри каждого бункера так, что

Рассмотрим дискретизированную случайную величину если .

Вероятность каждой точки опоры является

Позволять .Энтропия является

Если мы установим и тогда мы делаем точно такое же квантование, как и определение информационной размерности. Поскольку перемаркировка событий дискретной случайной величины не меняет ее энтропию, мы имеем

Это дает

и когда достаточно велик,

что такое дифференциальная энтропия непрерывной случайной величины. В частности, если интегрируема по Риману, то

Сравнивая это с -мерная энтропия показывает, что дифференциальная энтропия - это в точности одномерная энтропия.

Фактически, это можно обобщить на более высокие измерения. Реньи показывает, что если является случайным вектором в -мерное евклидово пространство с абсолютно непрерывным распределением с функцией плотности вероятности и конечная энтропия целой части ( ), у нас есть

и

если интеграл существует.

Сжатие данных без потерь

[ редактировать ]Информационная размерность распределения дает теоретическую верхнюю границу степени сжатия, если кто-то хочет сжать переменную, поступающую из этого распределения. В контексте сжатия данных без потерь мы пытаемся сжать действительное число с помощью менее вещественного числа, оба из которых имеют бесконечную точность.

Основная цель сжатия данных без потерь — найти эффективные представления для реализации источника. к . А код для представляет собой пару отображений:

- кодер: который преобразует информацию из источника в символы для передачи или хранения;

- декодер: это обратный процесс, преобразующий символы кода обратно в форму, понятную получателю.

Вероятность ошибки блока равна .

Определять быть нижней границей такая, что существует последовательность коды такие, что для всех достаточно больших .

Так в основном дает соотношение между длиной кода и длиной источника, оно показывает, насколько хороша конкретная пара кодера-декодера. Фундаментальные ограничения исходного кодирования без потерь заключаются в следующем. [4]

Рассмотрим непрерывную функцию кодера с функцией непрерывного декодера . Если мы не будем навязывать регулярности и , благодаря богатому строению , у нас есть минимум - достижимая ставка для всех . Это означает, что можно построить пару кодер-декодер с бесконечной степенью сжатия.

Чтобы получить некоторые нетривиальные и содержательные выводы, позвольте минимум достижимая скорость для линейного энкодера и декодера Бореля. Если случайная величина имеет распределение, представляющее собой смесь дискретной и непрерывной частей. Затем для всех Предположим, мы ограничили декодер непрерывной по Липшицу функцией и выполняется, то минимум достижимая ставка для всех .

Фундаментальная роль информационного измерения в сжатии данных без потерь выходит за рамки данных iid. Показано, что для заданных процессов (например, процессов скользящего среднего) коэффициент сжатия без потерь также равен размерности информации. [5] Этот результат позволяет обеспечить дальнейшее сжатие, которое было невозможно при рассмотрении только предельного распределения процесса.

См. также

[ редактировать ]Примечания

[ редактировать ]- ^ См. Реньи, 1959 .

- ^ См . Чинлар 2011 .

- ^ См. Cover & Thomas 2012 .

- ^ См. Ву и Верду, 2010 .

- ^ См. Чарусайе, Амини и Рини, 2022 г.

Ссылки

[ редактировать ]- Чынлар, Эрхан (2011). Вероятность и стохастика . Тексты для аспирантов по математике. Том. 261. Спрингер. дои : 10.1007/978-0-387-87859-1 . ISBN 978-0-387-87858-4 .

- Обложка, Томас М.; Томас, Джой А. (2012). Элементы теории информации (2-е изд.). Уайли. стр. 247–248. ISBN 9781118585771 .

- Реньи, А. (март 1959 г.). «О размерности и энтропии вероятностных распределений» . Acta Mathematica Academiae Scientiarum Hungaricae . 10 (1–2): 193–215. дои : 10.1007/BF02063299 . ISSN 0001-5954 . S2CID 121006720 .

- Ву, Ихонг; Верду, С. (август 2010 г.). «Информационное измерение Реньи: фундаментальные ограничения аналогового сжатия почти без потерь». Транзакции IEEE по теории информации . 56 (8): 3721–3748. дои : 10.1109/TIT.2010.2050803 . ISSN 0018-9448 . S2CID 206737933 .

- Чарусайе, М.; Амини, А.; Рини, С. (май 2022 г.). «Меры сжимаемости аффинно сингулярных случайных векторов» . Транзакции IEEE по теории информации . 68 (9): 6245–6275. arXiv : 2001.03884 . дои : 10.1109/TIT.2022.3174623 .

- Кавабата, Т.; Дембо, А. (сентябрь 1994 г.). «Измерение скорости-искажения множеств и мер» . Транзакции IEEE по теории информации . 40 (5): 1564–1572. дои : 10.1109/18.333868 .