Локальная регрессия

Эта статья включает список общих ссылок , но в ней отсутствуют достаточные соответствующие встроенные цитаты . ( июнь 2011 г. ) |

| Часть серии о |

| Регрессионный анализ |

|---|

| Модели |

| Оценка |

| Фон |

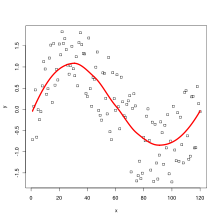

Локальная регрессия или локальная полиномиальная регрессия , [1] также известный как скользящая регрессия , [2] является обобщением скользящего среднего и полиномиальной регрессии . [3] Его наиболее распространенные методы, первоначально разработанные для сглаживания диаграмм рассеяния , — это LOESS ( локально оцененное сглаживание диаграмм рассеяния ) и LOWESS ( локально взвешенное сглаживание диаграмм рассеяния ), оба произносятся как / ˈ l oʊ ɛ s / LOH -ess . Это два тесно связанных метода непараметрической регрессии , которые объединяют несколько моделей регрессии в k -ближайшего соседа метамодель на основе .В некоторых областях LOESS известен и обычно называется фильтром Савицкого – Голея. [4] [5] (предложено за 15 лет до ЛЕССА).

Таким образом, LOESS и LOWESS основаны на «классических» методах , таких как линейная и нелинейная регрессия по методу наименьших квадратов . Они предназначены для ситуаций, в которых классические процедуры неэффективны или не могут быть эффективно применены без чрезмерных усилий. LOESS сочетает в себе большую часть простоты линейной регрессии наименьших квадратов с гибкостью нелинейной регрессии . Это делается путем подгонки простых моделей к локализованным подмножествам данных для создания функции, которая описывает детерминированную часть изменения данных, точка за точкой. Фактически, одна из главных достопримечательностей этого метода заключается в том, что аналитику данных не требуется указывать глобальную функцию любой формы для подгонки модели к данным, а только для подгонки сегментов данных.

Компромиссом для этих функций является увеличение объема вычислений. Поскольку LOESS требует больших вычислительных ресурсов, его было бы практически невозможно использовать в эпоху, когда разрабатывалась регрессия наименьших квадратов. Большинство других современных методов моделирования процессов в этом отношении аналогичны LOESS. Эти методы были сознательно разработаны для максимально эффективного использования наших нынешних вычислительных возможностей для достижения целей, которые нелегко достичь с помощью традиционных подходов.

Сглаженная кривая, проходящая через набор точек данных, полученных с помощью этого статистического метода, называется лессовой кривой , особенно когда каждое сглаженное значение задается взвешенной квадратичной регрессией наименьших квадратов в диапазоне значений Y. по оси рассеяния критериальной переменной диаграммы Когда каждое сглаженное значение задается взвешенной линейной регрессией наименьших квадратов в пределах диапазона, это называется кривой наименьшего значения ; однако некоторые авторитеты рассматривают лоэсс и лесс как синонимы. [6] [7]

Определение модели

[ редактировать ]В 1964 году Савицкий и Голей предложили метод, эквивалентный LOESS, который обычно называют фильтром Савицкого-Голея . Уильям С. Кливленд заново открыл этот метод в 1979 году и дал ему особое название. В дальнейшем метод был развит Кливлендом и Сьюзан Дж. Девлин (1988). LOWESS также известен как локально-взвешенная полиномиальная регрессия.

В каждой точке диапазона набора данных низкой степени полином к подмножеству данных подгоняется со значениями объясняющей переменной рядом с точкой, ответ которой оценивается. Полином аппроксимируется с использованием взвешенного метода наименьших квадратов , придавая больший вес точкам рядом с точкой, отклик которой оценивается, и меньший вес точкам, расположенным дальше. Затем значение функции регрессии для точки получается путем оценки локального полинома с использованием значений объясняющих переменных для этой точки данных. Подбор LOESS завершается после того, как значения функции регрессии были вычислены для каждого из точки данных. Многие детали этого метода, такие как степень полиномиальной модели и веса, являются гибкими. Далее кратко обсуждаются диапазон вариантов для каждой части метода и типичные значения по умолчанию.

Локализованные подмножества данных

[ редактировать ]Подмножества данных , используемые для каждого взвешенного метода наименьших квадратов, подходящего для LOESS, определяются с помощью алгоритма ближайших соседей. Указанные пользователем входные данные для процедуры, называемые «полоса пропускания» или «параметр сглаживания», определяют, какой объем данных используется для соответствия каждому локальному полиному. Параметр сглаживания, , — это доля общего числа n точек данных, которые используются при каждой локальной подгонке. Таким образом, подмножество данных, используемое при каждой взвешенной аппроксимации методом наименьших квадратов, включает точки (округленные до ближайшего по величине целого числа), значения независимых переменных которых наиболее близки к точке, в которой оценивается ответ. [7]

полинома степени k требуется не менее k + 1 точек, параметр сглаживания Поскольку для подгонки должно быть между и 1, с обозначающий степень локального полинома.

называется параметром сглаживания, поскольку он контролирует гибкость функции регрессии LOESS. Большие значения создавать самые плавные функции, которые меньше всего покачиваются в ответ на колебания данных. Чем меньше то есть, тем ближе функция регрессии будет соответствовать данным. Однако использовать слишком маленькое значение параметра сглаживания нежелательно, поскольку функция регрессии со временем начнет улавливать случайные ошибки в данных.

Степень локальных полиномов

[ редактировать ]Локальные полиномы, соответствующие каждому подмножеству данных, почти всегда имеют первую или вторую степень; то есть либо локально линейный (в смысле прямой), либо локально квадратичный. Использование полинома нулевой степени превращает LOESS в взвешенное скользящее среднее . Полиномы более высокой степени теоретически могут работать, но дают модели, которые на самом деле не соответствуют духу LOESS. LOESS основан на идеях о том, что любую функцию можно хорошо аппроксимировать в небольшой окрестности полиномом низкого порядка и что простые модели можно легко подогнать к данным. Полиномы высокой степени будут иметь тенденцию переопределять данные в каждом подмножестве и являются численно нестабильными, что затрудняет точные вычисления.

Весовая функция

[ редактировать ]Как упоминалось выше, весовая функция придает наибольший вес точкам данных, ближайшим к точке оценки, и наименьший вес точкам данных, которые находятся дальше всего. Использование весов основано на идее, что точки, расположенные рядом друг с другом в пространстве независимых переменных, с большей вероятностью будут связаны друг с другом простым способом, чем точки, которые находятся дальше друг от друга. Следуя этой логике, точки, которые, скорее всего, будут следовать локальной модели, лучше всего влияют на оценки параметров локальной модели. Точки, которые с меньшей вероятностью фактически соответствуют локальной модели, оказывают меньшее влияние на параметров оценки локальной модели .

Традиционной весовой функцией, используемой для LOESS, является весовая функция трех кубов .

где d — расстояние данной точки данных от точки аппроксимируемой кривой, масштабированное так, чтобы оно лежало в диапазоне от 0 до 1. [7]

Однако можно также использовать любую другую весовую функцию, удовлетворяющую свойствам, перечисленным в Cleveland (1979). Вес конкретной точки в любом локализованном подмножестве данных получается путем оценки весовой функции на расстоянии между этой точкой и точкой оценки после масштабирования расстояния таким образом, чтобы максимальное абсолютное расстояние по всем точкам в подмножестве данных данные ровно одни.

Рассмотрим следующее обобщение модели линейной регрессии с метрикой на целевом пространстве это зависит от двух параметров, . Предположим, что линейная гипотеза основана на входные параметры и что, как обычно в этих случаях, встраиваем пространство ввода в как и рассмотрим следующую функцию потерь

Здесь, это действительная матрица коэффициентов, а индекс i перечисляет входные и выходные векторы из обучающего набора. С является метрикой, это симметричная положительно определенная матрица и, как таковая, существует еще одна симметричная матрица такой, что . Вышеупомянутую функцию потерь можно преобразовать в след, заметив, что . Располагая векторы и в столбцы матрица и матрица соответственно, вышеуказанную функцию потерь можно записать как

где диагональ квадрата матрица, элементы которой являются с. Дифференцируя по и приравняв результат к 0, находим экстремальное матричное уравнение

- .

Предполагая далее, что квадратная матрица несингулярна, функция потерь достигает минимума при

- .

Типичный выбор для это гауссов вес

- .

Преимущества

[ редактировать ]Как обсуждалось выше, самое большое преимущество LOESS перед многими другими методами заключается в том, что процесс подгонки модели к выборочным данным не начинается с указания функции. Вместо этого аналитик должен указать только значение параметра сглаживания и степень локального полинома. Кроме того, LOESS очень гибок, что делает его идеальным для моделирования сложных процессов, для которых не существует теоретических моделей. Эти два преимущества в сочетании с простотой метода делают LOESS одним из наиболее привлекательных современных методов регрессии для приложений, которые соответствуют общей структуре регрессии наименьших квадратов, но имеют сложную детерминированную структуру.

Хотя это менее очевидно, чем некоторые другие методы, связанные с линейной регрессией наименьших квадратов, LOESS также обладает большинством преимуществ, обычно присущих этим процедурам. Наиболее важной из них является теория расчета неопределенностей для прогнозирования и калибровки. Многие другие тесты и процедуры, используемые для проверки моделей наименьших квадратов, также могут быть распространены на модели LOESS. [ нужна ссылка ] .

Недостатки

[ редактировать ]LOESS менее эффективно использует данные, чем другие методы наименьших квадратов. Для создания хороших моделей требуются довольно большие наборы данных с плотной выборкой. Это связано с тем, что LOESS полагается на локальную структуру данных при выполнении локальной подгонки. Таким образом, LOESS обеспечивает менее сложный анализ данных в обмен на более высокие затраты на эксперименты. [7]

Еще одним недостатком LOESS является тот факт, что он не создает функцию регрессии, которую легко представить математической формулой. Это может затруднить передачу результатов анализа другим людям. Чтобы передать функцию регрессии другому человеку, ему понадобится набор данных и программное обеспечение для расчетов LOESS. С другой стороны, в нелинейной регрессии необходимо только записать функциональную форму, чтобы обеспечить оценки неизвестных параметров и предполагаемой неопределенности. В зависимости от применения это может быть как существенным, так и незначительным недостатком использования LOESS. В частности, простая форма LOESS не может использоваться для механистического моделирования, где подобранные параметры определяют определенные физические свойства системы.

Наконец, как обсуждалось выше, LOESS — это метод с интенсивными вычислениями (за исключением равномерно распределенных данных, где регрессию затем можно сформулировать как беспричинный фильтр с конечной импульсной характеристикой ). LOESS также подвержен влиянию выбросов в наборе данных, как и другие методы наименьших квадратов. Существует итеративная, надежная версия LOESS [Cleveland (1979)], которую можно использовать для снижения чувствительности LOESS к выбросам , но слишком большое количество экстремальных выбросов все равно может преодолеть даже устойчивый метод.

См. также

[ редактировать ]- Степени свободы (статистика)#В нестандартной регрессии

- Регрессия ядра

- Перемещение по методу наименьших квадратов

- Скользящее среднее

- Сплайны многомерной адаптивной регрессии

- Непараметрическая статистика

- Фильтр Савицкого – Голея

- Сегментированная регрессия

Ссылки

[ редактировать ]Цитаты

[ редактировать ]- ^ Fox & Weisberg 2018 , Приложение.

- ^ Харрелл 2015 , с. 29.

- ^ Гаримелла 2017 .

- ^ «Фильтрация Савицкого – Голея – MATLAB sgolayfilt» . Mathworks.com .

- ^ «scipy.signal.savgol_filter — Справочное руководство SciPy v0.16.1» . Docs.scipy.org .

- ^ Кристен Павлик, Агентство по охране окружающей среды США, Лёсс (или Ловесс) , Nutrient Steps , июль 2016 г.

- ^ Jump up to: а б с д NIST, «LOESS (также известный как LOWESS)» , раздел 4.1.4.4, Электронный справочник по статистическим методам NIST/SEMATECH (по состоянию на 14 апреля 2017 г.)

Источники

[ редактировать ]- Кливленд, Уильям С. (1979). «Надежная локально взвешенная регрессия и сглаживающие диаграммы рассеяния». Журнал Американской статистической ассоциации . 74 (368): 829–836. дои : 10.2307/2286407 . JSTOR 2286407 . МР 0556476 .

- Кливленд, Уильям С. (1981). «LOWESS: программа для сглаживания диаграмм рассеяния с помощью надежной локально-взвешенной регрессии». Американский статистик . 35 (1): 54. дои : 10.2307/2683591 . JSTOR 2683591 .

- Кливленд, Уильям С .; Девлин, Сьюзен Дж. (1988). «Локально-взвешенная регрессия: подход к регрессионному анализу путем локальной подгонки». Журнал Американской статистической ассоциации . 83 (403): 596–610. дои : 10.2307/2289282 . JSTOR 2289282 .

- Фокс, Джон; Вайсберг, Сэнфорд (2018). «Приложение: Непараметрическая регрессия в R» (PDF) . R-компаньон прикладной регрессии (3-е изд.). МУДРЕЦ. ISBN 978-1-5443-3645-9 .

- Фридман, Джером Х. (1984). «Сглаживатель с переменным диапазоном» (PDF) . Лаборатория вычислительной статистики. Технический отчет LCS 5, SLAC PUB-3466. Стэнфордский университет.

{{cite journal}}: Для цитирования журнала требуется|journal=( помощь ) - Гаримелла, Рао Вирабхадра (22 июня 2017 г.). «Простое введение в метод наименьших квадратов и оценку локальной регрессии». дои : 10.2172/1367799 . ОСТИ 1367799 .

{{cite journal}}: Для цитирования журнала требуется|journal=( помощь ) - Харрелл, Фрэнк Э. младший (2015). Стратегии регрессионного моделирования: с приложениями к линейным моделям, логистической и порядковой регрессии и анализу выживания . Спрингер. ISBN 978-3-319-19425-7 .

Внешние ссылки

[ редактировать ] в этой статье Использование внешних ссылок может не соответствовать политике и рекомендациям Википедии . ( Ноябрь 2021 г. ) |

- Локальная регрессия и моделирование выборов

- Сглаживание посредством локальной регрессии: принципы и методы (документ PostScript)

- Раздел справочника NIST по инженерной статистике, посвященный LOESS

- Программное обеспечение для локальной настройки

- Сглаживание точечной диаграммы

- R: Подбор локальной полиномиальной регрессии функции Лесса в R

- R: Сглаживание диаграммы рассеяния. Функция Лоусса в R.

- Функция supsmu (SuperSmoother Фридмана) в R

- Квантиль LOESS – метод выполнения локальной регрессии в скользящем окне квантиля (с кодом R).

- Нейт Сильвер, Как меняется мнение об однополых браках и что это значит – образец LOESS в сравнении с линейной регрессией

Реализации

[ редактировать ]- Реализация Фортрана

- Реализация C (из проекта R)

- Реализация Lowess в Cython от Карла Фогеля

- Реализация Python (в Statsmodels)

- ЛЕСС Сглаживание в Excel

- Реализация LOESS в чистой Джулии

- Реализация JavaScript

- Java-реализация

![]() Эта статья включает общедоступные материалы Национального института стандартов и технологий.

Эта статья включает общедоступные материалы Национального института стандартов и технологий.