Марковский процесс принятия решения

В математике процесс принятия решений Маркова ( MDP ) представляет собой с дискретным временем стохастический процесс управления . Он обеспечивает математическую основу для моделирования принятия решений в ситуациях, когда результаты частично случайны , а частично находятся под контролем лица, принимающего решения. MDP полезны для изучения задач оптимизации, решаемых с помощью динамического программирования . MDP были известны по крайней мере еще в 1950-х годах; [1] Основной объем исследований марковских процессов принятия решений стал результатом книги Рональда Ховарда 1960 года « Динамическое программирование и марковские процессы» . [2] Они используются во многих дисциплинах, включая робототехнику , автоматическое управление , экономику и производство . Название MDP происходит от русского математика Андрея Маркова, поскольку они являются продолжением цепей Маркова .

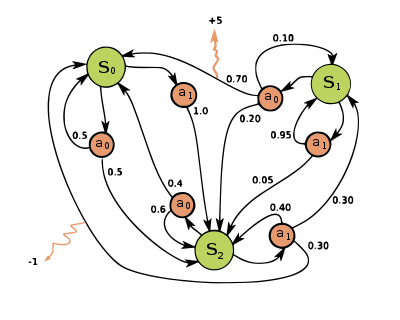

На каждом временном шаге процесс находится в некотором состоянии , и лицо, принимающее решение, может выбрать любое действие который доступен в штате . На следующем временном шаге процесс реагирует случайным переходом в новое состояние. и дать лицу, принимающему решение, соответствующее вознаграждение .

Вероятность состояние перехода процесса в новое зависит от выбранного действия. В частности, это задается функцией перехода состояний . Таким образом, следующее состояние зависит от текущего состояния и действия лица, принимающего решение . Но учитывая и , он условно независим от всех предыдущих состояний и действий; другими словами, переходы состояний MDP удовлетворяют марковскому свойству .

Марковские процессы принятия решений являются расширением цепей Маркова ; разница заключается в добавлении действий (предоставляющих выбор) и вознаграждений (дающих мотивацию). И наоборот, если для каждого состояния существует только одно действие (например, «ожидание») и все вознаграждения одинаковы (например, «ноль»), процесс принятия решения Маркова сводится к цепи Маркова.

Определение [ править ]

Марковский процесс принятия решений представляет собой четырехкортежный процесс . , где:

- представляет собой набор состояний, называемый пространством состояний ,

- представляет собой набор действий, называемый пространством действий (альтернативно, это набор действий, доступных из состояния ),

- это вероятность того, что действие в штате во время приведет к состоянию во время ,

- это немедленная награда (или ожидаемая немедленная награда), полученная после перехода из состояния заявить , из-за действия

Пространства состояний и действий могут быть конечными или бесконечными, например, набор действительных чисел . Некоторые процессы со счётно бесконечными пространствами состояний и действий можно свести к процессам с конечными пространствами состояний и действий. [3]

Политическая функция является (потенциально вероятностным) отображением пространства состояний ( ) в пространство действия ( ).

Цель оптимизации [ править ]

Цель марковского процесса принятия решений — найти хорошую «политику» для лица, принимающего решения: функция который определяет действие что лицо, принимающее решение, выберет, когда находится в состоянии . Когда процесс принятия решений Маркова объединен с политикой таким образом, это фиксирует действие для каждого состояния, и результирующая комбинация ведет себя как цепь Маркова (поскольку действие, выбранное в состоянии полностью определяется и сводится к , матрица марковского перехода).

Цель – выбрать политику. это максимизирует некоторую кумулятивную функцию случайных вознаграждений, обычно ожидаемую дисконтированную сумму на потенциально бесконечном горизонте:

- (где мы выбираем , т.е. действия, заданные политикой). И ожидание взято на себя

где является коэффициентом дисконтирования, удовлетворяющим , которое обычно близко к 1 (например, для некоторой ставки дисконта r). Более низкий коэффициент дисконтирования мотивирует лиц, принимающих решения, отдавать предпочтение принятию мер как можно раньше, а не откладывать их на неопределенный срок.

Политика, которая максимизирует указанную выше функцию, называется оптимальной политикой и обычно обозначается . Конкретный MDP может иметь несколько различных оптимальных политик. Благодаря свойству Маркова можно показать, что оптимальная политика является функцией текущего состояния, как предполагалось выше.

Модели симуляторов [ править ]

Во многих случаях трудно представить распределения вероятностей перехода. , явно. В таких случаях для неявного моделирования MDP можно использовать симулятор, предоставляя образцы из переходных распределений. Одной из распространенных форм неявной модели MDP является эпизодический симулятор среды, который может запускаться из начального состояния и выдавать последующее состояние и вознаграждение каждый раз, когда он получает входное действие. Таким образом траектории состояний, действий и вознаграждений, часто называемые эпизодами могут быть созданы .

Другой формой симулятора является генеративная модель , одношаговый симулятор, который может генерировать образцы следующего состояния и вознаграждать за любое состояние и действие. [4] (Обратите внимание, что это значение отличается от термина «генеративная модель» в контексте статистической классификации.) В алгоритмах , выраженных с использованием псевдокода , часто используется для представления генеративной модели. Например, выражение может обозначать действие выборки из генеративной модели, где и являются текущим состоянием и действием, и и новое состояние и награда. По сравнению с эпизодическим симулятором генеративная модель имеет то преимущество, что она может давать данные из любого состояния, а не только из тех, которые встречаются на траектории.

Эти классы моделей образуют иерархию информационного содержания: явная модель тривиально дает генеративную модель путем выборки из распределений, а повторное применение генеративной модели дает эпизодический симулятор. В обратном направлении изучить приближенные модели можно только посредством регрессии . Тип модели, доступной для конкретного MDP, играет важную роль в определении того, какие алгоритмы решения подходят. Например, алгоритмы динамического программирования, описанные в следующем разделе, требуют явной модели, а поиск по дереву Монте-Карло требует генеративной модели (или эпизодического симулятора, который можно скопировать в любом состоянии), тогда как для большинства алгоритмов обучения с подкреплением требуется только эпизодический симулятор. .

Алгоритмы [ править ]

Решения для MDP с конечными пространствами состояний и действий можно найти с помощью различных методов, таких как динамическое программирование . Алгоритмы в этом разделе применимы к MDP с конечными пространствами состояний и действий и явно заданными вероятностями перехода и функциями вознаграждения, но основные концепции могут быть расширены для обработки других классов проблем, например, с использованием аппроксимации функций .

Стандартное семейство алгоритмов для расчета оптимальных политик для MDP с конечным состоянием и действием требует хранения двух массивов, индексированных по состоянию: значению. , который содержит реальные ценности и политику , который содержит действия. В конце алгоритма будет содержать решение и будет содержать дисконтированную сумму вознаграждений, которые можно получить (в среднем), следуя этому решению из состояния .

Алгоритм состоит из двух этапов: (1) обновление значения и (2) обновление политики, которые повторяются в определенном порядке для всех состояний до тех пор, пока не прекратятся дальнейшие изменения. Оба рекурсивно обновляют новую оценку оптимальной политики и значения состояния, используя более старую оценку этих значений.

Их порядок зависит от варианта алгоритма; можно также сделать их для всех штатов одновременно или для каждого штата, причем для одних штатов чаще, чем для других. Пока ни одно состояние не исключено навсегда из любого из шагов, алгоритм в конечном итоге придет к правильному решению. [5]

Известные варианты [ править ]

Итерация значения [ править ]

В итерации значений ( Беллман 1957 ), которую также называют обратной индукцией ,тот функция не используется; вместо этого значение рассчитывается в пределах всякий раз, когда это необходимо. Подставляя расчет в расчет дает комбинированный шаг [ нужны дальнейшие объяснения ] :

где это номер итерации. Итерация значения начинается с и как предположение о функции значения . Затем он выполняет итерацию, неоднократно вычисляя для всех штатов , до сходится, причем левая часть равна правой части (что является « уравнением Беллмана » для этой задачи [ нужны разъяснения ] ). В статье Ллойда Шепли 1953 года о стохастических играх в качестве особого случая был включен метод итерации значений для MDP: [6] но это было признано лишь позднее. [7]

Итерация политики [ править ]

При итерации политики ( Howard 1960 ) первый шаг выполняется один раз, затем второй шаг выполняется один раз, затем оба повторяются до тех пор, пока политика не сойдется. Затем первый шаг снова выполняется один раз и так далее. (Итерация политики была изобретена Говардом для оптимизации почтовой рассылки по каталогу Sears , которую он оптимизировал с помощью итерации значений. [8] )

Вместо повторения второго шага сходимости его можно сформулировать и решить как набор линейных уравнений. Эти уравнения просто получаются, если сделать в уравнении второго шага. [ нужны разъяснения ] Таким образом, повторение второго шага сходимости можно интерпретировать как решение линейных уравнений путем релаксации .

Преимущество этого варианта состоит в том, что существует определенное условие остановки: когда массив не меняется в ходе применения шага 1 ко всем состояниям, алгоритм завершен.

Итерация политики обычно медленнее, чем итерация значения для большого количества возможных состояний.

Итерация измененной политики [ править ]

В итерации модифицированной политики ( van Nunen 1976 ; Puterman & Shin 1978 ) первый шаг выполняется один раз, а затем второй шаг повторяется несколько раз. [9] [10] Затем первый шаг снова выполняется один раз и так далее.

Приоритетная очистка [ править ]

В этом варианте шаги преимущественно применяются к состояниям, которые в некотором роде важны – основаны ли они на алгоритме (были большие изменения в или вокруг этих состояний в последнее время) или на основе использования (эти состояния находятся рядом с начальным состоянием или иным образом представляют интерес для человека или программы, использующей алгоритм).

Вычислительная сложность [ править ]

Алгоритмы поиска оптимальных политик с полиномиальной временной сложностью от размера представления задачи существуют для конечных MDP. Таким образом, задачи принятия решений основе MDP относятся к классу вычислительной сложности P. на [11] Однако из-за проклятия размерности размер представления проблемы часто экспоненциально зависит от числа переменных состояния и действия, что ограничивает методы точного решения проблемами, имеющими компактное представление. На практике методы онлайн-планирования, такие как поиск по дереву Монте-Карло, могут найти полезные решения для более крупных задач, и теоретически можно построить алгоритмы онлайн-планирования, которые могут найти сколь угодно близкую к оптимальной политику без зависимости сложности вычислений от размера. государственного пространства. [12]

Расширения и обобщения [ править ]

Марковский процесс принятия решений — это стохастическая игра, в которой участвует только один игрок.

Частичная наблюдаемость [ править ]

Решение выше предполагает, что состояние известно, когда необходимо предпринять действия; в противном случае не может быть рассчитано. Когда это предположение неверно, проблема называется частично наблюдаемым марковским процессом принятия решений или POMDP.

Обучение с подкреплением [ править ]

Обучение с подкреплением использует MDP, где вероятности или вознаграждения неизвестны. [13]

Для этой цели полезно определить дополнительную функцию, которая соответствует совершению действия а затем продолжаем оптимально (или в соответствии с любой политикой, которая у вас есть в данный момент):

Хотя эта функция также неизвестна, опыт во время обучения основан на пары (вместе с исходом ; то есть: «Я был в состоянии и я попробовал сделать и произошло"). Таким образом, имеется массив и использует опыт для его непосредственного обновления. Это известно как Q-обучение .

Обучение с подкреплением может решать процессы Марковского решения без явного указания вероятностей перехода; значения вероятностей перехода необходимы в итерации значений и политики. При обучении с подкреплением вместо явного указания вероятностей перехода доступ к вероятностям перехода осуществляется через симулятор, который обычно перезапускается много раз из равномерно случайного начального состояния. Обучение с подкреплением также можно комбинировать с аппроксимацией функций для решения проблем с очень большим количеством состояний.

Обучающиеся автоматы [ править ]

Другое применение процесса MDP в теории машинного обучения называется обучающимися автоматами. Это также один из типов обучения с подкреплением, если среда стохастическая. Первая статья об автоматах с подробным обучением рассмотрена Нарендрой и Татхачаром (1974), которые первоначально были явно описаны как автоматы с конечным состоянием . [14] Подобно обучению с подкреплением, алгоритм обучающего автомата также имеет преимущество в решении проблемы, когда вероятность или вознаграждение неизвестны. Разница между обучающимися автоматами и Q-обучением заключается в том, что первый метод не запоминает Q-значения, но непосредственно обновляет вероятность действия, чтобы найти результат обучения. Автоматы обучения — это схема обучения со строгим доказательством сходимости. [15]

В теории обучающихся автоматов стохастический автомат состоит из:

- набор x возможных входов,

- множество Φ = { Φ 1 , ..., Φ s } возможных внутренних состояний,

- набор α = {α 1 , ..., α r } возможных выходов или действий с r ≤ s ,

- вектор вероятности начального состояния p (0) = ≪ p 1 (0), ..., p s (0) ≫,

- A вычислимая функция , которая после каждого временного шага t генерирует p ( t + 1) из p ( t ), текущего входного сигнала и текущего состояния, и

- функция G : Φ → α, которая генерирует выходные данные на каждом временном шаге.

Состояния такого автомата соответствуют состояниям « марковского процесса с дискретными состояниями и дискретными параметрами ». [16] На каждом временном шаге t = 0,1,2,3,... автомат считывает входные данные из своей среды, обновляет P( t ) до P( t + 1) с помощью A , случайным образом выбирает состояние-преемник в соответствии с вероятности P( t + 1) и выводит соответствующее действие. Среда автомата, в свою очередь, считывает действие и отправляет автомату следующий ввод. [15]

категорийная Теоретико интерпретация -

Помимо вознаграждений, процесс принятия решений по Маркову можно понять с точки зрения теории категорий . А именно, пусть обозначим свободный моноид с порождающим A. множеством Обозначим через Dist Клейсли категорию Жири монады . Тогда функтор кодирует как набор состояний S так и функцию вероятности P. ,

Таким образом, марковские процессы принятия решений можно было бы обобщить от моноидов (категорий с одним объектом) до произвольных категорий. Можно назвать результат , Марковский процесс принятия решений, зависящий от контекста поскольку переход от одного объекта к другому в меняет набор доступных действий и набор возможных состояний. [ нужна ссылка ]

Марковский процесс принятия решений времени в непрерывном

В марковских процессах принятия решений с дискретным временем решения принимаются через дискретные промежутки времени. Однако в марковских процессах принятия решений с непрерывным временем решения могут приниматься в любое время по выбору лица, принимающего решения. По сравнению с марковскими процессами принятия решений с дискретным временем, марковские процессы принятия решений с непрерывным временем могут лучше моделировать процесс принятия решений для системы, которая имеет непрерывную динамику , т. е. динамика системы определяется обыкновенными дифференциальными уравнениями (ОДУ).

Определение [ править ]

Чтобы обсудить марковский процесс принятия решений в непрерывном времени, мы вводим два набора обозначений:

Если пространство состояний и пространство действий конечны,

- : Государственное пространство;

- : Пространство действия;

- : , функция скорости перехода;

- : , функция вознаграждения.

Если пространство состояний и пространство действий непрерывны,

- : пространство состояний;

- : пространство возможного контроля;

- : , функция скорости перехода;

- : , функция ставки вознаграждения такая, что , где — это функция вознаграждения, которую мы обсуждали в предыдущем случае.

Проблема [ править ]

Подобно марковским процессам принятия решений с дискретным временем, в марковских процессах принятия решений с непрерывным временем мы хотим найти оптимальную политику или управление , которые могли бы дать нам оптимальное ожидаемое интегрированное вознаграждение:

где

программирования Формулировка линейного

Если пространство состояний и пространство действий конечны, мы могли бы использовать линейное программирование для поиска оптимальной политики, что было одним из первых примененных подходов. Здесь мы рассматриваем только эргодическую модель, что означает, что наша MDP с непрерывным временем становится эргодической цепью Маркова с непрерывным временем при стационарной политике . Согласно этому предположению, хотя лицо, принимающее решения, может принять решение в любой момент в текущем состоянии, оно не сможет получить большей выгоды, предприняв более одного действия. Им лучше предпринимать действия только в тот момент, когда система переходит из текущего состояния в другое. При некоторых условиях (подробнее см. Следствие 3.14 марковских процессов принятия решений в непрерывном времени ), если наша функция оптимального значения независим от государства , мы будем иметь следующее неравенство:

Если существует функция , затем будет самым маленьким удовлетворяющее приведенному выше уравнению. Чтобы найти мы могли бы использовать следующую модель линейного программирования:

- Первичная линейная программа (P-LP)

- Двойная линейная программа (D-LP)

является допустимым решением D-LP, если является неродным и удовлетворяет ограничениям задачи D-LP. Возможное решение к D-LP называется оптимальным решением, если

для всех возможных решений в Д-ЛП. Как только мы нашли оптимальное решение , мы можем использовать его для установления оптимальной политики.

Уравнение Гамильтона–Якоби–Беллмана [ править ]

В MDP с непрерывным временем, если пространство состояний и пространство действий непрерывны, оптимальный критерий может быть найден путем решения уравнения в частных производных Гамильтона – Якоби – Беллмана (HJB) . Чтобы обсудить уравнение HJB, нам нужно переформулироватьнаша проблема

— функция вознаграждения терминала, вектор состояния системы, — вектор управления системой, который мы пытаемся найти. показывает, как вектор состояния меняется со временем. Уравнение Гамильтона – Якоби – Беллмана имеет следующий вид:

Мы могли бы решить уравнение, чтобы найти оптимальное управление , что могло бы дать нам оптимальную функцию значения

Приложение [ править ]

Марковские процессы принятия решений в непрерывном времени имеют приложения в системах массового обслуживания , эпидемических процессах и процессах народонаселения .

Альтернативные обозначения [ править ]

Терминология и обозначения для MDP не совсем устоялись. Существует два основных направления: одно фокусируется на проблемах максимизации из таких контекстов, как экономика, используя термины действие, вознаграждение, ценность и вызывая коэффициент дисконтирования β или γ , тогда как другое фокусируется на проблемах минимизации из инженерного дела и навигации. [ нужна ссылка ] , используя термины контроль, стоимость, себестоимость и вызывая коэффициент дисконтирования α . Кроме того, различаются обозначения вероятности перехода.

| в этой статье | альтернатива | комментарий |

|---|---|---|

| действие а | контролировать тебя | |

| награда R | стоимость г | g — отрицательный результат R |

| значение В | себестоимость J | J - отрицательный результат V |

| политика π | политика м | |

| коэффициент дисконтирования γ | коэффициент дисконтирования α | |

| вероятность перехода | вероятность перехода |

Кроме того, вероятность перехода иногда пишут , или, редко,

процессы принятия решений ограничениями с Марковские

Марковские процессы принятия решений с ограничениями (CMDPS) являются расширением марковского процесса принятия решений (MDP). Между MDP и CMDP есть три фундаментальных различия. [17]

- После применения действия возникает несколько затрат вместо одной.

- CMDP решаются только линейными программами , динамическое программирование не работает.

- Окончательная политика зависит от начального состояния.

К CMDP применяется метод множителей Лагранжа.Было разработано множество алгоритмов на основе Лагранжа.

- Естественно-политический градиентный первично-двойственный метод. [18]

Существует ряд приложений для CMDP. Недавно он использовался в сценариях планирования движения в робототехнике. [19]

См. также [ править ]

- Вероятностные автоматы

- Алгоритм шансов

- Сколько у вас роботов?

- Частично наблюдаемый марковский процесс принятия решений

- Динамическое программирование

- Уравнение Беллмана для приложения к экономике.

- Уравнение Гамильтона – Якоби – Беллмана

- Оптимальное управление

- Рекурсивная экономика

- Проблема с овцами Мабиногиона

- Стохастические игры

- Q-обучение

Ссылки [ править ]

- ^ Беллман, Р. (1957). «Марковский процесс принятия решений» . Журнал математики и механики . 6 (5): 679–684. JSTOR 24900506 .

- ^ Ховард, Рональд А. (1960). Динамическое программирование и марковские процессы . Массачусетский технологический институт Пресс.

- ^ Врубель, А. (1984). «О марковских моделях принятия решений с конечным скелетом». Математические методы исследования операций . 28 (февраль): 17–27. дои : 10.1007/bf01919083 . S2CID 2545336 .

- ^ Кернс, Майкл; Мансур, Ишай; Нг, Эндрю (2002). «Алгоритм разреженной выборки для почти оптимального планирования в больших марковских процессах принятия решений» . Машинное обучение . 49 (193–208): 193–208. дои : 10.1023/A:1017932429737 .

- ^ Обучение с подкреплением: теория и реализация на Python . Пекин: Китайская машинная пресса. 2019. с. 44. ИСБН 9787111631774 .

- ^ Шепли, Ллойд (1953). «Стохастические игры» . Труды Национальной академии наук Соединенных Штатов Америки . 39 (10): 1095–1100. Бибкод : 1953PNAS...39.1095S . дои : 10.1073/pnas.39.10.1095 . ПМЦ 1063912 . ПМИД 16589380 .

- ^ Калленберг, Лодевейк (2002). «Конечное состояние и MDP действия». В Фейнберге, Юджин А .; Шварц, Адам (ред.). Справочник по марковским процессам принятия решений: методы и приложения . Спрингер. ISBN 978-0-7923-7459-6 .

- ^ Ховард 2002, «Комментарии о происхождении и применении марковских процессов принятия решений»

- ^ Путерман, М.Л.; Шин, MC (1978). «Модифицированные алгоритмы итерации политики для дисконтированных марковских задач принятия решений». Наука управления . 24 (11): 1127–1137. дои : 10.1287/mnsc.24.11.1127 .

- ^ ван Нунен, JAE E (1976). «Набор методов последовательного приближения для дисконтированных марковских задач решения». Zeitschrift für Operations Research . 20 (5): 203–208. дои : 10.1007/bf01920264 . S2CID 5167748 .

- ^ Пападимитриу, Христос ; Цициклис, Джон (1987). «Сложность марковских процессов принятия решений» . Математика исследования операций . 12 (3). дои : 10.1287/moor.12.3.441 . hdl : 1721.1/2893 . Проверено 2 ноября 2023 г.

- ^ Кернс, Майкл; Мансур, Ишай; Нг, Эндрю (ноябрь 2002 г.). «Алгоритм разреженной выборки для почти оптимального планирования в больших марковских процессах принятия решений» . Машинное обучение . 49 . дои : 10.1023/A:1017932429737 . Проверено 2 ноября 2023 г.

- ^ Шохам, Ю.; Пауэрс, Р.; Гренагер, Т. (2003). «Многоагентное обучение с подкреплением: критический обзор» (PDF) . Технический отчет, Стэнфордский университет : 1–13 . Проверено 12 декабря 2018 г.

- ^ Нарендра, Канзас ; Татачар, МАЛ (1974). «Обучающиеся автоматы. Обзор». Транзакции IEEE по системам, человеку и кибернетике . СМК-4 (4): 323–334. CiteSeerX 10.1.1.295.2280 . дои : 10.1109/TSMC.1974.5408453 . ISSN 0018-9472 .

- ↑ Перейти обратно: Перейти обратно: а б Нарендра, Кумпати С .; Татачар, Мандаям А.Л. (1989). Обучающиеся автоматы: Введение . Прентис Холл. ISBN 9780134855585 .

- ^ Нарендра и Татачар 1974 , стр.325 слева.

- ^ Альтман, Эйтан (1999). Марковские процессы принятия решений с ограничениями . Том. 7. ЦРК Пресс.

- ^ Дин, Дуншэн; Чжан, Кайцин; Йованович, Михайло; Басар, Тамер (2020). Первично-двойственный метод градиента естественной политики для марковских процессов принятия решений с ограничениями . Достижения в области нейронных систем обработки информации.

- ^ Фейзабади, С.; Карпин, С. (18–22 августа 2014 г.). «Планирование пути с учетом рисков с использованием иерархических марковских процессов принятия решений с ограничениями» . Наука и техника автоматизации (CASE) . Международная конференция IEEE. стр. 297, 303.

Дальнейшее чтение [ править ]

- Беллман., RE (2003) [1957]. Динамическое программирование (изд. Дувр в мягкой обложке). Принстон, Нью-Джерси: Издательство Принстонского университета. ISBN 978-0-486-42809-3 .

- Берцекас, Д. (1995). Динамическое программирование и оптимальное управление . Том. 2. МА: Афина.

- Дерман, К. (1970). Марковские процессы принятия решений с конечными состояниями . Академическая пресса.

- Фейнберг, Э.А.; Шварц А., ред. (2002). Справочник по марковским процессам принятия решений . Бостон, Массачусетс: Клувер. ISBN 9781461508052 .

- Го, X.; Эрнандес-Лерма, О. (2009). Марковские процессы принятия решений в непрерывном времени . Стохастическое моделирование и прикладная теория вероятности. Спрингер. ISBN 9783642025464 .

- Мейн, СП (2007). Методы управления сложными сетями . Издательство Кембриджского университета. ISBN 978-0-521-88441-9 . Архивировано из оригинала 19 июня 2010 года. Приложение содержит сокращенные версии. «Мейн и Твиди» . Архивировано из оригинала 18 декабря 2012 года.

- Путерман., МЛ (1994). Марковские процессы принятия решений . Уайли.

- Росс, С.М. (1983). Введение в стохастическое динамическое программирование (PDF) . Академическая пресса.

- Саттон, РС; Барто, АГ (2017). Обучение с подкреплением: Введение . Кембридж, Массачусетс: MIT Press.

- Таймс, ХК (2003). Первый курс стохастических моделей . Уайли. ISBN 9780470864289 .

![{\displaystyle E\left[\sum _{t=0}^{\infty }{\gamma ^{t}R_{a_{t}}(s_{t},s_{t+1})}\right ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/712f6adf8034f0df53957e45ab0f35441bef017e)

![{\displaystyle \max \operatorname {E} _{u}\left[\left.\int _{0}^{\infty }\gamma ^{t}r(x(t),u(t))\ ,dt\;\right|x_{0}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e05a1fdbeab7160d561b264525d725cf592bda79)

![{\displaystyle {\begin{aligned}V(x(0),0)={}&\max _{u}\int _{0}^{T}r(x(t),u(t)) \,dt+D[x(T)]\\{\text{st}}\quad &{\frac {dx(t)}{dt}}=f[t,x(t),u(t) ]\end{выровнено}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3b798dc9345b260fe104fc55b5cdb475d1f9e006)