Вариационные байесовские методы

| Часть серии о |

| Байесовская статистика |

|---|

| Апостериорный = Вероятность × Априорный ÷ Доказательства |

| Фон |

| Модельное здание |

| Апостериорное приближение |

| Оценщики |

| Приближение доказательств |

| Оценка модели |

Вариационные байесовские методы — это семейство методов аппроксимации трудноразрешимых интегралов, возникающих при байесовском выводе и машинном обучении . Они обычно используются в сложных статистических моделях, состоящих из наблюдаемых переменных (обычно называемых «данными»), а также неизвестных параметров и скрытых переменных , с различными видами отношений между тремя типами случайных величин , которые могут быть описаны графической моделью . Как это типично для байесовского вывода, параметры и скрытые переменные группируются вместе как «ненаблюдаемые переменные». Вариационные байесовские методы в основном используются для двух целей:

- Обеспечить аналитическую аппроксимацию апостериорной вероятности ненаблюдаемых переменных, чтобы сделать статистические выводы по этим переменным.

- Получить нижнюю границу ( предельной вероятности иногда называемой доказательством ) наблюдаемых данных (т. е. предельной вероятности данных с учетом модели с маргинализацией, выполняемой по ненаблюдаемым переменным). Обычно это используется для выбора модели , общая идея заключается в том, что более высокая предельная вероятность для данной модели указывает на лучшее соответствие данных этой моделью и, следовательно, большую вероятность того, что рассматриваемая модель была той, которая сгенерировала данные. (См. также статью о байесовском факторе .)

В первой цели (аппроксимация апостериорной вероятности) вариационный Байес является альтернативой методам выборки Монте-Карло , в частности, методам Монте-Карло с цепью Маркова , таким как выборка Гиббса , для использования полностью байесовского подхода к статистическому выводу по сложным распределениям , которые трудно оценить напрямую или по образцу . В частности, в то время как методы Монте-Карло обеспечивают численную аппроксимацию точной апостериорной функции с использованием набора выборок, вариационный Байес обеспечивает локально оптимальное, точное аналитическое решение для аппроксимации апостериорной функции.

Вариационный Байес можно рассматривать как расширение алгоритма ожидания-максимизации (EM) от максимальной апостериорной оценки (оценка MAP) единственного наиболее вероятного значения каждого параметра до полностью байесовской оценки, которая вычисляет (приближение) всего апостериорного распределения. параметров и скрытых переменных. Как и в EM, он находит набор оптимальных значений параметров и имеет ту же переменную структуру, что и EM, основанную на наборе взаимосвязанных (взаимозависимых) уравнений, которые не могут быть решены аналитически.

Для многих приложений вариационный Байес дает решения, сравнимые по точности с выборкой Гиббса, но с большей скоростью. Однако получение набора уравнений, используемых для итеративного обновления параметров, часто требует большого объема работы по сравнению с получением сопоставимых уравнений выборки Гиббса. Это справедливо даже для многих моделей, которые концептуально довольно просты, как показано ниже в случае базовой неиерархической модели только с двумя параметрами и без скрытых переменных.

Математический вывод

[ редактировать ]Проблема

[ редактировать ]В вариационном выводе апостериорное распределение по набору ненаблюдаемых переменных учитывая некоторые данные аппроксимируется так называемым вариационным распределением ,

Распределение ограничивается принадлежностью к семейству распределений более простой формы, чем (например, семейство гауссовских распределений), выбранное с намерением сделать аналогичен истинному заднему, .

Сходство (или несходство) измеряется с помощью функции несходства. и, следовательно, вывод выполняется путем выбора распределения что сводит к минимуму .

Дивергенция КЛ

[ редактировать ]Наиболее распространенный тип вариационного Байеса использует расхождение Кульбака – Лейблера (KL-дивергенцию) Q от P в качестве функции несходства. Этот выбор делает эту минимизацию осуществимой. KL-дивергенция определяется как

Обратите внимание, что Q и P перевернуты, чего можно было ожидать. Такое использование обратной КЛ-дивергенции концептуально похоже на алгоритм ожидания-максимизации . (Другое использование KL-дивергенции приводит к алгоритму распространения ожиданий .)

несговорчивость

[ редактировать ]Вариационные методы обычно используются для формирования аппроксимации:

Маргинализация закончилась рассчитать в знаменателе обычно трудноразрешима, потому что, например, пространство поиска является комбинаторно большим. Поэтому мы ищем приближение, используя .

Нижняя граница доказательств

[ редактировать ]При условии , KL-дивергенция, указанная выше, также может быть записана как

Потому что является константой по отношению к и потому что это дистрибутив, у нас есть

которое согласно определению ожидаемого значения (для дискретной случайной величины ) можно записать следующим образом

который можно переставить так, чтобы он стал

Как журнал- свидетельство фиксируется относительно , максимизируя последний член минимизирует расхождение KL от . При соответствующем выборе , становится доступным для вычислений и максимизации. Следовательно, мы имеем как аналитическое приближение для задней части и нижняя граница для протокола-доказательства (поскольку KL-дивергенция неотрицательна).

Нижняя граница известна как (отрицательная) вариационная свободная энергия по аналогии с термодинамической свободной энергией , поскольку ее также можно выразить как отрицательную энергию. плюс энтропия . Термин также известен как Нижняя граница доказательств , сокращенно ELBO , чтобы подчеркнуть, что это нижняя граница (наихудший случай) логарифмической достоверности данных.

Доказательства

[ редактировать ]С помощью обобщенной теоремы Пифагора о дивергенции Брегмана , частным случаем которой является KL-дивергенция, можно показать, что: [1] [2]

где является выпуклым множеством и равенство имеет место, если:

В этом случае глобальный минимизатор с можно найти следующим образом: [1]

в котором нормировочная константа равна:

Термин на практике часто называют нижней границей доказательств ( ELBO ), поскольку , [1] как показано выше.

Поменявшись ролями и мы можем итеративно вычислить приближенное и маргинальных значений истинной модели и соответственно. Хотя эта итерационная схема гарантированно сходится монотонно, [1] конвергентный является лишь локальным минимизатором .

Если ограниченное пространство заключен в независимое пространство, т.е. приведенная выше итерационная схема станет так называемым приближением среднего поля как показано ниже.

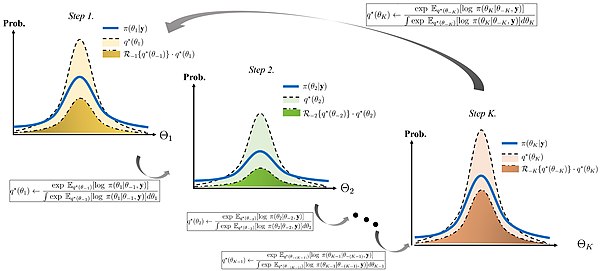

Приближение среднего поля

[ редактировать ]Вариационное распределение обычно предполагается, что факторизуется по некоторому разделу скрытых переменных, т.е. по некоторому разделу скрытых переменных в ,

можно показать, что «лучшее» распределение С помощью вариационного исчисления (отсюда и название «вариационный Байес») по каждому из факторов (с точки зрения распределения, минимизирующего KL-расхождение, как описано выше) удовлетворяет: [3]

где - это математическое ожидание логарифма совместной вероятности данных и скрытых переменных, взятого относительно по всем переменным, не входящим в разбиение: см. лемму 4.1 из [4] для вывода распределения .

На практике мы обычно работаем с логарифмами, т.е.:

Константа в приведенном выше выражении связана с константой нормализации (знаменатель в приведенном выше выражении для ) и обычно восстанавливается при проверке, поскольку остальную часть выражения обычно можно распознать как распределение известного типа (например, Гауссово , гамма и т. д.).

Используя свойства ожиданий, выражение обычно можно упростить до функции фиксированных гиперпараметров предшествующих распределений по скрытым переменным и ожиданий (а иногда и более высоких моментов, таких как дисперсия ) скрытых переменных, не входящих в текущий раздел (т.е. скрытых переменных, не включенных в ). Это создает круговые зависимости между параметрами распределений переменных в одном разделе и ожиданиями переменных в других разделах. Это, естественно, предполагает итерационный алгоритм, очень похожий на EM ( алгоритм максимизации ожидания ), в котором ожидания (и, возможно, более высокие моменты) скрытых переменных инициализируются каким-то образом (возможно, случайным образом), а затем параметры каждого распределения вычисляется, в свою очередь, с использованием текущих значений ожиданий, после чего ожидание вновь вычисленного распределения устанавливается соответствующим образом в соответствии с вычисленными параметрами. Алгоритм такого типа гарантированно сходится . [5]

Другими словами, для каждого из разбиений переменных, упростив выражение распределения по переменным разбиения и исследовав функциональную зависимость распределения от рассматриваемых переменных, обычно можно определить семейство распределения (что, в свою очередь, определяет значение константы). Формула для параметров распределения будет выражаться через гиперпараметры предыдущих распределений (которые являются известными константами), а также через ожидания функций переменных в других разделах. Обычно эти ожидания можно упростить до функций ожиданий самих переменных (т.е. средств ); иногда также появляются ожидания квадратов переменных (которые могут быть связаны с дисперсией переменных) или ожидания более высоких степеней (т.е. более высоких моментов ). В большинстве случаев распределения других переменных будут принадлежать к известным семействам, и можно найти формулы для соответствующих ожиданий. Однако эти формулы зависят от параметров этих распределений, которые, в свою очередь, зависят от ожиданий относительно других переменных. В результате формулы для параметров распределений каждой переменной могут быть выражены в виде серии уравнений с взаимными нелинейные зависимости между переменными. Обычно решить эту систему уравнений напрямую не представляется возможным. Однако, как описано выше, зависимости предполагают простой итерационный алгоритм, который в большинстве случаев гарантированно сходится. Пример сделает этот процесс более понятным.

Формула двойственности для вариационного вывода

[ редактировать ]

Следующая теорема называется формулой двойственности для вариационного вывода. [4] Это объясняет некоторые важные свойства вариационных распределений, используемых в вариационных методах Байеса.

Теорема. Рассмотрим два вероятностных пространства. и с . Предположим, что существует общая доминирующая вероятностная мера такой, что и . Позволять обозначают любую действительную случайную величину на это удовлетворяет . Тогда имеет место равенство

Далее, верхняя грань в правой части достигается тогда и только тогда, когда выполняется

почти наверняка относительно вероятностной меры , где и обозначим производные Радона–Никодима вероятностных мер и относительно , соответственно.

Базовый пример

[ редактировать ]Рассмотрим простую неиерархическую байесовскую модель, состоящую из набора наблюдений iid из гауссовского распределения с неизвестными средним значением и дисперсией . [6] Далее мы подробно рассмотрим эту модель, чтобы проиллюстрировать работу вариационного метода Байеса.

Для математического удобства в следующем примере мы работаем с точки зрения точности — то есть обратной величины дисперсии (или в многомерном гауссове, обратной ковариационной матрице ) — а не самой дисперсии. (С теоретической точки зрения точность и дисперсия эквивалентны, поскольку существует взаимно однозначное соответствие между ними .)

Математическая модель

[ редактировать ]Мы помещаем сопряженные априорные распределения в неизвестное среднее значение и точность т.е. среднее значение также соответствует распределению Гаусса, а точность соответствует гамма-распределению . Другими словами:

Гиперпараметры и в предыдущих распределениях фиксированы заданные значения. Им можно задать небольшие положительные числа, чтобы получить широкие априорные распределения, указывающие на незнание априорных распределений. и .

Нам дано точки данных и наша цель — вывести апостериорное распределение параметров и

Совместная вероятность

[ редактировать ]Совместную вероятность всех переменных можно переписать как

где отдельные факторы

где

Факторизованное приближение

[ редактировать ]Предположим, что , т. е. что апостериорное распределение разлагается на независимые факторы для и . Этот тип предположения лежит в основе вариационного байесовского метода. Истинное апостериорное распределение на самом деле не учитывает этот фактор (на самом деле, в этом простом случае известно, что оно представляет собой гамма-распределение Гаусса ), и, следовательно, результат, который мы получим, будет аппроксимацией.

Вывод q ( µ )

[ редактировать ]Затем

В приведенном выше выводе , и относятся к значениям, которые постоянны по отношению к . Обратите внимание, что термин не является функцией и будет иметь одно и то же значение независимо от значения . Следовательно, в строке 3 мы можем объединить его с постоянным членом в конце. То же самое делаем в строке 7.

Последняя строка представляет собой просто квадратичный полином от . Так как это логарифм , мы можем это видеть само по себе является распределением Гаусса .

С помощью определенного количества утомительных математических вычислений (расширение квадратов внутри фигурных скобок, выделение и группировка терминов, включающих и и квадрат завершаем ), мы можем вывести параметры распределения Гаусса:

Обратите внимание, что все вышеперечисленные шаги можно сократить, используя формулу суммы двух квадратичных дробей .

Другими словами:

Вывод q(τ)

[ редактировать ]Вывод аналогично предыдущему, хотя для краткости мы опускаем некоторые детали.

Возведя в степень обе стороны, мы увидим, что представляет собой гамма-распределение . Конкретно:

Алгоритм расчета параметров

[ редактировать ]Подведем итоги предыдущих разделов:

и

В каждом случае параметры распределения по одной из переменных зависят от ожиданий, принятых по отношению к другой переменной. Мы можем расширить ожидания, используя стандартные формулы для математических ожиданий моментов гауссовского и гамма-распределений:

Применение этих формул к приведенным выше уравнениям в большинстве случаев тривиально, но уравнение для требует больше работы:

Затем мы можем записать уравнения параметров следующим образом, без каких-либо ожиданий:

Обратите внимание, что между формулами для и . Это, естественно, предполагает EM -подобный алгоритм:

- Вычислить и Используйте эти значения для вычисления и

- Инициализировать до некоторого произвольного значения.

- Используйте текущее значение наряду с известными значениями других параметров, чтобы вычислить .

- Используйте текущее значение наряду с известными значениями других параметров, чтобы вычислить .

- Повторяйте последние два шага до тех пор, пока не произойдет сходимость (т. е. пока ни одно из значений не изменится более чем на небольшую величину).

Затем у нас есть значения гиперпараметров аппроксимирующих распределений апостериорных параметров, которые мы можем использовать для вычисления любых желаемых свойств апостериорного показателя — например, его среднего значения и дисперсии, 95%-ной области с самой высокой плотностью (наименьший интервал, включающий 95 % от общей вероятности) и т. д.

Можно показать, что этот алгоритм гарантированно сходится к локальному максимуму.

Отметим также, что апостериорные распределения имеют ту же форму, что и соответствующие априорные распределения. Мы не этого предполагали; единственное предположение, которое мы сделали, заключалось в том, что распределения факторизуются, и форма распределений получается естественным образом. Оказывается (см. ниже), что тот факт, что апостериорные распределения имеют ту же форму, что и априорные распределения, является не совпадением, а общим результатом всякий раз, когда априорные распределения являются членами экспоненциального семейства , что имеет место для большинства стандартные дистрибутивы.

Дальнейшее обсуждение

[ редактировать ]Пошаговый рецепт

[ редактировать ]В приведенном выше примере показан метод, с помощью которого вариационно-байесовская аппроксимация апостериорной плотности вероятности в данной байесовской сети выводится :

- Опишите сеть с помощью графической модели , определив наблюдаемые переменные (данные). и ненаблюдаемые переменные ( параметры и скрытые переменные ) и их условные распределения вероятностей . Затем вариационный Байес построит аппроксимацию апостериорной вероятности. . Основное свойство аппроксимации состоит в том, что это факторизованное распределение, т.е. произведение двух или более независимых распределений по непересекающимся подмножествам ненаблюдаемых переменных.

- Разделите ненаблюдаемые переменные на два или более подмножества, на основе которых будут получены независимые факторы. Для этого не существует универсальной процедуры; создание слишком большого количества подмножеств дает плохую аппроксимацию, а создание слишком малого количества делает всю вариационную процедуру Байеса неразрешимой. Обычно первое разделение заключается в разделении параметров и скрытых переменных; часто этого достаточно, чтобы получить приемлемый результат. Предположим, что разделы называются .

- Для данного раздела , запишите формулу наилучшего аппроксимирующего распределения используя основное уравнение .

- Заполните формулу совместного распределения вероятностей, используя графическую модель. Любые условные распределения компонентов, которые не включают ни одну из переменных в можно игнорировать; они будут свернуты в постоянный член.

- Упростите формулу и примените оператор ожидания, следуя приведенному выше примеру. В идеале это должно упроститься до ожиданий базовых функций переменных, не входящих в (например, первый или второй необработанные моменты , математическое ожидание логарифма и т. д.). Чтобы вариационная процедура Байеса работала хорошо, эти ожидания обычно должны быть выражены аналитически как функции параметров и/или гиперпараметров распределений этих переменных. Во всех случаях эти математические ожидания являются константами по отношению к переменным в текущем разделе.

- Функциональная форма формулы относительно переменных текущего раздела указывает на тип распределения. В частности, возведение формулы в степень генерирует функцию плотности вероятности (PDF) распределения (или, по крайней мере, что-то пропорциональное ей с неизвестной константой нормализации ). Чтобы весь метод был управляемым, должна быть возможность распознать, что функциональная форма принадлежит известному распределению. Для преобразования формулы в форму, соответствующую PDF известного распределения, могут потребоваться значительные математические манипуляции. Когда это возможно, константа нормализации может быть восстановлена по определению, а уравнения для параметров известного распределения могут быть получены путем извлечения соответствующих частей формулы.

- Когда все ожидания могут быть аналитически заменены функциями переменных, не входящих в текущее разбиение, а PDF-файл представлен в форме, позволяющей идентифицировать его с известным распределением, результатом является набор уравнений, выражающих значения оптимальных параметров как функции параметры переменных в других разделах.

- Когда эту процедуру можно применить ко всем разделам, результатом является набор взаимосвязанных уравнений, определяющих оптимальные значения всех параметров.

- Затем применяется процедура типа ожидания-максимизации (EM), выбирающая начальное значение для каждого параметра и повторяющаяся серия шагов, где на каждом этапе мы циклически просматриваем уравнения, обновляя каждый параметр по очереди. Это гарантированно сходится.

Наиболее важные моменты

[ редактировать ]Из-за всех математических манипуляций легко потерять общую картину. Важные вещи:

- Идея вариационного Байеса состоит в том, чтобы построить аналитическую аппроксимацию апостериорной вероятности набора ненаблюдаемых переменных (параметров и скрытых переменных) по данным. Это означает, что форма решения аналогична другим методам байесовского вывода , таким как выборка Гиббса — то есть распределение, которое стремится описать все, что известно о переменных. Как и в других байесовских методах – но в отличие, например, от методов максимизации ожидания (EM) или других методов максимального правдоподобия – оба типа ненаблюдаемых переменных (т.е. параметры и скрытые переменные) обрабатываются одинаково, т.е. как случайные величины . Оценки переменных затем можно получить стандартными байесовскими способами, например, вычислив среднее значение распределения для получения одноточечной оценки или выведя достоверный интервал , область с наибольшей плотностью и т. д.

- «Аналитическая аппроксимация» означает, что можно записать формулу апостериорного распределения. Формула обычно состоит из произведения известных распределений вероятностей, каждое из которых факторизуется по набору ненаблюдаемых переменных (т.е. оно условно независимо от других переменных с учетом наблюдаемых данных). Эта формула не является истинным апостериорным распределением, а является его приближением; в частности, оно, как правило, довольно близко согласуется в самые низкие моменты ненаблюдаемых переменных, например среднего значения и дисперсии .

- Результатом всех математических манипуляций является (1) идентичность распределений вероятностей, составляющих факторы, и (2) взаимозависимые формулы для параметров этих распределений. Фактические значения этих параметров вычисляются численно с помощью поочередной итерационной процедуры, очень похожей на EM.

По сравнению с ожиданием-максимизацией (EM)

[ редактировать ]Вариационный байесовский метод (ВБ) часто сравнивают с ожиданием-максимизацией (ЕМ). Реальная численная процедура очень похожа, поскольку обе они представляют собой чередующиеся итерационные процедуры, которые последовательно сходятся к оптимальным значениям параметров. Начальные шаги по получению соответствующих процедур также отчасти схожи: оба начинаются с формул для плотностей вероятности и оба включают значительное количество математических манипуляций.

Однако существует ряд различий. Самое главное — то, что вычисляется.

- EM вычисляет точечные оценки апостериорного распределения тех случайных величин, которые можно отнести к категории «параметров», но только оценки фактических апостериорных распределений скрытых переменных (по крайней мере, в «мягком EM», и часто только тогда, когда скрытые переменные дискретны). ). Вычисленные точечные оценки представляют собой моды этих параметров; никакой другой информации нет.

- VB, с другой стороны, вычисляет оценки фактического апостериорного распределения всех переменных, как параметров, так и скрытых переменных. Когда необходимо получить точечные оценки, обычно среднее значение используется , а не мода, как это обычно бывает в байесовском выводе. При этом параметры, рассчитанные в VB, не имеют того же значения, что и в EM. EM сама вычисляет оптимальные значения параметров сети Байеса. VB вычисляет оптимальные значения параметров распределений, используемых для аппроксимации параметров и скрытых переменных сети Байеса. Например, типичная модель гауссовой смеси будет иметь параметры для среднего значения и дисперсии каждого из компонентов смеси. ЭМ будет напрямую оценивать оптимальные значения этих параметров. Однако VB сначала подгонял бы распределение под эти параметры — обычно в форме априорного распределения , например, обратного гамма-распределения в нормальном масштабе — и затем вычислял бы значения параметров этого априорного распределения, т.е. гиперпараметры . В этом случае VB вычислит оптимальные оценки четырех параметров обратного гамма-распределения в нормальном масштабе, которое описывает совместное распределение среднего значения и дисперсии компонента.

Более сложный пример

[ редактировать ]

Представьте себе модель байесовской смеси Гаусса, описываемую следующим образом: [3]

Примечание:

- SymDir() — симметричное распределение Дирихле размерности. , с гиперпараметром для каждого компонента, установленным на . Распределение Дирихле является сопряженным априорным по отношению к категориальному распределению или полиномиальному распределению .

- — это распределение Уишарта , которое является сопряженным априором матрицы точности (обратной ковариационной матрицы ) для многомерного распределения Гаусса .

- Mult() — это полиномиальное распределение по одному наблюдению (эквивалентно категориальному распределению ). Пространство состояний представляет собой представление «один из K», т.е. -мерный вектор, в котором один из элементов равен 1 (определяющий идентичность наблюдения), а все остальные элементы равны 0.

- - это распределение Гаусса , в данном случае именно многомерное распределение Гаусса .

Интерпретация вышеуказанных переменных следующая:

- это набор точки данных, каждая из которых представляет собой -мерный вектор, распределенный согласно многомерному распределению Гаусса .

- представляет собой набор скрытых переменных, по одной на каждую точку данных, определяющих, какому компоненту смеси принадлежит соответствующая точка данных, с использованием векторного представления «один из K» с компонентами для , как описано выше.

- это пропорции смешивания компоненты смеси.

- и укажите параметры ( среднее значение и точность ), связанные с каждым компонентом смеси.

Совместную вероятность всех переменных можно переписать как

где отдельные факторы

где

Предположим, что .

Затем [3]

где мы определили

Возведение в степень обеих частей формулы для урожайность

Требование, чтобы это было нормализовано, в конечном итоге требует, чтобы суммировать до 1 по всем значениям , уступая

где

Другими словами, является продуктом полиномиальных распределений одного наблюдения и факторов по каждому отдельному наблюдению. , которое распространяется как полиномиальное распределение одного наблюдения с параметрами для .

Кроме того, отметим, что

что является стандартным результатом для категориальных распределений.

Теперь, учитывая фактор , обратите внимание, что это автоматически учитывается из-за структуры графической модели, определяющей нашу модель гауссовской смеси, указанной выше.

Затем,

Взяв экспоненту обеих сторон, мы узнаем как распределение Дирихле

где

где

Окончательно

Группировка и чтение терминов, включающих и , результатом является распределение Гаусса-Вишарта , определяемое формулой

учитывая определения

Наконец, обратите внимание, что эти функции требуют значений , которые используют , который, в свою очередь, определяется на основе , , и . Теперь, когда мы определили распределения, по которым берутся эти ожидания, мы можем вывести для них формулы:

Эти результаты приводят к

Их можно преобразовать из пропорциональных в абсолютные значения путем нормализации по так что сумма соответствующих значений равна 1.

Обратите внимание, что:

- Уравнения обновления параметров , , и переменных и зависит от статистики , , и , а эта статистика, в свою очередь, зависит от .

- Уравнения обновления параметров переменной зависит от статистики , что, в свою очередь, зависит от .

- Уравнение обновления для имеет прямую круговую зависимость от , , и а также косвенная круговая зависимость от , и через и .

Это предполагает итеративную процедуру, которая чередует два этапа:

- E-шаг, который вычисляет значение используя текущие значения всех остальных параметров.

- M-шаг, использующий новое значение для вычисления новых значений всех остальных параметров.

Обратите внимание, что эти шаги тесно связаны со стандартным алгоритмом EM для получения максимального правдоподобия или максимального апостериорного (MAP) решения для параметров модели гауссовой смеси . Обязанности на этапе E близко соответствуют апостериорным вероятностям скрытых переменных с учетом данных, т.е. ; расчет статистики , , и близко соответствует вычислению соответствующей статистики «мягкого подсчета» по данным; и использование этой статистики для вычисления новых значений параметров близко соответствует использованию мягких подсчетов для вычисления новых значений параметров в обычной ЭМ по модели гауссовой смеси.

Распределения экспоненциального семейства

[ редактировать ]Обратите внимание, что в предыдущем примере, когда предполагалось, что распределение по ненаблюдаемым переменным разлагается на распределения по «параметрам» и распределения по «скрытым данным», полученное «лучшее» распределение для каждой переменной находилось в том же семействе, что и соответствующее предварительное распределение по переменной. Это общий результат, который справедлив для всех предыдущих распределений, полученных из экспоненциального семейства .

См. также

[ редактировать ]- Вариационная передача сообщений : модульный алгоритм вариационного байесовского вывода.

- Вариационный автоэнкодер : искусственная нейронная сеть, принадлежащая к семействам вероятностных графических моделей и вариационных байесовских методов.

- Алгоритм ожидания-максимизации : родственный подход, который соответствует частному случаю вариационного байесовского вывода.

- Обобщенная фильтрация : вариационная схема фильтрации для нелинейных моделей в пространстве состояний.

- Вариационное исчисление : область математического анализа, занимающаяся максимизацией или минимизацией функционалов.

- Максимальная дискриминация по энтропии : это метод вариационного вывода, который позволяет вводить и учитывать дополнительные ограничения с большой прибылью. [7]

Ссылки

[ редактировать ]- ^ Перейти обратно: а б с д Тран, Вьет Хунг (2018). «Вариационный байесовский вывод копулы с помощью информационной геометрии». arXiv : 1803.10998 [ cs.IT ].

- ^ Перейти обратно: а б Адамчик, Мартин (2014). «Информационная геометрия расхождений Брегмана и некоторые приложения в рассуждениях с участием нескольких экспертов» . Энтропия . 16 (12): 6338–6381. Бибкод : 2014Entrp..16.6338A . дои : 10.3390/e16126338 .

- ^ Перейти обратно: а б с Нгуен, Дуй (15 августа 2023 г.). «ГЛУБОКОЕ ВВЕДЕНИЕ В ВАРИАЦИОННОЕ ЗАМЕЧАНИЕ» . дои : 10.2139/ssrn.4541076 . ССНР 4541076 . Проверено 15 августа 2023 г.

- ^ Перейти обратно: а б с Ли, Се Юн (2021). «Сэмплер Гиббса и вариационный вывод по координатному восхождению: теоретико-множественный обзор». Коммуникации в статистике - теория и методы . 51 (6): 1–21. arXiv : 2008.01006 . дои : 10.1080/03610926.2021.1921214 . S2CID 220935477 .

- ^ Бойд, Стивен П.; Ванденберге, Ливен (2004). Выпуклая оптимизация (PDF) . Издательство Кембриджского университета. ISBN 978-0-521-83378-3 . Проверено 15 октября 2011 г.

- ^ Бишоп, Кристофер М. (2006). «Глава 10». Распознавание образов и машинное обучение . Спрингер. ISBN 978-0-387-31073-2 .

- ^ Сотириос П. Чацис, « Бесконечные машины дискриминации с максимальной энтропией с марковским переключением », Proc. 30-я Международная конференция по машинному обучению (ICML). Журнал исследований машинного обучения: материалы семинаров и конференций, том. 28, нет. 3, стр. 729–737, июнь 2013 г.

Внешние ссылки

[ редактировать ]- Онлайн-учебник «Теория информации, вывод и алгоритмы обучения » Дэвида Дж. Маккея представляет собой введение в вариационные методы (стр. 422).

- Учебное пособие по вариационному Байесу . Фокс К. и Робертс С. 2012. Обзор искусственного интеллекта, два : 10.1007/s10462-011-9236-8 .

- Репозиторий вариационно-байесовского репозитория. Репозиторий исследовательских работ, программного обеспечения и ссылок, связанных с использованием вариационных методов для приближенного байесовского обучения до 2003 года.

- Вариационные алгоритмы для приблизительного байесовского вывода , автор М. Дж. Бил, включает сравнение EM с вариационным байесовским EM и выводы нескольких моделей, включая вариационные байесовские HMM.

- Возможно, стоит прочитать «Общее объяснение вариационного вывода» Джейсона Эйснера перед более математически подробным рассмотрением.

- Вариационный байесовский вывод копулы с помощью информационной геометрии (pdf) , Тран, В.Х., 2018. Эта статья в первую очередь написана для студентов. С помощью дивергенции Брегмана статья показывает, что вариационный Байес — это просто обобщенная пифагорейская проекция истинной модели на произвольно коррелированное (связку) пространство распределения, из которого независимое пространство является лишь частным случаем.

- Подробное введение в вариационную байесовскую заметку . Нгуен, Д. 2023 г.

![{\displaystyle D_{\mathrm {KL} }(Q\parallel P)=\sum _{\mathbf {Z} }Q(\mathbf {Z})\left[\log {\frac {Q(\mathbf { Z} )}{P(\mathbf {Z} ,\mathbf {X} )}}+\log P(\mathbf {X} )\right]=\sum _{\mathbf {Z} }Q(\mathbf {Z})\left[\log Q(\mathbf {Z})-\log P(\mathbf {Z},\mathbf {X})\right]+\sum _{\mathbf {Z} }Q( \mathbf {Z})\left[\log P(\mathbf {X})\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/70488fe9b787af7d32d3cbaa97479e414601db46)

![{\displaystyle D_{\mathrm {KL} }(Q\parallel P)=\sum _ {\mathbf {Z} }Q(\mathbf {Z})\left[\log Q(\mathbf {Z}) - \log P(\mathbf {Z},\mathbf {X})\right]+\log P(\mathbf {X})}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fe7ea8e2d866fa0a91aaab65b66646a27ee2c1ef)

![{\displaystyle D_{\mathrm {KL} }(Q\parallel P)=\mathbb {E} _{\mathbf {Q}}\left[\log Q(\mathbf {Z})-\log P(\ mathbf {Z} ,\mathbf {X} )\right]+\log P(\mathbf {X} )}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a8cdf19ada48df35350f6069e8bdb467ea90fa3a)

![{\displaystyle \log P(\mathbf {X})=D_{\mathrm {KL} }(Q\parallel P)-\mathbb {E} _{\mathbf {Q} }\left[\log Q(\ mathbf {Z})-\log P(\mathbf {Z},\mathbf {X})\right]=D_{\mathrm {KL} }(Q\parallel P)+{\mathcal {L}}(Q )}](https://wikimedia.org/api/rest_v1/media/math/render/svg/014dc584197ed29d710ec90a734d0979fab476e5)

![{\displaystyle \operatorname {E} _{Q}[\log P(\mathbf {Z},\mathbf {X})]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a7e43c3758a771143c7934709ad3198bf43e1ca6)

![{\displaystyle q_{j}^{*}(\mathbf {Z} _{j}\mid \mathbf {X}) = {\frac {e^{\operatorname {E} _{q_{-j}^ {*}}[\ln p(\mathbf {Z} ,\mathbf {X} )]}}{\int e^{\operatorname {E} _{q_{-j}^{*}}[\ln p(\mathbf {Z},\mathbf {X})]}\,d\mathbf {Z} _{j}}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c433a20d83c8b317b21d3ebe5f6bdc820f564310)

![{\displaystyle \operatorname {E} _{q_{-j}^{*}}[\ln p(\mathbf {Z},\mathbf {X})]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8d25b04c50785b1ac3d66bd7e1610b77bc64314d)

![{\displaystyle \ln q_{j}^{*}(\mathbf {Z} _{j}\mid \mathbf {X})=\operatorname {E} _{q_{-j}^{*}}[ \ln p(\mathbf {Z},\mathbf {X})]+{\text{константа}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/87a270648b59bbf964ca39d81d20b7de87d50d25)

![{\displaystyle \log E_{P}[\exp h]={\text{sup}}_{Q\ll P}\{E_{Q}[h]-D_{\text{KL}}(Q\ параллель P)\}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6b77d97ef624d72b613687f5ba1dae28f355ea34)

![{\displaystyle {\frac {q(\theta)}{p(\theta)}} = {\frac {\exp h(\theta)}{E_{P}[\exp h]}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3aa6d2bde96aa9ae886413e7889fd4496dbe710c)

![{\displaystyle {\begin{aligned}\ln q_{\mu }^{*}(\mu)&=\operatorname {E} _{\tau }\left[\ln p(\mathbf {X} \mid \mu ,\tau )+\ln p(\mu \mid \tau )+\ln p(\tau )\right]+C\\&=\operatorname {E} _{\tau }\left[\ln p(\mathbf {X} \mid \mu ,\tau )\right]+\operatorname {E} _ {\tau }\left[\ln p(\mu \mid \tau )\right]+\operatorname { E} _{\tau }\left[\ln p(\tau )\right]+C\\&=\operatorname {E} _{\tau }\left[\ln \prod _{n=1}^ {N}{\mathcal {N}}\left(x_{n}\mid \mu ,\tau ^{-1}\right)\right]+\operatorname {E} _{\tau }\left[\ ln {\mathcal {N}}\left(\mu \mid \mu _{0},(\lambda _{0}\tau )^{-1}\right)\right]+C_{2}\\ &=\operatorname {E} _{\tau }\left[\ln \prod _{n=1}^{N}{\sqrt {\frac {\tau }{2\pi }}}e^{- {\frac {(x_{n}-\mu )^{2}\tau }{2}}}\right]+\operatorname {E} _{\tau }\left[\ln {\sqrt {\frac {\lambda _{0}\tau }{2\pi }}}e^{-{\frac {(\mu -\mu _{0})^{2}\lambda _{0}\tau } 2}}}\right]+C_{2}\\&=\operatorname {E} _{\tau }\left[\sum _{n=1}^{N}\left({\frac {1} {2}}(\ln \tau -\ln 2\pi )-{\frac {(x_{n}-\mu )^{2}\tau }{2}}\right)\right]+\operatorname {E} _{\tau }\left[{\frac {1}{2}}(\ln \lambda _{0}+\ln \tau -\ln 2\pi )-{\frac {(\mu -\mu _{0})^{2}\lambda _{0}\tau }{2}}\right]+C_{2}\\&=\operatorname {E} _{\tau }\left[ \sum _{n=1}^{N}-{\frac {(x_{n}-\mu )^{2}\tau }{2}}\right]+\operatorname {E} _{\tau }\left[-{\frac {(\mu -\mu _{0})^{2}\lambda _{0}\tau }{2}}\right]+\operatorname {E} _{\tau }\left[\sum _{n=1}^{N}{\frac {1}{2}}(\ln \tau -\ln 2\pi )\right]+\operatorname {E} _{\ tau }\left[{\frac {1}{2}}(\ln \lambda _{0}+\ln \tau -\ln 2\pi )\right]+C_{2}\\&=\operatorname {E} _{\tau }\left[\sum _{n=1}^{N}-{\frac {(x_{n}-\mu )^{2}\tau }{2}}\right ]+\operatorname {E} _{\tau }\left[-{\frac {(\mu -\mu _{0})^{2}\lambda _{0}\tau }{2}}\right ]+C_{3}\\&=-{\frac {\operatorname {E} _{\tau }[\tau ]}{2}}\left\{\sum _{n=1}^{N} (x_{n}-\mu )^{2}+\lambda _{0}(\mu -\mu _{0})^{2}\right\}+C_{3}\end{aligned}} }](https://wikimedia.org/api/rest_v1/media/math/render/svg/c64dbf7b78ed109532c4258d2f03ed35181be164)

![{\displaystyle \operatorname {E} _ {\tau }[\ln p(\tau)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ccf212e8b1c0bdaf7c00735ff771c5f117572089)

![{\displaystyle {\begin{aligned}\ln q_ {\mu }^{*}(\mu )&=- {\frac {\operatorname {E} _{\tau }[\tau ]}{2}} \left\{\sum _{n=1}^{N}(x_{n}-\mu )^{2}+\lambda _{0}(\mu -\mu _{0})^{2 }\right\}+C_{3}\\&=-{\frac {\frac {\operatorname {E} _{\tau }[\tau ]}{2}}\left\{\sum _{n =1} ^{N}(x_{n}^{2}-2x_{n}\in +\in ^{2})+\lambda _{0}(\in ^{2}-2\in _ {0} \mu +\mu _{0}^{2})\right\}+C_{3}\\&=-{\frac {\operatorname {E} _{\tau }[\tau ]} {2} }\left\{\left(\sum _{n=1}^{N}x_{n}^{2}\right)-2\left(\sum _{n=1}^{N }x_{ n}\right)\in +\left(\sum _{n=1}^{N}\in ^{2}\right)+\lambda _{0}\in ^{2}-2 \lambda _ {0}\in _{0}\in +\lambda _{0}\in _{0}^{2}\right\}+C_{3}\\&=-{\frac {\ имя_оператора {E } _{\people }[\people ]}{2}}\left\{(\lambda _{0}+N)\in ^{2}-2\left(\lambda _{0}\ в _{ 0}+\sum _{n=1}^{N}x_{n}\right)\mu +\left(\sum _{n=1}^{N}x_{n}^{2 }\right )+\lambda _{0}\mu _{0}^{2}\right\}+C_{3}\\&=-{\frac {\operatorname {E} _{\people }[ \people }{2}}\left\{(\lambda _{0}+N)\in ^{2}-2\left(\lambda _{0}\in _{0}+\sum _{n =1 }^{N}x_{n}\right)\mu \right\}+C_{4}\\&=-{\frac {\operatorname {E} _{\tau }[\tau ]}{ 2} }\left\{(\lambda _{0}+N)\mu ^{2}-2\left({\frac {\lambda _{0}\mu _{0}+\sum _{n =1 }^{N}x_{n}}{\lambda _{0}+N}}\right)(\lambda _{0}+N)\mu \right\}+C_{4}\\& =- {\frac {\operatorname {E} _{\tau }[\tau ]}{2}}\left\{(\lambda _{0}+N)\left(\mu ^{2}-2 \left ({\frac {\lambda _{0}\mu _{0}+\sum _{n=1}^{N}x_{n}}{\lambda _{0}+N}}\right )\ in \right)\right\}+C_{4}\\&=-{\frac {\frac {\operatorname {E} _{\tau }[\tau ]}{2}}\left\{ (\lambda _{ 0}+N)\left(\mu ^{2}-2\left({\frac {\lambda _{0}\mu _{0}+\sum _{n=1}^ {N}x_{ n}}{\lambda _{0}+N}}\right)\mu +\left({\frac {\lambda _{0}\mu _{0}+\sum _{n =1}^{ N}x_{n}}{\lambda _{0}+N}}\right)^{2}-\left({\frac {\lambda _{0}\mu _{0} +\sum _{ n=1}^{N}x_{n}}{\lambda _{0}+N}}\right)^{2}\right)\right\}+C_{4}\\ &=-{\ frac {\operatorname {E} _{\tau }[\tau ]}{2}}\left\{(\lambda _{0}+N)\left(\mu ^{2}- 2\left({ \frac {\lambda _{0}\mu _{0}+\sum _{n=1}^{N}x_{n}}{\lambda _{0}+N}}\ right)\mu + \left({\frac {\lambda _{0}\mu _{0}+\sum _{n=1}^{N}x_{n}}{\lambda _{0}+ N}}\right )^{2}\right)\right\}+C_{5}\\&=-{\frac {\operatorname {E} _{\tau }[\tau ]}{2}} \left\{( \lambda _{0}+N)\left(\mu -{\frac {\lambda _{0}\mu _{0}+\sum _{n=1}^{N}x_ {n}}{ \lambda _{0}+N}}\right)^{2}\right\}+C_{5}\\&=-{\frac {1}{2}}(\lambda _ {0}+N )\operatorname {E} _{\human }[\human ]\left(\mu -{\frac {\lambda _{0}\mu _{0}+\sum _{n=1 }^{N} x_{n}}{\lambda _{0}+N}}\right)^{2}+C_{5}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b95121a849ebbf25ba5413565ef4696267ba0e42)

![{\displaystyle {\begin{aligned}q_{\mu }^{*}(\mu)&\sim {\mathcal {N}}(\mu \mid \mu _{N},\lambda _{N} ^{-1})\\\in _{N}&={\frac {\lambda _{0}\in _{0}+N{\bar {x}}}{\lambda _{0}+ N}}\\\lambda _{N}&=(\lambda _{0}+N)\operatorname {E} _{\person }[\person ]\\{\bar {x}}&={\ frac {1}{N}}\sum _{n=1}^{N}x_{n}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2d299b83cbb420dff824c2914458942a0fb39859)

![{\displaystyle {\begin{aligned}\ln q_{\tau }^{*}(\tau)&=\operatorname {E} _{\mu }[\ln p(\mathbf {X} \mid \mu ,\tau )+\ln p(\mu \mid \tau )]+\ln p(\tau )+{\text{константа}}\\&=(a_{0}-1)\ln \tau - b_{0}\tau +{\frac {1}{2}}\ln \tau +{\frac {N}{2}}\ln \tau -{\frac {\tau }{2}}\operatorname {E} _{\mu }\left[\sum _{n=1}^{N}(x_{n}-\mu )^{2}+\lambda _{0}(\mu -\mu _ {0})^{2}\right]+{\text{константа}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/58986c8046658988c363da1009d0beedc83ce01c)

![{\displaystyle {\begin{aligned}q_{\tau}^{*}(\tau)&\sim \operatorname {Gamma} (\tau \mid a_{N},b_{N})\\a_{N }&=a_{0}+{\frac {N+1}{2}}\\b_{N}&=b_{0}+{\frac {1}{2}}\operatorname {E} _{ \mu }\left[\sum _{n=1}^{N}(x_{n}-\mu )^{2}+\lambda _{0}(\mu -\mu _{0})^ {2}\right]\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f6ca127beab48a5d09ca7e57f8826ed863d01727)

![{\displaystyle {\begin{aligned}\operatorname {E} [\tau \mid a_{N},b_{N}]&={\frac {a_{N}}{b_{N}}}\\\ имя оператора {E} \left[\mu \mid \mu _{N},\lambda _{N}^{-1}\right]&=\mu _{N}\\\operatorname {E}\left[ X^{2}\right]&=\operatorname{Var}(X)+(\operatorname{E}[X])^{2}\\\operatorname{E}\left[\in^{2}\ Mid \mu _{N},\lambda _{N}^{-1}\right]&=\lambda _{N}^{-1}+\mu _{N}^{2}\end{aligned }}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/917241f915e88f88f8e3ff74096507c6efe8551c)

![{\displaystyle {\begin{aligned}b_{N}&=b_{0}+{\frac {1}{2}}\operatorname {E} _{\mu }\left[\sum _{n=1 }^{N}(x_{n}-\mu )^{2}+\lambda _{0}(\mu -\mu _{0})^{2}\right]\\&=b_{0 }+{\frac {1}{2}}\operatorname {E} _{\mu }\left[(\lambda _{0}+N)\mu ^{2}-2\left(\lambda _{ 0}\mu _{0}+\sum _{n=1}^{N}x_{n}\right)\mu +\left(\sum _{n=1}^{N}x_{n} ^{2}\right)+\lambda _{0}\mu _{0}^{2}\right]\\&=b_{0}+{\frac {1}{2}}\left[( \lambda _{0}+N)\operatorname {E} _{\mu }[\mu ^{2}]-2\left(\lambda _{0}\mu _{0}+\sum _{n =1}^{N}x_{n}\right)\operatorname {E} _{\mu }[\mu ]+\left(\sum _{n=1}^{N}x_{n}^{ 2}\right)+\lambda _{0}\mu _{0}^{2}\right]\\&=b_{0}+{\frac {1}{2}}\left[(\lambda _{0}+N)\left(\lambda _{N}^{-1}+\mu _{N}^{2}\right)-2\left(\lambda _{0}\mu _{ 0}+\sum _{n=1}^{N}x_{n}\right)\mu _{N}+\left(\sum _{n=1}^{N}x_{n}^{ 2}\right)+\lambda _{0}\mu _{0}^{2}\right]\\\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/16171a58ee7ad1a9dca35de3637f8034197b22a6)

![{\displaystyle {\begin{aligned}\mu _{N}&={\frac {\lambda _{0}\mu _{0}+N{\bar {x}}}{\lambda _{0} +N}}\\\lambda _{N}&=(\lambda _{0}+N){\frac {a_{N}}{b_{N}}}\\{\bar {x}}& ={\frac {1}{N}}\sum _{n=1}^{N}x_{n}\\a_{N}&=a_{0}+{\frac {N+1}{2 }}\\b_{N}&=b_{0}+{\frac {1}{2}}\left[(\lambda _{0}+N)\left(\lambda _{N}^{- 1}+\mu _{N}^{2}\right)-2\left(\lambda _{0}\mu _{0}+\sum _{n=1}^{N}x_{n} \right)\mu _{N}+\left(\sum _{n=1}^{N}x_{n}^{2}\right)+\lambda _{0}\mu _{0}^ {2}\right]\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fe12241932dc8dfb6a202e043b02cd60b3f593a6)

![{\displaystyle \ln q_{j}^{*}(\mathbf {Z} _{j}\mid \mathbf {X})=\operatorname {E} _{i\neq j}[\ln p(\ mathbf {Z} ,\mathbf {X} )]+{\text{константа}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/931ba9fd5d59d6d74dad8cf2a82448fbca0c5ff9)

![{\displaystyle {\begin{aligned}\mathbf {\pi } &\sim \operatorname {SymDir} (K,\alpha _{0}) \\\mathbf {\Lambda } _{i=1\dots K} &\sim {\mathcal {W}}(\mathbf {W} _{0},\nu _{0})\\\mathbf {\mu } _{i=1\dots K}&\sim {\ mathcal {N}}(\mathbf {\mu } _{0},(\beta _{0}\mathbf {\Lambda } _{i})^{-1})\\\mathbf {z} [i =1\dots N]&\sim \operatorname {Mult} (1,\mathbf {\pi } )\\\mathbf {x} _{i=1\dots N}&\sim {\mathcal {N}} (\mathbf {\mu } _{z_{i}},{\mathbf {\Lambda } _{z_{i}}}^{-1})\\K&={\text{количество смешиваемых компонентов}} \\N&={\text{количество точек данных}}\end{выровнено}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6e54f90a522209bd5e80751661fbd8f25570b952)

![{\displaystyle {\begin{aligned}\ln q^{*}(\mathbf {Z}) &=\operatorname {E} _ {\mathbf {\pi } ,\mathbf {\mu } ,\mathbf {\ Лямбда } }[\ln p(\mathbf {X} ,\mathbf {Z} ,\mathbf {\pi } ,\mathbf {\mu } ,\mathbf {\Lambda } )]+{\text{константа}} \\&=\operatorname{E}_{\mathbf{\pi}}[\ln p(\mathbf{Z}\mid\mathbf{\pi})]+\operatorname{E}_{\mathbf{\ in } ,\mathbf {\Lambda } }[\ln p(\mathbf {X} \mid \mathbf {Z} ,\mathbf {\in } ,\mathbf {\Lambda } )]+{\text{константа} }\\&=\sum _{n=1}^{N}\sum _{k=1}^{K}z_{nk}\ln \rho _{nk}+{\text{константа}}\ конец {выровнено}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a9e6956e240ed7d5d347063c687111ca758eabfd)

![{\displaystyle \ln \rho _{nk}=\operaname {E} [\ln \pi _{k}]+{\frac {1}{2}}\operaname {E} [\ln |\mathbf { \Lambda } _{k}|]-{\frac {D}{2}}\ln(2\pi )-{\frac {1}{2}}\operatorname {E} _{\mathbf {\mu } _{k},\mathbf {\Lambda } _{k}}[(\mathbf {x} _{n}-\mathbf {\mu } _{k})^{\rm {T}}\mathbf {\Lambda } _{k}(\mathbf {x} _{n}-\mathbf {\mu } _{k})]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6ec0788f8a16fa7e700c96d3af8382f54cbb287f)

![{\displaystyle \operatorname {E} [z_{nk}]=r_{nk}\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c15f150fa73aec952164769cfde73f6df58590e6)

![{\displaystyle {\begin{aligned}\ln q^{*}(\mathbf {\pi})&=\ln p(\mathbf {\pi})+\operatorname {E} _{\mathbf {Z} }[\ln p(\mathbf {Z} \mid \mathbf {\pi } )]+{\text{константа}}\\&=(\alpha _{0}-1)\sum _{k=1 }^{K}\ln \pi _{k}+\sum _{n=1}^{N}\sum _{k=1}^{K}r_{nk}\ln \pi _{k} +{\text{константа}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9ce937b397d56eb7f4ee329522f5ba5379abd69f)

![{\displaystyle \ln q^{*}(\mathbf {\mu } _{k}, \mathbf {\Lambda } _{k}) = \ln p(\mathbf {\mu } _{k},\ mathbf {\Lambda }_{k})+\sum _{n=1}^{N}\operatorname {E} [z_{nk}]\ln {\mathcal {N}}(\mathbf {x}_ {n}\mid \mathbf {\mu }_{k},\mathbf {\Lambda }_{k}^{-1})+{\text{константа}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cc21b5385915806fac7030e8de06621c21ee716c)

![{\displaystyle \operatorname {E} [\ln \pi _{k}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7038f8179432a3693f8296feacc5f8874ba6f267)

![{\displaystyle \operatorname {E} [\ln |\mathbf {\Lambda } _{k}|]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c07e1eecf8caee684700b0e4b63cc117051feab1)

![{\displaystyle \operatorname {E} _{\mathbf {\mu } _{k},\mathbf {\Lambda } _{k}}[(\mathbf {x} _{n}-\mathbf {\mu } _{k})^{\rm {T}}\mathbf {\Lambda } _{k}(\mathbf {x} _{n}-\mathbf {\mu } _{k})]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/632ace27969c8d456caa65b802e8e8ce268e51bb)

![{\displaystyle {\begin{aligned}\operatorname {E} _{\mathbf {\mu } _{k},\mathbf {\Lambda } _{k}}[(\mathbf {x} _{n}- \mathbf{\mu}_{k})^{\rm{T}}\mathbf{\Lambda}_{k}(\mathbf{x}_{n}-\mathbf{\mu}_{k} )]&=D\beta_{k}^{-1}+\nu_{k}(\mathbf{x}_{n}-\mathbf{m}_{k})^{\rm{T }} \mathbf {W}_{k}(\mathbf {x}_{n}-\mathbf {m}_{k})\\\ln {\wide title {\Lambda}}_{k}&\ equiv \operatorname {E} [\ln |\mathbf {\Lambda} _{k}|]=\sum _{i=1}^{D}\psi \left({\frac {\nu _{k} + 1-i}{2}}\right)+D\ln 2+\ln |\mathbf {W} _{k}|\\\ln {\wide tide {\pi }}_{k}&\equiv \operatorname {E} \left[\ln |\pi _{k}|\right]=\psi(\alpha _{k})-\psi \left(\sum _{i=1}^{K} \alpha _{i}\right)\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ef9311bd1332799fbb4578b2547cd94b56b37acd)