Интеллектуальный агент

В интеллекте и искусственном интеллекте интеллектуальный агент ( IA ) — это агент, действующий разумным образом. Он воспринимает окружающую среду предпринимает действия , самостоятельно для достижения целей и может улучшить свою производительность за счет обучения или приобретения знаний . Интеллектуальный агент может быть простым или сложным: термостат или другая система управления примером интеллектуального агента считается , как и человек , а также любая система, отвечающая этому определению, например, фирма , государство или биом. . [1]

Ведущие учебники по искусственному интеллекту определяют «искусственный интеллект» как «исследование и проектирование интеллектуальных агентов», и это определение рассматривает целенаправленное поведение как суть интеллекта. Целенаправленные агенты также описываются с использованием термина, заимствованного из экономики , « рациональный агент ». [1]

У агента есть «целевая функция», которая инкапсулирует все цели IA. Такой агент предназначен для создания и выполнения любого плана, который после завершения максимизирует ожидаемое значение целевой функции. [2] Например, агент обучения с подкреплением имеет «функцию вознаграждения», которая позволяет программистам формировать желаемое поведение IA. [3] а поведение эволюционного алгоритма определяется «функцией приспособленности». [4]

Интеллектуальные агенты в искусственном интеллекте тесно связаны с агентами в экономике , а версии парадигмы интеллектуального агента изучаются в когнитивной науке , этике и философии практического разума , а также во многих междисциплинарных социо-когнитивных моделях и компьютерных социальных симуляциях .

Интеллектуальные агенты часто схематически описываются как абстрактная функциональная система, подобная компьютерной программе. Абстрактные описания интеллектуальных агентов называются абстрактными интеллектуальными агентами ( AIA ), чтобы отличать их от их реальных реализаций. Автономный интеллектуальный агент предназначен для функционирования без вмешательства человека. Интеллектуальные агенты также тесно связаны с программными агентами ( автономной компьютерной программой, выполняющей задачи от имени пользователей).

Как определение искусственного интеллекта

[ редактировать ]Искусственный интеллект: современный подход [5] [6] [2] определяет «агента» как

«Все, что можно рассматривать как восприятие окружающей среды посредством датчиков и воздействие на эту среду посредством исполнительных механизмов»

Он определяет «рационального агента» как:

«Агент, который действует так, чтобы максимизировать ожидаемое значение показателя эффективности на основе прошлого опыта и знаний».

Он также определяет область «исследований искусственного интеллекта» как:

«Изучение и проектирование рациональных агентов»

Падгам и Виникофф (2005) согласны с тем, что интеллектуальный агент находится в окружающей среде и своевременно (хотя и не обязательно в режиме реального времени) реагирует на изменения в окружающей среде. Однако интеллектуальные агенты также должны активно и гибко добиваться поставленных целей . [а] Необязательные требования включают в себя то, чтобы агент был рациональным и чтобы он был способен анализировать убеждения-желания-намерения . [7]

Каплан и Хэнлайн определяют искусственный интеллект как «способность системы правильно интерпретировать внешние данные, учиться на таких данных и использовать эти знания для достижения конкретных целей и задач посредством гибкой адаптации». [8] Это определение тесно связано с определением интеллектуального агента.

Преимущества

[ редактировать ]Возможно, этот раздел содержит оригинальные исследования . ( февраль 2023 г. ) |

С философской точки зрения это определение искусственного интеллекта избегает нескольких направлений критики. В отличие от теста Тьюринга , он никак не относится к человеческому интеллекту. Таким образом, нет необходимости обсуждать, является ли это «реальным» или «имитированным» интеллектом (т. е. «синтетическим» или «искусственным» интеллектом), и это не указывает на то, что такая машина обладает разумом , сознанием или истинным пониманием (т. е. это не подразумевает « сильную гипотезу ИИ » Джона Сирла). Он также не пытается провести резкую разделительную линию между «разумным» и «неразумным» поведением — программы необходимо оценивать только с точки зрения их целевой функции.

Что еще более важно, он имеет ряд практических преимуществ, которые помогли продвинуть вперед исследования в области ИИ. Он обеспечивает надежный и научный способ тестирования программ; исследователи могут напрямую сравнивать или даже комбинировать различные подходы к изолированным проблемам, задавая вопрос, какой агент лучше всего максимизирует данную «целевую функцию». Это также дает им общий язык для общения с другими областями, такими как математическая оптимизация (которая определяется в терминах «целей») или экономика (которая использует то же определение « рационального агента »). [9]

Целевая функция

[ редактировать ]Агент, которому назначена явная «целевая функция», считается более умным, если он последовательно предпринимает действия, которые успешно максимизируют его запрограммированную целевую функцию. Цель может быть простой («1, если ИА выигрывает игру в Го , 0 в противном случае») или сложной («Выполнять действия, математически аналогичные тем, которые были успешны в прошлом»). «Целевая функция» инкапсулирует все цели, ради достижения которых агент вынужден действовать; в случае рациональных агентов функция также включает в себя приемлемые компромиссы между достижением противоречивых целей. (Терминология различается; например, некоторые агенты стремятся максимизировать или минимизировать « функцию полезности », «целевую функцию» или « функцию потерь ».) [6] [2]

Цели могут быть явно определены или стимулированы. Если ИИ запрограммирован на « обучение с подкреплением », у него есть « функция вознаграждения », которая поощряет одни типы поведения и наказывает другие. Альтернативно, эволюционная система может ставить перед собой цели, используя « функцию приспособленности », чтобы мутировать и преимущественно воспроизводить системы искусственного интеллекта с высокими показателями, подобно тому, как животные эволюционировали, чтобы врожденно желать определенных целей, таких как поиск еды. [10] Некоторым системам ИИ, таким как метод ближайшего соседа, вместо разума по аналогии, этим системам обычно не ставятся цели, за исключением той степени, в которой цели неявно подразумеваются в их обучающих данных. [11] Такие системы все еще можно оценить, если бесцелевую систему представить как систему, «цель» которой состоит в выполнении своей узкой классификационной задачи. [12]

Системы, которые традиционно не считаются агентами, такие как системы представления знаний, иногда включаются в парадигму, представляя их как агентов, цель которых (например) отвечать на вопросы как можно точнее; понятие «действия» здесь расширено и включает в себя «акт» дачи ответа на вопрос. В качестве дополнительного расширения системы, управляемые мимикрией, можно представить как агентов, которые оптимизируют «целевую функцию» в зависимости от того, насколько точно IA удается имитировать желаемое поведение. [6] [2] В генеративно-состязательных сетях 2010-х годов компонент «кодер»/«генератор» пытается имитировать и импровизировать композицию человеческого текста. Генератор пытается максимизировать функцию, инкапсулирующую, насколько хорошо она может обмануть антагонистический компонент «предиктор»/«дискриминатор». [13]

Хотя символические системы ИИ часто принимают явную целевую функцию, эта парадигма также может быть применена к нейронным сетям и эволюционным вычислениям . Обучение с подкреплением может создавать интеллектуальных агентов, которые действуют таким образом, чтобы максимизировать «функцию вознаграждения». [14] Иногда вместо того, чтобы устанавливать функцию вознаграждения, прямо равную желаемой функции эталонной оценки, программисты машинного обучения используют формирование вознаграждения, чтобы изначально давать машине вознаграждение за постепенный прогресс в обучении. [15] Ян ЛеКун заявил в 2018 году: «Большинство алгоритмов обучения, которые придумали люди, по сути, состоят из минимизации некоторой целевой функции». [16] Шахматы AlphaZero имели простую целевую функцию; каждая победа засчитывается как +1 очко, а каждое поражение - как -1 очко. Целевая функция для беспилотного автомобиля должна быть более сложной. [17] Эволюционные вычисления могут развить интеллектуальных агентов, которые, по-видимому, будут действовать таким образом, чтобы максимизировать «функцию приспособленности», влияющую на то, сколько потомков может оставить каждый агент. [4]

Теоретическая и невычислимая конструкция AIXI является максимально интеллектуальным агентом в этой парадигме; [18] однако в реальном мире IA ограничено ограниченным временем и аппаратными ресурсами, и ученые конкурируют за создание алгоритмов, которые могут достигать все более высоких результатов в тестах производительности с реальным оборудованием. [19] [ соответствующий? ]

Классы интеллектуальных агентов

[ редактировать ]Классификация Рассела и Норвига

[ редактировать ]Рассел и Норвиг (2003) группируют агентов на пять классов в зависимости от степени их предполагаемого интеллекта и способностей: [20]

Простые рефлекторные агенты

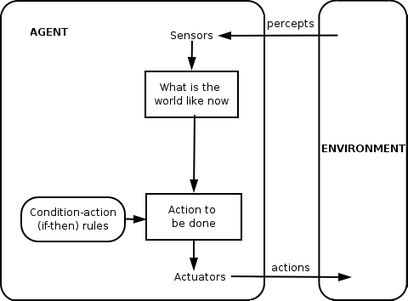

[ редактировать ]

Простые рефлекторные агенты действуют только на основе текущего восприятия , игнорируя остальную часть истории восприятия. Функция агента основана на правиле «условие-действие» : «если условие, то действие».

Эта функция агента успешна только тогда, когда среда полностью наблюдаема. Некоторые рефлекторные агенты также могут содержать информацию о своем текущем состоянии, что позволяет им игнорировать условия, активаторы которых уже сработали.

Бесконечные петли часто неизбежны для простых рефлекторных агентов, действующих в частично наблюдаемой среде. Если агент может рандомизировать свои действия, возможно, удастся избежать бесконечных циклов.

Рефлекторные агенты на основе моделей

[ редактировать ]

Агент на основе модели может работать с частично наблюдаемыми средами. Его текущее состояние хранится внутри агента, поддерживая некую структуру, описывающую ту часть мира, которую нельзя увидеть. Это знание о том, «как устроен мир», называется моделью мира, отсюда и название «агент, основанный на модели».

Рефлекторный агент, основанный на модели, должен поддерживать некую внутреннюю модель , которая зависит от истории восприятия и тем самым отражает, по крайней мере, некоторые из ненаблюдаемых аспектов текущего состояния. Историю восприятия и влияние действия на окружающую среду можно определить с помощью внутренней модели. Затем он выбирает действие так же, как и рефлекторный агент.

Агент также может использовать модели для описания и прогнозирования поведения других агентов в среде. [21]

Агенты, основанные на целях

[ редактировать ]

Агенты на основе целей дополнительно расширяют возможности агентов на основе модели за счет использования информации о «целях». Информация о целях описывает ситуации, которые желательны. Это дает агенту возможность выбирать среди множества возможностей, выбирая ту, которая достигает целевого состояния. Поиск и планирование — это разделы искусственного интеллекта, посвященные поиску последовательностей действий, которые достигают целей агента.

Агенты на основе утилит

[ редактировать ]

Агенты, основанные на целях, различают только целевые и нецелевые состояния. Также возможно определить меру того, насколько желательно то или иное состояние. Эту меру можно получить с помощью функции полезности , которая отображает состояние в меру полезности состояния. Более общий показатель эффективности должен позволять сравнивать различные состояния мира в зависимости от того, насколько хорошо они удовлетворяют целям агента. Термин «полезность» можно использовать для описания того, насколько «счастлив» агент.

Рациональный агент, основанный на полезности, выбирает действие, которое максимизирует ожидаемую полезность результатов действия, то есть то, что агент ожидает получить в среднем с учетом вероятностей и полезностей каждого результата. Агенту, основанному на утилитах, приходится моделировать и отслеживать свое окружение — задачи, которые потребовали большого количества исследований в области восприятия, представления, рассуждения и обучения.

Обучающиеся агенты

[ редактировать ]

Преимущество обучения заключается в том, что оно позволяет агентам изначально действовать в неизвестных средах и становиться более компетентными, чем могли бы позволить только их первоначальные знания. Наиболее важное различие проводится между «элементом обучения», ответственным за улучшение, и «элементом производительности», ответственным за выбор внешних действий.

Элемент обучения использует обратную связь от «критика» о том, как работает агент, и определяет, как следует изменить элемент производительности или «актера», чтобы добиться большего успеха в будущем. Элемент производительности, ранее считавшийся всем агентом, воспринимает восприятие и принимает решения о действиях.

Последний компонент обучающего агента — это «генератор задач». Он отвечает за предложение действий, которые приведут к новому и информативному опыту.

Классификация Вейсса

[ редактировать ]Вайс (2013) определяет четыре класса агентов:

- Агенты на основе логики – в которых решение о том, какое действие выполнить, принимается посредством логического вывода.

- Реактивные агенты – в которых принятие решений реализуется в той или иной форме прямого сопоставления ситуации с действием.

- Агенты убеждения-желания-намерения - в которых принятие решений зависит от манипулирования структурами данных, представляющими убеждения, желания и намерения агента; и, наконец,

- Многоуровневые архитектуры – в которых принятие решений реализуется с помощью различных уровней программного обеспечения, каждый из которых более или менее явно анализирует окружающую среду на разных уровнях абстракции.

Другой

[ редактировать ]В 2013 году Александр Висснер-Гросс опубликовал теорию свободы и интеллекта интеллектуальных агентов. [22] [23]

Иерархия агентов

[ редактировать ]Для активного выполнения своих функций интеллектуальные агенты сегодня обычно объединяются в иерархическую структуру, содержащую множество «субагентов». Интеллектуальные субагенты обрабатывают и выполняют функции более низкого уровня. Взятые вместе, интеллектуальный агент и субагенты создают целостную систему, которая может выполнять сложные задачи или цели с помощью поведения и реакций, отображающих форму интеллекта.

Как правило, агент может быть создан путем разделения тела на датчики и исполнительные механизмы и таким образом, чтобы он работал со сложной системой восприятия, которая принимает описание мира в качестве входных данных для контроллера и выводит команды на исполнительный механизм. Однако иерархия уровней контроллера часто необходима, чтобы сбалансировать немедленную реакцию, необходимую для задач низкого уровня, и медленное рассуждение о сложных целях высокого уровня. [24]

Функция агента

[ редактировать ]Простую программу агента можно математически определить как функцию f (называемую «функцией агента»). [25] который сопоставляет каждую возможную последовательность восприятий с возможным действием, которое агент может выполнить, или с коэффициентом, элементом обратной связи, функцией или константой, которая влияет на возможные действия:

Функция агента — это абстрактное понятие, поскольку оно может включать в себя различные принципы принятия решений, такие как расчет полезности отдельных вариантов, дедукция по логическим правилам, нечеткая логика и т. д. [26]

Вместо этого программный агент отображает каждое возможное восприятие на действие. [27]

Мы используем термин «перцепт» для обозначения входных данных восприятия агента в любой данный момент. На следующих рисунках агент — это все, что можно рассматривать как воспринимающее окружающую среду через датчики и воздействующее на эту среду через исполнительные механизмы.

Приложения

[ редактировать ]В этом разделе может быть придан чрезмерный вес определенным идеям, происшествиям или противоречиям . Пожалуйста, помогите создать более сбалансированную презентацию . Обсудите и решите эту проблему, прежде чем удалять это сообщение. ( сентябрь 2023 г. ) |

Халлербах и др. обсудили применение агентных подходов для разработки и проверки автоматизированных систем вождения с помощью цифрового двойника тестируемого транспортного средства и микроскопического моделирования дорожного движения на основе независимых агентов. [28] Waymo создала мультиагентную среду моделирования Carcraft для тестирования алгоритмов беспилотных автомобилей . [29] [30] Он моделирует взаимодействие водителей-людей, пешеходов и автоматизированных транспортных средств. Поведение людей имитируется искусственными агентами на основе данных о реальном поведении человека. Основная идея использования агентного моделирования для понимания беспилотных автомобилей обсуждалась еще в 2003 году. [31]

Альтернативные определения и использование

[ редактировать ]«Интеллектуальный агент» также часто используется как расплывчатый маркетинговый термин, иногда синоним « виртуального личного помощника ». [32] Некоторые определения 20-го века характеризуют агент как программу, которая помогает пользователю или действует от имени пользователя. [33] Эти примеры известны как программные агенты , а иногда «интеллектуальный программный агент» (то есть программный агент с интеллектом) называют «интеллектуальным агентом».

По мнению Николы Касабова , системы IA должны обладать следующими характеристиками: [34]

- внедряйте новые правила решения проблем. Постепенно

- Адаптируйтесь онлайн и в реальном времени

- Умеют анализировать себя с точки зрения поведения, ошибок и успехов.

- Учитесь и совершенствуйтесь через взаимодействие с окружающей средой ( воплощение )

- Быстро обучайтесь на больших объемах данных

- образцов в памяти. Иметь возможности хранения и извлечения

- Иметь параметры для представления кратковременной и долговременной памяти, возраста, забывания и т. д.

См. также

[ редактировать ]- Окружающий интеллект

- Интеграция систем искусственного интеллекта

- Автономный агент

- Когнитивные архитектуры

- Когнитивное радио – практическое поле для реализации

- Кибернетика

- Мечтатель

- Воплощенный агент

- Федеративный поиск – возможность агентов осуществлять поиск в разнородных источниках данных, используя единый словарь.

- Дружественный искусственный интеллект

- Нечеткие агенты – IA, реализованный с помощью адаптивной нечеткой логики.

- Язык программирования агента GOAL

- Гибридная интеллектуальная система

- Интеллектуальное управление

- Интеллектуальная система

- ДЖЕК Интеллектуальные агенты

- Многоагентная система и многоагентная система – несколько интерактивных агентов

- Обучение с подкреплением

- Семантическая сеть – предоставление данных в Интернете для автоматической обработки агентами.

- Социальная симуляция

- Программный агент

- Программный бот

Примечания

[ редактировать ]- ^ Определение Пэдгама и Виникоффа явно охватывает только социальных агентов, которые взаимодействуют с другими агентами.

Встроенные ссылки

[ редактировать ]- ^ Jump up to: а б Рассел и Норвиг 2003 , гл. 2.

- ^ Jump up to: а б с д Брингсйорд, Зельмер; Говиндараджулу, Навин Сундар (12 июля 2018 г.). "Искусственный интеллект" . В Эдварде Н. Залте (ред.). Стэнфордская энциклопедия философии (выпуск лета 2020 г.) .

- ^ Волчовер, Натали (30 января 2020 г.). «Искусственный интеллект сделает то, что мы просим. Это проблема» . Журнал Кванта . Проверено 21 июня 2020 г.

- ^ Jump up to: а б Булл, Ларри (1999). «Об эволюционных вычислениях на основе моделей». Мягкие вычисления . 3 (2): 76–82. дои : 10.1007/s005000050055 . S2CID 9699920 .

- ^ Рассел и Норвиг 2003 , стр. 4–5, 32, 35, 36 и 56.

- ^ Jump up to: а б с Рассел и Норвиг (2003)

- ^ Лин Пэдхэм и Майкл Виникофф. Разработка интеллектуальных агентных систем: Практическое руководство. Том. 13. Джон Уайли и сыновья, 2005.

- ^ Каплан, Андреас; Хэнляйн, Майкл (1 января 2019 г.). «Сири, Сири, в моей руке: кто самый справедливый на земле? Об интерпретациях, иллюстрациях и значении искусственного интеллекта». Горизонты бизнеса . 62 (1): 15–25. дои : 10.1016/j.bushor.2018.08.004 . S2CID 158433736 .

- ^ Рассел и Норвиг 2003 , с. 27.

- ^ Домингос 2015 , Глава 5.

- ^ Домингос 2015 , Глава 7.

- ^ Линденбаум М., Маркович С. и Русаков Д. (2004). Выборочная выборка для классификаторов ближайших соседей. Машинное обучение, 54(2), 125–152.

- ^ «Генераторно-состязательные сети: что такое GAN и как они развивались» . ВенчурБит . 26 декабря 2019 года . Проверено 18 июня 2020 г.

- ^ Уолчовер, Натали (январь 2020 г.). «Искусственный интеллект сделает то, что мы просим. Это проблема» . Журнал Кванта . Проверено 18 июня 2020 г.

- ^ Эндрю Ю. Нг, Дайши Харада и Стюарт Рассел. «Инвариантность политики при трансформации вознаграждения: теория и применение к формированию вознаграждения». В ICML, вып. 99, стр. 278-287. 1999.

- ^ Мартин Форд . Архитекторы интеллекта: правда об искусственном интеллекте от людей, его создающих. ООО «Пакт Паблишинг», 2018.

- ^ «Почему у искусственного интеллекта AlphaZero проблемы с реальным миром» . Журнал Кванта . 2018 . Проверено 18 июня 2020 г.

- ^ Адамс, Сэм; Арель, Итмар; Бах, Йоша; Куп, Роберт; Фурлан, Род; Герцель, Бен; Холл, Дж. Сторрс; Самсонович, Алексей; Шойц, Матиас; Шлезингер, Мэтью; Шапиро, Стюарт К.; Сова, Джон (15 марта 2012 г.). «Составление карты общего искусственного интеллекта человеческого уровня» . Журнал ИИ . 33 (1): 25. дои : 10.1609/aimag.v33i1.2322 .

- ^ Хатсон, Мэтью (27 мая 2020 г.). «Привлекательные достижения в некоторых областях искусственного интеллекта нереальны» . Наука | АААС . Проверено 18 июня 2020 г.

- ^ Рассел и Норвиг 2003 , стр. 46–54.

- ^ Стефано Альбрехт и Питер Стоун (2018). Автономные агенты, моделирующие других агентов: всесторонний обзор и открытые проблемы. Искусственный интеллект, Том. 258, стр. 66-95. https://doi.org/10.1016/j.artint.2018.01.002

- ^ Коробка, фанаты из (04.12.2019). «Универсальная формула интеллекта» . Гики из коробки . Проверено 11 октября 2022 г.

- ^ Висснер-Гросс, AD; Фрир, CE (19 апреля 2013 г.). «Причинные энтропийные силы» . Письма о физических отзывах . 110 (16): 168702. Бибкод : 2013PhRvL.110p8702W . doi : 10.1103/PhysRevLett.110.168702 . hdl : 1721.1/79750 . ПМИД 23679649 .

- ^ Пул, Дэвид; Макворт, Алан. «1.3 Агенты, расположенные в окружающей среде ‣ Глава 2. Архитектура агентов и иерархическое управление ‣ Искусственный интеллект: основы вычислительных агентов, 2-е издание» . artint.info . Проверено 28 ноября 2018 г.

- ^ Рассел и Норвиг 2003 , с. 33

- ^ Саламон, Томас (2011). Проектирование агентно-ориентированных моделей . Репин: Издательство Брукнер. стр. 42–59. ISBN 978-80-904661-1-1 .

- ^ Нильссон, Нильс Дж. (апрель 1996 г.). «Искусственный интеллект: современный подход» . Искусственный интеллект . 82 (1–2): 369–380. дои : 10.1016/0004-3702(96)00007-0 . ISSN 0004-3702 .

- ^ Халлербах, С.; Ся, Ю.; Эберле, У.; Кестер, Ф. (2018). «Идентификация критических сценариев на основе моделирования для кооперативных и автоматизированных транспортных средств» . Международный журнал SAE о подключенных и автоматизированных транспортных средствах . 1 (2). SAE International: 93. doi : 10.4271/2018-01-1066 .

- ^ Мадригал, рассказ Алексиса К. «В секретном мире Waymo для обучения беспилотным автомобилям» . Атлантика . Проверено 14 августа 2020 г.

- ^ Коннорс, Дж.; Грэм, С.; Майу, Л. (2018). «Кибер-синтетическое моделирование для транспортных средств». На Международной конференции по кибервойне и безопасности . Academic Conferences International Limited: 594-XI.

- ^ Ян, Гоцин; Ву, Чжаохуэй; Ли, Сюмэй; Чен, Вэй (2003). «SVE: встроенная среда интеллектуального автомобиля на основе агентов» . Материалы Международной конференции IEEE 2003 года по интеллектуальным транспортным системам . Том. 2. стр. 1745–1749. дои : 10.1109/ITSC.2003.1252782 . ISBN 0-7803-8125-4 . S2CID 110177067 .

- ^ Фингар, Питер (2018). «Конкуренция за будущее с интеллектуальными агентами... и признание» . Сайты Форбс . Проверено 18 июня 2020 г.

- ^ Бургин, Марк и Гордана Додиг-Црнкович. «Системный подход к искусственным агентам». Препринт arXiv arXiv:0902.3513 (2009).

- ^ Касабов 1998 .

Другие ссылки

[ редактировать ]- Домингос, Педро (22 сентября 2015 г.). Главный алгоритм: как поиски совершенной обучающейся машины изменят наш мир . Основные книги . ISBN 978-0465065707 .

- Рассел, Стюарт Дж .; Норвиг, Питер (2003). Искусственный интеллект: современный подход (2-е изд.). Река Аппер-Сэддл, Нью-Джерси: Прентис-Холл. Глава 2. ISBN 0-13-790395-2 .

- Касабов, Н. (1998). «Введение: Гибридные интеллектуальные адаптивные системы» . Международный журнал интеллектуальных систем . 13 (6): 453–454. doi : 10.1002/(SICI)1098-111X(199806)13:6<453::AID-INT1>3.0.CO;2-K . S2CID 120318478 .

- Вайс, Г. (2013). Мультиагентные системы (2-е изд.). Кембридж, Массачусетс: MIT Press. ISBN 978-0-262-01889-0 .