Искусственный нейрон

Искусственный нейрон — это математическая функция , задуманная как модель биологических нейронов в нейронной сети . Искусственные нейроны — это элементарные единицы искусственных нейронных сетей . [1] Искусственный нейрон — это функция, которая получает один или несколько входных данных, присваивает этим входным весам веса и суммирует их для получения выходных данных.

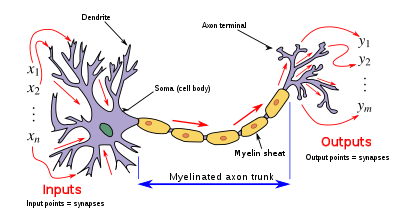

Дизайн искусственного нейрона был вдохновлен нейронной схемой . Его входы аналогичны возбуждающим постсинаптическим потенциалам и тормозным постсинаптическим потенциалам нервных дендритов , или активации , его вес аналогичен синаптическому весу нейрона , а его выходной сигнал аналогичен потенциалу действия , который передается по его аксону .

Обычно каждый вход взвешивается отдельно , и сумма часто добавляется к члену, известному как смещение (в общих чертах соответствующее пороговому потенциалу ), прежде чем пройти через нелинейную функцию, известную как функция активации или передаточная функция. [ нужны разъяснения ] . Передаточные функции обычно имеют сигмовидную форму , но могут также принимать форму других нелинейных функций, кусочно -линейных функций или ступенчатых функций . Они также часто монотонно возрастают , непрерывны , дифференцируемы и ограничены . Недавно также были исследованы немонотонные, неограниченные и осциллирующие функции активации с несколькими нулями, которые превосходят сигмоидальные и ReLU-подобные функции активации во многих задачах. Функция определения порога вдохновила на создание логических элементов, называемых пороговой логикой; применимо для построения логических схем, напоминающих обработку мозга. Например, новые устройства, такие как мемристоры . в последнее время для разработки такой логики широко используются [2]

линейной системы Передаточную функцию искусственного нейрона не следует путать с передаточной функцией .

Искусственный нейрон может называться полулинейной единицей , Nv-нейроном , бинарным нейроном , линейной пороговой функцией или МакКаллоха-Питтса ( MCP ) нейроном , в зависимости от используемой структуры.

Простые искусственные нейроны, такие как модель Маккаллоха-Питтса, иногда называют «карикатурными моделями», поскольку они предназначены для отражения одного или нескольких нейрофизиологических наблюдений, но без учета реализма. [3] Искусственные нейроны также могут относиться к искусственным клеткам в нейроморфной инженерии ( ), которые похожи на естественные физические нейроны.

Базовая структура

[ редактировать ]Для данного искусственного нейрона k пусть имеется m + 1 вход с сигналами от x 0 до x m и весами от w k 0 до w k m . Обычно входу x 0 присваивается значение +1, что делает его входом смещения с w k 0 = b k . Это оставляет только m фактических входов для нейрона: от x 1 до x m .

Выходной сигнал k -го нейрона:

Где (phi) — передаточная функция (обычно пороговая функция).

Выходной сигнал аналогичен аксону биологического нейрона, и его значение распространяется на вход следующего слоя через синапс. Он также может выйти из системы, возможно, как часть выходного вектора .

У него нет процесса обучения как такового. Рассчитываются веса его передаточной функции и заранее определяется пороговое значение.

Нейрон Маккаллоха – Питтса (MCP)

[ редактировать ]Нейрон MCP — это своего рода ограниченный искусственный нейрон, который работает с дискретными временными шагами. Каждый из них имеет ноль или более входов и записывается как . Он имеет один выход, записанный как . Каждый вход может быть либо возбуждающим , либо тормозящим . Выход может быть либо тихим , либо стреляющим . Нейрон MCP также имеет порог .

В нейронной сети MCP все нейроны работают синхронно с дискретными временными шагами. . Во время , выход нейрона если количество возбуждающих входов по меньшей мере равно порогу и ни один тормозной вход не активируется; в противном случае.

Каждый выход может быть входом для произвольного числа нейронов, включая самого себя (то есть возможны циклы). Однако выход не может соединяться с одним нейроном более одного раза. Самоциклы не вызывают противоречий, поскольку сеть работает синхронно с дискретными временными шагами.

В качестве простого примера рассмотрим один нейрон с порогом 0 и одну тормозную петлю. Его выходной сигнал будет колебаться между 0 и 1 на каждом шаге, действуя как «часы».

Любой конечный автомат может быть смоделирован нейронной сетью MCP. [4] Нейронные сети MCP, оснащенные бесконечной лентой, могут моделировать любую машину Тьюринга . [5]

Биологические модели

[ редактировать ]

Искусственные нейроны созданы для имитации особенностей своих биологических аналогов. Однако между биологическими и искусственными нейронными сетями существует значительный разрыв в производительности. одиночные биологические нейроны в человеческом мозге с осциллирующей функцией активации, способные обучаться функции XOR . В частности, были обнаружены [6]

- Дендриты . В биологическом нейроне дендриты действуют как входной вектор. Эти дендриты позволяют клетке получать сигналы от большого (>1000) числа соседних нейронов. Как и в приведенной выше математической обработке, каждый дендрит способен выполнять «умножение» на «весовое значение» этого дендрита. Умножение осуществляется за счет увеличения или уменьшения соотношения синаптических нейротрансмиттеров и сигнальных химических веществ, вводимых в дендрит в ответ на синаптический нейромедиатор. Отрицательный эффект мультипликации может быть достигнут за счет передачи ингибиторов сигнала (т.е. противоположно заряженных ионов) по дендриту в ответ на прием синаптических нейротрансмиттеров.

- Сома . В биологическом нейроне сома действует как функция суммирования, как видно из приведенного выше математического описания. Когда положительные и отрицательные сигналы (возбуждающие и тормозящие соответственно) поступают в сому от дендритов, положительные и отрицательные ионы эффективно суммируются просто потому, что смешиваются вместе в растворе внутри тела клетки.

- Аксон . Аксон получает сигнал от процесса суммирования, который происходит внутри сомы. Отверстие аксона, по сути, измеряет электрический потенциал раствора внутри сомы. Как только сома достигает определенного потенциала, аксон передает сигнальный импульс по всей своей длине. В этом отношении аксон выступает для нас как возможность соединять наш искусственный нейрон с другими искусственными нейронами.

Однако, в отличие от большинства искусственных нейронов, биологические нейроны активируются дискретными импульсами. Каждый раз, когда электрический потенциал внутри сомы достигает определенного порога, по аксону передается импульс. Эту пульсацию можно перевести в непрерывные значения. Скорость (активаций в секунду и т. д.), с которой срабатывает аксон, напрямую преобразуется в скорость, с которой соседние клетки получают в себя сигнальные ионы. Чем быстрее срабатывает биологический нейрон, тем быстрее близлежащие нейроны накапливают электрический потенциал (или теряют электрический потенциал, в зависимости от «веса» дендрита, который соединяется с сработавшим нейроном). Именно это преобразование позволяет ученым-компьютерщикам и математикам моделировать биологические нейронные сети с использованием искусственных нейронов, которые могут выдавать разные значения (часто от -1 до 1).

Кодирование

[ редактировать ]Исследования показали, что унарное кодирование используется в нейронных цепях, ответственных за воспроизведение пения птиц, . [7] [8] Использование унарного кода в биологических сетях, по-видимому, связано с простотой кодирования. Еще одним фактором, способствующим этому, может быть то, что унарное кодирование обеспечивает определенную степень исправления ошибок. [9]

Физические искусственные клетки

[ редактировать ]Ведутся исследования и разработки в области физических искусственных нейронов – органических и неорганических.

Например, некоторые искусственные нейроны могут получать [10] [11] и высвобождают дофамин ( химические сигналы, а не электрические сигналы) и взаимодействуют с естественными клетками мышц и мозга крысы , что потенциально может быть использовано в BCI / протезировании . [12] [13]

малой мощности Биосовместимые мемристоры могут позволить создавать искусственные нейроны, которые функционируют при напряжениях биологических потенциалов действия и могут использоваться для непосредственной обработки биосенсорных сигналов , для нейроморфных вычислений и/или прямой связи с биологическими нейронами . [14] [15] [16]

Органические нейроморфные схемы, изготовленные из полимеров и покрытые гелем, богатым ионами, позволяющим материалу переносить электрический заряд, как настоящие нейроны , были встроены в робота, что позволяет ему обучаться сенсомоторно в реальном мире, а не посредством моделирования или практически. [17] [18] Более того, искусственные шиповые нейроны, изготовленные из мягкого вещества (полимеров), могут работать в биологически значимых средах и обеспечивать синергетическую связь между искусственными и биологическими доменами. [19] [20]

История

[ редактировать ]Первым искусственным нейроном был Threshold Logic Unit (TLU), или Linear Threshold Unit. [21] впервые предложена Уорреном Маккалоком и Уолтером Питтсом в 1943 году. Модель была специально разработана как вычислительная модель «нервной сети» в мозге. [22] В качестве передаточной функции использовался порог, эквивалентный использованию ступенчатой функции Хевисайда . Первоначально рассматривалась только простая модель с двоичными входами и выходами, некоторыми ограничениями на возможные веса и более гибким пороговым значением. С самого начала уже было замечено, что любая логическая функция может быть реализована сетями таких устройств, что легко увидеть из того факта, что можно реализовать функции И и ИЛИ и использовать их в дизъюнктивной или конъюнктивной нормальной форме . Исследователи также вскоре поняли, что циклические сети с обратной связью через нейроны могут определять динамические системы с памятью, но большая часть исследований сосредоточилась (и до сих пор делает) на сетях строго прямой связи из- за меньших трудностей, которые они представляют.

Одной из важных и новаторских искусственных нейронных сетей, использовавших линейную пороговую функцию, был персептрон , разработанный Фрэнком Розенблаттом . Эта модель уже учитывала более гибкие значения веса в нейронах и использовалась в машинах с адаптивными возможностями. Представление пороговых значений как фактора смещения было введено Бернардом Уидроу в 1960 году – см. ADALINE .

В конце 1980-х годов, когда исследования нейронных сетей вновь набрали силу, стали рассматриваться нейроны более непрерывной формы. Возможность дифференцирования функции активации позволяет напрямую использовать градиентный спуск и другие алгоритмы оптимизации для корректировки весов. Нейронные сети также начали использоваться в качестве общей модели аппроксимации функций . Самый известный алгоритм обучения, называемый обратным распространением ошибки, был открыт несколько раз, но его первая разработка восходит к работе Пола Вербоса . [23] [24]

Виды передаточных функций

[ редактировать ]Передаточная функция ( функция активации ) нейрона выбирается так, чтобы она имела ряд свойств, которые либо улучшают, либо упрощают сеть, содержащую нейрон. Крайне важно, например, что любой многослойный персептрон, использующий линейную передаточную функцию, имеет эквивалентную однослойную сеть; поэтому для получения преимуществ многоуровневой сети необходима нелинейная функция. [ нужна ссылка ]

Ниже во всех случаях u относится к взвешенной сумме всех входных данных нейрона, т. е. для n входных данных

где w — вектор синаптических весов , а x — вектор входов.

Ступенчатая функция

[ редактировать ]Выход y этой передаточной функции является двоичным, в зависимости от того, соответствует ли вход заданному порогу θ . Посылается «сигнал», т.е. выход устанавливается на единицу, если активация соответствует пороговому значению.

Эта функция используется в персептронах и часто встречается во многих других моделях. Он выполняет деление пространства входов гиперплоскостью . Это особенно полезно на последнем уровне сети, предназначенном для двоичной классификации входных данных. Его можно аппроксимировать на основе других сигмоидальных функций, присвоив весам большие значения.

Линейная комбинация

[ редактировать ]В этом случае выходная единица представляет собой просто взвешенную сумму ее входов плюс член смещения . Несколько таких линейных нейронов выполняют линейное преобразование входного вектора. Обычно это более полезно на первых уровнях сети. Существует ряд инструментов анализа, основанных на линейных моделях, таких как гармонический анализ , и все они могут использоваться в нейронных сетях с этим линейным нейроном. Термин смещения позволяет нам выполнять аффинные преобразования данных.

См.: Линейное преобразование , Гармонический анализ , Линейный фильтр , Вейвлет , Анализ главных компонент , Анализ независимых компонентов , Деконволюция .

сигмовидная

[ редактировать ]Довольно простая нелинейная функция, сигмовидная функция, такая как логистическая функция, также имеет легко вычисляемую производную, которая может быть важна при расчете обновлений веса в сети. Таким образом, это делает сеть более легко манипулируемой математически и было привлекательно для первых ученых-компьютерщиков, которым нужно было минимизировать вычислительную нагрузку при моделировании. Ранее это часто наблюдалось в многослойных перцептронах . Однако недавняя работа показала, что сигмовидные нейроны менее эффективны, чем выпрямленные линейные нейроны. Причина в том, что градиенты, рассчитанные алгоритмом обратного распространения ошибки , имеют тенденцию уменьшаться к нулю по мере распространения активации через слои сигмоидальных нейронов, что затрудняет оптимизацию нейронных сетей, использующих несколько слоев сигмоидальных нейронов.

выпрямитель

[ редактировать ]В контексте искусственных нейронных сетей выпрямитель — или ReLU (выпрямленная линейная единица) это функция активации, определяемая как положительная часть ее аргумента:

где x — входной сигнал нейрона. Это также известно как функция линейного изменения и аналогично полуволновому выпрямлению в электротехнике. Эта функция активации была впервые введена в динамическую сеть Ханлозером и др. в статье 2000 года в журнале Nature [25] с сильными биологическими мотивами и математическими обоснованиями. [26] Впервые это было продемонстрировано в 2011 году, чтобы обеспечить лучшее обучение более глубоких сетей. [27] по сравнению с широко используемыми функциями активации до 2011 года, то есть логистической сигмоидой (которая основана на теории вероятностей ; см. логистическую регрессию ) и ее более практичной функцией. [28] аналог — гиперболический тангенс .

Обычно используемым вариантом функции активации ReLU является Leaky ReLU, который допускает небольшой положительный градиент, когда устройство не активно:

где x — входные данные нейрона, а a использовалось значение 0,01 — небольшая положительная константа (в оригинальной статье для a ). [29]

Алгоритм псевдокода

[ редактировать ]Ниже приведена простая реализация псевдокода одного TLU, который принимает логические входные значения (истина или ложь) и возвращает один логический выход при активации. объектно -ориентированная Используется модель. Никакой метод обучения не определен, поскольку существует несколько. Если бы использовалась чисто функциональная модель, приведенный ниже класс TLU был бы заменен функциональным TLU с порогом входных параметров, весами и входными данными, которые возвращали логическое значение.

class TLU defined as:

data member threshold : number

data member weights : list of numbers of size X

function member fire(inputs : list of booleans of size X) : boolean defined as:

variable T : number

T ← 0

for each i in 1 to X do

if inputs(i) is true then

T ← T + weights(i)

end if

end for each

if T > threshold then

return true

else:

return false

end if

end function

end class

См. также

[ редактировать ]Ссылки

[ редактировать ]- ^ Рами А. Альзахрани; Элис С. Паркер. «Нейроморфные схемы с нейронной модуляцией, улучшающие информационное содержание нейронной сигнализации». Материалы международной конференции по нейроморфным системам 2020 . Искусство. 19. Нью-Йорк: Ассоциация вычислительной техники. дои : 10.1145/3407197.3407204 . ISBN 978-1-4503-8851-1 . S2CID 220794387 .

- ^ Маан, АК; Джаядеви, Д.А.; Джеймс, AP (1 января 2016 г.). «Обзор мемристивных пороговых логических схем». Транзакции IEEE в нейронных сетях и системах обучения . ПП (99): 1734–1746. arXiv : 1604.07121 . Бибкод : 2016arXiv160407121M . дои : 10.1109/TNNLS.2016.2547842 . ISSN 2162-237X . ПМИД 27164608 . S2CID 1798273 .

- ^ ФК Хоппенштадт и Е.М. Ижикевич (1997). Слабосвязанные нейронные сети . Спрингер. п. 4. ISBN 978-0-387-94948-2 .

- ^ Мински, Марвин Ли (1 января 1967 г.). Вычисления: конечные и бесконечные машины . Прентис Холл. ISBN 978-0-13-165563-8 .

- ^ Маккалок, Уоррен С.; Питтс, Уолтер (1 декабря 1943 г.). «Логическое исчисление идей, имманентных нервной деятельности» . Вестник математической биофизики . 5 (4): 115–133. дои : 10.1007/BF02478259 . ISSN 1522-9602 .

- ^ Гидон, Альберт; Зольник, Тимоти Адам; Фидзинский, Павел; Болдуан, Феликс; Папуци, Афанасия; Poirazi, Панайота ; Хольткамп, Мартин; Вида, Имре; Ларкум, Мэтью Эван (03 января 2020 г.). «Дендритные потенциалы действия и вычисления в нейронах коры головного мозга 2/3 слоя человека» . Наука . 367 (6473): 83–87. Бибкод : 2020Sci...367...83G . дои : 10.1126/science.aax6239 . ПМИД 31896716 . S2CID 209676937 .

- ^ Сквайр, Л.; Олбрайт, Т.; Блум, Ф.; Гейдж, Ф.; Спитцер, Н., ред. (октябрь 2007 г.). Нейросетевые модели производства, обучения и кодирования пения птиц (PDF) . Новая энциклопедия неврологии: Эльсервье. Архивировано из оригинала (PDF) 12 апреля 2015 г. Проверено 12 апреля 2015 г.

- ^ Мур, Дж. М.; и др. (2011). «Конвергенция двигательных путей предсказывает размер слогового репертуара у осциновых птиц» . Учеб. Натл. акад. наук. США . 108 (39): 16440–16445. Бибкод : 2011PNAS..10816440M . дои : 10.1073/pnas.1102077108 . ПМК 3182746 . ПМИД 21918109 .

- ^ Потлури, Пушпа Шри (26 ноября 2014 г.). «Способность исправления ошибок унарного кодирования». arXiv : 1411.7406 [ cs.IT ].

- ^ Кляйнер, Курт (25 августа 2022 г.). «Сделать компьютерные чипы более похожими на клетки мозга» . Познаваемый журнал | Ежегодные обзоры . doi : 10.1146/knowable-082422-1 . Проверено 23 сентября 2022 г.

- ^ Кин, Скотт Т.; Лубрано, Клаудия; Каземзаде, Сетаре; Мелианас, Армантас; Тухман, Яаков; Полино, Джузеппина; Сконьямильо, Паола; Сина, Лусио; Саллео, Альберто; ван де Бургт, Йори; Санторо, Франческа (сентябрь 2020 г.). «Бигибридный синапс с пластичностью, опосредованной нейротрансмиттерами» . Природные материалы . 19 (9): 969–973. Бибкод : 2020NatMa..19..969K . дои : 10.1038/s41563-020-0703-y . ISSN 1476-4660 . ПМИД 32541935 . S2CID 219691307 .

- Пресс-релиз университета: «Исследователи разрабатывают искусственный синапс, который работает с живыми клетками» . Стэнфордский университет черезmedicalxpress.com . Проверено 23 сентября 2022 г.

- ^ «Искусственный нейрон обменивается дофамином с клетками мозга крысы, как настоящий» . Новый учёный . Проверено 16 сентября 2022 г.

- ^ Wang, Ting; Wang, Ming; Wang, Jianwu; Yang, Le; Ren, Xueyang; Song, Gang; Chen, Shisheng; Yuan, Yuehui; Liu, Ruiqing; Pan, Liang; Li, Zheng; Leow, Wan Ru; Luo, Yifei; Ji, Shaobo; Cui, Zequn; He, Ke; Zhang, Feilong; Lv, Fengting; Tian, Yuanyuan; Cai, Kaiyu; Yang, Bowen; Niu, Jingyi; Zou, Haochen; Liu, Songrui; Xu, Guoliang; Fan, Xing; Hu, Benhui; Loh, Xian Jun; Wang, Lianhui; Chen, Xiaodong (8 August 2022). , /s41928-022-00803-0.hdl , Ван, Мин, Ван, Цзяну; Жэнь, Сюэян; Юань, Юэхуэй; Ли, Чжэн, Ван Лу; , Ифэй; Цуй, Цзэцюнь; Хэ, Чжан, Фейлун; Цай, Кайюй; , Голян Ляньхуэй Син ; 10356/163240 Ху . ; Бэньхуэй ; , Ван :

- ^ «Ученые создают крошечные устройства, которые работают как человеческий мозг» . Независимый . 20 апреля 2020 года. Архивировано из оригинала 24 апреля 2020 года . Проверено 17 мая 2020 г.

- ^ «Исследователи представляют электронику, которая имитирует человеческий мозг в эффективном обучении» . физ.орг . Архивировано из оригинала 28 мая 2020 года . Проверено 17 мая 2020 г.

- ^ Фу, Тианда; Гао, Хунъянь; Уорд, Лю, Сяорун; Ван, Чжунжуй, Е; Джошуа Ян, Дж.; Дерек Р.; Цзюнь (20 апреля 2020 г.). Бионапряженные мемристоры» . Nature Communications . 11 1): 1861. Бибкод : 2020NatCo..11.1861F . ( , « -у 7171104 .

- ^ Болахе, Саугат. «Робот Lego с органическим «мозгом» учится перемещаться по лабиринту» . Научный американец . Проверено 1 февраля 2022 г.

- ^ Краухаузен, Имке; Куцурас, Димитриос А.; Мелианас, Оружие; Кин, Скотт Т.; Либерт, Кэтрин; Ледансер, Адриан; Шиламантула, Раджендер; Джованни, Александр; Торричелли, Фабрицио; Маккаллох, Иэн; Блом, Пол ВМ; Саллео, Альберт; Бургт, Йори ван де; Гкупиденис, Пасхалис (декабрь 2021 г.). «Органическая нейроморфная электроника для сенсомоторной интеграции и обучения в робототехнике» . Достижения науки . 7 (50): eabl5068. Бибкод : 2021SciA....7.5068K . дои : 10.1126/sciadv.abl5068 . hdl : 10754/673986 . ПМЦ 8664264 . ПМИД 34890232 . S2CID 245046482 .

- ^ Саркар, Танмой; Либерт, Катарина; Павлу, Аристея; Фрэнк, Томас; Майлендер, Волкер; Маккалок, Иэн; Блом, Пол ВМ; Торричелли, Фабрицио; Гкупиденис, Пасхалис (7 ноября 2022 г.). «Органический искусственный импульсный нейрон для нейроморфного зондирования in situ и биоинтерфейса» . Природная электроника . 5 (11): 774–783. дои : 10.1038/s41928-022-00859-y . hdl : 10754/686016 . ISSN 2520-1131 . S2CID 253413801 .

- ^ «Искусственные нейроны имитируют биологические аналоги, обеспечивая синергетическое действие» . Природная электроника . 5 (11): 721–722. 10 ноября 2022 г. doi : 10.1038/s41928-022-00862-3 . ISSN 2520-1131 . S2CID 253469402 .

- ^ Мартин Энтони (январь 2001 г.). Дискретная математика нейронных сетей: избранные темы . СИАМ. стр. 3–. ISBN 978-0-89871-480-7 .

- ^ Чару К. Аггарвал (25 июля 2014 г.). Классификация данных: алгоритмы и приложения . ЦРК Пресс. стр. 209–. ISBN 978-1-4665-8674-1 .

- ^ Пол Вербос , За пределами регрессии: новые инструменты прогнозирования и анализа в поведенческих науках. Докторская диссертация, Гарвардский университет, 1974 г.

- ^ Вербос, П.Дж. (1990). «Обратное распространение ошибки во времени: что оно делает и как это сделать» . Труды IEEE . 78 (10): 1550–1560. дои : 10.1109/5.58337 . ISSN 0018-9219 . S2CID 18470994 .

- ^ Ханлозер, Ричард Х.Р.; Сарпешкар, Рахул; Маховальд, Миша А.; Дуглас, Родни Дж.; Сын, Х. Себастьян (2000). «Цифровая селекция и аналоговое усиление сосуществуют в кремниевой схеме, основанной на коре головного мозга». Природа . 405 (6789): 947–951. Бибкод : 2000Natur.405..947H . дои : 10.1038/35016072 . ISSN 0028-0836 . ПМИД 10879535 . S2CID 4399014 .

- ^ Р. Ханлозер; Х. С. Сын (2001). Разрешенные и запрещенные множества в симметричных порогово-линейных сетях . НИПС 2001.

- ^ Ксавье Глорот; Антуан Борд; Йошуа Бенджио (2011). Нейронные сети с глубоким разреженным выпрямителем (PDF) . АЙСТАТС.

- ^ Ян ЛеКун ; Леон Ботту ; Женевьева Б. Орр; Клаус-Роберт Мюллер (1998). «Эффективный BackProp» (PDF) . У Г. Орра; К. Мюллер (ред.). Нейронные сети: хитрости . Спрингер.

- ^ Эндрю Л. Маас, Ауни Ю. Ханнун, Эндрю Ю. Нг (2014). Нелинейность выпрямителя улучшает акустические модели нейронных сетей .

Дальнейшее чтение

[ редактировать ]- Маккалок, Уоррен С .; Питтс, Уолтер (1943). «Логическое исчисление идей, имманентных нервной деятельности». Вестник математической биофизики . 5 (4): 115–133. дои : 10.1007/bf02478259 .

- Самардак А.; Ногаре, А.; Янсон, НБ; Баланов А.Г.; Фаррер, И.; Ричи, Д.А. (5 июня 2009 г.). «Шумоконтролируемая передача сигнала в многопоточном полупроводниковом нейроне» . Письма о физических отзывах . 102 (22): 226802. Бибкод : 2009PhRvL.102v6802S . дои : 10.1103/physrevlett.102.226802 . ПМИД 19658886 . S2CID 11211062 .