Нелинейное уменьшение размерности

Нелинейное уменьшение размерности , также известное как обучение многообразию , представляет собой любой из различных связанных методов, целью которых является проецирование многомерных данных на скрытые многообразия более низкой размерности с целью либо визуализации данных в низкомерном пространстве, либо изучения отображения. (либо из многомерного пространства в низкомерное вложение, либо наоборот). [ 1 ] [ 2 ] Методы, описанные ниже, можно понимать как обобщение методов линейной декомпозиции, используемых для уменьшения размерности , таких как разложение по сингулярным значениям и анализ главных компонент .

Применение НЛДР

[ редактировать ]С крупноразмерными данными может быть сложно работать машинам, поскольку для анализа требуется значительное время и пространство. Это также представляет собой проблему для людей, поскольку трудно визуализировать или понять данные более чем в трех измерениях. Уменьшение размерности набора данных при относительном сохранении его основных характеристик может сделать алгоритмы более эффективными и позволить аналитикам визуализировать тенденции и закономерности.

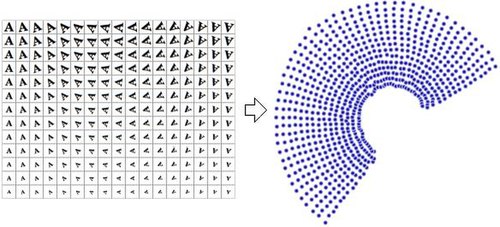

Представления данных уменьшенной размерности часто называют «внутренними переменными». Это описание подразумевает, что это значения, из которых были получены данные. Например, рассмотрим набор данных, содержащий изображения буквы «А», масштабированные и повернутые на разную величину. Каждое изображение имеет размер 32×32 пикселя. Каждое изображение может быть представлено как вектор из 1024 значений пикселей. Каждая строка представляет собой выборку на двумерном многообразии в 1024-мерном пространстве ( пространстве Хэмминга ). Внутренняя размерность равна двум, поскольку для получения данных менялись две переменные (вращение и масштаб). Информация о форме или внешнем виде буквы «А» не является частью внутренних переменных, поскольку она одинакова во всех случаях. Нелинейное уменьшение размерности позволит отбросить коррелированную информацию (букву «А») и восстановить только изменяющуюся информацию (вращение и масштаб). На изображении справа показаны образцы изображений из этого набора данных (в целях экономии места показаны не все входные изображения) и график двумерных точек, полученный в результате использования алгоритма NLDR (в данном случае использовалось моделирование многообразия). чтобы свести данные только к двум измерениям.

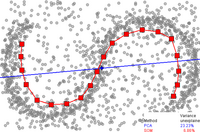

Для сравнения, если для преобразования этого же набора данных в два измерения используется анализ главных компонент , который представляет собой алгоритм уменьшения линейной размерности, полученные значения не так хорошо организованы. Это демонстрирует, что многомерные векторы (каждый из которых представляет букву «А»), которые выбирают это многообразие, изменяются нелинейным образом.

Таким образом, должно быть очевидно, что NLDR имеет несколько применений в области компьютерного зрения. Например, рассмотрим робота, который использует камеру для навигации в закрытой статической среде. Изображения, полученные этой камерой, можно рассматривать как образцы многообразия в многомерном пространстве, а внутренние переменные этого многообразия будут представлять положение и ориентацию робота.

Инвариантные многообразия представляют общий интерес для понижения порядка моделей в динамических системах . В частности, если в фазовом пространстве существует притягивающее инвариантное многообразие, близлежащие траектории будут сходиться к нему и оставаться на нем неопределенно долго, что делает его кандидатом на понижение размерности динамической системы. Хотя существование таких многообразий вообще не гарантируется, теория спектральных подмногообразий (ССМ) дает условия существования уникальных притягивающих инвариантных объектов в широком классе динамических систем. [ 3 ] Активные исследования в области NLDR направлены на раскрытие многообразий наблюдений, связанных с динамическими системами, для разработки методов моделирования. [ 4 ]

Некоторые из наиболее известных методов нелинейного уменьшения размерности перечислены ниже.

Важные понятия

[ редактировать ]Картирование Саммона

[ редактировать ]Картирование Сэммона — один из первых и наиболее популярных методов NLDR.

Самоорганизующаяся карта

[ редактировать ]( Самоорганизующаяся карта SOM, также называемая картой Кохонена ) и ее вероятностный вариант генеративного топографического отображения (GTM) используют точечное представление во встроенном пространстве для формирования модели скрытых переменных, основанной на нелинейном отображении встроенного пространства во встроенное пространство. многомерное пространство. [ 6 ] Эти методы связаны с работой над сетями плотности , которые также основаны на той же вероятностной модели.

Анализ главных компонентов ядра

[ редактировать ]Пожалуй, наиболее широко используемый алгоритм уменьшения размерности — это ядро PCA . [ 7 ] PCA начинается с вычисления ковариационной матрицы матрица

Затем он проецирует данные на первые k собственных векторов этой матрицы. Для сравнения, KPCA начинается с вычисления ковариационной матрицы данных после преобразования в многомерное пространство.

Затем он проецирует преобразованные данные на первые k собственных векторов этой матрицы, как и PCA. Он использует трюк с ядром , чтобы исключить большую часть вычислений, так что весь процесс может быть выполнен без фактических вычислений. . Конечно должен выбираться так, чтобы ему было известно соответствующее ядро. К сожалению, найти хорошее ядро для данной задачи непросто, поэтому KPCA не дает хороших результатов при некоторых проблемах при использовании стандартных ядер. Например, известно, что эти ядра плохо работают на коллекторе швейцарского валка . Однако можно рассматривать некоторые другие методы, которые хорошо работают в таких условиях (например, собственные карты Лапласа, LLE), как частные случаи PCA ядра путем построения матрицы ядра, зависящей от данных. [ 8 ]

KPCA имеет внутреннюю модель, поэтому ее можно использовать для сопоставления точек ее внедрения, которые были недоступны во время обучения.

Основные кривые и многообразия

[ редактировать ]

Основные кривые и многообразия дают естественную геометрическую основу для нелинейного уменьшения размерности и расширяют геометрическую интерпретацию PCA путем явного построения встроенного многообразия и кодирования с использованием стандартной геометрической проекции на многообразие. Первоначально этот подход был предложен Тревором Хэсти в его диссертации 1984 года: [ 11 ] который он официально представил в 1989 году. [ 12 ] Эту идею далее исследовали многие авторы. [ 13 ] Как определить «простоту» многообразия, зависит от проблемы, однако обычно она измеряется внутренней размерностью и/или гладкостью многообразия. Обычно главное многообразие определяется как решение задачи оптимизации. Целевая функция включает в себя качество аппроксимации данных и некоторые штрафные санкции за изгиб многообразия. Популярные начальные приближения генерируются линейным PCA и SOM Кохонена.

Собственные отображения Лапласа

[ редактировать ]Собственные карты Лапласа используют спектральные методы для уменьшения размерности. [ 14 ] Этот метод основан на базовом предположении, что данные лежат в многообразии низкой размерности в пространстве высокой размерности. [ 15 ] Этот алгоритм не может встраивать точки вне выборки, но гильбертова пространства воспроизводящего ядра . для добавления этой возможности существуют методы, основанные на регуляризации [ 16 ] Такие методы могут быть применены и к другим нелинейным алгоритмам уменьшения размерности.

Традиционные методы, такие как анализ главных компонентов, не учитывают внутреннюю геометрию данных. Собственные карты Лапласа строят график на основе информации о окрестности набора данных. Каждая точка данных служит узлом на графе, и связность между узлами определяется близостью соседних точек (например, с использованием алгоритма k-ближайшего соседа ). Сгенерированный таким образом граф можно рассматривать как дискретную аппроксимацию низкоразмерного многообразия в многомерном пространстве. Минимизация функции стоимости на основе графика гарантирует, что точки, расположенные близко друг к другу на многообразии, отображаются близко друг к другу в низкоразмерном пространстве, сохраняя локальные расстояния. Собственные функции оператора Лапласа–Бельтрами на многообразии служат размерностями вложения, поскольку в мягких условиях этот оператор имеет счетный спектр, который является базисом для суммируемых с квадратом функций на многообразии (сравните с рядами Фурье на многообразии единичной окружности). Попытки разместить собственные карты Лапласа на прочной теоретической основе увенчались некоторым успехом, поскольку при определенных неограничительных предположениях было показано, что матрица Лапласа-графа сходится к оператору Лапласа-Бельтрами, когда количество точек стремится к бесконечности. [ 15 ]

Изомап

[ редактировать ]Изомап [ 17 ] представляет собой комбинацию алгоритма Флойда-Уоршалла с классическим многомерным масштабированием (MDS). Классический MDS принимает матрицу попарных расстояний между всеми точками и вычисляет положение для каждой точки. Isomap предполагает, что попарные расстояния известны только между соседними точками, и использует алгоритм Флойда – Уоршалла для вычисления попарных расстояний между всеми остальными точками. Это эффективно оценивает полную матрицу попарных геодезических расстояний между всеми точками. Затем Isomap использует классический MDS для вычисления уменьшенных положений всех точек. Landmark-Isomap — это вариант этого алгоритма, который использует ориентиры для увеличения скорости за счет некоторой точности.

При обучении многообразиям предполагается, что входные данные выбираются из многообразия низкой размерности , встроенного в векторное пространство более высокой размерности. Основная идея MVU заключается в использовании локальной линейности многообразий и создании отображения, сохраняющего локальные окрестности в каждой точке основного многообразия.

Локально-линейное вложение

[ редактировать ]Локально-линейное встраивание (LLE) было представлено примерно в то же время, что и Isomap. [ 18 ] Он имеет несколько преимуществ перед Isomap, в том числе более быструю оптимизацию при реализации с использованием алгоритмов разреженной матрицы и лучшие результаты при решении многих задач. LLE также начинается с поиска набора ближайших соседей каждой точки. Затем он вычисляет набор весов для каждой точки, который лучше всего описывает точку как линейную комбинацию ее соседей. Наконец, он использует метод оптимизации на основе собственных векторов для поиска низкоразмерного вложения точек, так что каждая точка по-прежнему описывается одной и той же линейной комбинацией своих соседей. LLE имеет тенденцию плохо справляться с неоднородной плотностью выборки, поскольку не существует фиксированной единицы измерения, предотвращающей дрейф весов, поскольку в различных регионах плотность выборки различается. LLE не имеет внутренней модели.

LLE вычисляет барицентрические координаты точки X i на основе ее соседей X j . Исходная точка восстанавливается с помощью линейной комбинации . , заданной весовой матрицей Wij ее соседей Ошибка реконструкции определяется функцией стоимости E ( W ).

Веса Wij Xj относятся к величине вклада, который точка при вносит точки Xi . восстановлении Функция стоимости минимизируется при двух ограничениях: (a) Каждая точка данных X i восстанавливается только на основе своих соседей, таким образом, W ij становится равным нулю, если точка X j не является соседом точки X i и (б) Сумма каждой строки весовой матрицы равна 1.

Исходные точки данных собираются в D- мерном пространстве, и цель алгоритма — уменьшить размерность до d так, чтобы D >> d . Те же веса Wij , которые восстанавливают i- ю точку данных в D -мерном пространстве, будут использоваться для восстановления той же точки в нижнем d -мерном пространстве. На основе этой идеи создана карта, сохраняющая окрестности. Каждая точка X i в D -мерном пространстве отображается в точку Y i в d -мерном пространстве путем минимизации функции стоимости.

В этой функции стоимости, в отличие от предыдущей, веса Wij остаются фиксированными, а минимизация выполняется в точках Yi для оптимизации координат. Эту проблему минимизации можно решить, решив разреженную N X N задачу собственных значений ( N — количество точек данных), чьи нижние d ненулевые собственные векторы обеспечивают ортогональный набор координат. Обычно точки данных восстанавливаются на основе K ближайших соседей, измеренных евклидовым расстоянием . Для такой реализации алгоритм имеет только один свободный параметр K, который можно выбрать путем перекрестной проверки.

Гессенское локально-линейное вложение (гессианское LLE)

[ редактировать ]Как и LLE, гессенский LLE также основан на методах разреженной матрицы. [ 19 ] Он имеет тенденцию давать результаты гораздо более высокого качества, чем LLE. К сожалению, он имеет очень высокую вычислительную сложность, поэтому не очень подходит для многообразий с большой выборкой. У него нет внутренней модели.

Модифицированное локально-линейное встраивание (MLLE)

[ редактировать ]Модифицированный LLE (MLLE) [ 20 ] это еще один вариант LLE, который использует несколько весов в каждой окрестности для решения проблемы кондиционирования локальной матрицы весов, которая приводит к искажениям в картах LLE. Грубо говоря, кратные веса представляют собой локальную ортогональную проекцию исходных весов, созданных LLE. Создатели этого регуляризованного варианта также являются авторами метода Local Tangent Space Alignment (LTSA), который подразумевается в формулировке MLLE, когда мы понимаем, что глобальная оптимизация ортогональных проекций каждого весового вектора, по сути, выравнивает локальные касательные пространства. каждой точки данных. Теоретические и эмпирические последствия правильного применения этого алгоритма имеют далеко идущие последствия. [ 21 ]

Выравнивание локального касательного пространства

[ редактировать ]LTSA [ 22 ] основано на интуитивном предположении, что при правильном развертывании многообразия все касательные к нему гиперплоскости выровняются. Он начинается с вычисления k -ближайших соседей каждой точки. Он вычисляет касательное пространство в каждой точке, вычисляя d -первые главные компоненты в каждой локальной окрестности. Затем он оптимизируется, чтобы найти вложение, которое выравнивает касательные пространства.

Максимальная дисперсия

[ редактировать ]Развертывание максимальной дисперсии , Isomap и локально линейное вложение имеют общую интуицию, основанную на идее, что если многообразие правильно развернуто, то дисперсия по точкам максимальна. Его первоначальный шаг, как и Isomap и локально линейное вложение, заключается в поиске k -ближайших соседей каждой точки. Затем он пытается решить задачу максимизации расстояния между всеми несмежными точками, ограниченную таким образом, чтобы расстояния между соседними точками сохранялись. Основным вкладом этого алгоритма является метод преобразования этой проблемы в полуопределенную задачу программирования. К сожалению, решатели полуопределенного программирования требуют больших вычислительных затрат. Как и локально линейное встраивание, оно не имеет внутренней модели.

Автоматические кодировщики

[ редактировать ]Автоэнкодер , прямого распространения — это нейронная сеть которая обучена аппроксимировать функцию идентичности. То есть его обучают отображать вектор значений в тот же вектор. При использовании в целях уменьшения размерности один из скрытых слоев сети ограничен и может содержать лишь небольшое количество сетевых блоков. Таким образом, сеть должна научиться кодировать вектор в небольшое количество измерений, а затем декодировать его обратно в исходное пространство. Таким образом, первая половина сети представляет собой модель, которая отображает пространство высокой размерности в пространство низкой размерности, а вторая половина отображает пространство низкой размерности в пространство высокой размерности. Хотя идея автоэнкодеров довольно старая, [ 23 ] Обучение глубоких автокодировщиков стало возможным лишь недавно благодаря использованию ограниченных машин Больцмана и многоуровневых автокодировщиков с шумоподавлением. С автоэнкодерами связан алгоритм NeuroScale , который использует функции напряжения, основанные на многомерном масштабировании и отображениях Сэммона (см. выше), для изучения нелинейного отображения многомерного пространства во встроенное. Отображения в NeuroScale основаны на радиальных сетях базисных функций .

Модели скрытых переменных гауссовского процесса

[ редактировать ]Модели скрытых переменных гауссовского процесса (GPLVM) [ 24 ] — это вероятностные методы уменьшения размерности, которые используют гауссовы процессы (GP) для поиска нелинейного внедрения низкоразмерных данных большой размерности. Они являются расширением вероятностной формулировки PCA. Модель определяется вероятностно, затем скрытые переменные маргинализируются, а параметры получаются путем максимизации правдоподобия. Как и ядро PCA, они используют функцию ядра для формирования нелинейного отображения (в форме гауссова процесса ). Однако в GPLVM отображение происходит из встроенного (скрытого) пространства в пространство данных (например, в сетях плотности и GTM), тогда как в ядре PCA оно происходит в противоположном направлении. Первоначально он был предложен для визуализации данных большой размерности, но был расширен для построения общей модели многообразия между двумя пространствами наблюдения. GPLVM и ее многочисленные варианты были предложены специально для моделирования движений человека, например, GPLVM с обратными ограничениями, динамическая модель GP (GPDM), сбалансированная GPDM (B-GPDM) и GPDM с топологическими ограничениями. Чтобы уловить эффект связи многообразий позы и походки при анализе походки, было предложено многослойное объединенное многообразие походки и позы. [ 25 ]

t-распределенное стохастическое встраивание соседей

[ редактировать ]t-распределенное стохастическое встраивание соседей (t-SNE) [ 26 ] широко используется. Это один из семейства стохастических методов встраивания соседей. Алгоритм вычисляет вероятность того, что пары точек данных в многомерном пространстве связаны, а затем выбирает низкоразмерные вложения, которые создают аналогичное распределение.

Другие алгоритмы

[ редактировать ]Реляционная карта перспективы

[ редактировать ]Реляционная карта перспективы — это алгоритм многомерного масштабирования . Алгоритм находит конфигурацию точек данных на многообразии, моделируя многочастичную динамическую систему на закрытом многообразии, где точки данных сопоставляются с частицами, а расстояния (или несходство) между точками данных представляют собой силу отталкивания. По мере того, как многообразие постепенно увеличивается в размерах, многочастичная система постепенно остывает и сходится к конфигурации, которая отражает информацию о расстоянии от точек данных.

Карта реляционной перспективы была вдохновлена физической моделью, в которой положительно заряженные частицы свободно движутся по поверхности шара. Руководствуясь кулоновской силой между частицами, минимальная энергетическая конфигурация частиц будет отражать силу сил отталкивания между частицами.

Карта реляционной перспективы была представлена в. [ 27 ] Алгоритм сначала использовал плоский тор в качестве многообразия изображений, затем он был расширен (в программном обеспечении VisuMap для использования других типов замкнутых многообразий, таких как сфера , проективное пространство и бутылка Клейна , в качестве многообразий изображений.

Карты заражения

[ редактировать ]Карты заражения используют несколько заражений в сети для отображения узлов в виде облака точек. [ 28 ] В случае модели «Глобальные каскады» скорость распространения можно регулировать с помощью порогового параметра. . Для карта заражения эквивалентна алгоритму Isomap .

Анализ криволинейных компонентов

[ редактировать ]Анализ криволинейных компонентов (CCA) ищет конфигурацию точек в выходном пространстве, которая максимально сохраняет исходные расстояния, уделяя при этом внимание небольшим расстояниям в выходном пространстве (в отличие от отображения Сэммона , которое фокусируется на небольших расстояниях в исходном пространстве). [ 29 ]

Следует отметить, что CCA, как алгоритм итеративного обучения, фактически начинается с фокусировки на больших расстояниях (как алгоритм Сэммона), затем постепенно переключает фокус на малые расстояния. Информация о малых расстояниях перезапишет информацию о больших расстояниях, если придется пойти на компромисс между ними.

Функция напряжения CCA связана с суммой правых расхождений Брегмана. [ 30 ]

Криволинейный дистанционный анализ

[ редактировать ]CDA [ 29 ] обучает самоорганизующуюся нейронную сеть, чтобы она соответствовала многообразию, и стремится сохранить геодезические расстояния при ее внедрении. Он основан на анализе криволинейных компонентов (который расширил картографирование Сэммона), но вместо этого использует геодезические расстояния.

Диффеоморфное уменьшение размерности

[ редактировать ]Диффеоморфное уменьшение размерности или диффеомап [ 31 ] изучает гладкое диффеоморфное отображение, которое переносит данные в линейное подпространство меньшей размерности. Методы позволяют найти гладкое векторное поле, индексированное по времени, так что потоки вдоль поля, которые начинаются в точках данных, заканчиваются в линейном подпространстве меньшей размерности, тем самым пытаясь сохранить попарные различия как при прямом, так и при обратном отображении.

Выравнивание коллектора

[ редактировать ]Выравнивание многообразия основано на предположении, что разрозненные наборы данных, созданные с помощью схожих процессов генерации, будут иметь одинаковое базовое представление многообразия. Путем изучения проекций из каждого исходного пространства на общее многообразие восстанавливаются соответствия и знания из одной области могут быть переданы в другую. Большинство методов выравнивания многообразия рассматривают только два набора данных, но эта концепция распространяется на произвольное количество исходных наборов данных. [ 32 ]

Карты диффузии

[ редактировать ]Карты диффузии используют взаимосвязь между диффузией тепла и случайным блужданием ( цепь Маркова ); Проводится аналогия между оператором диффузии на многообразии и марковской матрицей перехода, действующей на функции, определенные на графе, узлы которого были выбраны из многообразия. [ 33 ] В частности, пусть набор данных представлен в виде . Основное предположение диффузионной карты заключается в том, что многомерные данные лежат на многообразии низкой размерности размерности . Пусть X представляет набор данных и представляют распределение точек данных на X . Далее определим ядро , которое представляет некоторое понятие близости точек в X . Ядро имеет следующие свойства [ 34 ]

k симметричен

k сохраняет положительность

Таким образом, можно думать об отдельных точках данных как об узлах графа, а о ядре k как об определении некоторого рода сходства на этом графе. Граф симметричен по построению, поскольку ядро симметрично. Здесь легко видеть, что из набора ( X , k ) можно построить обратимую цепь Маркова . Этот метод является общим для множества областей и известен как графовый лапласиан.

Например, граф K = ( X , E ) можно построить с использованием ядра Гаусса.

В приведенном выше уравнении означает, что является ближайшим соседом . Правильно, геодезическое расстояние следует использовать для фактического измерения расстояний на многообразии . Поскольку точная структура многообразия неизвестна, для ближайших соседей геодезическое расстояние аппроксимируется евклидовым расстоянием. Выбор модулирует наше представление о близости в том смысле, что если затем и если затем . Первое означает, что произошла очень незначительная диффузия, тогда как второе означает, что процесс диффузии почти завершен. Различные стратегии на выбор можно найти в. [ 35 ]

Чтобы точно представить марковскую матрицу, должен быть нормализован соответствующей матрицей степеней :

теперь представляет собой цепь Маркова. вероятность перехода от к за один временной шаг. Аналогично вероятность перехода от к за t шагов по времени определяется выражением . Здесь это матрица умноженное само на себя t раз.

Марковская матрица представляет собой некоторое понятие локальной геометрии набора данных X . Основное различие между картами диффузии и анализом главных компонентов заключается в том, что в картах диффузии учитываются только локальные особенности данных, а не корреляции всего набора данных.

определяет случайное блуждание по набору данных, что означает, что ядро фиксирует некоторую локальную геометрию набора данных. Цепь Маркова определяет быстрые и медленные направления распространения значений ядра. По мере продвижения во времени информация о локальной геометрии объединяется таким же образом, как и локальные переходы (определяемые дифференциальными уравнениями) динамической системы. [ 34 ] Метафора диффузии возникает из определения семейного диффузионного расстояния.

Для фиксированного t, определяет расстояние между любыми двумя точками набора данных на основе связности пути: значение будет тем меньше, чем больше путей соединяют x с y и наоборот. Потому что количество включает в себя сумму всех путей длины t, гораздо более устойчив к шуму в данных, чем геодезическое расстояние. учитывает все связи между точками x и y при вычислении расстояния и служит лучшим понятием близости, чем просто евклидово расстояние или даже геодезическое расстояние.

Локальное многомерное масштабирование

[ редактировать ]Локальное многомерное масштабирование выполняет многомерное масштабирование в локальных регионах, а затем использует выпуклую оптимизацию, чтобы соединить все части вместе. [ 36 ]

Нелинейный PCA

[ редактировать ]Нелинейный PCA (NLPCA) использует обратное распространение ошибки для обучения многослойного перцептрона (MLP) приспособлению к многообразию. [ 37 ] В отличие от типичного обучения MLP, при котором обновляются только веса, NLPCA обновляет и веса, и входные данные. То есть и веса, и входные данные рассматриваются как скрытые значения. После обучения скрытые входные данные представляют собой низкоразмерное представление наблюдаемых векторов, и MLP отображает это низкоразмерное представление в многомерное пространство наблюдения.

Многомерное масштабирование на основе данных

[ редактировать ]Многомерное масштабирование на основе данных (DD-HDS) [ 38 ] тесно связан с картографированием Сэммона и анализом криволинейных компонентов, за исключением того, что (1) он одновременно штрафует ложные соседства и разрывы, фокусируясь на малых расстояниях как в исходном, так и в выходном пространстве, и что (2) он учитывает явление концентрации меры путем адаптации взвешивания функция распределения расстояний.

Скульптура многообразия

[ редактировать ]Скульптура многообразия [ 39 ] использует градуированную оптимизацию для поиска вложения. Как и другие алгоритмы, он вычисляет k -ближайших соседей и пытается найти вложение, сохраняющее отношения в локальных окрестностях. Он медленно масштабирует дисперсию в более высоких измерениях, одновременно корректируя точки в более низких измерениях, чтобы сохранить эти взаимосвязи. Если скорость масштабирования мала, можно найти очень точные вложения. Он может похвастаться более высокой эмпирической точностью, чем другие алгоритмы с несколькими проблемами. Его также можно использовать для уточнения результатов других алгоритмов обучения многообразию. Однако он с трудом разворачивает некоторые многообразия, если не используется очень медленная скорость масштабирования. У него нет модели.

РейтингВсе

[ редактировать ]РейтингВсе [ 40 ] разработан для сохранения ранга соседства, а не расстояния. RankVisu особенно полезен при выполнении сложных задач (когда сохранение дистанции не может быть удовлетворительным). Действительно, ранг соседства менее информативен, чем расстояние (ранги можно вывести из расстояний, но расстояния нельзя вывести из рангов), и поэтому его легче сохранить.

Топологически ограниченное изометрическое вложение

[ редактировать ]Топологически ограниченное изометрическое встраивание (TCIE) [ 41 ] — это алгоритм, основанный на аппроксимации геодезических расстояний после фильтрации геодезических, несовместимых с евклидовой метрикой. С целью исправления искажений, вызванных использованием Isomap для отображения изначально невыпуклых данных, TCIE использует MDS методом наименьших квадратов веса, чтобы получить более точное отображение. Алгоритм TCIE сначала обнаруживает возможные граничные точки в данных, а во время вычисления геодезической длины отмечает противоречивые геодезические, которым придается небольшой вес в взвешенном мажорировании напряжений последующем .

Приближение и проекция равномерного многообразия

[ редактировать ]Приближение и проекция равномерного многообразия (UMAP) - это метод нелинейного уменьшения размерности. [ 42 ] Визуально он похож на t-SNE , но предполагает, что данные равномерно распределены на локально связном римановом многообразии и что риманова метрика локально постоянна или приблизительно локально постоянна. [ 43 ]

Методы, основанные на матрицах близости

[ редактировать ]Метод, основанный на матрицах близости, — это метод, в котором данные представляются алгоритму в виде матрицы сходства или матрицы расстояний . Все эти методы относятся к более широкому классу метрического многомерного масштабирования . Изменения, как правило, связаны с различиями в том, как вычисляются данные о близости; например, isomap , локально линейные вложения , развертывание максимальной дисперсии и отображение Сэммона (которое на самом деле не является отображением) являются примерами метрических методов многомерного масштабирования.

Программное обеспечение

[ редактировать ]- Waffles — это библиотека C++ с открытым исходным кодом, содержащая реализации LLE, Manifold Sculpting и некоторых других алгоритмов обучения многообразиям.

- UMAP.jl реализует метод для языка программирования Julia .

- Метод также реализован на Python (код доступен на GitHub ).

См. также

[ редактировать ]- Гипотеза многообразия

- Спектральное подмногообразие

- Теорема Такена

- Теорема вложения Уитни

- Дискриминантный анализ

- Эластичная карта

- Особенности обучения

- Растущая самоорганизующаяся карта (ВШМ)

- Самоорганизующаяся карта (СОМ)

Ссылки

[ редактировать ]- ^ Лоуренс, Нил Д. (2012). «Объединяющая вероятностная перспектива уменьшения спектральной размерности: идеи и новые модели» . Журнал исследований машинного обучения . 13 (май): 1609–38. arXiv : 1010.4830 . Бибкод : 2010arXiv1010.4830L .

- ^ Ли, Джон А.; Верлейсен, Мишель (2007). Нелинейное уменьшение размерности . Спрингер. ISBN 978-0-387-39350-6 .

- ^ Халлер, Джордж; Понсиен, Стен (2016). «Нелинейные нормальные моды и спектральные подмногообразия: существование, уникальность и использование при сокращении модели». Нелинейная динамика . 86 (3): 1493–1534. arXiv : 1602.00560 . дои : 10.1007/s11071-016-2974-z . S2CID 44074026 .

- ^ Гашлер, М.; Мартинес, Т. (2011). Временное нелинейное уменьшение размерности (PDF) . Материалы Международной совместной конференции по нейронным сетям IJCNN'11. стр. 1959–66.

- ^ Иллюстрация подготовлена с использованием бесплатного программного обеспечения: Миркес, Э.М. (2011). «Анализ главных компонентов и самоорганизующиеся карты: апплет» . Университет Лестера.

- ^ Инь, Худжун (2007). «3. Изучение нелинейных главных многообразий с помощью самоорганизующихся отображений» . В Горбань, АН; Кегль, Б.; Вунш, округ Колумбия; Зиновьев А. (ред.). Основные многообразия для визуализации данных и уменьшения размерности . Конспекты лекций по информатике и инженерии. Том. 58. Спрингер. стр. 68–95. ISBN 978-3-540-73749-0 .

- ^ Шёлкопф, Б.; Смола, А.; Мюллер, К.-Р. (1998). «Анализ нелинейных компонентов как проблема собственных значений ядра». Нейронные вычисления . 10 (5). Массачусетский технологический институт Пресс : 1299–1319. дои : 10.1162/089976698300017467 . S2CID 6674407 .

- ^ Хэм, Джихун; Ли, Дэниел Д.; Мика, Себастьян; Шёлкопф, Бернхард. «Ядерный взгляд на уменьшение размерности многообразий». Материалы 21-й Международной конференции по машинному обучению, Банф, Канада, 2004 г. дои : 10.1145/1015330.1015417 .

- ^ Горбань, АН; Зиновьев, А. (2010). «Основные многообразия и графы на практике: от молекулярной биологии к динамическим системам». Международный журнал нейронных систем . 20 (3): 219–232. arXiv : 1001.1122 . дои : 10.1142/S0129065710002383 . ПМИД 20556849 . S2CID 2170982 .

- ^ А. Зиновьев, ViDaExpert — Инструмент многомерной визуализации данных Института Кюри , Париж.

- ^ Хасти, Т. (ноябрь 1984 г.). Основные кривые и поверхности (PDF) (доктор философии). Стэнфордский центр линейных ускорителей Стэнфордского университета. Архивировано (PDF) из оригинала 2 августа 2019 г.

- ^ Хасти, Т .; Штютцле, В. (июнь 1989 г.). «Основные кривые» (PDF) . Журнал Американской статистической ассоциации . 84 (406): 502–6. дои : 10.1080/01621459.1989.10478797 .

- ^ Горбань, АН ; Кегль, Б.; Вунш, округ Колумбия; Зиновьев А., ред. (2007). Основные многообразия для визуализации данных и уменьшения размерности . Конспекты лекций по информатике и инженерии (LNCSE). Том. 58. Спрингер. ISBN 978-3-540-73749-0 .

- ^ Белкин Михаил; Нийоги, Парта (2001). «Собственные карты Лапласа и спектральные методы встраивания и кластеризации» (PDF) . Достижения в области нейронных систем обработки информации . 14 . Массачусетский технологический институт Пресс: 586–691. ISBN 0-262-27173-7 . OCLC 52710683 .

- ^ Jump up to: а б Белкин, Михаил (август 2003 г.). Проблемы обучения на многообразиях (доктор философии). Департамент математики Чикагского университета. Код Matlab для лапласовых собственных карт можно найти в алгоритмах на сайте Ohio-state.edu.

- ^ Бенджио, Йошуа; Пайман, Жан-Франсуа; Винсент, Паскаль; Делалло, Оливье; Ле Ру, Николя; Уиме, Мари (2004). «Расширения вне выборки для LLE, Isomap, MDS, Eigenmaps и спектральной кластеризации» (PDF) . Достижения в области нейронных систем обработки информации . Том. 16. МИТ Пресс. ISBN 0-262-20152-6 .

- ^ Тененбаум, Дж. Б.; де Сильва, В.; Лэнгфорд, Джей Си (2000). «Глобальная геометрическая основа для нелинейного уменьшения размерности» (PDF) . Наука . 290 (5500): 2319–23. Бибкод : 2000Sci...290.2319T . дои : 10.1126/science.290.5500.2319 . ПМИД 11125149 . S2CID 221338160 .

- ^ Ровейс, ST; Саул, ЛК (2000). «Нелинейное уменьшение размерности путем локально линейного встраивания». Наука . 290 (5500): 2323–6. Бибкод : 2000Sci...290.2323R . дои : 10.1126/science.290.5500.2323 . ПМИД 11125150 . S2CID 5987139 .

- ^ Донохо, Д.; Граймс, К. (2003). «Собственные карты Гессе: локально линейные методы встраивания для многомерных данных» . Proc Natl Acad Sci США . 100 (10): 5591–6. Бибкод : 2003PNAS..100.5591D . дои : 10.1073/pnas.1031596100 . ПМК 156245 . ПМИД 16576753 .

- ^ Чжан, З.; Ван, Дж. (2006). «MLLE: модифицированное локально линейное встраивание с использованием нескольких весов» . NIPS'06: Материалы 19-й Международной конференции по нейронным системам обработки информации : 1593–1600.

- ^ Сидху, Гаган (2019). «Локально-линейное встраивание и выбор признаков фМРТ в психиатрической классификации» . Журнал IEEE трансляционной инженерии в здравоохранении и медицине . 7 : 1–11. arXiv : 1908.06319 . дои : 10.1109/JTEHM.2019.2936348 . ПМК 6726465 . ПМИД 31497410 . S2CID 201832756 .

- ^ Чжан, Чжэньюэ; Хунъюань Чжа (2005). «Основные многообразия и нелинейное уменьшение размерности посредством выравнивания локального касательного пространства». Журнал SIAM по научным вычислениям . 26 (1): 313–338. CiteSeerX 10.1.1.211.9957 . дои : 10.1137/s1064827502419154 .

- ^ ДеМерс, Д.; Коттрелл, GW (1993). «Нелинейное уменьшение размерности». Достижения в области нейронных систем обработки информации . Том. 5. С. 580–7. ISBN 1558600159 . OCLC 928936290 .

- ^ Лоуренс, Н. (2005). «Вероятностный нелинейный анализ главных компонентов с использованием моделей скрытых переменных гауссовского процесса» . Журнал исследований машинного обучения . 6 : 1783–1816.

- ^ Дин, М.; Фан, Г. (2015). «Многослойные многослойные позы суставов для моделирования движений походки человека» . Транзакции IEEE по кибернетике . 45 (11): 2413–24. дои : 10.1109/TCYB.2014.2373393 . ПМИД 25532201 . S2CID 15591304 .

- ^ ван дер Маатен, LJP; Хинтон, GE (2008). «Визуализация многомерных данных с использованием t-SNE» (PDF) . Журнал исследований машинного обучения . 9 : 2579–2605.

- ^ Ли, Джеймс X. (2004). «Визуализация многомерных данных с помощью реляционной карты перспективы» (PDF) . Визуализация информации . 3 : 49–59. doi : 10.1057/palgrave.ivs.9500051 . S2CID 7566939 .

- ^ Тейлор, Д.; Климм, Ф.; Харрингтон, штат Ха; Крамар, М.; Мишайков, К.; Портер, Массачусетс; Муха, Пи Джей (2015). «Топологический анализ данных карт заражения для изучения процессов распространения в сетях» . Природные коммуникации . 6 : 7723. arXiv : 1408.1168 . Бибкод : 2015NatCo...6.7723T . дои : 10.1038/ncomms8723 . ПМК 4566922 . ПМИД 26194875 .

- ^ Jump up to: а б Демартинс, П.; Эро, Ж. (1997). «Анализ криволинейных компонентов: самоорганизующаяся нейронная сеть для нелинейного отображения наборов данных» (PDF) . Транзакции IEEE в нейронных сетях . 8 (1): 148–154. дои : 10.1109/72.554199 . ПМИД 18255618 .

- ^ Сунь, Джиган; Кроу, Малькольм; Файф, Колин (2010). «Анализ криволинейных компонентов и расходимости Брегмана» (PDF) . Европейский симпозиум по искусственным нейронным сетям (Esann) . публикации на стороне d. стр. 81–86.

- ^ Уолдер, Кристиан; Шёлкопф, Бернхард (2009). «Диффеоморфное уменьшение размерности» (PDF) . Достижения в области нейронных систем обработки информации . Том. 22. МИТ Пресс. стр. 1713–20.

- ^ Ван, Чанг; Махадеван, Шридхар (июль 2008 г.). Выравнивание коллектора с использованием анализа Прокруста (PDF) . 25-я Международная конференция по машинному обучению. стр. 1120–7.

- ^ Лафон, Стефан (май 2004 г.). Карты диффузии и геометрические гармоники (доктор философии). Йельский университет .

- ^ Jump up to: а б Койфман, Рональд Р.; Лафон, Стефан (июль 2006 г.). «Диффузионные карты» (PDF) . Прикладной и вычислительный гармонический анализ . 21 (1): 5–30. дои : 10.1016/j.acha.2006.04.006 . S2CID 17160669 .

- ^ Бах, Б. (2008). Диффузионные карты: приложения и анализ (магистры). Оксфордский университет.

- ^ Венна, Дж.; Каски, С. (2006). «Локальное многомерное масштабирование». Нейронные сети . 19 (6–7): 889–899. дои : 10.1016/j.neunet.2006.05.014 . ПМИД 16787737 .

- ^ Шольц, М.; Каплан, Ф.; Гай, CL; Копка, Дж.; Селбиг, Дж. (2005). «Нелинейный PCA: подход с недостающими данными» . Биоинформатика . 21 (20). Издательство Оксфордского университета: 3887–95. doi : 10.1093/биоинформатика/bti634 . hdl : 11858/00-001M-0000-0014-2B1F-2 . ПМИД 16109748 .

- ^ С. Леспинат, М. Верлейсен, А. Гирон, Б. Фертил, DD-HDS: инструмент для визуализации и исследования многомерных данных, Транзакции IEEE в нейронных сетях 18 (5) (2007) 1265–1279.

- ^ Гашлер М. и Вентура Д. и Мартинес Т., Итеративное нелинейное уменьшение размерности с помощью многообразного скульптурирования , Платт, Дж. К., Коллер Д. и Сингер, Ю. и Роуэйс, С., редактор, Достижения в области Нейронные системы обработки информации 20, стр. 513–520, MIT Press, Кембридж, Массачусетс, 2008 г.

- ^ Леспинац С., Фертил Б., Вильмен П. и Эро Дж., Ранквису: Картирование из соседней сети , Neurocomputing, vol. 72 (13–15), стр. 2964–2978, 2009.

- ^ Росман, Г.; Бронштейн, М.М.; Бронштейн А.М.; Киммел, Р. (2010). «Нелинейное уменьшение размерности посредством топологически ограниченного изометрического встраивания» (PDF) . Международный журнал компьютерного зрения . 89 (1): 56–68. дои : 10.1007/s11263-010-0322-1 . S2CID 1365750 .

- ^ Макиннес, Лиланд; Хили, Джон; Мелвилл, Джеймс (07 декабря 2018 г.). «Аппроксимация равномерного многообразия и проекция для уменьшения размерности». arXiv : 1802.03426 .

- ^ «UMAP: Приближение и проекция равномерного многообразия для уменьшения размеров — документация umap 0.3» . umap-learn.readthedocs.io . Проверено 4 мая 2019 г.

Дальнейшее чтение

[ редактировать ]- Мерфи, Кевин П. (2022). «Многообразное обучение» . Вероятностное машинное обучение . МТИ Пресс. стр. 682–699. ISBN 978-0-262-04682-4 .

Внешние ссылки

[ редактировать ]- Изомап

- Генеративное топографическое картографирование

- Диссертация Майка Типпинга

- Модель скрытой переменной гауссовского процесса

- Локально линейное вложение

- Карта реляционной перспективы

- Домашняя страница DD-HDS

- Домашняя страница RankVisu

- Краткий обзор Diffusion Maps

- Нелинейный PCA с помощью нейронных сетей автоэнкодера

![{\displaystyle t\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/31a5c18739ff04858eecc8fec2f53912c348e0e5)

![{\displaystyle \mathbf {X} =[x_{1},x_{2},\ldots ,x_{n}]\in \Omega \subset \mathbf {R^{D}} }](https://wikimedia.org/api/rest_v1/media/math/render/svg/27767b00cc5714632b393ff3d9173e6eece42867)