Гауссов процесс

В теории вероятностей и статистике гауссов процесс — это случайный процесс (набор случайных величин, индексированных по времени или пространству), такой, что каждый конечный набор этих случайных величин имеет многомерное нормальное распределение . Распределение гауссовского процесса — это совместное распределение всех этих (бесконечно многих) случайных величин и, как таковое, распределение по функциям с непрерывной областью определения, например, во времени или пространстве.

Концепция гауссовских процессов названа в честь Карла Фридриха Гаусса , поскольку в ее основе лежит понятие гауссовского распределения ( нормального распределения ). Гауссовские процессы можно рассматривать как бесконечномерное обобщение многомерных нормальных распределений.

Гауссовы процессы полезны в статистическом моделировании , поскольку они извлекают выгоду из свойств, унаследованных от нормального распределения. Например, если случайный процесс моделируется как гауссовский процесс, распределения различных производных величин можно получить явно. К таким величинам относятся среднее значение процесса за определенный период времени и ошибка оценки среднего значения с использованием выборочных значений за небольшой набор периодов времени. Хотя точные модели часто плохо масштабируются по мере увеличения объема данных, несколько методов аппроксимации было разработано , которые часто сохраняют хорошую точность, резко сокращая время вычислений.

Определение

[ редактировать ]Непрерывный во времени случайный процесс является гауссовым тогда и только тогда, когда для любого конечного индексов набора в наборе индексов

— многомерная гауссова случайная величина . [1] Это то же самое, что сказать, что каждая линейная комбинация имеет одномерное нормальное (или гауссово) распределение.

Используя характеристические функции случайных величин с обозначая мнимую единицу такую, что , свойство Гаусса можно сформулировать следующим образом: является гауссовым тогда и только тогда, когда для любого конечного набора индексов , есть действительные значения , с такая, что для всех имеет место равенство ,

или . Числа и Можно показать, что это ковариации и средние значения переменных в процессе. [2]

Дисперсия

[ редактировать ]Дисперсия гауссовского процесса конечна в любой момент времени. , формально [3] : с. 515

Стационарность

[ редактировать ]Для общих случайных процессов стационарность в строгом смысле подразумевает стационарность в широком смысле , но не каждый стационарный случайный процесс в широком смысле является стационарным в строгом смысле. Однако для гауссовского случайного процесса эти две концепции эквивалентны. [3] : с. 518

Гауссов случайный процесс является стационарным в строгом смысле тогда и только тогда, когда он стационарен в широком смысле.

Пример

[ редактировать ]Существует явное представление для стационарных гауссовских процессов. [4] Простой пример такого представления:

где и являются независимыми случайными величинами со стандартным нормальным распределением .

Ковариационные функции

[ редактировать ]Ключевым фактом гауссовских процессов является то, что они могут быть полностью определены их статистикой второго порядка. [5] Таким образом, если предполагается, что гауссовский процесс имеет нулевое среднее, определение функции ковариации полностью определяет поведение процесса. Важно отметить, что неотрицательная определенность этой функции позволяет ее спектральное разложение с использованием расширения Карунена-Лоэва . процесса Основными аспектами, которые можно определить с помощью ковариационной функции, являются стационарность , изотропность , гладкость и периодичность . [6] [7]

Стационарность относится к поведению процесса в отношении разделения любых двух точек. и . Если процесс стационарен, ковариационная функция зависит только от . Например, процесс Орнштейна–Уленбека стационарен.

Если процесс зависит только от , евклидово расстояние (не направление) между и , то процесс считается изотропным. считается процесс, одновременно стационарный и изотропный Однородным ; [8] на практике эти свойства отражают различия (вернее, их отсутствие) в поведении процесса в зависимости от местоположения наблюдателя.

В конечном итоге гауссовские процессы переводятся как принятие априорных значений функций, и гладкость этих априорных значений может быть вызвана функцией ковариации. [6] Если мы ожидаем, что для «близких» входных точек и соответствующие им выходные точки и быть также «рядом», то присутствует предположение о непрерывности. Если мы хотим учесть значительное смещение, мы можем выбрать более грубую ковариационную функцию. Крайними примерами такого поведения являются ковариационная функция Орнштейна – Уленбека и квадратичная экспонента, где первая никогда не дифференцируема, а вторая бесконечно дифференцируема.

Периодичность означает создание периодических закономерностей в поведении процесса. Формально это достигается путем отображения входных данных в двумерный вектор .

Обычные ковариационные функции

[ редактировать ]

Существует ряд общих ковариационных функций: [7]

- Постоянный :

- Линейный:

- белый гауссов шум:

- Квадратная экспонента:

- Орнштейн-Уленбек:

- Мать:

- Периодический:

- Рациональный квадратик:

Здесь . Параметр — характерный масштаб процесса (практически «насколько близко» две точки и должны существенно влиять друг на друга), это дельта Кронекера и стандартное отклонение шумовых флуктуаций. Более того, — Бесселя модифицированная функция порядка и гамма -функция оценивается при . Важно отметить, что сложную ковариационную функцию можно определить как линейную комбинацию других более простых ковариационных функций, чтобы учесть различные представления о имеющемся наборе данных.

Результаты вывода зависят от значений гиперпараметров. (например и ), определяющий поведение модели. Популярный выбор для состоит в том, чтобы обеспечить максимальные апостериорные его (MAP) оценки с некоторыми выбранными априорными значениями. Если априор очень близок к однородному, это то же самое, что максимизировать предельную вероятность процесса; маргинализация, выполняемая по наблюдаемым значениям процесса . [7] Этот подход также известен как метод максимального правдоподобия II , максимизация доказательств или эмпирический Байес . [9]

Непрерывность

[ редактировать ]Для гауссовского процесса непрерывность по вероятности эквивалентна среднеквадратической непрерывности , [10] : 145 и непрерывность с вероятностью единица эквивалентна непрерывности выборки . [11] :91 «Гауссовы процессы разрывны в фиксированных точках». Последнее предполагает, но не подразумевает, непрерывность вероятности.Непрерывность вероятности имеет место тогда и только тогда, когда среднее значение и автоковариация являются непрерывными функциями. Напротив, непрерывность выборки была сложной задачей даже для стационарных гауссовских процессов (как, вероятно, впервые заметил Андрей Колмогоров ), и еще более сложной задачей для более общих процессов. [12] : Секта. 2,8 [13] : 69, 81 [14] : 80 [15] Как обычно, под выборочным непрерывным процессом понимают процесс, допускающий выборочную непрерывную модификацию . [16] : 292 [17] : 424

Стационарный корпус

[ редактировать ]Для стационарного гауссовского процесса некоторые условия в его спектре достаточны для непрерывности образца, но не являются необходимыми. Необходимое и достаточное условие, иногда называемое теоремой Дадли – Фернике, включает функцию определяется (правая часть не зависит от из-за стационарности). Непрерывность по вероятности эквивалентно непрерывности в При сближении к (как ) слишком медленный, непрерывность выборки может потерпеть неудачу. Имеет значение сходимость следующих интегралов: эти два интеграла равны согласно интегрированию путем замены Первый подынтегральный оператор не обязательно должен быть ограничен как таким образом, интеграл может сходиться ( ) или расходятся ( ). Взяв для примера для больших то есть, для маленьких получается когда и когда В этих двух случаях функция увеличивается на но в целом это не так. Более того, условие

не следует из непрерывности и очевидные отношения (для всех ) и

Теорема Пусть 1. быть непрерывным и удовлетворять (*) . Тогда условие необходимо и достаточно для обеспечения непрерывности выборки

Немного истории. [17] : 424 Достаточность была объявлена Ксавье Ферником в 1964 году, но первое доказательство было опубликовано Ричардом М. Дадли в 1967 году. [16] : Теорема 7.1 Необходимость доказали Майкл Б. Маркус и Лоуренс Шепп в 1970 году. [18] : 380

Существуют образцы непрерывных процессов такой, что они нарушают условие (*) . Пример, найденный Маркусом и Шеппом [18] : 387 представляет собой случайный лакунарный ряд Фурье где являются независимыми случайными величинами со стандартным нормальным распределением ; частоты являются быстрорастущей последовательностью; и коэффициенты удовлетворить Последнее соотношение подразумевает

откуда почти наверняка, что почти наверняка обеспечивает равномерную сходимость ряда Фурье и выборочную непрерывность

Его автоковариационная функция нигде не монотонна (см. рисунок), как и соответствующая функция

Броуновское движение как интеграл гауссовских процессов

[ редактировать ]Винеровский процесс (также известный как броуновское движение) является интегралом обобщенного гауссовского процесса белого шума . Он не стационарен , но имеет стационарные приращения .

Процесс Орнштейна – Уленбека является стационарным гауссовским процессом.

Броуновский мост (как и процесс Орнштейна-Уленбека) является примером гауссовского процесса, приращения которого не являются независимыми .

Дробное броуновское движение — это гауссов процесс, ковариационная функция которого является обобщением функции винеровского процесса.

Закон нуля и единицы Дрисколла

[ редактировать ]Закон нуля и единицы Дрисколла - это результат, характеризующий выборочные функции, генерируемые гауссовским процессом.

Позволять быть гауссовским процессом со средним нулем с неотрицательно определенной ковариационной функцией . Позволять быть гильбертовым пространством с воспроизводящим ядром с положительно определенным ядром. .

Затем где и являются ковариационными матрицами всех возможных пар точки, подразумевает

Более того, подразумевает [19]

Это имеет важные последствия, когда , как

Таким образом, почти все выборочные пути гауссовского процесса со средним нулем и положительно определенным ядром будет лежать вне гильбертова пространства .

Гауссовы процессы с линейными ограничениями

[ редактировать ]Для многих представляющих интерес приложений уже имеются некоторые ранее существовавшие знания о рассматриваемой системе. Рассмотрим, например, случай, когда результат гауссовского процесса соответствует магнитному полю; здесь реальное магнитное поле ограничено уравнениями Максвелла, и был бы желателен способ включить это ограничение в формализм гауссовского процесса, поскольку это, вероятно, улучшит точность алгоритма.

Метод включения линейных ограничений в гауссовские процессы уже существует: [20]

Рассмотрим (векторную) выходную функцию который, как известно, подчиняется линейному ограничению (т.е. является линейным оператором) Тогда ограничение можно выполнить, выбрав , где моделируется как гауссовский процесс, и нахождение такой, что Данный и используя тот факт, что гауссовы процессы замкнуты относительно линейных преобразований, гауссов процесс для подчинение принуждению становится Следовательно, линейные ограничения могут быть закодированы в среднее значение и ковариационную функцию гауссовского процесса.

Приложения

[ редактировать ]

Гауссов процесс можно использовать в качестве априорного распределения вероятностей по функциям в байесовском выводе . [7] [22] Учитывая любой набор из N точек в желаемой области ваших функций, возьмите многомерный гауссиан , параметром ковариационной матрицы которого является матрица Грамма ваших N точек с некоторым желаемым ядром , и выполните выборку из этого гауссиана. Для решения задачи прогнозирования с несколькими выходами была разработана регрессия гауссовского процесса для векторной функции. В этом методе строится «большая» ковариация, описывающая корреляции между всеми входными и выходными переменными, взятыми в N точках в желаемой области. [23] Этот подход был подробно разработан для матричных гауссовских процессов и обобщен на процессы с «более тяжелыми хвостами», такие как процессы Стьюдента . [24]

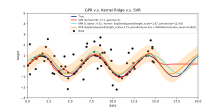

Вывод непрерывных значений с помощью предшествующего гауссовского процесса известен как регрессия гауссовского процесса или кригинг ; расширение регрессии гауссовского процесса на несколько целевых переменных известно как кокригинг . [25] Таким образом, гауссовские процессы полезны как мощный инструмент нелинейной многомерной интерполяции .

Гауссовы процессы также широко используются для решения задач численного анализа, таких как численное интегрирование, решение дифференциальных уравнений или оптимизация в области вероятностных чисел .

Гауссовские процессы также можно использовать, например, в контексте смешанных экспертных моделей. [26] [27] Основное обоснование такой структуры обучения состоит в предположении, что данное отображение не может быть хорошо отражено с помощью одной модели гауссовского процесса. Вместо этого пространство наблюдения разделено на подмножества, каждое из которых характеризуется своей функцией отображения; каждый из них изучается через различные компоненты гауссовского процесса в постулируемой смеси.

В естественных науках гауссовские процессы нашли применение в качестве вероятностных моделей астрономических временных рядов и в качестве предсказателей молекулярных свойств. [28]

Предсказание гауссовского процесса, или кригинг

[ редактировать ]

Когда речь идет об общей задаче регрессии гауссовского процесса (кригинг), предполагается, что для гауссовского процесса наблюдался в координатах , вектор значений — это всего лишь один образец из многомерного гауссовского распределения размерности, равной количеству наблюдаемых координат . Следовательно, в предположении распределения с нулевым средним , где — ковариационная матрица между всеми возможными парами для заданного набора гиперпараметров θ . [7] Таким образом, логарифмическая предельная вероятность равна:

и максимизация этой предельной вероятности в направлении θ обеспечивает полную спецификацию гауссова процесса f . Здесь можно кратко отметить, что первый член соответствует штрафному члену за неспособность модели соответствовать наблюдаемым значениям, а второй член - штрафному члену, который увеличивается пропорционально сложности модели. Указав θ , делаем прогнозы относительно ненаблюдаемых значений в координатах x * тогда остается только вопрос отбора выборок из прогнозируемого распределения где апостериорная средняя оценка A определяется как а апостериорная оценка дисперсии B определяется как: где — это ковариация между новой координатой оценки x * и всеми другими наблюдаемыми координатами x для данного вектора гиперпараметров θ , и определены, как и раньше, и — это дисперсия в точке x *, определяемая θ . Важно отметить, что практически апостериорная средняя оценка («точечная оценка») — это просто линейная комбинация наблюдений ; аналогичным образом дисперсия фактически не зависит от наблюдений . Известным узким местом в прогнозировании гауссовского процесса является то, что вычислительная сложность вывода и оценки правдоподобия кубична по числу точек | x |, и поэтому может стать невозможным для больших наборов данных. [6] Работы по разреженным гауссовским процессам, которые обычно основаны на идее построения репрезентативного множества для данного процесса f , пытаются обойти эту проблему. [29] [30] Метод кригинга можно использовать на скрытом уровне нелинейной модели смешанных эффектов для прогнозирования пространственных функций: этот метод называется скрытым кригингом. [31]

Часто ковариация имеет вид , где является параметром масштабирования. Примерами являются ковариационные функции класса Матерна. Если этот параметр масштабирования либо известна, либо неизвестна (т.е. должна быть маргинализирована), то апостериорная вероятность, , т.е. вероятность гиперпараметров задан набор пар данных наблюдений за и , допускает аналитическое выражение. [32]

Байесовские нейронные сети как гауссовские процессы

[ редактировать ]Байесовские нейронные сети — это особый тип байесовских сетей , который возникает в результате вероятностной обработки моделей глубокого обучения и искусственных нейронных сетей и назначения предварительного распределения их параметрам . Вычисления в искусственных нейронных сетях обычно организованы в последовательные слои искусственных нейронов . Количество нейронов в слое называется шириной слоя. По мере увеличения ширины слоя многие байесовские нейронные сети сводятся к гауссовскому процессу с композиционным ядром закрытой формы . Этот гауссов процесс называется гауссовским процессом нейронной сети (NNGP). [7] [33] [34] Он позволяет более эффективно оценивать прогнозы байесовских нейронных сетей и предоставляет аналитический инструмент для понимания глубокого обучения моделей .

Вычислительные проблемы

[ редактировать ]В практических приложениях модели гауссовских процессов часто оцениваются на сетке, приводящей к многомерным нормальным распределениям. Использование этих моделей для прогнозирования или оценки параметров с использованием максимального правдоподобия требует оценки многомерной гауссовской плотности, которая включает в себя вычисление определителя и обратной ковариационной матрицы. Обе эти операции имеют кубическую вычислительную сложность, что означает, что даже для сеток скромных размеров обе операции могут иметь непомерно высокие вычислительные затраты. Этот недостаток привел к развитию множества методов аппроксимации .

См. также

[ редактировать ]- Линейная статистика Байеса

- Байесовская интерпретация регуляризации

- Кригинг

- Гауссово свободное поле

- Процесс Гаусса – Маркова

- Градиентный кригинг (GEK)

- t-процесс Стьюдента

Ссылки

[ редактировать ]- ^ Маккей, Дэвид, Дж. К. (2003). Теория информации, вывод и алгоритмы обучения (PDF) . Издательство Кембриджского университета . п. 540. ИСБН 9780521642989 .

Распределение вероятностей функции является гауссовским процессом, если для любого конечного набора точек , плотность является гауссовым

{{cite book}}: CS1 maint: несколько имен: список авторов ( ссылка ) - ^ Дадли, РМ (1989). Реальный анализ и вероятность . Уодсворт и Брукс/Коул. ISBN 0-534-10050-3 .

- ^ Jump up to: Перейти обратно: а б Амос Лапидот (8 февраля 2017 г.). Фонд цифровых коммуникаций . Издательство Кембриджского университета. ISBN 978-1-107-17732-1 .

- ^ Кац, М.; Зигерт, AJF (1947). «Явное представление стационарного гауссова процесса» . Анналы математической статистики . 18 (3): 438–442. дои : 10.1214/aoms/1177730391 .

- ^ Бишоп, CM (2006). Распознавание образов и машинное обучение . Спрингер . ISBN 978-0-387-31073-2 .

- ^ Jump up to: Перейти обратно: а б с Барбер, Дэвид (2012). Байесовское рассуждение и машинное обучение . Издательство Кембриджского университета . ISBN 978-0-521-51814-7 .

- ^ Jump up to: Перейти обратно: а б с д и ж Расмуссен, CE; Уильямс, CKI (2006). Гауссовы процессы для машинного обучения . МТИ Пресс . ISBN 978-0-262-18253-9 .

- ^ Гриммет, Джеффри; Дэвид Стирзакер (2001). Вероятность и случайные процессы . Издательство Оксфордского университета . ISBN 978-0198572220 .

- ^ Сигер, Матиас (2004). «Гауссовы процессы для машинного обучения». Международный журнал нейронных систем . 14 (2): 69–104. CiteSeerX 10.1.1.71.1079 . дои : 10.1142/s0129065704001899 . ПМИД 15112367 . S2CID 52807317 .

- ^ Дадли, Р.М. (1975). «Гауссов процесс и подход к нему» (PDF) . Материалы Международного конгресса математиков . Том. 2. С. 143–146.

- ^ Дадли, РМ (2010). «Примерные функции гауссовского процесса» . Избранные произведения Р. М. Дадли . Том. 1. С. 66–103. дои : 10.1007/978-1-4419-5821-1_13 . ISBN 978-1-4419-5820-4 .

{{cite book}}:|journal=игнорируется ( помогите ) - ^ Талагранд, Мишель (2014). Верхние и нижние оценки случайных процессов: современные методы и классические задачи . Результаты математики и ее пограничные области. 3-я серия / Серия современных обзоров по математике. Спрингер, Гейдельберг. ISBN 978-3-642-54074-5 .

- ^ Леду, Мишель (1996), «Изопериметрия и гауссов анализ», Добрушин, Роланд; Грюнбум, Пит; Леду, Мишель (ред.), Лекции по теории вероятностей и статистике: Ecole d'Eté de Probabilités de Saint-Flour XXIV–1994 , Конспекты лекций по математике, том. 1648, Берлин: Springer, стр. 165–294, doi : 10.1007/BFb0095676 , ISBN. 978-3-540-62055-6 , МР 1600888

- ^ Адлер, Роберт Дж. (1990). Введение в непрерывность, экстремумы и смежные темы для общих гауссовских процессов . Том. 12. Хейворд, Калифорния: Институт математической статистики. ISBN 0-940600-17-Х . JSTOR 4355563 . МР 1088478 .

{{cite book}}:|journal=игнорируется ( помогите ) - ^ Берман, Симеон М. (1992). «Обзор: Адлер, 1990 г. «Введение в непрерывность...» ». Математические обзоры . МР 1088478 .

- ^ Jump up to: Перейти обратно: а б Дадли, РМ (1967). «Размеры компактов гильбертова пространства и непрерывность гауссовских процессов» . Журнал функционального анализа . 1 (3): 290–330. дои : 10.1016/0022-1236(67)90017-1 .

- ^ Jump up to: Перейти обратно: а б Маркус, МБ; Шепп, Лоуренс А. (1972). «Пример поведения гауссовских процессов» . Труды шестого симпозиума Беркли по математической статистике и вероятности, вып. II: теория вероятностей . Том. 6. Университет. Калифорния, Беркли. стр. 423–441.

- ^ Jump up to: Перейти обратно: а б Маркус, Майкл Б.; Шепп, Лоуренс А. (1970). «Непрерывность гауссовских процессов» . Труды Американского математического общества . 151 (2): 377–391. дои : 10.1090/s0002-9947-1970-0264749-1 . JSTOR 1995502 .

- ^ Дрисколл, Майкл Ф. (1973). «Воспроизводящее ядро структуры гильбертового пространства выборочных путей гауссовского процесса» . Журнал теории вероятностей и смежных областей . 26 (4): 309–316. дои : 10.1007/BF00534894 . ISSN 0044-3719 . S2CID 123348980 .

- ^ Джидлинг, Карл; Вальстрем, Никлас; Уиллс, Адриан; Шен, Томас Б. (19 сентября 2017 г.). «Линейно ограниченные гауссовские процессы». arXiv : 1703.00787 [ stat.ML ].

- ^ В документации scikit-learn также есть подобные примеры .

- ^ Лю, В.; Принсипи, JC; Хайкин, С. (2010). Адаптивная фильтрация ядра: подробное введение . Джон Уайли . ISBN 978-0-470-44753-6 . Архивировано из оригинала 4 марта 2016 г. Проверено 26 марта 2010 г.

- ^ Альварес, Маурисио А.; Росаско, Лоренцо; Лоуренс, Нил Д. (2012). «Ядра векторных функций: обзор» (PDF) . Основы и тенденции в машинном обучении . 4 (3): 195–266. дои : 10.1561/2200000036 . S2CID 456491 .

- ^ Чен, Цзэсюнь; Ван, Бо; Горбань, Александр Н. (2019). «Многомерная регрессия процессов Гаусса и Стьюдента для прогнозирования с несколькими выходами» . Нейронные вычисления и их приложения . 32 (8): 3005–3028. arXiv : 1703.04455 . дои : 10.1007/s00521-019-04687-8 .

- ^ Штейн, МЛ (1999). Интерполяция пространственных данных: некоторые теории кригинга . Спрингер .

- ^ Платаниос, Эммануил А.; Хацис, Сотириос П. (2014). «Условная гетероскедастичность гауссовой смеси процессов». Транзакции IEEE по анализу шаблонов и машинному интеллекту . 36 (5): 888–900. дои : 10.1109/TPAMI.2013.183 . ПМИД 26353224 . S2CID 10424638 .

- ^ Хацис, Сотириос П. (2013). «Модель гауссовского процесса со скрытой переменной с априорным процессом Питмана – Йора для многоклассовой классификации». Нейрокомпьютинг . 120 : 482–489. дои : 10.1016/j.neucom.2013.04.029 .

- ^ Гриффитс, Райан-Рис (2022). Применение гауссовских процессов на экстремальных масштабах длины: от молекул к черным дырам (кандидатская диссертация). Кембриджский университет. arXiv : 2303.14291 . дои : 10.17863/CAM.93643 .

- ^ Смола, Эй Джей; Шелькопф, Б. (2000). «Разреженная жадная матричная аппроксимация для машинного обучения». Материалы семнадцатой международной конференции по машинному обучению : 911–918. CiteSeerX 10.1.1.43.3153 .

- ^ Чато, Л.; Оппер, М. (2002). «Разреженные онлайн-гауссовские процессы». Нейронные вычисления . 14 (3): 641–668. CiteSeerX 10.1.1.335.9713 . дои : 10.1162/089976602317250933 . ПМИД 11860686 . S2CID 11375333 .

- ^ Ли, Се Юн; Маллик, Бани (2021). «Байесовское иерархическое моделирование: применение к результатам добычи в сланцах Игл Форд в Южном Техасе» . Санкхья Б. 84 : 1–43. дои : 10.1007/s13571-020-00245-8 .

- ^ Ранфтл, Саша; Мелито, Джан Марко; Бадели, Вахид; Рейнбахер-Кестингер, Алиса; Эллерманн, Катрин; фон дер Линден, Вольфганг (31 декабря 2019 г.). «Количественная оценка байесовской неопределенности с использованием данных разной точности и гауссовских процессов для импедансной кардиографии расслоения аорты» . Энтропия . 22 (1): 58. Бибкод : 2019Entrp..22...58R . дои : 10.3390/e22010058 . ISSN 1099-4300 . ПМЦ 7516489 . PMID 33285833 .

- ^ Новак, Роман; Сяо, Лечао; Хрон, Иржи; Ли, Джехун; Алеми, Александр А.; Золь-Дикштейн, Яша; Шенхольц, Сэмюэл С. (2020). «Нейронные касательные: быстрые и простые бесконечные нейронные сети в Python». Международная конференция по обучению представлений . arXiv : 1912.02803 .

- ^ Нил, Рэдфорд М. (2012). Байесовское обучение для нейронных сетей . Springer Science and Business Media.

Внешние ссылки

[ редактировать ]Литература

[ редактировать ]- Веб-сайт гауссовских процессов, включая текст книги Расмуссена и Уильямса «Гауссовы процессы для машинного обучения».

- Эбден, Марк (2015). «Гауссовы процессы: краткое введение». arXiv : 1505.02965 [ math.ST ].

- Обзор гауссовских случайных полей и корреляционных функций

- Эффективное обучение с подкреплением с использованием гауссовских процессов

Программное обеспечение

[ редактировать ]- GPML: комплексный набор инструментов Matlab для регрессии и классификации GP.

- STK: небольшой (Matlab/Octave) набор инструментов для моделирования кригинга и GP.

- Модуль Кригинга в среде UQLab (Matlab)

- CODES Toolbox: реализации кригинга, вариационного кригинга и моделей мультиточности (Matlab)

- Функция Matlab/Octave для стационарных гауссовских полей

- Yelp MOE — механизм оптимизации «черного ящика», использующий гауссово процесс обучения.

- ooDACE. Архивировано 9 августа 2020 г. на Wayback Machine — гибкий объектно-ориентированный набор инструментов Kriging Matlab.

- GPstuff — набор инструментов для гауссовских процессов для Matlab и Octave.

- GPy — структура гауссовских процессов на Python.

- GSTools — набор геостатистических инструментов, включая регрессию гауссовского процесса, написанный на Python.

- Интерактивная демонстрация регрессии гауссовского процесса

- Базовая библиотека гауссовских процессов, написанная на C++11.

- scikit-learn — библиотека машинного обучения для Python, которая включает регрессию и классификацию гауссовых процессов.

- [1] - Набор инструментов Кригинга (KriKit) разработан в Институте био- и геонаук 1 (IBG-1) Forschungszentrum Jülich (FZJ).

![{\displaystyle {\mathbb {E} }\left[\exp \left(i\sum _{\ell =1}^{k}s_{\ell }\,\mathbf {X} _{t_{\ell }}\right)\right]=\exp \left(-{\tfrac {1}{2}}\sum _{\ell ,j}\sigma _{\ell j}s_{\ell }s_{j }+i\sum _{\ell }\mu _{\ell }s_{\ell }\right),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bdb34f9f73060f65ce8450012831f2f32f0264b6)

![{\displaystyle {\mathbb {E}}\left[{\mathrm {e} }^{i\,\mathbf {s} \,(\mathbf {X} _{t}-\mathbf {\mu }) }\right]={\mathrm {e} }^{-\mathbf {s} \,\sigma \,\mathbf {s} /2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/97565415a502310350caf381b920a8bece43914d)

![{\displaystyle \operatorname {var} [X(t)]={\mathbb {E} }\left[\left|X(t)-\operatorname {E} [X(t)]\right|^{2 }\right]<\infty \quad {\text{для всех }}t\in T.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/66fc2c7877763c8da8ffd6a8b1276b477bddecec)

![{\displaystyle \sigma (h)={\sqrt {{\mathbb {E} }{\big [}X(t+h)-X(t){\big ]}^{2}}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/64ab58a38a47b0e6e16940be44327bb0ab0b957e)

![{\displaystyle [0,\varepsilon]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/09b79b1e11f2a6c9b36a919ddbbf91204fe7a1df)

![{\textstyle {\mathbb {E} }\sum _{n}c_{n}(|\xi _{n}|+|\eta _{n}|)=\sum _{n}c_{n} {\mathbb {E} }[|\xi _{n}|+|\eta _{n}|]={\text{const}}\cdot \sum _{n}c_{n}<\infty , }](https://wikimedia.org/api/rest_v1/media/math/render/svg/f2397aa6b5b6fe4708619c38b3098a7fb9b096d3)

![{\displaystyle {\mathbb {E} }[X_{t}X_{t+h}]=\sum _{n=1}^{\infty }c_{n}^{2}\cos \lambda _{ н}ч}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c74c4fe6d709650c8080cc792a2e3081ecc6456f)

![{\displaystyle \sigma (h)={\sqrt {2{\mathbb {E} }[X_{t}X_{t}]-2{\mathbb {E} }[X_{t}X_{t+h }]}}=2{\sqrt {\sum _{n=1}^{\infty }c_{n}^{2}\sin ^{2}{\frac {\lambda _{n}h}{ 2}}}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b2744f474eb0c2acec5b901987219b0955a7e121)

![{\displaystyle \lim _{n\to \infty }\operatorname {tr} [K_{n}R_{n}^{-1}]<\infty,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fc1d1379312a0e78525fce2f2e4404c8069abd48)

![{\displaystyle \Pr[f\in {\mathcal {H}}(R)]=1.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8c967b1fdbe5cdad6c678a7022bbfdd6a17901bb)

![{\displaystyle \lim _{n\to \infty }\operatorname {tr} [K_{n}R_{n}^{-1}]=\infty }](https://wikimedia.org/api/rest_v1/media/math/render/svg/e133d11ae8a4dc2825314c86ec4c86df1aabb0fe)

![{\displaystyle \Pr[f\in {\mathcal {H}}(R)]=0.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c3b6ef001cb269a0cbb38ff83d802da1ad908639)

![{\displaystyle \lim _ {n\to \infty }\operatorname {tr} [R_ {n}R_ {n}^{-1}] = \lim _ {n\to \infty } \operatorname {tr} [ I]=\lim _{n\to \infty }n=\infty .}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1ecb16aa9321bb328f2529628314558edb19b482)