Условная вероятность

| Часть серии по статистике. |

| Теория вероятностей |

|---|

|

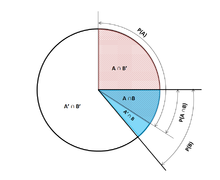

В теории вероятностей условная вероятность — это мера вероятности при возникновения события условии, что уже известно, что другое событие (по предположению, презумпции, утверждению или свидетельству) произошло. [1] Этот конкретный метод основан на том, что событие A происходит в некоторой связи с другим событием B. В этой ситуации событие A можно проанализировать с помощью условной вероятности относительно B. Если интересующее событие — это A , а событие B известно или предполагается, что оно произошло, «условная вероятность A при условии B » или «вероятность A при условии B » обычно записывается как P( A | B ) [2] или иногда P B ( A ) . Это также можно понимать как долю вероятности B, которая пересекается с A, или отношение вероятностей обоих событий к случаю «данного» события (сколько раз происходит A, а не не предполагается, что B произошло): . [3]

Например, вероятность того, что у какого-либо человека в любой день будет кашель, может составлять всего 5%. Но если мы знаем или предполагаем, что человек болен, то вероятность того, что он будет кашлять, гораздо выше. Например, условная вероятность того, что кто-то нездоров (больной) кашляет, может составлять 75%, и в этом случае мы будем иметь P(Кашель) = 5% и P(Кашель | Больной) = 75%. Хотя в этом примере существует связь между A и B , такая связь или зависимость между A и B не является обязательной, и они не должны возникать одновременно.

P( A | B ) равным P( A ) , т. е. безусловной вероятности или абсолютной вероятности A может быть равным или не . Если P( A | B ) = P( A ) , то события A и B называются независимыми : в таком случае знание о любом событии не меняет вероятность друг друга. P( A | B ) (условная вероятность A при условии B ) обычно отличается от P( B | A ) . Например, если у человека лихорадка денге , вероятность того, что у него будет положительный результат теста на это заболевание, может составлять 90%. В этом случае измеряется то, что если событие B ( заболевание лихорадкой денге ) произошло, вероятность события A ( проверенного как положительное ) при условии, что произошло событие B, составляет 90%, просто записывая P( A | B ) = 90%. С другой стороны, если у человека положительный результат теста на лихорадку денге, у него может быть только 15% вероятность того, что он действительно заболеет этим редким заболеванием из-за высокого уровня ложноположительных результатов . В этом случае вероятность события B ( заболевание лихорадкой денге ) при условии, что событие A ( положительный результат теста ) произошло, составляет 15% или P( B | A ) = 15%. Теперь должно быть очевидно, что ошибочное приравнивание двух вероятностей может привести к различным ошибкам в рассуждениях, что обычно проявляется в ошибки базовой ставки .

Хотя условные вероятности могут предоставить чрезвычайно полезную информацию, часто предоставляется или находится под рукой ограниченная информация. Поэтому может быть полезно обратить вспять или преобразовать условную вероятность с помощью теоремы Байеса : . [4] Другой вариант — отобразить условные вероятности в таблице условных вероятностей, чтобы пролить свет на взаимосвязь между событиями.

Определение

[ редактировать ]

Кондиционирование по событию

[ редактировать ]Колмогоровское определение

[ редактировать ]Учитывая два события A и B из сигма-поля вероятностного пространства, при этом безусловная вероятность B B больше нуля (т. е. P( B ) > 0) , условная вероятность A условии при ( ) — вероятность того, что событие A произойдет, если событие B произошло или предполагается, что событие произошло. [5] Предполагается, что A представляет собой набор всех возможных результатов эксперимента или случайного исследования с ограниченным или сокращенным пространством выборки. Условную вероятность можно найти как частное вероятности совместного пересечения событий А и В , то есть, , вероятность того, что и B встречаются вместе, и вероятность B A : [2] [6] [7]

- .

Для выборочного пространства, состоящего из исходов с равной вероятностью, вероятность события А понимается как отношение числа исходов в А к числу всех исходов в выборочном пространстве. Тогда под этим уравнением понимается доля множества множеству Б. к Обратите внимание, что приведенное выше уравнение является определением, а не просто теоретическим результатом. Обозначим величину как и назовем это «условной вероятностью А при условии В ».

Как аксиома вероятности

[ редактировать ]Некоторые авторы, например де Финетти , предпочитают вводить условную вероятность как аксиому вероятности :

- .

Это уравнение для условной вероятности, хотя оно и эквивалентно математически, интуитивно может быть проще для понимания. Его можно интерпретировать как «вероятность возникновения B , умноженная на вероятность возникновения A , при условии, что B произошло, равна вероятности возникновения A и B вместе, хотя и не обязательно произойдет в одно и то же время». Кроме того, это может быть предпочтительным с философской точки зрения; Согласно основным интерпретациям вероятности , таким как субъективная теория , условная вероятность считается примитивной сущностью. Более того, это «правило умножения» может оказаться практически полезным при вычислении вероятности и вводит симметрию с аксиомой суммирования для формулы Пуанкаре:

- Таким образом, уравнения можно объединить, чтобы найти новое представление:

Как вероятность условного события

[ редактировать ]Условную вероятность можно определить как вероятность условного события. . Условное событие Гудмана -Нгуена-Ван Фраассена можно определить как:

- , где и представляют состояния или элементы A или B. [8]

Можно показать, что

что соответствует определению условной вероятности Колмогорова. [9]

Обусловливание событием с нулевой вероятностью

[ редактировать ]Если , то по определению является неопределенным .

Наибольший интерес представляет случай случайной величины Y , обусловленной непрерывной случайной величиной X, приводящей к определенному результату x . Событие имеет нулевую вероятность и, как таковая, не может быть обусловлена.

Вместо того, чтобы обуславливать X равным точно x , мы могли бы поставить условие, что оно ближе, чем расстояние. вдали от х . Событие обычно будет иметь ненулевую вероятность и, следовательно, может быть обусловлено.Тогда мы можем взять предел

| ( 1 ) |

Например, если две непрерывные случайные величины X и Y имеют общую плотность , то по правилу Лопиталя и интегральному правилу Лейбница при дифференцировании по :

Результирующий предел представляет собой условное распределение вероятностей при Y условии X и существует, когда знаменатель, плотность вероятности , является строго положительным.

Соблазнительно определить неопределенную вероятность используя предел ( 1 ), но это невозможно сделать последовательным образом. В частности, можно найти случайные величины X и W и значения x , w такие, что события и идентичны, но результирующие пределы не являются:

Парадокс Бореля-Колмогорова демонстрирует это с помощью геометрического аргумента.

Условие на дискретной случайной величине

[ редактировать ]Пусть X — дискретная случайная величина, а ее возможные результаты обозначаются V . Например, если X представляет значение брошенной игральной кости, то V — это множество . Предположим для наглядности, что X — дискретная случайная величина, так что каждое значение в V имеет ненулевую вероятность.

Для значения x в V и события A условная вероятностьдается .Письмо

короче, мы видим, что это функция двух переменных x и A. :

Для фиксированного A мы можем сформировать случайную величину . Он представляет собой результат значение x из X. всякий раз, когда наблюдается

Таким образом, условную вероятность A при условии X можно рассматривать как случайную величину Y с результатами в интервале . По закону полной вероятности равно безусловной вероятности А. его ожидаемое значение

Частичная условная вероятность

[ редактировать ]Частичная условная вероятность речь идет о вероятности события учитывая, что каждое из событий условия произошло в какой-то степени (степень веры, степень опыта), которая может отличаться от 100%. С точки зрения частотности, частичная условная вероятность имеет смысл, если условия проверяются в повторениях эксперимента соответствующей длины. . [10] Такой -ограниченную частичную условную вероятность можно определить как условно ожидаемое среднее возникновение события. на стендах длиной которые соответствуют всем характеристикам вероятности , то есть:

Исходя из этого, частичную условную вероятность можно определить как

где [10]

Условность Джеффри [11] [12] является особым случаем частичной условной вероятности, в которой события условия должны образовывать раздел :

Пример

[ редактировать ]Предположим, что кто-то тайно бросает два справедливых шестигранных игральных кубика , и мы хотим вычислить вероятность того, что выпавшее на лицевой стороне первое из них будет равно 2, учитывая информацию о том, что их сумма не превышает 5.

- Пусть D 1 — значение, выпавшее на игральной кости 1.

- Пусть D 2 — значение, выпавшее на игральной кости 2.

Вероятность того, что D 1 = 2

В таблице 1 показано выборочное пространство из 36 комбинаций выпавших значений двух игральных костей, каждая из которых встречается с вероятностью 1/36, при этом числа, отображаемые в красных и темно-серых ячейках, равны D 1 + D 2 .

D 1 = 2 ровно в 6 из 36 исходов; таким образом, P ( D 1 = 2) = 6 ⁄ 36 = 1 ⁄ 6 :

Таблица 1 + DД2 1 2 3 4 5 6 Д 1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

Вероятность того, что D 1 + D 2 ≤ 5

Таблица 2 показывает, что D 1 + D 2 ≤ 5 ровно для 10 из 36 исходов, таким образом, P ( D 1 + D 2 ≤ 5) = 10 ⁄ 36 :

Таблица 2 + DД2 1 2 3 4 5 6 Д 1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

Вероятность того, что D 1 = 2 при условии, что D 1 + D 2 ≤ 5

Таблица 3 показывает, что для 3 из этих 10 исходов D 1 = 2.

Таким образом, условная вероятность P( D 1 = 2 | D 1 + D 2 ≤ 5) = 3 ⁄ 10 = 0.3:

Таблица 3 + DД2 1 2 3 4 5 6 Д 1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

Здесь, в более ранних обозначениях определения условной вероятности, обусловливающее событие B — это D 1 + D 2 ≤ 5, а событие A — это D 1 = 2. Мы имеем как видно в таблице.

Использование в выводе

[ редактировать ]В статистическом выводе условная вероятность — это обновление вероятности события на основе новой информации. [13] Новая информация может быть включена следующим образом: [1]

- Пусть A , интересующее событие, находится в выборочном пространстве , скажем ( X , P ).

- Возникновение события A, зная, что событие B произошло или произойдет, означает возникновение A, поскольку оно ограничено B , т.е. .

- Без знания о возникновении B информация о возникновении A была бы просто P ( A )

- Вероятность того, что А знает, что событие Б произошло или произойдет, будет вероятностью относительно P ( B ) — вероятность того, что событие B произошло.

- Это приводит к всякий раз, когда P ( B ) > 0 и 0 в противном случае.

В результате этого подхода получается вероятностная мера, согласующаяся с исходной вероятностной мерой и удовлетворяющая всем аксиомам Колмогорова . Эта условная вероятностная мера также могла бы возникнуть в результате предположения, что относительная величина вероятности A по отношению к X будет сохранена по отношению к B (см. Формальный вывод ниже).

Слова «доказательства» или «информация» обычно используются в байесовской интерпретации вероятности . Обусловливающее событие интерпретируется как свидетельство обусловленного события. То есть P ( A ) — это вероятность A до учета свидетельства E , а P ( A | E ) — это вероятность A после учета свидетельств E или после обновления P ( A ). Это согласуется с частотной интерпретацией, которая является первым определением, данным выше.

Пример

[ редактировать ]При передаче кода Морзе существует определенная вероятность того, что полученная «точка» или «тире» окажется ошибочной. Зачастую это воспринимается как вмешательство в передачу сообщения. Поэтому важно при отправке «точки» учитывать, например, вероятность того, что «точка» была получена. Это представлено: В азбуке Морзе соотношение точек и тире в момент отправки составляет 3:4, поэтому вероятность появления «точки» и «тире» равна . Если предположить, что вероятность того, что точка будет передана как тире, равна 1/10, а вероятность того, что тире будет передана как точка, также равна 1/10, то для расчета можно использовать правило Байеса. .

Сейчас, можно рассчитать:

Статистическая независимость

[ редактировать ]События A и B считаются статистически независимыми , если вероятность пересечения A и B равна произведению вероятностей A и B:

Если P ( B ) не равно нулю, то это эквивалентно утверждению, что

Аналогично, если P ( A ) не равно нулю, то

также эквивалентно. поскольку условные вероятности могут быть неопределенными, а предпочтительное определение симметрично относительно A и B. Хотя производные формы могут показаться более интуитивными, они не являются предпочтительным определением , Независимость не относится к непересекающемуся событию. [15]

Следует также отметить, что для пары независимых событий [AB] и события C пара определяется как условно независимая, если произведение истинно: [16]

Эта теорема может быть полезна в приложениях, где наблюдается множество независимых событий.

Независимые события против взаимоисключающих событий

Понятия взаимонезависимых событий и взаимоисключающих событий являются отдельными и различными. В следующей таблице сравниваются результаты для двух случаев (при условии, что вероятность события кондиционирования не равна нулю).

| Если статистически независимы | Если взаимоисключающие | |

|---|---|---|

| 0 | ||

| 0 | ||

| 0 |

В действительности взаимоисключающие события не могут быть статистически независимыми (если только оба они невозможны), поскольку знание о том, что одно происходит, дает информацию о другом (в частности, о том, что последнее заведомо не произойдет).

Распространенные заблуждения

[ редактировать ]- Эти заблуждения не следует путать с «условной ошибкой» Роберта К. Шопа 1978 года , в которой рассматриваются контрфактические примеры, вызывающие вопросы .

Предполагая, что условная вероятность имеет размер, аналогичный ее обратной величине.

[ редактировать ]

В общем случае нельзя предполагать, что P ( A | B ) ≈ P ( B | A ). Это может быть коварной ошибкой даже для тех, кто хорошо знаком со статистикой. [17] Связь между P ( A | B ) и P ( B | A ) определяется теоремой Байеса :

То есть P( A | B ) ≈ P( B | A ) только в том случае, если P ( B )/ P ( A ) ≈ 1 или, что то же самое, P ( A ) ≈ P ( B ).

Предполагая, что предельные и условные вероятности имеют одинаковый размер.

[ редактировать ]В общем случае нельзя предполагать, что P ( A ) ≈ P ( A | B ). Эти вероятности связаны законом полной вероятности :

где события счетное разбиение образуют .

Эта ошибка может возникнуть из-за предвзятости отбора . [18] Например, в контексте медицинского заявления пусть SC последствие будет событием, когда ( хроническое заболевание) S возникает вследствие обстоятельства (острое состояние C. ) Пусть H — событие, когда человек обращается за медицинской помощью. Предположим, что в большинстве случаев C не вызывает S (так что P ( SC ) низкое). Предположим также, что за медицинской помощью обращаются только в том случае, если произошло из-за C. S Поэтому, исходя из опыта пациентов, врач может ошибочно заключить, что ( SC ) P высокое. Фактическая вероятность, наблюдаемая врачом, равна ( SC | P H ) .

Избыточный или недостаточный вес априорных показателей

[ редактировать ]Частичный или полный неучет априорной вероятности называется пренебрежением базовой ставкой . Обратная ситуация – недостаточная корректировка априорной вероятности – это консерватизм .

Формальный вывод

[ редактировать ]Формально P ( A | B ) определяется как вероятность A в соответствии с новой функцией вероятности в выборочном пространстве, такая, что результаты, не входящие в B, имеют вероятность 0 и согласуются со всеми исходными вероятностными мерами . [19] [20]

Пусть Ω — дискретное выборочное пространство с элементарными событиями { ω }, и пусть P — вероятностная мера относительно σ-алгебры Ω. Предположим, нам сообщили, что событие B ⊆ Ω произошло. Чтобы отразить это, новое распределение вероятностей (обозначенное условным обозначением) должно быть назначено { ω }. Все события, которых нет в B, будут иметь нулевую вероятность в новом распределении. Для событий в B должны соблюдаться два условия: вероятность B равна единице и относительные величины вероятностей должны сохраняться. Первое требуется аксиомами вероятности , а второе вытекает из того факта, что новая вероятностная мера должна быть аналогом P , в котором вероятность B равна единице - и поэтому каждое событие, которое не находится в B , имеет нулевая вероятность. Следовательно, для некоторого масштабного коэффициента α новое распределение должно удовлетворять:

Подставляя 1 и 2 в 3, чтобы выбрать α :

Итак, новое вероятностей распределение

Теперь об общем событии А :

См. также

[ редактировать ]- Теорема Байеса

- Байесовская эпистемология

- Парадокс Бореля – Колмогорова

- Цепное правило (вероятность)

- Вероятность членства в классе

- Условная независимость

- Условное распределение вероятностей

- Обусловливание (вероятность)

- Теорема о дезинтеграции

- Совместное распределение вероятностей

- Проблема Монти Холла

- Попарно независимое распределение

- Апостериорная вероятность

- Постотбор

- Регулярная условная вероятность

Ссылки

[ редактировать ]- ^ Перейти обратно: а б Гут, Аллан (2013). Вероятность: аспирантура (второе изд.). Нью-Йорк, штат Нью-Йорк: Спрингер. ISBN 978-1-4614-4707-8 .

- ^ Перейти обратно: а б «Условная вероятность» . www.mathsisfun.com . Проверено 11 сентября 2020 г.

- ^ Декинг, Фредерик Мишель; Краайкамп, Корнелис; Лопухаа, Хендрик Пауль; Местер, Людольф Эрвин (2005). «Современное введение в теорию вероятности и статистику » Тексты Спрингера в статистике : 26. doi : 10.1007/1-84628-168-7 . ISBN 978-1-85233-896-1 . ISSN 1431-875X .

- ^ Декинг, Фредерик Мишель; Краайкамп, Корнелис; Лопухаа, Хендрик Пауль; Местер, Людольф Эрвин (2005). «Современное введение в теорию вероятности и статистику » Тексты Спрингера в статистике : 25–40. дои : 10.1007/ 1-84628-168-7 ISBN 978-1-85233-896-1 . ISSN 1431-875X .

- ^ Райхл, Линда Элизабет (2016). «2.3 Вероятность». Современный курс статистической физики (4-е исправленное и обновленное изд.). ВИЛИ-ВЧ. ISBN 978-3-527-69049-7 .

- ^ Колмогоров, Андрей (1956), Основы теории вероятностей , Челси.

- ^ «Условная вероятность» . www.stat.yale.edu . Проверено 11 сентября 2020 г.

- ^ Фламинио, Томмазо; Годо, Луис; Хосни, Хайкел (01 сентября 2020 г.). «Бульевы алгебры кондиционалов, вероятностей и логики» . Искусственный интеллект . 286 : 103347. arXiv : 2006.04673 . дои : 10.1016/j.artint.2020.103347 . ISSN 0004-3702 . S2CID 214584872 .

- ^ Ван Фраассен, Бас К. (1976), Харпер, Уильям Л.; Хукер, Клиффорд Алан (ред.), «Вероятности кондиционалов» , «Основы теории вероятностей, статистических выводов и статистических теорий науки: Том I. Основы и философия эпистемических применений теории вероятностей» , Серия Университета Западного Онтарио по философии Наука, Дордрехт: Springer Нидерланды, стр. 261–308, номер документа : 10.1007/978-94-010-1853-1_10 , ISBN. 978-94-010-1853-1 , получено 4 декабря 2021 г.

- ^ Перейти обратно: а б с Драхейм, Дирк (2017). «Обобщенная кондиционализация Джеффри (частая семантика частичной кондиционализации)» . Спрингер . Проверено 19 декабря 2017 г.

- ^ Джеффри, Ричард К. (1983), Логика решения, 2-е издание , University of Chicago Press, ISBN 9780226395821

- ^ «Байесовская эпистемология» . Стэнфордская энциклопедия философии. 2017 . Проверено 29 декабря 2017 г.

- ^ Казелла, Джордж; Бергер, Роджер Л. (2002). Статистический вывод . Даксбери Пресс. ISBN 0-534-24312-6 .

- ^ «Условная вероятность и независимость» (PDF) . Проверено 22 декабря 2021 г.

- ^ Таймс, Хенк (2012). Понимание вероятности (3-е изд.). Кембридж: Издательство Кембриджского университета. дои : 10.1017/cbo9781139206990 . ISBN 978-1-107-65856-1 .

- ^ Пфайффер, Пол Э. (1978). Условная независимость в прикладной теории вероятности . Бостон, Массачусетс: Биркхойзер Бостон. ISBN 978-1-4612-6335-7 . OCLC 858880328 .

- ^ Паулос, Дж. А. (1988) Неумение считать: математическая неграмотность и ее последствия , Хилл и Ван. ISBN 0-8090-7447-8 (стр. 63 и далее )

- ^ Ф. Томас Брюсс Эффект Вятта-Эрпа или соблазнительная сила малых вероятностей (на немецком языке), Spectrum of Science (немецкое издание журнала Scientific American), Том 2, 110–113, (2007).

- ^ Джордж Казелла и Роджер Л. Бергер (1990), Статистический вывод , Duxbury Press, ISBN 0-534-11958-1 (стр. 18 и далее )

- ^ Введение Гринстеда и Снелла в вероятность , с. 134

![{\displaystyle [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/738f7d23bb2d9642bab520020873cccbef49768d)

![{\displaystyle {\begin{aligned}1&=\sum _ {\omega \in \Omega }{P(\omega \mid B)}\\&=\sum _{\omega \in B}{P(\ omega \mid B)}+{\cancelto {0}{\sum _{\omega \notin B}P(\omega \mid B)}}\\&=\alpha \sum _{\omega \in B} {P(\omega )}\\[5pt]&=\alpha \cdot P(B)\\[5pt]\Rightarrow \alpha &={\frac {1}{P(B)}}\end{aligned }}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bc21b49c38af5566aeb4794016be9ee06b40458c)

![{\displaystyle {\begin{aligned}P(A\mid B)&=\sum _ {\omega \in A\cap B}{P(\omega \mid B)}+{\cancelto {0}{\ sum _ {\omega \in A\cap B^{c}}P(\omega \mid B)}}\\&=\sum _{\omega \in A\cap B}{\frac {P(\ omega )}{P(B)}}\\[5pt]&={\frac {P(A\cap B)}{P(B)}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4f6e98f9200e5cf74a15231fc3c753ccfeb8d1c6)