Катастрофическое вмешательство

| Часть серии о |

| Машинное обучение и интеллектуальный анализ данных |

|---|

Эту статью необходимо обновить . ( май 2024 г. ) |

Катастрофическое вмешательство , также известное как катастрофическое забывание , — это тенденция искусственной нейронной сети резко и резко забывать ранее полученную информацию при изучении новой информации. [1] [2]

Нейронные сети являются важной частью коннекционистского подхода к когнитивной науке . Проблема катастрофического вмешательства при моделировании человеческой памяти с помощью коннекционистских моделей первоначально была привлечена к вниманию научного сообщества в результате исследования Макклоски и Коэна (1989): [1] и Рэтклифф (1990). [2] Это радикальное проявление дилеммы «чувствительность-стабильность». [3] или дилемма «стабильность-пластичность». [4] В частности, эти проблемы относятся к задаче создания искусственной нейронной сети, чувствительной к новой информации, но не разрушаемой ею.

Справочные таблицы и коннекционистские сети лежат на противоположных сторонах спектра стабильности и пластичности. [5] Первый остается полностью стабильным при наличии новой информации, но ему не хватает способности обобщать , то есть выводить общие принципы, на основе новых входных данных. С другой стороны, коннекционистские сети, такие как стандартная сеть обратного распространения ошибки, могут обобщать невидимые входные данные, но они чувствительны к новой информации. Модели обратного распространения ошибки можно сравнить с человеческой памятью , поскольку они обладают схожей способностью обобщать результаты. [ нужна ссылка ] , но эти сети часто демонстрируют меньшую стабильность, чем человеческая память. Примечательно, что эти сети обратного распространения ошибки подвержены катастрофическим помехам. Это проблема при моделировании человеческой памяти, поскольку в отличие от этих сетей люди обычно не демонстрируют катастрофического забывания. [6]

История катастрофического вмешательства

[ редактировать ]Термин «катастрофическое вмешательство» первоначально был придуман Макклоски и Коэном (1989), но также был доведен до сведения научного сообщества благодаря исследованиям Рэтклиффа (1990). [2]

Проблема последовательного обучения : Макклоски и Коэн (1989).

[ редактировать ]Макклоски и Коэн (1989) отметили проблему катастрофических помех во время двух разных экспериментов по моделированию нейронных сетей обратного распространения ошибки.

- Эксперимент 1. Изучение фактов сложения единиц и двоек.

В своем первом эксперименте они обучали стандартную нейронную сеть обратного распространения ошибки на одном обучающем наборе, состоящем из 17 однозначных задач (т. е. от 1 + 1 до 9 + 1 и от 1 + 2 до 1 + 9), пока сеть не могла представлять и правильно реагировать на все из них. Ошибка между фактическим и желаемым результатом неуклонно снижалась в ходе сеансов обучения, что отражало то, что сеть научилась лучше представлять целевые результаты в ходе испытаний. Затем они обучали сеть на одном обучающем наборе, состоящем из 17 задач с однозначными двойками (т. е. от 2 + 1 до 2 + 9 и от 1 + 2 до 9 + 2), пока сеть не могла представлять и правильно реагировать на все их. Они отметили, что их процедура аналогична тому, как ребенок изучает факты сложения. После каждой попытки обучения по двойкам фактов сеть проверялась на знание фактов сложения как единиц, так и двойок. Как и один факт, два факта были легко изучены сетью. Однако Макклоски и Коэн отметили, что сеть больше не может должным образом решать задачи на сложение единиц даже после одного обучающего испытания задач на сложение двойок. Шаблон вывода, созданный в ответ на эти факты, часто больше напоминал шаблон вывода для неправильного числа, чем шаблон вывода для правильного числа. Считается, что это серьезная ошибка. Более того, задачи 2+1 и 2+1, которые были включены в оба обучающих набора, даже продемонстрировали резкие нарушения во время первых испытаний на изучение двух фактов.

- Эксперимент 2: повторение исследования Барнса и Андервуда (1959). [7]

В своей второй коннекционистской модели Макклоски и Коэн попытались повторить исследование Барнса и Андервуда (1959) о ретроактивном вмешательстве в организм человека. Они обучили модель на списках AB и AC и использовали шаблон контекста во входном векторе (входной шаблон), чтобы различать списки. В частности, сеть была обучена реагировать правильным ответом B на показ стимула A и контекстного шаблона AB и реагировать правильным ответом C на показ стимула A и контекстного шаблона AC. Когда модель обучалась одновременно на элементах AB и AC, сеть легко правильно запоминала все ассоциации. При последовательном обучении сначала обучался список AB, а затем список AC. После каждого представления списка AC оценивалась эффективность как списков AB, так и AC. Они обнаружили, что объем обучения в списке AC в исследовании Барнса и Андервуда, который приводит к 50% правильных ответов, приводит к почти 0% правильных ответов сети обратного распространения ошибки. Кроме того, они обнаружили, что сеть имела тенденцию показывать ответы, похожие на шаблон ответа C, когда сети предлагалось дать шаблон ответа B. Это указывало на то, что список AC, очевидно, перезаписал список AB. Это можно сравнить с изучением слова «собака», после которого следует выучить слово «табурет», а затем обнаружить, что вы думаете о слове «табурет», когда вам встречается слово «собака».

Макклоски и Коэн попытались уменьшить помехи с помощью ряда манипуляций, включая изменение количества скрытых единиц, изменение значения параметра скорости обучения, переобучение в списке AB, замораживание определенных весов соединений, изменение целевых значений 0 и 1 вместо 0,1 и 0,9. . Однако ни одна из этих манипуляций не привела к удовлетворительному уменьшению катастрофических помех, создаваемых сетями.

В целом Макклоски и Коэн (1989) пришли к следующему выводу:

- по крайней мере, некоторое вмешательство будет происходить всякий раз, когда новое обучение изменяет веса, представляющие

- чем больше объем новых знаний, тем сильнее разрушение старых знаний

- помехи были катастрофическими в сетях обратного распространения ошибки, когда обучение было последовательным, а не одновременным.

Ограничения, налагаемые функциями обучения и забывания : Рэтклифф (1990).

[ редактировать ]Рэтклифф (1990) использовал несколько наборов моделей обратного распространения ошибки, примененных к стандартным процедурам распознавания памяти, в которых элементы изучались последовательно. [2] Изучив модели эффективности распознавания, он обнаружил две основные проблемы:

- Хорошо изученная информация катастрофически забывалась по мере того, как новая информация усваивалась как в малых, так и в больших сетях обратного распространения ошибки.

Даже одна попытка обучения с новой информацией привела к значительной потере старой информации, что соответствует выводам Макклоски и Коэна (1989). [1] Рэтклифф также обнаружил, что полученные результаты часто представляли собой смесь предыдущего и нового входных данных. В более крупных сетях элементы, изученные в группах (например, AB, затем CD), были более устойчивы к забыванию, чем элементы, изученные по отдельности (например, A, затем B, затем C...). Однако забывание предметов, изученных в группах, по-прежнему было значительным. Добавление в сеть новых скрытых объектов не уменьшило помех.

- Дискриминация между изучаемыми объектами и ранее невидимыми объектами уменьшалась по мере того, как сеть узнавала больше.

Этот вывод противоречит исследованиям человеческой памяти, которые показали, что дискриминация усиливается по мере обучения. Рэтклифф попытался облегчить эту проблему, добавив «узлы ответа», которые выборочно реагировали бы на старые и новые входные данные. Однако этот метод не сработал, поскольку эти узлы ответа стали активными для всех входов. Модель, в которой использовался шаблон контекста, также не смогла улучшить различение новых и старых элементов.

Предлагаемые решения

[ редактировать ]Основной причиной катастрофических помех, по-видимому, является перекрытие представлений на скрытом уровне распределенных нейронных сетей. [8] [9] [10] В распределенном представлении каждый вход имеет тенденцию создавать изменения в весах многих узлов. Катастрофическое забывание происходит потому, что при изменении многих весов, в которых «хранятся знания», предварительные знания вряд ли останутся нетронутыми. Во время последовательного обучения входные данные смешиваются: новые входные данные накладываются поверх старых. [9] Другой способ концептуализировать это — представить обучение как движение через весовое пространство. [11] Это весовое пространство можно сравнить с пространственным представлением всех возможных комбинаций весов, которыми может обладать сеть. Когда сеть впервые учится представлять набор шаблонов, она находит точку в весовом пространстве, которая позволяет ей распознавать все эти шаблоны. [10] Однако когда сеть затем изучает новый набор шаблонов, она переместится в такое место в весовом пространстве, единственной заботой которого является распознавание новых шаблонов. [10] Чтобы распознать оба набора шаблонов, сеть должна найти место в весовом пространстве, подходящее для распознавания как новых, так и старых шаблонов.

Ниже приведен ряд методов, которые имеют эмпирическую поддержку в успешном уменьшении катастрофических помех в нейронных сетях обратного распространения ошибки:

Ортогональность

[ редактировать ]либо входных векторов, либо шаблонов активации скрытых единиц. Многие из ранних методов уменьшения перекрытия репрезентаций включали в себя ортогональность [ сломанный якорь ] друг другу. Левандовски и Ли (1995) [12] отметили, что интерференция между последовательно изучаемыми шаблонами сводится к минимуму, если входные векторы ортогональны друг другу. Говорят, что входные векторы ортогональны друг другу, если попарное произведение их элементов на два вектора в сумме равно нулю. Например, шаблоны [0,0,1,0] и [0,1,0,0] называются ортогональными, потому что (0×0 + 0×1 + 1×0 + 0×0) = 0. Один из методов создания ортогональных представлений на скрытых слоях включает биполярное кодирование признаков (т. е. кодирование с использованием -1 и 1, а не 0 и 1). [10] Ортогональные шаблоны имеют тенденцию создавать меньше помех друг другу. Однако не все проблемы обучения могут быть представлены с использованием этих типов векторов, и некоторые исследования показывают, что степень взаимодействия с ортогональными векторами все еще проблематична. [2]

Техника заточки узла

[ редактировать ]По мнению Френча (1991), [8] катастрофические помехи возникают в сетях прямого распространения ошибки из-за взаимодействия активаций узлов или перекрытия активаций, которое происходит в распределенных представлениях на скрытом уровне. Нейронные сети , использующие очень локализованные представления, не демонстрируют катастрофических помех из-за отсутствия перекрытия на скрытом уровне. Поэтому Френч предположил, что уменьшение значения перекрытия активации на скрытом уровне уменьшит катастрофические помехи в распределенных сетях. В частности, он предположил, что это можно сделать путем замены распределенных представлений на скрытом уровне на «полураспределенные» представления. «Полураспределенное» представление имеет меньше активных скрытых узлов и/или более низкое значение активации для этих узлов для каждого представления, что приводит к меньшему перекрытию представлений различных входных данных на скрытом уровне. Френч рекомендовал, чтобы это можно было сделать с помощью «уточнения активации» — метода, который немного увеличивает активацию определенного количества наиболее активных узлов в скрытом слое, немного уменьшает активацию всех остальных блоков, а затем меняет входные значения на -скрытые веса слоев для отражения этих изменений активации (аналогично обратному распространению ошибок).

Правило новизны

[ редактировать ]Короткометражный (1990) [13] предложил правило обучения нейронных сетей, называемое «правилом новизны», чтобы помочь смягчить катастрофические помехи. Как следует из названия, это правило помогает нейронной сети изучать только те компоненты нового ввода, которые отличаются от старых. Следовательно, правило новизны изменяет только веса, которые ранее не были предназначены для хранения информации, тем самым уменьшая перекрытие представлений в скрытых единицах. Чтобы применить правило новизны, во время обучения входной шаблон заменяется вектором новизны, который представляет отличающиеся компоненты. Когда правило новизны используется в стандартной сети обратного распространения ошибки, забывание старых элементов отсутствует или уменьшается, когда новые элементы представляются последовательно. [13] Однако ограничением является то, что это правило можно использовать только с автокодировщиком или автоассоциативными сетями, в которых целевой ответ выходного слоя идентичен входному шаблону.

Сети предварительной подготовки

[ редактировать ]Макрей и Хетерингтон (1993) [9] утверждал, что люди, в отличие от большинства нейронных сетей, не берутся за новые задачи обучения со случайным набором весов. Скорее, люди склонны привносить в задачу богатые предварительные знания, и это помогает избежать проблемы вмешательства. Они показали, что когда сеть предварительно обучается на случайной выборке данных перед началом последовательной задачи обучения, эти предварительные знания естественным образом будут ограничивать способы включения новой информации. Это может произойти потому, что случайная выборка данных из области, которая имеет высокую степень внутренней структуры, например английского языка, при обучении будет отражать закономерности или повторяющиеся закономерности, обнаруженные в этой области. Поскольку предметная область основана на закономерностях, вновь изученный элемент будет иметь тенденцию быть похожим на ранее изученную информацию, что позволит сети включать новые данные с небольшим вмешательством в существующие данные. В частности, входной вектор, который следует тому же шаблону закономерностей, что и ранее обученные данные, не должен вызывать радикально отличающийся шаблон активации на скрытом слое или радикально изменять веса.

Репетиция

[ редактировать ]Робинс (1995) [14] описали, что катастрофическое забывание можно предотвратить с помощью механизмов повторения. Это означает, что при добавлении новой информации нейронная сеть переобучается на некоторой ранее изученной информации. Однако в целом ранее полученная информация может быть недоступна для такой переподготовки. Решением этой проблемы является «псевдорепетиция», при которой сеть переобучается не на фактических предыдущих данных, а на их представлениях. Несколько методов основаны на этом общем механизме.

Псевдорекуррентные сети

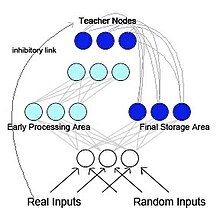

[ редактировать ]Френч (1997) предложил псевдорекуррентную сеть обратного распространения ошибки (см. рисунок 2). [5] В этой модели сеть разделена на две функционально различные, но взаимодействующие подсети. Эта модель основана на биологии и основана на исследованиях McClelland et al. (1995) [15] Макклелланд и его коллеги предположили, что гиппокамп и неокортекс действуют как отдельные, но дополняющие друг друга системы памяти: гиппокамп отвечает за хранение кратковременной памяти , а неокортекс — за хранение долговременной памяти . Информация, первоначально хранящаяся в гиппокампе, может быть «перенесена» в неокортекс посредством реактивации или воспроизведения. В псевдорекуррентной сети одна из подсетей действует как область ранней обработки, подобная гиппокампу, и функционирует для изучения новых входных шаблонов. Другая подсеть действует как область окончательного хранения, подобная неокортексу. Однако, в отличие от McClelland et al. (1995), область конечного хранения отправляет внутренне сгенерированное представление обратно в область ранней обработки. Это создает рекуррентную сеть. Френч предположил, что такое чередование старых представлений с новыми является единственным способом уменьшить радикальное забывание. Поскольку мозг, скорее всего, не будет иметь доступа к исходным входным шаблонам, шаблоны, которые будут передаваться обратно в неокортекс, будут представлять собой внутренне сгенерированные представления, называемые псевдопаттерны . Эти псевдошаблоны являются аппроксимацией предыдущих входных данных. [14] и их можно чередовать с изучением новых входных данных.

Самообновляющаяся память

[ редактировать ]Вдохновлено [14] и независимо от [5] Анс и Руссе (1997) [16] также предложил двухсетевую искусственную нейронную архитектуру с самообновлением памяти , которая преодолевает катастрофические помехи, когда последовательные задачи обучения выполняются в распределенных сетях, обученных методом обратного распространения ошибки. Принцип состоит в том, чтобы изучать новые внешние паттерны одновременно с внутренне генерируемыми псевдопаттернами или «псевдовоспоминаниями», которые отражают ранее изученную информацию. Что главным образом отличает эту модель от тех, которые используют классическую псевдорепетицию [14] [5] в многоуровневых сетях с прямой связью является реверберирующим процессом [ нужны дальнейшие объяснения ] который используется для генерации псевдошаблонов. После ряда повторных инъекций активности из одного случайного начального числа этот процесс имеет тенденцию переходить к нелинейным сетевым аттракторам , которые больше подходят для оптимального захвата глубокой структуры знаний, распределенных внутри весов соединений, чем одиночный проход активности прямой связи, используемый в псевдо -репетиция. Процедура самообновления памяти оказалась очень эффективной в процессах передачи [17] и в последовательном изучении временных последовательностей паттернов без катастрофического забывания. [18]

Генеративный повтор

[ редактировать ]В последние годы псевдорепетиция вновь обрела популярность благодаря прогрессу в возможностях глубоких генеративных моделей . Когда такие глубокие генеративные модели используются для генерации «псевдоданных», которые необходимо отрепетировать, этот метод обычно называют генеративным воспроизведением. [19] Такое генеративное воспроизведение может эффективно предотвратить катастрофическое забывание, особенно когда воспроизведение выполняется на скрытых уровнях, а не на уровне ввода. [20] [21]

Спонтанный повтор

[ редактировать ]Понимание механизмов консолидации памяти во время сна в мозге человека и животных привело к появлению других биологически обоснованных подходов. В то время как декларативные воспоминания в классической картине консолидируются гиппокампо-неокортикальным диалогом во время медленной фазы сна (см. выше), некоторые типы процедурных воспоминаний были предложены не полагаться на гиппокамп и включать фазу быстрого сна (например, [22] но посмотри [23] из-за сложности темы). Это вдохновило модели, в которых внутренние представления (воспоминания), созданные в результате предыдущего обучения, спонтанно воспроизводятся в периоды сна в самой сети. [24] [25] (т.е. без помощи вторичной сети, выполняемой с помощью упомянутых выше подходов генеративного воспроизведения).

Скрытое обучение

[ редактировать ]Скрытое обучение - это метод, используемый Гутштейном и Стампом (2015). [26] смягчить катастрофические помехи, воспользовавшись преимуществами трансферного обучения . Этот подход пытается найти оптимальные кодировки для любых новых изучаемых классов, чтобы они с наименьшей вероятностью катастрофически мешали существующим ответам. Дана сеть, которая научилась различать один набор классов, используя выходные коды с коррекцией ошибок (ECOC). [27] (в отличие от 1 горячих кодов ) оптимальные кодировки для новых классов выбираются путем наблюдения за средними реакциями сети на них. Поскольку эти средние ответы возникли во время изучения исходного набора классов без какого-либо воздействия на новые классы , их называют «латентно изученными кодировками». Эта терминология заимствована из концепции скрытого обучения , предложенной Толменом в 1930 году. [28] По сути, этот метод использует трансферное обучение, чтобы избежать катастрофических помех, делая ответы сети на новые классы максимально согласованными с существующими ответами на уже изученные классы.

Эластичная консолидация веса

[ редактировать ]Киркпатрик и др. (2017) [29] предложила эластичную консолидацию веса (EWC), метод последовательного обучения одной искусственной нейронной сети для выполнения нескольких задач. Этот метод предполагает, что некоторые веса обученной нейронной сети более важны для ранее изученных задач, чем другие. Во время обучения нейронной сети новой задаче изменения весов сети становятся менее вероятными, чем выше их важность. Для оценки важности весов сети EWC использует вероятностные механизмы, в частности информационную матрицу Фишера, но это можно сделать и другими способами. [30] [31] [32]

См. также

[ редактировать ]Ссылки

[ редактировать ]- ^ Jump up to: а б с Макклоски, Майкл; Коэн, Нил Дж. (1989). Катастрофические помехи в коннекционистских сетях: проблема последовательного обучения . Психология обучения и мотивации. Том. 24. С. 109–165. дои : 10.1016/S0079-7421(08)60536-8 . ISBN 978-0-12-543324-2 .

- ^ Jump up to: а б с д и Рэтклифф, Роджер (1990). «Коннекционистские модели узнавающей памяти: ограничения, налагаемые функциями обучения и забывания». Психологический обзор . 97 (2): 285–308. дои : 10.1037/0033-295x.97.2.285 . ПМИД 2186426 . S2CID 18556305 .

- ^ Хебб, Дональд Олдинг (1949). Организация поведения: нейропсихологическая теория . Уайли. ISBN 978-0-471-36727-7 . OCLC 569043119 . [ нужна страница ]

- ^ Карпентер, Гейл А.; Гроссберг, Стивен (1 декабря 1987 г.). «АРТ 2: самоорганизация стабильных кодов распознавания категорий для шаблонов аналогового ввода». Прикладная оптика . 26 (23): 4919–4930. Бибкод : 1987ApOpt..26.4919C . дои : 10.1364/AO.26.004919 . ПМИД 20523470 .

- ^ Jump up to: а б с д Френч, Роберт М. (декабрь 1997 г.). «Псевдорекуррентные коннекционистские сети: подход к дилемме« чувствительность-стабильность »» . Наука о связях . 9 (4): 353–380. дои : 10.1080/095400997116595 .

- ^ Гонсалес, Оскар С; Соколов Юрий; Кришнан, Гири П; Делануа, Жан Эрик; Баженов Максим (4 августа 2020 г.). «Может ли сон защитить воспоминания от катастрофического забывания?» . электронная жизнь . 9 : е51005. дои : 10.7554/eLife.51005 . ПМК 7440920 . ПМИД 32748786 .

- ^ Барнс, Джин М.; Андервуд, Бентон Дж. (август 1959 г.). « Судьба» объединений первого списка в теории трансфера». Журнал экспериментальной психологии . 58 (2): 97–105. дои : 10.1037/h0047507 . ПМИД 13796886 .

- ^ Jump up to: а б Френч, Роберт М. (1991). Использование полураспределенных представлений для преодоления катастрофического забывания в коннекционистских сетях (PDF) . Материалы 13-й ежегодной конференции Общества когнитивных наук. Нью-Джерси: Лоуренс Эрлбаум. стр. 173–178. CiteSeerX 10.1.1.1040.3564 .

- ^ Jump up to: а б с «Катастрофические помехи устраняются в предварительно обученных сетях» . Материалы пятнадцатой ежегодной конференции Общества когнитивных наук: 18–21 июня 1993 г., Институт когнитивных наук, Университет Колорадо-Боулдер . Психология Пресс. 1993. стр. 723–728. ISBN 978-0-8058-1487-3 .

- ^ Jump up to: а б с д Френч, R (1 апреля 1999 г.). «Катастрофическое забывание в коннекционистских сетях». Тенденции в когнитивных науках . 3 (4): 128–135. дои : 10.1016/S1364-6613(99)01294-2 . ПМИД 10322466 . S2CID 2691726 .

- ^ Левандовски, Стефан (1991). «Постепенное разучивание и катастрофическое вмешательство: сравнение распределенных архитектур» . В Хокли, Уильям Э.; Левандовски, Стефан (ред.). Связь теории и данных: очерки человеческой памяти в честь Беннета Б. Мердока . Психология Пресс. стр. 445–476. ISBN 978-1-317-76013-9 .

- ^ Левандовски, Стефан; Ли, Шу-Чен (1995). «Катастрофическое вмешательство в нейронные сети». Вмешательство и торможение в познании . стр. 329–361. дои : 10.1016/B978-012208930-5/50011-8 . ISBN 978-0-12-208930-5 .

- ^ Jump up to: а б Кортге, Калифорния (1990). Эпизодическая память в коннекционистских сетях. В: Двенадцатая ежегодная конференция Общества когнитивных наук (стр. 764-771). Хиллсдейл, Нью-Джерси: Лоуренс Эрлбаум.

- ^ Jump up to: а б с д Робинс, Энтони (июнь 1995 г.). «Катастрофическое забывание, репетиция и псевдорепетиция». Наука о связях . 7 (2): 123–146. дои : 10.1080/09540099550039318 . S2CID 22882861 .

- ^ Макклелланд, Джеймс Л.; Макнотон, Брюс Л.; О'Рейли, Рэндалл К. (июль 1995 г.). «Почему в гиппокампе и неокортексе существуют дополнительные системы обучения: выводы об успехах и неудачах коннекционистских моделей обучения и памяти». Психологический обзор . 102 (3): 419–457. дои : 10.1037/0033-295X.102.3.419 . ПМИД 7624455 . S2CID 2832081 .

- ^ Анс, Бернард; Руссе, Стефан (декабрь 1997 г.). «Как избежать катастрофического забывания путем объединения двух реверберирующих нейронных сетей». Доклады Академии наук, серия III . 320 (12): 989–997. Бибкод : 1997CRASG.320..989A . дои : 10.1016/S0764-4469(97)82472-9 .

- ^ Анс, Бернард; Руссе, Стефан (март 2000 г.). «Нейронные сети с самообновляющейся памятью: передача знаний в последовательных учебных задачах без катастрофического забывания». Наука о связях . 12 (1): 1–19. дои : 10.1080/095400900116177 . S2CID 7019649 .

- ^ Анс, Бернард; Руссе, Стефан; Френч, Роберт М.; Муска, Сербан (июнь 2004 г.). «Самообновляющаяся память в искусственных нейронных сетях: изучение временных последовательностей без катастрофического забывания» . Наука о связях . 16 (2): 71–99. дои : 10.1080/09540090412331271199 . S2CID 13462914 .

- ^ Мокану, Дечебал Константин; Торрес Вега, Мария; Итон, Эрик; Стоун, Питер; Лиотта, Антонио (18 октября 2016 г.). «Онлайн-контрастивная дивергенция с генеративным воспроизведением: опыт воспроизведения без хранения данных». arXiv : 1610.05555 [ cs.LG ].

- ^ Шин, Ханул; Ли, Юнг Квон; Ким, Джехон; Ким, Дживон (декабрь 2017 г.). Непрерывное обучение с глубоким генеративным воспроизведением . NIPS'17: Материалы 31-й Международной конференции по нейронным системам обработки информации. Карран Ассошиэйтс. стр. 2994–3003. ISBN 978-1-5108-6096-4 .

- ^ ван де Вен, Гидо М.; Сигельманн, Хава Т.; Толиас, Андреас С. (13 августа 2020 г.). «Вдохновленный мозгом повтор для непрерывного обучения с помощью искусственных нейронных сетей» . Природные коммуникации . 11 (1): 4069. Бибкод : 2020NatCo..11.4069V . дои : 10.1038/s41467-020-17866-2 . ПМЦ 7426273 . ПМИД 32792531 .

- ^ Макдевитт, Элизабет А.; Дагган, Кэтрин А.; Медник, Сара К. (01 июля 2015 г.). «Быстрый сон спасает обучение от помех» . Нейробиология обучения и памяти . Быстрый сон и память. 122 : 51–62. дои : 10.1016/j.nlm.2014.11.015 . ISSN 1074-7427 . ПМЦ 4704701 . ПМИД 25498222 .

- ^ Макдональд, Кевин Дж.; Кот, Кимберли А. (01 октября 2021 г.). «Вклад быстрого и медленного сна после обучения в восстановление памяти» . Обзоры медицины сна . 59 : 101453. doi : 10.1016/j.smrv.2021.101453 . hdl : 10464/17792 . ISSN 1087-0792 . ПМИД 33588273 .

- ^ Голден, Райан; Делануа, Жан Эрик; Санда, Павел; Баженов, Максим (18.11.2022). «Сон предотвращает катастрофическое забывание в нейронных сетях, формируя совместное представление синаптического веса» . PLOS Вычислительная биология . 18 (11): e1010628. Бибкод : 2022PLSCB..18E0628G . дои : 10.1371/journal.pcbi.1010628 . ISSN 1553-7358 . ПМЦ 9674146 . ПМИД 36399437 .

- ^ Тадрос, Тимоти; Кришнан, Гири П.; Рамьяа, Рамьяа; Баженов Максим (15 декабря 2022 г.). «Неконтролируемое воспроизведение, похожее на сон, снижает катастрофическое забывание в искусственных нейронных сетях» . Природные коммуникации . 13 (1): 7742. Бибкод : 2022NatCo..13.7742T . дои : 10.1038/s41467-022-34938-7 . ISSN 2041-1723 . ПМЦ 9755223 . ПМИД 36522325 .

- ^ Гутштейн, Стивен; Стамп, Итан (2015). «Уменьшение катастрофического забывания с помощью трансферного обучения и троичных выходных кодов». Международная совместная конференция по нейронным сетям, 2015 г. (IJCNN) . стр. 1–8. дои : 10.1109/IJCNN.2015.7280416 . ISBN 978-1-4799-1960-4 . S2CID 18745466 .

- ^ Дитерих, Т.Г.; Бакири, Г. (1 января 1995 г.). «Решение задач многоклассового обучения с помощью выходных кодов с коррекцией ошибок» . Журнал исследований искусственного интеллекта . 2 : 263–286. arXiv : cs/9501101 . дои : 10.1613/jair.105 . S2CID 47109072 .

- ^ Толман, ЕС; Хонзик, CH (1930). « Понимание» у крыс». Публикации по психологии . 4 . Калифорнийский университет: 215–232.

- ^ Киркпатрик, Джеймс; Пашкану, Разван; Рабиновиц, Нил; Венесс, Джоэл; Дежарден, Гийом; Русу, Андрей А.; Милан, Киран; Куан, Джон; Рамальо, Тьяго; Грабская-Барвинская, Агнешка; Хассабис, Демис; Клопат, Клаудия; Кумаран, Дхаршан; Хадселл, Райя (14 марта 2017 г.). «Преодоление катастрофического забывания в нейронных сетях» . Труды Национальной академии наук . 114 (13): 3521–3526. arXiv : 1612.00796 . Бибкод : 2017PNAS..114.3521K . дои : 10.1073/pnas.1611835114 . ПМК 5380101 . ПМИД 28292907 .

- ^ Зенке, Фридеманн; Пул, Бен; Гангули, Сурья (2017). «Непрерывное обучение посредством синаптического интеллекта» . Труды исследований машинного обучения . 70 : 3987–3995. arXiv : 1703.04200 . ПМК 6944509 . ПМИД 31909397 .

- ^ Альджунди, Рахаф; Бабилони, Франческа; Эльхосейни, Мохамед; Рорбах, Маркус; Туйтелаарс, Тинне (2018). «Синапсы с памятью: учимся тому, что (не) забывать». Компьютерное зрение – ECCV 2018 . Конспекты лекций по информатике. Том. 11207. стр. 144–161. arXiv : 1711.09601 . дои : 10.1007/978-3-030-01219-9_9 . ISBN 978-3-030-01218-2 . S2CID 4254748 .

- ^ Куталев, Алексей (2020). «Естественный способ преодолеть катастрофическое забывание в нейронных сетях». Современные информационные технологии и IT-образование . 16 (2): 331–337. arXiv : 2005.07107 . дои : 10.25559/SITITO.16.202002.331-337 . S2CID 218628670 .