Машинное обучение в видеоиграх

Методы искусственного интеллекта и машинного обучения используются в видеоиграх для самых разных приложений, таких как управление неигровыми персонажами (NPC) и процедурная генерация контента (PCG). Машинное обучение — это разновидность искусственного интеллекта, которая использует исторические данные для построения прогнозных и аналитических моделей. Это резко контрастирует с традиционными методами искусственного интеллекта, такими как деревья поиска и экспертные системы .

Информация о методах машинного обучения в сфере игр в основном известна общественности благодаря исследовательским проектам , поскольку большинство игровых компаний предпочитают не публиковать конкретную информацию о своей интеллектуальной собственности . Наиболее известным применением машинного обучения в играх, вероятно, является использование глубокого обучения агентов , которые конкурируют с профессиональными игроками-людьми в сложных стратегических играх . Машинное обучение широко применялось в таких играх, как Atari /ALE, Doom , Minecraft , StarCraft и автомобильных гонках. [ 1 ] Другие игры, которые изначально не существовали как видеоигры, такие как шахматы и го, также подверглись воздействию машинного обучения. [ 2 ]

Обзор соответствующих методов машинного обучения

[ редактировать ]

Глубокое обучение

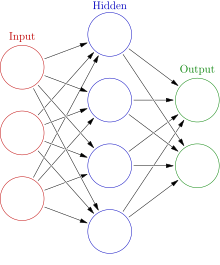

[ редактировать ]Глубокое обучение — это разновидность машинного обучения, в которой основное внимание уделяется использованию искусственных нейронных сетей (ИНС), которые учатся решать сложные задачи. Глубокое обучение использует несколько уровней ИНС и другие методы для постепенного извлечения информации из входных данных. Из-за такого сложного многоуровневого подхода модели глубокого обучения часто требуют мощных машин для обучения и работы.

Сверточные нейронные сети

[ редактировать ]Сверточные нейронные сети (CNN) — это специализированные ИНС, которые часто используются для анализа данных изображений. Эти типы сетей способны изучать шаблоны, инвариантные к трансляции , то есть шаблоны, не зависящие от местоположения. CNN способны изучать эти шаблоны в иерархии, а это означает, что более ранние сверточные слои изучают меньшие локальные шаблоны, а более поздние слои изучают более крупные шаблоны на основе предыдущих шаблонов. [ 3 ] Способность CNN изучать визуальные данные сделала ее широко используемым инструментом для глубокого обучения в играх. [ 4 ] [ 5 ]

Рекуррентная нейронная сеть

[ редактировать ]Рекуррентные нейронные сети — это тип ИНС, который предназначен для обработки последовательностей данных по порядку, по одной части, а не все сразу. RNN пробегает каждую часть последовательности, используя текущую часть последовательности вместе с памятью предыдущих частей текущей последовательности для получения вывода. Эти типы ИНС очень эффективны при решении таких задач, как распознавание речи и других проблем, которые сильно зависят от временного порядка. Существует несколько типов RNN с разными внутренними конфигурациями; базовая реализация страдает от нехватки долговременной памяти из-за проблемы исчезающего градиента , поэтому она редко используется в новых реализациях. [ 3 ]

Длинная кратковременная память

[ редактировать ]Сеть с длинной краткосрочной памятью (LSTM) — это конкретная реализация RNN, предназначенная для решения проблемы исчезновения градиента, наблюдаемой в простых RNN, которая приводит к тому, что они постепенно «забывают» о предыдущих частях введенной последовательности при вычислении. выход текущей части. LSTM решают эту проблему путем добавления сложной системы, которая использует дополнительный ввод/вывод для отслеживания долгосрочных данных. [ 3 ] LSTM достигли очень хороших результатов в различных областях и использовались несколькими выдающимися агентами глубокого обучения в играх. [ 6 ] [ 4 ]

Обучение с подкреплением

[ редактировать ]Обучение с подкреплением — это процесс обучения агента с использованием вознаграждений и/или наказаний. Способ вознаграждения или наказания агента во многом зависит от проблемы; например, предоставление агенту положительного вознаграждения за победу в игре или отрицательного за проигрыш. Обучение с подкреплением широко используется в области машинного обучения и его можно увидеть в таких методах, как Q-обучение , поиск политик , Deep Q-сети и других. Компания добилась хороших результатов как в области игр, так и в области робототехники . [ 7 ]

Нейроэволюция

[ редактировать ]Нейроэволюция предполагает использование как нейронных сетей, так и эволюционных алгоритмов . Вместо использования градиентного спуска, как в большинстве нейронных сетей, модели нейроэволюции используют эволюционные алгоритмы для обновления нейронов в сети. Исследователи утверждают, что этот процесс с меньшей вероятностью застрянет в локальном минимуме и потенциально быстрее, чем современные методы глубокого обучения. [ 8 ]

Агенты глубокого обучения

[ редактировать ]машинного обучения Агенты использовались вместо игроков-человеков, а не в качестве неигровых персонажей, которые намеренно добавляются в видеоигры как часть разработанного игрового процесса . Агенты глубокого обучения достигли впечатляющих результатов при использовании в конкуренции как с людьми, так и с другими агентами искусственного интеллекта. [ 2 ] [ 9 ]

шахматы

[ редактировать ]Шахматы — это пошаговая стратегическая игра, которая считается сложной задачей ИИ из-за вычислительной сложности игрового пространства. Подобные стратегические игры часто решаются с использованием той или иной формы поиска по минимаксному дереву. Известно, что эти типы ИИ-агентов побеждают профессиональных игроков-людей, например, в историческом матче Deep Blue против Гарри Каспарова в 1997 году . С тех пор агенты машинного обучения добились еще большего успеха, чем предыдущие агенты ИИ.

Идти

[ редактировать ]Го — еще одна пошаговая стратегическая игра, которая считается еще более сложной задачей ИИ, чем шахматы. Пространство состояний в Go составляет около 10^170 возможных состояний доски по сравнению с 10^120 состояниями доски в шахматах. До появления недавних моделей глубокого обучения агенты AI Go могли играть только на уровне любителя. [ 5 ]

АльфаГо

[ редактировать ]от Google в 2015 году AlphaGo стал первым агентом искусственного интеллекта, победившим профессионального игрока в го. [ 5 ] AlphaGo использовала модель глубокого обучения для тренировки весов поиска по дереву Монте-Карло (MCTS). Модель глубокого обучения состояла из 2 ANN, политической сети для прогнозирования вероятностей потенциальных действий оппонентов и сети ценностей для прогнозирования шансов на победу данного государства. Модель глубокого обучения позволяет агенту исследовать потенциальные игровые состояния более эффективно, чем стандартный MCTS. Первоначально сеть обучалась на играх людей-игроков, а затем обучалась играм против самой себя.

АльфаГоу Ноль

[ редактировать ]AlphaGo Zero , еще одна реализация AlphaGo, могла полностью тренироваться, играя против себя. Ему удалось быстро обучиться возможностям предыдущего агента. [ 10 ]

Старкрафт Серия

[ редактировать ]StarCraft и его продолжение StarCraft II — это видеоигры в жанре стратегии в реальном времени (RTS), которые стали популярной средой для исследований ИИ. Blizzard и DeepMind совместно работали над выпуском общедоступной среды StarCraft 2 для исследований ИИ. [ 11 ] В обеих играх были протестированы различные методы глубокого обучения, хотя у большинства агентов обычно возникают проблемы с тем, чтобы превзойти стандартный ИИ с включенными читами или опытными игроками. [ 1 ]

Альфастар

[ редактировать ]Alphastar был первым ИИ-агентом, победившим профессиональных игроков StarCraft 2 без каких-либо внутриигровых преимуществ. Сеть глубокого обучения агента изначально получала входные данные из упрощенной уменьшенной версии игрового состояния, но позже была обновлена для игры с использованием камеры, как и другие игроки-люди. Разработчики не обнародовали код или архитектуру своей модели, но перечислили несколько современных методов машинного обучения, таких как реляционное глубокое обучение с подкреплением, длинная краткосрочная память , авторегрессионные политики, сети указателей и централизованное значение. базовый уровень. [ 4 ] Первоначально Alphastar обучалась с учителем: она смотрела повторы многих человеческих игр, чтобы изучить базовые стратегии. Затем он тренировался на различных версиях самого себя и был улучшен посредством обучения с подкреплением. Финальная версия была чрезвычайно успешной, но была подготовлена только для игры на конкретной карте в зеркальном матче протоссов.

Дота 2

[ редактировать ]Dota 2 — это многопользовательская онлайн-игра на боевой арене (MOBA). Как и в других сложных играх, традиционные агенты ИИ не могут конкурировать на том же уровне, что и профессиональные игроки-люди. Единственная широко опубликованная информация о попытках использования ИИ-агентов в Dota 2 — это OpenAI агент глубокого обучения Five от .

OpenAI пять

[ редактировать ]OpenAI Five использовала отдельные сети LSTM для изучения каждого героя. Он обучался с использованием метода обучения с подкреплением, известного как Proximal Policy Learning, работающего в системе, содержащей 256 графических процессоров и 128 000 ядер ЦП . [ 6 ] Пятеро тренировались месяцами, каждый день накапливая 180 лет игрового опыта, прежде чем встретиться с профессиональными игроками. [ 12 ] [ 13 ] В конечном итоге ей удалось обыграть Dota 2 команду чемпиона по киберспорту 2018 года в серии игр 2019 года.

Планетарное уничтожение

[ редактировать ]Planetary Annihilation — это стратегическая игра в реальном времени, в которой основное внимание уделяется масштабной войне. Разработчики используют ИНС в своем ИИ-агенте по умолчанию. [ 14 ]

Верховный Главнокомандующий 2

[ редактировать ]Supreme Commander 2 — это в жанре стратегии в реальном времени видеоигра (RTS). В игре используются многослойные перцептроны (MLP) для управления реакцией взвода на встреченные вражеские подразделения. Всего используется четыре MLP, по одному на каждый тип взвода: сухопутный, морской, бомбардировочный и истребительный. [ 15 ]

Обобщенные игры

[ редактировать ]Были попытки создать агентов машинного обучения, способных играть более чем в одну игру. Эти «общие» игровые агенты обучены понимать игры на основе общих свойств между ними.

АльфаЗеро

[ редактировать ]AlphaZero — это модифицированная версия AlphaGo Zero , которая позволяет играть в сёги , шахматы и го . Модифицированный агент начинает с базовых правил игры и обучается полностью путем самообучения. DeepMind удалось обучить этого обобщенного агента, чтобы он мог конкурировать с предыдущими версиями самого себя в Го, а также с лучшими агентами в двух других играх. [ 2 ]

Сильные и слабые стороны агентов глубокого обучения

[ редактировать ]Агенты машинного обучения часто не рассматриваются во многих курсах по игровому дизайну. Предыдущее использование агентов машинного обучения в играх, возможно, было не очень практичным, поскольку даже версия AlphaGo 2015 года требовала сотни процессоров и графических процессоров для обучения до сильного уровня. [ 2 ] Это потенциально ограничивает создание высокоэффективных агентов глубокого обучения крупными корпорациями или чрезвычайно богатыми людьми. Длительное время обучения подходам, основанным на нейронных сетях, также может занять недели на этих мощных машинах. [ 4 ]

Проблема эффективного обучения моделей на основе ИНС выходит за рамки мощной аппаратной среды; найти хороший способ представления данных и извлечь из них значимые вещи также часто является сложной проблемой. Модели ИНС часто подходят для очень специфических данных и плохо работают в более обобщенных случаях. AlphaStar демонстрирует эту слабость: несмотря на то, что она способна побеждать профессиональных игроков, она может сделать это только на одной карте, играя в матче с зеркальными протоссами. [ 4 ] OpenAI Five также демонстрирует эту слабость: он смог победить профессионального игрока только тогда, когда столкнулся с очень ограниченным пулом героев за всю игру. [ 13 ] Этот пример показывает, насколько сложно научить агента глубокого обучения действовать в более общих ситуациях.

Агенты машинного обучения показали большие успехи в самых разных играх. [ 12 ] [ 2 ] [ 4 ] Однако слишком компетентные агенты также рискуют сделать игру слишком сложной для новых или случайных игроков. Исследования показали, что задача, которая слишком превышает уровень навыков игрока, испортит удовольствие от игры. [ 16 ] Эти высококвалифицированные агенты, вероятно, желательны только против очень опытных игроков-людей, имеющих многочасовой опыт в конкретной игре. Учитывая эти факторы, высокоэффективные агенты глубокого обучения, вероятно, являются лишь желательным выбором в играх с большой конкурентной сценой, где они могут выступать в качестве альтернативы опытному игроку-человеку.

Игроки на основе компьютерного зрения

[ редактировать ]Компьютерное зрение направлено на обучение компьютеров получению высокого уровня понимания цифровых изображений или видео. Многие методы компьютерного зрения также включают в себя формы машинного обучения и применяются в различных видеоиграх. Это приложение компьютерного зрения фокусируется на интерпретации игровых событий с использованием визуальных данных. В некоторых случаях агенты искусственного интеллекта использовали методы без моделей , чтобы научиться играть в игры без какой-либо прямой связи с внутренней игровой логикой, используя исключительно видеоданные в качестве входных данных.

Понг

[ редактировать ]Андрей Карпати продемонстрировал, что относительно тривиальную нейронную сеть всего с одним скрытым слоем можно обучить игре в понг только на основе данных с экрана. [ 17 ] [ 18 ]

Атари игры

[ редактировать ]В 2013 году команда DeepMind продемонстрировала использование глубокого Q-обучения для игры в различные Atari видеоигры — Beamrider , Breakout , Enduro , Pong , Q*bert , Seaquest и Space Invaders — на основе данных экрана. [ 19 ] Команда расширила свою работу, создав алгоритм обучения под названием MuZero, который смог «изучить» правила и разработать выигрышные стратегии для более чем 50 различных игр Atari на основе данных экрана. [ 20 ] [ 21 ]

Рок

[ редактировать ]Doom (1993) — игра-шутер от первого лица (FPS). Студенты-исследователи из Университета Карнеги-Меллон использовали методы компьютерного зрения, чтобы создать агента, который мог бы играть в игру, используя только входные пиксели изображения из игры. Студенты использовали слои сверточной нейронной сети (CNN) для интерпретации входящих данных изображения и вывода достоверной информации в рекуррентную нейронную сеть , которая отвечала за вывод игровых ходов. [ 22 ]

Супер Марио

[ редактировать ]на основе зрения Другие варианты использования методов глубокого обучения для игр включают в себя игру в Super Mario Bros. только с использованием ввода изображений и использование глубокого Q-обучения для обучения. [ 17 ]

Шахтерское ремесло

[ редактировать ]Исследователи из OpenAI создали около 2000 часов видеозаписей Minecraft, закодированных с необходимыми человеческими данными, а затем обучили модель машинного обучения понимать видеоотзывы от входных данных. Затем исследователи использовали эту модель с 70 000 часами прохождения Minecraft , представленными на YouTube, чтобы увидеть, насколько хорошо модель может создавать входные данные, соответствующие этому поведению, и учиться на ее основе, например, иметь возможность изучить шаги и процесс создания алмазной кирки. инструмент. [ 23 ] [ 24 ]

Машинное обучение для процедурной генерации контента в играх

[ редактировать ]В области машинного обучения проводились исследования по использованию в рекомендации и создании контента. Процедурная генерация контента — это процесс создания данных алгоритмически, а не вручную. Этот тип контента используется для повышения возможности повторного прохождения игр, не полагаясь на постоянные дополнения со стороны разработчиков. PCG использовался в различных играх для создания разных типов контента, примеры которого включают оружие в Borderlands 2 , [ 25 ] все макеты мира в Майнкрафте [ 26 ] и целые вселенные в No Man's Sky . [ 27 ] Общие подходы к PCG включают методы, включающие грамматики , алгоритмы поиска и логическое программирование . [ 28 ] Эти подходы требуют, чтобы люди вручную определяли диапазон возможного контента, а это означает, что разработчик-человек решает, какие функции составляют допустимую часть сгенерированного контента. Машинное обучение теоретически способно изучить эти функции, когда им даются примеры для обучения, что значительно сокращает сложный этап, требующий от разработчиков уточнения деталей дизайна контента. [ 29 ] Методы машинного обучения, используемые для генерации контента, включают с длинной краткосрочной памятью (LSTM) рекуррентные нейронные сети (RNN), генеративно-состязательные сети (GAN) и кластеризацию K-средних . Не все эти методы используют ИНС, но быстрое развитие глубокого обучения значительно увеличило потенциал таких методов. [ 29 ]

Галактическая гонка вооружений

[ редактировать ]Galactic Arms Race — это космическая видеоигра-стрелялка, в которой компьютерная игра на базе нейроэволюции используется для создания уникального оружия для игрока. Эта игра стала финалистом конкурса Indie Game Challenge 2010 года , а связанная с ней исследовательская работа получила награду за лучшую статью на конференции IEEE 2009 года по вычислительному интеллекту и играм. Разработчики используют форму нейроэволюции под названием cgNEAT для создания нового контента на основе личных предпочтений каждого игрока. [ 30 ]

Каждый сгенерированный элемент представлен специальной ИНС, известной как сеть создания композиционных шаблонов (CPPN). На этапе развития игры cgNEAT вычисляет пригодность текущих предметов на основе использования игроком и других показателей игрового процесса. Затем этот показатель приспособленности используется для принятия решения, какие CPPN будут воспроизводиться для создания нового предмета. Конечным результатом является создание новых эффектов оружия в зависимости от предпочтений игрока.

Супер Братья Марио.

[ редактировать ]Super Mario Bros. Несколько исследователей использовали для моделирования создания уровней PCG. Различные попытки с использованием разных методов. Версия 2014 года использовала n-граммы для генерации уровней, аналогичных тем, на которых она обучалась, что позже было улучшено за счет использования MCTS для управления генерацией. [ 31 ] Эти поколения часто не были оптимальными с учетом таких показателей игрового процесса, как движение игрока. Отдельный исследовательский проект в 2017 году пытался решить эту проблему, генерируя уровни на основе движения игрока с помощью цепей Маркова. [ 32 ] Эти проекты не подвергались тестированию на людях и могут не соответствовать стандартам играбельности для людей.

Легенда о Зельде

[ редактировать ]создать уровень PCG для The Legend of Zelda Исследователи из Калифорнийского университета в Санта-Крус попытались . В этой попытке использовалась байесовская сеть для изучения знаний высокого уровня на существующих уровнях, в то время как анализ главных компонентов (PCA) использовался для представления различных функций низкого уровня этих уровней. [ 33 ] Исследователи использовали PCA для сравнения сгенерированных уровней с уровнями, созданными человеком, и обнаружили, что они считаются очень похожими. Этот тест не включал в себя игровые возможности или тестирование сгенерированных уровней человеком.

Генерация музыки

[ редактировать ]Музыку часто можно увидеть в видеоиграх, и она может быть решающим элементом, влияющим на настроение различных ситуаций и сюжетных моментов. Машинное обучение нашло применение в экспериментальной области создания музыки; он уникально подходит для обработки необработанных неструктурированных данных и формирования представлений высокого уровня, которые могут быть применены к разнообразным областям музыки. [ 34 ] Большинство предпринятых методов предполагало использование ИНС в той или иной форме. Методы включают использование базовых нейронных сетей прямого распространения , автоэнкодеров , ограниченных машин Больцмана , рекуррентных нейронных сетей , сверточных нейронных сетей , генеративно-состязательных сетей (GAN) и составных архитектур, использующих несколько методов. [ 34 ]

Система генерации символической музыки мелодий видеоигр VRAE

[ редактировать ]В исследовательской работе 2014 года «Вариационные рекуррентные автокодировщики» была предпринята попытка создать музыку на основе песен из 8 различных видеоигр. Этот проект — один из немногих, созданных исключительно под музыку из видеоигр. Нейронная сеть в проекте смогла генерировать данные, очень похожие на данные игр, на которых она обучалась. [ 35 ] Сгенерированные данные не были преобразованы в музыку хорошего качества.

Ссылки

[ редактировать ]- ^ Перейти обратно: а б Юстесен, Нильс; Бонтрагер, Филип; Тогелиус, Джулиан; Ризи, Себастьян (2019). «Глубокое обучение для видеоигр». Транзакции IEEE в играх . 12 :1–20. arXiv : 1708.07902 . дои : 10.1109/tg.2019.2896986 . ISSN 2475-1502 . S2CID 37941741 .

- ^ Перейти обратно: а б с д и Сильвер, Дэвид; Юбер, Томас; Шритвизер, Джулиан; Антоноглу, Иоаннис; Лай, Мэтью; Гез, Артур; Ланкто, Марк; Сифре, Лоран; Кумаран, Дхаршан (6 декабря 2018 г.). «Общий алгоритм обучения с подкреплением, позволяющий освоить шахматы, сёги и самостоятельную игру» (PDF) . Наука . 362 (6419): 1140–1144. Бибкод : 2018Sci...362.1140S . doi : 10.1126/science.aar6404 . ISSN 0036-8075 . ПМИД 30523106 . S2CID 54457125 .

- ^ Перейти обратно: а б с Шолле, Франсуа (28 октября 2017 г.). Глубокое обучение с помощью Python . Компания Manning Publications. ISBN 9781617294433 . OCLC 1019988472 .

- ^ Перейти обратно: а б с д и ж «AlphaStar: освоение стратегии в реальном времени StarCraft II» . ДипМайнд . 24 января 2019 года . Проверено 4 июня 2019 г.

- ^ Перейти обратно: а б с Сильвер, Дэвид; Хуанг, Аджа; Мэддисон, Крис Дж.; Гез, Артур; Сифре, Лоран; ван ден Дриссе, Джордж; Шритвизер, Джулиан; Антоноглу, Иоаннис; Паннеершелвам, Веда (январь 2016 г.). «Освоение игры в го с помощью глубоких нейронных сетей и поиска по дереву». Природа . 529 (7587): 484–489. Бибкод : 2016Natur.529..484S . дои : 10.1038/nature16961 . ISSN 0028-0836 . ПМИД 26819042 . S2CID 515925 .

- ^ Перейти обратно: а б «ОпенАИ Пять» . ОпенАИ . 25 июня 2018 г. Проверено 4 июня 2019 г.

- ^ Рассел, Стюарт Дж. (Стюарт Джонатан) (2015). Искусственный интеллект: современный подход . Норвиг, Питер (Третье индийское изд.). Нойда, Индия. ISBN 9789332543515 . OCLC 928841872 .

{{cite book}}: CS1 maint: отсутствует местоположение издателя ( ссылка ) - ^ Клюн, Джефф; Стэнли, Кеннет О.; Леман, Джоэл; Конти, Эдоардо; Мадхаван, Вашишт; Такой, Фелипе Петроски (18 декабря 2017 г.). «Глубокая нейроэволюция: генетические алгоритмы — конкурентная альтернатива обучению глубоких нейронных сетей для обучения с подкреплением». arXiv : 1712.06567 [ cs.NE ].

- ^ Чжэнь, Джеки Шуньджи; Уотсон, Ян (2013), «Нейроэволюция микроменеджмента в стратегической игре в реальном времени Starcraft: Brood War», AI 2013: Достижения в области искусственного интеллекта , Конспекты лекций по информатике, том. 8272, Springer International Publishing, стр. 259–270, CiteSeerX 10.1.1.703.5110 , doi : 10.1007/978-3-319-03680-9_28 , ISBN 9783319036793

- ^ Сильвер, Дэвид; Шритвизер, Джулиан; Симонян, Карен; Антоноглу, Иоаннис; Хуанг, Аджа; Гез, Артур; Юбер, Томас; Бейкер, Лукас; Лай, Мэтью (октябрь 2017 г.). «Освоение игры в го без ведома человека» (PDF) . Природа . 550 (7676): 354–359. Бибкод : 2017Natur.550..354S . дои : 10.1038/nature24270 . ISSN 0028-0836 . ПМИД 29052630 . S2CID 205261034 .

- ^ Цинг, Родни; Репп, Джейкоб; Экермо, Андерс; Лоуренс, Дэвид; Брунассо, Энтони; Кит, Пол; Кальдероне, Кевин; Лилликрап, Тимоти; Сильвер, Дэвид (16 августа 2017 г.). «StarCraft II: новый вызов обучению с подкреплением». arXiv : 1708.04782 [ cs.LG ].

- ^ Перейти обратно: а б «ОпенАИ Пять» . ОпенАИ . Проверено 4 июня 2019 г.

- ^ Перейти обратно: а б «Как тренировать свою пятерку OpenAI» . ОпенАИ . 15 апреля 2019 г. Проверено 4 июня 2019 г.

- ^ xavdematos (7 июня 2014 г.). «Познакомьтесь с компьютером, который учится убивать, и человеком, который запрограммировал хаос» . Engadget . Проверено 4 июня 2019 г.

- ^ Роббинс, Майкл (6 сентября 2019 г.). «Использование нейронных сетей для управления реагированием агентов на угрозы» (PDF) . Игра AI Pro 360: Руководство по тактике и стратегии . CRC Press: 55–64. дои : 10.1201/9780429054969-5 . ISBN 9780429054969 . S2CID 208122019 . Проверено 30 ноября 2022 г.

- ^ Свитсер, Пенелопа; Уайет, Пета (1 июля 2005 г.). «ГеймФлоу». Компьютеры в сфере развлечений . 3 (3): 3. дои : 10.1145/1077246.1077253 . ISSN 1544-3574 . S2CID 2669730 .

- ^ Перейти обратно: а б Джонс, М. Тим (7 июня 2019 г.). «Машинное обучение и игры» . Разработчик IBM . Проверено 3 февраля 2020 г.

- ^ «Глубокое обучение с подкреплением: понг из пикселей» . karpathy.github.io . Проверено 3 февраля 2020 г.

- ^ Мних, Владимир; Кавукчуоглу, Корай; Сильвер, Дэвид; Грейвс, Алекс; Антоноглу, Иоаннис; Виерстра, Даан; Ридмиллер, Мартин (19 декабря 2013 г.). «Игра в Atari с глубоким обучением с подкреплением». arXiv : 1312.5602 [ cs.LG ].

- ^ Бонифачич, Игорь (23 декабря 2020 г.). «Новейший искусственный интеллект DeepMind может осваивать игры, даже не зная их правил» . Engadget . Проверено 23 декабря 2020 г.

- ^ Шритвизер, Джулиан; Антоноглу, Иоаннис; Юбер, Томас; Симонян, Карен; Сифре, Лоран; Шмитт, Саймон; Гез, Артур; Локхарт, Эдвард; Хассабис, Демис; Грепель, Торе; Лилликрап, Тимоти; Сильвер, Дэвид (2020). «Освоение Atari, го, шахмат и сёги путем планирования с использованием изученной модели». Природа . 588 (7839): 604–609. arXiv : 1911.08265 . Бибкод : 2020Natur.588..604S . дои : 10.1038/s41586-020-03051-4 . ПМИД 33361790 . S2CID 208158225 .

- ^ Лампле, Гийом; Часюжет, Девендра Сингх (2017). «Игра в шутеры от первого лица с глубоким обучением с подкреплением» . Материалы тридцать первой конференции AAAI по искусственному интеллекту . АААИ'17. Сан-Франциско, Калифорния, США: AAAI Press: 2140–2146. arXiv : 1609.05521 . Бибкод : 2016arXiv160905521L .

- ^ Мэтьюз, Дэвид (27 июня 2022 г.). «ИИ был обучен играть в Minecraft с помощью 70 000 часов видео на YouTube» . ИГН . Проверено 8 июля 2022 г.

- ^ Бейкер, Боуэн; Аккая, Ильге; Жохов, Петр; Хейзинга, Йост; Тан, Цзе; Экоффет, Адриан; Хоутон, Брэндон; Сампедро, Рауль; Клюн, Джефф (2022). «Предварительная подготовка по видео (VPT): учимся действовать, просматривая онлайн-видео без маркировки». arXiv : 2206.11795 [ cs.LG ].

- ^ Инь-Пул, Уэсли (16 июля 2012 г.). «Сколько оружия в Borderlands 2?» . Еврогеймер . Проверено 4 июня 2019 г.

- ^ «Генерация местности, часть 1» . Слово Нотча . Проверено 4 июня 2019 г.

- ^ Паркин, Саймон. «Научно-фантастическая вселенная, созданная алгоритмами» . Обзор технологий Массачусетского технологического института . Проверено 4 июня 2019 г.

- ^ Тогелиус, Джулиан; Шейкер, Нур; Нельсон, Марк Дж. (2016), «Введение», Процедурная генерация контента в играх , Вычислительный синтез и творческие системы, Springer International Publishing, стр. 1–15, doi : 10.1007/978-3-319-42716-4_1 , ISBN 9783319427140

- ^ Перейти обратно: а б Саммервилл, Адам; Снодграсс, Сэм; Гуздиал, Мэтью; Холмгард, Кристоффер; Гувер, Эми К.; Исаксен, Аарон; Нилен, Энди; Тогелиус, Джулиан (сентябрь 2018 г.). «Процедурная генерация контента с помощью машинного обучения (PCGML)». Транзакции IEEE в играх . 10 (3): 257–270. arXiv : 1702.00539 . дои : 10.1109/tg.2018.2846639 . ISSN 2475-1502 . S2CID 9950600 .

- ^ Гастингс, Эрин Дж.; Гуха, Ратан К.; Стэнли, Кеннет О. (сентябрь 2009 г.). «Развивающийся контент в видеоигре Galactic Arms Race» (PDF) . Симпозиум IEEE 2009 г. по вычислительному интеллекту и играм . IEEE. стр. 241–248. дои : 10.1109/cig.2009.5286468 . ISBN 9781424448142 . S2CID 16598064 .

- ^ Саммервилл, Адам. «MCMCTS PCG 4 SMB: поиск в дереве Монте-Карло для управления созданием уровней платформера» . www.aaai.org . Проверено 4 июня 2019 г.

- ^ Снодграсс, Сэм; Онтаньон, Сантьяго (август 2017 г.). «Модели движения игроков для создания уровней видеоигр». Материалы двадцать шестой Международной совместной конференции по искусственному интеллекту . Калифорния: Международные совместные конференции по организации искусственного интеллекта. стр. 757–763. дои : 10.24963/ijcai.2017/105 . ISBN 9780999241103 .

- ^ Саммервилл, Джеймс. «Выборка Хайрула: многопрофильная вероятностная генерация уровней для ролевых игр» . www.aaai.org . Проверено 4 июня 2019 г.

- ^ Перейти обратно: а б Паше, Франсуа-Давид; Хаджерес, Гаэтан; Брио, Жан-Пьер (05 сентября 2017 г.). «Методы глубокого обучения для создания музыки — опрос». arXiv : 1709.01620 [ cs.SD ].

- ^ ван Амерсфорт, Йост Р.; Фабиус, Отто (20 декабря 2014 г.). «Вариационные рекуррентные автокодеры». arXiv : 1412.6581 [ stat.ML ].