Нейронная сеть прямого распространения

Эта статья нуждается в дополнительных цитатах для проверки . ( сентябрь 2011 г. ) |

| Часть серии о |

| Машинное обучение и интеллектуальный анализ данных |

|---|

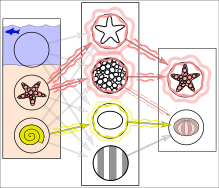

В действительности текстуры и контуры будут представлены не отдельными узлами, а скорее соответствующими весовыми шаблонами нескольких узлов.

Нейронная сеть прямого распространения ( FNN ) — это один из двух широких типов искусственных нейронных сетей , характеризующийся направлением потока информации между ее слоями. [2] Его поток является однонаправленным, что означает, что информация в модели течет только в одном направлении — вперед — от входных узлов через скрытые узлы (если таковые имеются) и к выходным узлам без каких-либо циклов или петель. [2] в отличие от рекуррентных нейронных сетей , [3] которые имеют двунаправленный поток. Современные сети прямого распространения обучаются с использованием обратного распространения ошибки. метода [4] [5] [6] [7] [8] и в просторечии их называют «ванильными» нейронными сетями. [9]

Хронология

[ редактировать ]- В 1958 году многослойная сеть перцептронов, состоящая из входного слоя, скрытого слоя со рандомизированными весами, которые не обучаются, и выходного слоя с обучающими связями, была представлена уже Фрэнком Розенблаттом в его книге «Перцептрон» . [10] [11] [12] Эта экстремальная обучающая машина [13] [12] еще не была сетью глубокого обучения .

- первая сеть прямого обучения с глубоким обучением , еще не использующая стохастический градиентный спуск и Валентином Лапой была опубликована В 1965 году Алексеем Григорьевичем Ивахненко , которая в то время называлась « Групповой метод обработки данных» . [14] [15] [12]

- В 1967 году сеть глубокого обучения, использовавшая стохастический градиентный спуск впервые , смогла классифицировать нелинейно разделимые классы шаблонов, как сообщил Шуничи Амари . [16] Ученик Амари Сайто провел компьютерные эксперименты, используя пятислойную сеть прямого распространения с двумя уровнями обучения.

- В 1970 году появился современный метод обратного распространения ошибки , эффективное применение цепочек правил на основе контролируемого обучения . [17] [18] была впервые опубликована финским исследователем Сеппо Линнаинмаа . [4] [19] [12] Сам термин (то есть «ошибки обратного распространения») использовался самим Розенблаттом. [11] но он не знал, как это реализовать, [12] хотя непрерывный предшественник обратного распространения ошибки уже использовался в контексте теории управления в 1960 году Генри Дж. Келли . [5] [12] Он известен также как обратный режим автоматического дифференцирования .

- В 1982 году обратное распространение ошибки было применено способом, ставшим стандартным, впервые Полом Вербосом . [7] [12]

- В 1985 году экспериментальный анализ метода был проведен Дэвидом Э. Румельхартом и др.. [8] В последующие десятилетия в этот подход было внесено множество усовершенствований. [12]

- В 1987 году, используя стохастический градиентный спуск в (широкой 12-слойной нелинейной) сети прямого распространения, Мэтью Брэнд обучил ее воспроизводить логические функции нетривиальной глубины схемы, используя небольшие партии случайных входных/выходных выборок. Он, однако, пришел к выводу, что на аппаратном обеспечении (компьютерах с субмегафлопсной производительностью), доступном в то время, это было непрактично, и предложил использовать фиксированные случайные ранние слои в качестве входного хеша для одного изменяемого слоя. [20]

- В 1990-х годах появилась (гораздо более простая) альтернатива использованию нейронных сетей, хотя и все еще связанная с ней. [21] Машинный подход опорных векторов был разработан Владимиром Вапником и его коллегами. Помимо выполнения линейной классификации , они смогли эффективно выполнить нелинейную классификацию, используя так называемый трюк с ядром , используя многомерные пространства признаков .

- В 2003 году интерес к сетям обратного распространения ошибки вернулся благодаря успехам глубокого обучения , примененного к языковому моделированию Йошуа Бенджио с соавторами. [22]

- В 2017 году современные архитектуры трансформаторов были представлены в статье « Внимание — это все, что вам нужно ». [23]

Математические основы

[ редактировать ]Функция активации

[ редактировать ]Две исторически распространенные функции активации являются сигмоидами и описываются формулой

- .

Первая представляет собой гиперболический тангенс , который находится в диапазоне от -1 до 1, а вторая — логистическая функция , которая аналогична по форме, но находится в диапазоне от 0 до 1. Здесь это результат -й узел (нейрон) и — взвешенная сумма входных соединений. Были предложены альтернативные функции активации, включая функции выпрямителя и softplus . К более специализированным функциям активации относятся радиальные базисные функции (используемые в радиальных базисных сетях — другом классе контролируемых моделей нейронных сетей).

В недавних разработках глубокого обучения выпрямленная линейная единица (ReLU) чаще используется как один из возможных способов преодоления числовых проблем, связанных с сигмоидами.

Обучение

[ редактировать ]Обучение происходит путем изменения весов соединений после обработки каждого фрагмента данных в зависимости от количества ошибок в выходных данных по сравнению с ожидаемым результатом. Это пример обучения с учителем , который осуществляется посредством обратного распространения ошибки .

Мы можем представить степень ошибки в выходном узле в -я точка данных (обучающий пример) по , где желаемое целевое значение для Точка данных в узле , и значение, произведенное в узле когда эта точка данных предоставляется в качестве входных данных.

Затем веса узлов можно скорректировать на основе поправок, которые минимизируют ошибку во всем выводе для th точка данных, заданная

- .

Используя градиентный спуск , изменение каждого веса является

где это выход предыдущего нейрона , и — скорость обучения , которая выбирается для того, чтобы веса быстро сходились к ответу, без колебаний. В предыдущем выражении обозначает частичную производную ошибки по взвешенной сумме входных связей нейрона .

Производная, которую необходимо вычислить, зависит от индуцированного локального поля , который сам по себе варьируется. Легко доказать, что для выходного узла эту производную можно упростить до

где является производной описанной выше функции активации, которая сама по себе не меняется. Анализ более сложен для изменения весов в скрытом узле, но можно показать, что соответствующая производная равна

- .

Это зависит от изменения веса th узлов, которые представляют выходной слой. Таким образом, чтобы изменить веса скрытого слоя, веса выходного слоя изменяются в соответствии с производной функции активации, и поэтому этот алгоритм представляет собой обратное распространение функции активации. [24]

История

[ редактировать ]Линейная нейронная сеть

[ редактировать ]Самый простой вид нейронной сети прямого распространения — это линейная сеть, состоящая из одного слоя выходных узлов; входные данные подаются непосредственно на выходные через ряд весов. Сумма произведений весов и входных данных рассчитывается в каждом узле. Среднеквадратические ошибки между этими рассчитанными выходными данными и заданными целевыми значениями сводятся к минимуму за счет корректировки весов. Этот метод известен уже более двух столетий как метод наименьших квадратов или линейная регрессия . (1795 г.) использовали его как средство нахождения хорошей грубой линейной аппроксимации набора точек Лежандр (1805 г.) и Гаусс для предсказания движения планет. [25] [26] [27] [12] [28]

Персептрон

[ редактировать ]Если используется порог, то есть линейная функция активации , результирующая линейная пороговая единица называется персептроном . (Часто этот термин используется для обозначения только одной из этих единиц.) Несколько параллельных нелинейных единиц способны аппроксимировать любую непрерывную функцию из компактного интервала действительных чисел в интервал [-1,1], несмотря на ограниченную вычислительную мощность. единичного устройства с линейной пороговой функцией. Этот результат можно найти у Питера Ауэра, Харальда Бургштайнера и Вольфганга Маасса «Правило обучения для очень простых универсальных аппроксиматоров, состоящих из одного слоя перцептронов». [29]

Перцептроны можно обучать с помощью простого алгоритма обучения, который обычно называют дельта-правилом . Он вычисляет ошибки между вычисленными выходными данными и выборочными выходными данными и использует их для корректировки весов, реализуя тем самым форму градиентного спуска .

Многослойный персептрон

[ редактировать ]

Многослойный перцептрон ( MLP ) — это неправильное название современной искусственной нейронной сети прямого распространения, состоящей из полностью связанных нейронов (отсюда иногда используется синоним полностью связанной сети ( FCN )), часто с нелинейным типом функции активации, организованной по крайней мере в три слоя, отличающиеся возможностью различать данные, которые не являются линейно разделимыми . [30]

Другие сети прямой связи

[ редактировать ]

Примеры других сетей прямого распространения включают сверточные нейронные сети и сети радиальных базисных функций , которые используют другую функцию активации.

См. также

[ редактировать ]Ссылки

[ редактировать ]- ^ Ферри К. и Кайзер С. (2019). Нейронные сети для детей . Справочники. ISBN 978-1492671206 .

{{cite book}}: CS1 maint: несколько имен: список авторов ( ссылка ) - ^ Jump up to: а б Зелл, Андреас (1994). сетей ( Моделирование нейронных на немецком языке) (1-е изд.). Эддисон Уэсли. п. 73. ИСБН 3-89319-554-8 .

- ^ Шмидхубер, Юрген (01 января 2015 г.). «Глубокое обучение в нейронных сетях: обзор». Нейронные сети . 61 : 85–117. arXiv : 1404.7828 . дои : 10.1016/j.neunet.2014.09.003 . ISSN 0893-6080 . ПМИД 25462637 . S2CID 11715509 .

- ^ Jump up to: а б Линнаинмаа, Сеппо (1970). Представление совокупной ошибки округления алгоритма в виде разложения Тейлора локальных ошибок округления (Мастерс) (на финском языке). Университет Хельсинки. п. 6–7.

- ^ Jump up to: а б Келли, Генри Дж. (1960). «Градиентная теория оптимальных траекторий полета». Журнал АРС . 30 (10): 947–954. дои : 10.2514/8.5282 .

- ^ Розенблатт, Фрэнк. х. Принципы нейродинамики: перцептроны и теория механизмов мозга. Спартанские книги, Вашингтон, округ Колумбия, 1961 г.

- ^ Jump up to: а б Вербос, Пол (1982). «Применение достижений нелинейного анализа чувствительности» (PDF) . Системное моделирование и оптимизация . Спрингер. стр. 762–770. Архивировано (PDF) из оригинала 14 апреля 2016 года . Проверено 2 июля 2017 г.

- ^ Jump up to: а б Румелхарт, Дэвид Э., Джеффри Э. Хинтон и Р. Дж. Уильямс. « Изучение внутренних представлений путем распространения ошибок ». Дэвид Э. Румельхарт, Джеймс Л. Макклелланд и исследовательская группа НДП. (редакторы), Параллельная распределенная обработка: Исследования микроструктуры познания, Том 1: Фонд. Массачусетский технологический институт Пресс, 1986.

- ^ Хасти, Тревор. Тибширани, Роберт. Фридман, Джером. Элементы статистического обучения: интеллектуальный анализ данных, логический вывод и прогнозирование. Спрингер, Нью-Йорк, 2009 г.

- ^ Розенблатт, Франк (1958). «Перцептрон: вероятностная модель хранения и организации информации в мозге». Психологический обзор . 65 (6): 386–408. CiteSeerX 10.1.1.588.3775 . дои : 10.1037/h0042519 . ПМИД 13602029 . S2CID 12781225 .

- ^ Jump up to: а б Розенблатт, Франк (1962). Принципы нейродинамики . Спартан, Нью-Йорк.

- ^ Jump up to: а б с д и ж г час я Шмидхубер, Юрген (2022). «Аннотированная история современного искусственного интеллекта и глубокого обучения». arXiv : 2212.11279 [ cs.NE ].

- ^ Хуан, Гуан-Бин; Чжу, Цинь-Юй; Сью, Чи-Хеонг (2006). «Машина экстремального обучения: теория и приложения». Нейрокомпьютинг . 70 (1): 489–501. CiteSeerX 10.1.1.217.3692 . дои : 10.1016/j.neucom.2005.12.126 . S2CID 116858 .

- ^ Ивахненко, А.Г. (1973). Кибернетические предсказывающие устройства . Информационная корпорация CCM.

- ^ Ивахненко А.Г. ; Григорьевич Лапа, Валентин (1967). Кибернетика и методы прогнозирования . Американский паб Elsevier. Ко.

- ^ Амари, Шуничи (1967). «Теория адаптивного классификатора шаблонов». IEEE-транзакции . ЕС (16): 279-307.

- ^ Родригес, Омар Эрнандес; Лопес Фернандес, Хорхе М. (2010). «Семиотическое размышление о дидактике правила цепочки» . Любитель математики . 7 (2): 321–332. дои : 10.54870/1551-3440.1191 . S2CID 29739148 . Проверено 4 августа 2019 г.

- ^ Лейбниц, Готфрид Вильгельм Фрайгер фон (1920). Ранние математические рукописи Лейбница: перевод с латинских текстов, опубликованных Карлом Иммануэлем Герхардтом с критическими и историческими примечаниями (Лейбниц опубликовал цепное правило в мемуарах 1676 года) . Издательство «Открытый суд». ISBN 9780598818461 .

- ^ Линнаинмаа, Сеппо (1976). «Разложение Тейлора накопленной ошибки округления». БИТ Численная математика . 16 (2): 146–160. дои : 10.1007/bf01931367 . S2CID 122357351 .

- ^ Мэтью Брэнд (1988) Машинное обучение и обучение мозга. Бакалаврская диссертация по методическим исследованиям Чикагского университета, 1988 г. Сообщено в Летнем лингвистическом институте Стэнфордского университета, 1987 г.

- ^ Р. Коллоберт и С. Бенджио (2004). Связи между перцептронами, MLP и SVM. Учеб. Международная конференция. по машинному обучению (ICML).

- ^ Бенджио, Йошуа; Дюшарм, Режан; Винсент, Паскаль; Джанвин, Кристиан (март 2003 г.). «Нейронно-вероятностная языковая модель» . Журнал исследований машинного обучения . 3 : 1137–1155.

- ^ Гева, Мор; Шустер, Рой; Берант, Джонатан; Леви, Омер (2021). «Слои прямой связи трансформатора — это память ключевых значений» . Материалы конференции 2021 года по эмпирическим методам обработки естественного языка . стр. 5484–5495. doi : 10.18653/v1/2021.emnlp-main.446 . S2CID 229923720 .

- ^ Хайкин, Саймон (1998). Нейронные сети: комплексный фундамент (2-е изд.). Прентис Холл. ISBN 0-13-273350-1 .

- ^ Мэнсфилд Мерриман, «Список работ, касающихся метода наименьших квадратов»

- ^ Стиглер, Стивен М. (1981). «Гаусс и изобретение метода наименьших квадратов» . Энн. Стат . 9 (3): 465–474. дои : 10.1214/aos/1176345451 .

- ^ Бретшер, Отто (1995). Линейная алгебра с приложениями (3-е изд.). Река Аппер-Сэдл, Нью-Джерси: Прентис-Холл.

- ^ Стиглер, Стивен М. (1986). История статистики: измерение неопределенности до 1900 года . Кембридж: Гарвард. ISBN 0-674-40340-1 .

- ^ Ауэр, Питер; Харальд Бургштайнер; Вольфганг Маасс (2008). «Правило обучения для очень простых универсальных аппроксиматоров, состоящих из одного слоя перцептронов» (PDF) . Нейронные сети . 21 (5): 786–795. дои : 10.1016/j.neunet.2007.12.036 . ПМИД 18249524 . Архивировано из оригинала (PDF) 6 июля 2011 г. Проверено 8 сентября 2009 г.

- ^ Цыбенко, Г. 1989. Приближение суперпозициями сигмоидальной функции. Математика управления, сигналов и систем , 2 (4), 303–314.