Суперкомпьютер

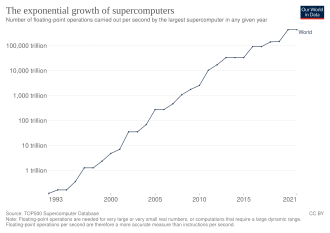

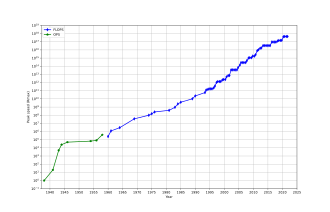

Суперкомпьютер - это тип компьютера с высоким уровнем производительности по сравнению с компьютером общего назначения. Производительность суперкомпьютера обычно измеряется в с плавающей точкой операциях в секунду ( флопах ) вместо миллионов инструкций в секунду (MIPS). С 2017 года существуют суперкомпьютеры, которые могут выполнять более 10 17 Флопы (сотня квадриллиона флопов, 100 Petaflops или 100 Pflops). [ 3 ] Для сравнения, настольный компьютер имеет производительность в диапазоне сотен гигафлопса (10 11 ) до десятков терафлопов (10 13 ). [ 4 ] [ 5 ] С ноября 2017 года все самые быстрые в мире 500 суперкомпьютеров работают в Linux . операционных системах на основе [ 6 ] В Соединенных Штатах, Европейском Союзе, Тайване, Японии и Китае проводится дополнительные исследования для строительства более быстрых, более мощных и технологически превосходных суперкомпьютеров Exascale . [ 7 ]

Суперкомпьютеры играют важную роль в области вычислительной науки и используются для широкого спектра вычислительно интенсивных задач в различных областях, включая квантовую механику , прогнозирование погоды , исследования климата , исследование нефти и газа , молекулярное моделирование (вычисление структур и свойств химических соединений, биологических макромолекул , полимеров и кристаллов) и физического моделирования (например, моделирование ранних моментов вселенной, самолета и аэродинамики космического корабля , детонация ядерного оружия и ядерное слияние ). Они были важны в области криптонализа . [ 8 ]

Суперкомпьютеры были введены в 1960 -х годах, и в течение нескольких десятилетий, самых быстрых, были сделаны Seymour Cray в Control Data Corporation (CDC), Cray Research и последующими компаниями, носящими его именем или монограммой. Первыми такими машинами были высоко настроенные обычные дизайны, которые работали быстрее, чем их более общие современники. В течение десятилетия увеличение количества параллелизма было добавлено , причем от одного до четырех процессоров было типичным. В 1970 -х годах векторные процессоры, работающие на больших массивах данных, стали доминировать. Примечательным примером является очень успешный Cray-1 от 1976 года. Векторные компьютеры оставались доминирующим дизайном в 1990-х годах. С тех пор до сегодняшнего дня массово параллельные суперкомпьютеры с десятками тысяч готовых процессоров стали нормой. [ 9 ] [ 10 ]

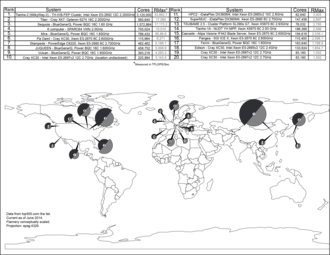

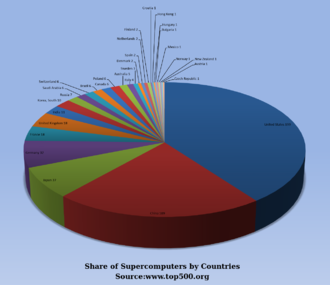

США долгое время были лидером в области суперкомпьютеров, сначала благодаря почти непрерывному доминированию Крэя в этой области, а затем через различные технологические компании. Япония добилась больших успехов в этой области в 1980 -х и 90 -х годах, и Китай становится все более активным в этой области. По состоянию на май 2022 года самым быстрым суперкомпьютером в списке суперкомпьютеров TOP500 является Frontier , в США, с оценкой эталона Linpack 1,102 Exaflop/S, затем Fugaku . [ 11 ] У США пять из 10 лучших; В Китае два; Япония, Финляндия и Франция имеют по одному. [ 12 ] В июне 2018 года все комбинированные суперкомпьютеры в списке Top500 преодолели отметку из 1 Exaflops . [ 13 ]

История

[ редактировать ]

В 1960 году Univac построил атомный исследовательский компьютер Livermore (LARC), сегодня рассматриваемый среди первых суперкомпьютеров для Центра исследований и разработок ВМС США. Он по-прежнему использовал высокоскоростную барабанную память , а не вновь появляющуюся технологию диска . [ 14 ] Кроме того, среди первых суперкомпьютеров был участок IBM 7030 . IBM 7030 был построен IBM для Национальной лаборатории Лос -Аламоса , которая затем в 1955 году запросила компьютер в 100 раз быстрее, чем любой существующий компьютер. IBM 7030 использовали транзисторы , магнитную память ядра, конвейерные инструкции, предварительные данные через контроллер памяти и включали новаторские дисковые диски случайного доступа. IBM 7030 был завершен в 1961 году, и, несмотря на то, что он не выполнил задачу в сотне роста производительности, он был приобретен Национальной лабораторией Лос -Аламоса. Клиенты в Англии и Франции также купили компьютер, и он стал основой для Harvest IBM 7950 , суперкомпьютера, созданного для криптанализа . [ 15 ]

Третьим новаторским проектом суперкомпьютеров в начале 1960 -х годов был Атлас в Университете Манчестера , построенный командой во главе с Томом Килберном . Он разработал атлас, чтобы иметь пространство памяти до миллиона слов из 48 бит, но поскольку магнитное хранилище с такой способностью было недоступно, фактическая основная память об атласе составляла всего 16 000 слов, причем барабан обеспечивает память еще 96 000 слова Супервизор Atlas поменял данные в виде страниц между магнитным ядром и барабаном. Операционная система Atlas также ввела в суперкомпьютеры, так что в суперкомпьютере можно было выполнить более одной программы на суперкомпьютере. [ 16 ] Атлас был совместным предприятием между Университетом Ферранти и Манчестера и был разработан для работы на скорости обработки, приближающимися к одной микросекунде на инструкции, около миллиона инструкций в секунду. [ 17 ]

CDC 6600 , разработанный Seymour Cray , был закончен в 1964 году и отметил переход от германия к кремниевым транзисторам. Кремниевые транзисторы могут работать быстрее, а проблема перегрева была решена путем введения охлаждения в дизайн суперкомпьютеров. [ 18 ] Таким образом, CDC6600 стал самым быстрым компьютером в мире. Учитывая, что 6600 превзошли все другие современные компьютеры примерно в 10 раз, его назвали суперкомпьютером и определили рынок суперкомпьютеров, когда сто компьютеров продавались по 8 миллионов долларов каждая. [ 19 ] [ 20 ] [ 21 ] [ 22 ]

Крей покинул CDC в 1972 году, чтобы сформировать свою собственную компанию Cray Research . [ 20 ] Через четыре года после выхода из CDC Cray доставил 80 МГц Cray-1 в 1976 году, который стал одним из самых успешных суперкомпьютеров в истории. [ 23 ] [ 24 ] CRAY -2 был выпущен в 1985 году. У него было восемь центральных перерабатывающих единиц (процессоров), жидкое охлаждение жидкости электроники , а флуоринерт был накачан через архитектуру суперкомпьютера . Он достиг 1,9 гигафлопса , что сделало его первым суперкомпьютером, который преодолел барьер гигафлопа. [ 25 ]

Массивно параллельные дизайны

[ редактировать ]

Единственным компьютером, который серьезно бросил вызов производительности CRAY-1 в 1970-х годах, был ILLIAC IV . Эта машина была первым реализованным примером истинного массово параллельного компьютера, в котором многие процессоры работали вместе, чтобы решить разные части одной более крупной проблемы. В отличие от векторных систем, которые были разработаны для того, чтобы как можно быстрее запустить один поток данных, в этой концепции компьютер вместо этого подает отдельные части данных в совершенно разные процессоры, а затем рекомбинирует результаты. Дизайн ILLIAC был завершен в 1966 году с 256 процессорами и обеспечивает скорость до 1 GFLOP, по сравнению с пиком Cray-1 1970-х годов 250 MFLOP. Тем не менее, проблемы разработки привели только к строительству только 64 процессоров, и система никогда не могла работать быстрее, чем около 200 Мффопов, одновременно намного больше и сложнее, чем ук. Другая проблема заключалась в том, что написание программного обеспечения для системы было трудным, и получить пиковую производительность от нее было вопросом серьезных усилий.

Но частичный успех ILLIAC IV широко рассматривался как указывающий путь к будущему суперкомпьютинг. Крэй выступил против этого, классно резко резко приводил в себя: «Если бы вы вспахали поле, что бы вы предпочли использовать? Два сильных вола или 1024 цыплят?» [ 26 ] Но к началу 1980 -х годов несколько команд работали над параллельными дизайнами с тысячами процессоров, в частности, на соединительной машине (CM), которая разработана на основе исследований в MIT . CM-1 использовал до 65 536 упрощенных пользовательских микропроцессоров, соединенных вместе в сети для обмена данными. Последовали несколько обновленных версий; Суперкомпьютер CM-5-это массово параллельная обработка компьютера, способного составлять многие миллиарды арифметических операций в секунду. [ 27 ]

В 1982 году Осаки компьютерная графическая графическая система Университета Links-1 использовала массово параллельную архитектуру обработки с 514 микропроцессорами , в том числе 257 Zilog Z8001 процессоров управления и 257 процессоров IAPX 86/20 с плавающей запятой . Он был в основном использован для отмены реалистичной 3D -компьютерной графики . [ 28 ] VPP500 Fujitsu с 1992 года является необычным, поскольку для достижения более высоких скоростей его процессоры использовали GAAS , материал, обычно зарезервированный для микроволновых применений из -за ее токсичности. [ 29 ] Fujitsu Суперкомпьютер численного ветровых туннелей использовал 166 векторных процессоров, чтобы получить первое место в 1994 году с пиковой скоростью 1,7 гигафлопса (GFLOPS) на процессор. [ 30 ] [ 31 ] Hitachi SR2201 получил пиковую производительность 600 GFLOPS в 1996 году, используя 2048 процессоров, подключенных через быструю трехмерную сеть поперечной штанги . [ 32 ] [ 33 ] [ 34 ] Paragon Intel может иметь от 1000 до 4000 процессоров Intel I860 в различных конфигурациях и был ранжирован самым быстрым в мире в 1993 году. Парагон представлял собой машину MIMD , которая подключила процессоры с помощью высокоскоростной двумерной сетки, позволяя процессам выполнять отдельные узлы. , общение через интерфейс прохождения сообщения . [ 35 ]

Разработка программного обеспечения оставалась проблемой, но серия CM вызвала значительные исследования этой проблемы. Аналогичные дизайны с использованием пользовательского оборудования были сделаны многими компаниями, включая Evans & Sutherland ES-1 , Maspar , NCUBE , Intel IPSC и Goodyear MPP . Но к середине 1990-х годов производительность процессора общего назначения настолько улучшилась в том, что суперкомпьютер мог быть построен с использованием их в качестве отдельных единиц обработки, вместо использования пользовательских чипов. К началу 21 -го века дизайны с десятками тысяч товарных процессоров были нормой, а более поздние машины добавляют графические единицы в микс. [ 9 ] [ 10 ]

В 1998 году Дэвид Бадер разработал первый суперкомпьютер Linux с использованием товарных деталей. [ 36 ] Находясь в Университете Нью-Мексико, Бадер стремился построить суперкомпьютер, использующий Linux, используя потребительские готовые детали и высокоскоростную сеть взаимосвязи с низкой задержкой. Прототип использовал Alta Technologies «AltaCluster» из восьми двойных, 333 МГц, Intel Pentium II компьютеров с модифицированным ядром Linux. Bader перенес значительное количество программного обеспечения для обеспечения поддержки Linux для необходимых компонентов, а также кода от членов Национального альянса по вычислительной науке (NCSA) для обеспечения совместимости, поскольку ни один из них не был запущен на Linux ранее. [ 37 ] Используя успешный дизайн прототипа, он руководил разработкой «Roadrunner», первого суперкомпьютера Linux для открытого использования национальным научным и инженерным сообществом через Национальную технологическую сеть Национального научного фонда. Roadrunner был введен в производство в апреле 1999 года. На момент развертывания он считался одним из 100 самых быстрых суперкомпьютеров в мире. [ 37 ] [ 38 ] Хотя кластеры на основе Linux, использующие детали потребительского уровня, такие как Beowulf , существовали до разработки прототипа Bader и Roadrunner, им не хватало масштабируемости, пропускной способности и параллельных вычислительных возможностей, которые должны считать «истинными» суперкомпьютерами. [ 37 ]

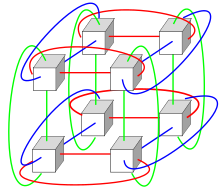

Системы с огромным количеством процессоров обычно проходят один из двух путей. В подходе вычисления сетки мощность обработки многих компьютеров, организованных как распределенные, разнообразные административные домены, оппортунистически используется всякий раз, когда доступен компьютер. [ 39 ] В другом подходе многие процессоры используются в непосредственной близости от друг друга, например, в компьютерном кластере . В такой централизованной массово параллельной системе скорость и гибкость Interconnect становится очень важным, и современные суперкомпьютеры использовали различные подходы, начиная от расширенных систем Infiniband до трехмерных межсоединений Torus . [ 40 ] [ 41 ] Использование многоядерных процессоров в сочетании с централизацией является новым направлением, например, как в системе Cyclops64 . [ 42 ] [ 43 ]

По мере того, как цена, производительность и энергоэффективность единиц обработки графики общего назначения (GPGPU) улучшились, ряд суперкомпьютеров Petaflops, таких как Tianhe-I и Debulae, начали полагаться на них. [ 44 ] Тем не менее, другие системы, такие как компьютер K, продолжают использовать обычные процессоры, такие как проекты на основе SPARC , и общая применимость GPGPU в высокопроизводительных вычислительных приложениях общего назначения была предметом дебатов, поскольку в то время как GPGPU может быть настроен Чтобы хорошо оценить конкретные контрольные показатели, его общая применимость к повседневным алгоритмам может быть ограничена, если не будут потрачены значительные усилия для настройки приложения на него. [ 45 ] Тем не менее, графические процессоры набирают обороты, и в 2012 году суперкомпьютер Jaguar был преобразован в Титан путем модернизации процессоров с помощью графических процессоров. [ 46 ] [ 47 ] [ 48 ]

Высокопроизводительные компьютеры имеют ожидаемый жизненный цикл примерно за три года до того, как потребуется обновление. [ 49 ] Суперкомпьютер Gyoukou уникален тем, что использует как массово параллельный дизайн, так и жидкое погружение .

Суперкомпьютеры специального назначения

[ редактировать ]Был разработан ряд специальных систем, посвященных одной проблеме. Это позволяет использовать специально запрограммированные чипы FPGA или даже пользовательские ASIC , что позволяет лучшие соотношения цен/производительность, жертвуя общностью. Примеры суперкомпьютеров специального назначения включают Belle , [ 50 ] Глубокий синий , [ 51 ] и гидра [ 52 ] Для игры в шахматы , гравитационная труба для астрофизики, [ 53 ] MDGRAPE-3 для прогнозирования структуры белка и молекулярной динамики, [ 54 ] и глубокая трещина за разрушение DES Cipher . [ 55 ]

Использование энергии и управление теплом

[ редактировать ]

В течение десятилетий управление плотностью тепла оставалось ключевой проблемой для большинства централизованных суперкомпьютеров. [ 58 ] [ 59 ] [ 60 ] Большое количество тепла, генерируемого системой, также может иметь другие эффекты, например, сокращение срока службы других компонентов системы. [ 61 ] Были разнообразные подходы к управлению теплением, от перекачки флуоринерта через систему, до гибридной системы охлаждения жидкости или воздушного охлаждения с нормальными кондиционирования воздуха . температурами [ 62 ] [ 63 ] Типичный суперкомпьютер потребляет большое количество электрической мощности, почти все из которых преобразуются в тепло, требующее охлаждения. Например, Tianhe-1a потребляет 4,04 мегаватта (MW) электричества. [ 64 ] Стоимость питания и охлаждения Система может быть значительной, например, 4 МВт в 0,10 долл. США/кВт -ч составляет 400 долл. США в час или около 3,5 млн. Долл. США в год.

Управление теплом является основной проблемой в сложных электронных устройствах и по -разному влияет на мощные компьютерные системы. [ 65 ] Проблемы мощности тепловой конструкции и рассеяния мощности процессора при суперкомпьютинге превосходят проблемы традиционных технологий компьютерного охлаждения . Награды суперкомпьютинг за зеленые вычисления отражают эту проблему. [ 66 ] [ 67 ] [ 68 ]

Упаковка тысяч процессоров вместе неизбежно генерирует значительное количество тепловой плотности , с которыми необходимо справиться. Cray -2 был охлажден жидким охлаждением и использовал фторинерный «охлаждающий водопад», который был вынужден через модули под давлением. [ 62 ] Тем не менее, подход по затоплению жидкого охлаждения не был практичным для многокабиновых систем, основанных на готовых процессорах, а в системе X специальная система охлаждения, которая объединила кондиционер с жидким охлаждением, была разработана в сочетании с компанией Liebert . [ 63 ]

В системе синих генов IBM намеренно использовал процессоры с низкой мощностью для борьбы с тепловой плотностью. [ 69 ] IBM Power 775 , выпущенный в 2011 году, имеет тесно упакованные элементы, которые требуют водяного охлаждения. [ 70 ] Система IBM Aquasar использует охлаждение горячей воды для достижения энергоэффективности, а также вода используется для нагрева зданий. [ 71 ] [ 72 ]

Экономическая эффективность компьютерных систем обычно измеряется с точки зрения « провалов на ватт ». В 2008 году Roadrunner от IBM работал в 376 MFLOPS/W . [ 73 ] [ 74 ] В ноябре 2010 года синий ген/Q достиг 1684 мфлопса/w [ 75 ] [ 76 ] А в июне 2011 года два лучших места в списке зеленых 500 были заняты синими генными машинами в Нью -Йорке (один достигнут 2097 мфлпс/Вт) с кластером Degima в Нагасаки, заняв третье место с 1375 мфлупс/w. [ 77 ]

Поскольку медные провода могут переносить энергию в суперкомпьютер с гораздо более высокой плотностью мощности, чем принудительный воздух или циркуляционные хладагенты могут удалить отходы , [ 78 ] Способность систем охлаждения удалять тепло отходов является ограничивающим фактором. [ 79 ] [ 80 ] По состоянию на 2015 год [update]Многие существующие суперкомпьютеры обладают большей инфраструктурной способностью, чем фактический пиковой спрос машины - дизайнеры, как правило, консервативно разрабатывают инфраструктуру мощности и охлаждения, чтобы справиться больше, чем теоретическая пиковая электрическая мощность, потребляемая суперкомпьютером. Проекты для будущих суперкомпьютеров ограничены мощностью- мощность тепловой конструкции суперкомпьютера в целом, количество, которое может обрабатывать инфраструктуру мощности и охлаждения, является несколько больше, чем ожидаемое нормальное энергопотребление, но меньше теоретического пикового энергопотребления электронное оборудование. [ 81 ]

Управление программным обеспечением и системой

[ редактировать ]Операционные системы

[ редактировать ]С конца 20 -го века операционные системы суперкомпьютеров претерпели серьезные преобразования, основанные на изменениях в архитектуре суперкомпьютеров . [ 82 ] В то время как ранние операционные системы были специально адаптированы к каждому суперкомпьютеру для достижения скорости, эта тенденция заключалась в том, чтобы отойти от внутренних операционных систем к адаптации общего программного обеспечения, такого как Linux . [ 83 ]

Поскольку современные массово параллельные суперкомпьютеры обычно отделяют вычисления от других служб с использованием нескольких типов узлов , они обычно запускают различные операционные системы на разных узлах, например, используя небольшое и эффективное легкое ядро , такое как CNK или CNL на вычислительных узлах, но более крупная система такой как Linux -Derivative на сервере и узлах ввода -вывода . [ 84 ] [ 85 ] [ 86 ]

Хотя в традиционном многопользовательском планировании заданий компьютерной системы , по сути, является задачей задачи для обработки и периферийных ресурсов, в массовой параллельной системе система управления работой необходимо для управления распределением как вычислительных, так и коммуникационных ресурсов, а также ресурсов, а также Изящно справляются с неизбежными сбоями аппаратного обеспечения, когда присутствуют десятки тысяч процессоров. [ 87 ]

Хотя большинство современных суперкомпьютеров используют операционные системы на основе Linux , каждый производитель имеет свой собственный специфический производство Linux, и нет отраслевого стандарта, отчасти из -за того, что различия в аппаратных архитектурах требуют изменений для оптимизации операционной системы в каждую конструкцию оборудования. [ 82 ] [ 88 ]

Программные инструменты и передача сообщений

[ редактировать ]

Параллельные архитектуры суперкомпьютеров часто диктуют использование специальных методов программирования для использования их скорости. Программные инструменты для распределенной обработки включают стандартные API, такие как MPI [ 90 ] и программное обеспечение PVM , VTL и с открытым исходным кодом , такие как Beowulf .

В наиболее распространенном сценарии такие среды, как PVM и MPI для слабо связанных кластеров и OpenMP используются для плотно скоординированных машин общей памяти. Требуются значительные усилия, чтобы оптимизировать алгоритм для взаимосвязанных характеристик машины, на которой он будет работать; Цель состоит в том, чтобы не дать любому процессору тратить время, ожидая данных из других узлов. GPGPU имеют сотни ядер процессоров и запрограммированы с использованием моделей программирования, таких как CUDA или OpenCL .

Более того, довольно сложно отлаживать и тестировать параллельные программы. Специальные методы должны использоваться для тестирования и отладки таких приложений.

Распределенные суперкомпьютинг

[ редактировать ]Оппортунистические подходы

[ редактировать ]

Оппортунистическая суперкомпьютинг - это форма сетевых вычислений сетки , в которой «супер виртуальный компьютер» из многих свободно связанных добровольных вычислительных машин выполняет очень большие вычислительные задачи. Сетчатые вычисления были применены к ряду крупномасштабных смущающих параллельных задач, которые требуют суперкомпьютерных масштабов производительности. Тем не менее, базовые подходы к сетке и облачным вычислениям , которые полагаются на волонтерские вычисления, не могут обрабатывать традиционные суперкомпьютерные задачи, такие как динамическое моделирование жидкости. [ 91 ]

Самая быстрая вычислительная система сетки - это волонтерский вычислительный проект Folding@Home (F@H). По состоянию на апрель 2020 года [update], F@H сообщил о 2,5 Exaflops of x86 Processing Power. Из этого более 100 PFLOP получают клиенты, работающие на различных графических процессорах, а остальные из различных систем процессора. [ 92 ]

Платформа Berkeley Open Infrastructure для сетевых вычислений (BOINC) проводит ряд проектов добровольных компьютеров. По состоянию на февраль 2017 года [update], Boinc записал обработку более 166 Petaflops в более чем 762 тысячи активных компьютеров (хост) в сети. [ 93 ]

По состоянию на октябрь 2016 года [update], Great Internet Internet Mersenne Prime Search (GIMPS) Distributed Mersenne Prime Search достиг около 0,313 PFLOP за более чем 1,3 миллиона компьютеров. [ 94 ] Сервер Primenet поддерживает подход GIMPS GRID, один из самых ранних добровольных вычислительных проектов с 1997 года.

Квази-оппортунистические подходы

[ редактировать ]Квази-оппортунистическое суперкомпьютинг-это форма распределенных вычислений , в которой «супер виртуальный компьютер» многих сетевых географически диспергированных компьютеров выполняет вычислительные задачи, которые требуют огромной мощности обработки. [ 95 ] Квази-оппортунистическое суперкомпьютинг направлен на обеспечение более высокого качества обслуживания, чем оппортунистические вычисления сетки, путем достижения большего контроля над назначением задач распределенным ресурсам и использования интеллекта в отношении доступности и надежности отдельных систем в сети суперопиния. Тем не менее, квази-оппортунистическое распределенное выполнение требовательного программного обеспечения для параллельных вычислительных вычислений в сетках должно быть достигнуто посредством реализации соглашений о распределении сетей, подсистемы совместного распределения, механизмов распределения топологии связи, передачи библиотеков, толерантных сообщений о неисправности и предварительных условий данных. [ 95 ]

Высокопроизводительные вычислительные облака

[ редактировать ]Облачные вычисления с его недавними и быстрыми расширениями и разработкой привлекли внимание пользователей и разработчиков высокопроизводительных вычислений (HPC) и разработчиков. Облачные вычисления пытаются предоставить HPC-как услуга точно так же, как и другие формы услуг, доступных в облаке, таких как программное обеспечение в качестве услуги , платформа в качестве услуги и инфраструктура в качестве услуги . Пользователи HPC могут извлечь выгоду из облака под разными углами, такими как масштабируемость, ресурсы по требованию, быстрые и недорогие. С другой стороны, у перемещения приложений HPC также есть набор проблем. Хорошими примерами таких проблем являются накладные расходы на виртуализацию в облаке, многоцелевые ресурсы и проблемы с задержкой сети. В настоящее время проводится много исследований, чтобы преодолеть эти проблемы и сделать HPC в облаке более реалистичной возможностью. [ 96 ] [ 97 ] [ 98 ] [ 99 ]

В 2016 году Penguin Computing, Parallel Works, R-HPC, Amazon Web Services , Univa , Silicon Graphics International , Rescale , Sabalcore и Gomput начали предлагать облачные вычисления HPC . Облако Penguin on Demand (POD) представляет собой модель вычислительной работы с голой металлом для выполнения кода, но каждому пользователю дается виртуализированный узел входа в систему. Узлы вычислений POD подключены через не виртуализированные сети 10 Гбит/с Ethernet или QDR Infiniband . POD Подключение пользователя к центру обработки данных варьируется от 50 Мбит/с до 1 Гбит/с. [ 100 ] Ссылаясь на Amazon Ec2 Elastic Compute Cloud, Penguin Computing утверждает, что виртуализация вычислительных узлов не подходит для HPC. Penguin Computing также подвергли критике, что облака HPC могут выделять вычислительные узлы для клиентов, которые находятся далеко друг от друга, что вызывает задержку, которая ухудшает производительность для некоторых приложений HPC. [ 101 ]

Измерение производительности

[ редактировать ]Способность против пропускной способности

[ редактировать ]Суперкомпьютеры, как правило, стремятся к максимум в вычислениях возможностей, а не на вычислениях емкости. Вычисление возможностей обычно рассматривается как использование максимальной вычислительной мощности для решения одной большой проблемы в кратчайшие сроки. Часто система возможностей способна решить проблему размера или сложности, которую не может ни один другой компьютер, например, очень сложное применение имитации с погодой . [ 102 ]

Вычисление пропускной способности, напротив, обычно считается использованием эффективной экономически эффективной вычислительной мощности для решения нескольких несколько больших проблем или многих небольших проблем. [ 102 ] Архитектуры, которые придают себе поддержку многих пользователей для обычных повседневных задач, могут иметь большую способность, но обычно не считаются суперкомпьютерами, учитывая, что они не решают ни одной очень сложной проблемы. [ 102 ]

Показатели производительности

[ редактировать ]

В целом, скорость суперкомпьютеров измеряется и сравнивается в флопах (операции с плавающей точкой в секунду), а не с точки зрения MIP (миллион инструкций в секунду), как в случае с компьютерами общего назначения. [ 103 ] Эти измерения обычно используются с префиксом SI , таким как тера- , объединенные в сокращенные TFLOPS (10 12 Флопы, выраженные терафлопы ) или Peta- , объединенные в сокращенные PFLOP (10 15 Флопы, произносится Petaflops .) Суперкомпьютеры Petascale могут обрабатывать один квадриллион (10 15 ) (1000 трлн) провалы. Exascale вычисляет производительность в диапазоне Exaflops (EFLOPS). Eflops - это один квинтиллион (10 18 ) Провалы (один миллион TFLOPS). Тем не менее, на производительность суперкомпьютера может быть сильно повлиять на колебания, вызванные такими элементами, как системный нагрузка, сетевой трафик и параллельные процессы, как упоминалось Brehm и Bruhwiler (2015). [ 104 ]

Ни одно число не может отражать общую производительность компьютерной системы, однако целью эталона Linpack является приближение того, как быстро компьютер решает численные проблемы, и он широко используется в отрасли. [ 105 ] Измерение флопов либо цитируется на основе теоретической производительности процессора процессора (полученных из спецификаций процессора производителя и показано как «rPeak» в списках TOP500), что, как правило, недостижимо при запуске реальных рабочи тесты Linpack и показаны как «Rmax» в списке TOP500. [ 106 ] Трикорец Linpack обычно выполняет разложение LU большой матрицы. [ 107 ] Производительность Linpack дает некоторое представление о производительности для некоторых реальных проблем, но не обязательно соответствует требованиям обработки многих других рабочих нагрузок суперкомпьютера, которые, например, могут потребовать большей пропускной способности памяти или могут потребовать более высоких показателей численности вычислений или могут потребоваться Система ввода -вывода высокой производительности для достижения высокого уровня производительности. [ 105 ]

Список TOP500

[ редактировать ]

С 1993 года самые быстрые суперкомпьютеры были ранжированы в списке TOP500 в соответствии с результатами их эталона Linpack . Список не претендует на смещение или окончательный, но это широко цитируемое текущее определение «самого быстрого» суперкомпьютера, доступного в любой момент времени.

Это список компьютеров, которые появились в верхней части списка Top500 с июня 1993 года, [ 108 ] и «пиковая скорость» дается как рейтинг «Rmax». В 2018 году Lenovo стал крупнейшим в мире поставщиком суперкомпьютеров TOP500 с 117 производителями. [ 109 ]

| Ранг (предыдущий) | Rmax

Rpeak (PETA Flops ) |

Имя | Модель | ЦП Ядра | Акселераторные (например, графические процессоры) | Взаимосвязь | Производитель | Сайт

страна |

Год | Работа

система |

|---|---|---|---|---|---|---|---|---|---|---|

| 1 |

1,102.00

1,685.65 |

Граница | HPE Cray Ex235a | 591,872

(9,248 × 64-ядерный оптимизированный 3-е поколение EPYC 64C при 2,0 ГГц) |

36,992 × 220 AMD Инстинкт Mi250x | Slingshot-11 | HPE | Национальная лаборатория Ок -Ридж |

2022 | Linux ( HPE Cray OS ) |

| 2 |

442.010

537.212 |

Фугаку | Суперкомпьютер Фугаку | 7,630,848

(158,976 × 48-ядерный Fujitsu A64FX @2,2 ГГц) |

0 | Тофу взаимодействие d | Fujitsu | Центр вычислительной науки Рикена |

2020 | Linux ( Rhel ) |

| 3 |

309.10

428.70 |

Комната | HPE Cray Ex235a | 150,528

(2352 × 64-ядерный оптимизированный 3-й поколение EPYC 64C при 2,0 ГГц) |

9,408 × 220 AMD Инстинкт Mi250x | Slingshot-11 | HPE | Eurohpc после всех каджани |

2022 | Linux ( HPE Cray OS ) |

| 4 |

174.70

255.75 |

Леонардо | Bull Sectectana XH2000 | 110,592

(3456 × 32-ядерный Xeon Platinum 8358 при 2,6 ГГц) |

13 824 × 108 NVIDIA AMPERE A100 | NVIDIA HDR100 Infiniband | Деяние | Eurohpc Ju Bolgana |

2022 | Linux |

| 5 |

148.60

200.795 |

Саммит | IBM Power System AC922 | 202,752

(9 216 × 22-ядерный IBM Power9 @3,07 ГГц) |

27 648 × 80 NVIDIA TESLA V100 | Infiniband Edr | IBM | Национальная лаборатория Ок -Ридж |

2018 | Linux ( RHEL 7.4) |

| 6 |

94.640

125.712 |

Сьерра | IBM Power System S922LC | 190,080

(8 640 × 22-ядерный IBM Power9 @3,1 ГГц) |

17 280 × 80 NVIDIA TESLA V100 | Infiniband Edr | IBM | Национальная лаборатория Лоуренса Ливермор |

2018 | Linux ( Rhel ) |

| 7 |

93.015

125.436 |

Sunwaytaihulight | Sunway Mpp | 10,649,600

(40,960 × 260-ценя Sunway SW26010 при 1,45 ГГц) |

0 | Солнечный путь [ 111 ] | NRCPC | Национальный суперкомпьютерный центр в Вуси |

2016 | Linux (Raisos 2.0.5) |

| 8 |

70.87

93.75 |

Perlmutter | HPE Cray Ex235n | ? × ? | ? × 108 nvidia ampere a100 | Slingshot-10 | HPE | Nersc |

2021 | Linux ( HPE Cray OS ) |

| 9 |

63.460

79.215 |

Селена | Нвидия | 71,680

(1120 × 64-ядерный AMD EPYC 7742 при 2,25 ГГц) |

4480 × 108 NVIDIA AMPERE A100 | Mellanox HDR Infiniband | Нвидия | Нвидия |

2020 | Linux ( Ubuntu 20.04 .1) |

| 10 |

61.445

100.679 |

Tianhe-2 a | TH-IVB-FEP | 427,008

(35 584 × 12-ядерный Intel Xeon E5–2692 V2 @2,2 ГГц) |

35 584 × Матрикс-2000 [ 112 ] 128-яд | Th Express-2 | Пособие | Национальный суперкомпьютерный центр в Гуанчжоу |

2018 [ 113 ] | Linux ( Kylin ) |

Приложения

[ редактировать ]Этот раздел нуждается в расширении . Вы можете помочь, добавив к этому . ( Январь 2020 г. ) |

Стадии приложения суперкомпьютера могут быть обобщены в следующей таблице:

| Десятилетие | ИСПОЛЬЗОВАНИЕ И КОМПЬЮТЕР |

|---|---|

| 1970 -е годы | Прогнозирование погоды, аэродинамические исследования ( Cray-1 ). [ 114 ] |

| 1980 -е годы | Вероятностный анализ, [ 115 ] Моделирование радиационного экранирования [ 116 ] ( CDC Cyber ). |

| 1990 -е годы | Разрыв кода грубой силы ( Eff Des Cracker ). [ 117 ] |

| 2000 -е годы | 3D-моделирование ядерных испытаний в качестве замены юридического поведения ядерного договора о нераспространении ( ASCI Q ). [ 118 ] |

| 2010 -е | Tianhehe - 1a [ 119 ] |

| 2020 -е годы | Научные исследования для профилактики вспышки/исследования электрохимической реакции [ 120 ] |

Компьютер IBM Blue Gene /P использовался для моделирования ряда искусственных нейронов, эквивалентных приблизительно одному проценту коры головного мозга человека, содержащей 1,6 миллиарда нейронов с приблизительно 9 триллионов соединений. Та же исследовательская группа также удалось использовать суперкомпьютер для имитации ряда искусственных нейронов, эквивалентных всей мозге крысы. [ 121 ]

Современное прогнозирование погоды также зависит от суперкомпьютеров. Национальное администрация океанических и атмосферных ресурсов использует суперкомпьютеры для хронового сотни миллионов наблюдений, чтобы помочь сделать прогнозы погоды более точными. [ 122 ]

В 2011 году проблемы и трудности в продвижении конверта в суперкомпьютинге были подчеркнуты из -за IBM отказа от проекта Petaskale Blue Waters Project. [ 123 ]

Программа расширенного моделирования и вычислений в настоящее время использует суперкомпьютеры для поддержания и имитации ядерного запаса США. [ 124 ]

В начале 2020 года Covid-19 был передним и центром в мире. Суперкомпьютеры использовали разные моделирования, чтобы найти соединения, которые могут потенциально остановить распространение. Эти компьютеры работают в течение десятков часов, используя несколько параллельных запущенных процессоров для моделирования различных процессов. [ 125 ] [ 126 ] [ 127 ]

Разработка и тенденции

[ редактировать ]

В 2010 -х годах Китай, Соединенные Штаты, Европейский Союз и другие соревновались, чтобы быть первыми, кто создал 1 exaflop (10 18 или один квинтиллион) суперкомпьютер. [ 128 ] Эрик П. Унигендиктис из национальных лабораторий Sandia предположил, что Zettaflops (10 21 Или один секс-флоп) компьютер должен выполнить полное моделирование погоды , что может точно охватить двухнедельный промежуток времени. [ 129 ] [ 130 ] [ 131 ] Такие системы могут быть построены около 2030 года. [ 132 ]

Многие симуляции Монте -Карло используют тот же алгоритм для обработки случайно сгенерированного набора данных; В частности, интеграционные уравнения, описывающие процессы физического транспорта , случайные пути , столкновения, а также отложения энергии и импульса нейтронов, фотонов, ионов, электронов и т. Д. Следующий шаг для микропроцессоров может быть в третьем измерении ; И специализируясь на Монте -Карло, многие слои могут быть идентичными, упрощая процесс проектирования и изготовления. [ 133 ]

Стоимость эксплуатации высокопроизводительных суперкомпьютеров возросла, главным образом из -за увеличения энергопотребления. В середине 1990-х годов 10 лучших суперкомпьютера, необходимой в диапазоне 100 киловатт, в 2010 году 10 лучших суперкомпьютеров потребовались от 1 до 2 мегаватт. [ 134 ] Исследование 2010 года, проведенное в эксплуатации DARPA, определило потребление власти как наиболее распространенную проблему в достижении Exascale Computing . [ 135 ] В то время мегаватт в год стоимость потребления энергии стоит около 1 миллиона долларов. Суперкомпьютерные объекты были построены для эффективного удаления растущего количества тепла, производимого современными многоядерными центральными обработками . Основываясь на энергопотреблении в списке суперкомпьютеров Green 500 в период с 2007 по 2011 год, суперкомпьютер с 1 exaflops в 2011 году потребовал бы почти 500 мегаватт. Операционные системы были разработаны для существующего аппаратного обеспечения для сохранения энергии, когда это возможно. [ 136 ] Ядра процессора, не используемые во время выполнения параллелизированного приложения, были помещены в состояния с низким энергопотреблением, что обеспечивает экономию энергии для некоторых суперкомпьютерных приложений. [ 137 ]

Растущая стоимость эксплуатационных суперкомпьютеров была движущей силой в тенденции к объединению ресурсов с помощью распределенной суперкомпьютерной инфраструктуры. Национальные центры суперкомпьютинга впервые появились в США, за которыми последовали Германия и Япония. Европейский союз запустил Партнерство по передовым вычислениям в Европе (PRACE) с целью создания постоянной пан-европейской суперкомпьютерной инфраструктуры с услугами по поддержке ученых по всему Европейскому союзу в портировании, масштабировании и оптимизации суперкомпьютерных приложений. [ 134 ] Исландия построила первый в мире суперкомпьютер нулевого уровня. Расположенный в Центре обработки данных Thor в Рейкьявике , Исландия, этот суперкомпьютер опирается на полностью возобновляемые источники для своей мощности, а не на ископаемое топливо. Более холодный климат также уменьшает необходимость активного охлаждения, что делает его одним из самых зеленых объектов в мире компьютеров. [ 138 ]

Финансирование аппаратного обеспечения суперкомпьютеров также становится все труднее. В середине 1990-х годов 10 лучших суперкомпьютеров стоили около 10 миллионов евро, а в 2010 году 10 лучших суперкомпьютеров потребовали инвестиции от 40 до 50 миллионов евро. [ 134 ] В 2000 -х годах национальные правительства разработали различные стратегии для финансирования суперкомпьютеров. В Великобритании суперкомпьютеры, полностью финансируемые национальным правительством, и высокоэффективные вычисления были поставлены под контроль Национального финансирования. Германия разработала модель смешанного финансирования, объединяя местное государственное финансирование и федеральное финансирование. [ 134 ]

В художественной литературе

[ редактировать ]Примеры суперкомпьютеров в художественной литературе включают HAL 9000 , Multivac , Machine Spects , Glados , Avieful Conflict , Hammer Vulcan , Colossus , Wopr , AM и Deep Ending . Суперкомпьютер из мыслительных машин был упомянут как суперкомпьютер, используемый для последовательности ДНК, извлеченной из сохранившихся паразитов в серии Парка Юрского периода .

Смотрите также

[ редактировать ]- ACM/IEEE Supercomputing Conference

- ACM Sighpc

- Высокопроизводительные вычисления

- Высокопроизводительные технические вычисления

- Jungle Computing

- Nvidia Tesla Personal Supercompuster

- Параллельные вычисления

- Суперкомпьютинг в Китае

- Суперкомпьюте в Европе

- Суперкомпьюте в Индии

- Суперкомпьютинг в Японии

- Седло

- Тестирование высокопроизводительных вычислительных приложений

- Ultra Network Technologies

- Квантовые вычисления

Ссылки

[ редактировать ]- ^ «Объявление IBM Blue Gene» . 03.ibm.com. 26 июня 2007 года. Архивировано из оригинала 8 июля 2007 года . Получено 9 июня 2012 года .

- ^ "Бесстранный" . Аргронная лидерская вычислительная установка . Аргронная национальная лаборатория . Архивировано из оригинала 7 мая 2013 года . Получено 26 марта 2020 года .

- ^ «Список: июнь 2018 года» . Топ 500 . Получено 25 июня 2018 года .

- ^ "AMD PlayStation 5 спецификации графического процесса" . TechPowerup . Получено 11 сентября 2021 года .

- ^ «NVIDIA GEFORCE GT 730 Спецификации» . TechPowerup . Получено 11 сентября 2021 года .

- ^ «Семейство операционной системы / Linux» . Top500.org . Получено 30 ноября 2017 года .

- ^ Андерсон, Марк (21 июня 2017 г.). «Глобальная гонка в отношении Exascale будет стимулировать суперкомпьютинг, ИИ в массы». Spectrum.ieee.org . Получено 20 января 2019 года.

- ^ Лемке, Тим (8 мая 2013 г.). «АНБ открывается на массивном вычислительном центре» . Получено 11 декабря 2013 года .

- ^ Jump up to: а беременный Хоффман, Аллан Р.; и др. (1990). Суперкомпьютеры: направления в технологии и приложениях . Национальные академии. С. 35–47. ISBN 978-0-309-04088-4 .

- ^ Jump up to: а беременный Хилл, Марк Дональд; Жуппи, Норман Пол ; Sohi, Gurindar (1999). Показания в компьютерной архитектуре . Профессиональный залив. С. 40–49. ISBN 978-1-55860-539-8 .

- ^ Пол Алкорн (30 мая 2022 г.). «Frontier Supercompuster с AMD-мощностью прерывает барьер Exascale, теперь самый быстрый в мире» . Аппаратное обеспечение Тома . Получено 30 мая 2022 года .

- ^ «Япония захватывает корону Top500 с суперкомпьютером с питанием от рук - веб -сайт TOP500» . www.top500.org .

- ^ "Развитие производительности" . www.top500.org . Получено 27 октября 2022 года .

- ^ Эрик Г. Шеент; Дэвид Л. Ферро (2007). Компьютеры: история жизни технологии . Jhu Press. п. 57. ISBN 9780801887741 .

- ^ Эрик Г. Шеент; Дэвид Л. Ферро (2007). Компьютеры: история жизни технологии . Jhu Press. п. 56. ISBN 9780801887741 .

- ^ Эрик Г. Шеент; Дэвид Л. Ферро (2007). Компьютеры: история жизни технологии . Jhu Press. п. 58. ISBN 9780801887741 .

- ^ Атлас , Университет Манчестера, архивировал из оригинала 28 июля 2012 года , извлечен 21 сентября 2010 г.

- ^ Супермены , Чарльз Мюррей, Wiley & Sons, 1997.

- ^ Пол Э. Керуцци (2003). История современных вычислений MIT Press. П. 161 . ISBN 978-0-262-53203-7 .

- ^ Jump up to: а беременный Ханнан, Карин (2008). Висконсинский биографический словарь . Государственная история истории. С. 83–84. ISBN 978-1-878592-63-7 .

- ^ Джон Импагляццо; Джон А. Ли (2004). История вычислений в образовании . Springer Science & Business Media. п. 172 . ISBN 978-1-4020-8135-4 .

- ^ Эндрю Р.Л. Кейтон; Ричард Сиссон; Крис Захер (2006). Американский Средний Запад: интерпретирующая энциклопедия . Издательство Университета Индианы. п. 1489. ISBN 978-0-253-00349-2 .

- ^ Чтение в компьютерной архитектуре Марка Дональда Хилла, Нормана Пола Жуппи, Гуриндара Сохи 1999 ISBN 978-1-55860-539-8 Page 41-48

- ^ Вехи в области компьютерных наук и информационных технологий Эдвина Д. Рейли 2003 ISBN 1-57356-521-0 Page 65

- ^ Из -за советской пропаганды иногда можно прочитать, что советский суперкомпьютер M13 был первым, кто достиг барьеры гигафлопса. На самом деле, здание M13 началось в 1984 году, но оно не работало до 1986 года. Рогачев Юрь Васильивич, Российский музей виртуального компьютера

- ^ «Сеймур Крэй цитирует» . Мозговой .

- ^ Стив Нельсон (3 октября 2014 г.). "Computergk.com: суперкомпьютеры" .

- ^ «Ссылки-1 Музей компьютерной графики-компьютер-компьютер» . Museum.ipsj.or.jp .

- ^ «VPP500 (1992) - Fujitsu Global» .

- ^ «Top500 Годовой отчет 1994» . Netlib.org. 1 октября 1996 г. Получено 9 июня 2012 года .

- ^ Н. Хироз и М. Фукуда (1997). «Численные аэродинамические трудные туннели (NWT) и исследования CFD в Национальной аэрокосмической лаборатории». Материалы Высокопроизводительные вычисления на информационном супермагроме. HPC Asia '97 . Труды HPC-ASIA '97. IEEE Computer Societypages. С. 99–103. doi : 10.1109/hpc.1997.592130 . ISBN 0-8186-7901-8 .

- ^ H. Fujii, Y. Yasuda, H. Akashi, Y. Inagami, M. Koga, O. Ishihara, M. Syazwan, H. Wada, T. Sumimoto, Архитектура и производительность Hitachi SR2201 Система параллельных процессоров , разбирательство 11 -й международной параллельной обработки симпозиума, апрель 1997 г., страницы 233–241.

- ^ Y. Iwasaki, Проект CP-PACS, ядерная физика B: Труды, объем 60, выпуски 1–2, январь 1998 г., страницы 246–254.

- ^ AJ van der Steen, Обзор недавних суперкомпьютеров , публикация NCF, Stichting Nationale Computer Computer, Нидерланды, январь 1997 года.

- ^ Масштабируемый вход/вывод: достижение системного баланса Даниэлем А. Рид 2003 ISBN 978-0-262-68142-1 Page 182

- ^ «Дэвид Бадер выбрал для получения премии IEEE Computer Society 2021 года Сидни Фернбаха» . IEEE Computer Society. 22 сентября 2021 года . Получено 12 октября 2023 года .

- ^ Jump up to: а беременный в Бадер, Дэвид А. (2021). «Linux и Supercomputing: как моя страсть к созданию систем COTS привела к революции HPC» . IEEE ANNALS ИСТОРИЯ ИСКУССТВА . 43 (3): 73–80. doi : 10.1109/mahc.2021.3101415 . S2CID 237318907 .

- ^ Флек, Джон (8 апреля 1999 г.). «UM -und, чтобы заработать суперкомпьютер за 400 000 долларов». Albuquerque Journal . п. D1.

- ^ Prodan, Radu; Фарингер, Томас (2007). Сетчатые вычисления: управление экспериментами, интеграция инструментов и научные рабочие процессы . Спрингер. С. 1 –4. ISBN 978-3-540-69261-4 .

- ^ Knight, Will: « IBM создает самый мощный компьютер в мире », NewsCientist.com Service , июнь 2007 г.

- ^ NR Agida; и др. (2005). «Blue Gene/L Torus Interconnection Network | IBM Journal of Research and Development» (PDF) . Сеть взаимосвязи Torus . п. 265. Архивировано из оригинала (PDF) 15 августа 2011 года.

- ^ Ниу, Янвей; Ху, Зян; Барнер, Кеннет ; Гао, Гуан Р. (2005). «Моделирование производительности и оптимизация доступа к памяти на сотовой компьютерной архитектуре Cyclops64» (PDF) . Сеть и параллельные вычисления . Заметки лекции в информатике. Тол. 3779. С. 132–143. doi : 10.1007/11577188_18 . ISBN 978-3-540-29810-6 Полем Архивировано (PDF) из оригинала 9 октября 2022 года.

- ^ Анализ и производительность Результаты вычислений между центральной ценностью на IBM Cyclops64 Гуанминг Тан, Вугранам С. Шридхар и Гуан Р. Гао Журнал суперкомпьютинга 56, номер 1, 1–24 сентября 2011 г.

- ^ Прикетт, Тимофей (31 мая 2010 г.). «Лучшие 500 суперс - задействование графических процессоров» . Thesgister.co.uk.

- ^ Ганс Хакер; Карстен Тринит; Josef Weidendorfer; Матиас Брем (2010). «Рассмотрение GPGPU для центров HPC: стоит ли это усилиться?» Полем В Райнере Келлер; Дэвид Крамер; Ян-Филипп Вайс (ред.). Столкнувшись с многокроушонным температурой: аспекты новых парадигм и технологий в параллельных вычислениях . Springer Science & Business Media. С. 118–121. ISBN 978-3-642-16232-9 .

- ^ Деймон Поэтер (11 октября 2011 г.). «Суперкомпьютер Cray's Titan для Ornl может быть самым быстрым в мире» . Pcmag.com.

- ^ Фельдман, Майкл (11 октября 2011 г.). «Графические процессоры превратят Ягуара Орнла в 20-петафлоп Титан» . Hpcwire.com.

- ^ Тимоти Прикетт Морган (11 октября 2011 г.). «Ок -хребет меняет пятна Джагуара с процессоров на графические процессоры» . Thesgister.co.uk.

- ^ «Суперкомпьютер Netl» архивировал 4 сентября 2015 года на машине Wayback . Страница 2.

- ^ Кондон, JH и K.Thompson, " Belle Chess Hardware ", в успехах в компьютерных шахматах 3 (ed.mrbclarke), Pergamon Press, 1982.

- ^ Hsu, Feng-Hsiung (2002). Позади Deep Blue: строительство компьютера, которое победило чемпиона мира по шахматам . ПРИЗНАЯ УНИВЕРСИТЕТА ПРИСЕТА . ISBN 978-0-691-09065-8 .

- ^ C. Даннингер, У. Лоренц. Шахматный монстр Гидра. Прокурор 14-й Международной конференции по программируемой логике и приложениям (FPL), 2004, Антверпен-Бельгия, LNCS 3203, с. 927-932

- ^ J Makino и M. Taiji, Научные моделирование с компьютерами специального назначения: виноградные системы , Wiley. 1998.

- ^ Riken Пресс-релиз, Завершение компьютерной системы с одним Petaflops для моделирования молекулярной динамики архивировано 2 декабря 2012 года на машине Wayback

- ^ Фонд Electronic Frontier (1998). Cracking DES - секреты исследований шифрования, политики WIRETAP и дизайна чипов . Oreilly & Associates Inc. ISBN 978-1-56592-520-5 .

- ^ Лор, Стив (8 июня 2018 г.). «Переезд, Китай: США снова являются домом для самого быстрого суперкомпьютера в мире» . Нью -Йорк Таймс . Получено 19 июля 2018 года .

- ^ «Список Green500 - ноябрь 2018 года» . TOP500 . Получено 19 июля 2018 года .

- ^ Сюэ-Джун Ян; Сян-ке Ляо; и др. (2011). «Суперкомпьютер Tianhe-1A: его аппаратное и программное обеспечение». Журнал компьютерных наук и техники . 26 (3): 344–351. doi : 10.1007/s02011-011-1137-8 . S2CID 1389468 .

- ^ Супермены: История Сеймура Крэй и технических волшебников, стоящих за суперкомпьютером Чарльза Дж. Мюррея 1997, ISBN 0-471-04885-2 , страницы 133–135

- ^ Параллельная вычислительная жидкость динамика; Последние достижения и будущие направления , под редакцией Рупака Бисваса 2010 ISBN 1-60595-022-X Page 401

- ^ Суперкомпьютинг исследований yongge Huáng 2008, ISBN 1-60456-186-6 , страницы 313–314

- ^ Jump up to: а беременный Параллельные вычисления для обработки и контроля сигнала в реальном времени Мохаммадом Аламгиром Хоссейном 2003, 2003 г. ISBN 978-1-85233-599-1 , страницы 201–202

- ^ Jump up to: а беременный Вычислительная наука - ICCS 2005: 5 -я международная конференция под редакцией Vaidy S. Sunderam 2005, ISBN 3-540-26043-9 , страницы 60–67

- ^ «NVIDIA TESLA GPUS Power World Saster Supercomputer» (пресс -релиз). Нвидия. 29 октября 2010 года. Архивировано с оригинала 2 марта 2014 года . Получено 21 февраля 2011 года .

- ^ Баландин, Александр А. (октябрь 2009 г.). «Лучше вычисления через охлаждение процессора» . IEEE . Архивировано из оригинала 14 июля 2012 года.

- ^ "Зеленый 500" . Green500.org. Архивировано с оригинала 26 августа 2016 года . Получено 14 августа 2011 года .

- ^ «Зеленый 500 список оценивает суперкомпьютеры» . Itnews Australia . Архивировано из оригинала 22 октября 2008 года.

- ^ Wu-Chun Feng (2003). «Обозначение для эффективного суперкомпьютирования | Журнал Queue ACM, том 1 выпуск 7, 10 января 2003 г. DOI 10.1145/957717.9577772» . Очередь . 1 (7): 54. DOI : 10.1145/957717.957772 . S2CID 11283177 .

- ^ «IBM Uncloaks 20 Petaflops Bluegene/Q Super» . Реестр . 22 ноября 2010 г. Получено 25 ноября 2010 года .

- ^ Прикетт, Тимофей (15 июля 2011 г.). « Регистр : IBM 'Blue Waters' Super Node вымывает на берег в августе» . Thesgister.co.uk . Получено 9 июня 2012 года .

- ^ «Суперкомпьютер IBM Hot Water-охлаждаемый живет в Eth Zurich» . Новостная комната IBM . 2 июля 2010 г. Архивировано с оригинала 10 января 2011 года . Получено 16 марта 2020 года .

- ^ Мартин Ламоника (10 мая 2010 г.). "CNET 10 мая 2010 года" . News.cnet.com. Архивировано с оригинала 1 ноября 2013 года . Получено 9 июня 2012 года .

- ^ «Правительство раскрывает самый быстрый компьютер в мире» . CNN . Архивировано из оригинала 10 июня 2008 года.

Выполнение 376 миллионов расчетов для каждого ватта используемого электроэнергии.

- ^ «IBM Roadrunner берет золото в гонке Petaflop» . Архивировано из оригинала 17 декабря 2008 года . Получено 16 марта 2020 года .

- ^ «Список суперкомпьютировки TOP500 раскрывает вычислительные тенденции» . 20 июля 2010 года.

IBM ... Система BlueGene/Q. Установка записи эффективности питания со значением 1680 MFLOPS/W, более чем в два раза больше, чем в следующей лучшей системе.

- ^ «IBM Исследование явного победителя в Green 500» . 18 ноября 2010.

- ^ "Зеленый 500 список" . Green500.org. Архивировано из оригинала 3 июля 2011 года . Получено 16 марта 2020 года .

- ^ Саед Г. Юнис. «Асимптотически нулевые энергетические вычисления с использованием логики восстановления заряда на уровне» . 1994. Страница 14.

- ^ «Горячая тема - проблема охлаждения суперкомпьютеров», архивировав 18 января 2015 года на машине Wayback .

- ^ Ананд Лал Шиппи. «Внутри суперкомпьютера Titan: 299K AMD X86 ядер и 18,6K NVIDIA GPU» . 2012

- ^ Кертис Сторли; Джо Секстон; Скотт Пакин; Майкл Лэнг; Брайан Рейх; Уильям Руст. «Моделирование и прогнозирование энергопотребления высокопроизводительных вычислительных заданий» . 2014.

- ^ Jump up to: а беременный Энциклопедия параллельных вычислений Дэвида Падуи 2011 ISBN 0-387-09765-1 Страницы 426–429

- ^ Знание машин: эссе о технических изменениях Дональда Маккензи 1998 ISBN 0-262-63188-1 Page 149-151

- ^ Euro-Par 2004 Параллельная обработка: 10-я Международная конференция по евро-парне 2004 года, Марко Даелутто, Марко Ваннши и Доменико Лафорненза, ISBN 3-540-22924-8 , стр. 835

- ^ Euro-Par 2006 Параллельная обработка: 12-я Международная конференция евро-партий , 2006 г., Вольфганг Э. Нагель, Вольфганг В. Уолтер и Вольфганг Ленер ISBN 3-540-37783-2 Страница

- ^ Оценка Национальной лабораторной лабораторной лаборатории Оук -Ридж Cray XT3 Садафом Р. Аламом инал Международный журнал высокоэффективных вычислений. Февраль 2008 г. Том. 22 Нет. 1 52–80

- ^ Открыть архитектуру управления работой для синего гена/L Суперкомпьютер от Yariv Aridor et al. В стратегиях планирования рабочих мест для параллельной обработки Dror G. Feitelson 2005 ISBN 978-3-540-31024-2 Страницы 95–101

- ^ "Top500 OS -диаграмма" . Top500.org. Архивировано из оригинала 5 марта 2012 года . Получено 31 октября 2010 года .

- ^ «Широкоугольный вид коррелятора Алма» . ESO Пресс -релиз . Получено 13 февраля 2013 года .

- ^ Нильсен, Фрэнк (2016). Введение в HPC с MPI для науки о данных . Спрингер. С. 185–221. ISBN 978-3-319-21903-5 .

- ^ Рахат, Назмул. «Глава 03 Программное обеспечение и управление системой» .

- ^ Панде лаборатория. «Статистика клиента от ОС» . Склад@домой . Стэнфордский университет . Получено 10 апреля 2020 года .

- ^ «Боинк вместе» . Boincstats . Боевой Архивировано из оригинала 19 сентября 2010 года . Получено 30 октября 2016 г. Примечание. Эта ссылка будет предоставлена текущая статистика, а не дата, которая дана последняя.

{{cite web}}: Cs1 maint: postscript ( ссылка ) - ^ «Интернет -Primenet Server Distribute Computing Technology для Great Internet Internet Mersenne Prime Search» . GIMPS . Получено 6 июня 2011 года .

- ^ Jump up to: а беременный Кравитсов, Валентин; Кармели, Дэвид; Дубицкий, Вернер; Орда, Ариэль; Шустер, Ассаф ; Йошпа, Бенни. «Квази-оппортунистическое суперкомпьютеры в сетках, горячая тематическая бумага (2007)» . Международный симпозиум IEEE по высокопроизводительным распределенным вычислениям . IEEE. Citeseerx 10.1.1.135.8993 . Получено 4 августа 2011 года .

- ^ Jamaly, S.; Rajaei, H. (1 марта 2015 г.). «ASETS: система планирования задач SDN для HPCAAS в облаке». 2015 IEEE Международная конференция по облачной инженерии . С. 329–334. doi : 10.1109/ic2e.2015.56 . ISBN 978-1-4799-8218-9 Полем S2CID 10974077 .

- ^ Jamaly, S.; Раджаи, Х. (1 июня 2015 г.). «Задача данных HPC-задачи с SDN для включения HPC-As-A-Service». 2015 IEEE 8 -й Международная конференция по облачным вычислениям . С. 596–603. doi : 10.1109/cloud.2015.85 . ISBN 978-1-4673-7287-9 Полем S2CID 10141367 .

- ^ Гупта, А.; Milojicic, D. (1 октября 2011 г.). «Оценка приложений HPC на облаке». 2011 Шестой Открытый Саммит Циррус . С. 22–26. Citeseerx 10.1.1.294.3936 . doi : 10.1109/ocs.2011.10 . ISBN 978-0-7695-4650-6 Полем S2CID 9405724 .

- ^ Ким, Х.; El-Khamra, Y.; Jha, S.; Парашар М. (1 декабря 2009 г.). «Автономный подход к интегрированной сетке HPC и использованию облака». 2009 Пятая Международная конференция IEEE по E-Science . С. 366–373. Citeseerx 10.1.1.455.7000 . doi : 10.1109/e-science.2009.58 . ISBN 978-1-4244-5340-5 Полем S2CID 11502126 .

- ^ Идлин, Дуглас. «Перемещение HPC в облако» . Журнал администратора . Получено 30 марта 2019 года .

- ^ Никколай, Джеймс (11 августа 2009 г.). «Пингвин ставит высокопроизводительные вычисления в облаке» . PCWorld . IDG Consumer & SMB . Получено 6 июня 2016 года .

- ^ Jump up to: а беременный в Потенциальное влияние вычислений высокого уровня способностей на четыре иллюстративные области науки и техники со стороны Комитета по потенциальному воздействию высококлассных вычислений на иллюстративные области науки, инженерного и национального исследовательского совета (28 октября 2008 г.) ISBN 0-309-12485-9 Page 9

- ^ Синфу Ву (1999). Оценка эффективности, прогнозирование и визуализация параллельных систем . Springer Science & Business Media. С. 114–117. ISBN 978-0-7923-8462-5 .

- ^ Brehm, M. and Bruhwiler, DL (2015) «Характеристики производительности ускорения Уэйкфилда Плазмы, обусловленного протонными пучками». Журнал физики: серия конференций

- ^ Jump up to: а беременный Донгарра, Джек Дж.; Лушчек, Петр; Petite, Antoine (2003), «The Linpack Clackmark: прошлое, настоящее и будущее» (PDF) , параллелизм и вычисление: практика и опыт , 15 (9): 803–820, doi : 10.1002/cpe.728 , s2cid 1900724

- ^ «Понимание показателей производительности суперкомпьютеров и емкости системы хранения» . Университет Индианы . Получено 3 декабря 2017 года .

- ^ «Часто задаваемые вопросы» . Top500.org . Получено 3 декабря 2017 года .

- ^ «Списки TOP500» . Top500.org . Получено 3 августа 2024 года .

- ^ «Lenovo достигает статуса крупнейшего глобального поставщика суперкомпьютеров TOP500» . Бизнес -проволока . 25 июня 2018 года.

- ^ «Ноябрь 2022 г. | TOP500» . www.top500.org . Получено 7 декабря 2022 года .

- ^ Jump up to: а беременный «Китайские вершины рейтинга суперкомпьютеров с новой маркой 93-Petaflop | Top500» . www.top500.org .

- ^ «Матрица -2000 - nudt - wikichip» . en.wikichip.org . Получено 19 июля 2019 года .

- ^ «Tianhe-2A-TH-IVB-FEP-кластер, Intel Xeon E5-2692V2 12C 2,2 ГГц, TH Express-2, Matrix-2000 | SuperComputer Sites Top500» . www.top500.org . Получено 16 ноября 2022 года .

- ^ «Компьютерная система Cray-1» (PDF) . Cray Research, Inc. Архивировал (PDF) из оригинала 9 октября 2022 года . Получено 25 мая 2011 года .

- ^ Джоши, Раджани Р. (9 июня 1998 г.). «Новый эвристический алгоритм для вероятностной оптимизации». Компьютеры и операционные исследования . 24 (7): 687–697. doi : 10.1016/s0305-0548 (96) 00056-1 .

- ^ «Аннотация для Samsy - модульная система экранирования» . Агентство по ядерной энергетике ОЭСР, Исси-Ол-Мулино, Франция . Получено 25 мая 2011 года .

- ^ "Eff Des Cracker Source Code" . Cosic.esat.kuleuven.be . Получено 8 июля 2011 года .

- ^ «Дипломатия разоружения: - Программа DOE SuperComputing & Test Simulation» . Abrenomm.org.uk. 22 августа 2000 года. Архивировано из оригинала 16 мая 2013 года . Получено 8 июля 2011 года .

- ^ «Инвестиции в Китае в суперкомпьютинг графических процессоров начинают окупаться большим временем!» Полем Blogss.nvidia.com. Архивировано из оригинала 5 июля 2011 года . Получено 8 июля 2011 года .

- ^ Эндрю, Скотти (19 марта 2020 г.). «Самый быстрый суперкомпьютер в мире идентифицировал химические вещества, которые могли остановить распространение коронавируса, что является решающим шагом к лечению» . CNN . Получено 12 мая 2020 года .

- ^ Каку, Мичио. Физика будущего (Нью -Йорк: Doubleday, 2011), 65.

- ^ «Более быстрые суперкомпьютеры помогают прогнозам погоды» . News.nationalgeography.com. 28 октября 2010 года. Архивировано с оригинала 5 сентября 2005 года . Получено 8 июля 2011 года .

- ^ «IBM Drops SuperComputer Project IBM Drops 'Blue Waters» . Международное деловое время . 9 августа 2011 года . Получено 14 декабря 2018 года . - через EBSCO (требуется подписка)

- ^ «Суперкомпьютеры» . Министерство энергетики США . Архивировано из оригинала 7 марта 2017 года . Получено 7 марта 2017 года .

- ^ «Моделирование суперкомпьютеров помогает продвигать исследование электрохимической реакции» . ucsdnews.ucsd.edu . Получено 12 мая 2020 года .

- ^ «Саммит IBM - суперкомпьютер, сражающийся с коронавирусом» . Medicalexpo E-Magazine . 16 апреля 2020 года . Получено 12 мая 2020 года .

- ^ «Funding Funding Supercomputer Research для борьбы с Covid-19-Meritalk» . Получено 12 мая 2020 года .

- ^ «EU $ 1,2 Supercomputer Project на несколько 10-100 компьютеров Petaflop к 2020 году и Exaflop к 2022 году | NextBigfuture.com» . NextBigfuture.com . 4 февраля 2018 года . Получено 21 мая 2018 года .

- ^ Debenedictis, Erik P. (2004). «Путь к экстремальным вычислениям» (PDF) . Zettaflops . Сандия Национальные лаборатории. Архивировано из оригинала (PDF) 3 августа 2007 года . Получено 9 сентября 2020 года .

- ^ Коэн, Реувен (28 ноября 2013 г.). «Global Bitcoin Computing Power теперь в 256 раз быстрее, чем 500 суперкомпьютеров, объединенных!» Полем Форбс . Получено 1 декабря 2017 года .

- ^ Debenedictis, Erik P. (2005). «Обратимая логика для суперкомпьютинг» . Материалы 2 -й конференции по вычислительным границам . ACM Press. С. 391–402. ISBN 978-1-59593-019-4 .

- ^ «IDF: Intel говорит, что закон Мура действует до 2029 года» . Heise Online . 4 апреля 2008 года. Архивировано с оригинала 8 декабря 2013 года.

- ^ Солм, JC (1985). «MECA: многопроцессорная концепция, специализирующаяся на Монте -Карло» . Монте-Карло Методы и применения в нейтринике, фотонике и статистической физике . Заметки лекции в физике. Тол. 240. Труды Объединенной национальной лаборатории Лос -Аламоса - Комиссариата по атомике Комиссариата, состоявшейся в замке Кадараша, Прованс, Франция 22–26 апреля 1985 г.; Методы и приложения Монте-Карло в области нейники, фотоники и статистической физики, Alcouffe, R.; Dautray, R.; Forster, A.; Forster, G.; Mercier, B.; Ред. (Springer Verlag, Берлин). С. 184–195. Bibcode : 1985lnp ... 240..184S . doi : 10.1007/bfb0049047 . ISBN 978-3-540-16070-0 Полем Ости 5689714 .

- ^ Jump up to: а беременный в дюймовый Яннис Котонс; Энтони Даналис; Димитрис Николопулос; Джек Донгарра (2011). Недавние достижения в области прохождения сообщения: 18-е европейское собрание группы пользователей MPI, Eurompi 2011, Санторини, Греция, 18-21 сентября 2011 г. 2011 г. Труды . Springer Science & Business Media. ISBN 9783642244483 .

- ^ Джеймс Х. Ларос III; Кевин Педретти; Сюзанна М. Келли; Вэй Шу; Курт Феррейра; Джон Ван Дайк; Кортни Воган (2012). Энергоэффективные высокопроизводительные вычисления: измерение и настройка . Springer Science & Business Media. п. 1 ISBN 9781447144922 .

- ^ Джеймс Х. Ларос III; Кевин Педретти; Сюзанна М. Келли; Вэй Шу; Курт Феррейра; Джон Ван Дайк; Кортни Воган (2012). Энергоэффективные высокопроизводительные вычисления: измерение и настройка . Springer Science & Business Media. п. 2 ISBN 9781447144922 .

- ^ Джеймс Х. Ларос III; Кевин Педретти; Сюзанна М. Келли; Вэй Шу; Курт Феррейра; Джон Ван Дайк; Кортни Воган (2012). Энергоэффективные высокопроизводительные вычисления: измерение и настройка . Springer Science & Business Media. п. 3 ISBN 9781447144922 .

- ^ «Зеленый суперкомпьютер кричит большие данные в Исландии» . intelfreepress.com . 21 мая 2015 года. Архивировано с оригинала 20 мая 2015 года . Получено 18 мая 2015 года .

Внешние ссылки

[ редактировать ]- McDonnell, Marshall T. (2013). «Дизайн суперкомпьютеров: первоначальные усилия по захвату экологических, экономических и социальных воздействий» . Химические и биомолекулярные инженерные публикации и другие работы.