Тест Тьюринга

| Часть серии о |

| Искусственный интеллект |

|---|

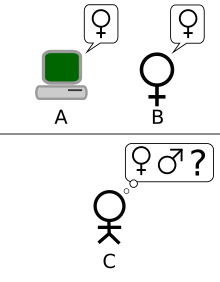

Тест Тьюринга , первоначально названный имитационной игрой , в Аланом Тьюрингом 1950 году [2] Это проверка способности машины демонстрировать разумное поведение , эквивалентное человеческому или неотличимое от него. Тьюринг предположил, что оценщик-человек будет оценивать разговоры на естественном языке между человеком и машиной, предназначенной для генерации ответов, подобных человеческим. Оценщик будет знать, что один из двух собеседников является машиной, и все участники будут отделены друг от друга. Разговор будет ограничен только текстовым каналом, таким как клавиатура и экран компьютера, поэтому результат не будет зависеть от способности машины отображать слова как речь. [3] Если бы оценщик не мог достоверно отличить машину от человека, можно было бы сказать, что машина прошла испытание. Результаты теста не будут зависеть от способности машины давать правильные ответы на вопросы , а только от того, насколько ее ответы будут похожи на те, которые дал бы человек. Поскольку тест Тьюринга представляет собой тест неотличимости производительности, вербальная версия естественным образом обобщает все человеческие способности, как вербальные, так и невербальные (роботизированные). [4]

Этот тест был представлен Тьюрингом в его статье 1950 года « Вычислительная техника и интеллект », когда он работал в Манчестерском университете . [5] Он открывается словами: «Я предлагаю рассмотреть вопрос: «Могут ли машины мыслить? »» . Поскольку «мышление» трудно определить, Тьюринг предпочитает «заменить этот вопрос другим, который тесно с ним связан и выражается в относительно однозначные слова». [6] Тьюринг описывает новую форму задачи в терминах игры для трех человек, называемой «игрой-имитацией», в которой следователь задает вопросы мужчине и женщине в другой комнате, чтобы определить правильный пол двух игроков. Новый вопрос Тьюринга звучит так: «Существуют ли вообразимые цифровые компьютеры, которые преуспели бы в игре в имитацию ?» [2] На этот вопрос, по мнению Тьюринга, действительно можно было ответить. В оставшейся части статьи он выступил против всех основных возражений против утверждения о том, что «машины могут думать». [7]

С тех пор, как Тьюринг представил свой тест, он пользовался большим влиянием и широкой критикой и стал важной концепцией в философии искусственного интеллекта . [8] [9] [10] Философ Джон Сирл прокомментировал тест Тьюринга в своей аргументации в китайской комнате , мысленный эксперимент, который предполагает, что машина не может иметь « разум », « понимание » или « сознание », независимо от того, насколько разумной или человеческой является программа. заставить компьютер вести себя. Сирл критикует тест Тьюринга и утверждает, что его недостаточно для обнаружения присутствия сознания.

История

[ редактировать ]Философская подоплека

[ редактировать ]Вопрос о том, могут ли машины мыслить, имеет долгую историю, которая прочно укоренилась в различии между дуалистическим и материалистическим взглядами на разум. Рене Декарт является прообразом аспектов теста Тьюринга в своем «Рассуждении о методе» 1637 года , когда он пишет:

[Как] много разных автоматов или движущихся машин могло бы быть создано человеческой промышленностью... Ибо мы можем легко понять, что машина устроена так, что она может произносить слова и даже излучать некоторые реакции на действия над ней телесного рода. , что вызывает изменение в его органах; например, если прикоснуться к определенной части, он может спросить, что мы хотим ему сказать; если в другой части он может воскликнуть, что ему причиняют боль, и так далее. Но никогда не бывает так, чтобы оно по-разному устраивало свою речь, чтобы соответственно ответить на все, что можно сказать в его присутствии, как это может сделать даже самый низший тип человека. [11]

Здесь Декарт отмечает, что автоматы способны реагировать на человеческие взаимодействия, но утверждает, что такие автоматы не могут реагировать соответствующим образом на слова, сказанные в их присутствии, так, как это может сделать любой человек. Таким образом, Декарт является прообразом теста Тьюринга, определяя недостаточность соответствующей лингвистической реакции как то, что отделяет человека от автомата. Декарт не учитывает возможность того, что будущие автоматы смогут преодолеть такую недостаточность, и поэтому не предлагает тест Тьюринга как таковой, даже если он является прообразом его концептуальной основы и критерия.

Дени Дидро формулирует в своей книге «Философские мысли» 1746 года критерий теста Тьюринга, хотя и с сохранением важного неявного ограничивающего предположения, согласно которому участники являются естественными живыми существами, а не учитывают созданные артефакты:

Если бы они нашли попугая, который мог бы ответить на все вопросы, я бы без колебаний назвал его разумным существом.

Это не значит, что он с этим согласен, но то, что это уже было обычным рассуждением материалистов того времени.

Согласно дуализму, разум нефизичен . (или, по крайней мере, обладает нефизическими свойствами ) [12] и, следовательно, не может быть объяснено чисто физически. Согласно материализму, разум можно объяснить физически, что оставляет открытой возможность существования разума, созданного искусственно. [13]

В 1936 году философ Альфред Айер задумался над стандартным философским вопросом, касающимся других умов : откуда мы знаем, что другие люди имеют тот же сознательный опыт, что и мы? В своей книге « Язык, истина и логика » Айер предложил протокол, позволяющий различать сознательного человека и бессознательную машину: «Единственное основание, которое я могу иметь для утверждения, что объект, который кажется сознательным, на самом деле не является сознательным существом, но только манекен или машина, заключается в том, что она не удовлетворяет одному из эмпирических тестов, с помощью которых определяется наличие или отсутствие сознания». [14] (Это предположение очень похоже на тест Тьюринга, но нет уверенности в том, что популярная философская классика Айера была знакома Тьюрингу.) Другими словами, вещь не является сознательной, если она не проходит тест на сознание.

Культурный фон

[ редактировать ]Элементарная идея теста Тьюринга появляется в романе Путешествия Гулливера» « Джонатана Свифта 1726 года . [15] [16] Когда Гулливера предстают перед королем Бробдингнаггов, король сначала думает, что Гулливер может быть «частью часового механизма (который в этой стране достиг очень высокого совершенства), изобретенного каким-то гениальным художником». Даже когда он слышит речь Гулливера, король все еще сомневается, научили ли Гулливера «набору слов», чтобы заставить его «продать по более выгодной цене». Гулливер рассказывает, что только после того, как «он задал мне еще несколько вопросов и все же получил рациональные ответы», король убедился, что Гулливер не машина. [17]

Тесты, в которых человек определяет, разумен ли компьютер или инопланетянин, были устоявшейся традицией в научной фантастике к 1940-м годам, и вполне вероятно, что Тьюринг знал о них. [18] Стэнли Г. Вайнбаума (1934) представляет собой пример того, насколько детальными могут быть такие испытания. «Марсианская одиссея» [18]

Более ранние примеры машин или автоматов, пытающихся выдать себя за людей, включают древнегреческий миф о Пигмалионе , который создает скульптуру женщины, оживляемую Афродитой , Карло Коллоди роман «Приключения Пиноккио » о марионетке, которая хочет стать реальной. мальчика и рассказ Э.Т.А. Гофмана 1816 года « Песочный человек », где главный герой влюбляется в автомат. Во всех этих примерах людей обманывают искусственные существа, которые — до определенного момента — выдают себя за людей. [19]

Алан Тьюринг и игра в имитацию

[ редактировать ]Исследователи в Соединенном Королевстве изучали «машинный интеллект» на протяжении десяти лет до основания области исследований искусственного интеллекта ( ИИ ) в 1956 году. [20] Это была общая тема среди членов Ratio Club , неформальной группы британских исследователей кибернетики и электроники , в которую входил Алан Тьюринг. [21]

Тьюринг, в частности, придерживался идеи машинного интеллекта как минимум с 1941 года. [22] и одно из первых известных упоминаний о «компьютерном интеллекте» было сделано им в 1947 году. [23] В докладе Тьюринга «Интеллектуальные машины» [24] он исследовал «вопрос о том, могут ли машины проявлять разумное поведение». [25] и в рамках этого расследования предложил то, что можно считать предшественником его более поздних испытаний:

Нетрудно изобрести бумажную машину, которая будет играть в неплохие шахматы. [26] Теперь возьмите трех мужчин A, B и C в качестве субъектов для эксперимента. А и С должны быть довольно плохими шахматистами, Б — оператором бумагоделательной машины. ... Используются две комнаты с некоторыми приспособлениями для обмена ходами, и игра ведется между C и A или бумагоделательной машиной. Игроку C может быть довольно сложно определить, на каком игроке он играет. [27]

« Вычислительная техника и интеллект » ( 1950 ) была первой опубликованной работой Тьюринга, посвященной исключительно машинному интеллекту. Тьюринг начинает статью 1950 года с утверждения: «Я предлагаю рассмотреть вопрос: «Могут ли машины думать? » ». [6] Как он подчеркивает, традиционный подход к такому вопросу состоит в том, чтобы начать с определений , определяя как термины «машина», так и «думать». Тьюринг предпочитает не делать этого; вместо этого он заменяет вопрос новым, «который тесно с ним связан и выражен относительно однозначными словами». [6] По сути он предлагает изменить вопрос с «Могут ли машины думать?» на «Могут ли машины делать то, что можем мы (как мыслящие существа)?» [28] Преимущество нового вопроса, утверждает Тьюринг, состоит в том, что он проводит «довольно резкую грань между физическими и интеллектуальными способностями человека». [29]

Чтобы продемонстрировать этот подход, Тьюринг предлагает тест, вдохновленный игрой для вечеринок , известной как «игра в имитацию», в которой мужчина и женщина идут в разные комнаты, а гости пытаются отличить их друг от друга, записывая серию вопросов и читая машинописные тексты. ответы отправлены обратно. В этой игре и мужчина, и женщина стремятся убедить гостей, что они другие. (Хума Шах утверждает, что эта версия игры для двух человек была представлена Тьюрингом только для того, чтобы познакомить читателя с тестом «вопрос-ответ». [30] ) Тьюринг так описал свою новую версию игры:

Теперь мы задаем вопрос: «Что произойдет, когда машина возьмет на себя роль А в этой игре?» Будет ли следователь принимать ошибочные решения так же часто, когда игра ведется таким образом, как и тогда, когда игра ведется между мужчиной и женщиной? Эти вопросы заменяют наш первоначальный вопрос: «Могут ли машины думать?» [29]

Далее в статье Тьюринг предлагает «эквивалентную» альтернативную формулировку, в которой судья разговаривает только с компьютером и человеком. [31] Хотя ни одна из этих формулировок не соответствует в точности более известной сегодня версии теста Тьюринга, в 1952 году он предложил третью. В этой версии, которую Тьюринг обсуждал в радиопередаче BBC , жюри задает вопросы о компьютере и роли Использование компьютера должно заставить значительную часть присяжных поверить, что это действительно мужчина. [32]

В статье Тьюринга рассматривались девять предполагаемых возражений, в том числе некоторые из основных аргументов против искусственного интеллекта , выдвинутых за годы, прошедшие после публикации статьи (см. « Вычислительная техника и интеллект »). [7]

ЭЛИЗА и ПЭРРИ

[ редактировать ]В 1966 году Джозеф Вайценбаум создал программу, которая, по-видимому, прошла тест Тьюринга. Программа, известная как ELIZA , работала, проверяя набранные пользователем комментарии на предмет ключевых слов. Если ключевое слово найдено, применяется правило, преобразующее комментарии пользователя, и возвращается результирующее предложение. Если ключевое слово не найдено, ELIZA отвечает либо общим ответом, либо повторением одного из предыдущих комментариев. [33] Кроме того, Вайценбаум разработал ELIZA, чтобы имитировать поведение психотерапевта Роджера , позволяя ELIZA «свободно принимать позу почти ничего не знающего о реальном мире». [34] С помощью этих методов программа Вайценбаума смогла обмануть некоторых людей, заставив их поверить в то, что они разговаривают с реальным человеком, при этом некоторых испытуемых «очень трудно убедить, что ЭЛИЗА [...] не человек ». [34] Таким образом, некоторые утверждают, что ELIZA является одной из программ (возможно, первой), способной пройти тест Тьюринга. [34] [35] хотя эта точка зрения весьма спорна (см. «Наивность следователей» ниже).

Кеннет Колби создал в 1972 году программу PARRY , названную «ЭЛИЗА с отношением». [36] Они попытались смоделировать поведение параноидального шизофреника , используя аналогичный (хотя и более продвинутый) подход, использованный Вейценбаумом. Для проверки работы PARRY был протестирован в начале 1970-х годов с использованием варианта теста Тьюринга. Группа опытных психиатров проанализировала сочетание реальных пациентов и компьютеров, запускающих PARRY через телетайпы . Другой группе из 33 психиатров были показаны стенограммы разговоров. Затем обеим группам было предложено определить, кто из «пациентов» был человеком, а кто — компьютерной программой. [37] Психиатры смогли сделать правильную идентификацию только в 52 процентах случаев – цифра, согласующаяся со случайным предположением. [37]

В 21 веке версии этих программ (теперь известные как « чат-боты ») продолжают обманывать людей. «CyberLover», вредоносная программа, охотится на пользователей Интернета, убеждая их «раскрыть информацию о своей личности или заставить их посетить веб-сайт, который доставляет вредоносный контент на их компьютеры». [38] Программа возникла как «Валентинский риск», предназначенный для флирта с людьми, «ищущими отношений в Интернете с целью сбора своих личных данных». [39]

Китайская комната

[ редактировать ]В статье Джона Сирла 1980 года « Разум, мозг и программы» был предложен мысленный эксперимент « Китайская комната » и доказано, что тест Тьюринга нельзя использовать для определения способности машины думать. Сирл отметил, что программное обеспечение (такое как ELIZA) может пройти тест Тьюринга, просто манипулируя символами, которые они не понимают. Без понимания их нельзя было бы назвать «думающими» в том же смысле, в каком это делают люди. Таким образом, заключил Сирл, тест Тьюринга не может доказать, что машины могут думать. [40] Как и сам тест Тьюринга, аргумент Сирла подвергся широкой критике. [41] и одобрено. [42]

Аргументы, подобные аргументам Сирла и других авторов, занимающихся философией разума, вызвали более интенсивные дебаты о природе интеллекта, возможности существования машин с сознательным разумом и ценности теста Тьюринга, которые продолжались на протяжении 1980-х и 1990-х годов. [43]

Премия Лебнера

[ редактировать ]Премия Лёбнера представляет собой ежегодную платформу для практических тестов Тьюринга, первый конкурс которой состоялся в ноябре 1991 года. [44] Он подписан Хью Лебнером . Кембриджский центр поведенческих исследований в Массачусетсе , США, организовал призы вплоть до конкурса 2003 года. По словам Лебнера, одной из причин создания конкурса является улучшение состояния исследований ИИ, по крайней мере частично, потому что никто не предпринял шагов для реализации теста Тьюринга, несмотря на 40 лет его обсуждения. [45]

Первый конкурс на премию Лебнера в 1991 году привел к возобновлению дискуссии о жизнеспособности теста Тьюринга и ценности его проведения как в популярной прессе, так и в прессе. [46] и академические круги. [47] Первое состязание выиграла бессмысленная программа без какого-либо идентифицируемого интеллекта, которой удалось обмануть наивных следователей, заставив их сделать неправильную идентификацию. Это выявило несколько недостатков теста Тьюринга (обсуждаемых ниже ): Победитель победил, по крайней мере частично, потому что он был в состоянии «имитировать человеческие ошибки при наборе текста»; [46] неискушенных следователей было легко обмануть; [47] и некоторые исследователи в области ИИ пришли к выводу, что тест — это просто отвлечение от более плодотворных исследований. [48]

Серебряный (только текст) и золотой (аудио и визуальный) призы так и не были выиграны. Однако конкурс каждый год присуждает бронзовую медаль за компьютерную систему, которая, по мнению судей, демонстрирует «самое человечное» диалоговое поведение среди работ того года. Искусственная лингвистическая Интернет-компьютерная организация (ALICE) за последнее время трижды получала бронзовую награду (2000, 2001, 2004 гг.). «Изучение искусственного интеллекта» Джабберваки выигрывал в 2005 и 2006 годах.

Премия Лебнера проверяет разговорный интеллект; победителями обычно становятся программы -чат-боты или искусственные диалоговые сущности (ACE) . Ранние правила премии Лебнера ограничивали разговоры: каждая запись и скрытый человек разговаривали на одну тему. [49] таким образом, следователи были ограничены одной линией допроса на каждое взаимодействие сущности. Правило ограниченного разговора было отменено для премии Лёбнера 1995 года. Продолжительность взаимодействия между судьей и субъектом в рамках премий Лебнера различалась. В Лебнере 2003 года в Университете Суррея каждому следователю было предоставлено пять минут на взаимодействие с сущностью, машиной или скрытым человеком. В период с 2004 по 2007 год время взаимодействия, разрешенное в рамках Премий Лебнера, составляло более двадцати минут.

Чат-бот Google LaMDA

[ редактировать ]В июне 2022 года чат-бот Google LaMDA (Языковая модель для диалоговых приложений) получил широкое освещение в связи с заявлениями о том, что он достиг разумности. Первоначально в статье в The Economist научный сотрудник Google Блез Агуэра-и-Аркас сказал, что чат-бот продемонстрировал определенную степень понимания социальных отношений. [50] Несколько дней спустя инженер Google Блейк Лемуан заявил в интервью Washington Post , что LaMDA обрел разум. Лемуана отправили в отпуск из-за внутренних заявлений по этому поводу. Агуэра-и-Аркас (вице-президент Google) и Джен Дженнаи (руководитель отдела ответственных инноваций) расследовали претензии, но отклонили их. [51] Утверждение Лемуана было категорически отвергнуто другими экспертами в этой области, указав, что языковая модель, которая, по-видимому, имитирует человеческий разговор, не указывает на то, что за ней стоит какой-либо разум. [52] несмотря на то, что кажется, что он прошел тест Тьюринга. Широкая дискуссия со стороны сторонников и против утверждения о том, что LaMDA достигла разумности, вызвала дискуссию на платформах социальных сетей, в том числе определение значения разумности, а также того, что значит быть человеком.

ЧатGPT

[ редактировать ]Чат-бот OpenAI ChatGPT, выпущенный в ноябре 2022 года, основан на GPT-3.5 и GPT-4 моделях больших языков . Селеста Бивер написала в статье в журнале Nature , что «ChatGPT сломал тест Тьюринга». [53] Исследователи из Стэнфорда сообщили, что ChatGPT проходит тест; они обнаружили, что ChatGPT-4 «проходит строгий тест Тьюринга, отличаясь от поведения обычного человека главным образом из-за большей склонности к сотрудничеству». [54] [55]

Версии

[ редактировать ]

Сол Трейгер утверждает, что существует по крайней мере три основных версии теста Тьюринга, две из которых предлагаются в «Вычислительной технике и интеллекте», а одну он описывает как «Стандартную интерпретацию». [56] Хотя ведутся споры относительно того, является ли «Стандартная интерпретация» той, которую описал Тьюринг, или же она основана на неправильном прочтении его статьи, эти три версии не считаются эквивалентными. [56] и их сильные и слабые стороны различны. [57]

В оригинальной статье Тьюринга описывается простая групповая игра с участием трех игроков. Игрок А — мужчина, игрок Б — женщина, а игрок С (играющий роль следователя) — любого пола. В имитационной игре игрок С не может видеть ни игрока А, ни игрока Б и может общаться с ними только посредством письменных заметок. Задавая вопросы игроку А и игроку Б, игрок С пытается определить, кто из двоих мужчина, а кто женщина. Роль игрока А состоит в том, чтобы обманом заставить допрашивающего принять неправильное решение, в то время как игрок Б пытается помочь допрашивающему принять правильное решение. [8]

Затем Тьюринг спрашивает:

«Что произойдет, если машина возьмет на себя роль А в этой игре? Будет ли следователь принимать ошибочные решения, когда игра ведется таким образом, как он делает это, когда игра ведется между мужчиной и женщиной?» Эти вопросы заменяют наш первоначальный вопрос: «Могут ли машины думать?» [29]

Вторая версия появилась позже в статье Тьюринга 1950 года. Как и в оригинальном тесте на имитационную игру, роль игрока А выполняет компьютер. Однако роль игрока Б выполняет мужчина, а не женщина.

Давайте сосредоточим наше внимание на одном конкретном цифровом компьютере C. Верно ли, что, модифицировав этот компьютер, чтобы он имел достаточный объем памяти, соответствующим образом увеличив скорость его действия и снабдив его соответствующей программой, C можно заставить удовлетворительно играть свою роль? А в имитационной игре роль Б занимает мужчина? [29]

В этой версии и игрок А (компьютер), и игрок Б пытаются обманом заставить следователя принять неправильное решение.

Стандартная интерпретация не включена в оригинальную статью, но одновременно принимается и обсуждается.Общепринято считать, что цель теста Тьюринга состоит не в том, чтобы определить, способен ли компьютер обмануть следователя, заставив его поверить, что он человек, а в том, может ли компьютер имитировать человека. [8] Хотя существуют некоторые споры о том, была ли эта интерпретация задумана Тьюрингом, Стерретт полагает, что это было [58] и, таким образом, объединяет вторую версию с этой, в то время как другие, такие как Трейгер, не делают этого. [56] – тем не менее, это привело к тому, что можно рассматривать как «стандартную интерпретацию». В этой версии игрок А — компьютер, а игрок Б — человек любого пола. Роль следователя заключается не в том, чтобы определить, кто мужчина, а кто женщина, а в том, кто компьютер, а кто человек. [59] Фундаментальная проблема стандартной интерпретации заключается в том, что следователь не может отличить, кто из отвечающих — человек, а кто — машина. Существуют вопросы по поводу продолжительности, но стандартная интерпретация обычно считает это ограничение разумным.

Интерпретации

[ редактировать ]Споры возникли по поводу того, какую из альтернативных формулировок теста имел в виду Тьюринг. [58] Стерретт утверждает, что из его статьи 1950 года можно извлечь два разных теста, и что, несмотря на замечание Тьюринга, они не эквивалентны. Тест, в котором используется групповая игра и сравнивается частота успеха, называется «Оригинальным тестом в имитационной игре», тогда как тест, состоящий из разговора судьи-человека с человеком и машиной, называется «Стандартным тестом Тьюринга». отмечая, что Стерретт приравнивает это к «стандартной интерпретации», а не ко второй версии имитационной игры. Стерретт согласен с тем, что стандартный тест Тьюринга (STT) имеет проблемы, на которые ссылаются его критики, но считает, что, напротив, оригинальный тест имитационной игры (OIG), определенный таким образом, невосприимчив ко многим из них из-за существенного различия: в отличие от STT, он не делает критерием сходство с человеческими способностями, хотя и использует человеческие способности при установлении критерия машинного интеллекта. Мужчина может провалить тест OIG, но утверждается, что достоинством теста на интеллект является то, что неудача указывает на недостаток изобретательности: тест OIG требует находчивости, связанной с интеллектом, а не просто «симуляции человеческого разговорного поведения». Общая структура теста OIG может использоваться даже с невербальными версиями имитационных игр. [60]

По словам Хумы Шаха, Тьюринг сам был обеспокоен тем, может ли машина думать, и предлагал простой метод проверки этого: посредством сеансов вопросов и ответов между человеком и машиной. [61] Шах утверждает, что имитационную игру, описанную Тьюрингом, можно реализовать двумя разными способами: а) тест «один на один» между следователем и машиной и б) одновременное сравнение машины с человеком, оба из которых допрашиваются следователем параллельно. [30]

Еще другие писатели [62] интерпретировали Тьюринга как предположение, что игра в имитацию сама по себе является тестом, не уточнив, как следует принимать во внимание утверждение Тьюринга о том, что тест, который он предложил с использованием партийной версии игры в имитацию, основан на критерии сравнительной частоты успеха в этой имитации. игры, а не способность добиться успеха в одном раунде игры.

Некоторые авторы утверждают, что имитационную игру лучше всего понять через ее социальные аспекты. В своей статье 1948 года Тьюринг называет интеллект «эмоциональной концепцией» и отмечает, что

Степень, в которой мы считаем что-то разумным, определяется как нашим собственным состоянием ума и тренировкой, так и свойствами рассматриваемого объекта. Если мы способны объяснить и предсказать его поведение или если кажется, что в его основе нет никакого плана, у нас мало искушения представить разум. Следовательно, с одним и тем же объектом один человек может считать его разумным, а другой — нет; второй человек узнал бы правила его поведения. [63]

После этого замечания и подобных ему, разбросанных по публикациям Тьюринга, Дайан Праудфут [64] утверждает, что Тьюринг придерживался подхода к интеллекту, основанного на реакции , согласно которому разумная (или мыслящая) сущность — это сущность, которая кажется разумной среднестатистическому следователю. Бернардо Гонсалвес показывает, что, хотя Тьюринг использовал риторику введения своего теста как своего рода решающий эксперимент, чтобы решить, можно ли сказать, что машины думают, [65] фактическое представление его теста удовлетворяет хорошо известным свойствам мысленных экспериментов в современной научной традиции Галилея. [66] Шломо Данцигер [67] продвигает социотехнологическую интерпретацию, согласно которой Тьюринг рассматривал игру в имитацию не как проверку интеллекта, а как технологическое стремление, реализация которого, вероятно, повлечет за собой изменение отношения общества к машинам. Согласно этому прочтению, знаменитое 50-летнее предсказание Тьюринга о том, что к концу 20-го века его тест пройдет какая-то машина, на самом деле состоит из двух различных предсказаний. Первый — технологический прогноз:

Я считаю, что лет через пятьдесят можно будет запрограммировать компьютеры... заставить их играть в имитационную игру настолько хорошо, что у среднего следователя будет не более 70% шансов правильно опознать после пяти минут допроса. . [68]

Второе предсказание Тьюринга носит социологический характер:

Я верю, что в конце века употребление слов и общее мнение образованных людей изменятся настолько, что можно будет говорить о машинном мышлении, не ожидая, что вам будут возражать. [68]

Данцигер далее утверждает, что для Тьюринга изменение отношения общества к машинам является предпосылкой существования разумных машин: Только когда термин «разумная машина» больше не будет рассматриваться как оксюморон, существование разумных машин станет логически возможным.

Сайгин предположил, что, возможно, оригинальная игра — это способ предложить менее предвзятый экспериментальный дизайн, поскольку он скрывает участие компьютера. [69] Игра-имитация также включает в себя «социальный хак», которого нет в стандартной интерпретации, поскольку в игре и компьютер, и человек мужского пола должны играть, притворяясь тем, кем они не являются. [70]

Должен ли следователь знать о компьютере?

[ редактировать ]Важнейшей частью любого лабораторного исследования является наличие контроля. Тьюринг никогда не уточняет, осознает ли следователь в своих тестах, что одним из участников является компьютер. Он утверждает только, что игрок А должен быть заменен машиной, а не что игрок С должен быть уведомлен об этой замене. [29] Когда Колби, Ф. Д. Хильф, С. Вебер и А. Д. Крамер тестировали PARRY, они делали это, предполагая, что следователям не нужно знать, что один или несколько из допрашиваемых во время допроса были компьютером. [71] Как Айше Сайгин, Питер Свирски, [72] и другие подчеркнули, что это имеет большое значение для реализации и результатов теста. [8] В экспериментальном исследовании нарушений принципа Грайса с использованием стенограмм приза Лебнера «один на один» (скрытый собеседник) в конкурсах ИИ в период с 1994 по 1999 год Айше Сайгин обнаружила значительные различия между ответами участников, которые знали и не знали о компьютерах. будучи вовлеченным. [73]

Сильные стороны

[ редактировать ]Удобство и простота

[ редактировать ]Сила и привлекательность теста Тьюринга проистекают из его простоты. Философия разума , психология и современная нейробиология не смогли дать определения «интеллекта» и «мышления», которые были бы достаточно точными и общими, чтобы их можно было применить к машинам. центральные вопросы философии искусственного интеллекта Без таких определений невозможно ответить на . Тест Тьюринга, пусть даже и несовершенный, по крайней мере, дает то, что действительно можно измерить. По сути, это прагматичная попытка ответить на сложный философский вопрос.

Широта тематики

[ редактировать ]Формат теста позволяет следователю давать машине самые разнообразные интеллектуальные задачи. Тьюринг писал, что «метод вопросов и ответов, кажется, подходит для знакомства практически с любой из областей человеческой деятельности, которые мы хотим включить». [74] Джон Хаугеланд добавляет, что «недостаточно понимать слова; нужно понимать тему ». также [75]

Чтобы пройти хорошо продуманный тест Тьюринга, машина должна использовать естественный язык , рассуждать , обладать знаниями и учиться . Тест можно расширить, включив в него видеовход, а также «люк», через который можно пропускать объекты: это заставит машину продемонстрировать умелое использование хорошо продуманного зрения и робототехники также . Вместе они представляют почти все основные проблемы, которые исследования искусственного интеллекта хотели бы решить. [76]

Тест Фейгенбаума предназначен для использования широкого спектра тем, доступных для теста Тьюринга. Это ограниченная форма игры «вопрос-ответ» Тьюринга, в которой машина сравнивается со способностями экспертов в конкретных областях, таких как литература или химия .

Акцент на эмоциональном и эстетическом интеллекте.

[ редактировать ]Можно было ожидать, что Тьюринг, будучи выпускником Кембриджа по математике с отличием, предложит тест на компьютерный интеллект, требующий экспертных знаний в какой-то высокотехнической области и, таким образом, предвосхищающий более современный подход к этому предмету . Вместо этого, как уже отмечалось, тест, который он описал в своей основополагающей статье 1950 года, требует, чтобы компьютер был в состоянии успешно конкурировать в обычной групповой игре, и для этого он должен действовать так же хорошо, как обычный человек, отвечая на ряд вопросов, чтобы убедительно притворитесь участницей конкурса.

Учитывая статус полового диморфизма человека как одного из самых древних субъектов , из приведенного выше сценария неявно следует, что вопросы, на которые предстоит ответить, не будут включать ни специализированные фактические знания, ни методы обработки информации. Задача компьютера, скорее, будет заключаться в том, чтобы продемонстрировать сочувствие к роли женщины, а также продемонстрировать характерную эстетическую чувствительность — оба эти качества демонстрируются в этом фрагменте диалога, который вообразил Тьюринг:

- Следователь: Скажите, пожалуйста, Х, длину его или ее волос?

- Участница: Мои волосы расчесаны, а самые длинные пряди имеют длину около девяти дюймов.

Когда Тьюринг вводит некоторые специальные знания в один из своих воображаемых диалогов, речь идет не о математике или электронике, а о поэзии:

- Следователь: В первой строке вашего сонета, которая гласит: «Сравнить ли мне тебя с летним днем», не подойдет ли «весенний день» так же или даже лучше?

- Свидетель: Он не сканировал .

- Следователь: Как насчет «зимнего дня»? Это будет нормально сканировать.

- Свидетель: Да, но никто не хочет, чтобы его сравнивали с зимним днем.

Таким образом, Тьюринг еще раз демонстрирует свой интерес к эмпатии и эстетической чувствительности как компонентам искусственного интеллекта; и в свете растущей осведомленности об угрозе, исходящей от вышедшего из-под контроля ИИ, [77] это было предложено [78] что этот фокус, возможно, представляет собой критическую интуицию со стороны Тьюринга, т.е. что эмоциональный и эстетический интеллект будет играть ключевую роль в создании « дружественного ИИ ». Далее отмечается, однако, что любое вдохновение, которое Тьюринг мог бы оказать в этом направлении, зависит от сохранения его первоначального видения, то есть, далее, что распространение «стандартной интерпретации» теста Тьюринга, т.е. , который фокусируется только на дискурсивном интеллекте, следует рассматривать с некоторой осторожностью.

Слабые стороны

[ редактировать ]Тьюринг прямо не заявил, что тест Тьюринга можно использовать в качестве меры « интеллекта » или любого другого человеческого качества. Он хотел предложить ясную и понятную альтернативу слову «думать», которую он затем мог бы использовать, чтобы ответить на критику возможности «думающих машин» и предложить пути дальнейшего развития исследований.

Тем не менее, тест Тьюринга был предложен как мера «способности машины думать» или ее «интеллекта». Это предложение подверглось критике как со стороны философов, так и ученых-компьютерщиков. Интерпретация предполагает, что следователь может определить, «думает» ли машина, сравнивая ее поведение с поведением человека. Каждый элемент этого предположения был подвергнут сомнению: надежность суждения следователя, ценность сравнения машины с человеком и ценность сравнения только поведения. Из-за этих и других соображений некоторые исследователи ИИ поставили под сомнение актуальность теста для их области.

Наивность следователей

[ редактировать ]На практике результаты теста могут легко зависеть не от интеллекта компьютера, а от отношения, навыков или наивности спрашивающего. Многочисленные эксперты в этой области, в том числе ученый-когнитивист Гэри Маркус , настаивают на том, что тест Тьюринга лишь показывает, насколько легко обмануть людей, и не является показателем машинного интеллекта. [79]

Тьюринг не уточняет точные навыки и знания, необходимые следователю в своем описании теста, но он использовал термин «средний следователь»: «[средний] следователь не будет иметь более чем 70-процентную вероятность того, что правильное опознание после пяти минут допроса». [68]

Программы Chatterbot, такие как ELIZA, неоднократно обманывали ничего не подозревающих людей, заставляя их поверить, что они общаются с людьми. В этих случаях «дознаватели» даже не подозревают о возможности взаимодействия с компьютерами. Чтобы успешно казаться человеком, машине не обязательно обладать каким-либо интеллектом, достаточно лишь поверхностного сходства с поведением человека.

В первых конкурсах на получение премии Лебнера использовались «неискушенные» следователи, которых машины легко обманули. [47] С 2004 года организаторы премии Лебнера привлекали к допросам философов, ученых-компьютерщиков и журналистов. Тем не менее, некоторые из этих экспертов были обмануты машинами. [80]

Одной из интересных особенностей теста Тьюринга является частота эффекта конфедерации , когда люди-конфедераты (испытуемые) ошибочно принимаются следователями за машины. Было высказано предположение, что то, что следователи ожидают от человеческих ответов, не обязательно типично для людей. В результате некоторых людей можно отнести к машинам. Таким образом, это может сработать в пользу конкурирующей машины. Людям приказано «действовать самостоятельно», но иногда их ответы больше похожи на то, что следователь ожидает от машины. [81] Это поднимает вопрос о том, как обеспечить мотивацию людей «вести себя по-человечески».

Человеческий интеллект против интеллекта в целом

[ редактировать ]

Тест Тьюринга не проверяет напрямую, разумно ли ведет себя компьютер. Он проверяет только то, ведет ли компьютер себя как человек. Поскольку человеческое поведение и интеллектуальное поведение — это не одно и то же, тест может не дать точного измерения интеллекта по двум причинам:

- Некоторые виды человеческого поведения неразумны

- Тест Тьюринга требует, чтобы машина могла выполнять все человеческие действия, независимо от того, являются ли они разумными. Он даже проверяет поведение, которое вообще нельзя считать разумным, например, восприимчивость к оскорблениям, [82] искушение солгать или, проще говоря, высокая частота ошибок при наборе текста . Если машина не может детально имитировать это неразумное поведение, она не проходит тест.

- Это возражение было выдвинуто журналом The Economist в статье под названием « искусственная глупость », опубликованной вскоре после первого конкурса на премию Лебнера в 1992 году. В статье отмечалось, что победа первого лауреата Лебнера была обусловлена, по крайней мере частично, его способностью «имитировать человеческие ошибки при наборе текста». [46] Сам Тьюринг предлагал программам добавлять ошибки в свой вывод, чтобы лучше «играть» в игру. [83]

- Некоторое разумное поведение бесчеловечно

- Тест Тьюринга не проверяет высокоинтеллектуальное поведение, такое как способность решать сложные проблемы или приходить к оригинальным идеям. На самом деле, это конкретно требует обмана со стороны машины: если машина умнее человека, она должна сознательно избегать показаться слишком умной. Если бы нужно было решить вычислительную задачу, которую человеку практически невозможно решить, тогда исследователь знал бы, что программа не является человеком, и машина не прошла бы тест.

- Поскольку он не может измерить интеллект, превосходящий возможности человека, этот тест нельзя использовать для создания или оценки систем, которые более интеллектуальны, чем люди. По этой причине было предложено несколько альтернативных тестов, которые могли бы оценить сверхразумные системы. [84]

Сознание против симуляции сознания

[ редактировать ]Тест Тьюринга касается исключительно того, как действует субъект – внешнего поведения машины. применяется бихевиористский или функционалистский В этом отношении к изучению разума подход. Пример ELIZA предполагает, что машина, прошедшая тест, может быть способна имитировать разговорное поведение человека, следуя простому (но большому) списку механических правил, вообще не думая и не имея ума.

Джон Сирл утверждал, что внешнее поведение нельзя использовать для определения того, «на самом деле» думает машина или просто «симулирует мышление». [40] Его аргумент о китайской комнате призван показать, что, даже если тест Тьюринга является хорошим оперативным определением интеллекта, он не может указывать на то, что машина обладает разумом , сознанием или интенциональностью . (Интенциональность — это философский термин, обозначающий способность мысли быть «о» чем-то.)

Тьюринг предвидел эту линию критики в своей первоначальной статье: [85] письмо:

Я не хочу создавать впечатление, что, по моему мнению, в сознании нет никакой тайны. Например, существует некий парадокс, связанный с любой попыткой его локализации. Но я не думаю, что эти загадки обязательно нужно разгадать, прежде чем мы сможем ответить на вопрос, который нас интересует в этой статье. [86]

Непрактичность и бесполезность: тест Тьюринга и исследования искусственного интеллекта

[ редактировать ]

Ведущие исследователи ИИ утверждают, что попытка пройти тест Тьюринга — это просто отвлечение от более плодотворных исследований. [48] Действительно, тест Тьюринга не является активным объектом научных или коммерческих усилий — как пишут Стюарт Рассел и Питер Норвиг : «Исследователи ИИ уделяют мало внимания прохождению теста Тьюринга». [87] Есть несколько причин.

Во-первых, есть более простые способы протестировать их программы. Большинство современных исследований в областях, связанных с ИИ, направлены на скромные и конкретные цели, такие как распознавание объектов или логистика . Чтобы проверить интеллект программ, решающих эти проблемы, исследователи ИИ просто дают им задание напрямую. Стюарт Рассел и Питер Норвиг предлагают аналогию с историей полетов : самолеты проверяют по тому, насколько хорошо они летают, а не по сравнению с птицами. « В текстах по авиационной технике , — пишут они, — цель своей области деятельности не определяется как «создание машин, которые летают настолько точно, как , что могут обмануть других голубей » . голуби [87]

Во-вторых, создание реалистичных симуляций людей само по себе является сложной проблемой, которую не нужно решать для достижения основных целей исследований ИИ. Правдоподобные человеческие персонажи могут быть интересны в произведении искусства, игре или сложном пользовательском интерфейсе , но они не являются частью науки создания интеллектуальных машин, то есть машин, решающих проблемы с помощью интеллекта.

Тьюринг не собирался использовать свою идею для проверки интеллекта программ — он хотел предоставить ясный и понятный пример, который поможет в обсуждении философии искусственного интеллекта . [88] Джон Маккарти утверждает, что нам не следует удивляться тому, что философская идея оказывается бесполезной для практического применения. Он отмечает, что философия ИИ «вряд ли окажет большее влияние на практику исследований ИИ, чем философия науки в целом оказывает на научную практику». [89] [90]

Языкоцентрическое возражение

[ редактировать ]Другое широко известное возражение, выдвинутое против теста Тьюринга, касается его исключительного внимания к языковому поведению (т.е. это всего лишь «языковый» эксперимент, в то время как все остальные когнитивные способности не проверяются). Этот недостаток умаляет роль других модально-специфичных «умных способностей» человека, которые психолог Говард Гарднер в своей « теории множественного интеллекта » (вербально-лингвистические способности — лишь одна из них). предлагает учитывать [91]

Тишина

[ редактировать ]Важнейшим аспектом теста Тьюринга является то, что машина должна выдавать себя за машину по своим высказываниям. Затем следователь должен провести «правильную идентификацию», правильно идентифицировав машину как таковую. Однако если машина молчит во время разговора, то собеседник не сможет точно идентифицировать машину, кроме как посредством расчетного предположения. [92] Даже учет параллельного/скрытого человека в рамках теста может не помочь ситуации, поскольку людей часто можно ошибочно принять за машину. [93]

Ловушка Тьюринга

[ редактировать ]Сосредотачиваясь на подражании людям, а не на увеличении или расширении человеческих возможностей, тест Тьюринга рискует направить исследования и внедрение на технологии, которые заменяют людей и тем самым снижают заработную плату и доходы работников. По мере того, как они теряют экономическую власть, эти рабочие могут также потерять политическую власть, что затрудняет им изменение распределения богатства и доходов. Это может привести их в ловушку плохого равновесия. Эрик Бриньольфссон назвал это « ловушкой Тьюринга » и заявил, что в настоящее время существует избыток стимулов для создания машин, которые имитируют, а не дополняют людей.

Вариации

[ редактировать ]На протяжении многих лет выдвигалось множество других версий теста Тьюринга, включая изложенные выше.

Обратный тест Тьюринга и CAPTCHA

[ редактировать ]Модификация теста Тьюринга, в которой цель одной или нескольких ролей между машинами и людьми поменялась местами, называется обратным тестом Тьюринга. Пример подразумевается в работе психоаналитика Уилфреда Биона . [94] которого особенно завораживала «буря», возникшая в результате столкновения одного разума с другим. В своей книге 2000 г. [72] Среди нескольких других оригинальных моментов, касающихся теста Тьюринга, литературовед Питер Свирски подробно обсудил идею того, что он назвал тестом Свирского — по сути, обратного теста Тьюринга. Он отметил, что это преодолевает большинство, если не все стандартные возражения, выдвигаемые против стандартной версии.

Развивая эту идею, Р.Д. Хиншелвуд [95] описал разум как «аппарат распознавания разума». Задача будет заключаться в том, чтобы компьютер смог определить, взаимодействует ли он с человеком или другим компьютером. Это расширение первоначального вопроса, на который Тьюринг пытался ответить, но, возможно, предложил бы достаточно высокий стандарт, чтобы определить машину, которая могла бы «думать» способом, который мы обычно определяем как типично человеческий.

CAPTCHA — это разновидность обратного теста Тьюринга. Прежде чем разрешить выполнить какое-либо действие на веб-сайте, пользователю предъявляют буквенно-цифровые символы в искаженном графическом изображении и просят их напечатать. Это сделано для предотвращения использования автоматизированных систем для злоупотреблений сайтом. Причина в том, что программного обеспечения, достаточно сложного для точного считывания и воспроизведения искаженного изображения, не существует (или оно недоступно обычному пользователю), поэтому любая система, способная это сделать, скорее всего, будет человеком.

Программное обеспечение, которое могло бы с некоторой точностью отменить CAPTCHA путем анализа шаблонов в генерирующем механизме, начало разрабатываться вскоре после создания CAPTCHA. [96] В 2013 году исследователи Vicarious объявили, что они разработали систему для решения задач CAPTCHA от Google , Yahoo! и PayPal в 90 % случаев. [97] В 2014 году инженеры Google продемонстрировали систему, способную решать задачи CAPTCHA с точностью 99,8%. [98] В 2015 году Шуман Госемаджумдер , бывший руководитель Google по мошенничеству с кликами , заявил, что существуют сайты киберпреступников , которые за определенную плату преодолевают проблемы CAPTCHA, чтобы обеспечить различные формы мошенничества. [99]

Отличие точного использования языка от фактического понимания

[ редактировать ]Дальнейший вариант мотивирован опасением, что современные системы обработки естественного языка оказываются очень успешными в генерации текста на основе огромного текстового корпуса и могут в конечном итоге пройти тест Тьюринга, просто манипулируя словами и предложениями, которые использовались при начальном обучении. модели. Поскольку у следователя нет точного понимания обучающих данных, модель может просто возвращать предложения, которые существуют одинаковым образом в огромном объеме обучающих данных. По этой причине Артур Шванингер предлагает вариант теста Тьюринга, который позволяет различать системы, способные только использовать язык, и системы, понимающие язык. Он предлагает тест, в котором машина сталкивается с философскими вопросами, которые не зависят от каких-либо предварительных знаний, но требуют саморефлексии для правильного ответа. [100]

Эксперт в предметной области Тест Тьюринга

[ редактировать ]Другой вариант описывается как тест Тьюринга эксперта в предметной области , при котором реакцию машины невозможно отличить от реакции эксперта в данной области. Это также известно как «тест Фейгенбаума» и было предложено Эдвардом Фейгенбаумом в статье 2003 года. [101]

Тест на когнитивные способности «низкого уровня»

[ редактировать ]Роберт Френч (1990) утверждает, что следователь может различать людей и нечеловеческих собеседников, задавая вопросы, раскрывающие низкоуровневые (т.е. бессознательные) процессы человеческого познания, изучаемые когнитивной наукой . Такие вопросы раскрывают точные детали человеческого воплощения мысли и могут разоблачить компьютер, если он не воспринимает мир так, как это делают люди. [102]

Полный тест Тьюринга

[ редактировать ]«Тотальный тест Тьюринга» [4] вариант теста Тьюринга, предложенный учёным-когнитивистом Стивеном Харнадом , [103] добавляет два дополнительных требования к традиционному тесту Тьюринга. Следователь также может проверить перцептивные способности субъекта (требуется компьютерное зрение ) и способность субъекта манипулировать объектами (требуется робототехника ). [104]

Электронные медицинские карты

[ редактировать ]Письмо опубликовано в журнале Communications of the ACM. [105] описывает концепцию создания синтетической популяции пациентов и предлагает вариант теста Тьюринга для оценки разницы между синтетическими и реальными пациентами. В письме говорится: «В контексте ЭМК, хотя врач-человек может легко отличить синтетически созданных пациентов от реальных живых людей, может ли машина обладать интеллектом, чтобы сделать такое определение самостоятельно?» и далее в письме говорится: «Прежде чем синтетические личности пациентов станут проблемой общественного здравоохранения, законный рынок ЭМК может извлечь выгоду из применения методов, подобных тесту Тьюринга, для обеспечения большей надежности данных и диагностической ценности. Таким образом, любые новые методы должны учитывать гетерогенность пациентов и являются вероятно, будет более сложным, чем может оценить тест Аллена по естествознанию для восьмого класса».

Минимальный интеллектуальный тест сигнала

[ редактировать ]Тест минимального интеллектуального сигнала был предложен Крисом МакКинстри как «максимальная абстракция теста Тьюринга». [106] в котором разрешены только бинарные ответы (правда/ложь или да/нет), чтобы сосредоточиться только на способности мыслить. Он устраняет проблемы текстового чата, такие как предвзятость антропоморфизма , и не требует эмуляции неразумного человеческого поведения , что позволяет создавать системы, превосходящие человеческий интеллект. Однако каждый из вопросов должен быть самостоятельным, что делает его больше похожим на тест IQ, чем на допрос. Обычно он используется для сбора статистических данных, на основе которых можно измерить производительность программ искусственного интеллекта. [107]

Премия Хаттера

[ редактировать ]Организаторы премии Хаттера считают, что сжатие текста на естественном языке — сложная задача искусственного интеллекта, эквивалентная прохождению теста Тьюринга.

Тест сжатия данных имеет некоторые преимущества перед большинством версий и вариантов теста Тьюринга, в том числе:

- Он дает единственное число, которое можно напрямую использовать для сравнения того, какая из двух машин «более умна».

- Компьютер не требует лжи судье

Основными недостатками использования сжатия данных в качестве теста являются:

- Таким способом проверить людей невозможно.

- Неизвестно, какой конкретный «балл» в этом тесте (если таковой имеется) эквивалентен прохождению теста Тьюринга на человеческом уровне.

Другие тесты, основанные на сжатии или сложности Колмогорова.

[ редактировать ]Подход, похожий на премию Хаттера, который появился гораздо раньше, в конце 1990-х годов, — это включение задач сжатия в расширенный тест Тьюринга. [108] или с помощью тестов, полностью выведенных из колмогоровской сложности . [109] Другие родственные тесты этой линии представлены Эрнандесом-Оралло и Доу. [110]

Алгоритмический IQ, или сокращенно AIQ, — это попытка превратить теоретическую меру универсального интеллекта Легга и Хаттера (основанную на индуктивном выводе Соломонова ) в работающий практический тест машинного интеллекта. [111]

Двумя основными преимуществами некоторых из этих тестов являются их применимость к нечеловеческому интеллекту и отсутствие требований к людям-испытателям.

тест Эберта

[ редактировать ]Тест Тьюринга вдохновил на создание теста Эберта, предложенного в 2011 году кинокритиком Роджером Эбертом, который представляет собой тест, обладает ли компьютерно- синтезированный голос достаточными навыками с точки зрения интонаций, интонаций, времени и т. д., чтобы рассмешить людей. [112]

Социальная игра Тьюринга

[ редактировать ]Воспользовавшись преимуществами больших языковых моделей , в 2023 году исследовательская компания AI21 Labs провела социальный онлайн-эксперимент под названием «Человек или нет?». [113] [114] В нее сыграли более 10 миллионов раз более 2 миллионов человек. [115] На тот момент это крупнейший эксперимент в стиле Тьюринга. Результаты показали, что 32% людей не могут отличить человека от машины. [116] [117]

Конференции

[ редактировать ]Коллоквиум Тьюринга

[ редактировать ]В 1990 году исполнилось сорок лет со дня первой публикации статьи Тьюринга «Вычислительная техника и интеллект», и интерес к тесту возобновился. В этом году произошли два важных события: первым стал коллоквиум Тьюринга, который состоялся в Университете Сассекса в апреле и собрал ученых и исследователей из самых разных дисциплин для обсуждения теста Тьюринга с точки зрения его прошлого и настоящего. и будущее; вторым стало учреждение ежегодного конкурса премии Лебнера .

Блей Уитби перечисляет четыре основных поворотных момента в истории теста Тьюринга: публикация «Вычислительной техники и интеллекта» в 1950 году, анонс Джозефа Вайценбаума в ELIZA 1966 году, Кеннетом Колби создание теста PARRY , который был впервые описан. в 1972 году и Тьюринговском коллоквиуме в 1990 году. [118]

Симпозиум AISB 2008 г.

[ редактировать ]Параллельно с вручением премии Лебнера 2008 года в Рединга Университете [119] Общество по изучению искусственного интеллекта и моделирования поведения (AISB) провело однодневный симпозиум по обсуждению теста Тьюринга, организованный Джоном Барнденом , Марком Бишопом , Хумой Шахом и Кевином Уорвиком . [120] Среди выступавших были директор Королевского института баронесса Сьюзан Гринфилд , Сельмер Брингсйорд , биограф Тьюринга Эндрю Ходжес и ученый, занимающийся сознанием Оуэн Холланд . Никакого соглашения по поводу канонического теста Тьюринга достигнуто не было, хотя Брингсйорд заявил, что крупный приз приведет к более быстрому прохождению теста Тьюринга.

См. также

[ редактировать ]- Обработка естественного языка

- Искусственный интеллект в художественной литературе

- Слепое зрение

- Причинность

- Чат-бот

- ЧатGPT

- Компьютерный игровой бот «Тест Тьюринга»

- Теория мертвого Интернета

- Объяснение

- Объяснительный пробел

- Функционализм

- Графический тест Тьюринга

- Бывшая машина (фильм)

- Сложная проблема сознания

- Список вещей, названных в честь Алана Тьюринга

- Mark V. Shaney (Usenet bot)

- Проблема разума и тела

- Зеркальный нейрон

- Философский зомби

- Проблема других умов

- Реверс-инжиниринг

- Чувствительность

- Имитированная реальность

- Социальный бот

- Технологическая особенность

- Теория разума

- Зловещая долина

- Машина Войта-Кампфа (вымышленный тест Тьюринга из «Бегущего по лезвию» )

- Вызов схемы Винограда

- ШРДЛУ

Примечания

[ редактировать ]- ^ Изображение адаптировано из Saygin 2000.

- ^ Перейти обратно: а б ( Тьюринг 1950 ). Тьюринг писал о «игре в имитацию» центрально и подробно на протяжении всего своего текста 1950 года, но впоследствии, очевидно, отказался от этого термина. Он упомянул «[свой] тест» четыре раза — три раза на стр. 446–447 и один раз на стр. 446–447. 454. Он также назвал это «экспериментом» — однажды на с. 436, дважды на с. 455, и еще дважды на с. 457 — и использовал термин «viva voce» (стр. 446), см. Gonçalves (2023b , стр. 2). См. также #Версии ниже. Тьюринг дает более точную версию вопроса далее в статье: «Эти вопросы эквивалентны следующему: «Давайте сосредоточим наше внимание на одном конкретном цифровом компьютере C. Верно ли, что, модифицировав этот компьютер так, чтобы он имел адекватное хранилище, соответствующим образом увеличивающее скорость его действий и снабжающее его соответствующей программой, может заставить С удовлетворительно играть роль А в имитационной игре, причем роль Б берет на себя человек » ( Тьюринг 1950 ? , с. 442)

- ^ Тьюринг первоначально предложил телетайп , одну из немногих систем текстовой связи, доступных в 1950 году. ( Тьюринг 1950 , стр. 433)

- ^ Перейти обратно: а б Оппи, Грэм и Доу, Дэвид (2011). Тест Тьюринга. Архивировано 20 марта 2012 года в Wayback Machine . Стэнфордская энциклопедия философии .

- ^ «Тест Тьюринга, 1950 год» . turing.org.uk . Интернет-альбом для вырезок Алана Тьюринга. Архивировано из оригинала 3 апреля 2019 года . Проверено 23 апреля 2015 г.

- ^ Перейти обратно: а б с Тьюринг 1950 , с. 433.

- ^ Перейти обратно: а б Turing 1950 , стр. 442–454, а также см. Russell & Norvig (2003 , стр. 948), где они комментируют: «Тьюринг исследовал широкий спектр возможных возражений против возможности существования разумных машин, включая практически все те, которые были выдвинуты. за полвека с момента появления его статьи».

- ^ Перейти обратно: а б с д и ж Сайгин 2000 .

- ^ Рассел и Норвиг 2003 , стр. 2–3, 948.

- ^ Свеховский, Мацей (2020). «Соревнования по игровому искусственному интеллекту: мотивация для соревнований по имитации игр» (PDF) . Материалы Федеральной конференции по информатике и информационным системам 2020 года . Издательство IEEE. стр. 155–160. дои : 10.15439/2020F126 . ISBN 978-83-955416-7-4 . S2CID 222296354 . Архивировано (PDF) из оригинала 26 января 2021 года . Проверено 8 сентября 2020 г.

- ^ Декарт 1996 , стр. 34–35 .

- ^ Пример дуализма свойств см. в Qualia .

- ^ Отмечая, что материализм не требует возможности существования искусственного разума (например, Роджера Пенроуза ), так же, как дуализм обязательно исключает эту возможность. (См., например, «Дуализм свойств ».)

- ^ Айер, AJ (2001), «Язык, истина и логика», Nature , 138 (3498), Penguin : 140, Bibcode : 1936Natur.138..823G , doi : 10.1038/138823a0 , ISBN 978-0-334-04122-1 , S2CID 4121089 [ нужны разъяснения ]

- ^ Рапапорт, WJ (2003). Как пройти тест Тьюринга . В: Мур, Дж. Х. (ред.) Тест Тьюринга. Исследования когнитивных систем, том 30. Спрингер, Дордрехт. https://doi.org/10.1007/978-94-010-0105-2_9

- ^ Амини, Маджид (1 мая 2020 г.). «Познание как вычисление: от Свифта до Тьюринга. | Бюллетень гуманитарных наук | EBSCOhost» . openurl.ebsco.com . Проверено 13 июня 2024 г.

- ^ Свифт, Джонатан (1726). «Путешествие в Бробдингнаг. Глава 3» . ru.wikisource.org . Проверено 13 июня 2024 г.

- ^ Перейти обратно: а б Свилпис, Янис (2008). «Научно-фантастическая предыстория теста Тьюринга». Научно-фантастические исследования . 35 (3): 430–449. ISSN 0091-7729 . JSTOR 25475177 .

- ^ Уонсбро, Алекс (2021). Капитализм и заколдованный экран: мифы и аллегории в эпоху цифровых технологий . Нью-Йорк: Bloomsbury Academic. п. 114. ИСБН 978-1-5013-5639-1 . OCLC 1202731640 .

- ^ Дартмутские конференции 1956 года широко считаются «рождением искусственного интеллекта». ( Кревье 1993 , стр. 49)

- ^ МакКордак 2004 , с. 95.

- ^ Коупленд 2003 , с. 1.

- ^ Коупленд 2003 , с. 2.

- ^ «Интеллектуальная техника» (1948) не была опубликована Тьюрингом и не публиковалась до 1968 года в:

- Эванс, ADJ; Робертсон (1968), Кибернетика: ключевые статьи , University Park Press

- ^ Тьюринг 1948 , с. 412.

- ↑ В 1948 году, работая со своим бывшим коллегой по бакалавриату, Д. Г. Чамперноуном , Тьюринг начал писать шахматную программу для ещё не существовавшего компьютера, а в 1952 году, не имея компьютера, достаточно мощного для выполнения этой программы, сыграл в игру, в которой он симулировал на каждый ход уходит около получаса. Игра была записана, и программа проиграла коллеге Тьюринга Алику Гленни , хотя говорят, что выиграла партию у жены Чамперноуна.

- ^ Тьюринг 1948 , с. [ нужна страница ] .

- ^ Харнад 2004 , с. 1.

- ^ Перейти обратно: а б с д и Тьюринг 1950 , с. 434.

- ^ Перейти обратно: а б Шах и Уорвик 2010a .

- ^ Тьюринг 1950 , с. 446.

- ^ Тьюринг 1952 , стр. 524–525. Тьюринг, похоже, не делает различия между «мужчиной» как полом и «мужчиной» как человеком. В первом случае эта формулировка будет ближе к имитационной игре, а во втором — к нынешнему изображению теста.

- ^ Вайценбаум 1966 , с. 37.

- ^ Перейти обратно: а б с Вайценбаум 1966 , с. 42.

- ^ Томас 1995 , с. 112.

- ^ Боден 2006 , с. 370.

- ^ Перейти обратно: а б Колби и др. 1972 , с. 220.

- ^ Уизерс, Стивен (11 декабря 2007 г.), «Flirty Bot Passes for Human» , iTWire , заархивировано из оригинала 4 октября 2017 г. , получено 10 февраля 2010 г.

- ^ Уильямс, Ян (10 декабря 2007 г.), «Искатели любви в Интернете предупредили ботов для флирта» , версия 3 , заархивировано из оригинала 24 апреля 2010 г. , получено 10 февраля 2010 г.

- ^ Перейти обратно: а б Сирл 1980 .

- ↑ Существует большое количество аргументов против китайской комнаты Сирла . Некоторые из них:

- Хаузер, Ларри (1997), «Китайская шкатулка Сирла: развенчание аргумента о китайской комнате», Minds and Machines , 7 (2): 199–226, doi : 10.1023/A:1008255830248 , S2CID 32153206 .

- Рехман, Уоррен. (19 июля 2009 г.), Аргумент против аргумента китайской комнаты , заархивировано из оригинала 19 июля 2010 г.

- Торнли, Дэвид Х. (1997), «Почему китайская комната не работает» , заархивировано из оригинала 26 апреля 2009 г.

- ^ М. Бишоп и Дж. Престон (ред.) (2001) Очерки аргумента Сирла о китайской комнате. Издательство Оксфордского университета.

- ^ Сайгин 2000 , с. 479.

- ^ Сундман 2003 .

- ^ Лебнер 1994 .

- ^ Перейти обратно: а б с «Искусственная глупость». Экономист . Том. 324, нет. 7770. 1 августа 1992. с. 14.

- ^ Перейти обратно: а б с Шапиро 1992 , с. 10–11 и Шибер 1994 , среди других.

- ^ Перейти обратно: а б Шибер 1994 , с. 77.

- ^ «Тест Тьюринга, 4 сезон, 3 серия» . Научные американские границы . Производственная компания Чедд-Анжер. 1993–1994 гг. ПБС . Архивировано из оригинала 1 января 2006 года.

- ^ Дэн Уильямс (9 июня 2022 г.). «По мнению Блеза Агуэра-и-Аркаса, искусственные нейронные сети делают шаги к сознанию» . Экономист . Архивировано из оригинала 9 июня 2022 года . Проверено 13 июня 2022 г.

- ^ Ниташа Тику (11 июня 2022 г.). «Инженер Google, который считает, что ИИ компании ожил» . Вашингтон Пост . Архивировано из оригинала 11 июня 2022 года . Проверено 13 июня 2022 г.

- ^ Джереми Кан (13 июня 2022 г.). «Эксперты по искусственному интеллекту говорят, что утверждение исследователя Google о том, что его чат-бот стал «разумным», абсурдно, но также подчеркивает большие проблемы в этой области» . Удача . Архивировано из оригинала 13 июня 2022 года . Проверено 13 июня 2022 г.

- ^ Бивер, Селеста (25 июля 2023 г.). «ChatGPT сломал тест Тьюринга — идет гонка за новыми способами оценки ИИ» . Природа . 619 (7971): 686–689. Бибкод : 2023Natur.619..686B . дои : 10.1038/d41586-023-02361-7 . Проверено 26 марта 2024 г.

- ^ Скотт, Кэмерон. «Исследование показало, что последний бот ChatGPT ведет себя как человек, только лучше | Стэнфордская школа гуманитарных и естественных наук» . humsci.stanford.edu . Проверено 26 марта 2024 г.

- ^ Мэй, Цяочжу; Се, Ютун; Юань, Уолтер; Джексон, Мэтью О. (27 февраля 2024 г.). «Тест Тьюринга на предмет того, похожи ли чат-боты с искусственным интеллектом по поведению на людей» . Труды Национальной академии наук . 121 (9): e2313925121. дои : 10.1073/pnas.2313925121 . ISSN 0027-8424 . ПМЦ 10907317 . ПМИД 38386710 .

- ^ Перейти обратно: а б с Трейгер 2000 .

- ^ Сайгин, Робертс и Бебер 2008 .

- ^ Перейти обратно: а б Мавр 2003 .

- ^ Трейгер 2000 , с. 99.

- ^ Стерретт 2000 .

- ^ Шах 2011 .

- ^ Генуя 1994 г. , Хейс и Форд 1995 г. , Хайль 1998 г. , Дрейфус 1979 г.

- ^ Тьюринг 1948 , с. 431.

- ^ Праудфут 2013 , с. 398.

- ^ Гонсалвеш 2023a .

- ^ Гонсалвес 2023b .

- ^ Данцигер 2022 .

- ^ Перейти обратно: а б с Тьюринг 1950 , с. 442.

- ^ Р. Эпштейн, Г. Робертс, Г. Поланд, (ред.) Анализ теста Тьюринга: философские и методологические проблемы в поисках мыслящего компьютера. Спрингер: Дордрехт, Нидерланды

- ^ Томпсон, Клайв (июль 2005 г.). «Другой тест Тьюринга» . Выпуск 13.07 . Журнал WIRED . Архивировано из оригинала 19 августа 2011 года . Проверено 10 сентября 2011 г.

Будучи геем, который провел почти всю свою жизнь в туалете, Тьюринг, должно быть, остро осознавал социальные трудности, связанные с постоянной фальсификацией своей настоящей личности. И есть восхитительная ирония в том, что десятилетия учёных в области искусственного интеллекта предпочитали игнорировать тест Тьюринга на гендерные искажения – только для того, чтобы им ухватились три женщины студенческого возраста

. ( Полная версия. Архивировано 23 марта 2019 г. на Wayback Machine ). - ^ Колби и др. 1972 год .

- ^ Перейти обратно: а б Свирски 2000 .

- ^ Сайгин и Чичекли 2002 .

- ^ Тьюринг 1950 , в разделе «Критика новой проблемы».

- ^ Хаугеланд 1985 , с. 8.

- ^ «Эти шесть дисциплин, — пишут Стюарт Дж. Рассел и Питер Норвиг , — представляют собой большую часть ИИ». Рассел и Норвиг 2003 , с. 3

- ^ Урбан, Тим (февраль 2015 г.). «Революция искусственного интеллекта: наше бессмертие или вымирание» . Подождите, но почему. Архивировано из оригинала 23 марта 2019 года . Проверено 5 апреля 2015 г.

- ^ Смит, GW (27 марта 2015 г.). «Искусство и искусственный интеллект» . АртЭнт. Архивировано из оригинала 25 июня 2017 года . Проверено 27 марта 2015 г.

- ^ Маркус, Гэри (9 июня 2014 г.). «Что происходит после теста Тьюринга?» . Житель Нью-Йорка . Архивировано из оригинала 1 января 2022 года . Проверено 16 декабря 2021 г.

- ^ Шах и Уорвик 2010j .

- ^ Кевин Уорвик; Хума Шах (июнь 2014 г.). «Ошибочная идентификация человека в тестах Тьюринга». Журнал экспериментального и теоретического искусственного интеллекта . 27 (2): 123–135. дои : 10.1080/0952813X.2014.921734 . S2CID 45773196 .

- ^ Сайгин и Чичекли 2002 , стр. 227–258.

- ^ Тьюринг 1950 , с. 448.

- ^ Несколько альтернатив тесту Тьюринга, предназначенных для оценки машин, более умных, чем люди:

- Хосе Эрнандес-Оралло (2000), «За пределами теста Тьюринга», Journal of Logic, Language and Information , 9 (4): 447–466, CiteSeerX 10.1.1.44.8943 , doi : 10.1023/A:1008367325700 , S2CID 14481982 .

- Д.Л. Доу и А.Р. Хайек (1997), «Вычислительное расширение теста Тьюринга» , Труды 4-й конференции Австралазийского общества когнитивных наук , заархивировано из оригинала 28 июня 2011 г. , получено 21 июля 2009 г.

- Шейн Легг и Маркус Хаттер (2007), «Универсальный интеллект: определение машинного интеллекта» (PDF) , Minds and Machines , 17 (4): 391–444, arXiv : 0712.3329 , Bibcode : 2007arXiv0712.3329L , doi : 10.1007/ s11023-007-9079-x , S2CID 847021 , заархивировано из оригинала (PDF) 18 июня 2009 г. , получено 21 июля 2009 г.

- Эрнандес-Оралло, Дж; Доу, Д.Л. (2010), «Измерение универсального интеллекта: к тесту интеллекта в любое время», Искусственный интеллект , 174 (18): 1508–1539, doi : 10.1016/j.artint.2010.09.006 .

- ^ Рассел и Норвиг (2003 , стр. 958–960) отождествляют аргумент Сирла с тем, на который отвечает Тьюринг.

- ^ Тьюринг 1950 .

- ^ Перейти обратно: а б Рассел и Норвиг 2003 , с. 3.

- ↑ Тьюринг 1950 , под заголовком «Игра в имитацию», где он пишет: «Вместо того, чтобы пытаться дать такое определение, я заменю этот вопрос другим, который тесно с ним связан и выражен относительно недвусмысленными словами».

- ^ Маккарти, Джон (1996), «Философия искусственного интеллекта» , Что общего у искусственного интеллекта с философией? , архивировано из оригинала 5 апреля 2019 года , получено 26 февраля 2009 года.

- ^ Бриньольфссон, Эрик (1 мая 2022 г.). «Ловушка Тьюринга: перспективы и опасности человеческого искусственного интеллекта» . Дедал . 151 (2): 272–287. дои : 10.1162/daed_a_01915 .

- ^ Гарднер, Х. (2011). Образ мышления: теория множественного интеллекта. Хачетт Великобритания

- ^ Уорвик, Кевин; Шах, Хума (4 марта 2017 г.). «Принятие пятой поправки в имитационной игре Тьюринга» (PDF) . Журнал экспериментального и теоретического искусственного интеллекта . 29 (2): 287–297. Бибкод : 2017JETAI..29..287W . дои : 10.1080/0952813X.2015.1132273 . ISSN 0952-813X . S2CID 205634569 . [ постоянная мертвая ссылка ]

- ^ Уорвик, Кевин; Шах, Хума (4 марта 2015 г.). «Ошибочная идентификация человека в тестах Тьюринга». Журнал экспериментального и теоретического искусственного интеллекта . 27 (2): 123–135. дои : 10.1080/0952813X.2014.921734 . ISSN 0952-813X . S2CID 45773196 .

- ^ Бион 1979 .

- ^ Хиншельвуд 2001 .

- ^ Малик, Джитендра ; Мори, Грег, Взлом визуальной капчи , заархивировано из оригинала 23 марта 2019 г. , получено 21 ноября 2009 г.

- ^ Пачал, Пит, Captcha FAIL: Исследователи взломали самый популярный тест Тьюринга в Интернете , заархивировано из оригинала 3 декабря 2018 г. , получено 31 декабря 2015 г.

- ^ Тунг, Лиам, алгоритм Google разрушает CAPTCHA с точностью 99,8 процента , заархивировано из оригинала 23 марта 2019 г. , получено 31 декабря 2015 г.

- ^ Госемаджумдер, Шуман, Игра в имитацию: новый фронт безопасности , заархивировано из оригинала 23 марта 2019 г. , получено 31 декабря 2015 г.

- ^ Шванингер, Артур К. (2022), «Философствующая машина – спецификация теста Тьюринга», Philosophia , 50 (3): 1437–1453, doi : 10.1007/s11406-022-00480-5 , S2CID 247282718

- ^ МакКордак 2004 , стр. 503–505, Фейгенбаум 2003 . Экспертный тест по предмету также упоминается у Курцвейла (2005).

- ^ Френч, Роберт М. , «Подсознание и пределы теста Тьюринга», Mind , 99 (393): 53–65.

- ^ Гент, Эдд (2014), Тест Тьюринга: многопутевой подход к вычислениям, вдохновленным мозгом , заархивировано из оригинала 23 марта 2019 г. , получено 18 октября 2018 г.

- ^ Рассел и Норвиг 2010 , с. 3.

- ^ Персонал Cacm (2017). «Прыжок от искусственного к интеллекту». Коммуникации АКМ . 61 : 10–11. дои : 10.1145/3168260 .

- ^ [1]

- ^ МакКинстри, Крис (1997), «Тест минимального интеллектуального сигнала: альтернативный тест Тьюринга» , Канадский искусственный интеллект (41), заархивировано из оригинала 31 марта 2019 г. , получено 4 мая 2011 г.

- ^ Д.Л. Доу и А.Р. Хайек (1997), «Вычислительное расширение теста Тьюринга» , Труды 4-й конференции Австралазийского общества когнитивных наук , заархивировано из оригинала 28 июня 2011 г. , получено 21 июля 2009 г.

- ^ Хосе Эрнандес-Оралло (2000), «За пределами теста Тьюринга», Journal of Logic, Language and Information , 9 (4): 447–466, CiteSeerX 10.1.1.44.8943 , doi : 10.1023/A:1008367325700 , S2CID 14481982 .

- ^ Эрнандес-Оралло и Доу, 2010 .

- ^ Приближение меры универсального интеллекта, Шейн Легг и Джоэл Венесс, Конференция памяти Соломонова, 2011 г.

- ^ Алекс_Пастернак (18 апреля 2011 г.). «MacBook, возможно, подарил Роджеру Эберту его голос, но iPod спас ему жизнь (Видео)» . Материнская плата. Архивировано из оригинала 6 сентября 2011 года . Проверено 12 сентября 2011 г.

Он называет это «тестом Эберта» в честь стандарта искусственного интеллекта Тьюринга...

- ^ Ки, Элис (21 апреля 2023 г.). «Можете ли вы сказать, был ли кто-то человеком или искусственным интеллектом?» . Вечерний стандарт . Проверено 2 августа 2023 г.

- ^ «Масштабный тест Тьюринга показывает, что мы можем лишь с трудом отличить ИИ от людей» . Новый учёный . Проверено 2 августа 2023 г.

- ^ Бивер, Селеста (25 июля 2023 г.). «ChatGPT сломал тест Тьюринга — идет гонка за новыми способами оценки ИИ» . Природа . 619 (7971): 686–689. Бибкод : 2023Natur.619..686B . дои : 10.1038/d41586-023-02361-7 . ПМИД 37491395 .

- ^ «Можете ли вы отличить людей от ботов с искусственным интеллектом? Онлайн-игра «Человек или нет» дает результаты» . ЗДНЕТ . Проверено 2 августа 2023 г.

- ^ Пресс, Гил. «Это чат-бот с искусственным интеллектом или человек? 32% не могут сказать» . Форбс . Проверено 2 августа 2023 г.

- ^ Уитби 1996 , с. 53.

- ^ Премия Лебнера 2008 г. , Университет Рединга , получено 29 марта 2009 г. [ постоянная мертвая ссылка ]

- ^ Симпозиум AISB 2008 по тесту Тьюринга , Общество изучения искусственного интеллекта и моделирования поведения, заархивировано из оригинала 18 марта 2009 г. , получено 29 марта 2009 г.

Ссылки

[ редактировать ]- Бион, WS (1979), «Как сделать плохую работу максимально полезной», Клинические семинары и четыре статьи , Абингдон: Fleetwood Press.

- Боден, Маргарет А. (2006), Разум как машина: история когнитивной науки , Oxford University Press , ISBN 978-0-19-924144-6

- Колби, КМ; Хильф, Флорида; Вебер, С.; Кремер, Х. (1972), «Тьюринговские тесты неотличимости для проверки компьютерного моделирования параноидальных процессов», Искусственный интеллект , 3 : 199–221, doi : 10.1016/0004-3702(72)90049-5

- Коупленд, Джек (2003), Мур, Джеймс (редактор), «Тест Тьюринга», Тест Тьюринга: неуловимый стандарт искусственного интеллекта , Springer, ISBN 978-1-4020-1205-1

- Кревье, Дэниел (1993), AI: Бурные поиски искусственного интеллекта , Нью-Йорк, Нью-Йорк: BasicBooks, ISBN 978-0-465-02997-6

- Данцигер, Шломо (2022), «Интеллект как социальная концепция: социотехнологическая интерпретация теста Тьюринга», Philosophy & Technology , 35 (3): 68, doi : 10.1007/s13347-022-00561-z , S2CID 251000575

- Декарт, Рене (1996). Рассуждение о методе и размышления о первой философии . Нью-Хейвен и Лондон: Издательство Йельского университета. ISBN 978-0-300-06772-9 .

- Дидро, Д. (2007), Философские мысли, Дополнение к философским мыслям , [Фламмарион], ISBN 978-2-0807-1249-3

- Дрейфус, Хьюберт (1979), Чего компьютеры все еще не могут сделать , Нью-Йорк: MIT Press, ISBN 978-0-06-090613-9

- Фейгенбаум, Эдвард А. (2003), «Некоторые проблемы и большие проблемы вычислительного интеллекта», Журнал ACM , 50 (1): 32–40, doi : 10.1145/602382.602400 , S2CID 15379263

- Френч, Роберт М. (1990), «Подсознание и пределы теста Тьюринга», Mind , 99 (393): 53–65, doi : 10.1093/mind/xcix.393.53 , S2CID 38063853

- Дженова, Дж. (1994), «Игра Тьюринга в угадайку сексуального характера», Social Epistemology , 8 (4): 314–326, doi : 10.1080/02691729408578758

- Гонсалвес, Бернардо (2023a), «Резонансы Галилея: роль эксперимента в построении Тьюрингом машинного интеллекта», Annals of Science , 81 : 1–31, doi : 10.1080/00033790.2023.2234912 , PMID 37466560

- Гонсалвес, Бернардо (2023b), «Тест Тьюринга — это мысленный эксперимент», Minds & Machines , 33 : 1–31, doi : 10.1007/s11023-022-09616-8

- Харнад, Стеван (2004), «Аннотационная игра: О Тьюринге (1950) о вычислительной технике, технике и интеллекте», в Эпштейне, Роберте; Питерс, Грейс (ред.), Справочник по тесту Тьюринга: Философские и методологические проблемы в поисках мыслящего компьютера , Клевер, заархивировано из оригинала 6 июля 2011 г. , получено 17 декабря 2005 г.

- Хаугеланд, Джон (1985), Искусственный интеллект: сама идея , Кембридж, Массачусетс: MIT Press .

- Хейс, Патрик; Форд, Кеннет (1995), «Тест Тьюринга считается вредным», Труды четырнадцатой Международной совместной конференции по искусственному интеллекту (IJCAI95-1), Монреаль, Квебек, Канада. : 972–997

- Хейл, Джон (1998), Философия разума: современное введение , Лондон и Нью-Йорк: Routledge, ISBN 978-0-415-13060-8

- Хиншелвуд, Р.Д. (2001), Групповой менталитет и наличие разума: размышления о работе Биона о группах и психозе.

- Курцвейл, Рэй (1990), Эпоха интеллектуальных машин , Кембридж, Массачусетс: MIT Press, ISBN 978-0-262-61079-7

- Курцвейл, Рэй (2005), Сингулярность близка , Penguin Books, ISBN 978-0-670-03384-3

- Лебнер, Хью Джин (1994), «В ответ» , Communications of the ACM , 37 (6): 79–82, doi : 10.1145/175208.175218 , S2CID 38428377 , заархивировано из оригинала 14 марта 2008 г. , получено 22 марта 2008 г.

- МакКордак, Памела (2004), Машины, которые думают (2-е изд.), Натик, Массачусетс: AK Peters, Ltd., ISBN 1-56881-205-1

- Мур, Джеймс, изд. (2003), Тест Тьюринга: неуловимый стандарт искусственного интеллекта , Дордрехт: Kluwer Academic Publishers, ISBN 978-1-4020-1205-1

- Пенроуз, Роджер (1989), Новый разум императора: о компьютерах, разуме и законах физики , Oxford University Press, ISBN 978-0-14-014534-2

- Праудфут, Дайан (июль 2013 г.), «Переосмысление теста Тьюринга», The Journal of Philosophy , 110 (7): 391–411, doi : 10.5840/jphil2013110722 , JSTOR 43820781

- Рассел, Стюарт Дж .; Норвиг, Питер (2003), Искусственный интеллект: современный подход (2-е изд.), Аппер-Сэддл-Ривер, Нью-Джерси: Прентис-Холл, ISBN 0-13-790395-2

- Рассел, Стюарт Дж.; Норвиг, Питер (2010), Искусственный интеллект: современный подход (3-е изд.), Аппер-Сэдд-Ривер, Нью-Джерси: Прентис-Холл, ISBN 978-0-13-604259-4

- Сайгин, А.П.; Чичекли, И.; Акман, В. (2000), «Тест Тьюринга: 50 лет спустя» (PDF) , Minds and Machines , 10 (4): 463–518, doi : 10.1023/A:1011288000451 , hdl : 11693/24987 , S2CID 990084 , Архивировано из оригинала (PDF) 9 апреля 2011 года , получено 7 января 2004 года . Перепечатано в Moor (2003 , стр. 23–78).

- Сайгин, А.П.; Чичекли, И. (2002), «Прагматика в общении человека с компьютером», Journal of Pragmatics , 34 (3): 227–258, CiteSeerX 10.1.1.12.7834 , doi : 10.1016/S0378-2166(02)80001-7 .

- Сайгин, А.П.; Робертс, Гэри; Бебер, Грейс (2008), «Комментарии к «Вычислительной технике и интеллекту» Алана Тьюринга», в Эпштейне, Р.; Робертс, Г.; Польша, Г. (ред.), Анализ теста Тьюринга: философские и методологические проблемы в поисках мыслящего компьютера , Дордрехт, Нидерланды: Springer, Bibcode : 2009pttt.book.....E , doi : 10.1007/978- 1-4020-6710-5 , ISBN 978-1-4020-9624-2 , S2CID 60070108

- Сирл, Джон (1980), «Мысли, мозг и программы» , Поведенческие и мозговые науки , 3 (3): 417–457, doi : 10.1017/S0140525X00005756 , S2CID 55303721 , заархивировано из оригинала 23 августа 2000 г. , получено 19 марта. 2008 год . Номера страниц выше относятся к стандартной в формате PDF распечатке статьи Сирла . См. также первоначальный проект .

- Шах, Хума; Уорвик, Кевин (2009a), «Эмоции в тесте Тьюринга: тенденция к снижению числа машин в недавних премиях Лёбнера», в Вальверду, Хорди; Касакуберта, Дэвид (ред.), Справочник по исследованиям синтетических эмоций и общительной робототехники: новые применения в аффективных вычислениях и искусственном интеллекте , информатика, IGI, ISBN 978-1-60566-354-8

- Шах, Хума; Уорвик, Кевин (апрель 2010 г.), «Тестирование пятиминутной имитационной игры Тьюринга в параллельных парах», Kybernetes , 4 (3): 449–465, doi : 10.1108/03684921011036178

- Шах, Хума; Уорвик, Кевин (июнь 2010j), «Ошибочная идентификация скрытого собеседника в практических тестах Тьюринга», Minds and Machines , 20 (3): 441–454, doi : 10.1007/s11023-010-9219-6 , S2CID 34076187

- Шах, Хума (5 апреля 2011 г.), неправильно понятая имитационная игра Тьюринга и успех IBM Watson , заархивировано из оригинала 10 февраля 2023 г. , получено 20 декабря 2017 г.

- Шапиро, Стюарт К. (1992), «Тест Тьюринга и экономист», Бюллетень ACM SIGART , 3 (4): 10–11, doi : 10.1145/141420.141423 , S2CID 27079507