Глубокое обучение

| Часть серии о |

| Искусственный интеллект |

|---|

Глубокое обучение — это подмножество методов машинного обучения , основанных на нейронных сетях с обучением представлений . Прилагательное «глубокий» относится к использованию в сети нескольких уровней. Используемые методы могут быть контролируемыми , полуконтролируемыми или неконтролируемыми . [2]

Архитектуры глубокого обучения, такие как глубокие нейронные сети , сети глубоких убеждений , рекуррентные нейронные сети , сверточные нейронные сети и преобразователи, применяются в таких областях, как компьютерное зрение , распознавание речи , обработка естественного языка , машинный перевод , биоинформатика , дизайн лекарств , анализ медицинских изображений. , климатологии , инспекции материалов и программ настольных игр , где они дали результаты, сравнимые, а в некоторых случаях превосходящие результаты человеческих экспертов. [3] [4] [5]

Early forms of neural networks were inspired by information processing and distributed communication nodes in biological systems, in particular the human brain. However, current neural networks do not intend to model the brain function of organisms, and are generally seen as low quality models for that purpose.[6]

Overview[edit]

Most modern deep learning models are based on multi-layered neural networks such as convolutional neural networks and transformers, although they can also include propositional formulas or latent variables organized layer-wise in deep generative models such as the nodes in deep belief networks and deep Boltzmann machines.[7]

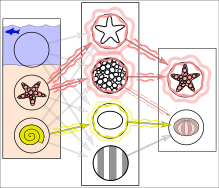

Fundamentally, deep learning refers to a class of machine learning algorithms in which a hierarchy of layers is used to transform input data into a slightly more abstract and composite representation. For example, in an image recognition model, the raw input may be an image (represented as a tensor of pixels). The first representational layer may attempt to identify basic shapes such as lines and circles, the second layer may compose and encode arrangements of edges, the third layer may encode a nose and eyes, and the fourth layer may recognize that the image contains a face.

Importantly, a deep learning process can learn which features to optimally place in which level on its own. Prior to deep learning, machine learning techniques often involved hand-crafted feature engineering to transform the data into a more suitable representation for a classification algorithm to operate upon. In the deep learning approach, features are not hand-crafted and the model discovers useful feature representations from the data automatically. This does not eliminate the need for hand-tuning; for example, varying numbers of layers and layer sizes can provide different degrees of abstraction.[8][2]

The word "deep" in "deep learning" refers to the number of layers through which the data is transformed. More precisely, deep learning systems have a substantial credit assignment path (CAP) depth. The CAP is the chain of transformations from input to output. CAPs describe potentially causal connections between input and output. For a feedforward neural network, the depth of the CAPs is that of the network and is the number of hidden layers plus one (as the output layer is also parameterized). For recurrent neural networks, in which a signal may propagate through a layer more than once, the CAP depth is potentially unlimited.[9] No universally agreed-upon threshold of depth divides shallow learning from deep learning, but most researchers agree that deep learning involves CAP depth higher than 2. CAP of depth 2 has been shown to be a universal approximator in the sense that it can emulate any function.[10] Beyond that, more layers do not add to the function approximator ability of the network. Deep models (CAP > 2) are able to extract better features than shallow models and hence, extra layers help in learning the features effectively.

Deep learning architectures can be constructed with a greedy layer-by-layer method.[11] Deep learning helps to disentangle these abstractions and pick out which features improve performance.[8]

Deep learning algorithms can be applied to unsupervised learning tasks. This is an important benefit because unlabeled data are more abundant than the labeled data. Examples of deep structures that can be trained in an unsupervised manner are deep belief networks.[8][12]

Interpretations[edit]

Deep neural networks are generally interpreted in terms of the universal approximation theorem[13][14][15][16][17] or probabilistic inference.[18][19][8][9][20]

The classic universal approximation theorem concerns the capacity of feedforward neural networks with a single hidden layer of finite size to approximate continuous functions.[13][14][15][16] In 1989, the first proof was published by George Cybenko for sigmoid activation functions[13] and was generalised to feed-forward multi-layer architectures in 1991 by Kurt Hornik.[14] Recent work also showed that universal approximation also holds for non-bounded activation functions such as Kunihiko Fukushima's rectified linear unit.[21][22]

The universal approximation theorem for deep neural networks concerns the capacity of networks with bounded width but the depth is allowed to grow. Lu et al.[17] proved that if the width of a deep neural network with ReLU activation is strictly larger than the input dimension, then the network can approximate any Lebesgue integrable function; if the width is smaller or equal to the input dimension, then a deep neural network is not a universal approximator.

The probabilistic interpretation[20] derives from the field of machine learning. It features inference,[19][7][8][9][12][20] as well as the optimization concepts of training and testing, related to fitting and generalization, respectively. More specifically, the probabilistic interpretation considers the activation nonlinearity as a cumulative distribution function.[20] The probabilistic interpretation led to the introduction of dropout as regularizer in neural networks. The probabilistic interpretation was introduced by researchers including Hopfield, Widrow and Narendra and popularized in surveys such as the one by Bishop.[23]

History[edit]

There were two types of artificial neural network (ANN): feedforward neural networks (FNNs) and recurrent neural networks (RNNs). RNNs have cycles in their connectivity structure, FNNs don't. In the 1920s, Wilhelm Lenz and Ernst Ising created and analyzed the Ising model[24] which is essentially a non-learning RNN architecture consisting of neuron-like threshold elements. In 1972, Shun'ichi Amari made this architecture adaptive.[25][26] His learning RNN was popularised by John Hopfield in 1982.[27]

Charles Tappert writes that Frank Rosenblatt developed and explored all of the basic ingredients of the deep learning systems of today,[28] referring to Rosenblatt's 1962 book[29] which introduced multilayer perceptron (MLP) with 3 layers: an input layer, a hidden layer with randomized weights that did not learn, and an output layer. It also introduced variants, including a version with four-layer perceptrons where the last two layers have learned weights (and thus a proper multilayer perceptron).[29]: section 16 In addition, term deep learning was proposed in 1986 by Rina Dechter[30] although the history of its appearance is apparently more complicated.[31]

The first general, working learning algorithm for supervised, deep, feedforward, multilayer perceptrons was published by Alexey Ivakhnenko and Lapa in 1967.[32] A 1971 paper described a deep network with eight layers trained by the group method of data handling.[33]

The first deep learning multilayer perceptron trained by stochastic gradient descent[34] was published in 1967 by Shun'ichi Amari.[35][26] In computer experiments conducted by Amari's student Saito, a five layer MLP with two modifiable layers learned internal representations to classify non-linearily separable pattern classes.[26] In 1987 Matthew Brand reported that wide 12-layer nonlinear perceptrons could be fully end-to-end trained to reproduce logic functions of nontrivial circuit depth via gradient descent on small batches of random input/output samples, but concluded that training time on contemporary hardware (sub-megaflop computers) made the technique impractical, and proposed using fixed random early layers as an input hash for a single modifiable layer.[36] Instead, subsequent developments in hardware and hyperparameter tunings have made end-to-end stochastic gradient descent the currently dominant training technique.

In 1970, Seppo Linnainmaa published the reverse mode of automatic differentiation of discrete connected networks of nested differentiable functions.[37][38][39] This became known as backpropagation.[9] It is an efficient application of the chain rule derived by Gottfried Wilhelm Leibniz in 1673[40] to networks of differentiable nodes.[26] The terminology "back-propagating errors" was actually introduced in 1962 by Rosenblatt,[29][26] but he did not know how to implement this, although Henry J. Kelley had a continuous precursor of backpropagation[41] already in 1960 in the context of control theory.[26] In 1982, Paul Werbos applied backpropagation to MLPs in the way that has become standard.[42][43][26] In 1985, David E. Rumelhart et al. published an experimental analysis of the technique.[44]

Deep learning architectures for convolutional neural networks (CNNs) with convolutional layers and downsampling layers began with the Neocognitron introduced by Kunihiko Fukushima in 1980.[45] In 1969, he also introduced the ReLU (rectified linear unit) activation function.[21][26] The rectifier has become the most popular activation function for CNNs and deep learning in general.[46] CNNs have become an essential tool for computer vision.

The term Deep Learning was introduced to the machine learning community by Rina Dechter in 1986,[30] and to artificial neural networks by Igor Aizenberg and colleagues in 2000, in the context of Boolean threshold neurons.[47][48]

In 1988, Wei Zhang et al. applied the backpropagation algorithm to a convolutional neural network (a simplified Neocognitron with convolutional interconnections between the image feature layers and the last fully connected layer) for alphabet recognition. They also proposed an implementation of the CNN with an optical computing system.[49][50] In 1989, Yann LeCun et al. applied backpropagation to a CNN with the purpose of recognizing handwritten ZIP codes on mail. While the algorithm worked, training required 3 days.[51] Subsequently, Wei Zhang, et al. modified their model by removing the last fully connected layer and applied it for medical image object segmentation in 1991[52] and breast cancer detection in mammograms in 1994.[53] LeNet-5 (1998), a 7-level CNN by Yann LeCun et al.,[54] that classifies digits, was applied by several banks to recognize hand-written numbers on checks digitized in 32x32 pixel images.

In the 1980s, backpropagation did not work well for deep learning with long credit assignment paths. To overcome this problem, Jürgen Schmidhuber (1992) proposed a hierarchy of RNNs pre-trained one level at a time by self-supervised learning.[55] It uses predictive coding to learn internal representations at multiple self-organizing time scales. This can substantially facilitate downstream deep learning. The RNN hierarchy can be collapsed into a single RNN, by distilling a higher level chunker network into a lower level automatizer network.[55][26] In 1993, a chunker solved a deep learning task whose depth exceeded 1000.[56]

In 1992, Jürgen Schmidhuber also published an alternative to RNNs[57] which is now called a linear Transformer or a Transformer with linearized self-attention[58][59][26] (save for a normalization operator). It learns internal spotlights of attention:[60] a slow feedforward neural network learns by gradient descent to control the fast weights of another neural network through outer products of self-generated activation patterns FROM and TO (which are now called key and value for self-attention).[58] This fast weight attention mapping is applied to a query pattern.

The modern Transformer was introduced by Ashish Vaswani et al. in their 2017 paper "Attention Is All You Need".[61] It combines this with a softmax operator and a projection matrix.[26]Transformers have increasingly become the model of choice for natural language processing.[62] Many modern large language models such as ChatGPT, GPT-4, and BERT use it. Transformers are also increasingly being used in computer vision.[citation needed]

In 1991, Jürgen Schmidhuber also published adversarial neural networks that contest with each other in the form of a zero-sum game, where one network's gain is the other network's loss.[63][64][65] The first network is a generative model that models a probability distribution over output patterns. The second network learns by gradient descent to predict the reactions of the environment to these patterns. This was called "artificial curiosity". In 2014, this principle was used in a generative adversarial network (GAN) by Ian Goodfellow et al.[66] Here the environmental reaction is 1 or 0 depending on whether the first network's output is in a given set. This can be used to create realistic deepfakes.[67] Excellent image quality is achieved by Nvidia's StyleGAN (2018)[68] based on the Progressive GAN by Tero Karras et al.[69] Here the GAN generator is grown from small to large scale in a pyramidal fashion.

Sepp Hochreiter's diploma thesis (1991)[70] was called "one of the most important documents in the history of machine learning" by his supervisor Schmidhuber.[26] It not only tested the neural history compressor,[55] but also identified and analyzed the vanishing gradient problem.[70][71] Hochreiter proposed recurrent residual connections to solve this problem. This led to the deep learning method called long short-term memory (LSTM), published in 1997.[72] LSTM recurrent neural networks can learn "very deep learning" tasks[9] with long credit assignment paths that require memories of events that happened thousands of discrete time steps before. The "vanilla LSTM" with forget gate was introduced in 1999 by Felix Gers, Schmidhuber and Fred Cummins.[73] LSTM has become the most cited neural network of the 20th century.[26]In 2015, Rupesh Kumar Srivastava, Klaus Greff, and Schmidhuber used LSTM principles to create the Highway network, a feedforward neural network with hundreds of layers, much deeper than previous networks.[74][75] 7 months later, Kaiming He, Xiangyu Zhang; Shaoqing Ren, and Jian Sun won the ImageNet 2015 competition with an open-gated or gateless Highway network variant called Residual neural network.[76] This has become the most cited neural network of the 21st century.[26]

In 1994, André de Carvalho, together with Mike Fairhurst and David Bisset, published experimental results of a multi-layer boolean neural network, also known as a weightless neural network, composed of a 3-layers self-organising feature extraction neural network module (SOFT) followed by a multi-layer classification neural network module (GSN), which were independently trained. Each layer in the feature extraction module extracted features with growing complexity regarding the previous layer.[77]

In 1995, Brendan Frey demonstrated that it was possible to train (over two days) a network containing six fully connected layers and several hundred hidden units using the wake-sleep algorithm, co-developed with Peter Dayan and Hinton.[78]

Since 1997, Sven Behnke extended the feed-forward hierarchical convolutional approach in the Neural Abstraction Pyramid[79] by lateral and backward connections in order to flexibly incorporate context into decisions and iteratively resolve local ambiguities.

Simpler models that use task-specific handcrafted features such as Gabor filters and support vector machines (SVMs) were a popular choice in the 1990s and 2000s, because of artificial neural networks' computational cost and a lack of understanding of how the brain wires its biological networks.

Both shallow and deep learning (e.g., recurrent nets) of ANNs for speech recognition have been explored for many years.[80][81][82] These methods never outperformed non-uniform internal-handcrafting Gaussian mixture model/Hidden Markov model (GMM-HMM) technology based on generative models of speech trained discriminatively.[83] Key difficulties have been analyzed, including gradient diminishing[70] and weak temporal correlation structure in neural predictive models.[84][85] Additional difficulties were the lack of training data and limited computing power. Most speech recognition researchers moved away from neural nets to pursue generative modeling. An exception was at SRI International in the late 1990s. Funded by the US government's NSA and DARPA, SRI studied deep neural networks (DNNs) in speech and speaker recognition. The speaker recognition team led by Larry Heck reported significant success with deep neural networks in speech processing in the 1998 National Institute of Standards and Technology Speaker Recognition evaluation.[86] The SRI deep neural network was then deployed in the Nuance Verifier, representing the first major industrial application of deep learning.[87] The principle of elevating "raw" features over hand-crafted optimization was first explored successfully in the architecture of deep autoencoder on the "raw" spectrogram or linear filter-bank features in the late 1990s,[87] showing its superiority over the Mel-Cepstral features that contain stages of fixed transformation from spectrograms. The raw features of speech, waveforms, later produced excellent larger-scale results.[88]

Speech recognition was taken over by LSTM. In 2003, LSTM started to become competitive with traditional speech recognizers on certain tasks.[89] In 2006, Alex Graves, Santiago Fernández, Faustino Gomez, and Schmidhuber combined it with connectionist temporal classification (CTC)[90] in stacks of LSTM RNNs.[91] In 2015, Google's speech recognition reportedly experienced a dramatic performance jump of 49% through CTC-trained LSTM, which they made available through Google Voice Search.[92]

The impact of deep learning in industry began in the early 2000s, when CNNs already processed an estimated 10% to 20% of all the checks written in the US, according to Yann LeCun.[93] Industrial applications of deep learning to large-scale speech recognition started around 2010.

In 2006, publications by Geoff Hinton, Ruslan Salakhutdinov, Osindero and Teh[94][95][96] showed how a many-layered feedforward neural network could be effectively pre-trained one layer at a time, treating each layer in turn as an unsupervised restricted Boltzmann machine, then fine-tuning it using supervised backpropagation.[97] The papers referred to learning for deep belief nets.

The 2009 NIPS Workshop on Deep Learning for Speech Recognition was motivated by the limitations of deep generative models of speech, and the possibility that given more capable hardware and large-scale data sets that deep neural nets might become practical. It was believed that pre-training DNNs using generative models of deep belief nets (DBN) would overcome the main difficulties of neural nets. However, it was discovered that replacing pre-training with large amounts of training data for straightforward backpropagation when using DNNs with large, context-dependent output layers produced error rates dramatically lower than then-state-of-the-art Gaussian mixture model (GMM)/Hidden Markov Model (HMM) and also than more-advanced generative model-based systems.[98] The nature of the recognition errors produced by the two types of systems was characteristically different,[99] offering technical insights into how to integrate deep learning into the existing highly efficient, run-time speech decoding system deployed by all major speech recognition systems.[19][100][101] Analysis around 2009–2010, contrasting the GMM (and other generative speech models) vs. DNN models, stimulated early industrial investment in deep learning for speech recognition.[99] That analysis was done with comparable performance (less than 1.5% in error rate) between discriminative DNNs and generative models.[98][99][102]In 2010, researchers extended deep learning from TIMIT to large vocabulary speech recognition, by adopting large output layers of the DNN based on context-dependent HMM states constructed by decision trees.[103][104][105][100]

Deep learning is part of state-of-the-art systems in various disciplines, particularly computer vision and automatic speech recognition (ASR). Results on commonly used evaluation sets such as TIMIT (ASR) and MNIST (image classification), as well as a range of large-vocabulary speech recognition tasks have steadily improved.[98][106] Convolutional neural networks were superseded for ASR by CTC[90] for LSTM.[72][92][107][108][109] but are more successful in computer vision.

Advances in hardware have driven renewed interest in deep learning. In 2009, Nvidia was involved in what was called the "big bang" of deep learning, "as deep-learning neural networks were trained with Nvidia graphics processing units (GPUs)".[110] That year, Andrew Ng determined that GPUs could increase the speed of deep-learning systems by about 100 times.[111] In particular, GPUs are well-suited for the matrix/vector computations involved in machine learning.[112][113][114] GPUs speed up training algorithms by orders of magnitude, reducing running times from weeks to days.[115][116] Further, specialized hardware and algorithm optimizations can be used for efficient processing of deep learning models.[117]

Deep learning revolution[edit]

In the late 2000s, deep learning started to outperform other methods in machine learning competitions.In 2009, a long short-term memory trained by connectionist temporal classification (Alex Graves, Santiago Fernández, Faustino Gomez, and Jürgen Schmidhuber, 2006)[90] was the first RNN to win pattern recognition contests, winning three competitions in connected handwriting recognition.[118][9] Google later used CTC-trained LSTM for speech recognition on the smartphone.[119][92]

Significant impacts in image or object recognition were felt from 2011 to 2012. Although CNNs trained by backpropagation had been around for decades,[49][51] and GPU implementations of NNs for years,[112] including CNNs,[114][9] faster implementations of CNNs on GPUs were needed to progress on computer vision. In 2011, the DanNet[120][3] by Dan Ciresan, Ueli Meier, Jonathan Masci, Luca Maria Gambardella, and Jürgen Schmidhuber achieved for the first time superhuman performance in a visual pattern recognition contest, outperforming traditional methods by a factor of 3.[9] Also in 2011, DanNet won the ICDAR Chinese handwriting contest, and in May 2012, it won the ISBI image segmentation contest.[121] Until 2011, CNNs did not play a major role at computer vision conferences, but in June 2012, a paper by Ciresan et al. at the leading conference CVPR[3] showed how max-pooling CNNs on GPU can dramatically improve many vision benchmark records. In September 2012, DanNet also won the ICPR contest on analysis of large medical images for cancer detection, and in the following year also the MICCAI Grand Challenge on the same topic.[122] In October 2012, the similar AlexNet by Alex Krizhevsky, Ilya Sutskever, and Geoffrey Hinton[4] won the large-scale ImageNet competition by a significant margin over shallow machine learning methods. The VGG-16 network by Karen Simonyan and Andrew Zisserman[123] further reduced the error rate andwon the ImageNet 2014 competition, following a similar trend in large-scale speech recognition.

Image classification was then extended to the more challenging task of generating descriptions (captions) for images, often as a combination of CNNs and LSTMs.[124][125][126]

In 2012, a team led by George E. Dahl won the "Merck Molecular Activity Challenge" using multi-task deep neural networks to predict the biomolecular target of one drug.[127][128] In 2014, Sepp Hochreiter's group used deep learning to detect off-target and toxic effects of environmental chemicals in nutrients, household products and drugs and won the "Tox21 Data Challenge" of NIH, FDA and NCATS.[129][130][131]

In 2016, Roger Parloff mentioned a "deep learning revolution" that has transformed the AI industry.[132]

In March 2019, Yoshua Bengio, Geoffrey Hinton and Yann LeCun were awarded the Turing Award for conceptual and engineering breakthroughs that have made deep neural networks a critical component of computing.

Neural networks[edit]

In reality, textures and outlines would not be represented by single nodes, but rather by associated weight patterns of multiple nodes.

Artificial neural networks (ANNs) or connectionist systems are computing systems inspired by the biological neural networks that constitute animal brains. Such systems learn (progressively improve their ability) to do tasks by considering examples, generally without task-specific programming. For example, in image recognition, they might learn to identify images that contain cats by analyzing example images that have been manually labeled as "cat" or "no cat" and using the analytic results to identify cats in other images. They have found most use in applications difficult to express with a traditional computer algorithm using rule-based programming.

An ANN is based on a collection of connected units called artificial neurons, (analogous to biological neurons in a biological brain). Each connection (synapse) between neurons can transmit a signal to another neuron. The receiving (postsynaptic) neuron can process the signal(s) and then signal downstream neurons connected to it. Neurons may have state, generally represented by real numbers, typically between 0 and 1. Neurons and synapses may also have a weight that varies as learning proceeds, which can increase or decrease the strength of the signal that it sends downstream.

Typically, neurons are organized in layers. Different layers may perform different kinds of transformations on their inputs. Signals travel from the first (input), to the last (output) layer, possibly after traversing the layers multiple times.

The original goal of the neural network approach was to solve problems in the same way that a human brain would. Over time, attention focused on matching specific mental abilities, leading to deviations from biology such as backpropagation, or passing information in the reverse direction and adjusting the network to reflect that information.

Neural networks have been used on a variety of tasks, including computer vision, speech recognition, machine translation, social network filtering, playing board and video games and medical diagnosis.

As of 2017, neural networks typically have a few thousand to a few million units and millions of connections. Despite this number being several order of magnitude less than the number of neurons on a human brain, these networks can perform many tasks at a level beyond that of humans (e.g., recognizing faces, or playing "Go"[134]).

Deep neural networks[edit]

A deep neural network (DNN) is an artificial neural network with multiple layers between the input and output layers.[7][9] There are different types of neural networks but they always consist of the same components: neurons, synapses, weights, biases, and functions.[135] These components as a whole function in a way that mimics functions of the human brain, and can be trained like any other ML algorithm.[citation needed]

For example, a DNN that is trained to recognize dog breeds will go over the given image and calculate the probability that the dog in the image is a certain breed. The user can review the results and select which probabilities the network should display (above a certain threshold, etc.) and return the proposed label. Each mathematical manipulation as such is considered a layer,[citation needed] and complex DNN have many layers, hence the name "deep" networks.

DNNs can model complex non-linear relationships. DNN architectures generate compositional models where the object is expressed as a layered composition of primitives.[136] The extra layers enable composition of features from lower layers, potentially modeling complex data with fewer units than a similarly performing shallow network.[7] For instance, it was proved that sparse multivariate polynomials are exponentially easier to approximate with DNNs than with shallow networks.[137]

Deep architectures include many variants of a few basic approaches. Each architecture has found success in specific domains. It is not always possible to compare the performance of multiple architectures, unless they have been evaluated on the same data sets.

DNNs are typically feedforward networks in which data flows from the input layer to the output layer without looping back. At first, the DNN creates a map of virtual neurons and assigns random numerical values, or "weights", to connections between them. The weights and inputs are multiplied and return an output between 0 and 1. If the network did not accurately recognize a particular pattern, an algorithm would adjust the weights.[138] That way the algorithm can make certain parameters more influential, until it determines the correct mathematical manipulation to fully process the data.

Recurrent neural networks, in which data can flow in any direction, are used for applications such as language modeling.[139][140][141][142][143] Long short-term memory is particularly effective for this use.[72][144]

Convolutional neural networks (CNNs) are used in computer vision.[145] CNNs also have been applied to acoustic modeling for automatic speech recognition (ASR).[146]

Challenges[edit]

As with ANNs, many issues can arise with naively trained DNNs. Two common issues are overfitting and computation time.

DNNs are prone to overfitting because of the added layers of abstraction, which allow them to model rare dependencies in the training data. Regularization methods such as Ivakhnenko's unit pruning[33] or weight decay (-regularization) or sparsity (-regularization) can be applied during training to combat overfitting.[147] Alternatively dropout regularization randomly omits units from the hidden layers during training. This helps to exclude rare dependencies.[148] Finally, data can be augmented via methods such as cropping and rotating such that smaller training sets can be increased in size to reduce the chances of overfitting.[149]

DNNs must consider many training parameters, such as the size (number of layers and number of units per layer), the learning rate, and initial weights. Sweeping through the parameter space for optimal parameters may not be feasible due to the cost in time and computational resources. Various tricks, such as batching (computing the gradient on several training examples at once rather than individual examples)[150] speed up computation. Large processing capabilities of many-core architectures (such as GPUs or the Intel Xeon Phi) have produced significant speedups in training, because of the suitability of such processing architectures for the matrix and vector computations.[151][152]

Alternatively, engineers may look for other types of neural networks with more straightforward and convergent training algorithms. CMAC (cerebellar model articulation controller) is one such kind of neural network. It doesn't require learning rates or randomized initial weights. The training process can be guaranteed to converge in one step with a new batch of data, and the computational complexity of the training algorithm is linear with respect to the number of neurons involved.[153][154]

Hardware[edit]

Since the 2010s, advances in both machine learning algorithms and computer hardware have led to more efficient methods for training deep neural networks that contain many layers of non-linear hidden units and a very large output layer.[155] By 2019, graphic processing units (GPUs), often with AI-specific enhancements, had displaced CPUs as the dominant method of training large-scale commercial cloud AI.[156] OpenAI estimated the hardware computation used in the largest deep learning projects from AlexNet (2012) to AlphaZero (2017), and found a 300,000-fold increase in the amount of computation required, with a doubling-time trendline of 3.4 months.[157][158]

Special electronic circuits called deep learning processors were designed to speed up deep learning algorithms. Deep learning processors include neural processing units (NPUs) in Huawei cellphones[159] and cloud computing servers such as tensor processing units (TPU) in the Google Cloud Platform.[160] Cerebras Systems has also built a dedicated system to handle large deep learning models, the CS-2, based on the largest processor in the industry, the second-generation Wafer Scale Engine (WSE-2).[161][162]

Atomically thin semiconductors are considered promising for energy-efficient deep learning hardware where the same basic device structure is used for both logic operations and data storage.In 2020, Marega et al. published experiments with a large-area active channel material for developing logic-in-memory devices and circuits based on floating-gate field-effect transistors (FGFETs).[163]

In 2021, J. Feldmann et al. proposed an integrated photonic hardware accelerator for parallel convolutional processing.[164] The authors identify two key advantages of integrated photonics over its electronic counterparts: (1) massively parallel data transfer through wavelength division multiplexing in conjunction with frequency combs, and (2) extremely high data modulation speeds.[164] Their system can execute trillions of multiply-accumulate operations per second, indicating the potential of integrated photonics in data-heavy AI applications.[164]

Applications[edit]

Automatic speech recognition[edit]

Large-scale automatic speech recognition is the first and most convincing successful case of deep learning. LSTM RNNs can learn "Very Deep Learning" tasks[9] that involve multi-second intervals containing speech events separated by thousands of discrete time steps, where one time step corresponds to about 10 ms. LSTM with forget gates[144] is competitive with traditional speech recognizers on certain tasks.[89]

The initial success in speech recognition was based on small-scale recognition tasks based on TIMIT. The data set contains 630 speakers from eight major dialects of American English, where each speaker reads 10 sentences.[165] Its small size lets many configurations be tried. More importantly, the TIMIT task concerns phone-sequence recognition, which, unlike word-sequence recognition, allows weak phone bigram language models. This lets the strength of the acoustic modeling aspects of speech recognition be more easily analyzed. The error rates listed below, including these early results and measured as percent phone error rates (PER), have been summarized since 1991.

| Method | Percent phone error rate (PER) (%) |

|---|---|

| Randomly Initialized RNN[166] | 26.1 |

| Bayesian Triphone GMM-HMM | 25.6 |

| Hidden Trajectory (Generative) Model | 24.8 |

| Monophone Randomly Initialized DNN | 23.4 |

| Monophone DBN-DNN | 22.4 |

| Triphone GMM-HMM with BMMI Training | 21.7 |

| Monophone DBN-DNN on fbank | 20.7 |

| Convolutional DNN[167] | 20.0 |

| Convolutional DNN w. Heterogeneous Pooling | 18.7 |

| Ensemble DNN/CNN/RNN[168] | 18.3 |

| Bidirectional LSTM | 17.8 |

| Hierarchical Convolutional Deep Maxout Network[169] | 16.5 |

The debut of DNNs for speaker recognition in the late 1990s and speech recognition around 2009-2011 and of LSTM around 2003–2007, accelerated progress in eight major areas:[19][102][100]

- Scale-up/out and accelerated DNN training and decoding

- Sequence discriminative training

- Feature processing by deep models with solid understanding of the underlying mechanisms

- Adaptation of DNNs and related deep models

- Multi-task and transfer learning by DNNs and related deep models

- CNNs and how to design them to best exploit domain knowledge of speech

- RNN and its rich LSTM variants

- Other types of deep models including tensor-based models and integrated deep generative/discriminative models.

All major commercial speech recognition systems (e.g., Microsoft Cortana, Xbox, Skype Translator, Amazon Alexa, Google Now, Apple Siri, Baidu and iFlyTek voice search, and a range of Nuance speech products, etc.) are based on deep learning.[19][170][171]

Image recognition[edit]

A common evaluation set for image classification is the MNIST database data set. MNIST is composed of handwritten digits and includes 60,000 training examples and 10,000 test examples. As with TIMIT, its small size lets users test multiple configurations. A comprehensive list of results on this set is available.[172]

Deep learning-based image recognition has become "superhuman", producing more accurate results than human contestants. This first occurred in 2011 in recognition of traffic signs, and in 2014, with recognition of human faces.[173][174]

Deep learning-trained vehicles now interpret 360° camera views.[175] Another example is Facial Dysmorphology Novel Analysis (FDNA) used to analyze cases of human malformation connected to a large database of genetic syndromes.

Visual art processing[edit]

Closely related to the progress that has been made in image recognition is the increasing application of deep learning techniques to various visual art tasks. DNNs have proven themselves capable, for example, of

- identifying the style period of a given painting[176][177]

- Neural Style Transfer – capturing the style of a given artwork and applying it in a visually pleasing manner to an arbitrary photograph or video[176][177]

- generating striking imagery based on random visual input fields.[176][177]

Natural language processing[edit]

Neural networks have been used for implementing language models since the early 2000s.[139] LSTM helped to improve machine translation and language modeling.[140][141][142]

Other key techniques in this field are negative sampling[178] and word embedding. Word embedding, such as word2vec, can be thought of as a representational layer in a deep learning architecture that transforms an atomic word into a positional representation of the word relative to other words in the dataset; the position is represented as a point in a vector space. Using word embedding as an RNN input layer allows the network to parse sentences and phrases using an effective compositional vector grammar. A compositional vector grammar can be thought of as probabilistic context free grammar (PCFG) implemented by an RNN.[179] Recursive auto-encoders built atop word embeddings can assess sentence similarity and detect paraphrasing.[179] Deep neural architectures provide the best results for constituency parsing,[180] sentiment analysis,[181] information retrieval,[182][183] spoken language understanding,[184] machine translation,[140][185] contextual entity linking,[185] writing style recognition,[186] named-entity recognition (token classification),[187] text classification, and others.[188]

Recent developments generalize word embedding to sentence embedding.

Google Translate (GT) uses a large end-to-end long short-term memory (LSTM) network.[189][190][191][192] Google Neural Machine Translation (GNMT) uses an example-based machine translation method in which the system "learns from millions of examples".[190] It translates "whole sentences at a time, rather than pieces". Google Translate supports over one hundred languages.[190] The network encodes the "semantics of the sentence rather than simply memorizing phrase-to-phrase translations".[190][193] GT uses English as an intermediate between most language pairs.[193]

Drug discovery and toxicology[edit]

A large percentage of candidate drugs fail to win regulatory approval. These failures are caused by insufficient efficacy (on-target effect), undesired interactions (off-target effects), or unanticipated toxic effects.[194][195] Research has explored use of deep learning to predict the biomolecular targets,[127][128] off-targets, and toxic effects of environmental chemicals in nutrients, household products and drugs.[129][130][131]

AtomNet is a deep learning system for structure-based rational drug design.[196] AtomNet was used to predict novel candidate biomolecules for disease targets such as the Ebola virus[197] and multiple sclerosis.[198][197]

In 2017 graph neural networks were used for the first time to predict various properties of molecules in a large toxicology data set.[199] In 2019, generative neural networks were used to produce molecules that were validated experimentally all the way into mice.[200][201]

Customer relationship management[edit]

Deep reinforcement learning has been used to approximate the value of possible direct marketing actions, defined in terms of RFM variables. The estimated value function was shown to have a natural interpretation as customer lifetime value.[202]

Recommendation systems[edit]

Recommendation systems have used deep learning to extract meaningful features for a latent factor model for content-based music and journal recommendations.[203][204] Multi-view deep learning has been applied for learning user preferences from multiple domains.[205] The model uses a hybrid collaborative and content-based approach and enhances recommendations in multiple tasks.

Bioinformatics[edit]

An autoencoder ANN was used in bioinformatics, to predict gene ontology annotations and gene-function relationships.[206]

In medical informatics, deep learning was used to predict sleep quality based on data from wearables[207] and predictions of health complications from electronic health record data.[208]

Deep neural networks have shown unparalleled performance in predicting protein structure, according to the sequence of the amino acids that make it up. In 2020, AlphaFold, a deep-learning based system, achieved a level of accuracy significantly higher than all previous computational methods.[209][210]

Deep Neural Network Estimations[edit]

Deep neural networks can be used to estimate the entropy of a stochastic process and called Neural Joint Entropy Estimator (NJEE).[211] Such an estimation provides insights on the effects of input random variables on an independent random variable. Practically, the DNN is trained as a classifier that maps an input vector or matrix X to an output probability distribution over the possible classes of random variable Y, given input X. For example, in image classification tasks, the NJEE maps a vector of pixels' color values to probabilities over possible image classes. In practice, the probability distribution of Y is obtained by a Softmax layer with number of nodes that is equal to the alphabet size of Y. NJEE uses continuously differentiable activation functions, such that the conditions for the universal approximation theorem holds. It is shown that this method provides a strongly consistent estimator and outperforms other methods in case of large alphabet sizes.[211]

Medical image analysis[edit]

Deep learning has been shown to produce competitive results in medical application such as cancer cell classification, lesion detection, organ segmentation and image enhancement.[212][213] Modern deep learning tools demonstrate the high accuracy of detecting various diseases and the helpfulness of their use by specialists to improve the diagnosis efficiency.[214][215]

Mobile advertising[edit]

Finding the appropriate mobile audience for mobile advertising is always challenging, since many data points must be considered and analyzed before a target segment can be created and used in ad serving by any ad server.[216] Deep learning has been used to interpret large, many-dimensioned advertising datasets. Many data points are collected during the request/serve/click internet advertising cycle. This information can form the basis of machine learning to improve ad selection.

Image restoration[edit]

Deep learning has been successfully applied to inverse problems such as denoising, super-resolution, inpainting, and film colorization.[217] These applications include learning methods such as "Shrinkage Fields for Effective Image Restoration"[218] which trains on an image dataset, and Deep Image Prior, which trains on the image that needs restoration.

Financial fraud detection[edit]

Deep learning is being successfully applied to financial fraud detection, tax evasion detection,[219] and anti-money laundering.[220]

Materials science[edit]

In November 2023, researchers at Google DeepMind and Lawrence Berkeley National Laboratory announced that they had developed an AI system known as GNoME. This system has contributed to materials science by discovering over 2 million new materials within a relatively short timeframe. GNoME employs deep learning techniques to efficiently explore potential material structures, achieving a significant increase in the identification of stable inorganic crystal structures. The system's predictions were validated through autonomous robotic experiments, demonstrating a noteworthy success rate of 71%. The data of newly discovered materials is publicly available through the Materials Project database, offering researchers the opportunity to identify materials with desired properties for various applications. This development has implications for the future of scientific discovery and the integration of AI in material science research, potentially expediting material innovation and reducing costs in product development. The use of AI and deep learning suggests the possibility of minimizing or eliminating manual lab experiments and allowing scientists to focus more on the design and analysis of unique compounds.[221][222][223]

Military[edit]

The United States Department of Defense applied deep learning to train robots in new tasks through observation.[224]

Partial differential equations[edit]

Physics informed neural networks have been used to solve partial differential equations in both forward and inverse problems in a data driven manner.[225] One example is the reconstructing fluid flow governed by the Navier-Stokes equations. Using physics informed neural networks does not require the often expensive mesh generation that conventional CFD methods relies on.[226][227]

Image reconstruction[edit]

Image reconstruction is the reconstruction of the underlying images from the image-related measurements. Several works showed the better and superior performance of the deep learning methods compared to analytical methods for various applications, e.g., spectral imaging [228] and ultrasound imaging.[229]

Weather prediction[edit]

Traditional weather prediction systems solve a very complex system of patrial differential equations. GraphCast is a deep learning based model, trained on a long history of weather data to predict how weather patterns change over time. It is able to predict weather conditions for up to 10 days globally, at a very detailed level, and in under a minute, with precision similar to state of the art systems.[230][231]

Epigenetic clock[edit]

An epigenetic clock is a biochemical test that can be used to measure age. Galkin et al. used deep neural networks to train an epigenetic aging clock of unprecedented accuracy using >6,000 blood samples.[232] The clock uses information from 1000 CpG sites and predicts people with certain conditions older than healthy controls: IBD, frontotemporal dementia, ovarian cancer, obesity. The aging clock was planned to be released for public use in 2021 by an Insilico Medicine spinoff company Deep Longevity.

способностями и развитием мозга человека Связь с когнитивными

Глубокое обучение тесно связано с классом теорий развития мозга (в частности, развития неокортекса), предложенных когнитивными нейробиологами в начале 1990-х годов. [233] [234] [235] [236] Эти теории развития были воплощены в вычислительных моделях, что сделало их предшественниками систем глубокого обучения. Эти модели развития обладают тем общим свойством, что различные предполагаемые динамики обучения в мозге (например, волна фактора роста нервов ) поддерживают самоорганизацию, в некоторой степени аналогичную нейронным сетям, используемым в моделях глубокого обучения. Как и неокортекс , нейронные сети используют иерархию многоуровневых фильтров, в которой каждый уровень рассматривает информацию из предыдущего уровня (или операционной среды), а затем передает ее выходные данные (и, возможно, исходные входные данные) на другие уровни. В результате этого процесса получается самоорганизующийся набор датчиков , хорошо настроенный к рабочей среде. В описании 1995 года говорилось: «...мозг младенца, по-видимому, самоорганизуется под влиянием волн так называемых трофических факторов... различные области мозга соединяются последовательно, при этом один слой ткани созревает раньше другого и так до тех пор, пока весь мозг не созреет». [237]

Для исследования правдоподобности моделей глубокого обучения с нейробиологической точки зрения использовались различные подходы. С одной стороны, обратного распространения ошибки с целью повышения реалистичности его обработки. было предложено несколько вариантов алгоритма [238] [239] Другие исследователи утверждают, что неконтролируемые формы глубокого обучения, например, основанные на иерархических генеративных моделях и сетях глубоких убеждений , могут быть ближе к биологической реальности. [240] [241] В этом отношении модели генеративных нейронных сетей связаны с нейробиологическими данными об обработке данных в коре головного мозга на основе выборки. [242]

Хотя систематическое сравнение между организацией человеческого мозга и кодированием нейронов в глубоких сетях еще не проведено, сообщалось о нескольких аналогиях. Например, вычисления, выполняемые модулями глубокого обучения, могут быть аналогичны вычислениям реальных нейронов. [243] и нейронные популяции. [244] Точно так же представления, разработанные моделями глубокого обучения, аналогичны тем, которые измеряются в зрительной системе приматов. [245] оба в одном блоке [246] и у населения [247] уровни.

Коммерческая деятельность [ править ]

Facebook Лаборатория искусственного интеллекта выполняет такие задачи, как автоматическая пометка загруженных изображений именами людей на них. [248]

компании Google Компания DeepMind Technologies разработала систему, способную научиться играть Atari, в видеоигры используя в качестве входных данных только пиксели. В 2015 году они продемонстрировали свою систему AlphaGo , которая достаточно хорошо изучила игру в го, чтобы победить профессионального игрока в го. [249] [250] [251] Google Translate использует нейронную сеть для перевода более чем на 100 языков.

В 2017 году был запущен Covariant.ai, целью которого является интеграция глубокого обучения в фабрики. [252]

По состоянию на 2008 год [253] Исследователи из Техасского университета в Остине (Юта) разработали систему машинного обучения под названием «Обучение агента вручную с помощью оценочного подкрепления» или TAMER, которая предложила новые методы, позволяющие роботам или компьютерным программам научиться выполнять задачи, взаимодействуя с человеком-инструктором. [224] Новый алгоритм под названием Deep TAMER, впервые разработанный как TAMER, был позже представлен в 2018 году в ходе сотрудничества между Исследовательской лабораторией армии США (ARL) и исследователями UT. Deep TAMER использовал глубокое обучение, чтобы предоставить роботу возможность изучать новые задачи посредством наблюдения. [224] Используя Deep TAMER, робот обучался выполнению задачи вместе с тренером-человеком, просматривая видеопотоки или наблюдая, как человек выполняет задачу лично. Позже робот попрактиковался в выполнении задания под руководством тренера, который давал такие отзывы, как «хорошая работа» и «плохая работа». [254]

Критика и комментарии [ править ]

Глубокое обучение вызвало как критику, так и комментарии, в некоторых случаях за пределами области информатики.

Теория [ править ]

Основная критика касается отсутствия теории вокруг некоторых методов. [255] Обучение в наиболее распространенных глубоких архитектурах реализуется с помощью хорошо понятного градиентного спуска. Однако теория других алгоритмов, таких как контрастивная дивергенция, менее ясна. [ нужна ссылка ] (например, сходится ли оно? Если да, то как быстро? Что оно аппроксимирует?) Методы глубокого обучения часто рассматриваются как черный ящик , причем большинство подтверждений делается эмпирически, а не теоретически. [256]

Другие отмечают, что глубокое обучение следует рассматривать как шаг к созданию сильного ИИ , а не как всеобъемлющее решение. Несмотря на мощь методов глубокого обучения, им все еще не хватает функциональности, необходимой для полной реализации этой цели. Психолог-исследователь Гэри Маркус отметил:

На самом деле глубокое обучение — это лишь часть более масштабной задачи создания интеллектуальных машин. В таких методах отсутствуют способы представления причинно-следственных связей (...), нет очевидных способов выполнения логических выводов , а также они еще далеки от интеграции абстрактных знаний, таких как информация о том, что представляют собой объекты, для чего они предназначены и как они обычно используются. Самые мощные системы искусственного интеллекта, такие как Watson (...), используют такие методы, как глубокое обучение, как лишь один элемент в очень сложном ансамбле методов, начиная от статистического метода байесовского вывода и заканчивая дедуктивным рассуждением . [257]

В качестве дальнейшей ссылки на идею о том, что художественная чувствительность может быть присуща относительно низким уровням когнитивной иерархии, опубликована серия графических изображений внутренних состояний глубоких (20-30 слоев) нейронных сетей, пытающихся различить среди по существу случайных данных изображения. на котором они обучались [258] продемонстрировать визуальную привлекательность: оригинальное уведомление об исследовании получило более 1000 комментариев и стало темой статьи, которая какое-то время была наиболее часто доступной статьей в The Guardian . [259] веб-сайт.

Ошибки [ править ]

Некоторые архитектуры глубокого обучения демонстрируют проблемное поведение. [260] например, уверенное отнесение неузнаваемых изображений к знакомой категории обычных изображений (2014) [261] и неправильная классификация мельчайших искажений правильно классифицированных изображений (2013). [262] Герцель предположил, что такое поведение обусловлено ограничениями их внутренних представлений и что эти ограничения будут препятствовать интеграции в гетерогенные многокомпонентные общего искусственного интеллекта (AGI). архитектуры [260] Эти проблемы, возможно, могут быть решены с помощью архитектур глубокого обучения, которые внутри формируют состояния, гомологичные грамматике изображения. [263] декомпозиции наблюдаемых сущностей и событий. [260] Изучение грамматики (визуальной или лингвистической) на основе обучающих данных было бы эквивалентно ограничению системы рассуждениями здравого смысла , которые оперируют понятиями с точки зрения грамматических правил производства и являются основной целью как овладения человеческим языком, так и [264] и искусственный интеллект (ИИ). [265]

Киберугроза [ править ]

По мере того как глубокое обучение выходит из лабораторий в мир, исследования и опыт показывают, что искусственные нейронные сети уязвимы для хакерских атак и обмана. [266] Выявив закономерности, которые эти системы используют для функционирования, злоумышленники могут изменить входные данные ИНС таким образом, что ИНС найдет совпадение, которое люди-наблюдатели не смогут распознать. Например, злоумышленник может внести незначительные изменения в изображение, так что ИНС найдет совпадение, даже если для человека изображение выглядит совсем не так, как цель поиска. Такая манипуляция называется «состязательной атакой». [267]

В 2016 году исследователи использовали одну ИНС для обработки изображений методом проб и ошибок, определения фокусных точек другого и, таким образом, создания изображений, которые обманывали его. Модифицированные изображения ничем не отличались от человеческих глаз. Другая группа показала, что распечатки сфальсифицированных изображений, которые затем были сфотографированы, успешно обманули систему классификации изображений. [268] Одним из способов защиты является обратный поиск изображений, при котором возможное поддельное изображение отправляется на такой сайт, как TinEye , который затем может найти другие его экземпляры. Уточнение состоит в том, чтобы искать, используя только части изображения, чтобы идентифицировать изображения, из которых эта часть могла быть взята . [269]

Другая группа показала, что некоторые психоделические зрелища могут обмануть систему распознавания лиц , заставив ее думать, что обычные люди — знаменитости, потенциально позволяя одному человеку выдавать себя за другого. В 2017 году исследователи добавили наклейки на знаки остановки , из-за чего ANN неправильно их классифицировала. [268]

Однако ИНС можно дополнительно обучить обнаружению попыток обмана , что потенциально может привести злоумышленников и защитников к гонке вооружений, подобной той, которая уже определяет индустрию защиты от вредоносного ПО . ИНС обучены побеждать антивирусное программное обеспечение на основе ИНС, неоднократно атакуя защиту с помощью вредоносного ПО, которое постоянно изменялось генетическим алгоритмом, пока оно не обмануло антивирусное ПО, сохраняя при этом свою способность наносить ущерб цели. [268]

В 2016 году другая группа продемонстрировала, что определенные звуки могут заставить систему голосовых команд Google Now открыть определенный веб-адрес, и предположила, что это может «послужить трамплином для дальнейших атак (например, открытие веб-страницы, на которой размещено вредоносное ПО). ". [268]

При « отравлении данных » ложные данные постоянно вводятся в обучающий набор системы машинного обучения, чтобы помешать ей достичь мастерства. [268]

сбора Этика данных

Этот раздел нуждается в дополнительных цитатах для проверки . ( апрель 2021 г. ) |

Большинство систем глубокого обучения полагаются на данные обучения и проверки, которые генерируются и/или аннотируются людьми. [270] утверждается В философии СМИ , что для этой цели регулярно используется не только низкооплачиваемая работа с кликами (например, на Amazon Mechanical Turk ), но и неявные формы человеческой микроработы , которые часто не признаются как таковые. [271] Философ Райнер Мюльхофф выделяет пять типов «машинного захвата» микроработы человека для генерации обучающих данных: (1) геймификация (встраивание аннотаций или вычислительных задач в ход игры), (2) «перехват и отслеживание» (например, CAPTCHA для распознавания изображений или отслеживания кликов на страницах результатов поиска Google ), (3) использование социальных мотивов (например, пометка лиц на Facebook для получения маркированных изображений лиц), (4) интеллектуальный анализ информации (например, путем использования устройств количественной самооценки , таких как трекеры активности ) и (5) кликворк . [271]

Мюльхофф утверждает, что в большинстве коммерческих приложений глубокого обучения для конечных пользователей, таких как система распознавания лиц Facebook , потребность в обучающих данных не прекращается после обучения ИНС. Скорее, существует постоянный спрос на данные проверки, созданные человеком, для постоянной калибровки и обновления ИНС. С этой целью Facebook представил функцию: как только пользователь автоматически распознается на изображении, он получает уведомление. Они могут выбрать, хотят ли они, чтобы их публично отмечали на изображении, или сказать Facebook, что на изображении не они. [272] Этот пользовательский интерфейс представляет собой механизм генерации «постоянного потока проверочных данных». [271] для дальнейшего обучения сети в режиме реального времени. Как утверждает Мюльхофф, участие пользователей-людей для создания данных обучения и проверки настолько типично для большинства коммерческих приложений глубокого обучения для конечных пользователей, что такие системы можно назвать «искусственным интеллектом, управляемым человеком». [271]

См. также [ править ]

- Приложения искусственного интеллекта

- Сравнение программного обеспечения глубокого обучения

- Сжатое зондирование

- Дифференцируемое программирование

- Государственная сеть Эхо

- Список проектов искусственного интеллекта

- Машина жидкого состояния

- Список наборов данных для исследований в области машинного обучения

- Резервуарные вычисления

- Масштабирование пространства и глубокое обучение

- Разреженное кодирование

- Стохастический попугай

- Топологическое глубокое обучение

Ссылки [ править ]

- ^ Шульц, Ханнес; Бенке, Свен (1 ноября 2012 г.). «Глубокое обучение» . ИИ – искусственный интеллект . 26 (4): 357–363. дои : 10.1007/s13218-012-0198-z . ISSN 1610-1987 . S2CID 220523562 .

- ↑ Перейти обратно: Перейти обратно: а б ЛеКун, Янн; Бенджио, Йошуа; Хинтон, Джеффри (2015). «Глубокое обучение» (PDF) . Природа . 521 (7553): 436–444. Бибкод : 2015Natur.521..436L . дои : 10.1038/nature14539 . ПМИД 26017442 . S2CID 3074096 .

- ↑ Перейти обратно: Перейти обратно: а б с Чиресан, Д.; Мейер, У.; Шмидхубер, Дж. (2012). «Многостолбцовые глубокие нейронные сети для классификации изображений». Конференция IEEE 2012 по компьютерному зрению и распознаванию образов . стр. 3642–3649. arXiv : 1202.2745 . дои : 10.1109/cvpr.2012.6248110 . ISBN 978-1-4673-1228-8 . S2CID 2161592 .

- ↑ Перейти обратно: Перейти обратно: а б Крижевский, Алекс; Суцкевер, Илья; Хинтон, Джеффри (2012). «Классификация ImageNet с глубокими сверточными нейронными сетями» (PDF) . NIPS 2012: Нейронные системы обработки информации, озеро Тахо, Невада . Архивировано (PDF) из оригинала 10 января 2017 г. Проверено 24 мая 2017 г.

- ^ «ИИ AlphaGo от Google выиграл серию из трех матчей у лучшего в мире игрока в го» . ТехКранч . 25 мая 2017 года. Архивировано из оригинала 17 июня 2018 года . Проверено 17 июня 2018 г.

- ^ «Исследование призывает к осторожности при сравнении нейронных сетей с мозгом» . Новости Массачусетского технологического института | Массачусетский технологический институт . 02.11.2022 . Проверено 6 декабря 2023 г.

- ↑ Перейти обратно: Перейти обратно: а б с д Бенджио, Йошуа (2009). «Изучение глубокой архитектуры для искусственного интеллекта» (PDF) . Основы и тенденции в машинном обучении . 2 (1): 1–127. CiteSeerX 10.1.1.701.9550 . дои : 10.1561/2200000006 . S2CID 207178999 . Архивировано из оригинала (PDF) 4 марта 2016 года . Проверено 3 сентября 2015 г.

- ↑ Перейти обратно: Перейти обратно: а б с д и Бенджио, Ю.; Курвиль, А.; Винсент, П. (2013). «Обучение репрезентации: обзор и новые перспективы». Транзакции IEEE по анализу шаблонов и машинному интеллекту . 35 (8): 1798–1828. arXiv : 1206.5538 . дои : 10.1109/tpami.2013.50 . ПМИД 23787338 . S2CID 393948 .

- ↑ Перейти обратно: Перейти обратно: а б с д и ж г час я дж Шмидхубер, Дж. (2015). «Глубокое обучение в нейронных сетях: обзор». Нейронные сети . 61 : 85–117. arXiv : 1404.7828 . дои : 10.1016/j.neunet.2014.09.003 . ПМИД 25462637 . S2CID 11715509 .

- ^ Сигэки, Сугияма (12 апреля 2019 г.). Человеческое поведение и другие виды сознания: новые исследования и возможности: новые исследования и возможности . IGI Global. ISBN 978-1-5225-8218-2 .

- ^ Бенджио, Йошуа; Ламблин, Паскаль; Поповичи, Дэн; Ларошель, Хьюго (2007). Жадное послойное обучение глубоких сетей (PDF) . Достижения в области нейронных систем обработки информации. стр. 153–160. Архивировано (PDF) из оригинала 20 октября 2019 г. Проверено 6 октября 2019 г.

- ↑ Перейти обратно: Перейти обратно: а б Хинтон, GE (2009). «Сети глубоких убеждений» . Схоларпедия . 4 (5): 5947. Бибкод : 2009SchpJ...4.5947H . doi : 10.4249/scholarpedia.5947 .

- ↑ Перейти обратно: Перейти обратно: а б с Цыбенко (1989). «Приближения суперпозициями сигмоидальных функций» (PDF) . Математика управления, сигналов и систем . 2 (4): 303–314. дои : 10.1007/bf02551274 . S2CID 3958369 . Архивировано из оригинала (PDF) 10 октября 2015 года.

- ↑ Перейти обратно: Перейти обратно: а б с Хорник, Курт (1991). «Аппроксимационные возможности многослойных сетей прямого распространения». Нейронные сети . 4 (2): 251–257. дои : 10.1016/0893-6080(91)90009-т . S2CID 7343126 .

- ↑ Перейти обратно: Перейти обратно: а б Хайкин, Саймон С. (1999). Нейронные сети: комплексная основа . Прентис Холл. ISBN 978-0-13-273350-2 .

- ↑ Перейти обратно: Перейти обратно: а б Хассун, Мохамад Х. (1995). Основы искусственных нейронных сетей . МТИ Пресс. п. 48. ИСБН 978-0-262-08239-6 .

- ↑ Перейти обратно: Перейти обратно: а б Лу З., Пу Х., Ван Ф., Ху З. и Ван Л. (2017). Выразительная сила нейронных сетей: взгляд со стороны. Архивировано 13 февраля 2019 г. на Wayback Machine . Нейронные системы обработки информации, 6231-6239.

- ^ Орхан, А.Е.; Ма, WJ (2017). «Эффективный вероятностный вывод в универсальных нейронных сетях, обученных с использованием невероятностной обратной связи» . Природные коммуникации . 8 (1): 138. Бибкод : 2017NatCo...8..138O . дои : 10.1038/s41467-017-00181-8 . ПМК 5527101 . ПМИД 28743932 .

- ↑ Перейти обратно: Перейти обратно: а б с д и Дэн, Л.; Ю, Д. (2014). «Глубокое обучение: методы и приложения» (PDF) . Основы и тенденции в области обработки сигналов . 7 (3–4): 1–199. дои : 10.1561/2000000039 . Архивировано (PDF) из оригинала 14 марта 2016 г. Проверено 18 октября 2014 г.

- ↑ Перейти обратно: Перейти обратно: а б с д Мерфи, Кевин П. (24 августа 2012 г.). Машинное обучение: вероятностный взгляд . МТИ Пресс. ISBN 978-0-262-01802-9 .

- ↑ Перейти обратно: Перейти обратно: а б Фукусима, К. (1969). «Визуальное извлечение признаков с помощью многослойной сети аналоговых пороговых элементов». Транзакции IEEE по системным наукам и кибернетике . 5 (4): 322–333. дои : 10.1109/TSSC.1969.300225 .

- ^ Сонода, Шо; Мурата, Нобору (2017). «Нейронная сеть с неограниченными функциями активации является универсальным аппроксиматором». Прикладной и вычислительный гармонический анализ . 43 (2): 233–268. arXiv : 1505.03654 . дои : 10.1016/j.acha.2015.12.005 . S2CID 12149203 .

- ^ Бишоп, Кристофер М. (2006). Распознавание образов и машинное обучение (PDF) . Спрингер. ISBN 978-0-387-31073-2 . Архивировано (PDF) из оригинала 11 января 2017 г. Проверено 6 августа 2017 г.

- ^ Браш, Стивен Г. (1967). «История модели Ленца-Изинга». Обзоры современной физики . 39 (4): 883–893. Бибкод : 1967РвМП...39..883Б . дои : 10.1103/RevModPhys.39.883 .

- ^ Амари, Сюн-Ичи (1972). «Обучение шаблонам и последовательностям шаблонов с помощью самоорганизующихся сетей пороговых элементов». IEEE-транзакции . С (21): 1197–1206.

- ↑ Перейти обратно: Перейти обратно: а б с д и ж г час я дж к л м н Шмидхубер, Юрген (2022). «Аннотированная история современного искусственного интеллекта и глубокого обучения». arXiv : 2212.11279 [ cs.NE ].

- ^ Хопфилд, Джей-Джей (1982). «Нейронные сети и физические системы с возникающими коллективными вычислительными способностями» . Труды Национальной академии наук . 79 (8): 2554–2558. Бибкод : 1982PNAS...79.2554H . дои : 10.1073/pnas.79.8.2554 . ПМЦ 346238 . ПМИД 6953413 .

- ^ Тапперт, Чарльз К. (2019). «Кто отец глубокого обучения?» . Международная конференция по вычислительной науке и вычислительному интеллекту (CSCI) 2019 . IEEE. стр. 343–348. дои : 10.1109/CSCI49370.2019.00067 . ISBN 978-1-7281-5584-5 . S2CID 216043128 . Проверено 31 мая 2021 г.

- ↑ Перейти обратно: Перейти обратно: а б с Розенблатт, Франк (1962). Принципы нейродинамики . Спартан, Нью-Йорк.

- ↑ Перейти обратно: Перейти обратно: а б Рина Дектер (1986). Обучение во время поиска в задачах ограничения-удовлетворения. Калифорнийский университет, факультет компьютерных наук, лаборатория когнитивных систем. Интернет- архив, заархивированный 19 апреля 2016 г., на Wayback Machine.

- ^ Фрадков, Александр Львович (01.01.2020). «Ранняя история машинного обучения» . IFAC-PapersOnLine . 21-й Всемирный конгресс МФБ. 53 (2): 1385–1390. doi : 10.1016/j.ifacol.2020.12.1888 . ISSN 2405-8963 . S2CID 235081987 .

- ^ Ивахненко А.Г.; Лапа, В.Г. (1967). Кибернетика и методы прогнозирования . американской издательской компании Elsevier ISBN 978-0-444-00020-0 .

- ↑ Перейти обратно: Перейти обратно: а б Ивахненко, Алексей (1971). «Полиномиальная теория сложных систем» (PDF) . Транзакции IEEE по системам, человеку и кибернетике . СМК-1 (4): 364–378. дои : 10.1109/TSMC.1971.4308320 . Архивировано (PDF) из оригинала 29 августа 2017 г. Проверено 5 ноября 2019 г.

- ^ Роббинс, Х .; Монро, С. (1951). «Метод стохастической аппроксимации» . Анналы математической статистики . 22 (3): 400. дои : 10.1214/aoms/1177729586 .

- ^ Амари, Шуничи (1967). «Теория адаптивного классификатора шаблонов». IEEE-транзакции . ЕС (16): 279–307.

- ^ Мэтью Брэнд (1988) Машинное обучение и обучение мозга. Бакалаврская диссертация по методическим исследованиям Чикагского университета, 1988 г. Сообщено в Летнем лингвистическом институте Стэнфордского университета, 1987 г.

- ^ Линнаинмаа, Сеппо (1970). Представление совокупной ошибки округления алгоритма в виде разложения Тейлора локальных ошибок округления (Мастерс) (на финском языке). Университет Хельсинки. стр. 6–7.

- ^ Линнаинмаа, Сеппо (1976). «Разложение Тейлора накопленной ошибки округления». БИТ Численная математика . 16 (2): 146–160. дои : 10.1007/bf01931367 . S2CID 122357351 .

- ^ Гриванк, Андреас (2012). «Кто изобрел обратный способ дифференциации?» (PDF) . Документа Математика . Серия Documenta Mathematica (дополнительный том ISMP): 389–400. дои : 10.4171/dms/6/38 . ISBN 978-3-936609-58-5 . Архивировано из оригинала (PDF) 21 июля 2017 года . Проверено 11 июня 2017 г.

- ^ Лейбниц, Готфрид Вильгельм Фрайгер фон (1920). Ранние математические рукописи Лейбница: перевод с латинских текстов, опубликованных Карлом Иммануэлем Герхардтом с критическими и историческими примечаниями (Лейбниц опубликовал цепное правило в мемуарах 1676 года) . Издательство «Открытый суд». ISBN 9780598818461 .

- ^ Келли, Генри Дж. (1960). «Градиентная теория оптимальных траекторий полета». Журнал АРС . 30 (10): 947–954. дои : 10.2514/8.5282 .

- ^ Вербос, Пол (1982). «Применение достижений нелинейного анализа чувствительности». Системное моделирование и оптимизация . Спрингер. стр. 762–770.

- ^ Вербос, П. (1974). «За пределами регрессии: новые инструменты прогнозирования и анализа в поведенческих науках» . Гарвардский университет . Проверено 12 июня 2017 г.

- ^ Румельхарт, Дэвид Э., Джеффри Э. Хинтон и Р. Дж. Уильямс. « Изучение внутренних представлений путем распространения ошибок. Архивировано 13 октября 2022 г. в Wayback Machine ». Дэвид Э. Румельхарт, Джеймс Л. Макклелланд и исследовательская группа НДП. (редакторы), Параллельная распределенная обработка: Исследования микроструктуры познания, Том 1: Фонд. Массачусетский технологический институт Пресс, 1986.

- ^ Фукусима, К. (1980). «Неокогнитрон: самоорганизующаяся модель нейронной сети для механизма распознавания образов, на который не влияет сдвиг положения». Биол. Киберн . 36 (4): 193–202. дои : 10.1007/bf00344251 . ПМИД 7370364 . S2CID 206775608 .

- ^ Рамачандран, Праджит; Баррет, Зоф; Куок, В. Ле (16 октября 2017 г.). «Поиск функций активации». arXiv : 1710.05941 [ cs.NE ].

- ^ Айзенберг, Индиана; Айзенберг, Н.Н.; Вандевалле, Дж. (2000). Многозначные и универсальные бинарные нейроны . Научные и деловые СМИ. дои : 10.1007/978-1-4757-3115-6 . ISBN 978-0-7923-7824-2 . Проверено 27 декабря 2023 г.

- ^ Коэволюционирующие рекуррентные нейроны изучают POMDP глубокой памяти. Учеб. GECCO, Вашингтон, округ Колумбия, стр. 1795–1802, ACM Press, Нью-Йорк, Нью-Йорк, США, 2005 г.

- ↑ Перейти обратно: Перейти обратно: а б Чжан, Вэй (1988). «Сдвиг-инвариантная нейронная сеть распознавания образов и ее оптическая архитектура» . Материалы ежегодной конференции Японского общества прикладной физики .

- ^ Чжан, Вэй (1990). «Модель параллельной распределенной обработки с локальными пространственно-инвариантными соединениями и ее оптическая архитектура» . Прикладная оптика . 29 (32): 4790–7. Бибкод : 1990ApOpt..29.4790Z . дои : 10.1364/AO.29.004790 . ПМИД 20577468 .

- ↑ Перейти обратно: Перейти обратно: а б ЛеКун и др. , «Обратное распространение ошибки, примененное к распознаванию рукописного почтового индекса», Neural Computation , 1, стр. 541–551, 1989.

- ^ Чжан, Вэй (1991). «Обработка изображений эндотелия роговицы человека на основе обучающей сети» . Прикладная оптика . 30 (29): 4211–7. Бибкод : 1991ApOpt..30.4211Z . дои : 10.1364/AO.30.004211 . ПМИД 20706526 .

- ^ Чжан, Вэй (1994). «Компьютерное обнаружение кластерных микрокальцинатов на цифровых маммограммах с использованием инвариантной к сдвигу искусственной нейронной сети» . Медицинская физика . 21 (4): 517–24. Бибкод : 1994MedPh..21..517Z . дои : 10.1118/1.597177 . ПМИД 8058017 .

- ^ ЛеКун, Янн; Леон Ботту; Йошуа Бенджио; Патрик Хаффнер (1998). «Градиентное обучение, применяемое для распознавания документов» (PDF) . Труды IEEE . 86 (11): 2278–2324. CiteSeerX 10.1.1.32.9552 . дои : 10.1109/5.726791 . S2CID 14542261 . Проверено 7 октября 2016 г.

- ↑ Перейти обратно: Перейти обратно: а б с Шмидхубер, Юрген (1992). «Обучение сложных, расширенных последовательностей с использованием принципа сжатия истории (на основе ТР ФКИ-148, 1991 г.)» (PDF) . Нейронные вычисления . 4 (2): 234–242. дои : 10.1162/neco.1992.4.2.234 . S2CID 18271205 . [ постоянная мертвая ссылка ]

- ^ Шмидхубер, Юрген (1993). Кандидатская диссертация (PDF) (на немецком языке). Архивировано из оригинала (PDF) 26 июня 2021 года.

- ^ Шмидхубер, Юрген (1 ноября 1992 г.). «Научимся контролировать быстрые воспоминания: альтернатива повторяющимся сетям». Нейронные вычисления . 4 (1): 131–139. дои : 10.1162/neco.1992.4.1.131 . S2CID 16683347 .

- ↑ Перейти обратно: Перейти обратно: а б Шлаг, Иманол ; Ириэ, Кадзуки; Шмидхубер, Юрген (2021). «Линейные трансформаторы — тайно быстрые программисты веса». ICML 2021 . Спрингер. стр. 9355–9366.

- ^ Хороманский, Кшиштоф; Лихошерстов Валерий; Дохан, Дэвид; Сун, Синю; Гейн, Андреа; Сарлос, Тамас; Хокинс, Питер; Дэвис, Джаред; Мохиуддин, Афроз; Кайзер, Лукаш; Беланджер, Дэвид; Колвелл, Люси; Веллер, Адриан (2020). «Переосмысление внимания с исполнителями». arXiv : 2009.14794 [ cs.CL ].

- ^ Шмидхубер, Юрген (1993). «Уменьшение соотношения между сложностью обучения и количеством изменяющихся во времени переменных в полностью рекуррентных сетях». ИКАНН, 1993 год . Спрингер. стр. 460–463.

- ^ Васвани, Ашиш; Шазир, Ноам; Пармар, Ники; Ушкорейт, Якоб; Джонс, Лион; Гомес, Эйдан Н.; Кайзер, Лукаш; Полосухин, Илья (12 июня 2017 г.). «Внимание — это все, что вам нужно». arXiv : 1706.03762 [ cs.CL ].

- ^ Вольф, Томас; Дебют, Лисандра; Сан, Виктор; Шомон, Жюльен; Деланг, Клеман; Мой, Энтони; Систак, Пьеррик; Раулт, Тим; Луф, Реми; Фунтович, Морган; Дэвисон, Джо; Шлейфер, Сэм; фон Платен, Патрик; Ма, Клара; Джернит, Ясин; Плю, Жюльен; Сюй, Канвен; Ле Скао, Тевен; Гуггер, Сильвен; Драме, Мариама; Лоест, Квентин; Раш, Александр (2020). «Трансформеры: современная обработка естественного языка». Материалы конференции 2020 года по эмпирическим методам обработки естественного языка: системные демонстрации . стр. 38–45. doi : 10.18653/v1/2020.emnlp-demos.6 . S2CID 208117506 .

- ^ Шмидхубер, Юрген (1991). «Возможность реализовать любопытство и скуку в нейронных контроллерах для построения моделей». Учеб. САБ'1991 . MIT Press/Брэдфорд Букс. стр. 222–227.

- ^ Шмидхубер, Юрген (2010). «Формальная теория творчества, веселья и внутренней мотивации (1990–2010)». Транзакции IEEE по автономному умственному развитию . 2 (3): 230–247. дои : 10.1109/TAMD.2010.2056368 . S2CID 234198 .

- ^ Шмидхубер, Юрген (2020). «Генераторно-состязательные сети являются особыми случаями искусственного любопытства (1990), а также тесно связаны с минимизацией предсказуемости (1991)». Нейронные сети . 127 : 58–66. arXiv : 1906.04493 . doi : 10.1016/j.neunet.2020.04.008 . ПМИД 32334341 . S2CID 216056336 .

- ^ Гудфеллоу, Ян; Пуже-Абади, Жан; Мирза, Мехди; Сюй, Бин; Вард-Фарли, Дэвид; Озаир, Шерджил; Курвиль, Аарон; Бенджио, Йошуа (2014). Генеративно-состязательные сети (PDF) . Материалы Международной конференции по нейронным системам обработки информации (NIPS 2014). стр. 2672–2680. Архивировано (PDF) из оригинала 22 ноября 2019 г. Проверено 20 августа 2019 г.

- ^ «Готовьтесь, не паникуйте: синтетические медиа и дипфейки» . свидетель.орг. Архивировано из оригинала 2 декабря 2020 года . Проверено 25 ноября 2020 г.

- ^ «GAN 2.0: гиперреалистичный генератор лиц NVIDIA» . SyncedReview.com . 14 декабря 2018 года . Проверено 3 октября 2019 г.

- ^ Каррас, Т.; Айла, Т.; Лейн, С.; Лехтинен, Дж. (26 февраля 2018 г.). «Прогрессивное развитие GAN для повышения качества, стабильности и разнообразия». arXiv : 1710.10196 [ cs.NE ].

- ↑ Перейти обратно: Перейти обратно: а б с Хохрайтер С., « Исследования по динамическим нейронным сетям ». Архивировано 6 марта 2015 г. в Wayback Machine . Дипломная работа. Институт компьютерных наук Технического университета Мюнхен. Советник: Дж. Шмидхубер , 1991 г.

- ^ Хохрейтер, С.; и др. (15 января 2001 г.). «Градиентный поток в рекуррентных сетях: сложность изучения долгосрочных зависимостей» . В Колене, Джон Ф.; Кремер, Стефан К. (ред.). Полевое руководство по динамическим рекуррентным сетям . Джон Уайли и сыновья. ISBN 978-0-7803-5369-5 .

- ↑ Перейти обратно: Перейти обратно: а б с Хохрейтер, Зепп; Шмидхубер, Юрген (1 ноября 1997 г.). «Долгая кратковременная память». Нейронные вычисления . 9 (8): 1735–1780. дои : 10.1162/neco.1997.9.8.1735 . ISSN 0899-7667 . ПМИД 9377276 . S2CID 1915014 .

- ^ Герс, Феликс; Шмидхубер, Юрген; Камминс, Фред (1999). «Учимся забывать: постоянное предсказание с помощью LSTM». 9-я Международная конференция по искусственным нейронным сетям: ICANN '99 . Том. 1999. стр. 850–855. дои : 10.1049/cp:19991218 . ISBN 0-85296-721-7 .

- ^ Шривастава, Рупеш Кумар; Грефф, Клаус; Шмидхубер, Юрген (2 мая 2015 г.). «Дорожные сети». arXiv : 1505.00387 [ cs.LG ].

- ^ Шривастава, Рупеш К; Грефф, Клаус; Шмидхубер, Юрген (2015). «Обучение очень глубоких сетей» . Достижения в области нейронных систем обработки информации . 28 . Curran Associates, Inc.: 2377–2385.