Корреляция

В статистике причинно - корреляция или зависимость — это любая статистическая связь, следственная или нет, между двумя случайными величинами или двумерными данными . Хотя в самом широком смысле «корреляция» может указывать на любой тип связи, в статистике она обычно относится к степени линейной связи пары переменных. Знакомые примеры зависимых явлений включают корреляцию между ростом родителей и их потомства, а также корреляцию между ценой товара и количеством, которое потребители готовы купить, как это изображено на так называемой кривой спроса .

Корреляции полезны, поскольку они могут указывать на прогностическую взаимосвязь, которую можно использовать на практике. Например, электроэнергетическая компания может производить меньше электроэнергии в мягкий день в зависимости от корреляции между спросом на электроэнергию и погодой. В этом примере существует причинно-следственная связь , поскольку экстремальные погодные условия заставляют людей использовать больше электроэнергии для отопления или охлаждения. Однако, как правило, наличия корреляции недостаточно для вывода о наличии причинно-следственной связи (т. е. корреляция не подразумевает причинно-следственную связь ).

Формально случайные величины являются зависимыми , если они не удовлетворяют математическому свойству вероятностной независимости . На неформальном языке корреляция является синонимом зависимости . Однако в техническом смысле корреляция относится к любому из нескольких конкретных типов математических отношений между условным ожиданием одной переменной при условии, что другая не является постоянной при изменении обусловливающей переменной ; В широком смысле корреляция в этом конкретном смысле используется, когда связано с каким-то образом (например, линейно, монотонно или, возможно, в соответствии с какой-то конкретной функциональной формой, например логарифмической). По сути, корреляция — это мера того, как две или более переменных связаны друг с другом. Существует несколько коэффициентов корреляции , часто обозначаемых или , измеряя степень корреляции. Наиболее распространенным из них является коэффициент корреляции Пирсона , который чувствителен только к линейной зависимости между двумя переменными (которая может присутствовать, даже если одна переменная является нелинейной функцией другой). Другие коэффициенты корреляции, такие как ранговая корреляция Спирмена , были разработаны как более надежные, чем коэффициент Пирсона, то есть более чувствительные к нелинейным взаимосвязям. [1] [2] [3] Взаимная информация также может применяться для измерения зависимости между двумя переменными.

Коэффициент момента произведения Пирсона

[ редактировать ]

Наиболее известной мерой зависимости между двумя величинами является коэффициент корреляции момента произведения Пирсона (PPMCC), или «коэффициент корреляции Пирсона», обычно называемый просто «коэффициентом корреляции». Он получается путем взятия отношения ковариации двух рассматриваемых переменных нашего набора числовых данных, нормализованного на квадратный корень их дисперсий. просто делят Математически ковариацию двух переменных на произведение их стандартных отклонений . Карл Пирсон разработал коэффициент на основе аналогичной, но несколько иной идеи Фрэнсиса Гальтона . [4]

Коэффициент корреляции момента продукта Пирсона пытается установить линию наилучшего соответствия для набора данных из двух переменных, по сути, распределяя ожидаемые значения, а результирующий коэффициент корреляции Пирсона показывает, насколько далеко фактический набор данных находится от ожидаемых значений. В зависимости от знака нашего коэффициента корреляции Пирсона мы можем получить либо отрицательную, либо положительную корреляцию, если между переменными нашего набора данных существует какая-либо связь. [ нужна ссылка ]

Коэффициент корреляции населения между двумя случайными величинами и с ожидаемыми значениями и и стандартные отклонения и определяется как:

где — оператор ожидаемого значения , означает ковариацию , и — широко используемое альтернативное обозначение коэффициента корреляции. Корреляция Пирсона определяется только в том случае, если оба стандартных отклонения конечны и положительны. Альтернативная формула, выраженная исключительно в моментах :

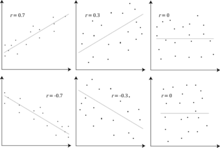

Корреляция и независимость

[ редактировать ]Следствием неравенства Коши – Шварца является то, что абсолютное значение коэффициента корреляции Пирсона не превышает 1. Следовательно, значение коэффициента корреляции колеблется от -1 до +1. Коэффициент корреляции равен +1 в случае идеальной прямой (возрастающей) линейной зависимости (корреляции), −1 в случае идеальной обратной (убывающей) линейной зависимости ( антикорреляции ), [5] и некоторое значение в открытом интервале во всех остальных случаях с указанием степени линейной зависимости между переменными. По мере приближения к нулю взаимосвязь становится меньше (ближе к некоррелированной). Чем ближе коэффициент к –1 или 1, тем сильнее корреляция между переменными.

Если переменные независимы , коэффициент корреляции Пирсона равен 0. Однако, поскольку коэффициент корреляции обнаруживает только линейные зависимости между двумя переменными, обратное не обязательно верно. Коэффициент корреляции, равный 0, не означает, что переменные независимы. [ нужна ссылка ] .

Например, предположим, что случайная величина симметрично распределено около нуля, а . Затем полностью определяется , так что и совершенно зависимы, но их корреляция равна нулю; они некоррелированы . Однако в частном случае, когда и совместно нормальны , некоррелированность эквивалентна независимости.

Несмотря на то, что некоррелированные данные не обязательно подразумевают независимость, можно проверить, являются ли случайные величины независимыми, если их взаимная информация равна 0.

Выборочный коэффициент корреляции

[ редактировать ]Учитывая ряд замеры пары индексируется Коэффициент выборочной корреляции можно использовать для оценки генеральной корреляции Пирсона. между и . Выборочный коэффициент корреляции определяется как

где и образцами средств являются и , и и – это скорректированные выборочные стандартные отклонения и .

Эквивалентные выражения для являются

где и являются неисправленными выборочными стандартными отклонениями и .

Если и являются результатами измерений, которые содержат ошибку измерения, реалистичные пределы коэффициента корреляции составляют не от -1 до +1, а меньший диапазон. [6] Для случая линейной модели с одной независимой переменной коэффициент детерминации (R в квадрате) представляет собой квадрат , Коэффициент момента произведения Пирсона.

Пример

[ редактировать ]Рассмотрим совместное распределение вероятностей X приведенное и Y, в таблице ниже.

- их

−1 0 1 0 0 1 / 3 0 1 1 / 3 0 1 / 3

Для этого совместного распределения предельные распределения таковы:

Это дает следующие ожидания и отклонения:

Поэтому:

Коэффициенты ранговой корреляции

[ редактировать ]Коэффициенты ранговой корреляции , такие как коэффициент ранговой корреляции Спирмена и коэффициент ранговой корреляции Кендалла (τ), измеряют степень, в которой по мере увеличения одной переменной другая переменная имеет тенденцию к увеличению, не требуя, чтобы это увеличение было представлено линейной зависимостью. Если при увеличении одной переменной другая уменьшается , коэффициенты ранговой корреляции будут отрицательными. Эти коэффициенты ранговой корреляции принято рассматривать как альтернативу коэффициенту Пирсона, используемую либо для уменьшения объема вычислений, либо для того, чтобы сделать коэффициент менее чувствительным к ненормальности в распределениях. Однако у этой точки зрения мало математической основы, поскольку коэффициенты ранговой корреляции измеряют другой тип отношений, чем коэффициент корреляции момента произведения Пирсона , и их лучше всего рассматривать как меры другого типа связи, а не как альтернативную меру генеральной совокупности. коэффициент корреляции. [7] [8]

Чтобы проиллюстрировать природу ранговой корреляции и ее отличие от линейной корреляции, рассмотрим следующие четыре пары чисел. :

- (0, 1), (10, 100), (101, 500), (102, 2000).

Когда мы переходим от каждой пары к следующей паре увеличивается, и тоже . Эта связь идеальна в том смысле, что увеличение всегда сопровождается увеличением . Это означает, что у нас идеальная ранговая корреляция, и коэффициенты корреляции Спирмена и Кендалла равны 1, тогда как в этом примере коэффициент корреляции момента произведения Пирсона равен 0,7544, что указывает на то, что точки далеки от прямой линии. Таким же образом, если всегда уменьшается, когда увеличивается , коэффициенты ранговой корреляции будут равны -1, в то время как коэффициент корреляции момента произведения Пирсона может быть близок или не близок к -1, в зависимости от того, насколько близко точки расположены к прямой линии. Хотя в крайних случаях идеальной ранговой корреляции оба коэффициента равны (оба +1 или оба -1), обычно это не так, и поэтому значения двух коэффициентов не могут сравниваться осмысленно. [7] Например, для трёх пар (1, 1) (2, 3) (3, 2) коэффициент Спирмена равен 1/2, а коэффициент Кендалла — 1/3.

Другие меры зависимости между случайными величинами

[ редактировать ]Информации, которую дает коэффициент корреляции, недостаточно для определения структуры зависимости между случайными величинами. [9] Коэффициент корреляции полностью определяет структуру зависимости только в очень частных случаях, например, когда распределение представляет собой многомерное нормальное распределение . (См. диаграмму выше.) В случае эллиптических распределений оно характеризует (гипер-)эллипсы равной плотности; однако оно не полностью характеризует структуру зависимости (например, степени свободы многомерного t-распределения определяют уровень хвостовой зависимости).

Корреляция расстояний [10] [11] был введен для устранения недостатка корреляции Пирсона, заключающегося в том, что она может быть равна нулю для зависимых случайных величин; корреляция с нулевым расстоянием подразумевает независимость.

Коэффициент рандомизированной зависимости [12] является вычислительно эффективной копулах мерой зависимости между многомерными случайными величинами, основанной на . RDC инвариантен по отношению к нелинейному масштабированию случайных величин, способен обнаруживать широкий спектр шаблонов функциональных ассоциаций и принимает нулевое значение при независимости.

Для двух двоичных переменных измеряет отношение шансов их зависимость и принимает неотрицательные числа в диапазоне, возможно, бесконечность: . Связанные статистические данные, такие как Юла Y и Юла, Q нормализуют это до диапазона, подобного корреляции . Отношение шансов обобщается логистической моделью для моделирования случаев, когда зависимые переменные дискретны и может существовать одна или несколько независимых переменных.

Коэффициент корреляции , энтропии на основе взаимная информация , полная корреляция , двойная полная корреляция и полихорическая корреляция также способны обнаруживать более общие зависимости, как и рассмотрение связки между ними, в то время как коэффициент детерминации обобщает коэффициент корреляции для множественной регрессии. .

Чувствительность к распределению данных

[ редактировать ]Степень зависимости между переменными X и Y не зависит от масштаба, в котором выражены переменные. То есть, если мы анализируем взаимосвязь между X и Y , на большинство показателей корреляции не влияет преобразование X в a + bX и Y в c + dY , где a , b , c и d — константы ( b и d являются положительными ). Это справедливо как для некоторых корреляционных статистических данных , так и для их популяционных аналогов. Некоторые статистические данные корреляции, такие как коэффициент ранговой корреляции, также инвариантны к монотонным преобразованиям маргинальных распределений X и/или Y .

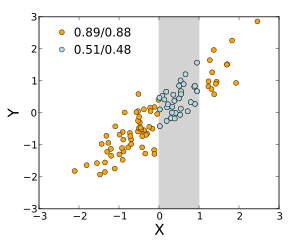

Большинство показателей корреляции чувствительны к способу X и Y. выборки Зависимости имеют тенденцию быть более сильными, если рассматривать их в более широком диапазоне значений. Таким образом, если мы рассмотрим коэффициент корреляции между ростом отцов и их сыновей для всех взрослых мужчин и сравним его с тем же коэффициентом корреляции, рассчитанным, когда отцы выбраны с ростом от 165 см до 170 см, корреляция будет равна в последнем случае слабее. Было разработано несколько методов, пытающихся исправить ограничение диапазона одной или обеих переменных, и они обычно используются в метаанализе; наиболее распространенными являются уравнения Торндайка для случая II и случая III. [13]

Различные используемые меры корреляции могут быть неопределенными для некоторых совместных X и Y. распределений Например, коэффициент корреляции Пирсона определяется в терминах моментов и, следовательно, будет неопределенным, если моменты не определены. меры зависимости, основанные на квантилях Всегда определяются . Статистика на основе выборки, предназначенная для оценки показателей зависимости населения, может иметь или не иметь желаемые статистические свойства, такие как несмещенность или асимптотическая согласованность , в зависимости от пространственной структуры совокупности, из которой были отобраны данные.

Чувствительность к распределению данных может быть использована с выгодой. Например, масштабированная корреляция предназначена для использования чувствительности к диапазону для выявления корреляций между быстрыми компонентами временного ряда . [14] Путем контролируемого сокращения диапазона значений корреляции в долгосрочном масштабе отфильтровываются и выявляются только корреляции в коротких временных масштабах.

Матрицы корреляции

[ редактировать ]Корреляционная матрица случайные величины это матрица чей запись

Таким образом, все диагональные элементы тождественно едины . Если используемыми мерами корреляции являются коэффициенты момента произведения, матрица корреляции такая же, как ковариационная матрица стандартизированных случайных величин. для . Это относится как к матрице корреляций населения (в этом случае — стандартное отклонение генеральной совокупности), а также к матрице выборочных корреляций (в этом случае обозначает выборочное стандартное отклонение). Следовательно, каждая из них обязательно является положительно-полуопределенной матрицей . Более того, корреляционная матрица является строго положительно определенной , если ни одна переменная не может иметь все свои значения, точно сгенерированные как линейная функция значений других.

Корреляционная матрица симметрична, поскольку корреляция между и то же самое, что и корреляция между и .

Корреляционная матрица появляется, например, в одной формуле для коэффициента множественной детерминации , меры согласия в множественной регрессии .

В статистическом моделировании корреляционные матрицы, представляющие взаимосвязи между переменными, подразделяются на различные корреляционные структуры, которые различаются такими факторами, как количество параметров, необходимых для их оценки. Например, в сменной корреляционной матрице все пары переменных моделируются как имеющие одинаковую корреляцию, поэтому все недиагональные элементы матрицы равны друг другу. С другой стороны, авторегрессионная матрица часто используется, когда переменные представляют временной ряд, поскольку корреляции, вероятно, будут выше, когда измерения ближе по времени. Другие примеры включают независимый, неструктурированный, M-зависимый и Теплиц .

При исследовательском анализе данных иконография корреляций состоит в замене корреляционной матрицы диаграммой, где «замечательные» корреляции представлены сплошной линией (положительная корреляция) или пунктирной линией (отрицательная корреляция).

Ближайшая действительная корреляционная матрица

[ редактировать ]В некоторых приложениях (например, при построении моделей данных только на основе частично наблюдаемых данных) требуется найти «ближайшую» корреляционную матрицу к «приблизительной» корреляционной матрице (например, матрице, которой обычно не хватает полуопределенной положительности из-за того, как она имеет было вычислено).

В 2002 году Хайэм [15] формализовал понятие близости с помощью нормы Фробениуса и предоставил метод вычисления ближайшей корреляционной матрицы с использованием алгоритма проекции Дикстры , реализация которого доступна в виде онлайн-веб-API. [16]

Это вызвало интерес к предмету с появлением новой теории (например, вычисление ближайшей корреляционной матрицы с факторной структурой). [17] ) и числовые (например, использование метода Ньютона для вычисления ближайшей корреляционной матрицы [18] ) результаты, полученные в последующие годы.

Некоррелированность и независимость случайных процессов

[ редактировать ]Аналогично для двух случайных процессов и : Если они независимы, то они некоррелированы. [19] : с. 151 Противоположное этому утверждению может быть неверным. Даже если две переменные не коррелируют, они могут не быть независимыми друг от друга.

Распространенные заблуждения

[ редактировать ]Корреляция и причинность

[ редактировать ]Традиционное утверждение о том, что « корреляция не подразумевает причинно-следственную связь », означает, что корреляция сама по себе не может использоваться для вывода о причинно-следственной связи между переменными. [20] Это изречение не следует понимать в том смысле, что корреляции не могут указывать на потенциальное существование причинных связей. Однако причины, лежащие в основе корреляции, если таковые имеются, могут быть косвенными и неизвестными, а высокие корреляции также перекрываются тождественными отношениями ( тавтологиями ), где причинного процесса не существует. Следовательно, корреляция между двумя переменными не является достаточным условием для установления причинно-следственной связи (в любом направлении).

Причинно-следственная связь между возрастом и ростом у детей довольно прозрачна, а вот корреляция между настроением и здоровьем у людей менее очевидна. Приводит ли улучшение настроения к улучшению здоровья, или хорошее здоровье приводит к хорошему настроению, или и то, и другое? Или в основе обоих лежит какой-то другой фактор? Другими словами, корреляция может рассматриваться как свидетельство возможной причинно-следственной связи, но не может указывать на то, какой может быть причинно-следственная связь, если таковая имеется.

Простые линейные корреляции

[ редактировать ]

Коэффициент корреляции Пирсона указывает на силу линейной связи между двумя переменными, но его значение, как правило, не полностью характеризует их взаимосвязь. [21] В частности, если условное среднее данный , обозначенный , не является линейным по , коэффициент корреляции не будет полностью определять вид .

На соседнем изображении показаны диаграммы рассеяния квартета Анскомба — набора из четырех различных пар переменных, созданных Фрэнсисом Анскомбом . [22] Четверо переменные имеют одинаковое среднее значение (7,5), дисперсию (4,12), корреляцию (0,816) и линию регрессии ( ). Однако, как видно на графиках, распределение переменных сильно различается. Первый из них (вверху слева), по-видимому, распределяется нормально и соответствует тому, что можно было бы ожидать, рассматривая две коррелированные переменные и следуя предположению о нормальности. Второй (справа вверху) не распространяется нормально; хотя можно наблюдать очевидную связь между двумя переменными, она не является линейной. В этом случае коэффициент корреляции Пирсона не указывает на наличие точной функциональной зависимости: только степень, в которой эта связь может быть аппроксимирована линейной зависимостью. В третьем случае (внизу слева) линейная зависимость идеальна, за исключением одного выброса , который оказывает достаточное влияние, чтобы снизить коэффициент корреляции с 1 до 0,816. Наконец, четвертый пример (внизу справа) показывает еще один пример, когда одного выброса достаточно для получения высокого коэффициента корреляции, даже несмотря на то, что связь между двумя переменными не является линейной.

Эти примеры показывают, что коэффициент корреляции как сводная статистика не может заменить визуальный анализ данных. Иногда говорят, что эти примеры демонстрируют, что корреляция Пирсона предполагает, что данные подчиняются нормальному распределению , но это верно лишь частично. [4] Корреляцию Пирсона можно точно рассчитать для любого распределения, имеющего конечную ковариационную матрицу , которая включает в себя большинство распределений, встречающихся на практике. Однако коэффициент корреляции Пирсона (вместе с выборочным средним и дисперсией) является достаточной статистикой только в том случае, если данные получены из многомерного нормального распределения . В результате коэффициент корреляции Пирсона полностью характеризует связь между переменными тогда и только тогда, когда данные взяты из многомерного нормального распределения.

Двумерное нормальное распределение

[ редактировать ]Если пара случайных величин следует двумерному нормальному распределению , условное среднее является линейной функцией , и условное среднее является линейной функцией Коэффициент корреляции между и а также предельные средние и дисперсии и определите эту линейную зависимость:

где и ожидаемые значения и соответственно, и и являются стандартными отклонениями и соответственно.

Эмпирическая корреляция представляет собой оценку коэффициента корреляции Оценка распределения дается

где — гипергеометрическая функция Гаусса .

Эта плотность является одновременно байесовской апостериорной плотностью и точной оптимальной плотностью доверительного распределения . [23] [24]

См. также

[ редактировать ]- Автокорреляция

- Каноническая корреляция

- Коэффициент детерминации

- Коинтеграция

- Коэффициент согласованности корреляции

- Кофенетическая корреляция

- Ослабление корреляции

- Корреляционная функция

- Корреляционный разрыв

- Ковариация

- Ковариация и корреляция

- Взаимная корреляция

- Экологическая корреляция

- Доля дисперсии необъяснима

- Генетическая корреляция

- Лямбда Гудмана и Краскала

- Иконография корреляций

- Иллюзорная корреляция

- Межклассовая корреляция

- Внутриклассовая корреляция

- Лифт (интеллектуальный анализ данных)

- Средняя зависимость

- Проблема с модифицируемой единицей площади

- Множественная корреляция

- Коэффициент точечно-бисерийной корреляции

- Соотношение количества квадрантов

- Ложная корреляция

- Статистическое корреляционное соотношение

- Субнезависимость

Ссылки

[ редактировать ]- ^ Крокстон, Фредерик Эмори; Кауден, Дадли Джонстон; Кляйн, Сидней (1968) Общая прикладная статистика , Питман. ISBN 9780273403159 (стр. 625)

- ^ Дитрих, Корнелиус Франк (1991) Неопределенность, калибровка и вероятность: статистика научных и промышленных измерений, 2-е издание, А. Хиглер. ISBN 9780750300605 (стр. 331)

- ^ Эйткен, Александр Крейг (1957) Статистическая математика, 8-е издание. Оливер и Бойд. ISBN 9780050013007 (стр. 95)

- ^ Jump up to: а б Роджерс, Дж.Л.; Найсвандер, Вашингтон (1988). «Тринадцать способов взглянуть на коэффициент корреляции». Американский статистик . 42 (1): 59–66. дои : 10.1080/00031305.1988.10475524 . JSTOR 2685263 .

- ^ Дауди, С. и Уирден, С. (1983). «Статистика для исследований», Уайли. ISBN 0-471-08602-9, стр. 230.

- ^ Фрэнсис, ДП; Пальто AJ; Гибсон Д. (1999). «Насколько высоким может быть коэффициент корреляции?». Инт Джей Кардиол . 69 (2): 185–199. дои : 10.1016/S0167-5273(99)00028-5 . ПМИД 10549842 .

- ^ Jump up to: а б Юл, Г.Ю. и Кендалл, М.Г. (1950), «Введение в теорию статистики», 14-е издание (5-е впечатление, 1968 г.). Чарльз Гриффин и компания, стр. 258–270.

- ^ Кендалл, М.Г. (1955) «Методы ранговой корреляции», Charles Griffin & Co.

- ^ Махдави Дамгани Б. (2013). «Не вводящая в заблуждение ценность предполагаемой корреляции: введение в модель коинтеляции». Журнал Уилмотт . 2013 (67): 50–61. дои : 10.1002/wilm.10252 .

- ^ Секели, Г. Дж. Риццо; Бакиров, НК (2007). «Измерение и проверка независимости путем корреляции расстояний». Анналы статистики . 35 (6): 2769–2794. arXiv : 0803.4101 . дои : 10.1214/009053607000000505 . S2CID 5661488 .

- ^ Секели, Г.Дж.; Риццо, МЛ (2009). «Ковариация броуновского расстояния» . Анналы прикладной статистики . 3 (4): 1233–1303. arXiv : 1010.0297 . дои : 10.1214/09-AOAS312 . ПМЦ 2889501 . ПМИД 20574547 .

- ^ Лопес-Пас Д., Хенниг П. и Шёлкопф Б. (2013). «Коэффициент рандомизированной зависимости», « Конференция по нейронным системам обработки информации », перепечатка

- ^ Торндайк, Роберт Лэдд (1947). Проблемы и методы исследования (Отчет №3) . Вашингтон, округ Колумбия: Правительство США. распечатать. выключенный.

- ^ Николич, Д; Муресан, РЦ; Фэн, В; Сингер, Вт (2012). «Масштабный корреляционный анализ: лучший способ вычисления кросс-коррелограммы». Европейский журнал неврологии . 35 (5): 1–21. дои : 10.1111/j.1460-9568.2011.07987.x . ПМИД 22324876 . S2CID 4694570 .

- ^ Хайэм, Николас Дж. (2002). «Вычисление ближайшей корреляционной матрицы — задача из финансов». Журнал IMA численного анализа . 22 (3): 329–343. CiteSeerX 10.1.1.661.2180 . дои : 10.1093/иманум/22.3.329 .

- ^ «Оптимизатор портфеля» . портфолиооптимизатор.io . Проверено 30 января 2021 г.

- ^ Борсдорф, Рюдигер; Хайэм, Николас Дж.; Райдан, Маркос (2010). «Вычисление матрицы ближайшей корреляции с факторной структурой» (PDF) . СИАМ Дж. Матричный анал. Приложение . 31 (5): 2603–2622. дои : 10.1137/090776718 .

- ^ Ци, ХОУДУО; Сунь, ДЭФЭН (2006). «Квадратично сходящийся метод Ньютона для вычисления ближайшей корреляционной матрицы». СИАМ Дж. Матричный анал. Приложение . 28 (2): 360–385. дои : 10.1137/050624509 .

- ^ Пак, Кун Иль (2018). Основы теории вероятности и случайных процессов с приложениями к средствам связи . Спрингер. ISBN 978-3-319-68074-3 .

- ^ Олдрич, Джон (1995). «Подлинные и ложные корреляции у Пирсона и Юла» . Статистическая наука . 10 (4): 364–376. дои : 10.1214/ss/1177009870 . JSTOR 2246135 .

- ^ Махдави Дамгани, Бабак (2012). «Вводящая в заблуждение ценность измеренной корреляции». Журнал Уилмотт . 2012 (1): 64–73. дои : 10.1002/wilm.10167 . S2CID 154550363 .

- ^ Анскомб, Фрэнсис Дж. (1973). «Графики в статистическом анализе». Американский статистик . 27 (1): 17–21. дои : 10.2307/2682899 . JSTOR 2682899 .

- ^ Таральдсен, Гуннар (2021). «Доверительная плотность корреляции» . Санкхья А. 85 : 600–616. дои : 10.1007/s13171-021-00267-y . ISSN 0976-8378 . S2CID 244594067 .

- ^ Таральдсен, Гуннар (2020). Уверенность в корреляции . Researchgate.net (препринт). дои : 10.13140/RG.2.2.23673.49769 .

Дальнейшее чтение

[ редактировать ]- Коэн, Дж.; Коэн П.; Уэст, С.Г. и Эйкен, Л.С. (2002). Прикладной множественный регрессионно-корреляционный анализ для поведенческих наук (3-е изд.). Психология Пресс. ISBN 978-0-8058-2223-6 .

- «Корреляция (в статистике)» , Математическая энциклопедия , EMS Press , 2001 [1994]

- Острайхер, Дж. и Д.Р. (26 февраля 2015 г.). «Чума равных»: научный триллер о международных заболеваниях, политике и открытии лекарств . Калифорния: Omega Cat Press. п. 408. ИСБН 978-0963175540 .

Внешние ссылки

[ редактировать ]- Страница MathWorld, посвященная коэффициентам (взаимной) корреляции выборки

- Вычисление значимости между двумя корреляциями для сравнения двух значений корреляции.

- «Пакет инструментов MATLAB для вычисления взвешенных коэффициентов корреляции» . Архивировано из оригинала 24 апреля 2021 года.

- Доказательство того, что выборочная двумерная корреляция имеет пределы плюс или минус 1.

- Интерактивное Flash-моделирование корреляции двух нормально распределенных переменных Юхи Пуранена.

- Корреляционный анализ. Биомедицинская статистика

- R-Психолог Корреляционная визуализация корреляции между двумя числовыми переменными

![{\displaystyle \rho _{X,Y}=\operatorname {corr} (X,Y)={\operatorname {cov} (X,Y) \over \sigma _{X}\sigma _{Y}}= {\operatorname {E} [(X-\mu _{X})(Y-\mu _{Y})] \over \sigma _{X}\sigma _{Y}},\quad {\text{ if}}\ \sigma _{X}\sigma _{Y}>0.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b551ad29592ae746bf05fe397fbdc56201f483a5)

![{\displaystyle {\begin{aligned}r_{xy}&={\frac {\sum x_{i}y_{i}-n{\bar {x}}{\bar {y}}}{ns'_ {x}s'_{y}}}\\[5pt]&={\frac {n\sum x_{i}y_{i}-\sum x_{i}\sum y_{i}}{{\ sqrt {n\sum x_{i}^{2}-(\sum x_{i})^{2}}}~{\sqrt {n\sum y_{i}^{2}-(\sum y_{ i})^{2}}}}}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6da33b8144a5e67959969ef2c4830ece1938bbb2)

![{\displaystyle {\begin{aligned}\rho _{X,Y}&={\frac {1}{\sigma _{X}\sigma _{Y}}}\mathrm {E} [(X-\ mu _{X})(Y-\mu _{Y})]\\[5pt]&={\frac {1}{\sigma _{X}\sigma _{Y}}}\sum _{x ,y}{(x-\mu _{X})(y-\mu _{Y})\mathrm {P} (X=x,Y=y)}\\[5pt]&={\frac { 3{\sqrt {3}}}{2}}\left(\left(1- {\frac {2}{3}}\right)(-1-0){\frac {1}{3}} +\left(0-{\frac {2}{3}}\right)(0-0){\frac {1}{3}}+\left(1-{\frac {2}{3}} \right)(1-0){\frac {1}{3}}\right)=0.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5c3ce03c3f9ad954e17f3a92d5314a9a3f669c29)

![{\displaystyle [0,+\infty]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f32245981f739c86ea8f68ce89b1ad6807428d35)

![{\displaystyle [-1,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/51e3b7f14a6f70e614728c583409a0b9a8b9de01)