Наименьшие квадраты

| Часть серии о |

| Регрессионный анализ |

|---|

| Модели |

| Оценка |

| Фон |

Метод наименьших квадратов — это метод оценки параметров в регрессионном анализе, основанный на минимизации суммы квадратов остатков ( остаток — это разница между наблюдаемым значением и подогнанным значением, предоставленным моделью), полученными в результатах каждого отдельного уравнение.

Наиболее важным применением является подбор данных . Когда задача имеет существенные неопределенности в независимой переменной ( переменной x ), тогда возникают проблемы с простой регрессией и методами наименьших квадратов; методологию, необходимую для подбора моделей ошибок в переменных в таких случаях вместо метода наименьших квадратов можно рассмотреть .

Задачи наименьших квадратов делятся на две категории: линейные или обычные наименьшие квадраты и нелинейные наименьшие квадраты , в зависимости от того, являются ли функции модели линейными по всем неизвестным. Линейная задача наименьших квадратов возникает в статистическом регрессионном анализе ; оно имеет решение в замкнутой форме . Нелинейная задача обычно решается путем итеративного уточнения ; на каждой итерации система аппроксимируется линейной, поэтому расчет ядра в обоих случаях аналогичен.

Полиномиальный метод наименьших квадратов описывает дисперсию предсказания зависимой переменной как функцию независимой переменной и отклонений от подобранной кривой.

Когда наблюдения происходят из экспоненциального семейства с тождеством в качестве естественной достаточной статистики и мягкими условиями (например, для нормального , экспоненциального , пуассоновского и биномиального распределений ), стандартизированные оценки наименьших квадратов и оценки максимального правдоподобия идентичны. [1] Метод наименьших квадратов также можно вывести как метод оценки моментов .

Следующее обсуждение в основном представлено в терминах линейных функций, но использование метода наименьших квадратов допустимо и практично для более общих семейств функций. Кроме того, путем итеративного применения локальной квадратичной аппроксимации к вероятности (с помощью информации Фишера ) можно использовать метод наименьших квадратов для подбора обобщенной линейной модели .

Метод наименьших квадратов был официально открыт и опубликован Адрианом-Мари Лежандром (1805 г.). [2] хотя обычно его также приписывают Карлу Фридриху Гауссу (1809 г.), [3] [4] которые внесли значительные теоретические достижения в этот метод, [4] и, возможно, также использовал его в своих более ранних работах в 1794 и 1795 годах. [5] [4]

История

[ редактировать ]Основание

[ редактировать ]Метод наименьших квадратов вырос из областей астрономии и геодезии , когда ученые и математики стремились найти решения проблем навигации по океанам Земли в эпоху Великих географических открытий . Точное описание поведения небесных тел было ключом к тому, чтобы корабли могли плавать в открытом море, где моряки больше не могли полагаться на наземные наблюдения для навигации.

Этот метод стал кульминацией нескольких достижений, произошедших в течение восемнадцатого века: [6]

- Комбинация различных наблюдений как лучшая оценка истинного значения; ошибки уменьшаются с агрегированием, а не увеличиваются, возможно, впервые это выразил Роджер Коутс в 1722 году.

- Сочетание различных наблюдений, проведенных в одних и тех же условиях, противоречит простому стремлению максимально точно наблюдать и записывать одно наблюдение. Этот подход был известен как метод средних значений. Этот подход особенно использовался Тобиасом Майером при изучении либраций Луны в 1750 году и Пьером-Симоном Лапласом в его работе по объяснению различий в движении Юпитера и Сатурна в 1788 году.

- Сочетание разных наблюдений, сделанных в разных условиях. Этот метод стал известен как метод наименьшего абсолютного отклонения . В частности, его выполнили Роджер Джозеф Боскович в своей работе о форме Земли в 1757 году и Пьер-Симон Лаплас для той же задачи в 1789 и 1799 годах.

- Разработка критерия, который можно оценить, чтобы определить, когда было достигнуто решение с минимальной ошибкой. Лаплас попытался указать математическую форму плотности вероятности ошибок и определить метод оценки, который минимизирует ошибку оценки. Для этой цели Лаплас использовал симметричное двустороннее экспоненциальное распределение, которое мы теперь называем распределением Лапласа , для моделирования распределения ошибок, и использовал сумму абсолютных отклонений в качестве ошибки оценки. Он считал, что это самые простые предположения, которые он мог сделать, и надеялся получить среднее арифметическое как наилучшую оценку. Вместо этого его оценкой была задняя медиана.

Метод

[ редактировать ]

Первое ясное и краткое изложение метода наименьших квадратов было опубликовано Лежандром в 1805 году. [7] Этот метод описывается как алгебраическая процедура подгонки линейных уравнений к данным, и Лежандр демонстрирует новый метод, анализируя те же данные, что и Лаплас, для определения формы Земли. В течение десяти лет после публикации Лежандра метод наименьших квадратов был принят в качестве стандартного инструмента астрономии и геодезии во Франции, Италии и Пруссии, что представляет собой чрезвычайно быстрое признание научной техники. [6]

В 1809 году Карл Фридрих Гаусс опубликовал свой метод расчета орбит небесных тел. В этой работе он утверждал, что владеет методом наименьших квадратов с 1795 года. [8] Это, естественно, привело к спору о приоритете с Лежандром. Однако, надо отдать должное Гауссу, он пошел дальше Лежандра и сумел связать метод наименьших квадратов с принципами вероятности и с нормальным распределением . Ему удалось завершить программу Лапласа по определению математической формы плотности вероятности наблюдений в зависимости от конечного числа неизвестных параметров и определить метод оценки, минимизирующий ошибку оценки. Гаусс показал, что среднее арифметическое действительно является лучшей оценкой параметра местоположения за счет изменения как плотности вероятности, так и метода оценки. Затем он перевернул проблему, задав вопрос, какую форму должна иметь плотность и какой метод оценки следует использовать, чтобы получить среднее арифметическое как оценку параметра местоположения. В этой попытке он изобрел нормальное распределение.

Первая демонстрация силы метода Гаусса произошла, когда он использовался для предсказания будущего местоположения недавно открытого астероида Церера . 1 января 1801 года итальянский астроном Джузеппе Пиацци открыл Цереру и смог отслеживать ее путь в течение 40 дней, прежде чем она потерялась в ярком свете Солнца. На основе этих данных астрономы хотели определить местоположение Цереры после того, как она вышла из-за Солнца, не решая Кеплера сложные нелинейные уравнения движения планет . Единственные предсказания, которые успешно позволили венгерскому астроному Францу Ксаверу фон Заху переместить Цереру, были предсказания, сделанные 24-летним Гауссом с использованием анализа наименьших квадратов.

В 1810 году, прочитав работу Гаусса, Лаплас, доказав центральную предельную теорему , использовал ее для большого выборочного обоснования метода наименьших квадратов и нормального распределения. В 1822 году Гаусс смог заявить, что подход к регрессионному анализу методом наименьших квадратов оптимален в том смысле, что в линейной модели, где ошибки имеют нулевое среднее значение, некоррелированы, нормально распределены и имеют равные дисперсии, лучший линейный метод несмещенная оценка коэффициентов - это оценка методом наименьших квадратов. Расширенная версия этого результата известна как теорема Гаусса–Маркова .

Идея анализа методом наименьших квадратов была также независимо сформулирована американцем Робертом Адрейном в 1808 году. В последующие два столетия исследователи теории ошибок и статистики нашли множество различных способов реализации метода наименьших квадратов. [9]

Постановка задачи

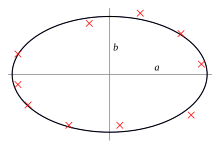

[ редактировать ]Цель состоит в корректировке параметров модельной функции для наилучшего соответствия набору данных. Простой набор данных состоит из n точек (пар данных). , i = 1, …, n , где является независимой переменной и — зависимая переменная , значение которой находится путем наблюдения. Модельная функция имеет вид , где m регулируемых параметров содержатся в векторе . Цель состоит в том, чтобы найти значения параметров модели, которые «наилучшим образом» соответствуют данным. Соответствие модели точке данных измеряется ее остатком , определяемым как разница между наблюдаемым значением зависимой переменной и значением, предсказанным моделью:

Метод наименьших квадратов находит оптимальные значения параметров путем минимизации суммы квадратов остатков , : [10]

В самом простом случае а результатом метода наименьших квадратов является среднее арифметическое входных данных.

Примером модели в двух измерениях является модель прямой линии. Обозначая y-пересечение как и наклон как , модельная функция имеет вид . См. линейный метод наименьших квадратов для получения полностью проработанного примера этой модели.

Точка данных может состоять из более чем одной независимой переменной. Например, при подгонке плоскости к набору измерений высоты плоскость является функцией двух независимых переменных, скажем, x и z . В самом общем случае в каждой точке данных может быть одна или несколько независимых переменных и одна или несколько зависимых переменных.

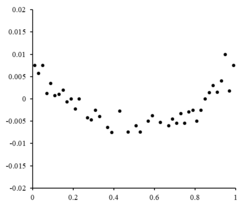

Справа находится остаточный график, иллюстрирующий случайные колебания , что указывает на то, что линейная модель подходит. является независимой случайной величиной. [10]

Если бы остаточные точки имели какую-то форму и не колебались случайным образом, линейная модель не была бы подходящей. Например, если остаточный график имел параболическую форму, как показано справа, параболическая модель будет соответствовать данным. Остатки для параболической модели можно рассчитать через . [10]

Ограничения

[ редактировать ]Эта формулировка регрессии учитывает только ошибки наблюдения в зависимой переменной (но альтернативная регрессия общих наименьших квадратов может учитывать ошибки в обеих переменных). Есть два довольно разных контекста с разными последствиями:

- Регрессия для прогнозирования. Здесь модель подбирается так, чтобы обеспечить правило прогнозирования для применения в аналогичной ситуации, к которой применимы данные, использованные для подгонки. Здесь зависимые переменные, соответствующие такому будущему применению, будут подвержены тем же типам ошибок наблюдения, что и данные, используемые для подбора. Поэтому логически логично использовать для таких данных правило прогнозирования по методу наименьших квадратов.

- Регрессия для установления «истинных отношений». В стандартном регрессионном анализе , который приводит к аппроксимации методом наименьших квадратов, существует неявное предположение, что ошибки в независимой переменной равны нулю или строго контролируются, чтобы ими можно было пренебречь. Когда ошибки в независимой переменной не пренебрежимо малы, модели ошибок измерения можно использовать ; такие методы могут привести к оценкам параметров , проверке гипотез и доверительным интервалам , которые учитывают наличие ошибок наблюдения в независимых переменных. [11] Альтернативный подход – аппроксимация модели методом наименьших квадратов ; это можно рассматривать как прагматичный подход к балансированию эффектов различных источников ошибок при формулировании целевой функции для использования при подборе модели.

Решение задачи наименьших квадратов

[ редактировать ]Минимум равным суммы квадратов находится путем установки градиента нулю . Поскольку модель содержит m параметров, существует m уравнений градиента: и поскольку , уравнения градиента принимают вид

Уравнения градиента применимы ко всем задачам наименьших квадратов. Каждая конкретная проблема требует определенных выражений для модели и ее частных производных . [12]

Линейный метод наименьших квадратов

[ редактировать ]Модель регрессии является линейной, если модель содержит линейную комбинацию параметров, т. е. где функция является функцией . [12]

Сдача в аренду и помещая независимые и зависимые переменные в матрицы и соответственно, мы можем вычислить наименьшие квадраты следующим образом. Обратите внимание, что представляет собой набор всех данных. [12] [13]

Градиент потерь составляет:

Установка градиента потерь равным нулю и решение для , мы получаем: [13] [12]

Нелинейный метод наименьших квадратов

[ редактировать ]В некоторых случаях существует решение в замкнутой форме нелинейной задачи наименьших квадратов, но в целом его нет. В случае отсутствия решения в замкнутой форме для нахождения значений параметров используются численные алгоритмы. это сводит к минимуму цель. Большинство алгоритмов предполагают выбор начальных значений параметров. Далее параметры уточняются итерационно, то есть значения получаются методом последовательного приближения: где верхний индекс k — номер итерации, а вектор приращений называется вектором сдвига. В некоторых широко используемых алгоритмах на каждой итерации модель может быть линеаризована путем приближения к разложению в ряд Тейлора первого порядка примерно :

Якобиан . J является функцией констант, независимой переменной и параметров, поэтому он меняется от одной итерации к другой Остатки определяются как

Чтобы минимизировать сумму квадратов , уравнение градиента устанавливается равным нулю и решается для : которые при перестановке превращаются в m одновременных линейных уравнений, нормальных уравнений :

Нормальные уравнения записываются в матричной записи как

Это определяющие уравнения алгоритма Гаусса–Ньютона .

Различия между линейным и нелинейным методом наименьших квадратов

[ редактировать ]- Модельная функция f в LLSQ (линейный метод наименьших квадратов) представляет собой линейную комбинацию параметров формы Модель может представлять собой прямую линию, параболу или любую другую линейную комбинацию функций. В NLLSQ (нелинейный метод наименьших квадратов) параметры отображаются как функции, например: и так далее. Если производные либо постоянны, либо зависят только от значений независимой переменной, модель линейна по параметрам. В противном случае модель является нелинейной.

- Нужны начальные значения параметров, чтобы найти решение проблемы NLLSQ; LLSQ не требует их.

- Алгоритмы решения NLLSQ часто требуют, чтобы якобиан можно было вычислить аналогично LLSQ. Аналитические выражения для частных производных могут быть сложными. Если аналитические выражения невозможно получить, либо частные производные должны быть рассчитаны путем численной аппроксимации, либо должна быть сделана оценка якобиана, часто с помощью конечных разностей .

- Несходимость (неспособность алгоритма найти минимум) — обычное явление в NLLSQ.

- LLSQ глобально вогнут, поэтому несходимость не является проблемой.

- Решение NLLSQ обычно представляет собой итерационный процесс, который необходимо прекратить, когда выполняется критерий сходимости. Решения LLSQ можно вычислить с помощью прямых методов, хотя задачи с большим количеством параметров обычно решаются итерационными методами, такими как метод Гаусса – Зейделя .

- В LLSQ решение уникально, но в NLLSQ может быть несколько минимумов суммы квадратов.

- При условии, что ошибки не коррелируют с переменными-предикторами, LLSQ дает несмещенные оценки, но даже при этом условии оценки NLLSQ обычно являются смещенными.

Эти различия необходимо учитывать всякий раз, когда ищется решение нелинейной задачи наименьших квадратов. [12]

Пример

[ редактировать ]Рассмотрим простой пример из физики. Пружина должна подчиняться закону Гука , который гласит, что растяжение пружины y пропорционально силе F. приложенной к ней представляет собой модель, где F — независимая переменная. Чтобы оценить силовую константу k n , мы проводим серию из измерений с различными силами для получения набора данных: , где y i — измеренное растяжение пружины. [14] Каждое экспериментальное наблюдение будет содержать некоторую ошибку, , и поэтому мы можем указать эмпирическую модель для наших наблюдений,

Существует множество методов, которые мы могли бы использовать для оценки неизвестного параметра k . Поскольку n уравнений с m переменными в наших данных представляют собой переопределенную систему с одним неизвестным и n уравнениями, мы оцениваем k с помощью метода наименьших квадратов. Сумма квадратов, которые необходимо минимизировать, равна [12]

Оценка силовой постоянной k по методу наименьших квадратов определяется выражением

Мы предполагаем, что приложение силы заставляет пружину расширяться. После получения силовой константы методом наименьших квадратов мы прогнозируем расширение на основе закона Гука.

Количественная оценка неопределенности

[ редактировать ]При расчете методом наименьших квадратов с единичными весами или в линейной регрессии дисперсия j -го параметра, обозначаемая , обычно оценивается с помощью где истинная дисперсия ошибки σ 2 заменяется оценкой, приведенной статистикой хи-квадрат , основанной на минимизированном значении остаточной суммы квадратов (целевая функция), S . Знаменатель n − m представляет собой статистические степени свободы ; см. эффективные степени свободы для обобщений. [12] C — ковариационная матрица .

Статистическое тестирование

[ редактировать ]Если известно распределение вероятностей параметров или сделано асимптотическое приближение, доверительные пределы можно найти . Аналогично, статистические тесты остатков могут проводиться, если распределение вероятностей остатков известно или предполагается. Мы можем получить распределение вероятностей любой линейной комбинации зависимых переменных, если известно или предполагается распределение вероятностей экспериментальных ошибок. Сделать вывод легко, если предположить, что ошибки подчиняются нормальному распределению, что, следовательно, подразумевает, что оценки параметров и остатки также будут нормально распределяться в зависимости от значений независимых переменных. [12]

Для статистической проверки результатов необходимо сделать предположения о характере экспериментальных ошибок. Распространенным предположением является то, что ошибки принадлежат нормальному распределению. Центральная предельная теорема подтверждает идею о том, что во многих случаях это хорошее приближение.

- Теорема Гаусса –Маркова . В линейной модели, в которой ошибки имеют нулевое ожидание, обусловленное независимыми переменными, некоррелированы и имеют равные дисперсии , лучшей линейной несмещенной оценкой любой линейной комбинации наблюдений является ее оценка методом наименьших квадратов. «Лучший» означает, что оценки параметров по методу наименьших квадратов имеют минимальную дисперсию. Предположение о равной дисперсии справедливо, когда все ошибки принадлежат одному и тому же распределению. [15]

- Если ошибки принадлежат нормальному распределению, оценки методом наименьших квадратов также являются оценками максимального правдоподобия в линейной модели.

Однако предположим, что ошибки не распределены нормально. Тем не менее в этом случае центральная предельная теорема часто подразумевает, что оценки параметров будут примерно нормально распределены, пока выборка достаточно велика. По этой причине, учитывая важное свойство, состоящее в том, что среднее значение ошибки не зависит от независимых переменных, распределение члена ошибки не является важной проблемой в регрессионном анализе. В частности, обычно не важно, соответствует ли член ошибки нормальному распределению.

Взвешенные наименьшие квадраты

[ редактировать ]

Особый случай обобщенного метода наименьших квадратов, называемый взвешенным методом наименьших квадратов, возникает, когда все недиагональные элементы Ω (корреляционная матрица остатков) равны нулю; дисперсии гетероскедастичность наблюдений (вдоль диагонали ковариационной матрицы) все еще могут быть неравными ( ) . Проще говоря, гетероскедастичность – это когда дисперсия зависит от стоимости что приводит к тому, что остаточный график создает эффект «разветвления» в сторону более крупных значения, как показано на остаточном графике справа. С другой стороны, гомоскедастичность предполагает, что дисперсия и дисперсия равны. [10]

Связь с основными компонентами

[ редактировать ]Первый главный компонент среднего значения набора точек может быть представлен той линией, которая наиболее близко приближается к точкам данных (измеряемая квадратом расстояния наибольшего сближения, т. е. перпендикулярно линии). Напротив, линейный метод наименьших квадратов пытается минимизировать расстояние в только направление. Таким образом, хотя они используют одинаковую метрику ошибок, линейный метод наименьших квадратов — это метод, который преимущественно обрабатывает одно измерение данных, тогда как PCA одинаково обрабатывает все измерения.

Связь с теорией меры

[ редактировать ]Известный статистик Сара ван де Гир использовала теорию эмпирических процессов и размерность Вапника – Червоненкиса, чтобы доказать, что оценку методом наименьших квадратов можно интерпретировать как меру в пространстве функций, интегрируемых с квадратом . [16]

Регуляризация

[ редактировать ]Tikhonov regularization

[ редактировать ]В некоторых контекстах регуляризованная версия решения методом наименьших квадратов может быть предпочтительнее. Регуляризация Тихонова (или гребневая регрессия ) добавляет ограничение, которое , квадрат -норма вектора параметров не превышает заданного значения в формуле наименьших квадратов, что приводит к задаче ограниченной минимизации. Это эквивалентно задаче неограниченной минимизации, где целевая функция представляет собой остаточную сумму квадратов плюс штрафной член. и — параметр настройки (это лагранжева форма задачи минимизации с ограничениями). [17]

В байесовском контексте это эквивалентно помещению нулевого среднего, нормально распределенного, в вектор вектора параметров.

Метод Лассо

[ редактировать ]Альтернативной регуляризованной версией метода наименьших квадратов является «Лассо» (оператор наименьшего абсолютного сжатия и выбора), который использует ограничение, , L 1 -норма вектора параметров, не превышает заданного значения. [18] [19] [20] (Можно показать, как указано выше, используя множители Лагранжа, что это эквивалентно неограниченной минимизации штрафа по методу наименьших квадратов с добавлено.) В байесовском контексте это эквивалентно помещению Лапласа априорного распределения с нулевым средним в вектор параметров. [21] Задача оптимизации может быть решена с использованием квадратичного программирования или более общих методов выпуклой оптимизации , а также с помощью конкретных алгоритмов, таких как алгоритм регрессии наименьшего угла .

Одно из основных отличий между Лассо и гребневой регрессией заключается в том, что в гребневой регрессии по мере увеличения штрафа все параметры уменьшаются, оставаясь при этом ненулевыми, в то время как в Лассо увеличение штрафа приведет к тому, что все больше и больше параметров будут становиться ненулевыми. доведен до нуля. Это преимущество Лассо перед гребневой регрессией, поскольку приведение параметров к нулю отменяет выбор объектов из регрессии. Таким образом, Лассо автоматически выбирает более релевантные функции и отбрасывает остальные, тогда как регрессия Риджа никогда полностью не отбрасывает какие-либо функции. Некоторые методы выбора признаков разработаны на основе LASSO, включая Bolasso, который загружает выборки, [22] и FeaLect, который анализирует коэффициенты регрессии, соответствующие различным значениям чтобы оценить все характеристики. [23]

Л 1 -регуляризованная формулировка полезна в некоторых контекстах из-за ее тенденции отдавать предпочтение решениям, в которых большее количество параметров равно нулю, что дает решения, зависящие от меньшего количества переменных. [18] По этой причине Лассо и его варианты имеют основополагающее значение для области сжатого зондирования . Расширением этого подхода является эластичная сетчатая регуляризация .

См. также

[ редактировать ]- Корректировка по методу наименьших квадратов

- Байесовский оценщик MMSE

- Лучшая линейная несмещенная оценка (СИНИЙ)

- Лучшее линейное несмещенное предсказание (BLUP)

- Теорема Гаусса–Маркова

- л 2 норма

- Наименьшие абсолютные отклонения

- Спектральный анализ методом наименьших квадратов

- Неопределенность измерения

- Ортогональная проекция

- Проксимальные градиентные методы обучения

- Квадратичная функция потерь

- Среднеквадратичное значение

- Квадратные отклонения от среднего значения

Ссылки

[ редактировать ]- ^ Чарнс, А.; Фром, Эл.; Ю, ПЛ (1976). «Эквивалентность обобщенных наименьших квадратов и оценок максимального правдоподобия в экспоненциальном семействе». Журнал Американской статистической ассоциации . 71 (353): 169–171. дои : 10.1080/01621459.1976.10481508 .

- ^ Мэнсфилд Мерриман, «Список работ, касающихся метода наименьших квадратов»

- ^ Бретшер, Отто (1995). Линейная алгебра с приложениями (3-е изд.). Река Аппер-Седл, Нью-Джерси: Прентис-Холл.

- ^ Jump up to: а б с Стиглер, Стивен М. (1981). «Гаусс и изобретение метода наименьших квадратов» . Энн. Стат . 9 (3): 465–474. дои : 10.1214/aos/1176345451 .

- ^ Плакетт, Р.Л. (1972). «Открытие метода наименьших квадратов» (PDF) . Биометрика . 59 (2): 239–251.

- ^ Jump up to: а б Стиглер, Стивен М. (1986). История статистики: измерение неопределенности до 1900 года . Кембридж, Массачусетс: Belknap Press издательства Гарвардского университета. ISBN 978-0-674-40340-6 .

- ^ Лежандр, Адриен-Мари (1805 г.), орбит комет ( Новые методы определения на французском языке), Париж: Ф. Дидо, hdl : 2027/nyp.33433069112559

- ^ «Открытие статистической регрессии» . Ценаономика . 06.11.2015 . Проверено 4 апреля 2023 г.

- ^ Олдрич, Дж. (1998). «Выполнение метода наименьших квадратов: перспективы Гаусса и Юла». Международный статистический обзор . 66 (1): 61–81. дои : 10.1111/j.1751-5823.1998.tb00406.x . S2CID 121471194 .

- ^ Jump up to: а б с д Современное введение в вероятность и статистику: понимание почему и как . Деккинг, Мишель (1946 г.р.). Лондон: Спрингер. 2005. ISBN 978-1-85233-896-1 . OCLC 262680588 .

{{cite book}}: CS1 maint: другие ( ссылка ) - ^ Хорошее введение в ошибки в переменных см. Фуллер, Вашингтон (1987). Модели ошибок измерения . Джон Уайли и сыновья. ISBN 978-0-471-86187-4 .

- ^ Jump up to: а б с д и ж г час Уильямс, Джеффри Х. (Джеффри Хью), 1956- (ноябрь 2016 г.). Количественное измерение: тирания чисел . Издательство Morgan & Claypool, Институт физики (Великобритания). Сан-Рафаэль [Калифорния] (40 Oak Drive, Сан-Рафаэль, Калифорния, 94903, США). ISBN 978-1-68174-433-9 . OCLC 962422324 .

{{cite book}}: CS1 maint: местоположение ( ссылка ) CS1 maint: отсутствует местоположение издателя ( ссылка ) CS1 maint: несколько имен: список авторов ( ссылка ) CS1 maint: числовые имена: список авторов ( ссылка ) - ^ Jump up to: а б Ренчер, Элвин К.; Кристенсен, Уильям Ф. (15 августа 2012 г.). Методы многомерного анализа . Джон Уайли и сыновья. п. 155. ИСБН 978-1-118-39167-9 .

- ^ Гир, Джеймс М.; Гудно, Барри Дж. (2013). Механика материалов (8-е изд.). Стэмфорд, Коннектикут: Cengage Learning. ISBN 978-1-111-57773-5 . OCLC 741541348 .

- ^ Халлин, Марк (2012). «Теорема Гаусса-Маркова» . Энциклопедия окружающей среды . Уайли. дои : 10.1002/9780470057339.vnn102 . ISBN 978-0-471-89997-6 . Проверено 18 октября 2023 г.

- ^ ван де Гир, Сара (июнь 1987 г.). «Новый подход к оценке методом наименьших квадратов с приложениями» . Анналы статистики . 15 (2): 587–602. дои : 10.1214/aos/1176350362 . S2CID 123088844 .

- ^ ван Виринген, Вессель Н. (2021). «Конспекты лекций по гребневой регрессии». arXiv : 1509.09169 [ stat.ME ].

- ^ Jump up to: а б Тибширани, Р. (1996). «Регрессионное сжатие и отбор с помощью лассо». Журнал Королевского статистического общества, серия B. 58 (1): 267–288. JSTOR 2346178 .

- ^ Хасти, Тревор ; Тибширани, Роберт; Фридман, Джером Х. (2009). Элементы статистического обучения (второе изд.). Спрингер-Верлаг. ISBN 978-0-387-84858-7 . Архивировано из оригинала 10 ноября 2009 г.

- ^ Бюльманн, Питер; ван де Гир, Сара (2011). Статистика для многомерных данных: методы, теория и приложения . Спрингер. ISBN 9783642201929 .

- ^ Парк, Тревор; Казелла, Джордж (2008). «Байесовское лассо». Журнал Американской статистической ассоциации . 103 (482): 681–686. дои : 10.1198/016214508000000337 . S2CID 11797924 .

- ^ Бах, Фрэнсис Р. (2008). «Боласо» . Материалы 25-й международной конференции по машинному обучению ICML '08 . стр. 33–40. arXiv : 0804.1302 . Бибкод : 2008arXiv0804.1302B . дои : 10.1145/1390156.1390161 . ISBN 9781605582054 . S2CID 609778 .

- ^ Заре, Хабиль (2013). «Оценка релевантности признаков на основе комбинаторного анализа Лассо с применением к диагностике лимфомы» . БМК Геномика . 14 (Приложение 1): S14. дои : 10.1186/1471-2164-14-S1-S14 . ПМЦ 3549810 . ПМИД 23369194 .

Дальнейшее чтение

[ редактировать ]- Бьёрк, О. (1996). Численные методы решения задач наименьших квадратов . СИАМ. ISBN 978-0-89871-360-2 .

- Кария, Т.; Курата, Х. (2004). Обобщенный метод наименьших квадратов . Хобокен: Уайли. ISBN 978-0-470-86697-9 .

- Люенбергер, Д.Г. (1997) [1969]. «Оценка методом наименьших квадратов» . Оптимизация методами векторного пространства . Нью-Йорк: Джон Уайли и сыновья. стр. 78–102. ISBN 978-0-471-18117-0 .

- Рао, ЧР ; Тутенбург, Х. ; и др. (2008). Линейные модели: метод наименьших квадратов и альтернативы . Серия Спрингера по статистике (3-е изд.). Берлин: Шпрингер. ISBN 978-3-540-74226-5 .

- Ван де Мортель, Коэн (апрель 2021 г.). «Многонаправленный регрессионный анализ» .

- Вольберг, Дж. (2005). Анализ данных методом наименьших квадратов: извлечение максимальной информации из экспериментов . Берлин: Шпрингер. ISBN 978-3-540-25674-8 .

Внешние ссылки

[ редактировать ] СМИ, связанные с методом наименьших квадратов, на Викискладе?

СМИ, связанные с методом наименьших квадратов, на Викискладе?

![{\displaystyle {\begin{aligned}f(x_{i},{\boldsymbol {\beta }})&=f^{k}(x_{i},{\boldsymbol {\beta }})+\sum _ {j}{\frac {\partial f(x_{i},{\boldsymbol {\beta }})}{\partial \beta _{j}}}\left(\beta _{j}-{\ beta _{j}}^{k}\right)\\[1ex]&=f^{k}(x_{i},{\boldsymbol {\beta }})+\sum _{j}J_{ij }\,\Delta \beta _{j}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2e16d6e5437c4f908d58d29bf0a59a37caed4820)

![{\displaystyle \operatorname {var} ({\hat {\beta }}_{j})=\sigma ^{2}\left(\left[X^{\mathsf {T}}X\right]^{ -1}\right)_{jj}\approx {\hat {\sigma }}^{2}C_{jj},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d85cf89d392a9c191ff1fe3429654bd748a02b2b)