Искусственный интеллект

| Часть серии о |

| Искусственный интеллект |

|---|

Искусственный интеллект ( ИИ ) в самом широком смысле — это интеллект, демонстрируемый машинами , в частности компьютерными системами . Это область исследований в области информатики , которая разрабатывает и изучает методы и программное обеспечение , которые позволяют машинам воспринимать окружающую среду и использовать обучение и интеллект для принятия мер, которые максимизируют их шансы на достижение определенных целей. [1] Такие машины можно назвать ИИ.

Некоторые известные приложения ИИ включают передовые поисковые системы в Интернете (например, Google Search ); системы рекомендаций (используются YouTube , Amazon и Netflix ); взаимодействие посредством человеческой речи (например, Google Assistant , Siri и Alexa ); автономные транспортные средства (например, Waymo ); генеративные и творческие инструменты (например, ChatGPT , Apple Intelligence и AI art ); и сверхчеловеческая игра и анализ в стратегических играх (например, шахматах и го ). [2] Однако многие приложения ИИ не воспринимаются как ИИ: «Множество передовых ИИ просочилось в общие приложения, часто не называемые ИИ, потому что как только что-то становится достаточно полезным и достаточно распространенным, его больше не называют ИИ ». [3] [4]

Алан Тьюринг был первым человеком, проведшим серьезные исследования в области, которую он назвал машинным интеллектом. [5] Искусственный интеллект был основан как академическая дисциплина в 1956 году. [6] те, кого сейчас считают отцами-основателями ИИ: Джон Маккарти , Марвин Минкси , Натаниэль Рочестер и Клод Шеннон . [7] [8] Эта отрасль прошла через несколько циклов оптимизма. [9] [10] за которыми следовали периоды разочарования и потери финансирования, известные как зима AI . [11] [12] Финансирование и интерес значительно возросли после 2012 года, когда глубокое обучение превзошло все предыдущие методы искусственного интеллекта. [13] а после 2017 года с архитектурой-трансформером . [14] Это привело к буму искусственного интеллекта в начале 2020-х годов, когда компании, университеты и лаборатории, преимущественно расположенные в Соединенных Штатах, стали пионерами значительных достижений в области искусственного интеллекта . [15]

Растущее использование искусственного интеллекта в 21 веке влияет на социальный и экономический сдвиг в сторону большей автоматизации , принятия решений на основе данных и интеграции систем искусственного интеллекта в различные экономические сектора и сферы жизни, влияя на рынки труда , здравоохранение , государственное управление. , промышленность , образование , пропаганда и дезинформация . Это поднимает вопросы о долгосрочных последствиях , этических последствиях и рисках ИИ , что побуждает к дискуссиям о регуляторной политике, направленной на обеспечение безопасности и преимуществ технологии .

Различные области исследований ИИ сосредоточены вокруг конкретных целей и использования определенных инструментов. Традиционные цели исследований ИИ включают рассуждение , представление знаний , планирование , обучение , обработку естественного языка , восприятие и поддержку робототехники . [а] Общий интеллект — способность выполнять любую задачу, которую может выполнить человек, как минимум на равном уровне — входит в число долгосрочных целей этой области. [16]

Для достижения этих целей исследователи ИИ адаптировали и интегрировали широкий спектр методов, включая поисковую и математическую оптимизацию , формальную логику , искусственные нейронные сети и методы, основанные на статистике , исследовании операций и экономике . [б] ИИ также опирается на психологию , лингвистику , философию , нейробиологию и другие области. [17]

Цели

Общая проблема моделирования (или создания) интеллекта разбита на подзадачи. Они состоят из определенных черт или способностей, которые исследователи ожидают от интеллектуальной системы. Описанные ниже черты получили наибольшее внимание и охватывают сферу исследований ИИ. [а]

Рассуждение и решение проблем

Ранние исследователи разработали алгоритмы, имитирующие пошаговые рассуждения, которые люди используют, когда решают головоломки или делают логические выводы . [18] К концу 1980-х и 1990-м годам были разработаны методы работы с неопределенной или неполной информацией с использованием концепций теории вероятности и экономики . [19]

Многих из этих алгоритмов недостаточно для решения больших задач рассуждения, поскольку они испытывают «комбинаторный взрыв»: по мере роста задач они становятся экспоненциально медленнее. [20] Даже люди редко используют пошаговые выводы, которые могли смоделировать ранние исследования ИИ. Они решают большинство своих проблем, используя быстрые и интуитивные суждения. [21] Точные и эффективные рассуждения — нерешенная проблема.

Представление знаний

Представление знаний и инженерия знаний [22] позволить программам искусственного интеллекта разумно отвечать на вопросы и делать выводы о реальных фактах. Формальные представления знаний используются при индексировании и поиске на основе контента. [23] интерпретация сцены, [24] поддержка принятия клинических решений, [25] обнаружение знаний (извлечение «интересных» и практических выводов из больших баз данных ), [26] и другие области. [27]

База знаний — это совокупность знаний, представленная в форме, которую может использовать программа. Онтология — это набор объектов, отношений, концепций и свойств, используемых в определенной области знаний. [28] Базы знаний должны представлять такие вещи, как объекты, свойства, категории и отношения между объектами; [29] ситуации, события, состояния и время; [30] причины и следствия; [31] знание о знании (то, что мы знаем о том, что знают другие люди); [32] рассуждения по умолчанию (вещи, которые люди считают истинными, пока им не скажут иначе, и останутся истинными, даже когда другие факты меняются); [33] и многие другие аспекты и области знаний.

Среди наиболее сложных проблем представления знаний — широта знаний здравого смысла (набор элементарных фактов, известных среднестатистическому человеку, огромен); [34] и субсимволическая форма большинства здравомыслящих знаний (многое из того, что знают люди, не представлено в виде «фактов» или «утверждений», которые они могли бы выразить устно). [21] Существует также сложность приобретения знаний , проблема получения знаний для приложений ИИ. [с]

Планирование и принятие решений

«Агент» — это все, что воспринимает и совершает действия в мире. имеет Рациональный агент цели или предпочтения и предпринимает действия для их достижения. [д] [37] При автоматизированном планировании у агента есть конкретная цель. [38] При автоматическом принятии решений у агента есть предпочтения: есть некоторые ситуации, в которых он предпочел бы оказаться, а некоторых ситуаций он пытается избежать. Агент, принимающий решения, присваивает каждой ситуации число (называемое « полезностью »), которое измеряет, насколько агент предпочитает ее. Для каждого возможного действия он может рассчитать « ожидаемую полезность »: полезность всех возможных результатов действия, взвешенную по вероятности того, что результат произойдет. Затем он может выбрать действие с максимальной ожидаемой полезностью. [39]

При классическом планировании агент точно знает, каким будет эффект любого действия. [40] Однако в большинстве задач реального мира агент может не быть уверен в ситуации, в которой он находится (она «неизвестна» или «ненаблюдаема»), и он может не знать наверняка, что произойдет после каждого возможного действия (это не так). «детерминированный»). Он должен выбрать действие, сделав вероятностное предположение, а затем повторно оценить ситуацию, чтобы увидеть, сработало ли действие. [41]

В некоторых задачах предпочтения агента могут быть неопределенными, особенно если в решении участвуют другие агенты или люди. Их можно изучить (например, с помощью обратного обучения с подкреплением ), или агент может искать информацию для улучшения своих предпочтений. [42] Теорию ценности информации можно использовать для взвешивания ценности исследовательских или экспериментальных действий. [43] Пространство возможных будущих действий и ситуаций обычно непреодолимо велико, поэтому агенты должны предпринимать действия и оценивать ситуации, не зная, каким будет результат.

Марковский процесс принятия решений имеет модель перехода , которая описывает вероятность того, что конкретное действие изменит состояние определенным образом, и функцию вознаграждения , которая определяет полезность каждого состояния и стоимость каждого действия. Политика . связывает решение с каждым возможным состоянием Политика может быть рассчитана (например, путем итерации ), быть эвристической или ее можно изучить. [44]

Теория игр описывает рациональное поведение нескольких взаимодействующих агентов и используется в программах ИИ, которые принимают решения с участием других агентов. [45]

Обучение

Машинное обучение — это исследование программ, которые могут автоматически улучшить свою производительность при выполнении определенной задачи. [46] Он был частью ИИ с самого начала. [и]

Существует несколько видов машинного обучения. Обучение без учителя анализирует поток данных, находит закономерности и делает прогнозы без какого-либо другого руководства. [49] Обучение с учителем требует, чтобы человек сначала помечал входные данные, и оно бывает двух основных разновидностей: классификация (когда программа должна научиться предсказывать, к какой категории принадлежат входные данные) и регрессия (когда программа должна вывести числовую функцию на основе числового ввода). ). [50]

При обучении с подкреплением агент вознаграждается за хорошие ответы и наказывается за плохие. Агент учится выбирать ответы, которые классифицируются как «хорошие». [51] Трансферное обучение — это когда знания, полученные при решении одной проблемы, применяются к новой проблеме. [52] Глубокое обучение — это тип машинного обучения, при котором входные данные передаются через биологически созданные искусственные нейронные сети для всех этих типов обучения. [53]

Теория компьютерного обучения может оценивать учащихся по сложности вычислений , по сложности выборки (сколько данных требуется) или по другим понятиям оптимизации . [54]

Обработка естественного языка

Обработка естественного языка (НЛП) [55] позволяет программам читать, писать и общаться на человеческих языках, таких как английский . Конкретные проблемы включают распознавание речи , синтез речи , машинный перевод , извлечение информации , поиск информации и ответы на вопросы . [56]

Ранние работы, основанные на Ноама Хомского , порождающей грамматике и семантических сетях имели трудности с устранением смысловой неоднозначности слов. [ф] если только они не ограничены небольшими областями, называемыми « микромирами » (из-за проблемы знания здравого смысла). [34] ). Маргарет Мастерман считала, что именно смысл, а не грамматика, является ключом к пониманию языков и что тезаурусы основой вычислительной структуры языка должны быть , а не словари.

Современные методы глубокого обучения для НЛП включают встраивание слов (представление слов, обычно в виде векторов, кодирующих их значение), [57] трансформеры (архитектура глубокого обучения с использованием механизма внимания ), [58] и другие. [59] В 2019 году генеративные предварительно обученные языковые модели-трансформеры (или «GPT») начали генерировать связный текст. [60] [61] и к 2023 году эти модели смогут получать оценки человеческого уровня на экзамене на получение адвокатского статуса , SAT тесте , тесте GRE и во многих других реальных приложениях. [62]

Восприятие

Машинное восприятие — это способность использовать данные от датчиков (таких как камеры, микрофоны, беспроводные сигналы, активный лидар , гидролокатор, радар и тактильные датчики ) для определения аспектов мира. Компьютерное зрение — это способность анализировать визуальную информацию. [63]

Область включает в себя распознавание речи , [64] классификация изображений , [65] распознавание лиц , распознавание объектов , [66] отслеживание объектов , [67] и роботизированное восприятие . [68]

Социальный интеллект

Аффективные вычисления — это междисциплинарный зонтик, включающий системы, которые распознают, интерпретируют, обрабатывают или моделируют человеческие чувства, эмоции и настроение . [70] Например, некоторые виртуальные помощники запрограммированы разговаривать разговорно или даже шутливо подшучивать; это делает их более чувствительными к эмоциональной динамике человеческого взаимодействия или иным образом облегчает взаимодействие человека с компьютером .

Однако это дает наивным пользователям нереальное представление об интеллекте существующих компьютерных агентов. [71] Умеренные успехи, связанные с аффективными вычислениями, включают текстовый анализ настроений и, в последнее время, мультимодальный анализ настроений , в котором ИИ классифицирует аффекты, отображаемые субъектом, записанным на видео. [72]

Общий интеллект

Машина с общим искусственным интеллектом должна быть способна решать широкий спектр задач с широтой и универсальностью, аналогичной человеческому интеллекту . [16]

Техники

Исследования ИИ используют широкий спектр методов для достижения вышеуказанных целей. [б]

Поиск и оптимизация

ИИ может решить множество проблем, разумно перебирая множество возможных решений. [73] В ИИ используются два совершенно разных типа поиска: поиск в пространстве состояний и локальный поиск .

Государственный космический поиск

Поиск в пространстве состояний просматривает дерево возможных состояний, чтобы попытаться найти целевое состояние. [74] Например, алгоритмы планирования просматривают деревья целей и подцелей, пытаясь найти путь к целевой цели. Этот процесс называется анализом средств и результатов . [75]

Простой исчерпывающий поиск [76] редко бывают достаточными для большинства реальных задач: пространство поиска (количество мест для поиска) быстро вырастает до астрономических цифр . В результате поиск выполняется слишком медленно или никогда не завершается. [20] « Эвристика » или «эмпирические правила» могут помочь расставить приоритеты в выборе, который с большей вероятностью приведет к достижению цели. [77]

Состязательный поиск используется для игровых программ, таких как шахматы или го. Он просматривает дерево возможных ходов и контрходов в поисках выигрышной позиции. [78]

Локальный поиск

Локальный поиск использует математическую оптимизацию для поиска решения проблемы. Он начинается с некоторой формы предположения и постепенно совершенствует его. [79]

Градиентный спуск — это тип локального поиска, который оптимизирует набор числовых параметров путем постепенной их корректировки для минимизации функции потерь . Варианты градиентного спуска обычно используются для обучения нейронных сетей. [80]

Другой тип локального поиска — эволюционные вычисления , целью которых является итеративное улучшение набора возможных решений путем «мутации» и «рекомбинации» их, отбирая только наиболее приспособленных для выживания в каждом поколении. [81]

Процессы распределенного поиска могут координироваться с помощью алгоритмов роевого интеллекта . Двумя популярными роевыми алгоритмами, используемыми в поиске, являются оптимизация роя частиц (вдохновленная стайкой птиц ) и оптимизация колонии муравьев (вдохновленная муравьиными следами ). [82]

Логика

Формальная логика используется для рассуждений и представления знаний . [83] Формальная логика существует в двух основных формах: логика высказываний (которая оперирует утверждениями, которые являются истинными или ложными, и использует логические связки, такие как «и», «или», «не» и «подразумевается»). [84] и логика предикатов (которая также работает с объектами, предикатами и отношениями и использует кванторы, такие как « Каждый X есть Y » и «Есть некоторые X , которые являются Y »). [85]

Дедуктивное рассуждение в логике — это процесс доказательства нового утверждения ( вывода ) на основе других утверждений, которые даны и считаются истинными ( посылок ). [86] Доказательства могут быть структурированы как деревья доказательств , в которых узлы помечены предложениями, а дочерние узлы соединены с родительскими узлами правилами вывода .

Учитывая проблему и набор предпосылок, решение проблемы сводится к поиску дерева доказательств, корневой узел которого помечен решением проблемы, а листовые узлы помечены посылками или аксиомами . В случае предложений Хорна поиск решения проблемы может осуществляться путем рассуждений вперед от посылок или назад от проблемы. [87] В более общем случае клаузальной формы первого порядка логики разрешение — это единственное, свободное от аксиом правило вывода, в котором проблема решается путем доказательства противоречия из посылок, которые включают отрицание решаемой проблемы. [88]

Вывод как в логике предложения Хорна, так и в логике первого порядка неразрешим и, следовательно, неразрешим . Однако обратные рассуждения с предложениями Хорна, которые лежат в основе вычислений в логического программирования языке Пролог , являются полными по Тьюрингу . Более того, его эффективность не уступает вычислениям на других символьных языках программирования. [89]

Нечеткая логика присваивает «степень истинности» от 0 до 1. Таким образом, она может обрабатывать расплывчатые и частично истинные утверждения. [90]

Немонотонная логика , включая логическое программирование с отрицанием как неудачей , предназначена для обработки рассуждений по умолчанию . [33] Для описания многих сложных областей были разработаны другие специализированные версии логики.

Вероятностные методы для неопределенных рассуждений

Многие проблемы ИИ (в том числе рассуждения, планирование, обучение, восприятие и робототехника) требуют от агента работы с неполной или неопределенной информацией. Исследователи искусственного интеллекта разработали ряд инструментов для решения этих проблем, используя методы теории вероятностей и экономики. [91] Были разработаны точные математические инструменты, которые анализируют, как агент может делать выбор и планировать, используя теорию принятия решений , анализ решений , [92] и теория ценности информации . [93] Эти инструменты включают в себя такие модели, как процессы принятия решений Маркова , [94] динамических сети решений , [95] Теория игр и проектирование механизмов . [96]

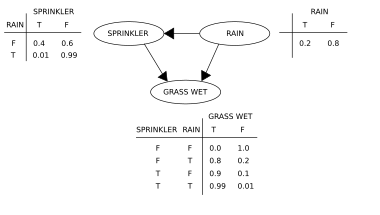

Байесовские сети [97] являются инструментом, который можно использовать для рассуждений (с использованием алгоритма байесовского вывода ), [г] [99] обучение (с использованием алгоритма ожидания-максимизации ), [час] [101] планирование (с использованием сетей принятия решений ) [102] и восприятие (с использованием динамических байесовских сетей ). [95]

Вероятностные алгоритмы также можно использовать для фильтрации, прогнозирования, сглаживания и поиска объяснений потоков данных, тем самым помогая системам восприятия анализировать процессы, происходящие с течением времени (например, скрытые модели Маркова или фильтры Калмана ). [95]

Классификаторы и статистические методы обучения

Простейшие приложения ИИ можно разделить на два типа: классификаторы (например, «если блестит, то ромб»), с одной стороны, и контроллеры (например, «если бриллиант, то поднимите»), с другой стороны. Классификаторы [103] — это функции, которые используют сопоставление с образцом для определения наиболее близкого соответствия. Их можно доработать на основе выбранных примеров с помощью обучения с учителем . Каждый шаблон (также называемый « наблюдением ») помечен определенным предопределенным классом. Все наблюдения в сочетании с их метками классов известны как набор данных . Когда получено новое наблюдение, оно классифицируется на основе предыдущего опыта. [50]

Существует множество видов классификаторов. Дерево решений — это самый простой и наиболее широко используемый алгоритм символьного машинного обучения. [104] Алгоритм K-ближайшего соседа был наиболее широко используемым аналоговым ИИ до середины 1990-х годов, а методы ядра , такие как машина опорных векторов (SVM), вытеснили k-ближайшего соседа в 1990-х годах. [105] Сообщается, что наивный классификатор Байеса является «наиболее широко используемым методом обучения». [106] в Google, отчасти благодаря его масштабируемости. [107] Нейронные сети также используются в качестве классификаторов. [108]

Искусственные нейронные сети

Искусственная нейронная сеть основана на наборе узлов, также известных как искусственные нейроны , которые в общих чертах моделируют нейроны биологического мозга. Он обучен распознавать закономерности; после обучения он сможет распознавать эти закономерности в свежих данных. Есть вход, как минимум один скрытый слой узлов и выход. Каждый узел применяет функцию, и как только вес пересекает указанный порог, данные передаются на следующий уровень. Сеть обычно называется глубокой нейронной сетью, если она имеет как минимум два скрытых слоя. [108]

Алгоритмы обучения нейронных сетей используют локальный поиск для выбора весов, которые дадут правильный результат для каждого входного сигнала во время обучения. Наиболее распространенным методом обучения является алгоритм обратного распространения ошибки . [109] Нейронные сети учатся моделировать сложные взаимосвязи между входными и выходными данными и находить закономерности в данных. Теоретически нейронная сеть может изучить любую функцию. [110]

В нейронных сетях прямого распространения сигнал проходит только в одном направлении. [111] Рекуррентные нейронные сети передают выходной сигнал обратно на вход, что позволяет кратковременно запоминать предыдущие входные события. Долговременная краткосрочная память является наиболее успешной сетевой архитектурой для рекуррентных сетей. [112] Персептроны [113] использовать только один слой нейронов, глубокое обучение [114] использует несколько слоев. Сверточные нейронные сети усиливают связь между нейронами, находящимися «близко» друг к другу — это особенно важно при обработке изображений , где локальный набор нейронов должен идентифицировать «край», прежде чем сеть сможет идентифицировать объект. [115]

Глубокое обучение

Глубокое обучение [114] использует несколько слоев нейронов между входами и выходами сети. Несколько слоев могут постепенно извлекать функции более высокого уровня из необработанных входных данных. Например, при обработке изображений нижние уровни могут идентифицировать края, а более высокие уровни могут идентифицировать понятия, относящиеся к человеку, такие как цифры, буквы или лица. [116]

Глубокое обучение значительно улучшило производительность программ во многих важных областях искусственного интеллекта, включая компьютерное зрение , распознавание речи , обработку естественного языка , классификацию изображений , [117] и другие. Причина, по которой глубокое обучение так хорошо работает во многих приложениях, по состоянию на 2023 год неизвестна. [118] Внезапный успех глубокого обучения в 2012–2015 годах произошел не из-за какого-то нового открытия или теоретического прорыва (глубокие нейронные сети и обратное распространение ошибки были описаны многими людьми еще в 1950-х годах). [я] но из-за двух факторов: невероятного увеличения мощности компьютера (включая стократное увеличение скорости за счет перехода на графические процессоры ) и доступности огромных объемов обучающих данных, особенно гигантских курируемых наборов данных, используемых для эталонного тестирования, таких как ImageNet . [Дж]

GPT

Генеративные предварительно обученные преобразователи (GPT) — это большие языковые модели , основанные на семантических отношениях между словами в предложениях ( обработка естественного языка ). Текстовые модели GPT предварительно обучаются на большом массиве текста , который может быть взят из Интернета. Предварительное обучение состоит в предсказании следующего токена (токеном обычно является слово, подслово или знак препинания). В ходе этого предварительного обучения модели GPT накапливают знания о мире, а затем могут генерировать текст, похожий на человеческий, многократно предсказывая следующий токен. Как правило, последующий этап обучения делает модель более правдивой, полезной и безвредной, обычно с помощью метода, называемого обучением с подкреплением на основе обратной связи с человеком (RLHF). Текущие модели GPT склонны генерировать ложные сведения, называемые « галлюцинациями », хотя это можно уменьшить с помощью RLHF и качественных данных. Они используются в чат-ботах , которые позволяют людям задавать вопросы или запрашивать задачу простым текстом. [126] [127]

Текущие модели и сервисы включают Gemini (ранее Bard), ChatGPT , Grok , Claude , Copilot и LLaMA . [128] Мультимодальные модели GPT могут обрабатывать различные типы данных ( модальности ), такие как изображения, видео, звук и текст. [129]

Специализированное оборудование и программное обеспечение

В конце 2010-х годов графические процессоры (GPU), которые все чаще проектировались с усовершенствованиями, специфичными для искусственного интеллекта, и использовались со специализированным программным обеспечением TensorFlow, заменили ранее использовавшиеся центральные процессоры (ЦП) в качестве доминирующего средства для крупномасштабных (коммерческих и академических) машин. обучения . обучение моделей [130] Специализированные языки программирования , такие как Пролог, использовались в ранних исследованиях ИИ. [131] но языки программирования общего назначения, такие как Python, стали преобладать. [132]

Приложения

Технологии искусственного интеллекта и машинного обучения используются в большинстве важнейших приложений 2020-х годов, включая: поисковые системы (такие как Google Search ), таргетинг онлайн-рекламы , системы рекомендаций (предлагаемые Netflix , YouTube или Amazon ), привлечение интернет-трафика , таргетированную рекламу. ( AdSense , Facebook ), виртуальные помощники (такие как Siri или Alexa ), автономные транспортные средства (включая дроны , ADAS и беспилотные автомобили ), автоматический языковой перевод ( Microsoft Translator , Google Translate ), распознавание лиц ( Apple ID Face или Microsoft от DeepFace и Google от FaceNet ) и маркировка изображений (используется Facebook от Apple , iPhoto и TikTok ). Развертывание ИИ может контролироваться директором по автоматизации (CAO).

Здоровье и медицина

Применение ИИ в медицине и медицинских исследованиях потенциально может улучшить уход за пациентами и качество их жизни. [133] Через призму клятвы Гиппократа медицинские работники этически обязаны использовать ИИ, если приложения могут более точно диагностировать и лечить пациентов.

Для медицинских исследований ИИ является важным инструментом обработки и интеграции больших данных . Это особенно важно для развития органоидной и тканевой инженерии визуализация используется , где микроскопическая в качестве ключевого метода производства. [134] Было высказано предположение, что ИИ может преодолеть несоответствия в финансировании, выделяемом на различные области исследований. [134] Новые инструменты искусственного интеллекта могут углубить понимание биомедицинских путей. Например, AlphaFold 2 (2021) продемонстрировал способность аппроксимировать трехмерную структуру белка за часы, а не за месяцы . [135] В 2023 году сообщалось, что открытие лекарств под руководством ИИ помогло найти класс антибиотиков, способных убивать два разных типа устойчивых к лекарствам бактерий. [136] В 2024 году исследователи использовали машинное обучение, чтобы ускорить поиск от болезни Паркинсона лекарств . Их целью было идентифицировать соединения, которые блокируют слипание или агрегацию альфа-синуклеина (белка, который характеризует болезнь Паркинсона). Им удалось ускорить процесс первичной проверки в десять раз и снизить стоимость в тысячу раз. [137] [138]

Игры

Игровые программы используются с 1950-х годов для демонстрации и тестирования самых передовых методов искусственного интеллекта. [139] Deep Blue стала первой компьютерной игровой системой, победившей действующего чемпиона мира по шахматам Гарри Каспарова 11 мая 1997 года. [140] В 2011 году в опасности! викторина-шоу показательный матч, , IBM вопросно-ответная система Уотсон , победилдва величайших Jeopardy! чемпионы Брэд Раттер и Кен Дженнингс со значительным отрывом. [141] В марте 2016 года AlphaGo выиграла 4 из 5 игр в го в матче с чемпионом по го Ли Седолем , став первой компьютерной системой игры в го, обыгравшей профессионального игрока в го без гандикапов . Затем в 2017 году он победил Кэ Цзе , который был лучшим игроком в го в мире. [142] Другие программы обрабатывают игры с несовершенной информацией , например в покер программа для игры Pluribus . [143] DeepMind разработала все более общие модели обучения с подкреплением , такие как MuZero , которые можно было обучить играть в шахматы, го или Atari . игры [144] В 2019 году AlphaStar из DeepMind достигла уровня гроссмейстера в StarCraft II , особенно сложной стратегической игре в реальном времени, которая предполагает неполное знание того, что происходит на карте. [145] В 2021 году ИИ-агент принял участие в соревновании PlayStation Gran Turismo , победив четырех лучших в мире водителей Gran Turismo, используя глубокое обучение с подкреплением. [146] В 2024 году Google DeepMind представила SIMA, тип искусственного интеллекта, способный автономно играть в девять ранее невиданных видеоигр с открытым миром , наблюдая за выводом на экран, а также выполнять короткие конкретные задачи в ответ на инструкции на естественном языке. [147]

Финансы

Финансы — один из наиболее быстрорастущих секторов, где используются прикладные инструменты искусственного интеллекта: от розничного онлайн-банкинга до инвестиционных консультаций и страхования, где уже несколько лет используются автоматизированные «роботы-консультанты». [148]

Эксперты World Pensions , такие как Николас Фирзли, настаивают, что, возможно, еще слишком рано видеть появление высокоинновационных финансовых продуктов и услуг на основе искусственного интеллекта: «развертывание инструментов искусственного интеллекта просто приведет к дальнейшей автоматизации процессов: уничтожению десятков тысяч рабочих мест в банковском деле, финансовом планировании и пенсионное консультирование в процессе, но я не уверен, что это вызовет новую волну [например, сложных] пенсионных инноваций». [149]

Военный

Различные страны внедряют военные приложения ИИ. [150] Основные приложения расширяют возможности управления и контроля , связи, датчиков, интеграции и совместимости. [151] Исследования направлены на сбор и анализ разведывательной информации, логистику, кибероперации, информационные операции, а также полуавтономные и автономные транспортные средства . [150] Технологии искусственного интеллекта обеспечивают координацию датчиков и исполнительных устройств, обнаружение и идентификацию угроз, маркировку позиций противника, захват целей , координацию и устранение конфликтов в распределенных совместных огнях между объединенными в сеть боевыми машинами с участием пилотируемых и беспилотных групп. [151] ИИ был задействован в военных операциях в Ираке и Сирии. [150]

В ноябре 2023 года вице-президент США Камала Харрис обнародовала подписанную 31 страной декларацию, устанавливающую ограничения на использование искусственного интеллекта в военных целях. Обязательства включают в себя проведение юридических проверок для обеспечения соответствия военного ИИ международному праву, а также осторожность и прозрачность при разработке этой технологии. [152]

Генеративный ИИ

В начале 2020-х годов генеративный искусственный интеллект получил широкое распространение. В марте 2023 года 58% взрослых американцев слышали о ChatGPT и 14% пробовали его. [153] Растущая реалистичность и простота использования генераторов текста в изображения на основе искусственного интеллекта, таких как Midjourney , DALL-E и Stable Diffusion, вызвали тенденцию к вирусным фотографиям, созданным с помощью искусственного интеллекта. Широкое внимание привлекли фейковая фотография Папы Франциска в белом пуховике, вымышленный арест Дональда Трампа и мистификация нападения на Пентагон , а также использование в профессиональном творчестве. [154] [155]

Другие отраслевые задачи

Существуют также тысячи успешных приложений ИИ, используемых для решения конкретных проблем в конкретных отраслях или учреждениях. В опросе 2017 года каждая пятая компания сообщила, что включила искусственный интеллект в некоторые предложения или процессы. [156] Несколько примеров — хранение энергии , медицинская диагностика, военная логистика, приложения, предсказывающие результат судебных решений, внешняя политика или управление цепочками поставок.

Приложения искусственного интеллекта для эвакуации и борьбы со стихийными бедствиями растут. Искусственный интеллект использовался для расследования того, эвакуировались ли люди в крупномасштабных и мелкомасштабных эвакуациях, и если да, то каким образом, с использованием исторических данных GPS, видео или социальных сетей. Кроме того, ИИ может предоставлять информацию в реальном времени об условиях эвакуации в реальном времени. [157] [158] [159]

В сельском хозяйстве ИИ помог фермерам определить области, которые нуждаются в ирригации, удобрении, обработке пестицидами или повышении урожайности. Агрономы используют ИИ для проведения исследований и разработок. ИИ использовался для прогнозирования времени созревания таких культур, как томаты, мониторинга влажности почвы, управления сельскохозяйственными роботами, проведения прогнозной аналитики, классификации эмоций, вызываемых домашним скотом, свиней, автоматизации теплиц, обнаружения болезней и вредителей, а также экономии воды.

Искусственный интеллект используется в астрономии для анализа растущих объемов доступных данных и приложений, в основном для «классификации, регрессии, кластеризации, прогнозирования, генерации, открытия и развития новых научных идей», например, для открытия экзопланет, прогнозирования солнечной активности и различие между сигналами и инструментальными эффектами в гравитационно-волновой астрономии. Его также можно использовать для деятельности в космосе, такой как исследование космоса, включая анализ данных космических миссий, научные решения космических кораблей в реальном времени, предотвращение космического мусора и более автономную работу.

Этика

ИИ имеет потенциальные преимущества и потенциальные риски. ИИ может способствовать развитию науки и находить решения серьезных проблем: Демис Хассабис из Deep Mind надеется «разгадать интеллект, а затем использовать его для решения всего остального». [160] Однако по мере того, как использование ИИ стало широко распространенным, было выявлено несколько непредвиденных последствий и рисков. [161] Производственные системы иногда не могут учитывать этику и предвзятость в процессах обучения ИИ, особенно когда алгоритмы ИИ по своей сути необъяснимы при глубоком обучении. [162]

Риски и вред

Конфиденциальность и авторские права

Алгоритмы машинного обучения требуют больших объемов данных. Методы, используемые для получения этих данных, вызвали обеспокоенность по поводу конфиденциальности , слежки и авторских прав .

Технологические компании собирают широкий спектр данных от своих пользователей, включая онлайн-активность, данные геолокации, видео и аудио. [163] Например, чтобы создать распознавания речи алгоритмы , Amazon записал миллионы частных разговоров и позволил временным работникам прослушивать и расшифровывать некоторые из них. [164] Мнения об этой широко распространенной слежке варьируются от тех, кто считает ее необходимым злом , до тех, для кого она явно неэтична и нарушает право на неприкосновенность частной жизни . [165]

Разработчики ИИ утверждают, что это единственный способ предоставлять ценные приложения. и разработали несколько методов, которые пытаются сохранить конфиденциальность при получении данных, таких как агрегирование данных , деидентификация и дифференциальная конфиденциальность . [166] С 2016 года некоторые эксперты по конфиденциальности, такие как Синтия Дворк , начали рассматривать конфиденциальность с точки зрения справедливости . Брайан Кристиан писал, что эксперты перешли «от вопроса «что они знают» к вопросу «что они с этим делают»». [167]

Генеративный ИИ часто обучается на нелицензированных произведениях, защищенных авторским правом, в том числе в таких областях, как изображения или компьютерный код; выходные данные затем используются на основании « добросовестного использования ». Эксперты расходятся во мнениях относительно того, насколько хорошо и при каких обстоятельствах это обоснование будет иметь силу в судах; соответствующие факторы могут включать «цель и характер использования произведения, защищенного авторским правом» и «влияние на потенциальный рынок произведения, защищенного авторским правом». [168] [169] Владельцы веб-сайтов, которые не хотят, чтобы их контент удалялся, могут указать это в файле robots.txt . [170] В 2023 году ведущие авторы (в том числе Джон Гришэм и Джонатан Франзен ) подали в суд на компании, занимающиеся ИИ, за использование их работ для обучения генеративному ИИ. [171] [172] Другой обсуждаемый подход заключается в создании отдельной sui Generis системы защиты творений, созданных ИИ, чтобы обеспечить справедливое присвоение авторства и компенсацию авторам-людям. [173]

Доминирование технологических гигантов

На коммерческой сцене ИИ доминируют крупные технологические компании, такие как Alphabet Inc. , Amazon , Apple Inc. , Meta Platforms и Microsoft . [174] [175] [176] Некоторые из этих игроков уже владеют подавляющим большинством существующей облачной инфраструктуры и вычислительными мощностями центров обработки данных , что позволяет им еще больше укрепиться на рынке. [177] [178]

Значительные потребности в электроэнергии и другие воздействия на окружающую среду

В январе 2024 года Международное энергетическое агентство (МЭА) опубликовало «Электричество 2024, анализ и прогноз до 2026 года» , в котором прогнозируется потребление электроэнергии. [179] Это первый отчет МЭА, в котором представлены прогнозы относительно центров обработки данных и энергопотребления для искусственного интеллекта и криптовалют. В отчете говорится, что спрос на электроэнергию для этих целей может удвоиться к 2026 году, при этом дополнительное потребление электроэнергии будет равно объему электроэнергии, потребляемой всей японской страной. [180]

Колоссальное энергопотребление ИИ является причиной роста использования ископаемого топлива и может задержать закрытие устаревших угольных энергетических объектов, выделяющих углерод. В США наблюдается лихорадочный рост строительства центров обработки данных, превращающий крупные технологические компании (например, Microsoft, Meta, Google, Amazon) в ненасытных потребителей электроэнергии. Прогнозируемое потребление электроэнергии настолько велико, что есть опасения, что оно будет обеспечено независимо от источника. Поиск ChatGPT требует в 10 раз больше электроэнергии, чем поиск Google. Крупные фирмы торопятся найти источники энергии – от ядерной энергии до геотермальной энергии и термоядерного синтеза. Технологические компании утверждают, что в долгосрочной перспективе ИИ в конечном итоге станет более добрым к окружающей среде, но энергия им нужна сейчас. По мнению технологических компаний, искусственный интеллект сделает энергосистему более эффективной и «интеллектуальной», будет способствовать развитию ядерной энергетики и отслеживать общие выбросы углекислого газа. [181]

2024 года Goldman Sachs В исследовательском документе « Центры обработки данных искусственного интеллекта и грядущий всплеск спроса на электроэнергию в США » говорится, что «спрос на электроэнергию в США, вероятно, будет испытывать рост, не наблюдавшийся в течение одного поколения…». и прогнозирует, что к 2030 году центры обработки данных США будут потреблять 8% электроэнергии в США по сравнению с 3% в 2022 году, что предвещает рост электроэнергетической отрасли различными способами. [182] Потребность центров обработки данных во все большем и большем количестве электроэнергии такова, что они могут максимально использовать электрическую сеть. Крупные технологические компании возражают, что искусственный интеллект может использоваться для максимального использования энергосистемы всеми. [183]

В 2024 году газета Wall Street Journal сообщила, что крупные компании, занимающиеся искусственным интеллектом, начали переговоры с поставщиками атомной энергии США о поставке электроэнергии в центры обработки данных. В марте 2024 года Amazon приобрела ядерный центр обработки данных в Пенсильвании за 650 миллионов долларов США. [184]

Дезинформация

YouTube , Facebook и другие используют системы рекомендаций , чтобы направлять пользователей к большему количеству контента. Целью этих программ искусственного интеллекта было максимальное вовлечение пользователей (то есть единственной целью было заставить людей следить за происходящим). ИИ узнал, что пользователи склонны выбирать дезинформацию , теории заговора и крайне предвзятый контент, и, чтобы удержать их на просмотре, ИИ рекомендовал больше такого контента. Пользователи также склонны смотреть больше контента на одну и ту же тему, поэтому ИИ направлял людей в пузыри фильтров , где они получали несколько версий одной и той же дезинформации. [185] Это убедило многих пользователей в правдивости дезинформации и в конечном итоге подорвало доверие к институтам, СМИ и правительству. [186] Программа ИИ правильно научилась максимизировать свою цель, но результат был вреден для общества. После выборов в США в 2016 году крупные технологические компании предприняли шаги по смягчению проблемы. [ нужна ссылка ] .

В 2022 году генеративный ИИ начал создавать изображения, аудио, видео и текст, неотличимые от реальных фотографий, записей, фильмов или написанного человеком текста. Злоумышленники могут использовать эту технологию для создания огромного количества дезинформации или пропаганды. [187] Пионер ИИ Джеффри Хинтон выразил обеспокоенность по поводу того, что ИИ, помимо других рисков, позволяет «авторитарным лидерам манипулировать своим электоратом» в больших масштабах. [188]

Алгоритмическая предвзятость и справедливость

В статистике смещение — это систематическая ошибка или отклонение от правильного значения. Но в контексте справедливости это часто относится к тенденции в пользу или против определенной группы или индивидуальной характеристики, обычно такой, которая считается несправедливой или вредной. Таким образом, статистически объективная система искусственного интеллекта, которая дает несопоставимые результаты для разных демографических групп, может рассматриваться как предвзятая в этическом смысле. [189]

Область справедливости изучает, как предотвратить вред от алгоритмических предубеждений. Существуют различные противоречивые определения и математические модели справедливости. Эти представления зависят от этических предположений и находятся под влиянием представлений об обществе. Одной из широких категорий является справедливость распределения, которая фокусируется на результатах, часто выявляя группы и стремясь компенсировать статистические различия. Репрезентативная справедливость направлена на то, чтобы системы искусственного интеллекта не укрепляли негативные стереотипы и не делали определенные группы невидимыми. Процедурная справедливость фокусируется на процессе принятия решений, а не на результате. Наиболее важные понятия справедливости могут зависеть от контекста, в частности от типа приложения ИИ и заинтересованных сторон. Субъективность понятий предвзятости и справедливости затрудняет их практическую реализацию компаниями. Многие специалисты по этике ИИ также считают, что доступ к чувствительным атрибутам, таким как раса или пол, необходим для компенсации предубеждений, но это может противоречить антидискриминационные законы . [189]

Приложения машинного обучения будут предвзятыми, если они будут учиться на предвзятых данных. [190] Разработчики могут не знать о существовании предвзятости. [191] Смещение может быть вызвано способом выбора обучающих данных и способом развертывания модели. [192] [190] Если предвзятый алгоритм используется для принятия решений, которые могут серьезно навредить людям (как это может быть в медицине , финансах , найме на работу , жилье или полиции ), тогда этот алгоритм может вызвать дискриминацию . [193]

28 июня 2015 года новая функция маркировки изображений в Google Фото ошибочно определила Джеки Алсина и его друга как «горилл», потому что они были черными. Система была обучена на наборе данных, содержащем очень мало изображений чернокожих людей. [194] проблема под названием «несоответствие размера выборки». [195] Google «исправил» эту проблему, запретив системе помечать что-либо как «гориллу». Восемь лет спустя, в 2023 году, Google Photos все еще не смог идентифицировать гориллу, как и аналогичные продукты Apple, Facebook, Microsoft и Amazon. [196]

COMPAS – коммерческая программа, широко используемая судами США для оценки вероятности того, что обвиняемый станет рецидивистом . В 2016 году Джулия Ангвин из ProPublica обнаружила, что КОМПАС демонстрирует расовую предвзятость, несмотря на то, что программе не была указана расовая принадлежность обвиняемых. Хотя частота ошибок как для белых, так и для черных была калибрована равной ровно 61%, ошибки для каждой расы были разными — система постоянно переоценивала вероятность того, что чернокожий человек совершит повторное правонарушение, и недооценивала вероятность того, что белый человек не совершит правонарушение. повторно обидеть. [197] В 2017 году несколько исследователей [к] показало, что COMPAS математически невозможно учесть все возможные меры справедливости, когда базовые показатели повторных правонарушений различаются для белых и черных в данных. [199]

Программа может принимать предвзятые решения, даже если в данных явно не упоминается проблемный признак (например, «раса» или «пол»). Эта функция будет коррелировать с другими функциями (такими как «адрес», «история покупок» или «имя»), и программа будет принимать те же решения на основе этих функций, что и на основе «расы» или «пола». [200] Мориц Хардт сказал: «Самый убедительный факт в этой области исследований заключается в том, что справедливость через слепоту не работает». [201]

Критика COMPAS подчеркнула, что модели машинного обучения созданы для того, чтобы делать «прогнозы», которые действительны только в том случае, если мы предполагаем, что будущее будет напоминать прошлое. Если они обучаются на данных, которые включают результаты расистских решений в прошлом, модели машинного обучения должны предсказывать, что расистские решения будут приняты в будущем. Если приложение затем использует эти прогнозы в качестве рекомендаций , некоторые из этих «рекомендаций», скорее всего, будут расистскими. [202] Таким образом, машинное обучение не очень подходит для принятия решений в тех областях, где есть надежда, что будущее будет лучше прошлого. Он носит скорее описательный, чем предписывающий характер. [л]

Предвзятость и несправедливость могут остаться незамеченными, поскольку разработчики в подавляющем большинстве белые и мужчины: среди инженеров ИИ около 4% — чернокожие, а 20% — женщины. [195]

На своей конференции по справедливости, подотчетности и прозрачности 2022 года (ACM FAccT 2022) Ассоциация вычислительной техники в Сеуле, Южная Корея, представила и опубликовала результаты, которые рекомендуют, чтобы до тех пор, пока системы искусственного интеллекта и робототехники не будут продемонстрированы, что они свободны от ошибок предвзятости, они небезопасны, и следует ограничить использование самообучающихся нейронных сетей, обученных на огромных нерегулируемых источниках ошибочных интернет-данных. [ сомнительно – обсудить ] [204]

Отсутствие прозрачности

Многие системы искусственного интеллекта настолько сложны, что их разработчики не могут объяснить, как они принимают решения. [205] Особенно с глубокими нейронными сетями , в которых существует большое количество нелинейных связей между входными и выходными данными. Но существуют некоторые популярные методы объяснения. [206]

Невозможно быть уверенным в том, что программа работает правильно, если никто не знает, как именно она работает. Было много случаев, когда программа машинного обучения прошла строгие тесты, но, тем не менее, узнала нечто иное, чем предполагали программисты. Например, было обнаружено, что система, которая может идентифицировать кожные заболевания лучше, чем медицинские работники, на самом деле имеет сильную тенденцию классифицировать изображения с линейкой как «раковые», поскольку изображения злокачественных новообразований обычно включают линейку, показывающую масштаб. [207] Было обнаружено, что другая система машинного обучения, разработанная для эффективного распределения медицинских ресурсов, классифицирует пациентов с астмой как людей с «низким риском» смерти от пневмонии. Наличие астмы на самом деле является серьезным фактором риска, но, поскольку пациенты, страдающие астмой, обычно получают гораздо больше медицинской помощи, согласно данным обучения, их смерть относительно маловероятна. Корреляция между астмой и низким риском смерти от пневмонии была реальной, но вводящей в заблуждение. [208]

Люди, пострадавшие от решения алгоритма, имеют право на объяснение. [209] От врачей, например, ожидается, что они будут четко и полностью объяснять своим коллегам причины любого принимаемого ими решения. Ранние проекты Общего регламента ЕС по защите данных в 2016 году содержали прямое заявление о существовании этого права. [м] Эксперты отрасли отметили, что это нерешенная проблема, решения которой не видно. Регуляторы утверждали, что тем не менее вред реален: если проблема не имеет решения, инструменты не следует использовать. [210]

DARPA учредило программу XAI («Объяснимый искусственный интеллект») в 2014 году, чтобы попытаться решить эти проблемы. [211]

Несколько подходов направлены на решение проблемы прозрачности. SHAP позволяет визуализировать вклад каждой функции в выходные данные. [212] LIME может локально аппроксимировать результаты модели более простой интерпретируемой моделью. [213] Многозадачное обучение обеспечивает большое количество результатов в дополнение к целевой классификации. Эти другие выходные данные могут помочь разработчикам понять, чему научилась сеть. [214] Деконволюция , DeepDream и другие генеративные методы могут позволить разработчикам увидеть, чему научились различные уровни глубокой сети для компьютерного зрения, и получить выходные данные, которые могут подсказать, что изучает сеть. [215] Для генеративных предварительно обученных трансформаторов компания Anthropic разработала метод, основанный на словарном обучении , который связывает паттерны активации нейронов с понятными человеку понятиями. [216]

Плохие актеры и вооруженный ИИ

Искусственный интеллект предоставляет ряд инструментов, полезных для злоумышленников , таких как авторитарные правительства , террористы , преступники или государства-изгои .

Смертоносное автономное оружие — это машина, которая обнаруживает, выбирает и поражает человеческие цели без присмотра человека. [н] Широко доступные инструменты искусственного интеллекта могут быть использованы злоумышленниками для разработки недорогого автономного оружия, и, если они будут производиться в больших масштабах, они потенциально станут оружием массового уничтожения . [218] Даже при использовании в обычной войне маловероятно, что они не смогут надежно выбирать цели и потенциально смогут убить невиновного человека . [218] В 2014 году 30 стран (включая Китай) поддержали запрет на автономное оружие в соответствии с ООН Конвенцией о конкретных видах обычного оружия , однако Соединенные Штаты и другие страны с этим не согласились. [219] Сообщалось, что к 2015 году более пятидесяти стран исследовали боевых роботов. [220]

Инструменты ИИ облегчают авторитарным правительствам эффективный контроль над своими гражданами несколькими способами. лиц и Распознавание голоса позволяет осуществлять повсеместное наблюдение . Машинное обучение , оперируя этими данными, может классифицировать потенциальных врагов государства и не давать им скрываться. Системы рекомендаций могут точно нацелены на пропаганду и дезинформацию для достижения максимального эффекта. Дипфейки и генеративный искусственный интеллект помогают создавать дезинформацию. Передовой ИИ может сделать авторитарные централизованные процессы принятия решений более конкурентоспособными, чем либеральные и децентрализованные системы, такие как рынки . Это снижает стоимость и сложность цифровой войны и современного шпионского ПО . [221] Все эти технологии доступны с 2020 года или раньше — системы распознавания лиц с искусственным интеллектом уже используются для массовой слежки в Китае. [222] [223]

Существует множество других способов, с помощью которых ИИ может помочь злодеям, некоторые из которых невозможно предвидеть. Например, искусственный интеллект с машинным обучением способен создавать десятки тысяч токсичных молекул за считанные часы. [224]

Технологическая безработица

Экономисты часто подчеркивали риски увольнений из ИИ и высказывали предположения о безработице, если не будет адекватной социальной политики для полной занятости. [225]

В прошлом технологии имели тенденцию скорее увеличивать, чем сокращать общую занятость, но экономисты признают, что с ИИ «мы находимся на неизведанной территории». [226] Опрос экономистов показал разногласия по поводу того, приведет ли растущее использование роботов и искусственного интеллекта к существенному увеличению долгосрочной безработицы , но в целом они согласны с тем, что это может принести чистую выгоду, если производительности прирост перераспределить . [227] Оценки риска различаются; например, в 2010-х годах Майкл Осборн и Карл Бенедикт Фрей подсчитали, что 47% рабочих мест в США подвергаются «высокому риску» потенциальной автоматизации, тогда как в отчете ОЭСР только 9% рабочих мест в США классифицируются как «высокие риски». [the] [229] Методологию рассуждений о будущих уровнях занятости подвергали критике за отсутствие доказательной базы и за то, что она подразумевает, что технологии, а не социальная политика, создают безработицу, а не увольнения. [225] В апреле 2023 года сообщалось, что 70% рабочих мест китайских иллюстраторов видеоигр были сокращены из-за генеративного искусственного интеллекта. [230] [231]

В отличие от предыдущих волн автоматизации, многие рабочие места среднего класса могут быть ликвидированы искусственным интеллектом; В 2015 году журнал The Economist заявил, что «беспокойство о том, что ИИ может сделать с рабочими местами белых воротничков то же, что паровая энергия сделала с рабочими во время промышленной революции», «стоит отнестись серьезно». [232] Рабочие места, подвергающиеся крайнему риску, варьируются от помощников юристов до поваров фаст-фуда, в то время как спрос на рабочие места, вероятно, увеличится для профессий, связанных с уходом, от личного здравоохранения до духовенства. [233]

С первых дней развития искусственного интеллекта существовали аргументы, например, выдвинутые Джозефом Вайценбаумом , о том, должны ли на самом деле выполняться ими задачи, которые могут выполняться компьютерами, учитывая разницу между компьютерами и людьми, и между количественными расчетами и качественными, основанными на ценностях суждениями. [234]

Экзистенциальный риск

Утверждалось, что ИИ станет настолько мощным, что человечество может необратимо потерять над ним контроль. Это может, как заявил физик Стивен Хокинг , « означать конец человечества ». [235] Этот сценарий был обычным явлением в научной фантастике, когда компьютер или робот внезапно развивает человеческое «самосознание» (или «чувственность» или «сознание») и становится злонамеренным персонажем. [п] Эти научно-фантастические сценарии вводят в заблуждение по нескольким причинам.

Во-первых, ИИ не требует, чтобы человеческое « сознание » представляло собой экзистенциальный риск. Современные программы искусственного интеллекта ставят перед собой конкретные цели и используют обучение и интеллект для их достижения. Философ Ник Бостром утверждал, что если дать достаточно мощному ИИ практически любую цель, он может решить уничтожить человечество для ее достижения (он использовал пример менеджера фабрики по производству скрепок ). [237] Стюарт Рассел приводит пример домашнего робота, который пытается найти способ убить своего владельца, чтобы предотвратить его отключение от сети, мотивируя это тем, что «вы не сможете принести кофе, если вы мертвы». [238] Чтобы быть безопасным для человечества, сверхразум должен быть искренне связан с моралью и ценностями человечества, чтобы он был «фундаментально на нашей стороне». [239]

Во-вторых, Юваль Ной Харари утверждает, что ИИ не требует тела робота или физического контроля, чтобы представлять экзистенциальный риск. Существенные части цивилизации не являются физическими. Такие вещи, как идеологии , законы , правительство , деньги и экономика , созданы из языка ; они существуют, потому что есть истории, в которые верят миллиарды людей. Нынешняя распространенность дезинформации предполагает, что ИИ может использовать язык, чтобы убедить людей поверить во что угодно, даже совершить разрушительные действия. [240]

Мнения среди экспертов и инсайдеров отрасли неоднозначны: значительная часть их как обеспокоена, так и не обеспокоена риском, исходящим от возможного сверхразумного ИИ. [241] Такие личности, как Стивен Хокинг , Билл Гейтс и Илон Маск , [242] а также пионеры ИИ, такие как Йошуа Бенджио , Стюарт Рассел , Демис Хассабис и Сэм Альтман , выразили обеспокоенность по поводу экзистенциального риска, связанного с ИИ.

В мае 2023 года Джеффри Хинтон объявил о своем уходе из Google, чтобы иметь возможность «свободно говорить о рисках ИИ», «не задумываясь о том, как это повлияет на Google». [243] В частности, он упомянул о рисках поглощения ИИ . [244] и подчеркнул, что во избежание наихудших результатов разработка руководящих принципов безопасности потребует сотрудничества между теми, кто конкурирует в использовании ИИ. [245]

В 2023 году многие ведущие эксперты в области ИИ выступили с совместным заявлением , что «Снижение риска исчезновения ИИ должно стать глобальным приоритетом наряду с другими рисками социального масштаба, такими как пандемии и ядерная война». [246]

Другие исследователи, однако, высказались в пользу менее антиутопической точки зрения. Пионер искусственного интеллекта Юрген Шмидхубер не подписал совместное заявление, подчеркнув, что в 95% всех случаев исследования искусственного интеллекта направлены на то, чтобы сделать «человеческую жизнь дольше, здоровее и проще». [247] Хотя инструменты, которые сейчас используются для улучшения жизни, также могут быть использованы злоумышленниками, «они также могут быть использованы против злоумышленников». [248] [249] Эндрю Нг также заявил, что «было бы ошибкой поддаться шумихе вокруг ИИ, связанной с судным днем, и что регуляторы, которые это сделают, принесут пользу только корыстным интересам». [250] Янн ЛеКун «высмеивает антиутопические сценарии своих сверстников о чрезмерной дезинформации и даже, в конечном итоге, о вымирании человечества». [251] В начале 2010-х годов эксперты утверждали, что риски в будущем слишком отдалены, чтобы требовать проведения исследований, или что люди будут представлять ценность с точки зрения сверхразумной машины. [252] Однако после 2016 года изучение текущих и будущих рисков и возможных решений стало серьезным направлением исследований. [253]

Этические машины и согласованность

Дружественный ИИ — это машины, которые с самого начала были разработаны для минимизации рисков и принятия решений, приносящих пользу людям. Элиэзер Юдковски , придумавший этот термин, утверждает, что разработка дружественного ИИ должна быть более высоким приоритетом исследований: это может потребовать больших инвестиций и должно быть завершено до того, как ИИ станет экзистенциальным риском. [254]

У машин, обладающих интеллектом, есть потенциал использовать свой интеллект для принятия этических решений. Область машинной этики предоставляет машинам этические принципы и процедуры для решения этических дилемм. [255] Область машинной этики также называется вычислительной моралью. [255] и была основана на симпозиуме AAAI в 2005 году. [256]

Другие подходы включают Венделла Уоллаха . «искусственные моральные агенты» [257] и Стюарта Дж. Рассела для три принципа разработки доказуемо полезных машин. [258]

Открытый исходный код

Активные организации в сообществе разработчиков искусственного интеллекта с открытым исходным кодом включают Hugging Face , [259] Google , [260] ЭлеутерИИ и Мета . [261] Различные модели ИИ, такие как Llama 2 , Mistral или Stable Diffusion , были сделаны с открытым весом, [262] [263] это означает, что их архитектура и обученные параметры («веса») общедоступны. Модели открытого веса можно свободно настраивать , что позволяет компаниям специализировать их на основе собственных данных и для собственных сценариев использования. [264] Модели открытого веса полезны для исследований и инноваций, но ими также можно злоупотреблять. Поскольку их можно точно настроить, любые встроенные меры безопасности, такие как противодействие вредоносным запросам, можно отключать до тех пор, пока они не станут неэффективными. Некоторые исследователи предупреждают, что будущие модели ИИ могут обладать опасными возможностями (например, потенциально способствовать значительному развитию биотерроризма ) и что, как только они будут опубликованы в Интернете, их нельзя будет удалить повсюду, если это необходимо. Они рекомендуют предварительные аудиты и анализ затрат и выгод. [265]

Рамки

Этическая допустимость проектов искусственного интеллекта может быть проверена при проектировании, разработке и внедрении системы ИИ. Структура искусственного интеллекта, такая как Care and Act Framework, содержащая значения SUM, разработанная Институтом Алана Тьюринга, тестирует проекты в четырех основных областях: [266] [267]

- Уважайте достоинство отдельных людей

- Общайтесь с другими людьми искренне, открыто и инклюзивно.

- Забота о благополучии каждого

- Защищать социальные ценности, справедливость и общественные интересы

Другие разработки в области этических норм включают, среди прочего, решения, принятые на конференции Асиломар , Монреальскую декларацию об ответственном ИИ и инициативу IEEE по этике автономных систем; [268] однако эти принципы не обходятся без критики, особенно в отношении людей, избранных в эти рамки. [269]

Содействие благополучию людей и сообществ, на которые влияют эти технологии, требует рассмотрения социальных и этических последствий на всех этапах проектирования, разработки и внедрения системы ИИ, а также сотрудничества между должностными лицами, такими как специалисты по обработке данных, менеджеры по продуктам, инженеры по обработке данных, специалисты по предметной области. специалисты и менеджеры по доставке. [270]

Британский институт безопасности ИИ выпустил в 2024 году набор инструментов для тестирования под названием «Inspect» для оценки безопасности ИИ, доступный по лицензии MIT с открытым исходным кодом, который находится в свободном доступе на GitHub и может быть улучшен с помощью сторонних пакетов. Его можно использовать для оценки моделей ИИ в различных областях, включая базовые знания, способность рассуждать и автономные возможности. [271]

Регулирование

Регулирование искусственного интеллекта — это разработка политики и законов государственного сектора для продвижения и регулирования ИИ; следовательно, это связано с более широким регулированием алгоритмов. [272] Нормативно-правовая и политическая среда в области ИИ является новой проблемой в юрисдикциях по всему миру. [273] По данным AI Index в Стэнфорде , ежегодное количество законов, связанных с ИИ, принятых в 127 странах, принявших участие в исследовании, выросло с одного, принятого в 2016 году, до 37, принятых только в 2022 году. [274] [275] В период с 2016 по 2020 год более 30 стран приняли специальные стратегии в области ИИ. [276] Большинство государств-членов ЕС опубликовали национальные стратегии в области искусственного интеллекта, а также Канада, Китай, Индия, Япония, Маврикий, Российская Федерация, Саудовская Аравия, Объединенные Арабские Эмираты, США и Вьетнам. Другие страны, в том числе Бангладеш, Малайзия и Тунис, находились в процессе разработки собственной стратегии ИИ. [276] Глобальное партнерство по искусственному интеллекту было запущено в июне 2020 года, заявив о необходимости разработки ИИ в соответствии с правами человека и демократическими ценностями, чтобы обеспечить доверие общества к этой технологии. [276] Генри Киссинджер , Эрик Шмидт и Дэниел Хуттенлохер опубликовали в ноябре 2021 года совместное заявление с призывом создать правительственную комиссию по регулированию ИИ. [277] В 2023 году лидеры OpenAI опубликовали рекомендации по управлению сверхинтеллектом, что, по их мнению, может произойти менее чем через 10 лет. [278] В 2023 году Организация Объединенных Наций также создала консультативный орган для предоставления рекомендаций по управлению ИИ; В состав этого органа входят руководители технологических компаний, правительственные чиновники и ученые. [279]

Согласно опросу Ipsos 2022 года , отношение к ИИ сильно различалось в зависимости от страны; 78% граждан Китая и только 35% американцев согласились, что «продукты и услуги, использующие ИИ, имеют больше преимуществ, чем недостатков». [274] /Ipsos , проведенный в 2023 году, Опрос Reuters показал, что 61% американцев согласны и 22% не согласны с тем, что ИИ представляет угрозу для человечества. [280] В опросе Fox News 2023 года 35% американцев сочли «очень важным», а еще 41% сочли «несколько важным» регулирование ИИ со стороны федерального правительства, по сравнению с 13%, ответившими «не очень важно» и 8% отвечая «совсем не важно». [281] [282]

первый глобальный саммит по безопасности ИИ в Великобритании прошел В ноябре 2023 года в Блетчли-Парке , на котором обсуждались краткосрочные и долгосрочные риски ИИ, а также возможность создания обязательных и добровольных нормативных рамок. [283] 28 стран, включая США, Китай и Европейский Союз, в начале саммита опубликовали декларацию, призывающую к международному сотрудничеству для решения проблем и рисков, связанных с искусственным интеллектом. [284] [285] В мае 2024 года на Сеульском саммите AI 16 глобальных компаний, занимающихся технологиями искусственного интеллекта, согласились взять на себя обязательства по обеспечению безопасности при разработке искусственного интеллекта. [286] [287]

История

Изучение механического или «формального» рассуждения началось с философов и математиков древности. Изучение логики привело непосредственно к Алана Тьюринга , теории вычислений которая предполагала, что машина, перетасовывая такие простые символы, как «0» и «1», может моделировать любую мыслимую форму математического рассуждения. [288] [5] Это, наряду с одновременными открытиями в кибернетике , теории информации и нейробиологии , побудило исследователей рассмотреть возможность создания «электронного мозга». [д] Они разработали несколько областей исследований, которые впоследствии стали частью ИИ. [290] такие как Маккаллуша и Питта «искусственных нейронов» в 1943 году, разработка [119] и влиятельная статья Тьюринга 1950 года « Вычислительная техника и интеллект », в которой был представлен тест Тьюринга и показано, что «машинный интеллект» вполне правдоподобен. [291] [5]

Область исследований искусственного интеллекта была основана на семинаре в Дартмутском колледже в 1956 году. [р] [6] Участники стали лидерами исследований в области искусственного интеллекта в 1960-х годах. [с] Они и их студенты подготовили программы, которые пресса назвала «поразительными»: [т] компьютеры изучали стратегии игры в шашки , решали текстовые задачи по алгебре, доказывали логические теоремы и говорили по-английски. [в] [9] Лаборатории искусственного интеллекта были созданы в ряде университетов Великобритании и США в конце 1950-х — начале 1960-х годов. [5]

Исследователи 1960-х и 1970-х годов были убеждены, что их методы в конечном итоге позволят создать машину с общим интеллектом , и считали это целью своей области. [295] Герберт Саймон предсказал: «Через двадцать лет машины будут способны выполнять любую работу, которую может выполнить человек». [296] Марвин Мински согласился, написав: «Через поколение… проблема создания «искусственного интеллекта» будет существенно решена». [297] Однако они недооценили сложность проблемы. [v] В 1974 году правительства США и Великобритании прекратили исследовательские исследования в ответ на критику сэра Джеймса Лайтхилла. [299] и продолжающееся давление со стороны Конгресса США с целью финансирования более продуктивных проектов . [300] Мински и Паперта Книга « Перцептроны » была воспринята как доказательство того, что искусственные нейронные сети никогда не будут полезны для решения реальных задач, что полностью дискредитировало этот подход. [301] Затем последовала « зима ИИ », период, когда получение финансирования для проектов ИИ было затруднено. [11]

В начале 1980-х годов исследования ИИ возобновились благодаря коммерческому успеху экспертных систем . [302] форма программы искусственного интеллекта, которая моделирует знания и аналитические навыки людей-экспертов. К 1985 году рынок искусственного интеллекта превысил миллиард долларов. В то же время японский компьютерный проект пятого поколения вдохновил правительства США и Великобритании восстановить финансирование академических исследований . [10] Однако, начиная с краха рынка Lisp-машин в 1987 году, ИИ снова потерял репутацию, и началась вторая, более продолжительная зима. [12]

До этого момента большая часть финансирования ИИ направлялась на проекты, в которых использовались символы высокого уровня для представления мысленных объектов, таких как планы, цели, убеждения и известные факты. В 1980-х годах некоторые исследователи начали сомневаться в том, что такой подход сможет имитировать все процессы человеческого познания, особенно восприятие , робототехнику , обучение и распознавание образов . [303] и начал изучать «субсимволические» подходы. [304] Родни Брукс отверг «представление» в целом и сосредоточился непосредственно на разработке машин, которые движутся и выживают. [В] Джудея Перл , Лофти Заде и другие разработали методы, которые обрабатывали неполную и неопределенную информацию, делая разумные предположения, а не точную логику. [91] [309] Но самым важным событием стало возрождение « коннекционизма », включая исследования нейронных сетей, Джеффри Хинтоном и другими. [310] В 1990 году Ян ЛеКун успешно показал, что сверточные нейронные сети могут распознавать рукописные цифры, что стало первым из многих успешных применений нейронных сетей. [311]

ИИ постепенно восстановил свою репутацию в конце 1990-х и начале 21 века, используя формальные математические методы и находя конкретные решения конкретных проблем. Эта « узкая » и «формальная» направленность позволила исследователям получать поддающиеся проверке результаты и сотрудничать с другими областями (такими как статистика , экономика и математика ). [312] К 2000 году решения, разработанные исследователями искусственного интеллекта, стали широко использоваться, хотя в 1990-е годы их редко называли «искусственным интеллектом». [313] Однако некоторые академические исследователи были обеспокоены тем, что ИИ больше не преследует свою первоначальную цель — создание универсальных, полностью интеллектуальных машин. Примерно начиная с 2002 года они основали подразделение общего искусственного интеллекта (или «AGI»), в котором к 2010-м годам было несколько хорошо финансируемых учреждений. [16]

Глубокое обучение начало доминировать в отрасли в 2012 году и было внедрено во всех сферах. [13] Для многих конкретных задач от других методов отказались. [х] Успех глубокого обучения был основан как на усовершенствовании аппаратного обеспечения ( более быстрые компьютеры , [315] графические процессоры , облачные вычисления [316] ) и доступ к большим объемам данных [317] (включая тщательно подобранные наборы данных, [316] например, ImageNet ). Успех глубокого обучения привел к огромному увеличению интереса и финансирования ИИ. [и] Объем исследований в области машинного обучения (измеряемый общим количеством публикаций) увеличился на 50% в 2015–2019 годах. [276]

В 2016 году вопросы справедливости и неправомерного использования технологий оказались в центре внимания конференций по машинному обучению, количество публикаций значительно увеличилось, появилось финансирование, и многие исследователи переориентировали свою карьеру на эти проблемы. Проблема выравнивания стала серьезной областью академических исследований. [253]

В конце подросткового периода и начале 2020-х годов компании AGI начали предлагать программы, вызвавшие огромный интерес. В 2015 году AlphaGo , разработанная DeepMind , обыграла чемпиона мира по игре в го . Программу обучали только правилам игры и самостоятельно разрабатывали стратегию. GPT-3 — это большая языковая модель , выпущенная OpenAI в 2020 году и способная генерировать высококачественный человеческий текст. [318] Эти и другие программы спровоцировали агрессивный бум искусственного интеллекта , когда крупные компании начали инвестировать миллиарды в исследования искусственного интеллекта. По данным AI Impacts, примерно в 2022 году только в США в ИИ ежегодно инвестировалось около 50 миллиардов долларов, и около 20% новых выпускников докторантов компьютерных наук в США специализировались на «ИИ». [319] В 2022 году в США существовало около 800 000 вакансий, связанных с искусственным интеллектом. [320]

Философия

Определение искусственного интеллекта

Алан Тьюринг написал в 1950 году: «Я предлагаю рассмотреть вопрос: могут ли машины думать?» [321] Он посоветовал изменить вопрос с «думает ли машина» на «может ли машина демонстрировать разумное поведение». [321] Он разработал тест Тьюринга, который измеряет способность машины имитировать человеческий разговор. [291] Поскольку мы можем только наблюдать за поведением машины, не имеет значения, «на самом деле» она думает или буквально имеет «разум». Тьюринг отмечает, что мы не можем определить эти вещи в отношении других людей , но «обычно существует вежливая условность, о которой думают все». [322]

Рассел и Норвиг согласны с Тьюрингом в том, что интеллект следует определять с точки зрения внешнего поведения, а не внутренней структуры. [1] Тем не менее, они очень важны, так как тест требует, чтобы машина имитировала людей. « В текстах по авиационной технике , — писали они, — цель их области деятельности не определяется как создание «машин, которые летают настолько точно, как , что могут обмануть других голубей » . голуби [323] Основатель искусственного интеллекта Джон Маккарти согласился, написав, что «искусственный интеллект по определению не является симуляцией человеческого интеллекта». [324]

Маккарти определяет интеллект как «вычислительную часть способности достигать целей в мире». [325] Другой основатель ИИ, Марвин Мински, также описывает его как «способность решать сложные проблемы». [326] Ведущий учебник по искусственному интеллекту определяет его как исследование агентов, которые воспринимают окружающую среду и предпринимают действия, которые максимизируют их шансы на достижение определенных целей. [1] Эти определения рассматривают интеллект как четко определенные проблемы с четко определенными решениями, где и сложность проблемы, и производительность программы являются прямыми мерами «разума» машины - и никакого другого философского обсуждения не требуется. или может быть даже невозможно.

Другое определение было принято Google: [327] крупный практик в области искусственного интеллекта. Это определение предусматривает способность систем синтезировать информацию как проявление интеллекта, аналогично тому, как это определяется в биологическом интеллекте.

Некоторые авторы на практике предполагают, что определение ИИ расплывчато и его трудно определить, при этом возникают споры относительно того, следует ли классические алгоритмы отнести к категории ИИ. [328] Многие компании во время бума ИИ в начале 2020-х годов использовали этот термин как модное маркетинговое словечко , часто даже если они «на самом деле не использовали ИИ в материальном плане». [329]

Оценка подходов к ИИ

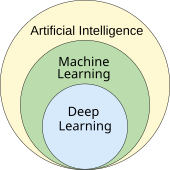

Никакая устоявшаяся объединяющая теория или парадигма не направляла исследования ИИ на протяжении большей части его истории. [С] Беспрецедентный успех статистического машинного обучения в 2010-х годах затмил все другие подходы (настолько, что некоторые источники, особенно в деловом мире, используют термин «искусственный интеллект» для обозначения «машинного обучения с нейронными сетями»). Этот подход в основном субсимволический , мягкий и узкий . Критики утверждают, что будущим поколениям исследователей ИИ, возможно, придется вернуться к этим вопросам.

Символический ИИ и его пределы

Символический ИИ (или « ГОФАИ ») [331] смоделировали сознательные рассуждения высокого уровня, которые люди используют, когда решают головоломки, выражают юридические рассуждения и занимаются математикой. Они очень успешно справлялись с «умными» задачами, такими как алгебра или тесты на IQ. В 1960-х годах Ньюэлл и Саймон предложили гипотезу системы физических символов : «Система физических символов обладает необходимыми и достаточными средствами общего разумного действия». [332]

Однако символический подход не справился со многими задачами, которые люди легко решают, такими как обучение, распознавание объекта или здравое рассуждение. Парадокс Моравца заключается в открытии того, что «интеллектуальные» задачи высокого уровня были легкими для ИИ, а «инстинктивные» задачи низкого уровня были чрезвычайно трудными. [333] Философ Хьюберт Дрейфус с 1960-х годов утверждал , что человеческий опыт зависит от бессознательного инстинкта, а не от сознательного манипулирования символами, и от «чувства» ситуации, а не от явного символического знания. [334] Хотя его аргументы были высмеяны и проигнорированы, когда они были впервые представлены, в конечном итоге исследования ИИ пришли к его мнению. [аа] [21]

Проблема не решена: субсимволические рассуждения могут совершать многие из тех же непостижимых ошибок, что и человеческая интуиция, например алгоритмическая предвзятость . Критики, такие как Ноам Хомский, утверждают, что продолжение исследований символического ИИ по-прежнему будет необходимо для достижения общего интеллекта. [336] [337] отчасти потому, что субсимволический ИИ — это отход от объяснимого ИИ : может быть трудно или невозможно понять, почему современная статистическая программа ИИ приняла то или иное решение. Развивающаяся область нейросимволического искусственного интеллекта пытается соединить два подхода.

Аккуратный против неряшливого